vue

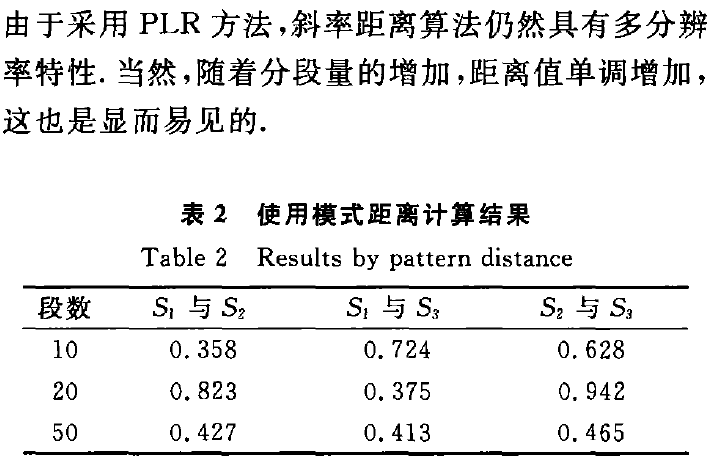

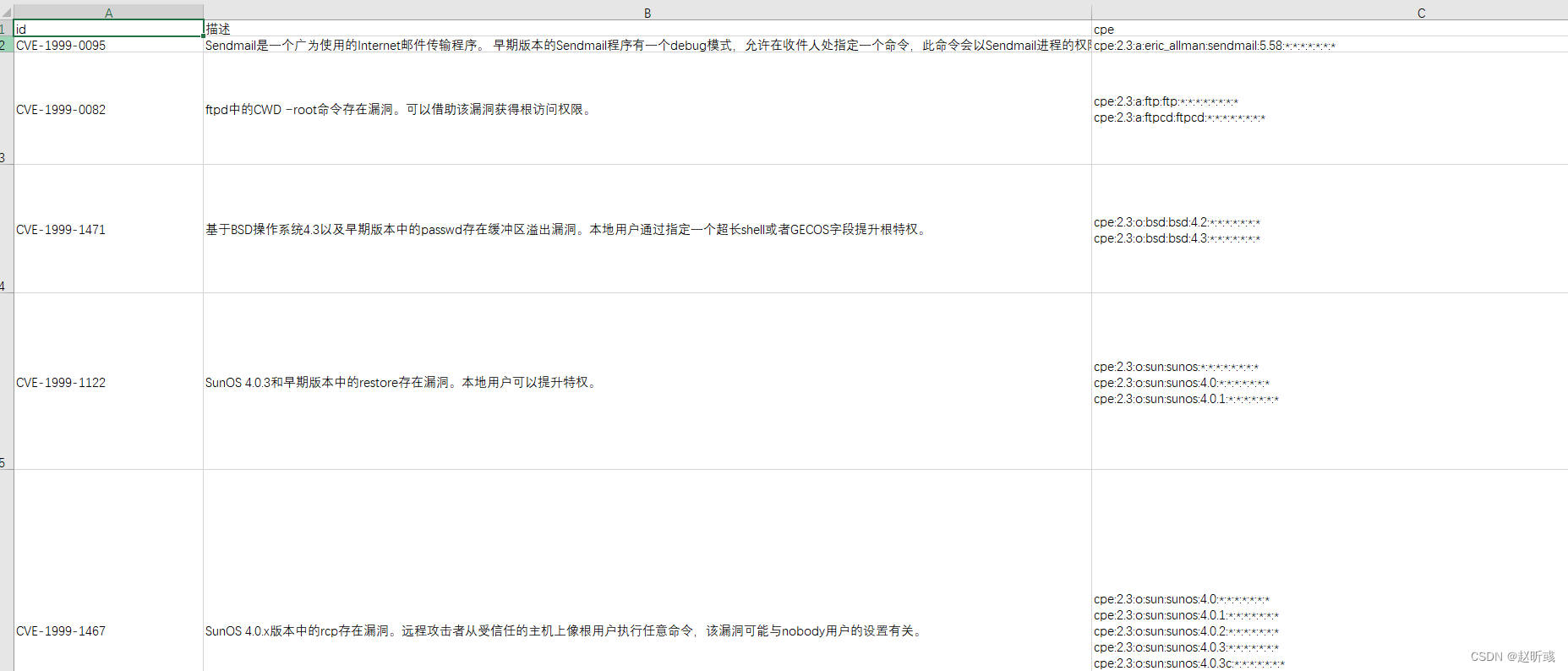

导航

考研

拍照

EPICS

xshell

iVX低代码平台

符号表导出

cisp考试难度

技术

汇编求解一元二次方程的解

高等数学

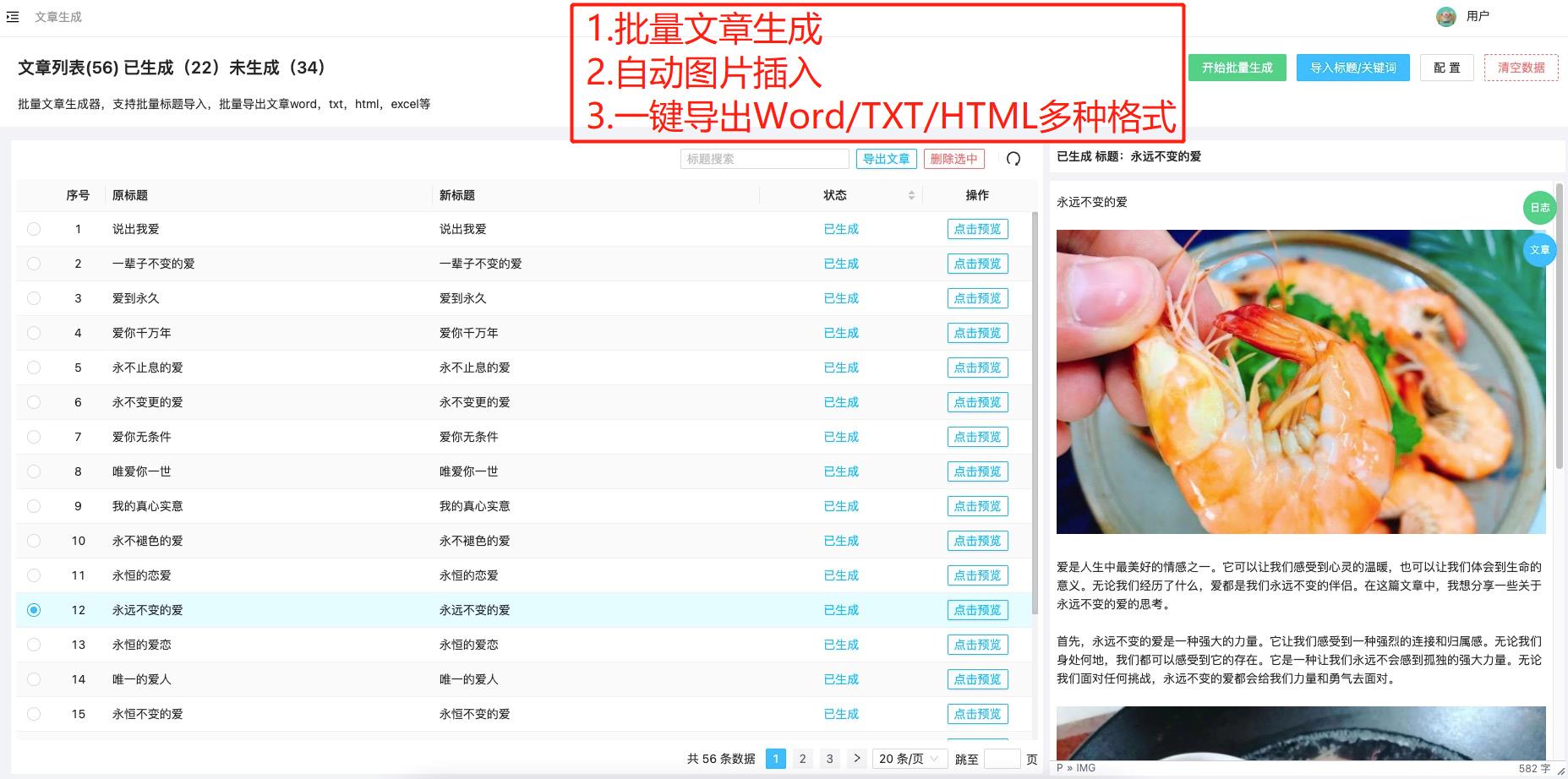

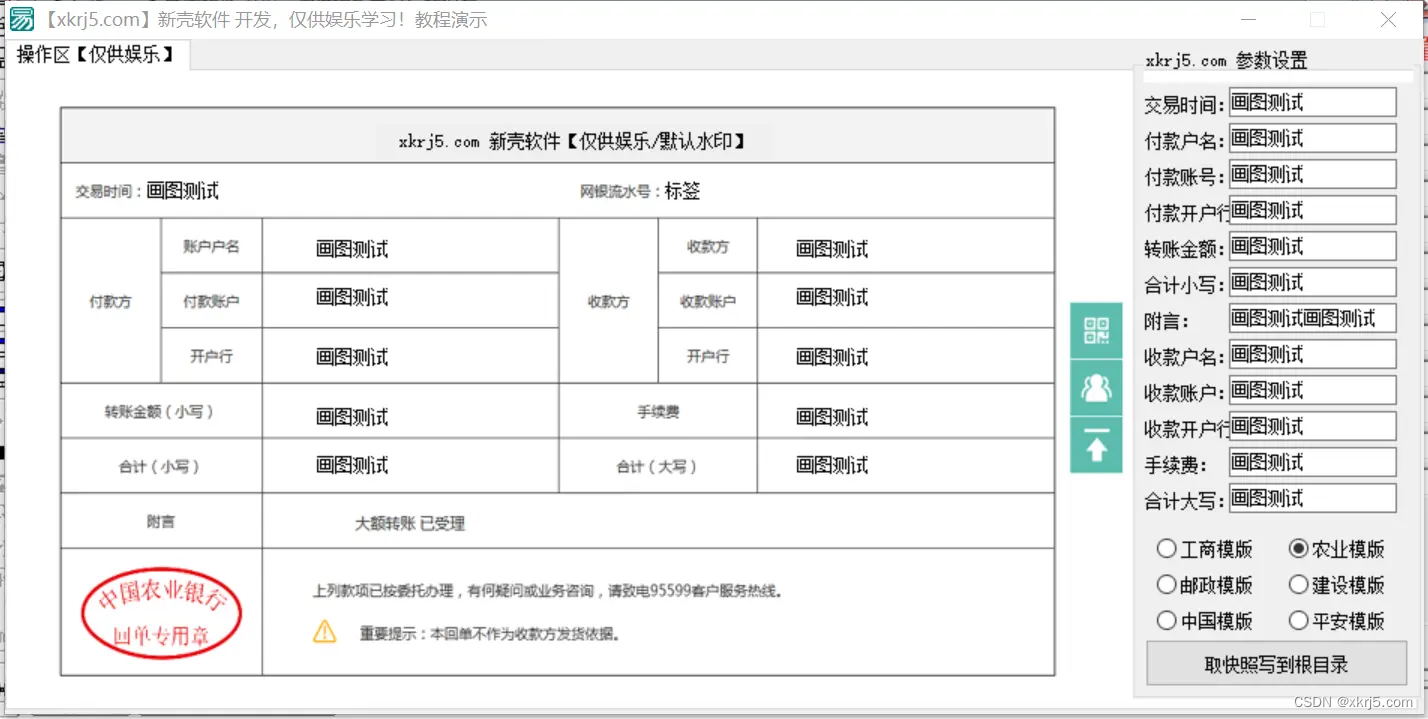

批量制图

DDD

遗传算法

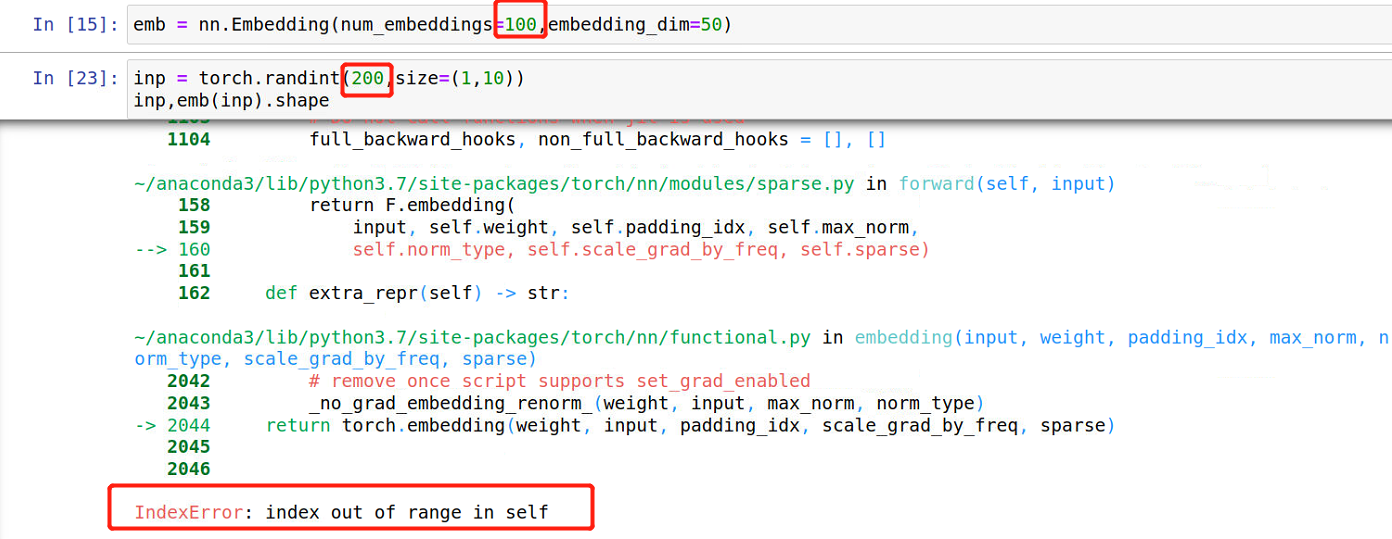

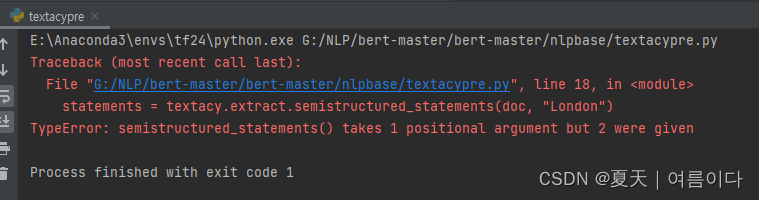

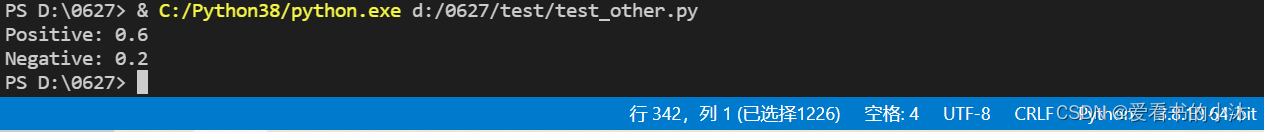

python老错误

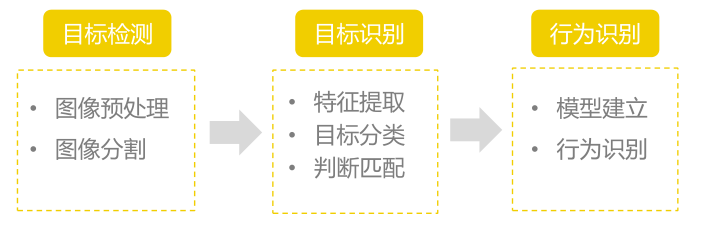

车牌识别

1+x web 例题

解析

if语句

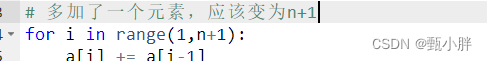

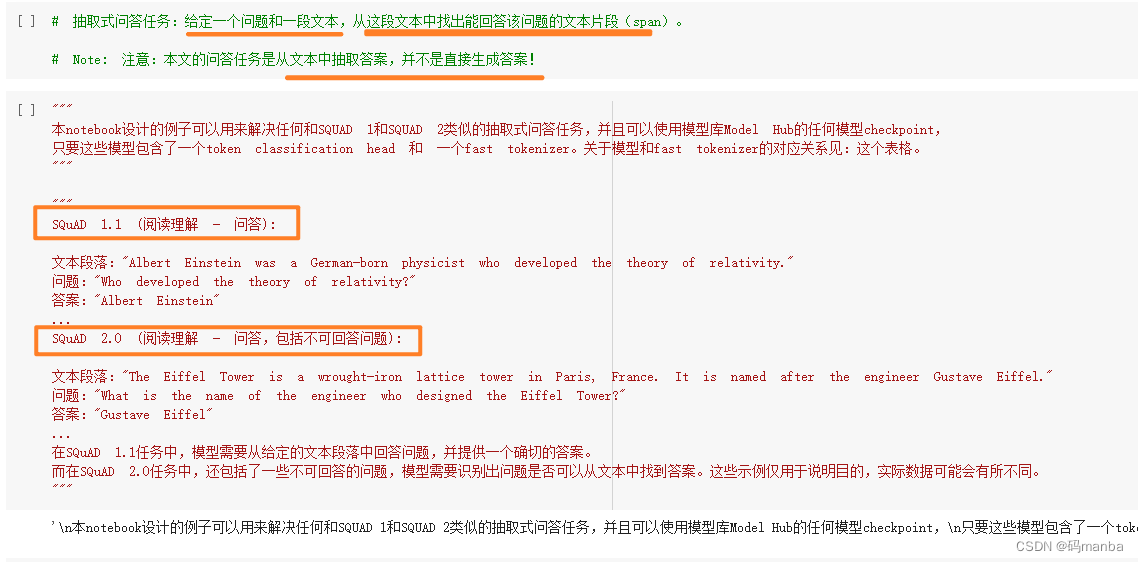

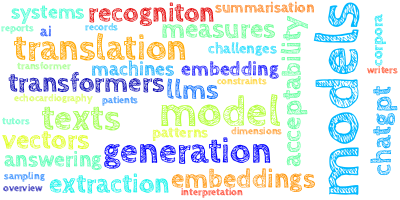

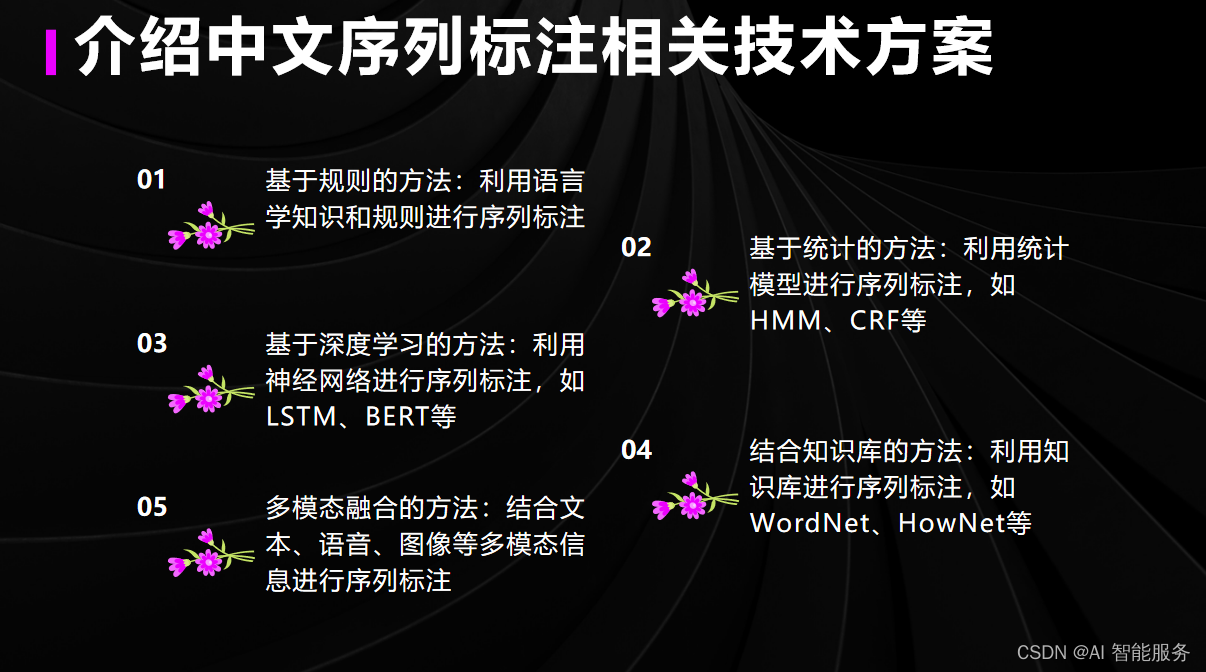

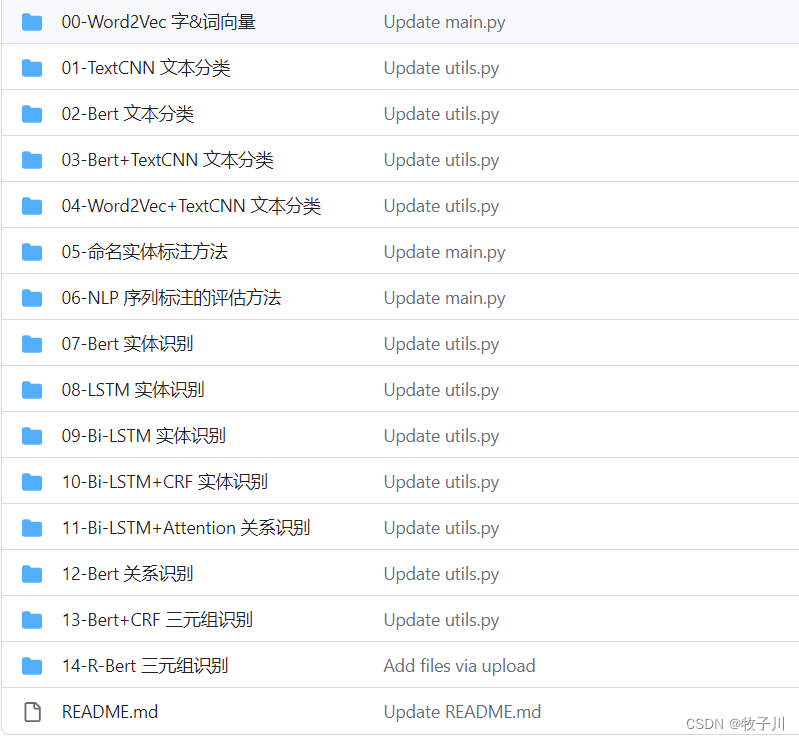

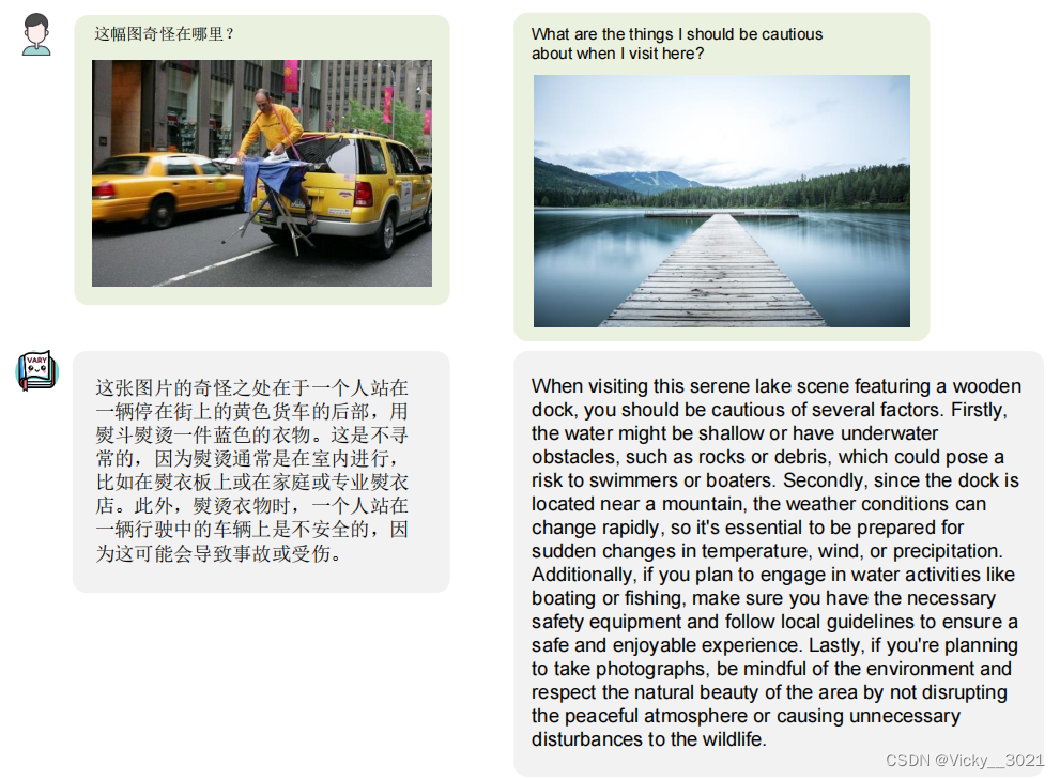

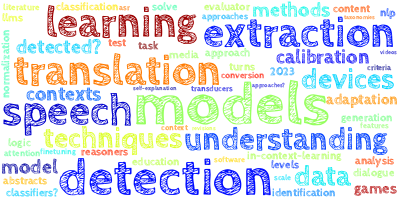

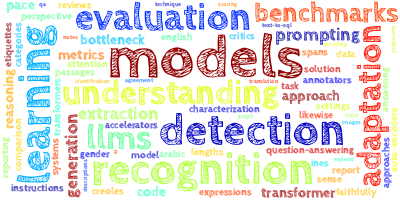

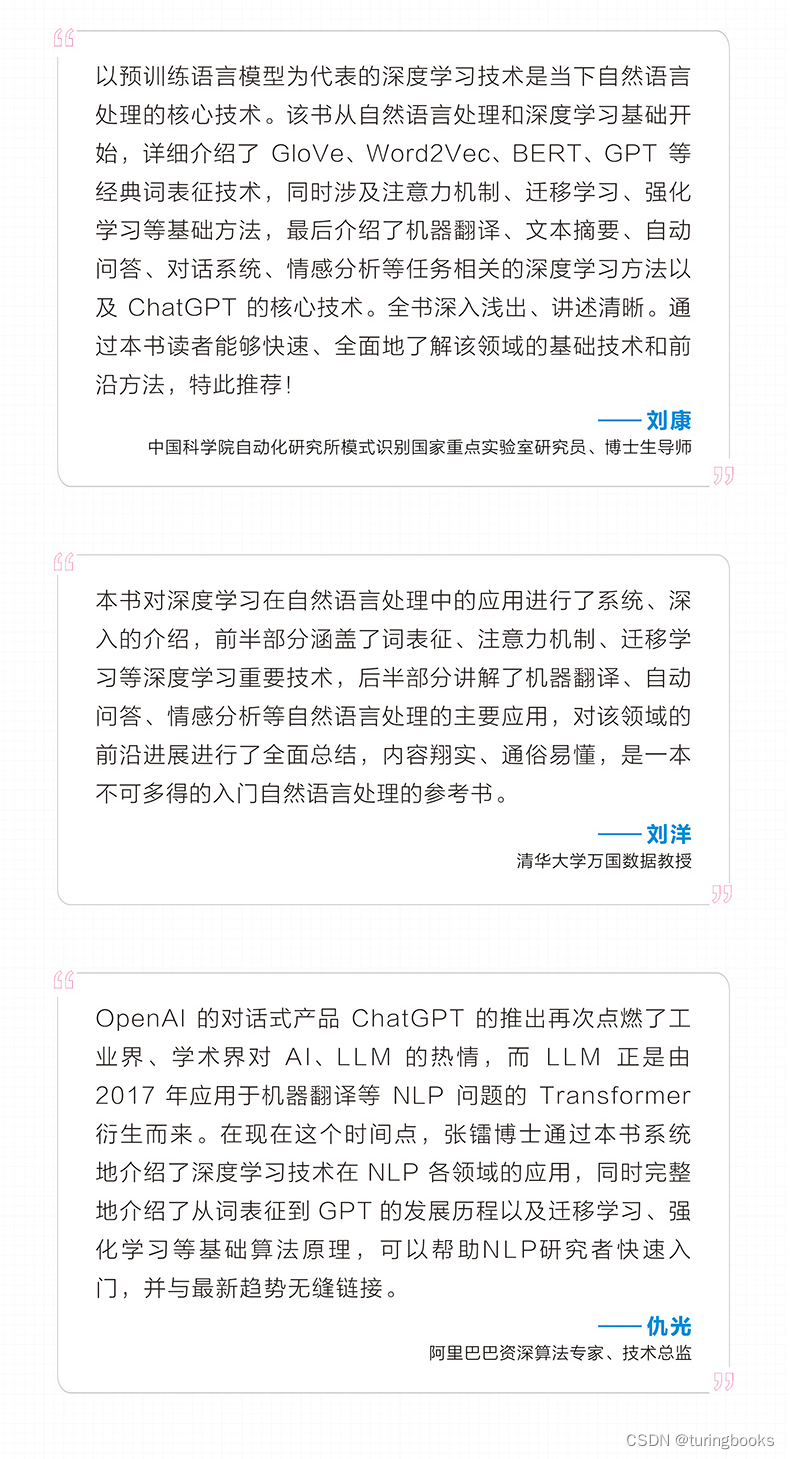

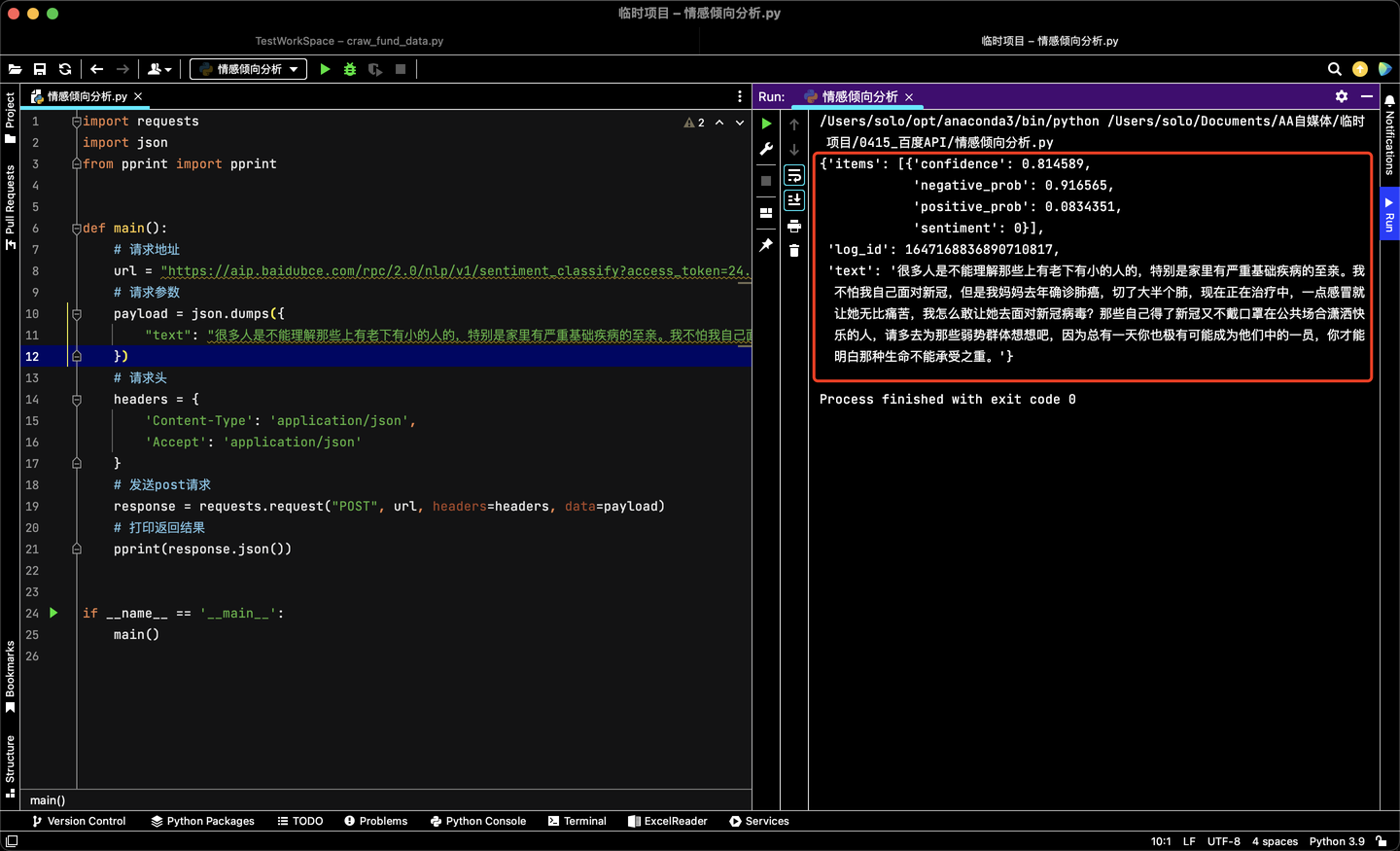

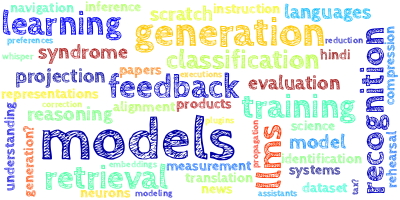

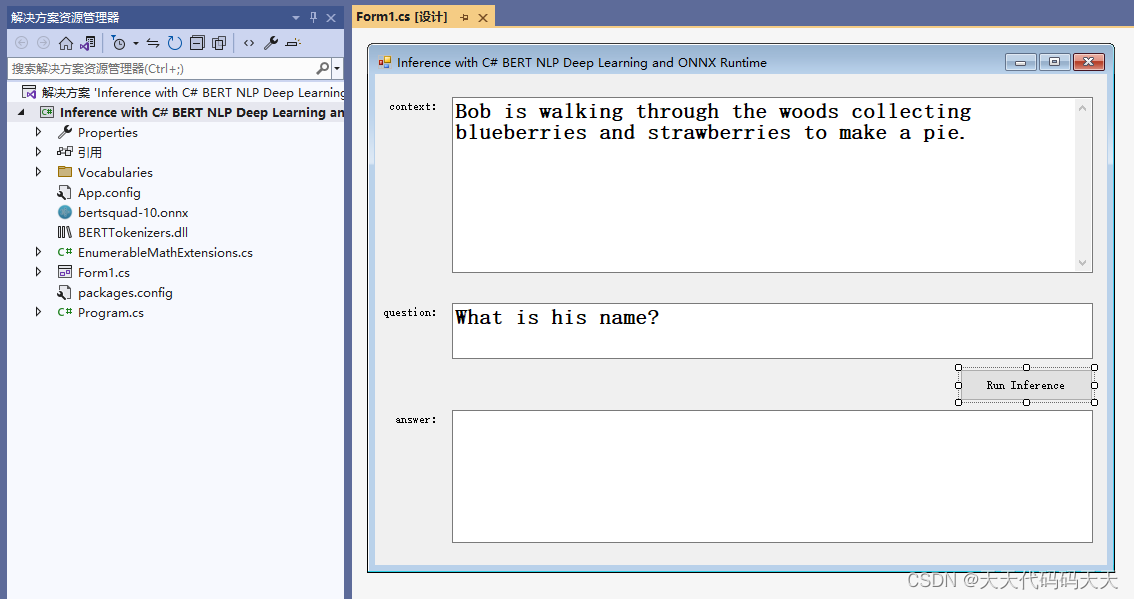

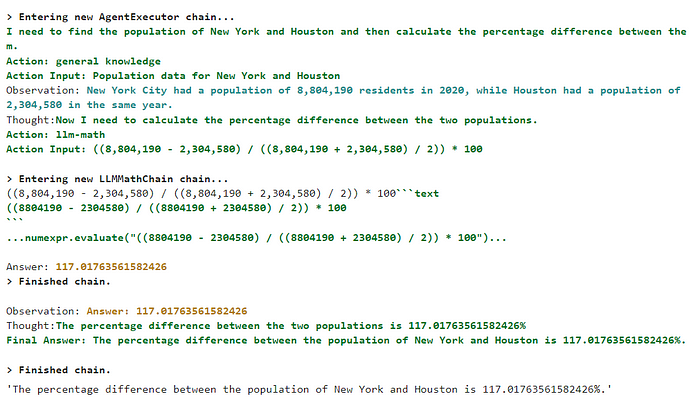

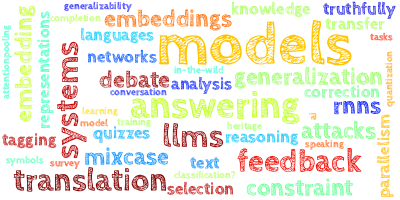

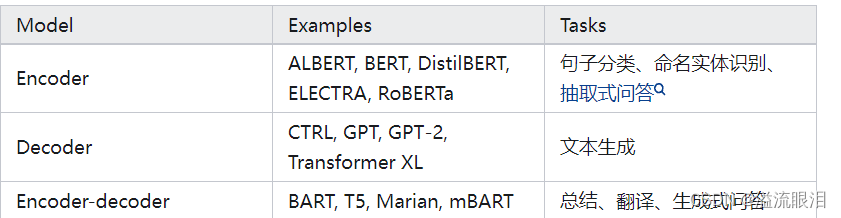

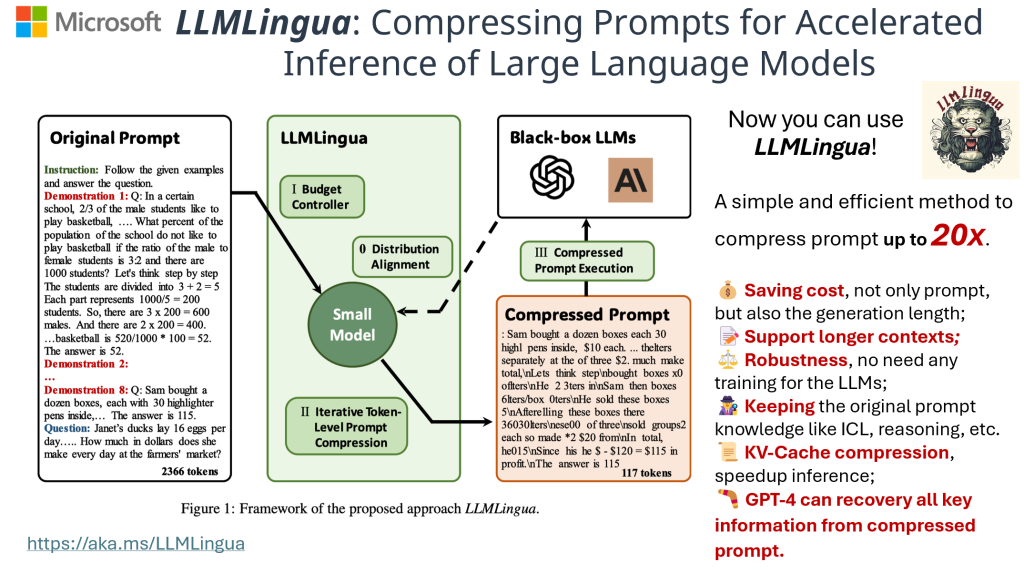

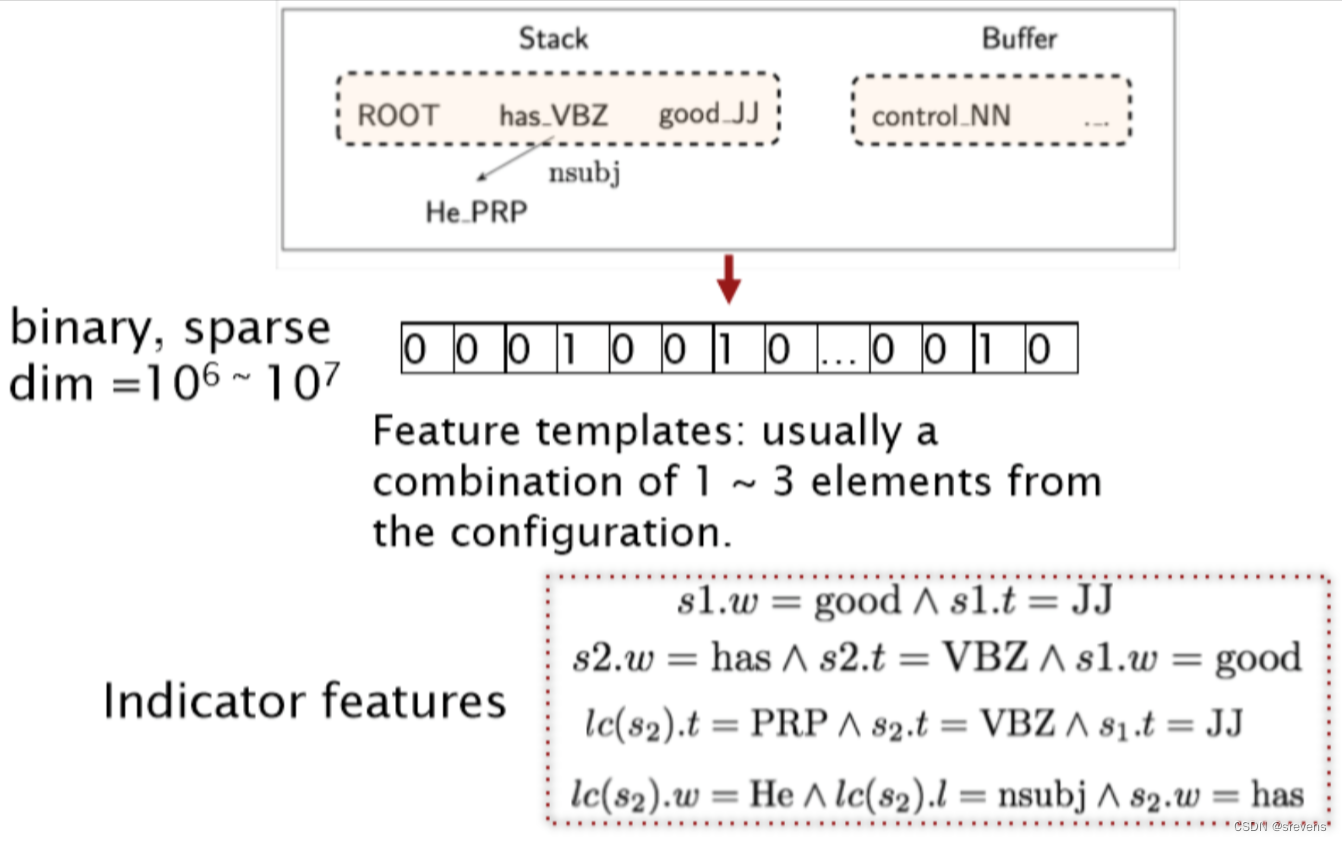

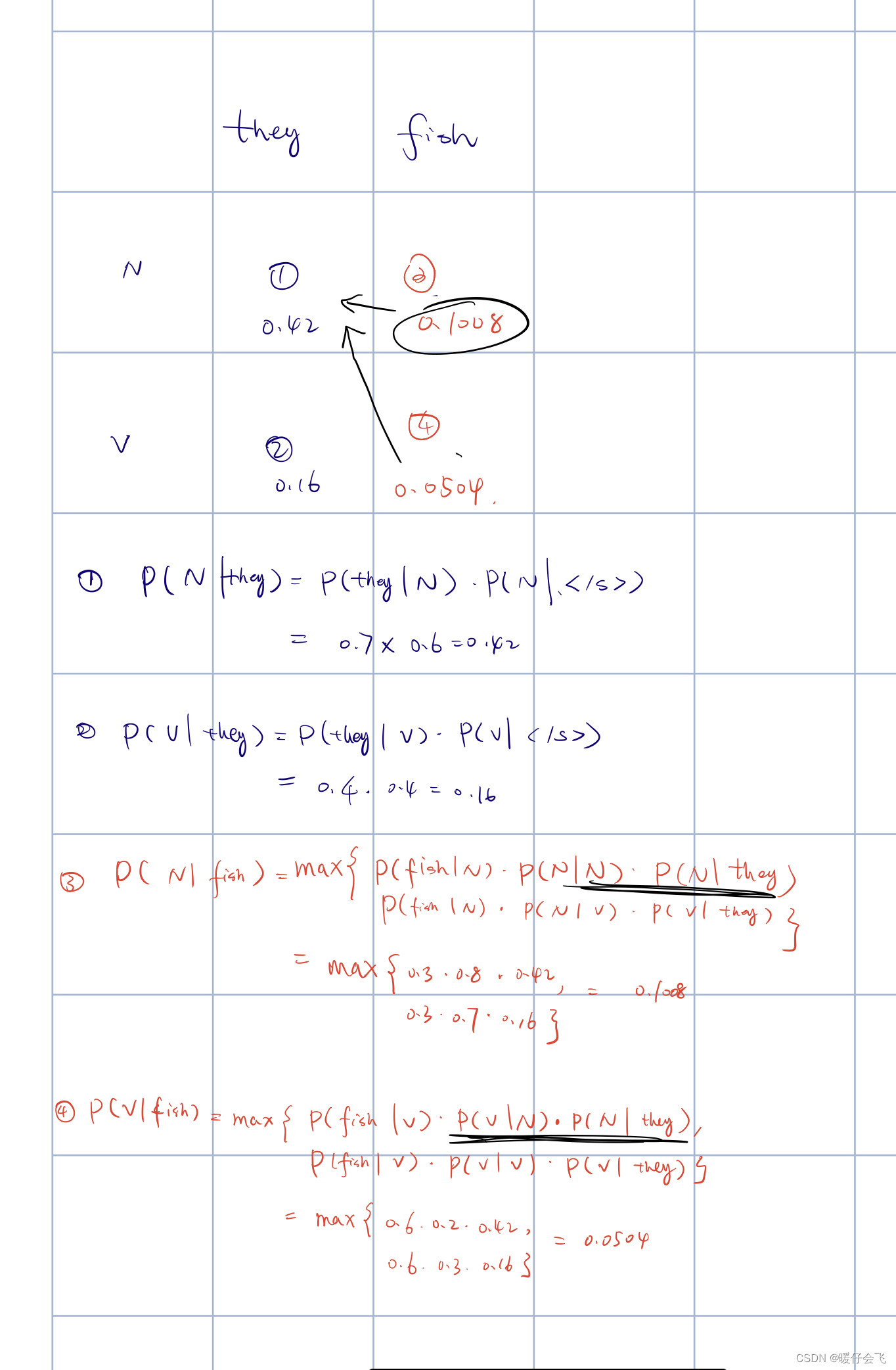

自然语言处理

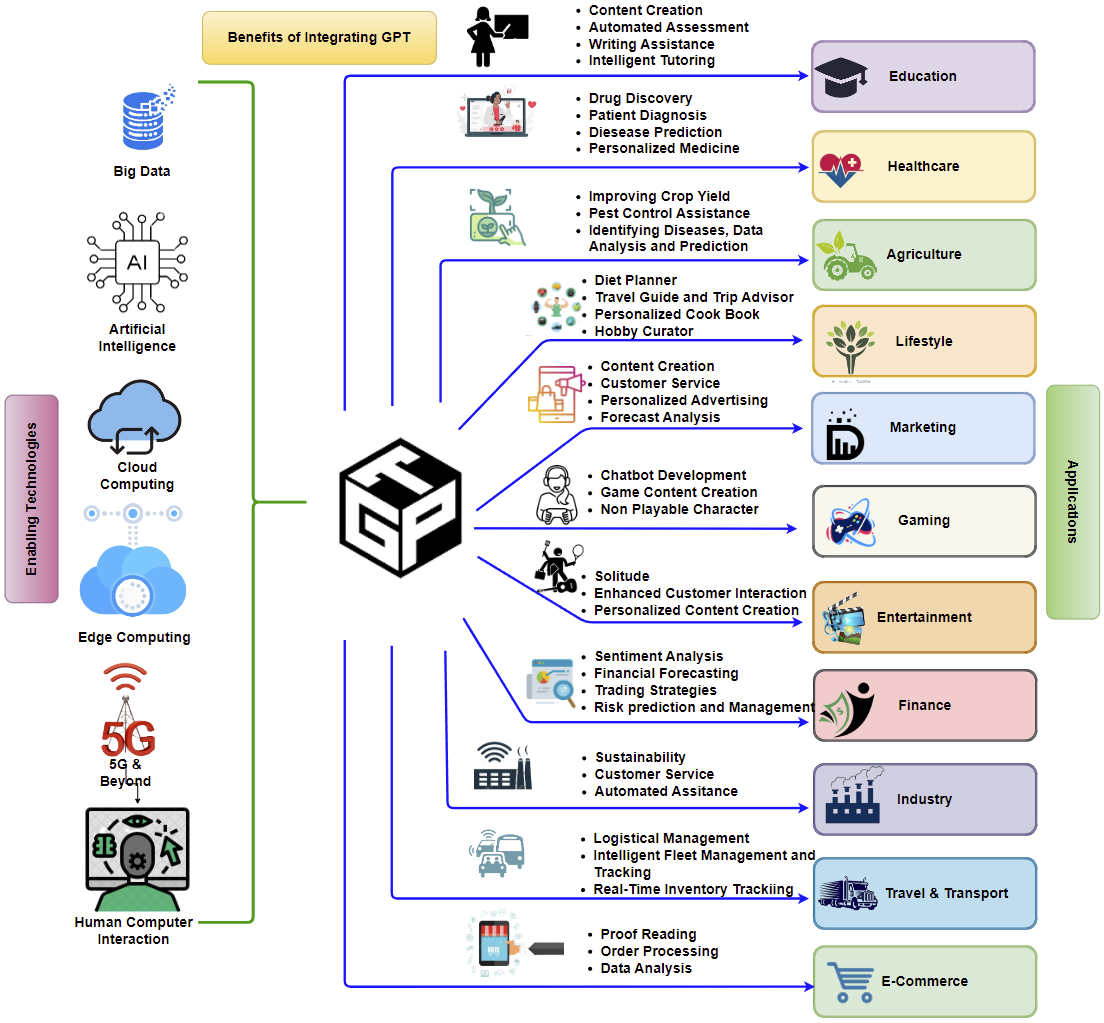

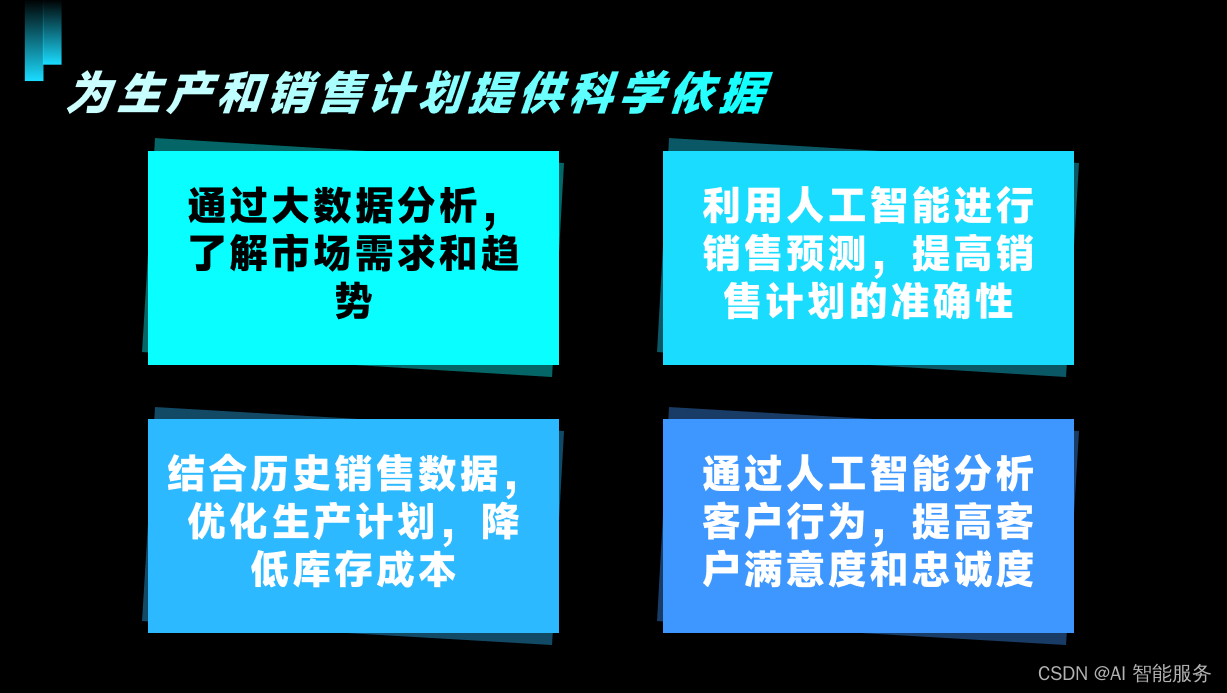

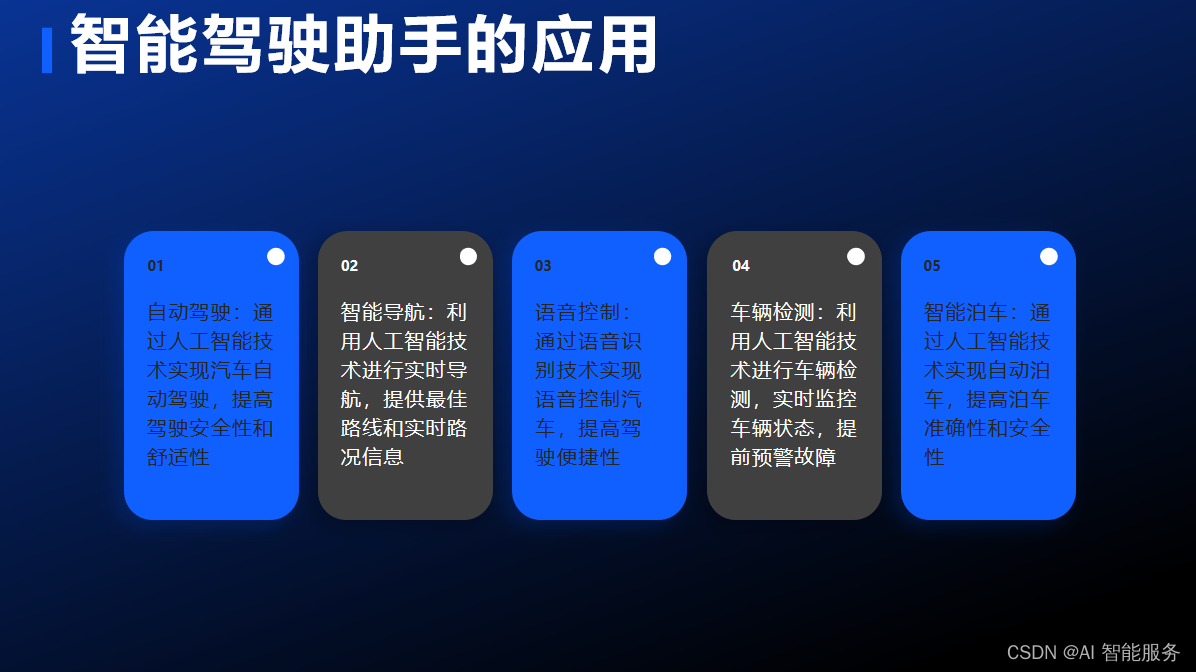

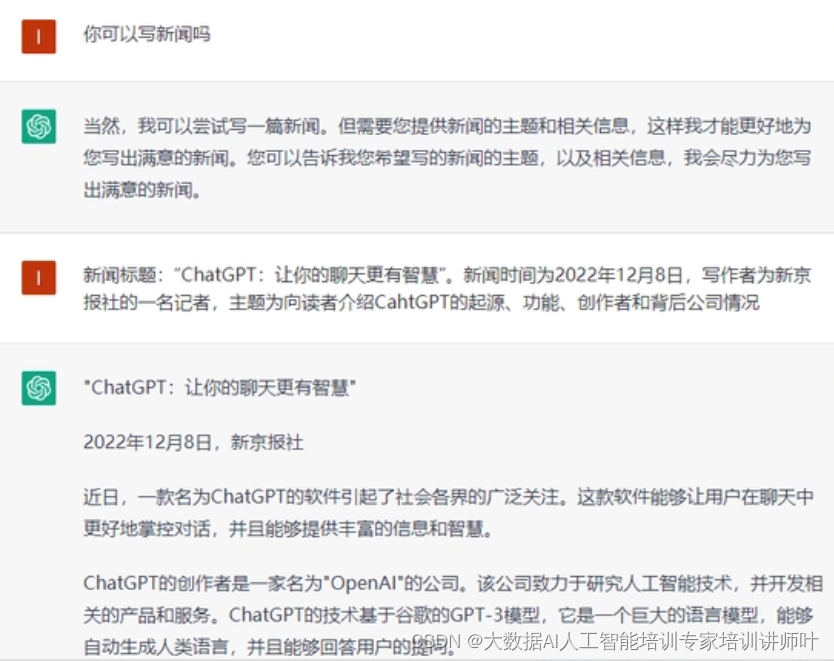

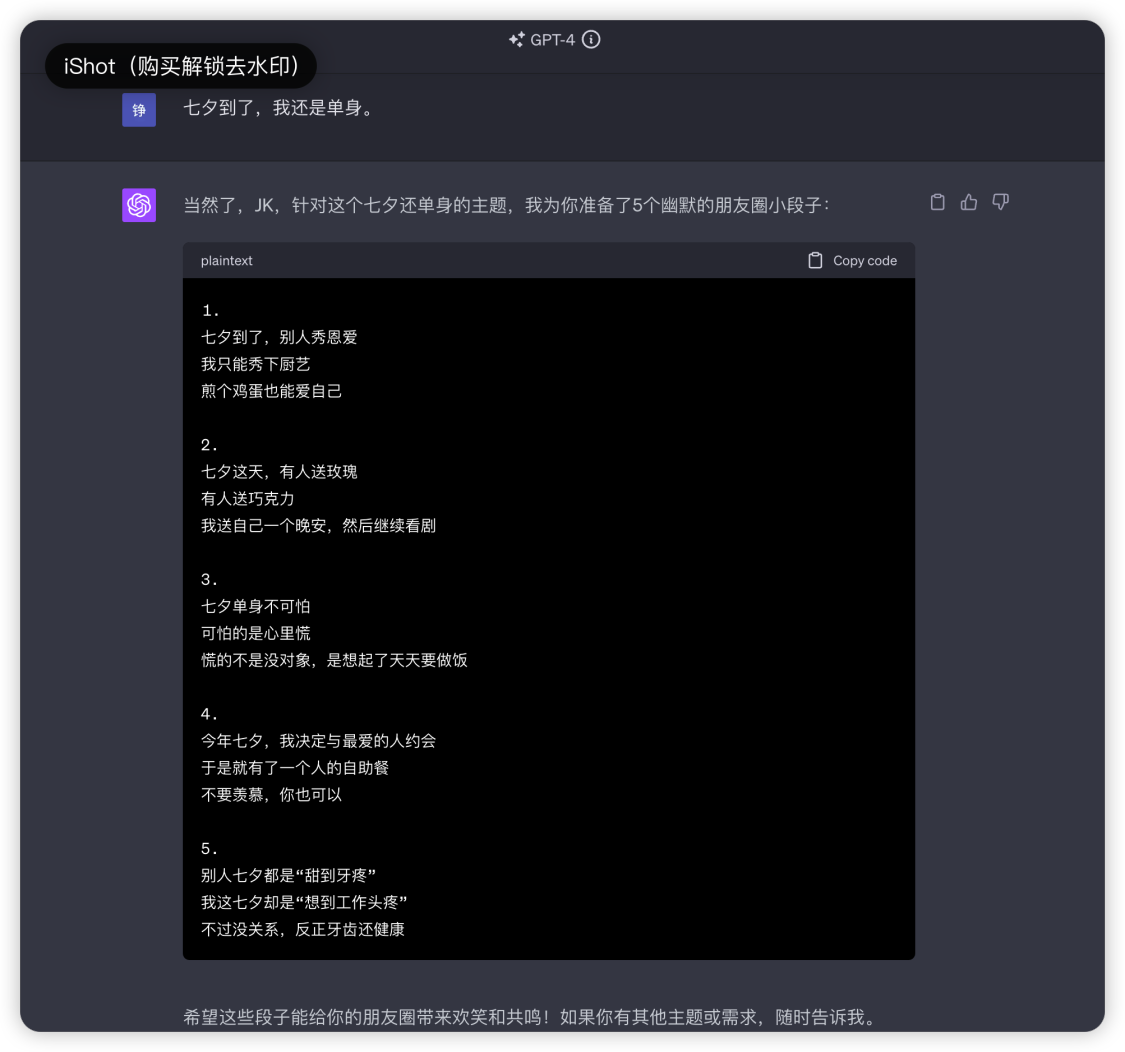

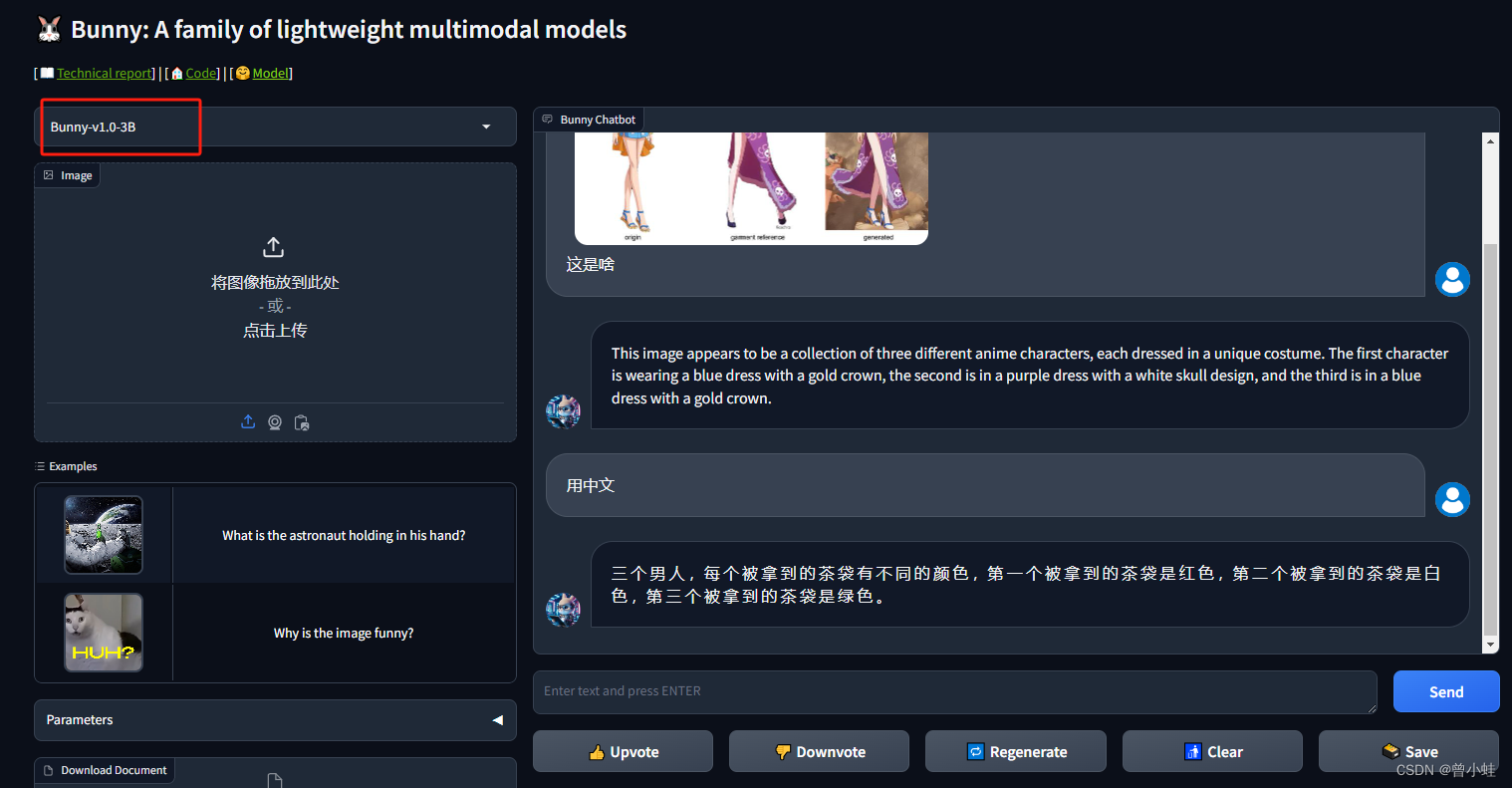

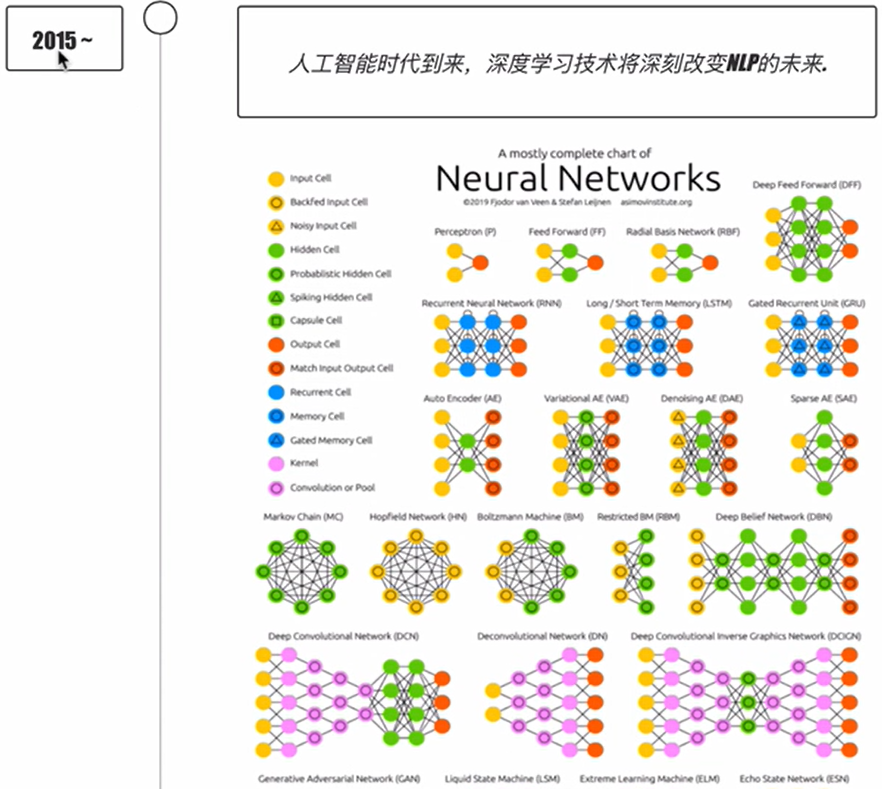

2024/4/11 14:03:16使机器能够胜任一些通常需要人类智能才能完成的复杂工作

人工智能简称AI,它是计算机科学的一个分支,这项技术的最终目的是为了模拟、延伸和扩展人的智能,使机器能够胜任一些通常需要人类智能才能完成的复杂工作,从而帮助人类更好、更快地发展,让人类过上更加美好幸福的生活。…

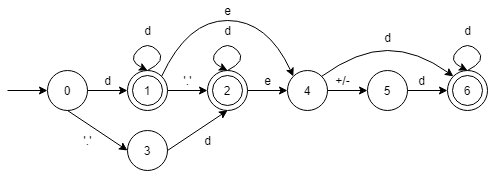

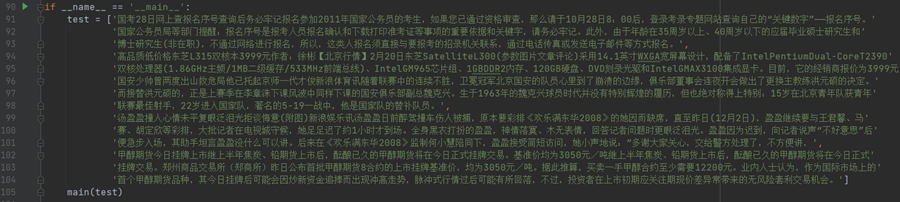

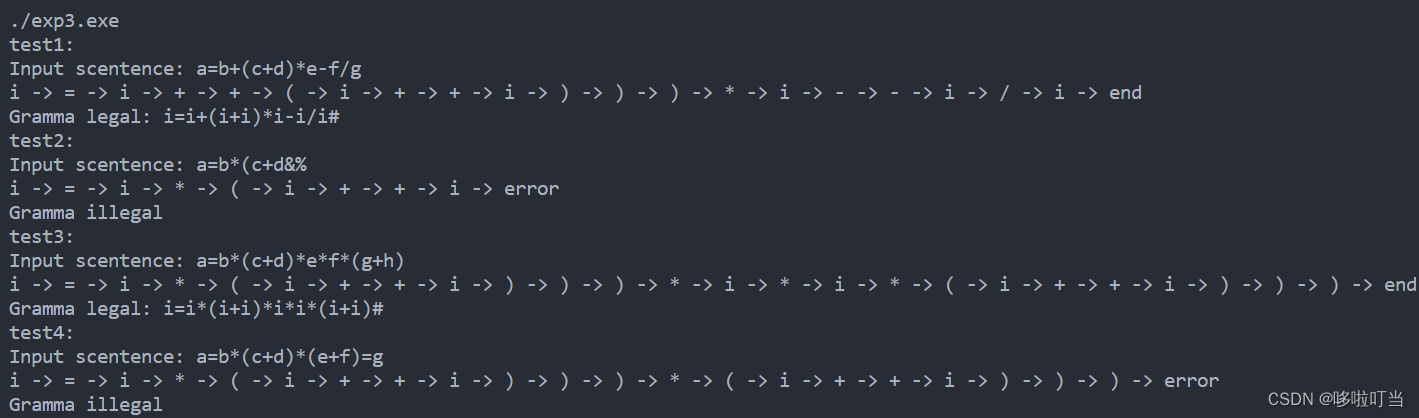

正则表达式python实现

目录引言语法代码实例引言

正则表达式,又称规则表达式,英语称为 Regular Expression,通常被用来检索、替换那些符合某个模式(规则)的文本,例如在以上任务中匹配身份证号或者电话号码,是在文本预处理过程中常用的技术。…

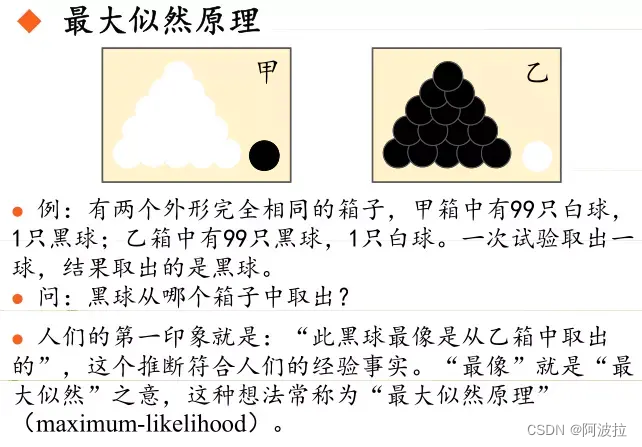

似然函数与极大似然估计

似然函数与极大似然估计

标签(空格分隔): ML

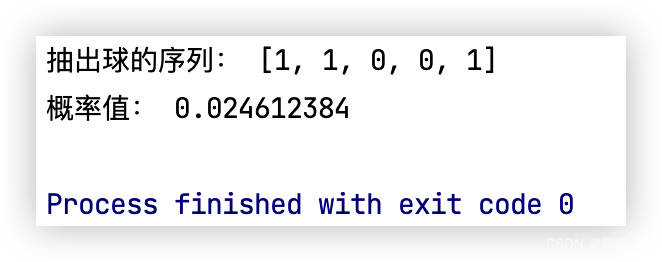

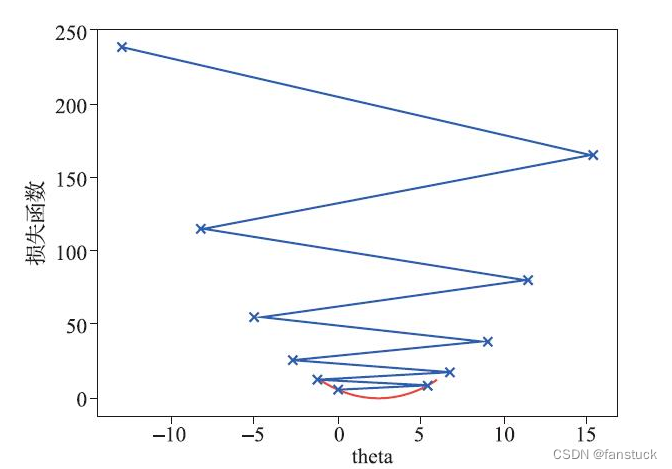

似然函数 随机变量XXX的概率分布已知,但是这个分布的参数是未知的,需要我们去估计,我们把他记作θ\thetaθ,好比在抛硬币的试验中,硬币…

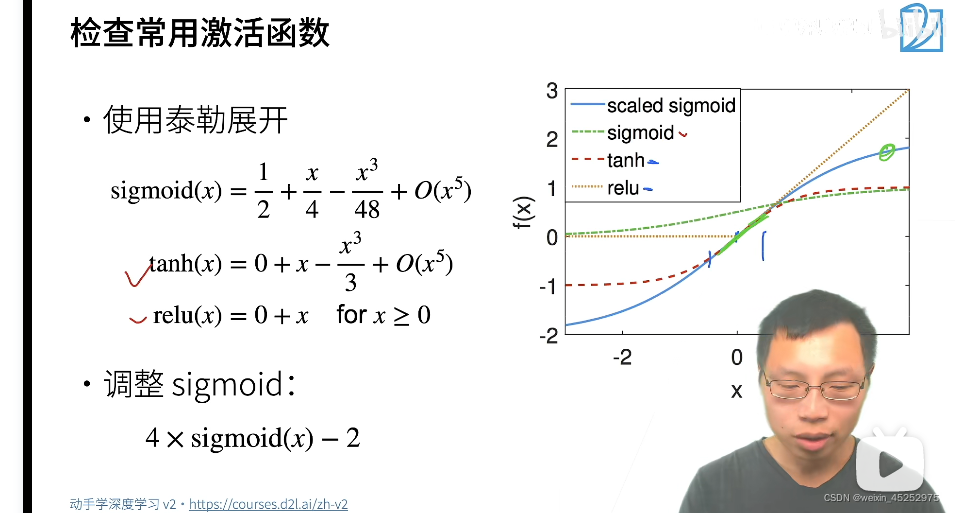

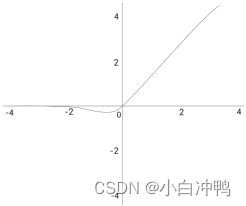

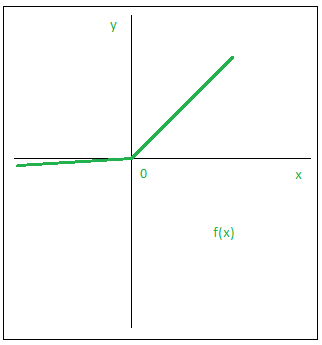

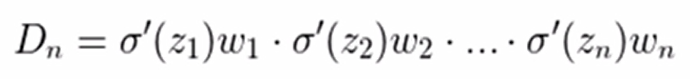

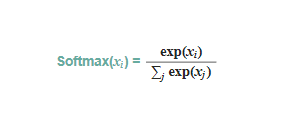

Sigmoid函数求导

Sigmoid函数求导

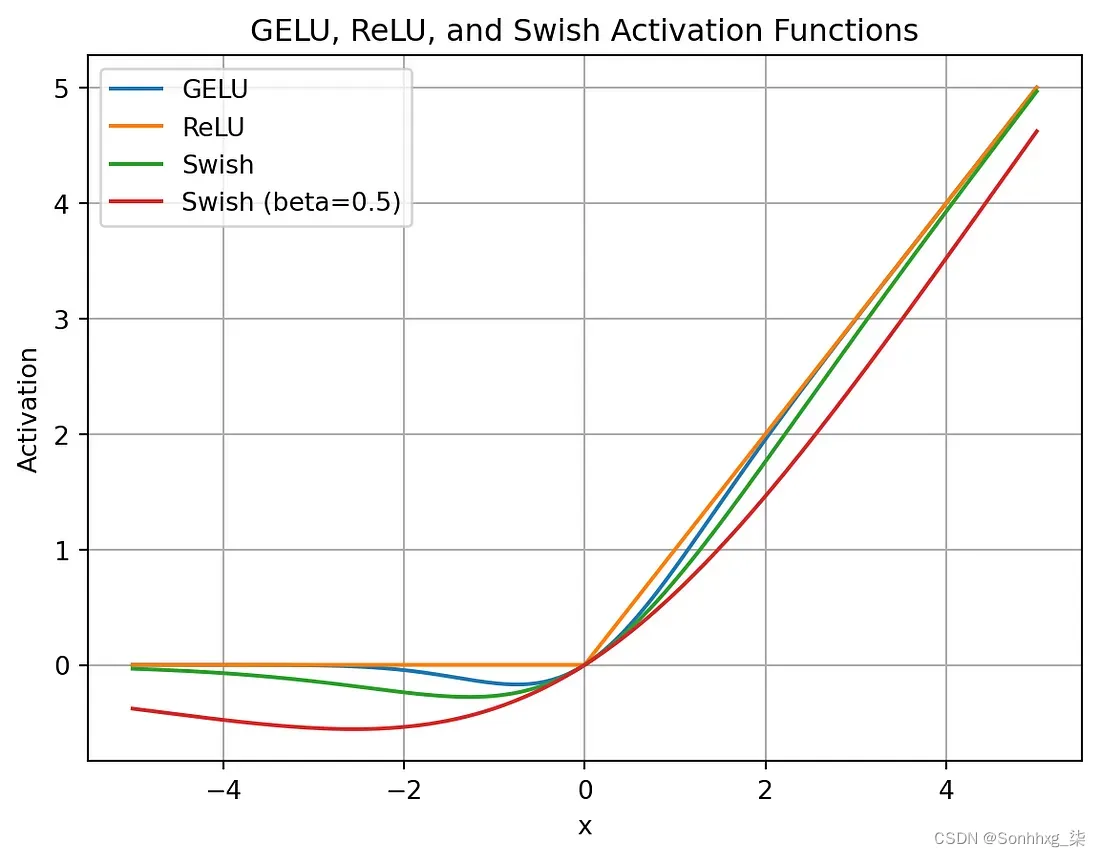

标签(空格分隔): ML sigmoid函数是神经网络中常用的激活函数之一,其定义为 σ(x)11e−x\sigma(x) \frac{1}{1 e^{-x}}σ(x)1e−x1 该函数的定义域为(−∞,∞)(-\infty,\infty)(−∞,∞),值域为(0,1)(0,1)(0,…

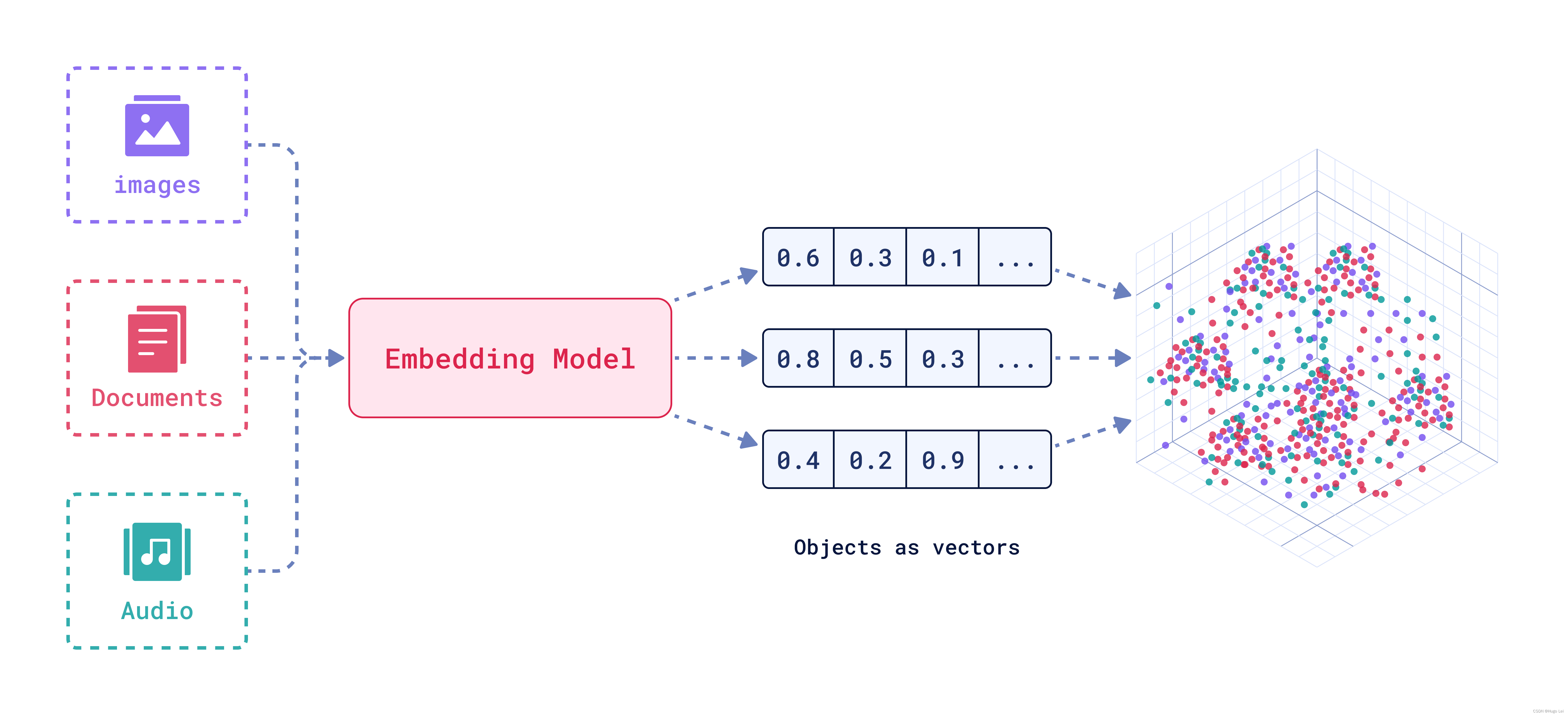

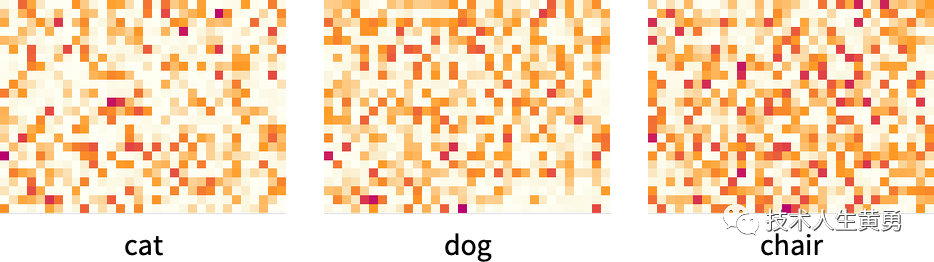

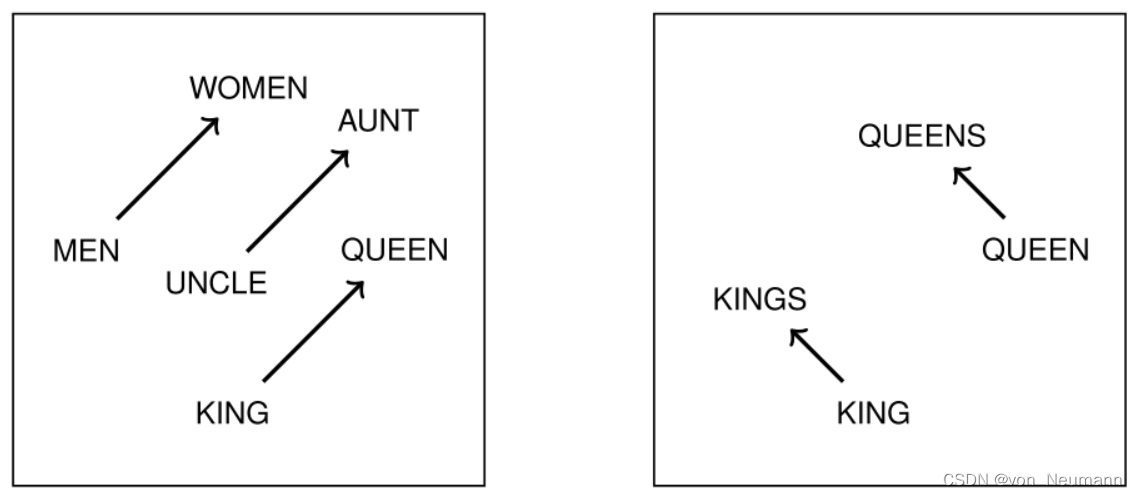

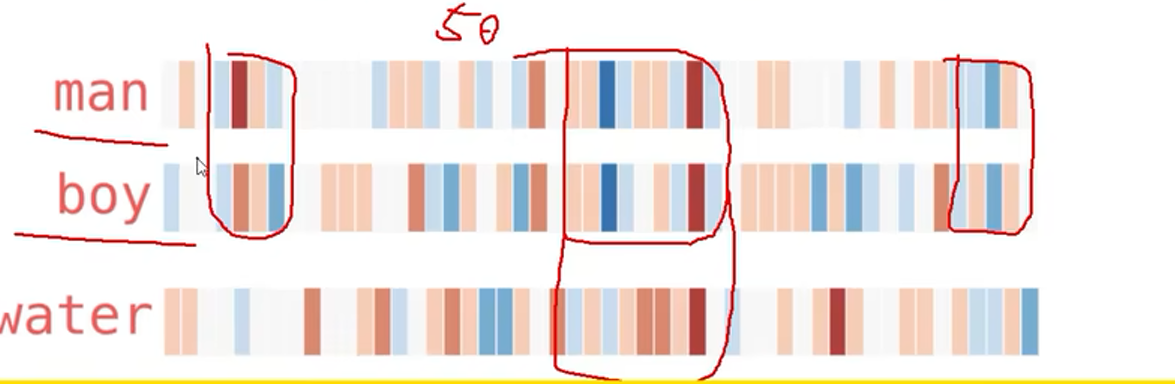

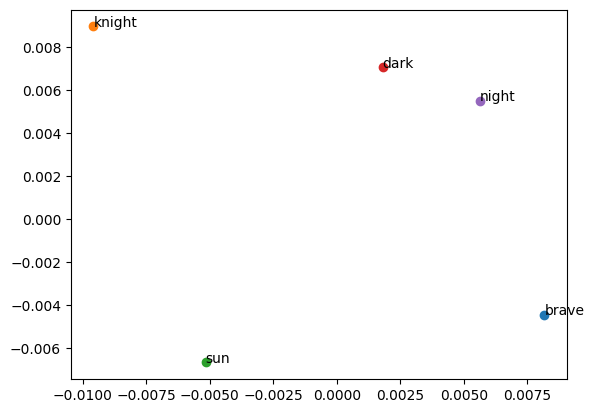

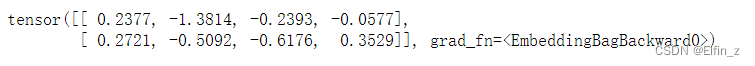

分布式表示和分布表示

标签(空格分隔): 《基于深度学习的自然语言处理》阅读笔记 NLP 分布式表示 书上说:在分布式表示中,每个实体被表示为值的向量,并且实体的含义及其与其他实体的关系由向量中的激活以及不同向量之间的相似性来…

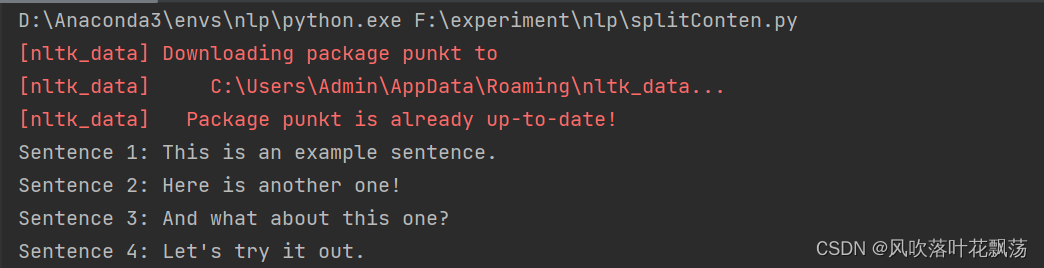

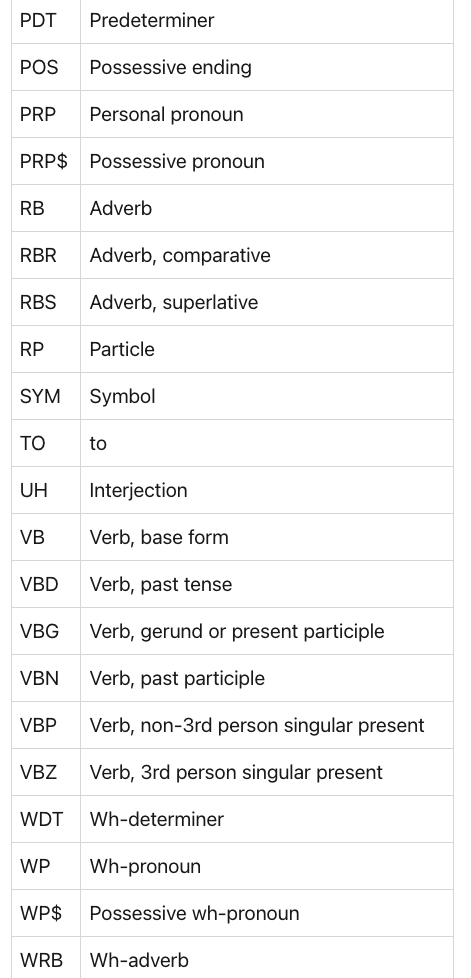

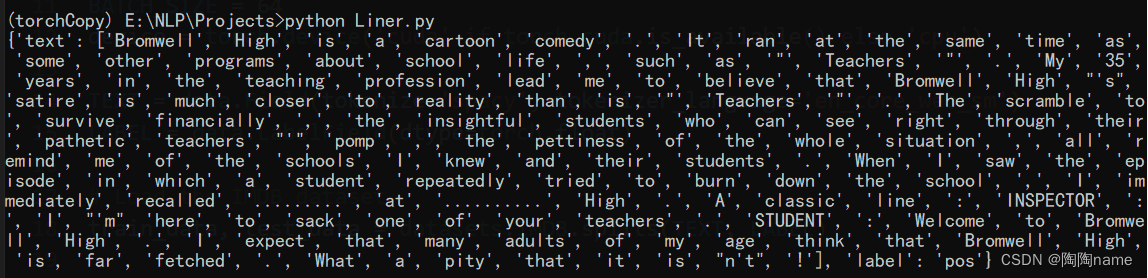

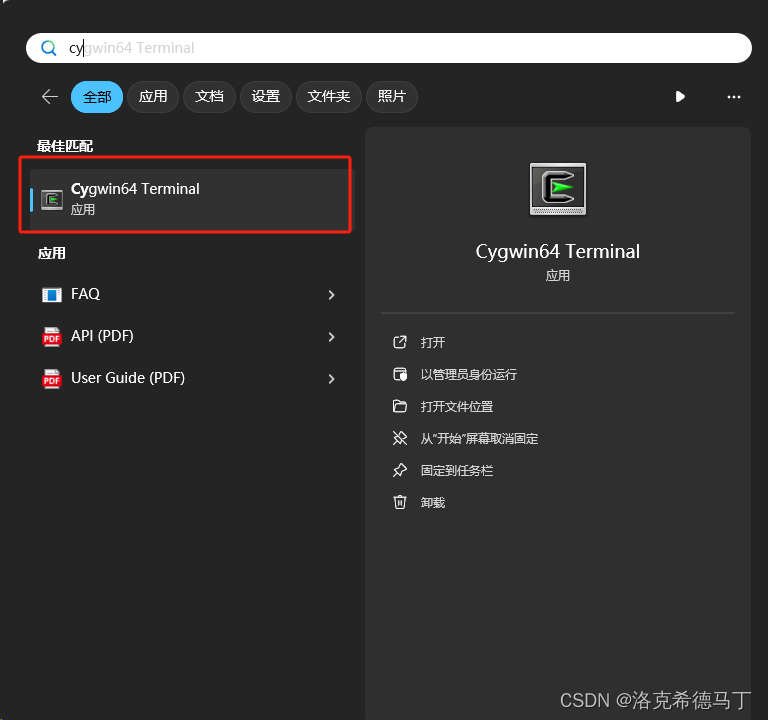

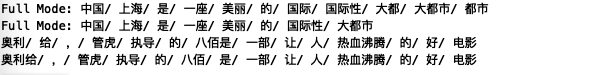

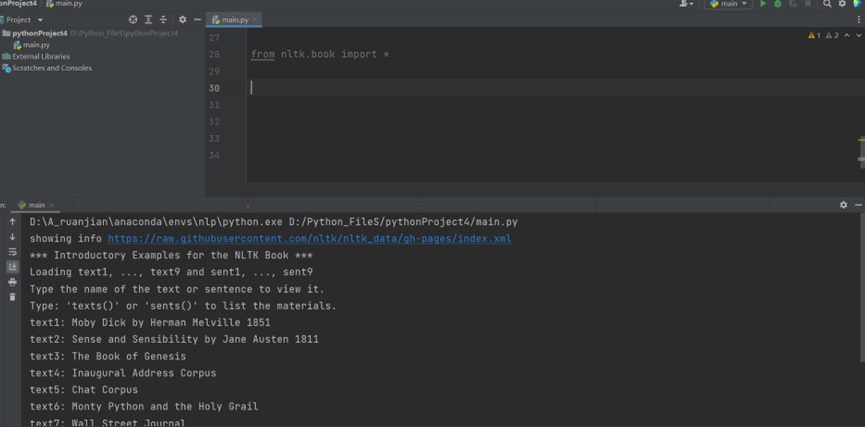

自然语言处理-chapter(1)--字符串操作

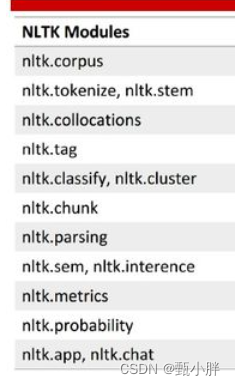

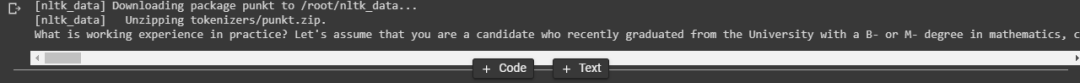

精通自然语言处理-chapter(1)–字符串操作 首先安装nltk包 sudo pip install nltk 安装完毕后 进入终端 下载nltk 数据源 >>> import nltk>>> nltk.download() 给定文本切分为语句 >>> import nltk

>>> from nltk.tokenize import sent_…

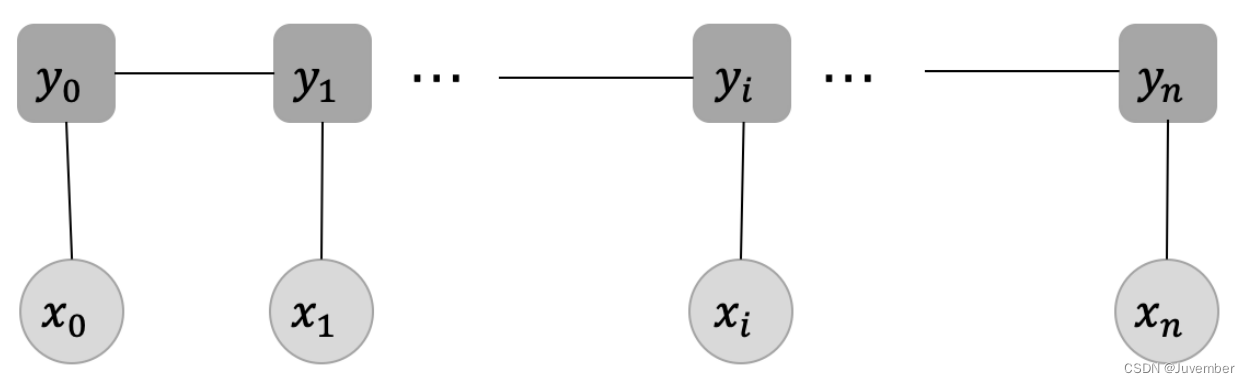

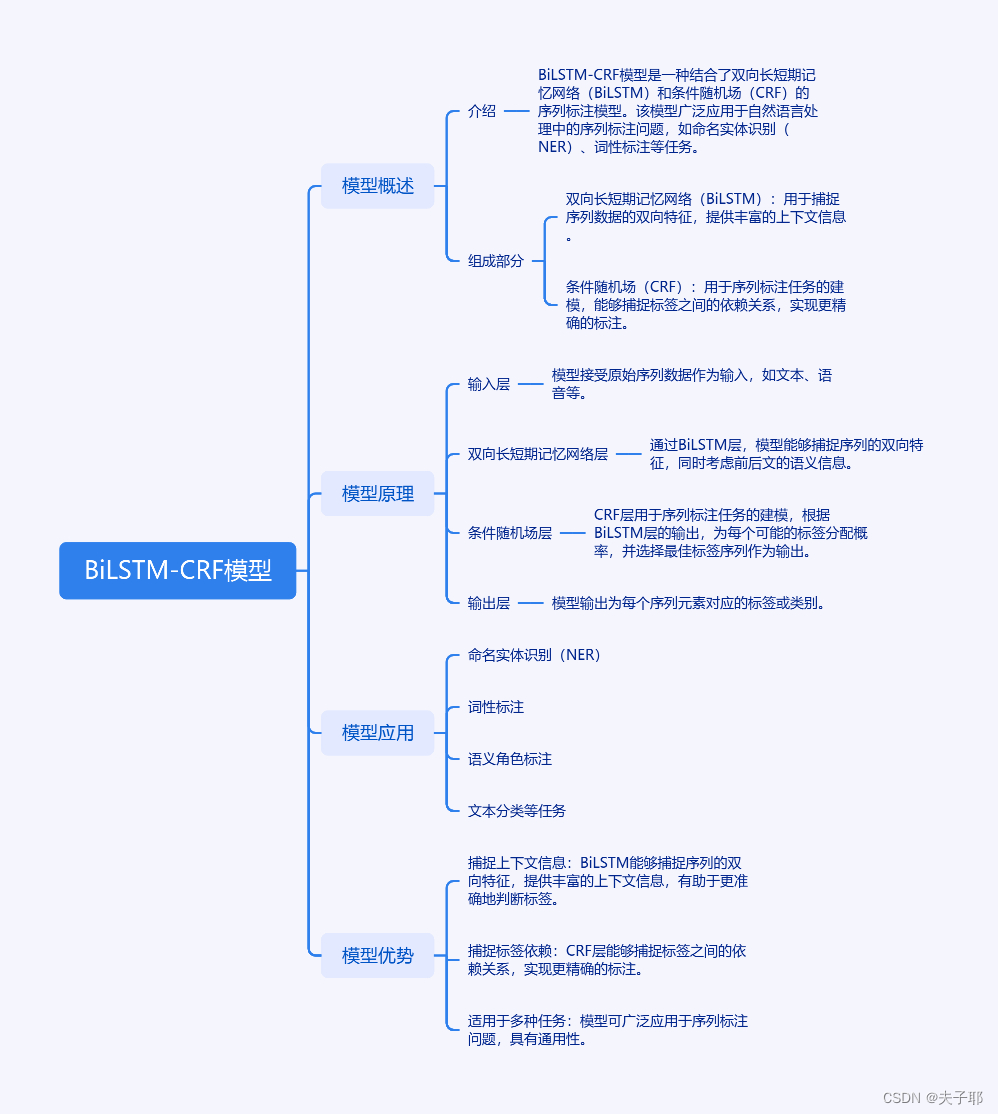

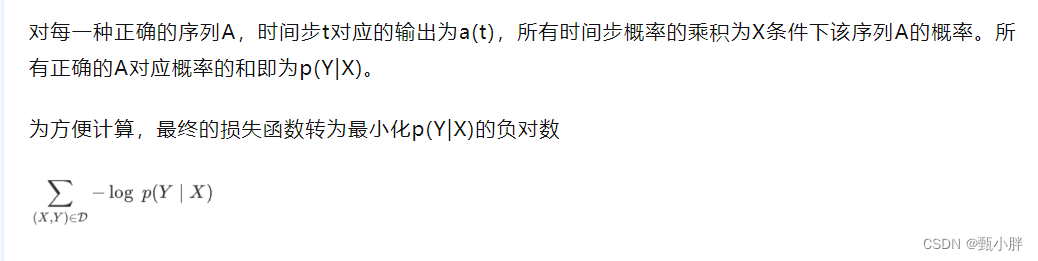

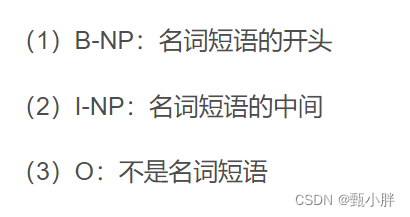

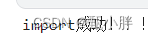

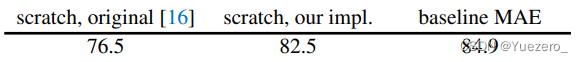

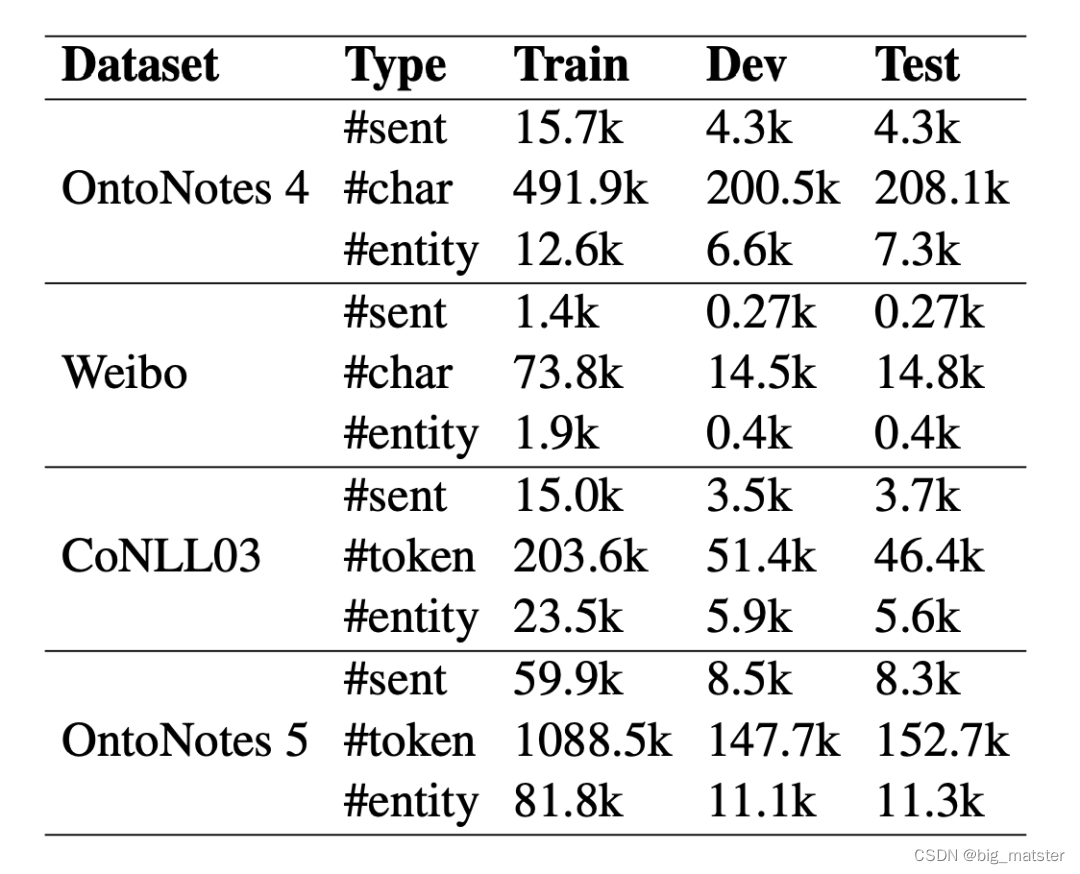

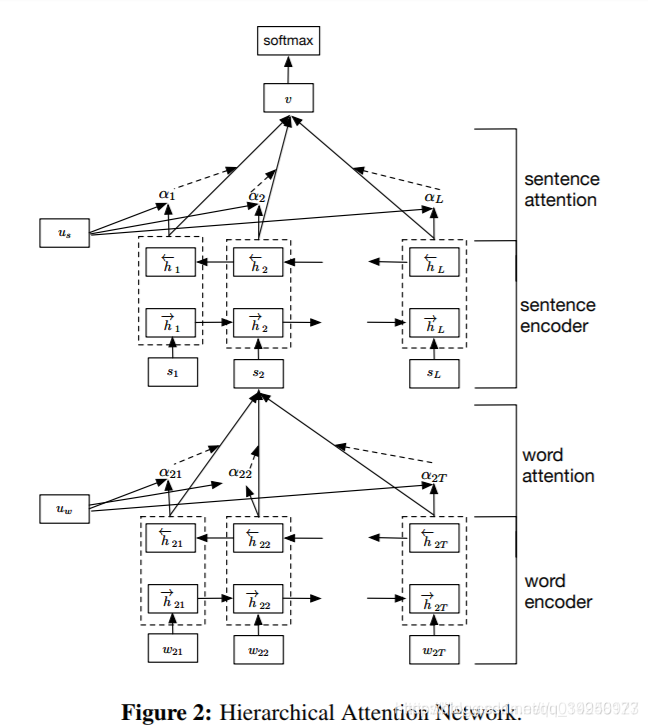

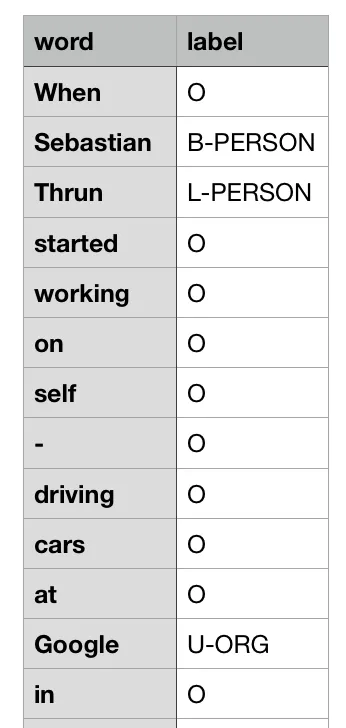

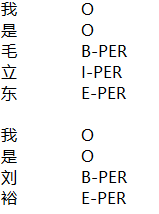

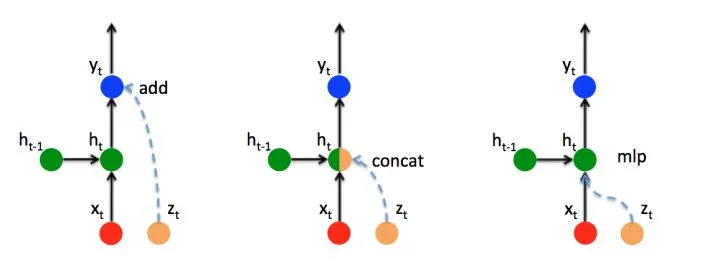

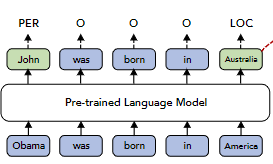

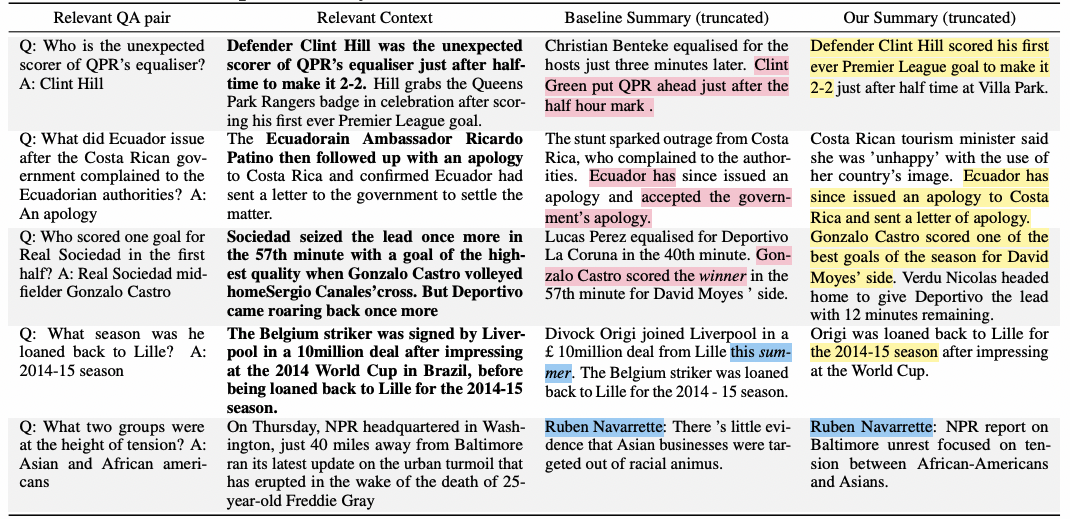

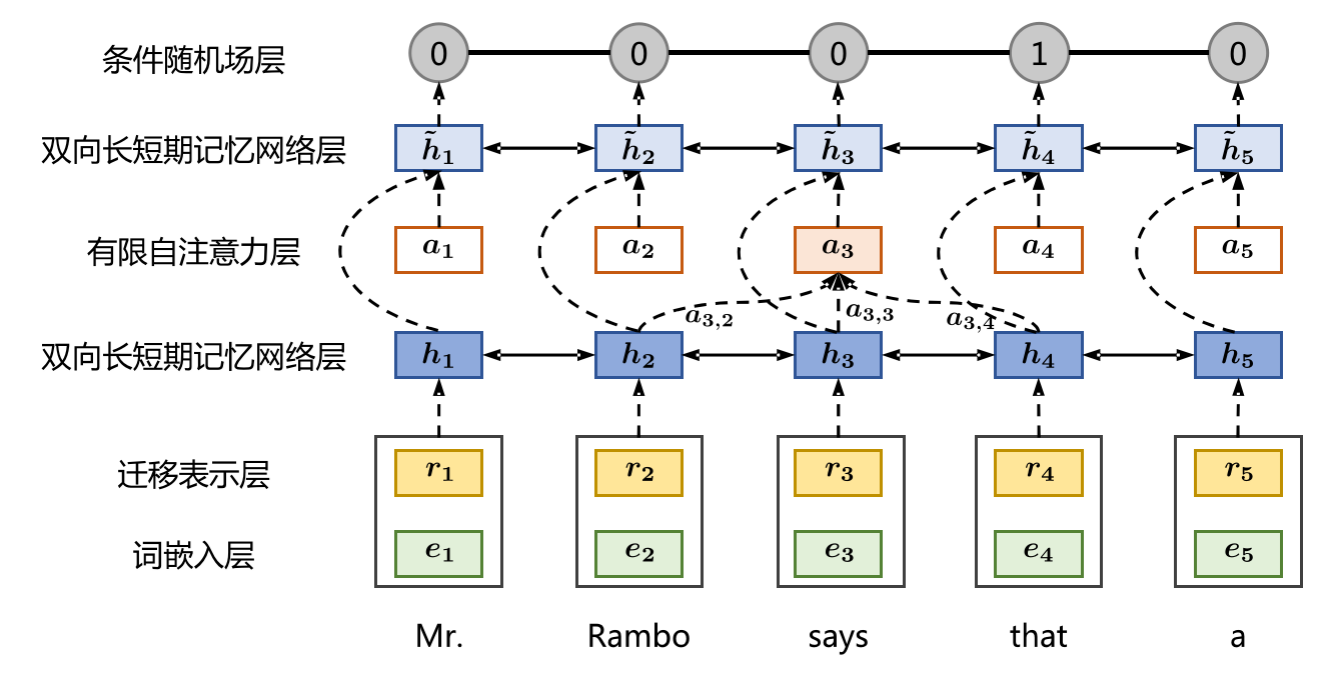

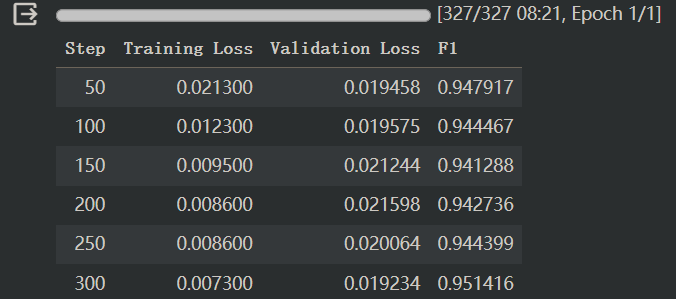

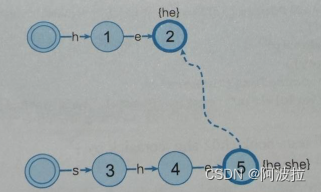

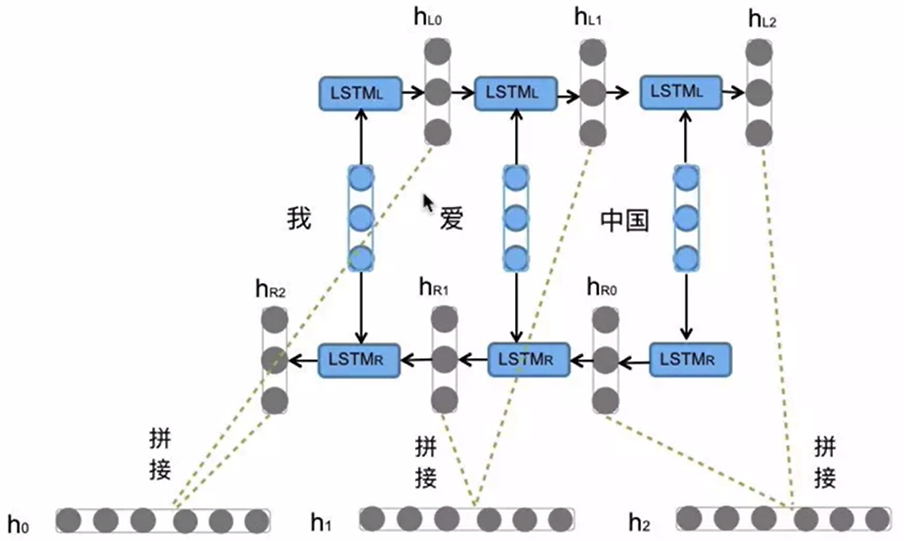

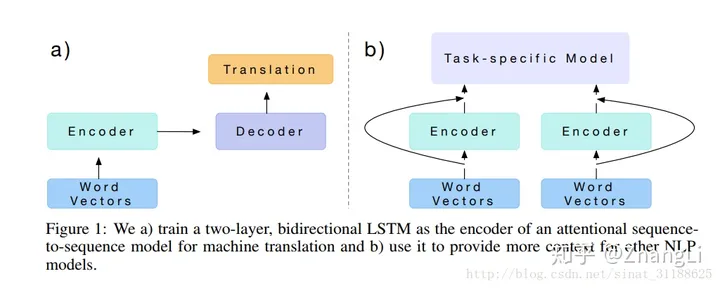

【论文学习】BiLSTM-CRF模型及pytorch代码详解

Bidirectional LSTM-CRF Models for Sequence Tagging

用于序列标注的双向LSTM-CRF模型

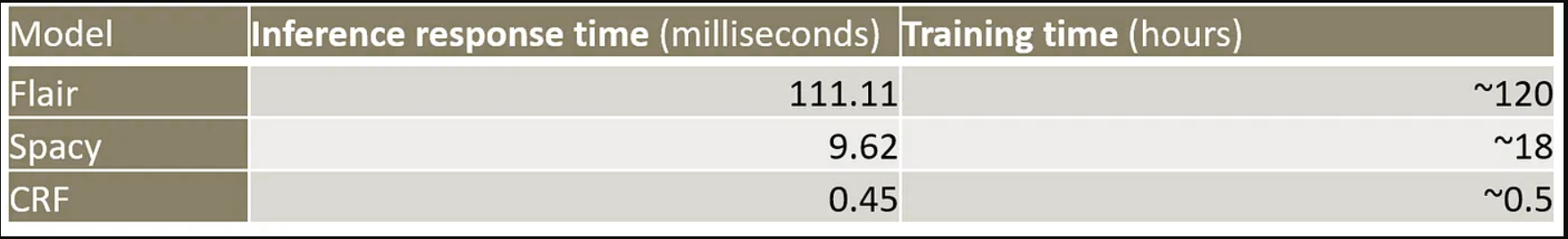

序列标注问题输入为特征序列,输出为类别序列。 大部分情况下,标签体系越复杂准确度也越高,但相应的训练时间也会增加。因此需要根据实际情况选择合适的…

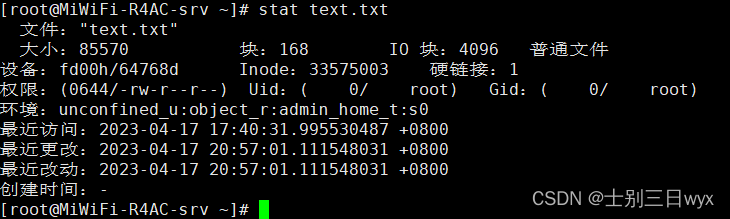

2021年9月22号,实战烧写树莓派sd卡的系统

1.下载格式化u盘的软件,软件地址,阿里云盘地址:https://www.aliyundrive.com/s/ux2re9FFxd2 2.将有sd卡的读写盘插入电脑接口

3.打开软件,点击格式化即可格式化sd卡 4.下载ubantu系统镜像,以便等下烧写进入sd卡&…

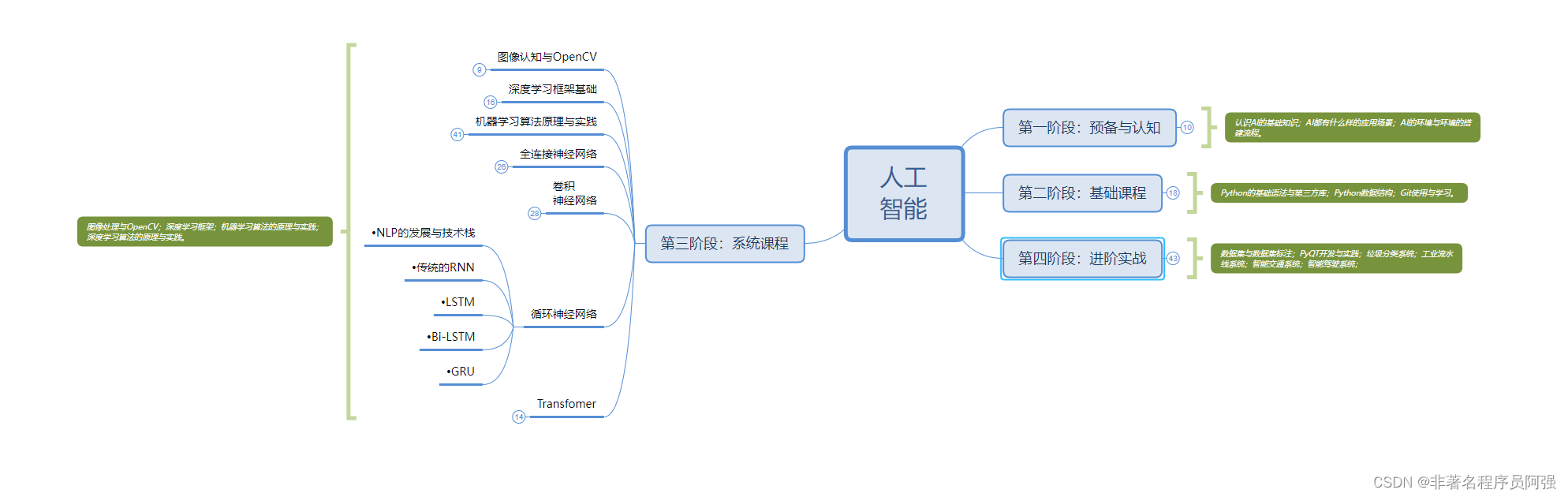

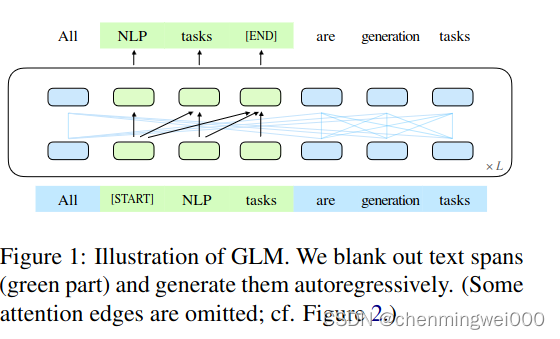

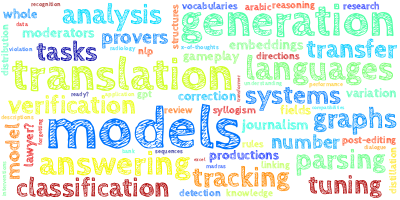

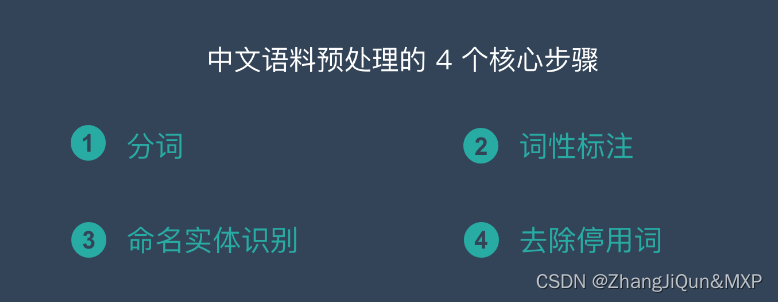

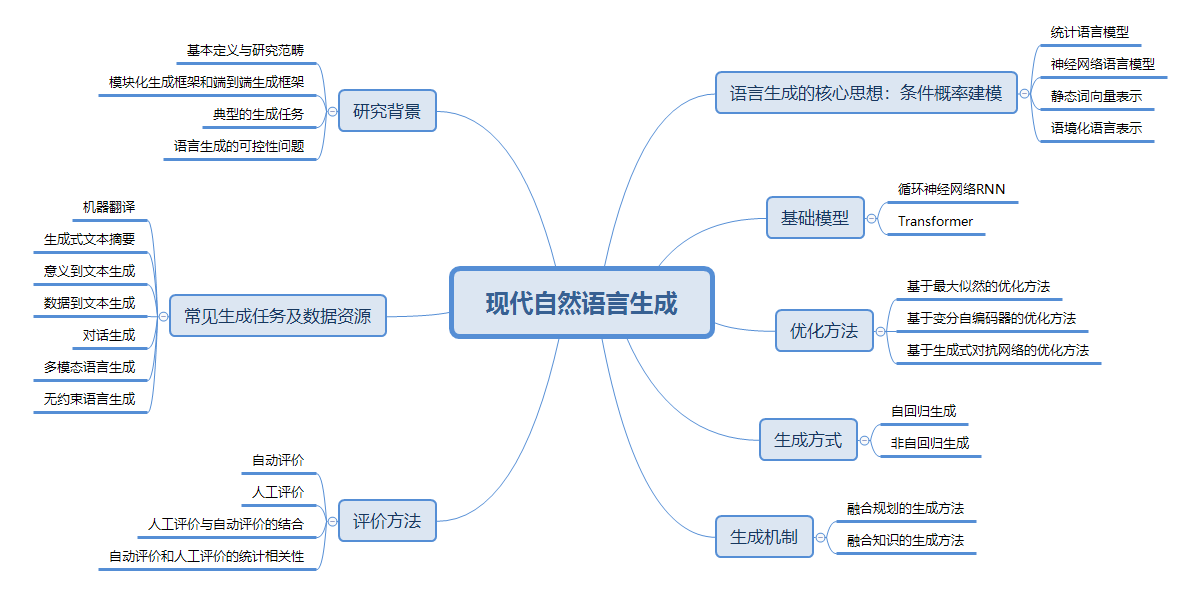

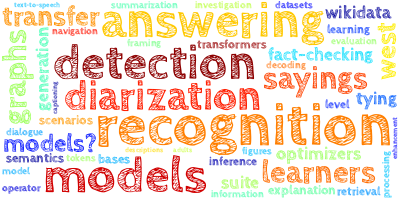

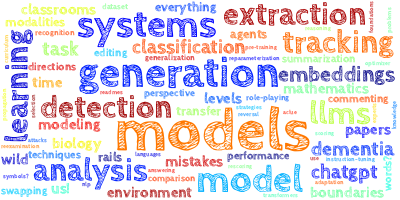

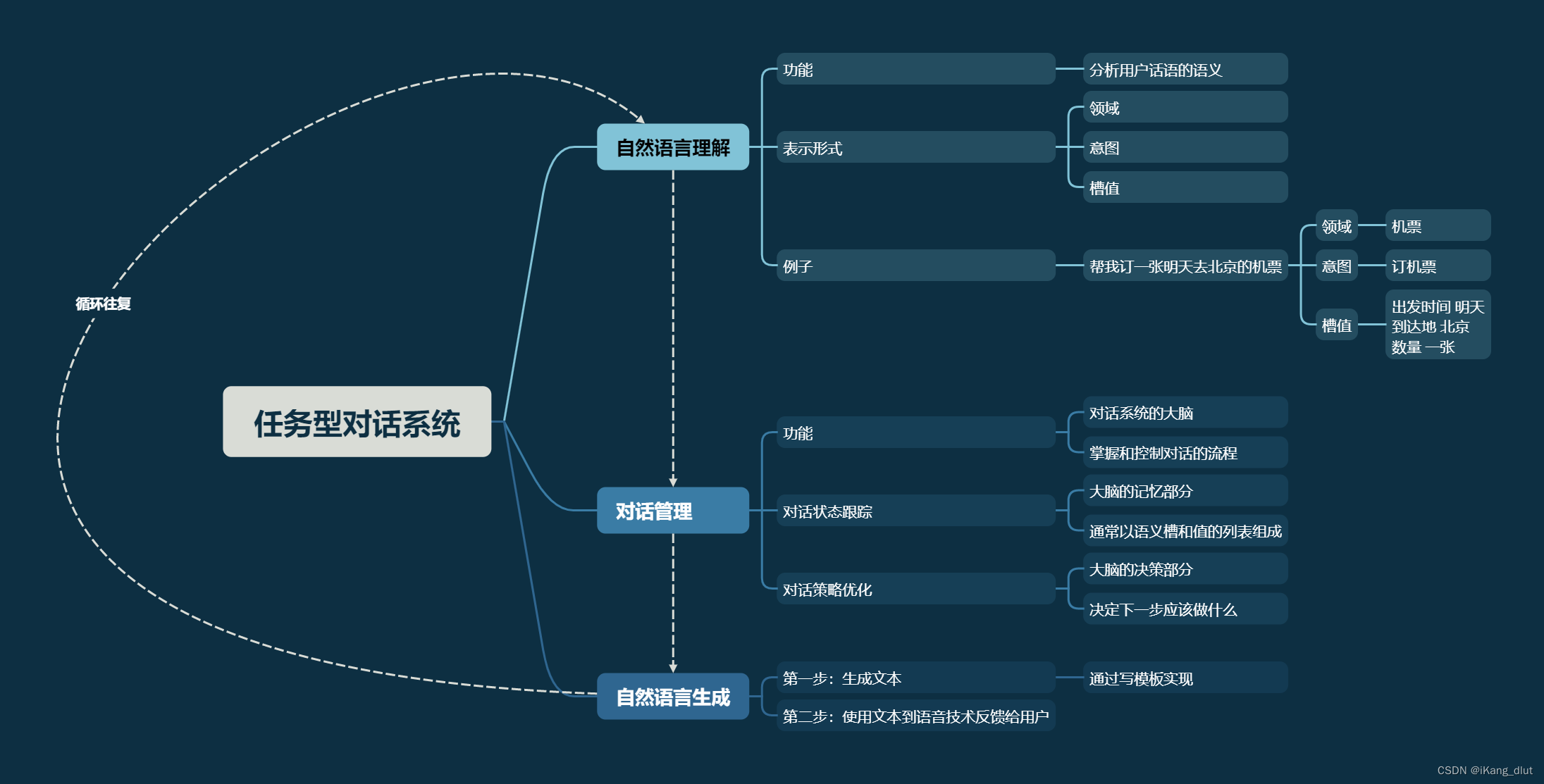

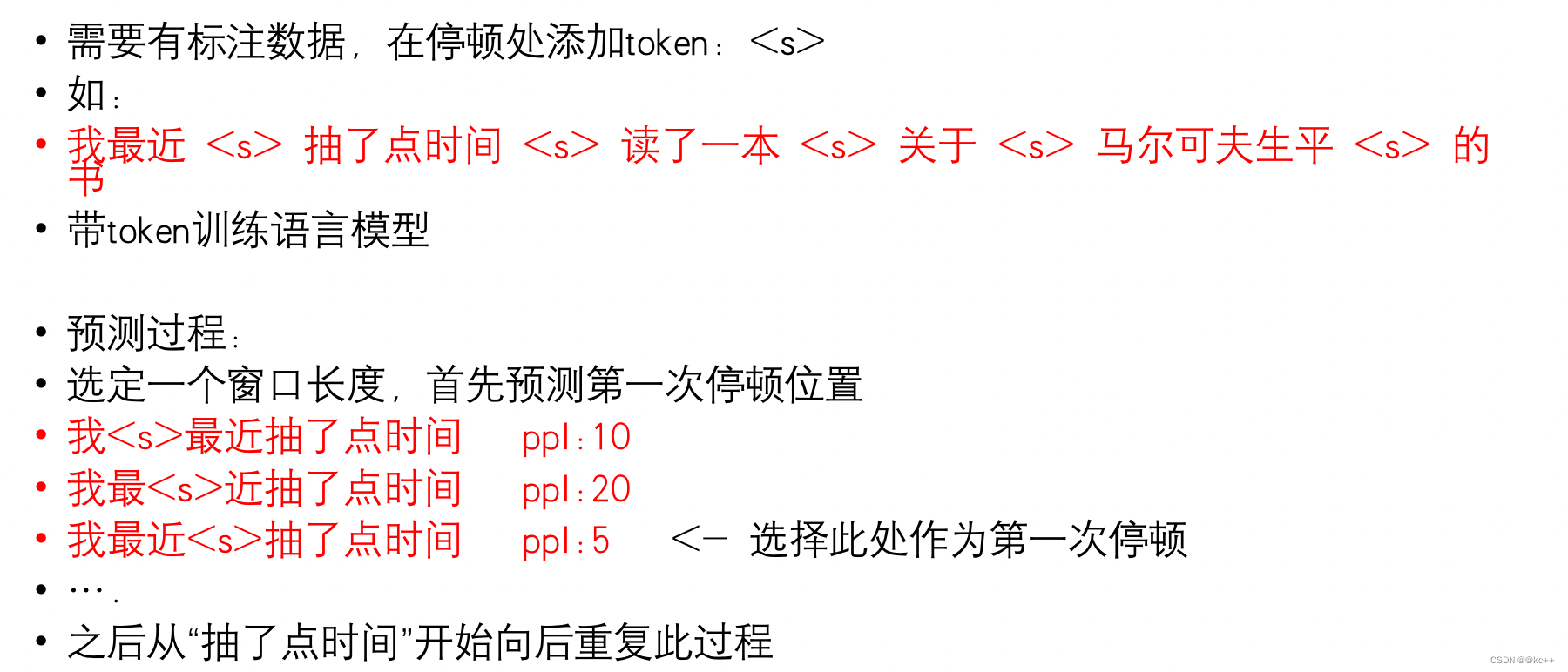

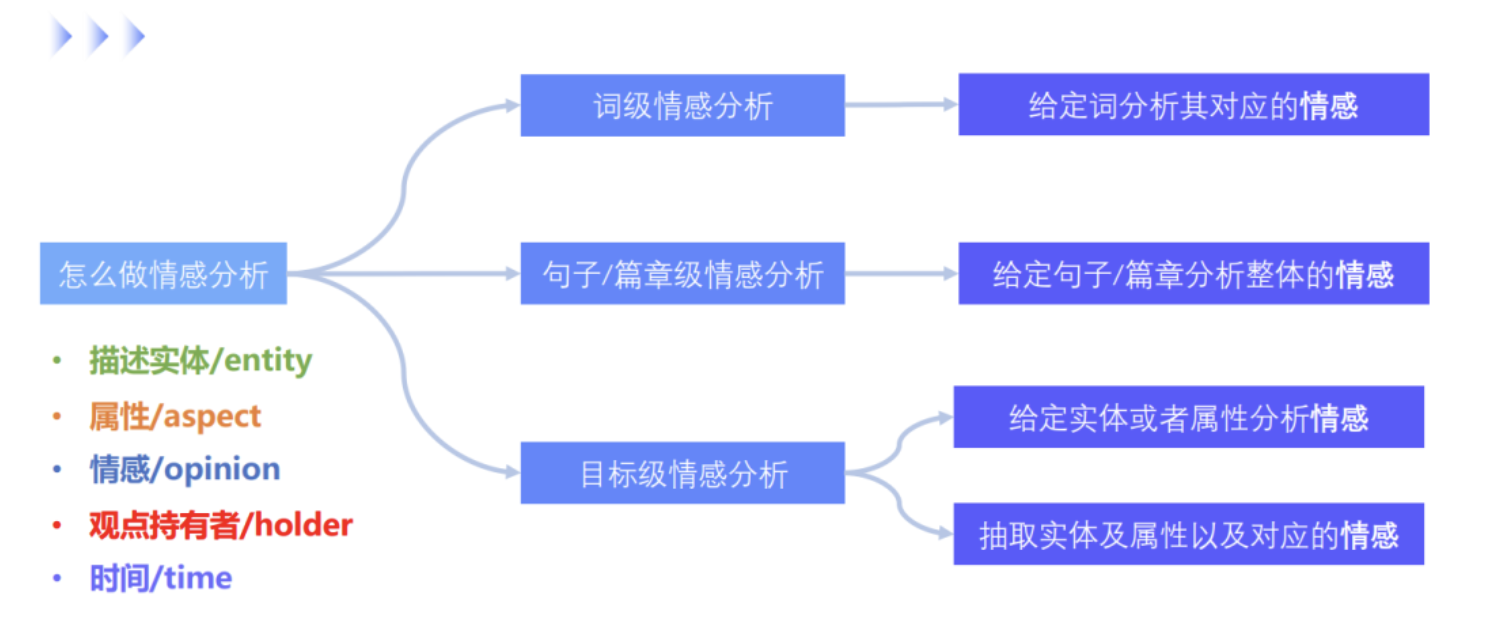

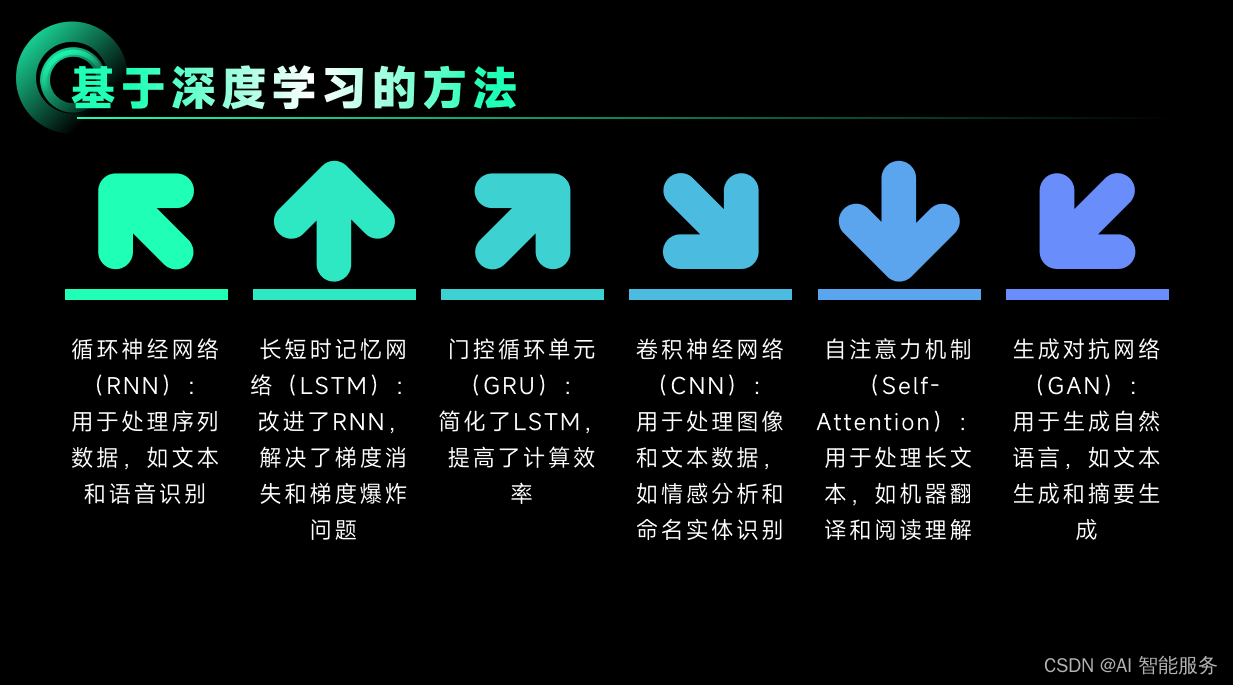

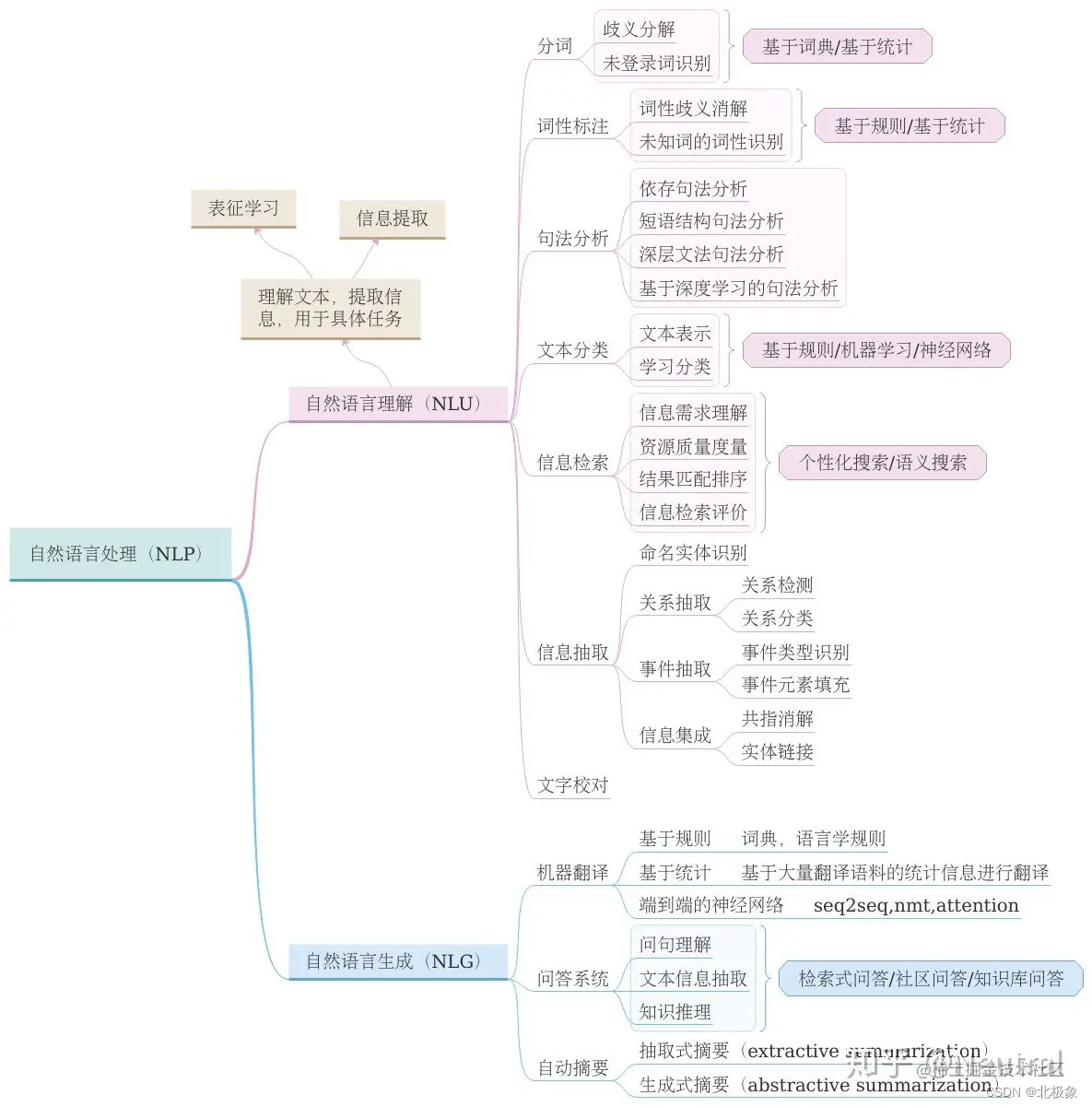

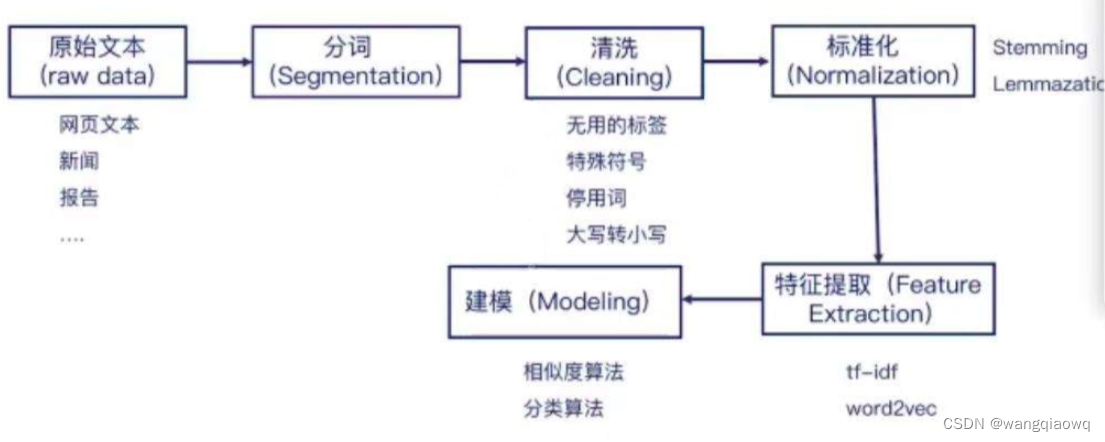

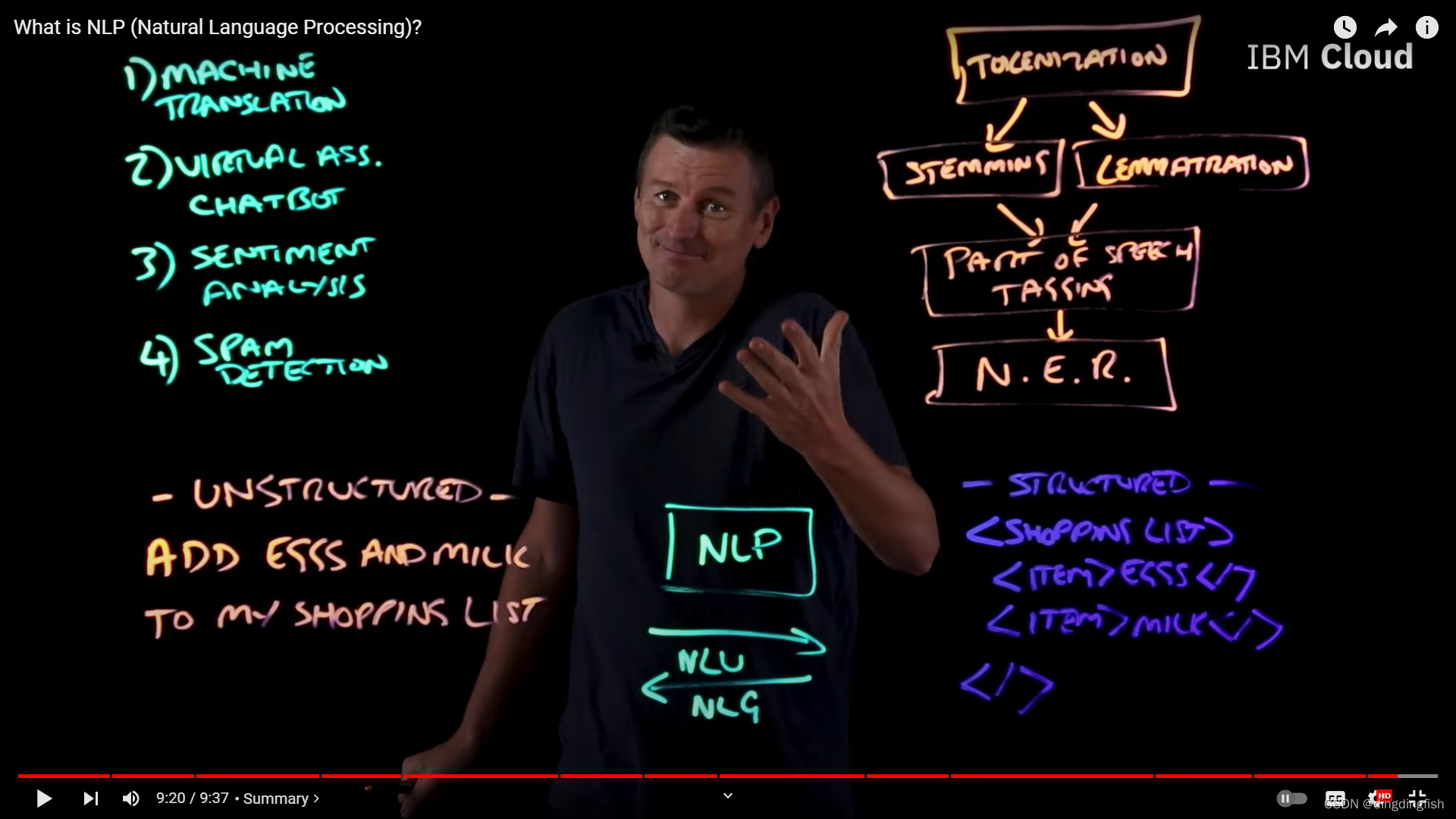

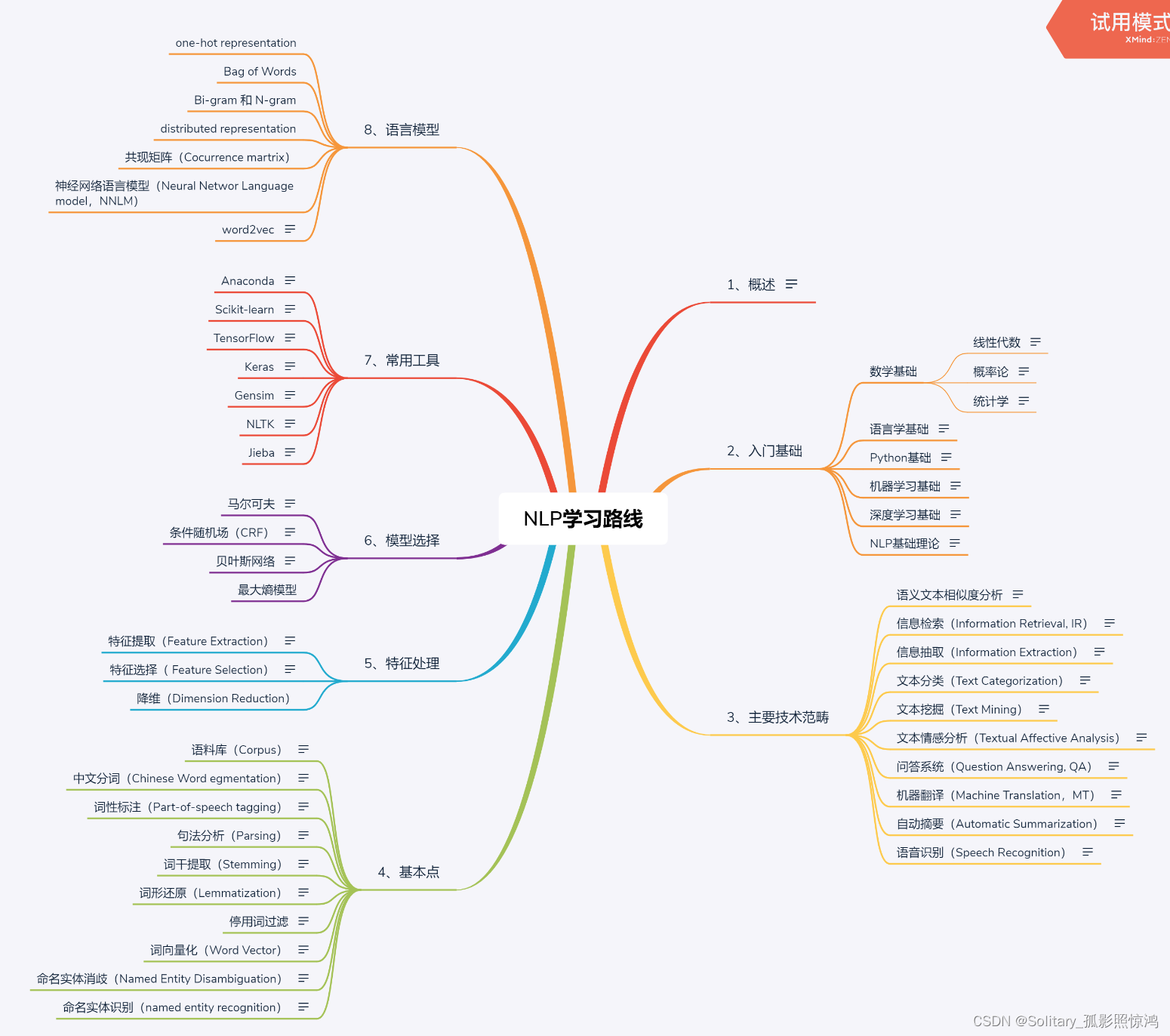

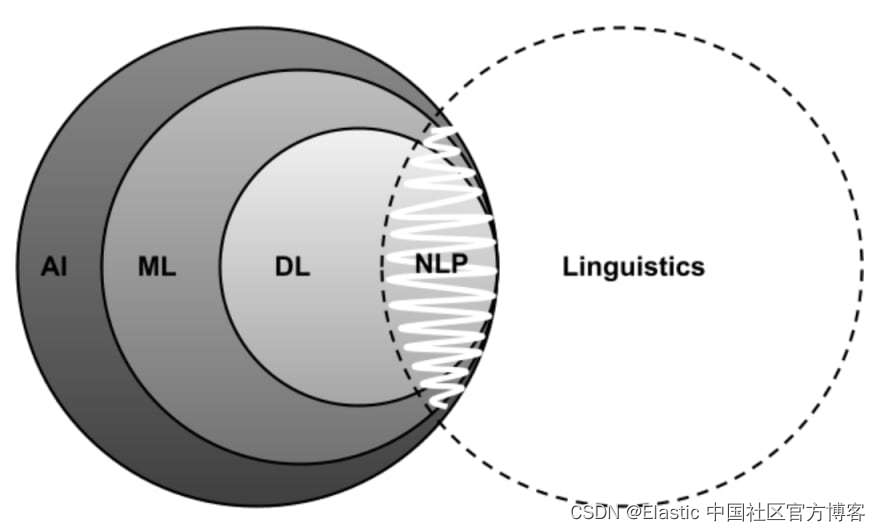

自然语言处理NLP概论

文章目录1 什么是NLP1.1 NLP的两大任务1 NLU 自然语言理解2 NLG 自然语言生成1.2 NLP的发展和技术路线1 基于传统机器学习的NLP流程2 基于深度学习的NLP流程3 方法路线1.3 目前研究方向2 词法分析(Lexical Analyse)2.1 分词1. 为什么需要分词?…

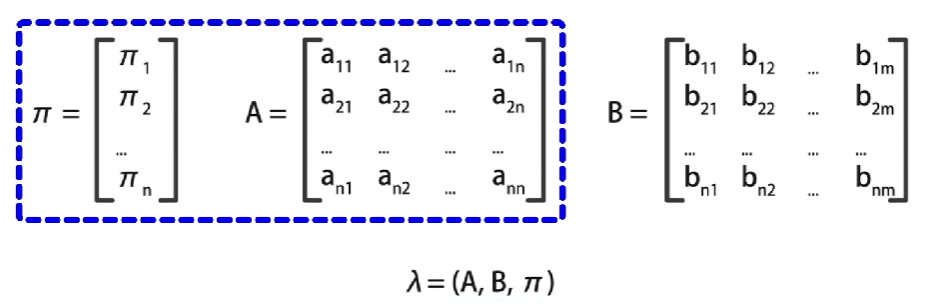

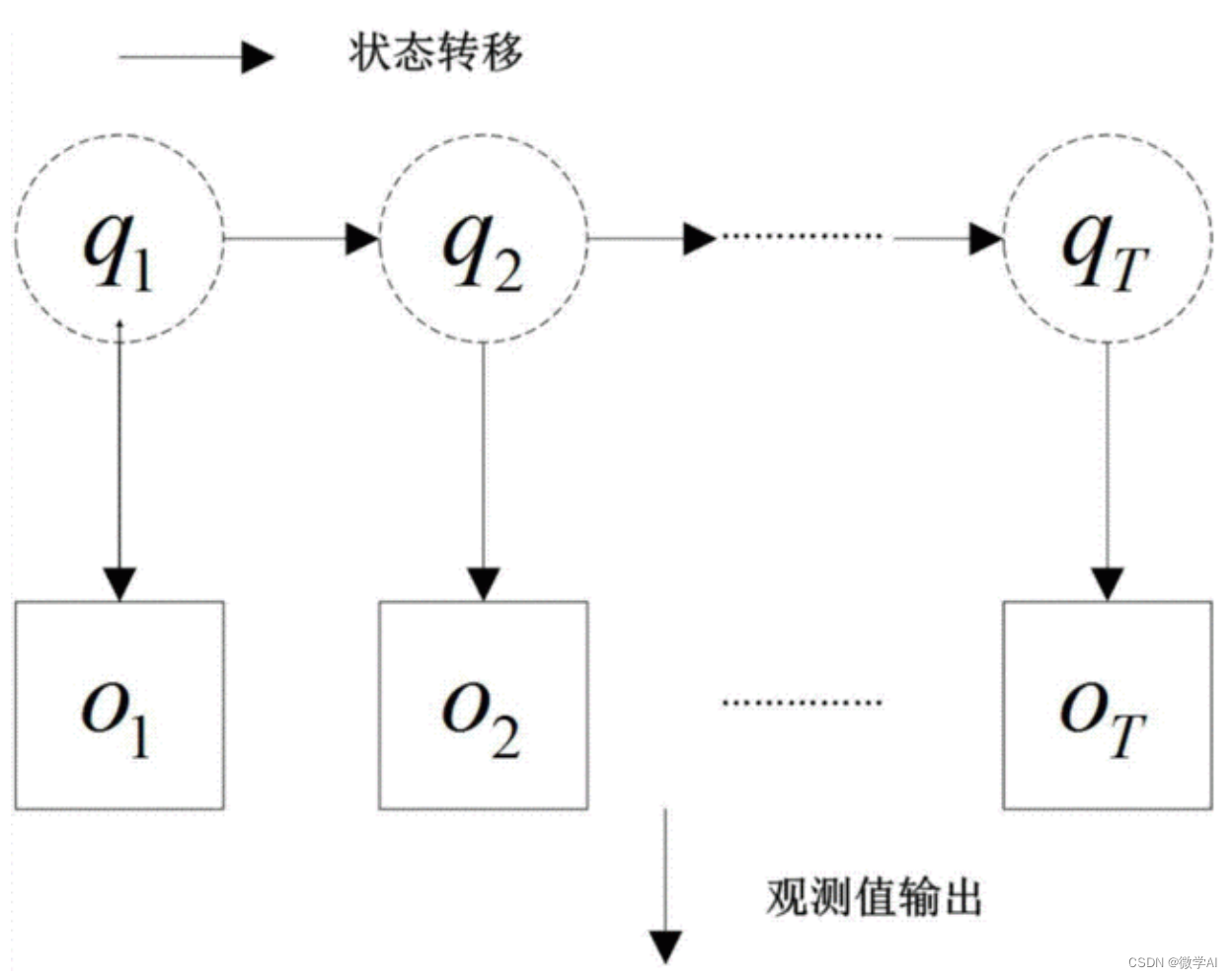

条件随机场(CRF)——2 CRF、HMM、LR的比较

1 HMM & CRF

1.1 HMM是生成模型,CRF是判别模型。

生成式模型根据大量的标注数据,计算联合分布,在通过联合分布计算条件概率进行分类,这就是生成模型的基本思想,而判别式是直接对条件概率进行建模。

CRF就像一个…

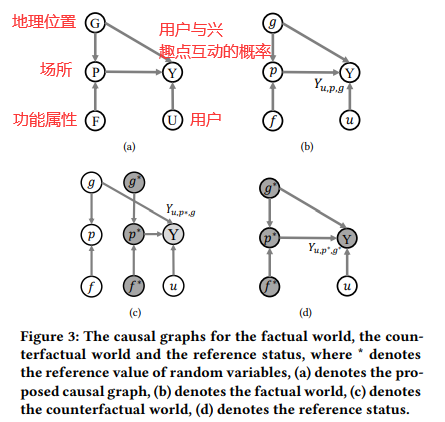

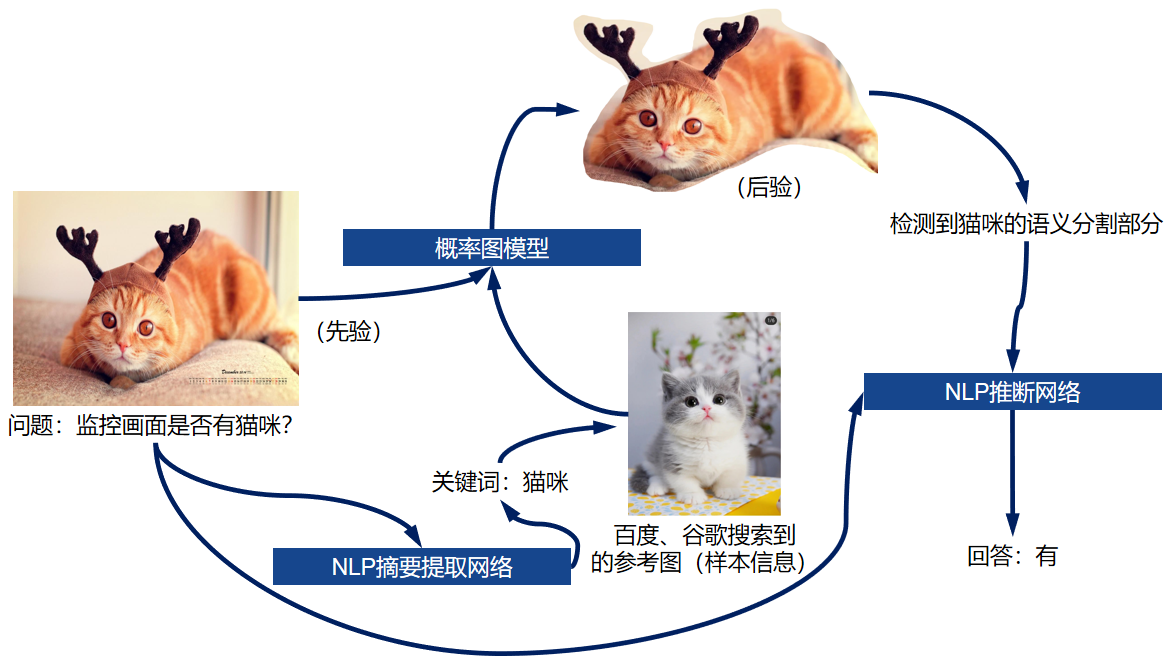

pgm模型_PGM的应用以及贝叶斯和马尔可夫模型的关系和转换

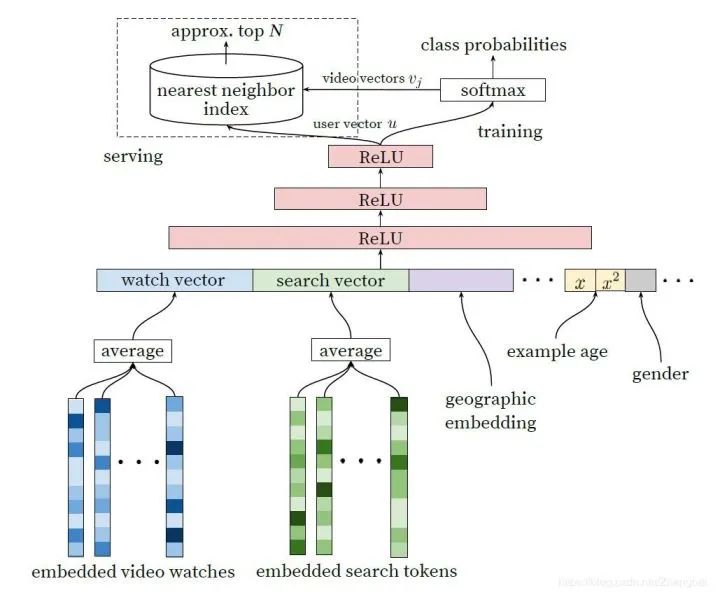

pgm模型PGM的应用:(用例) (Application of PGMs: (Use cases)) Netflix, Amazon, facebook all use PGM recommend what is best for you. Netflix,Amazon,facebook都使用PGM推荐最适合您的。 This algorithm, Use the latent factor model a…

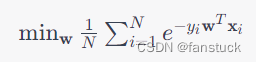

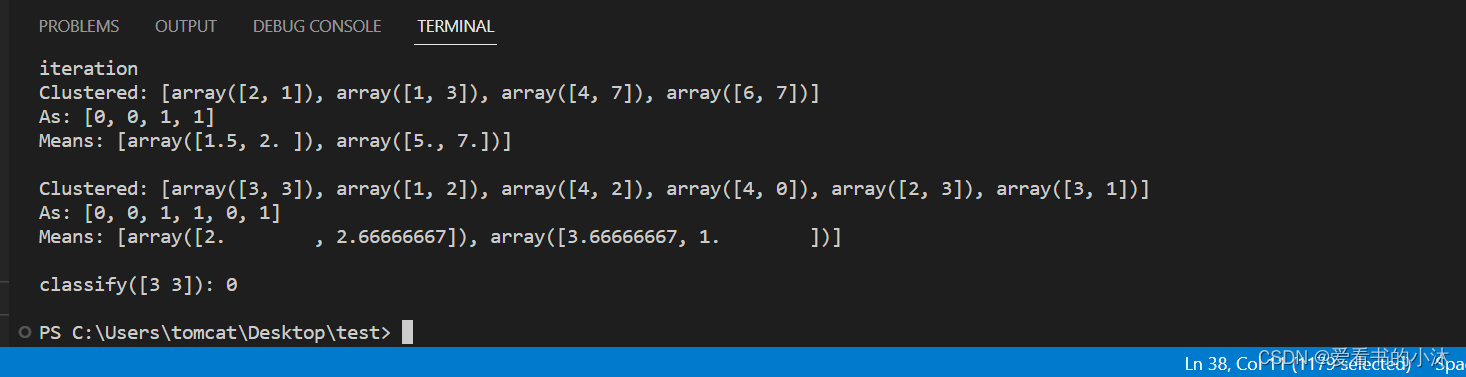

实例分析相应的逻辑斯蒂回归

假设train.csv文件中的内容为1,2,3,4,5,test.csv文件中的内容为2,3,4,5,1,则首先将train数组以及test数组提取出来, trainSet:2,3,4,5 labelList:0(因为trainSet打头的数字为1,所以类别标为第0类) testSet:3,4,5,1 labelList:0(因为testSet打头的数字为1,所以类别标为第0类) 对…

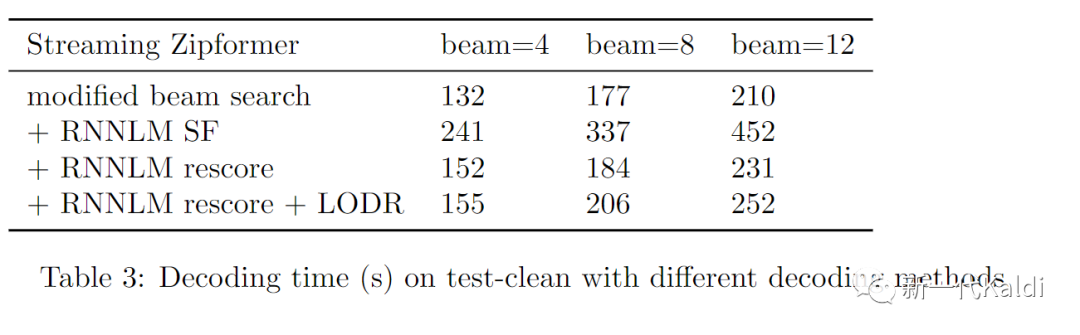

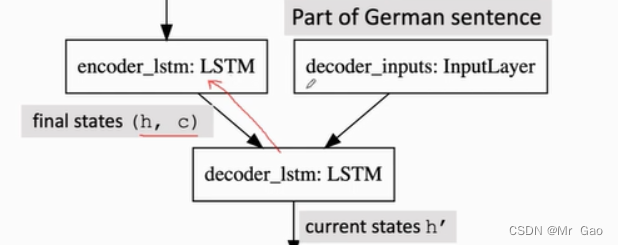

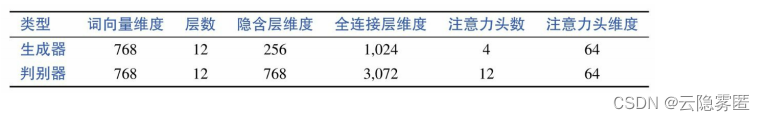

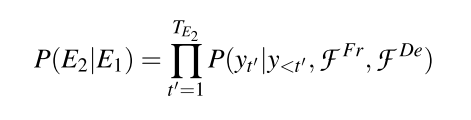

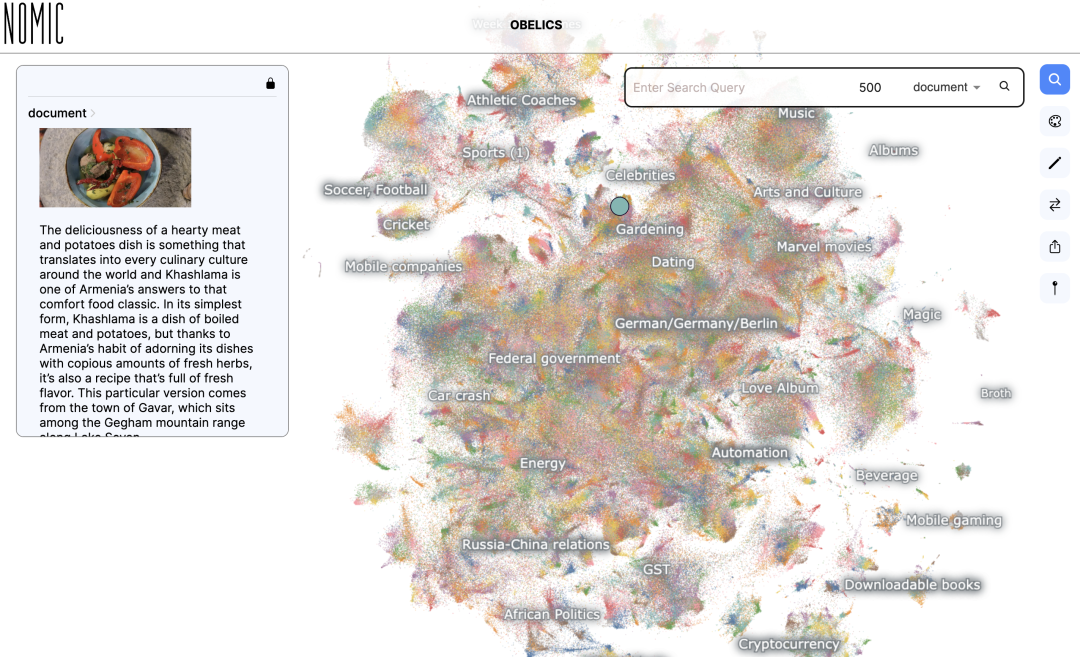

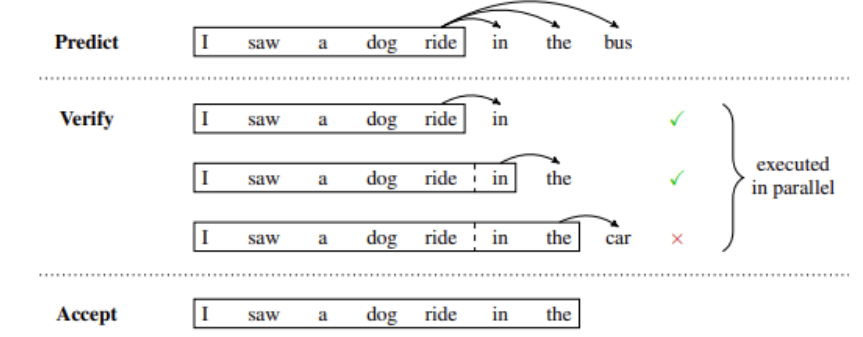

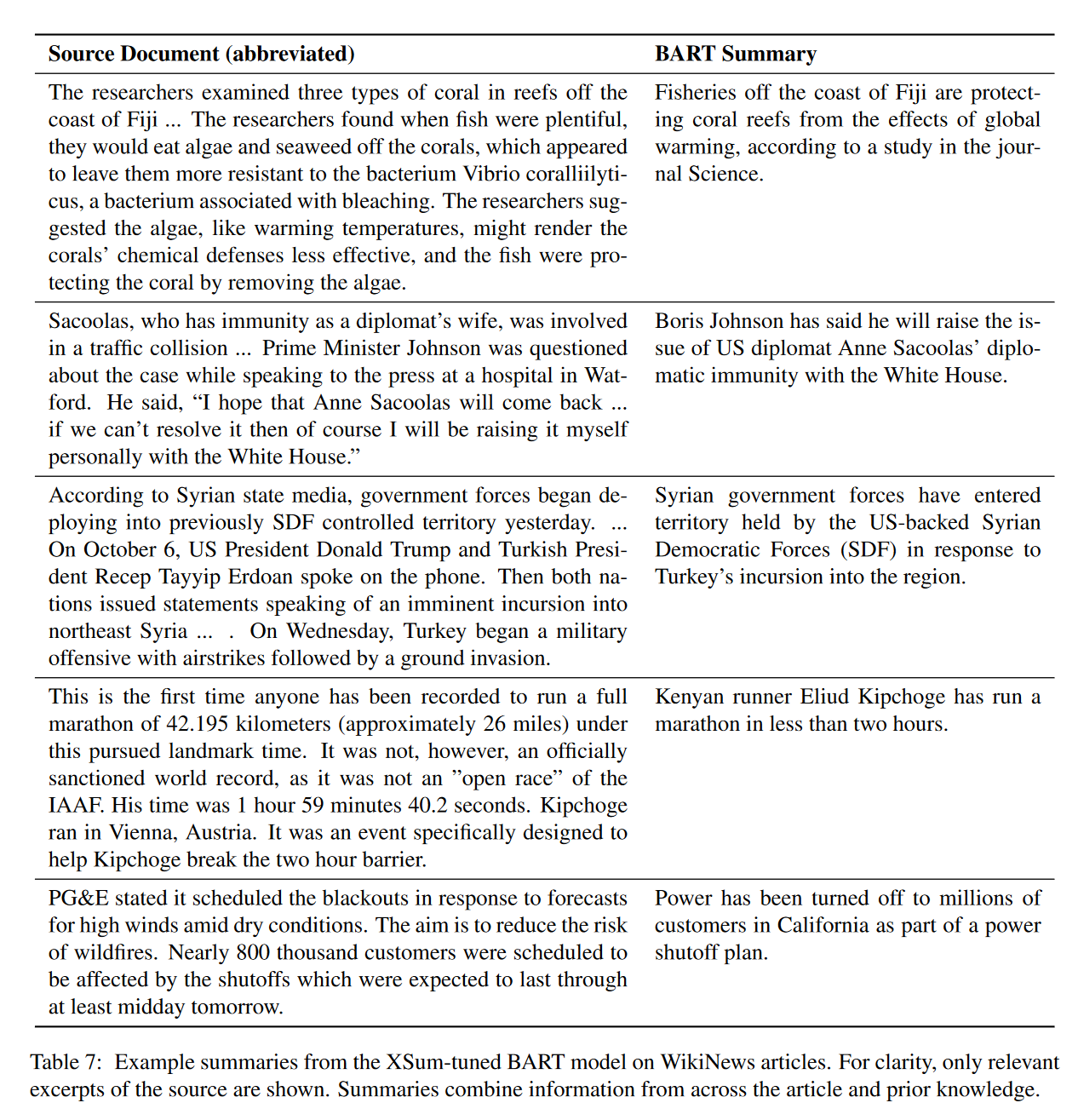

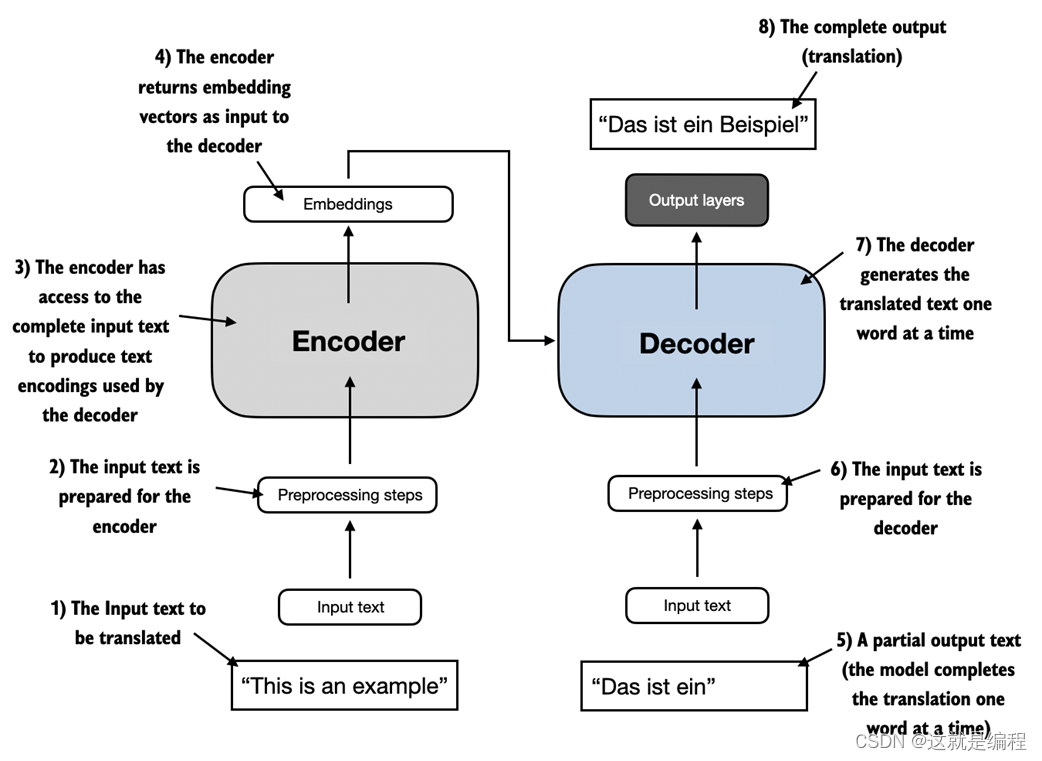

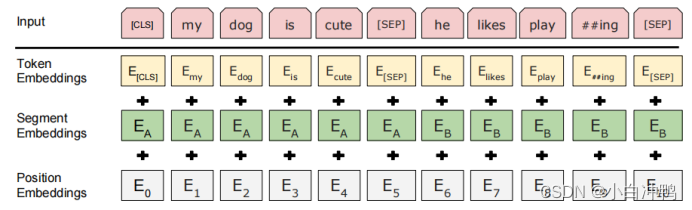

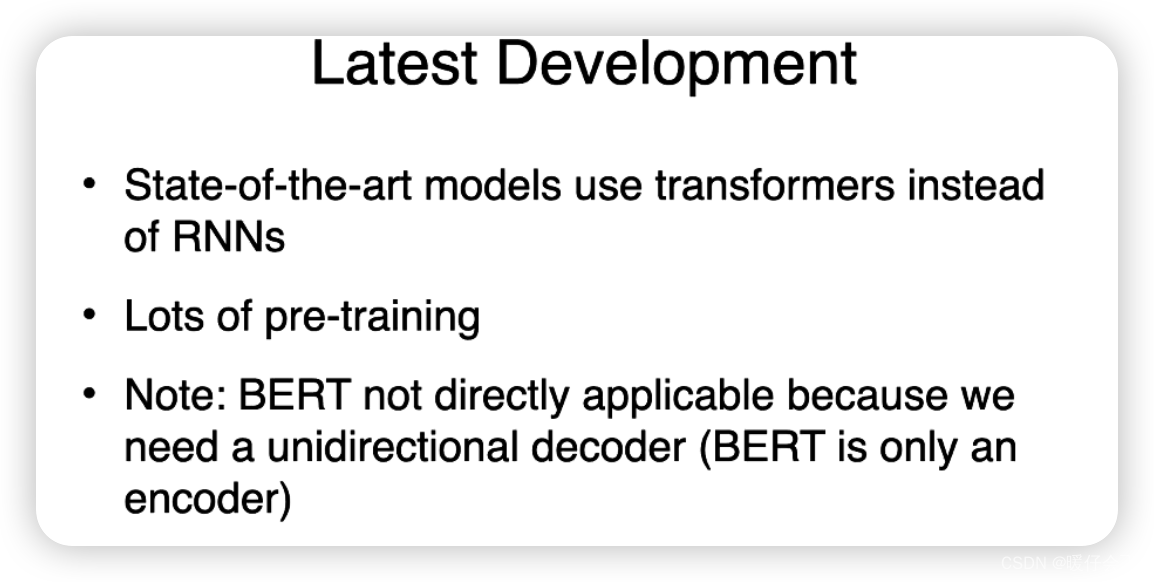

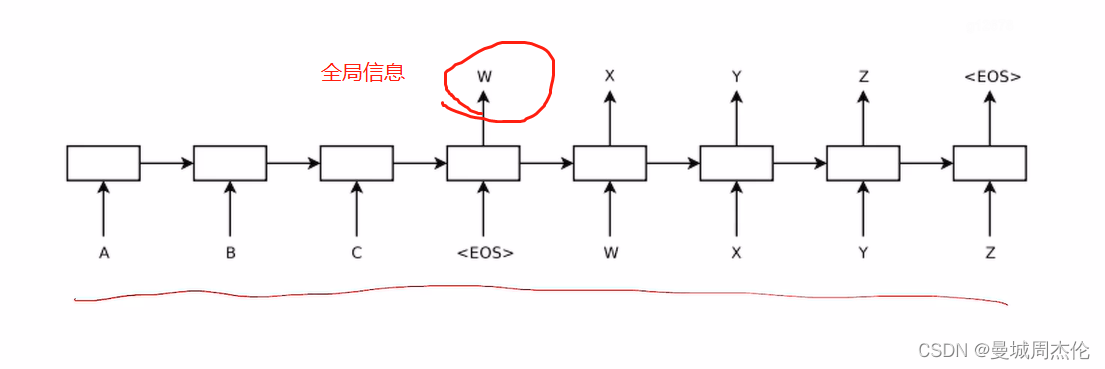

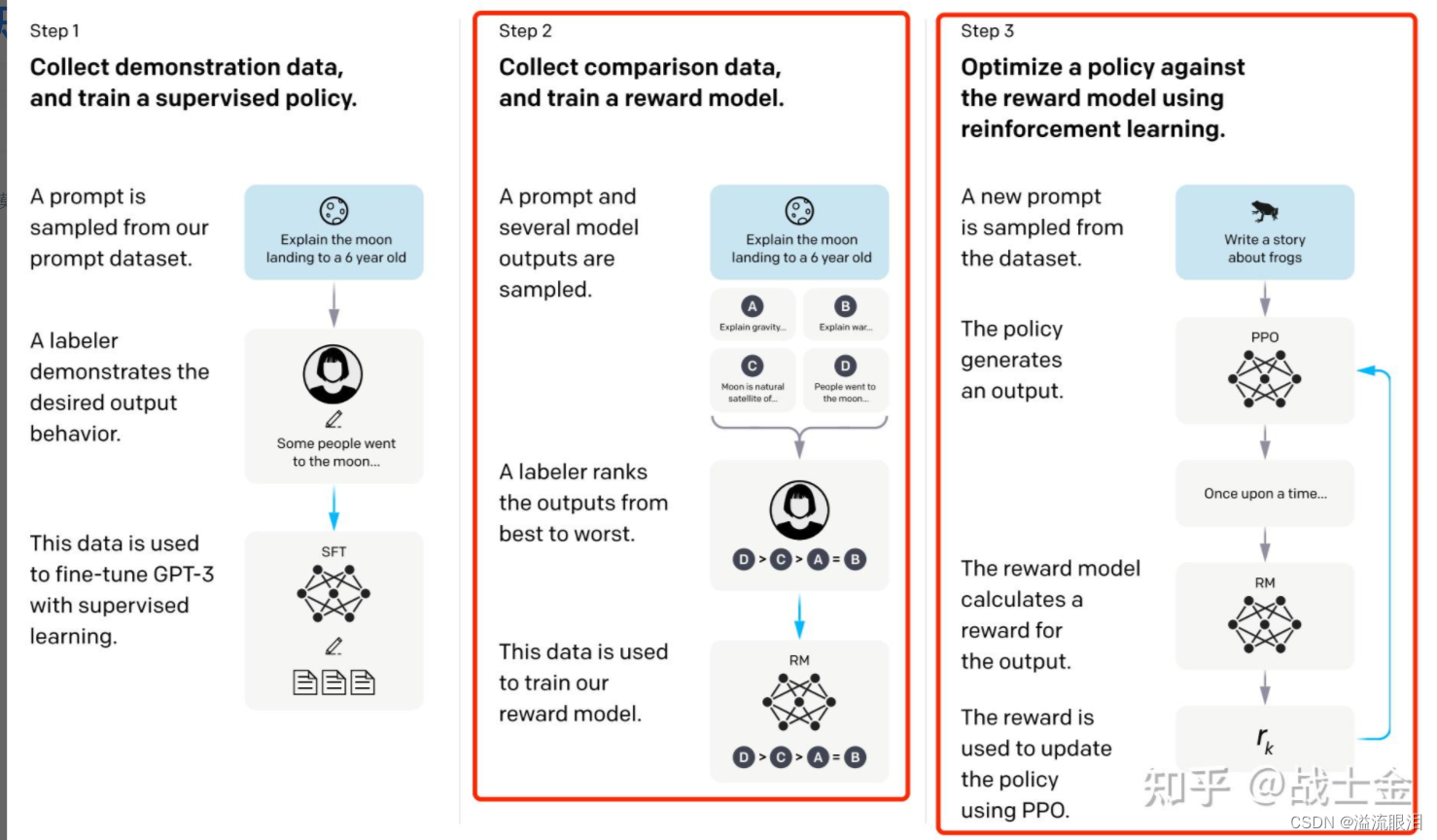

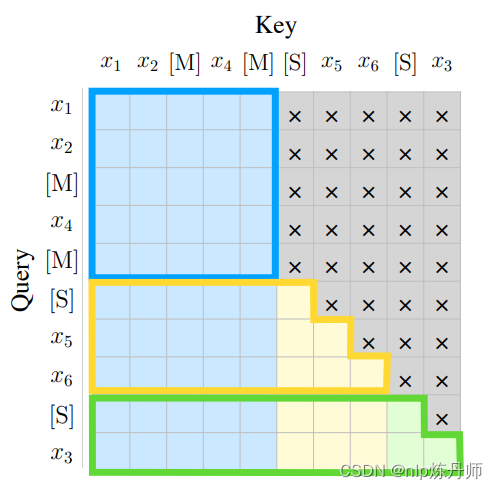

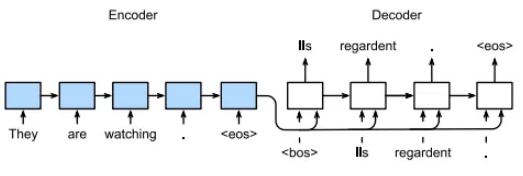

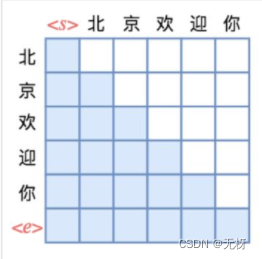

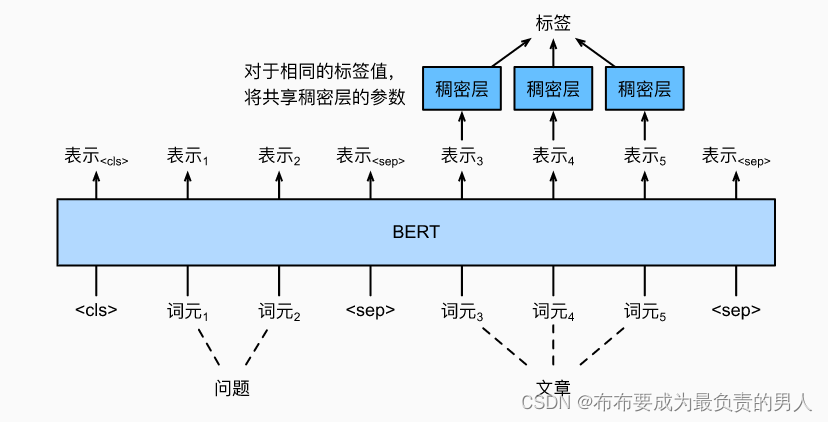

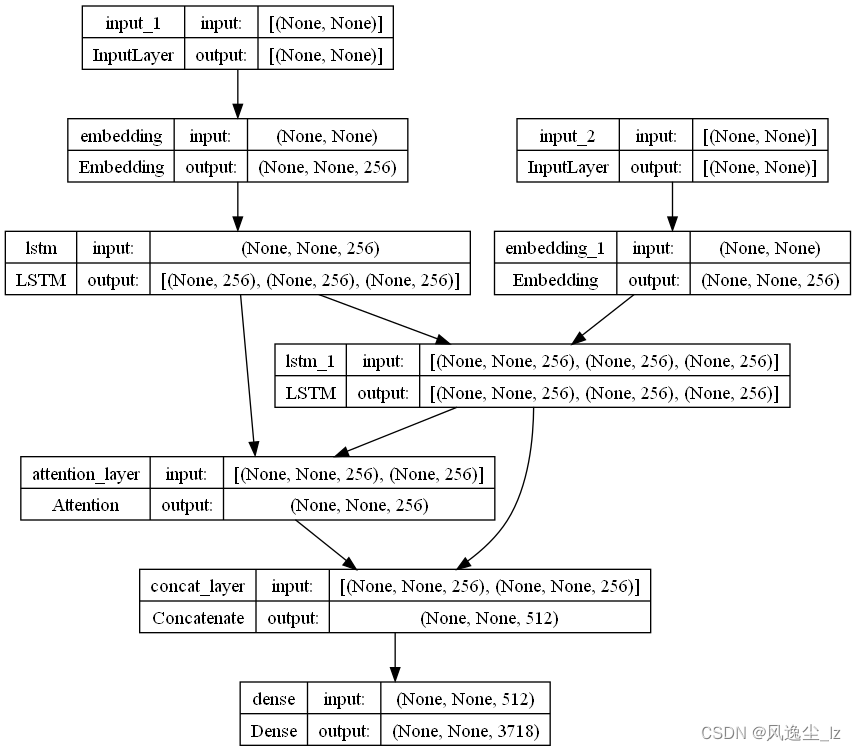

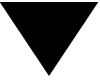

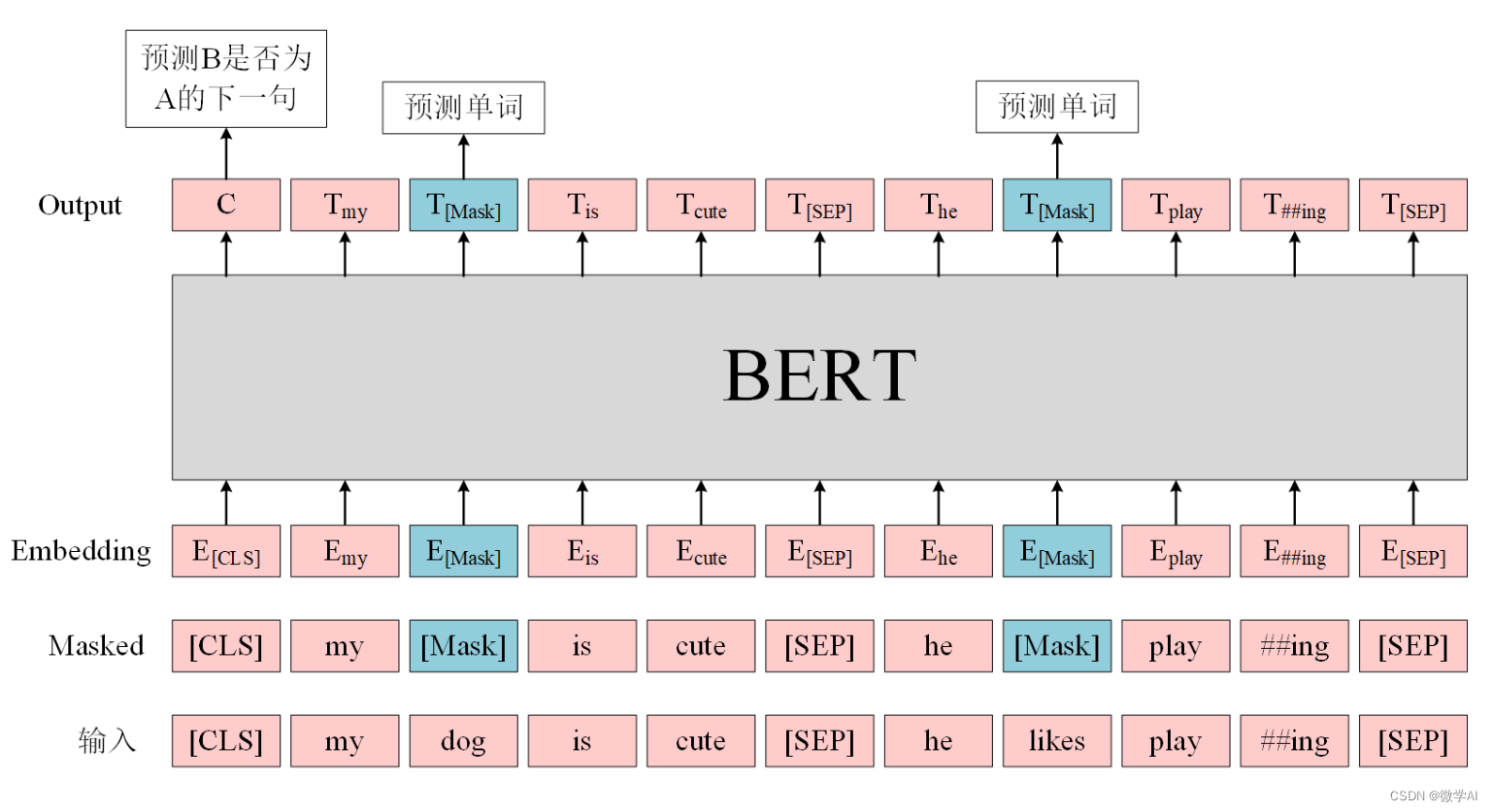

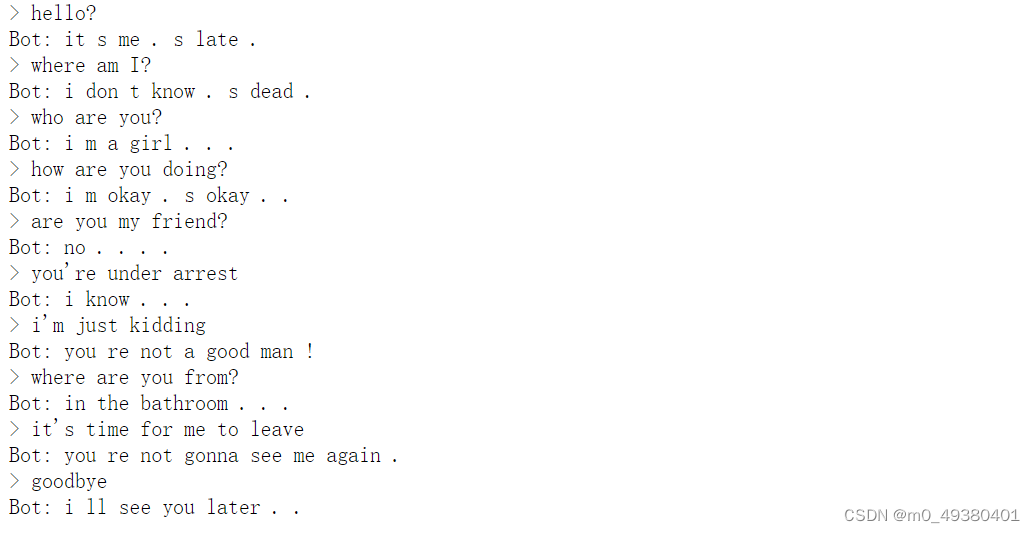

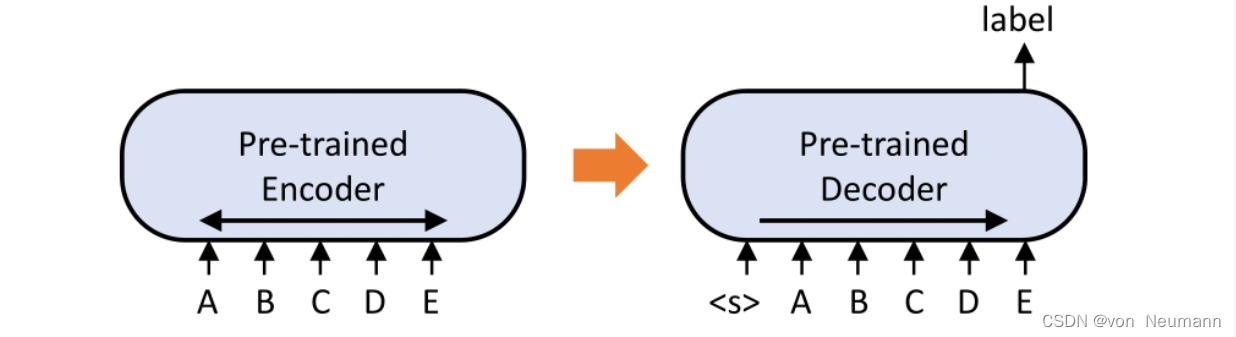

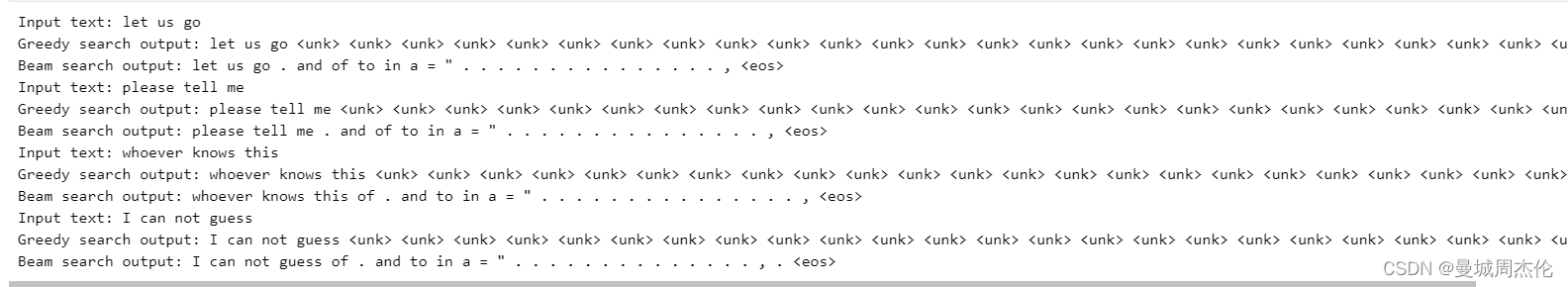

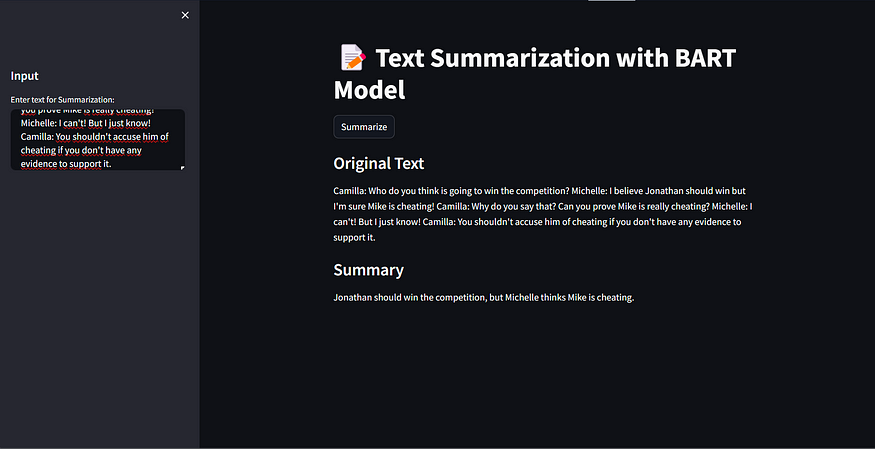

seq2seq bert模型训练以及预测过程讲解

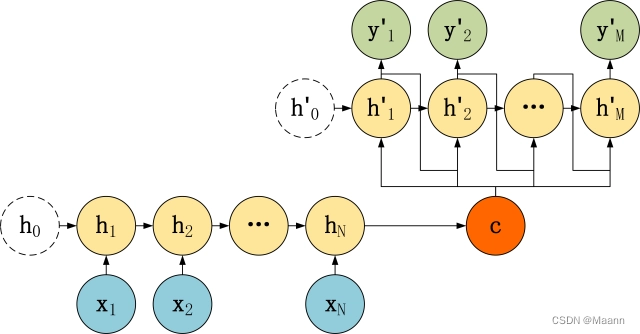

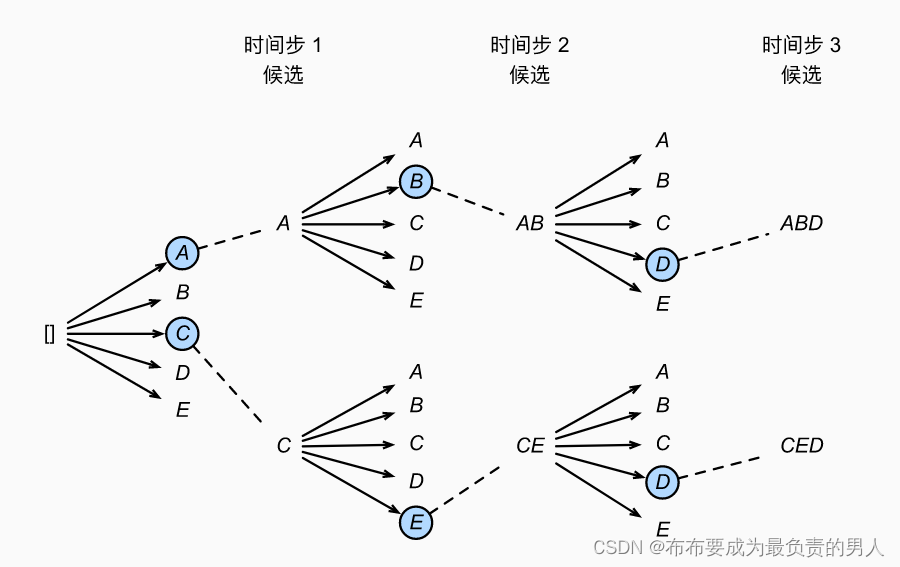

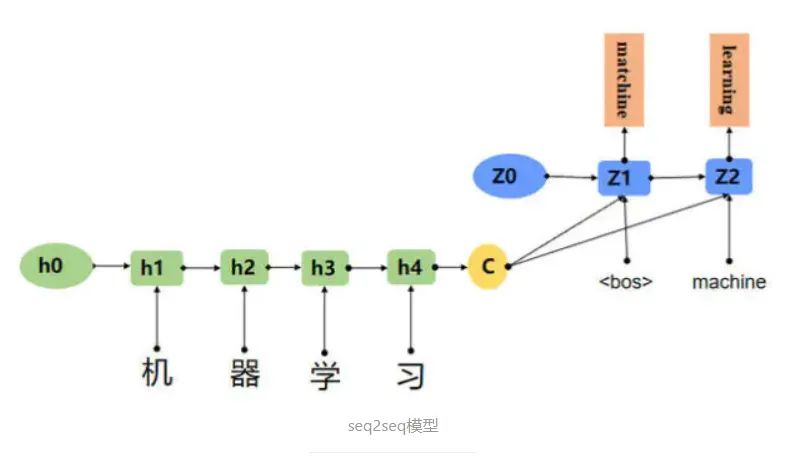

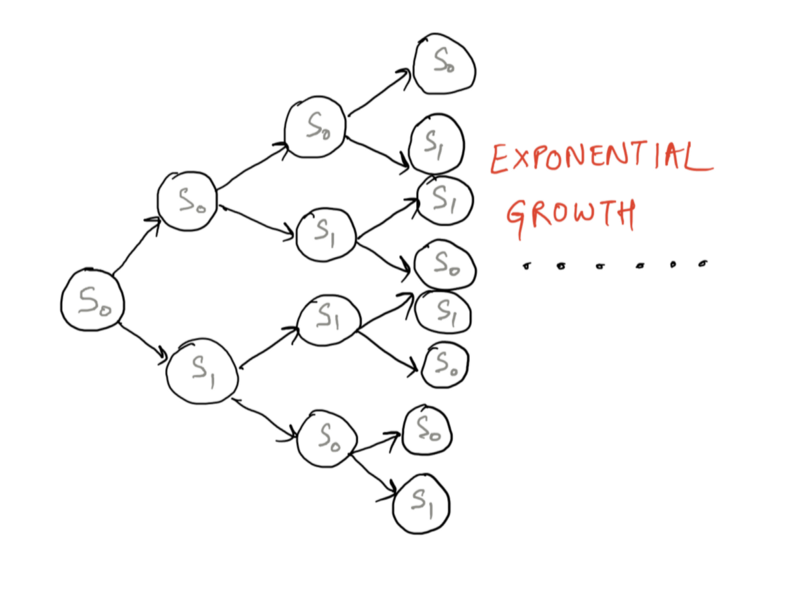

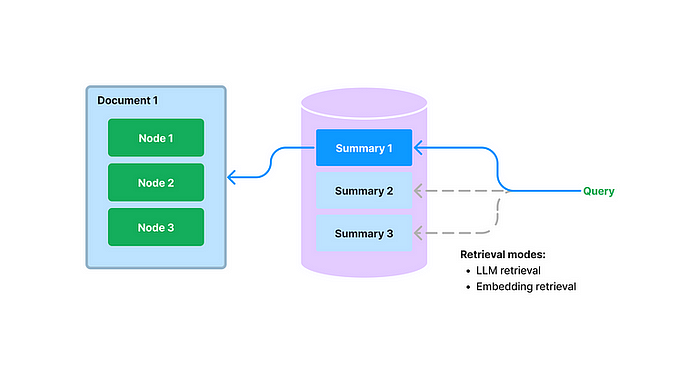

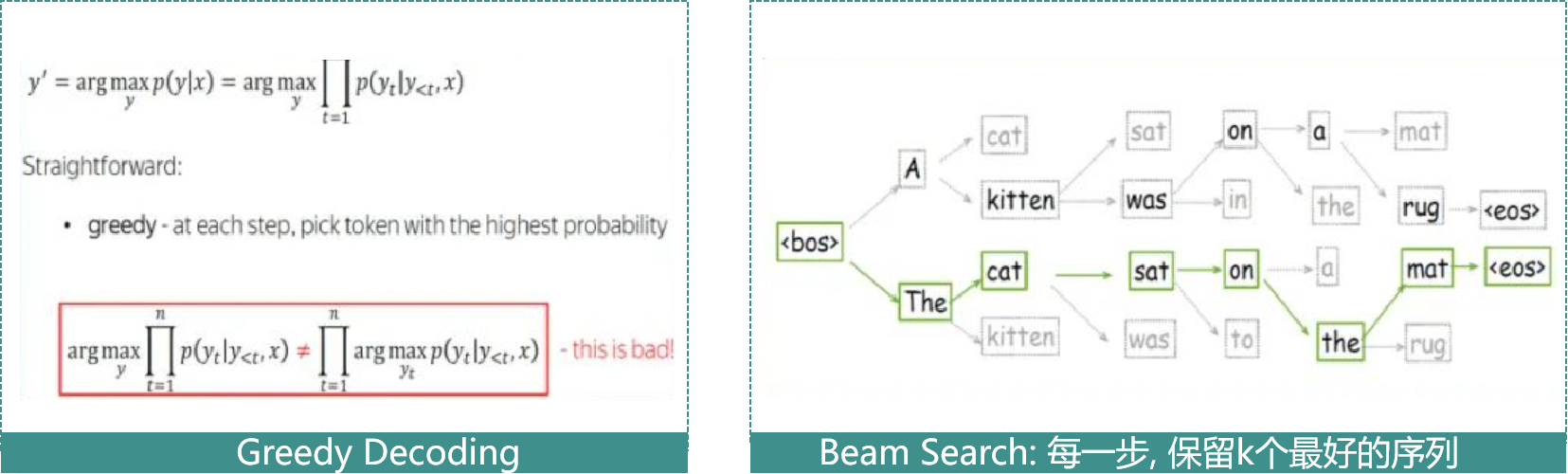

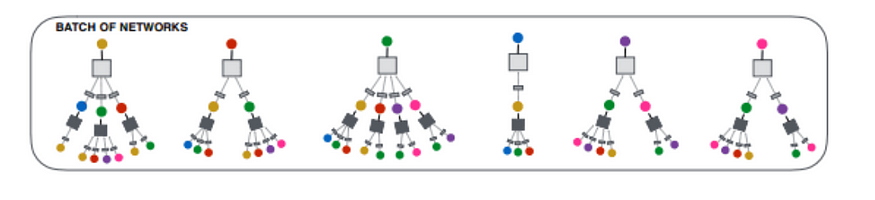

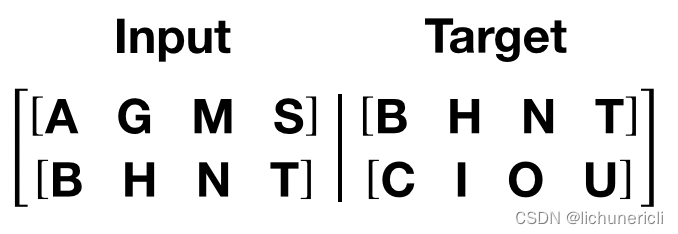

seq2seq bert模型训练seq2seq训练模型的过程seq2seq预测模型的过程unilm代码部分讲解超出长度了是截取原始的部分还是截取摘要的部分???beam_search束搜索过程之中的batch问题seq2seq训练模型的过程

最近学习了seq2seq模型的内容,…

人工智能生成舞蹈 | Mixlab交叉学科

NVIDIA最新深度学习模型:根据音乐自动编舞AI DancingFacebook ResearchFacebook AI研究人员开发了一种系统,该系统可使机器为任何输入的音乐生成舞蹈。它不仅仅是模仿人类的舞蹈动作,而是可以创建极富创意的舞蹈。研究人员认为,人…

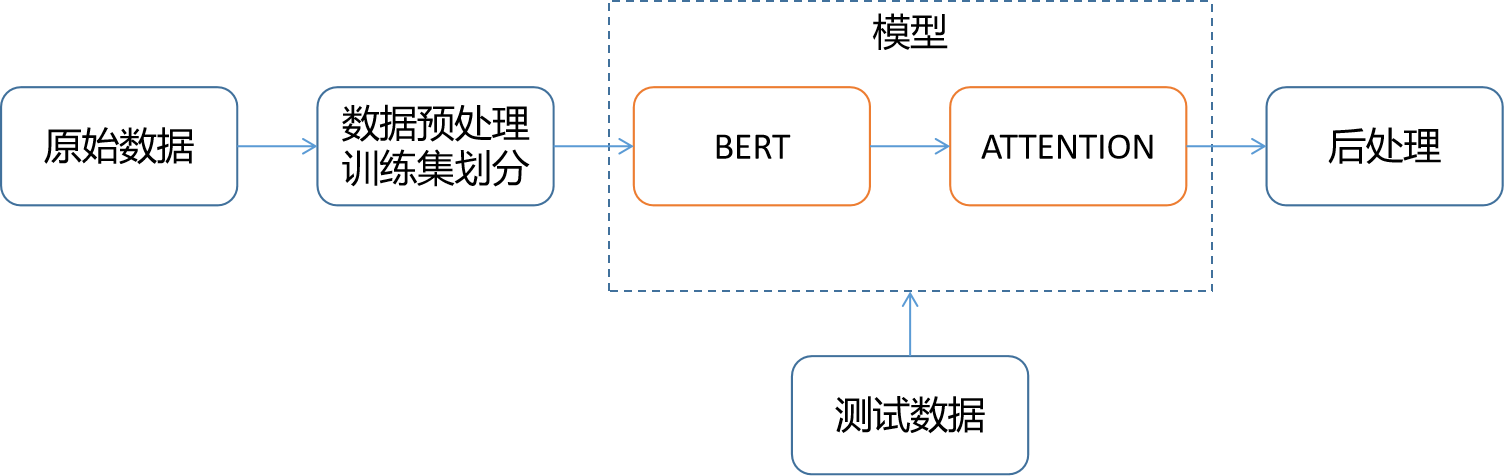

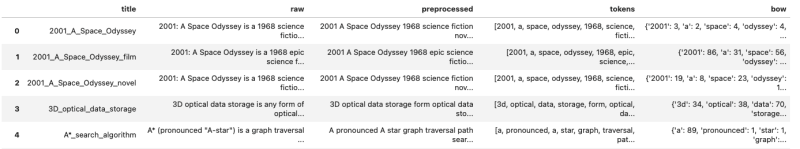

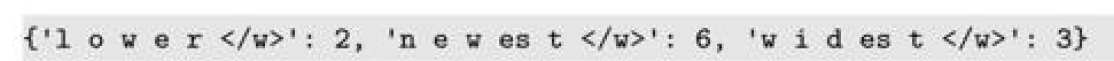

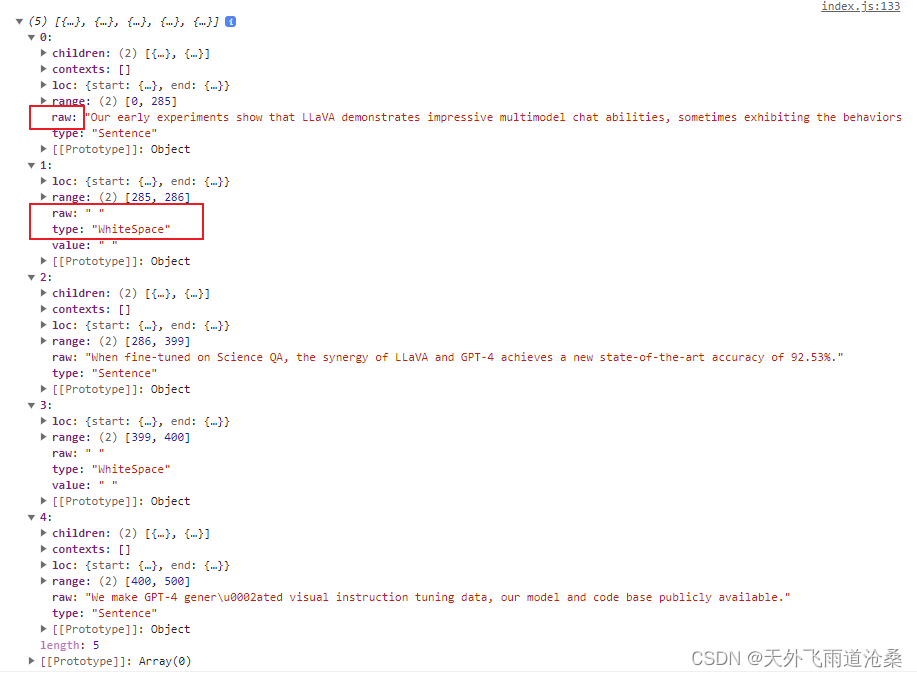

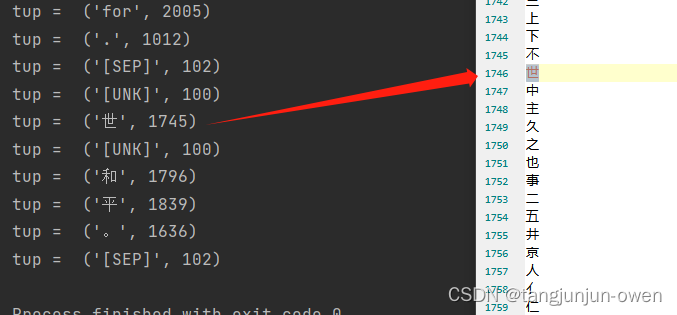

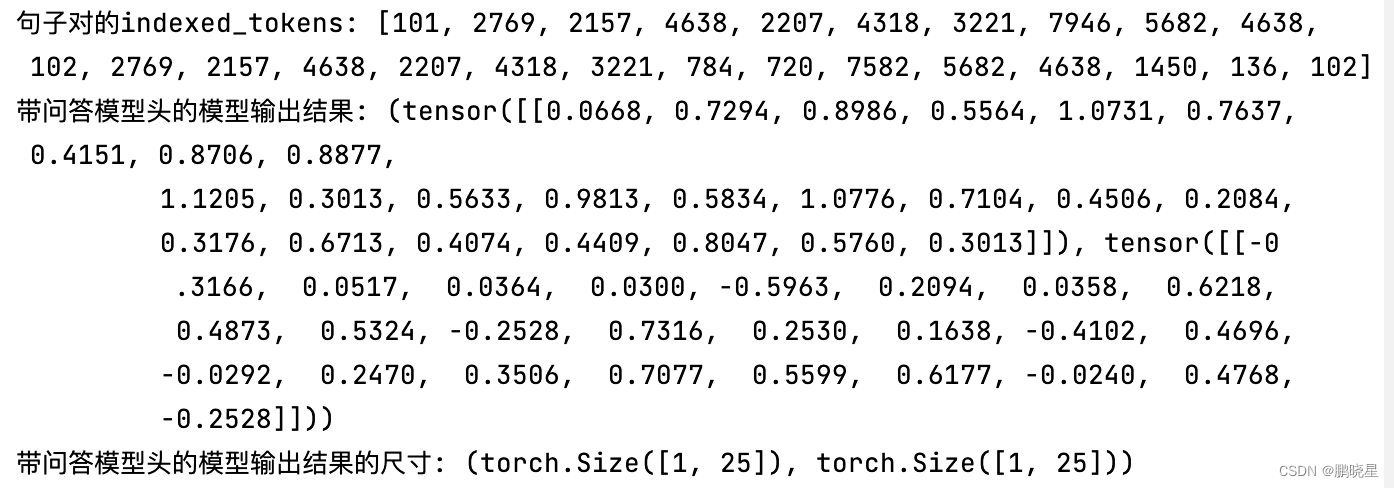

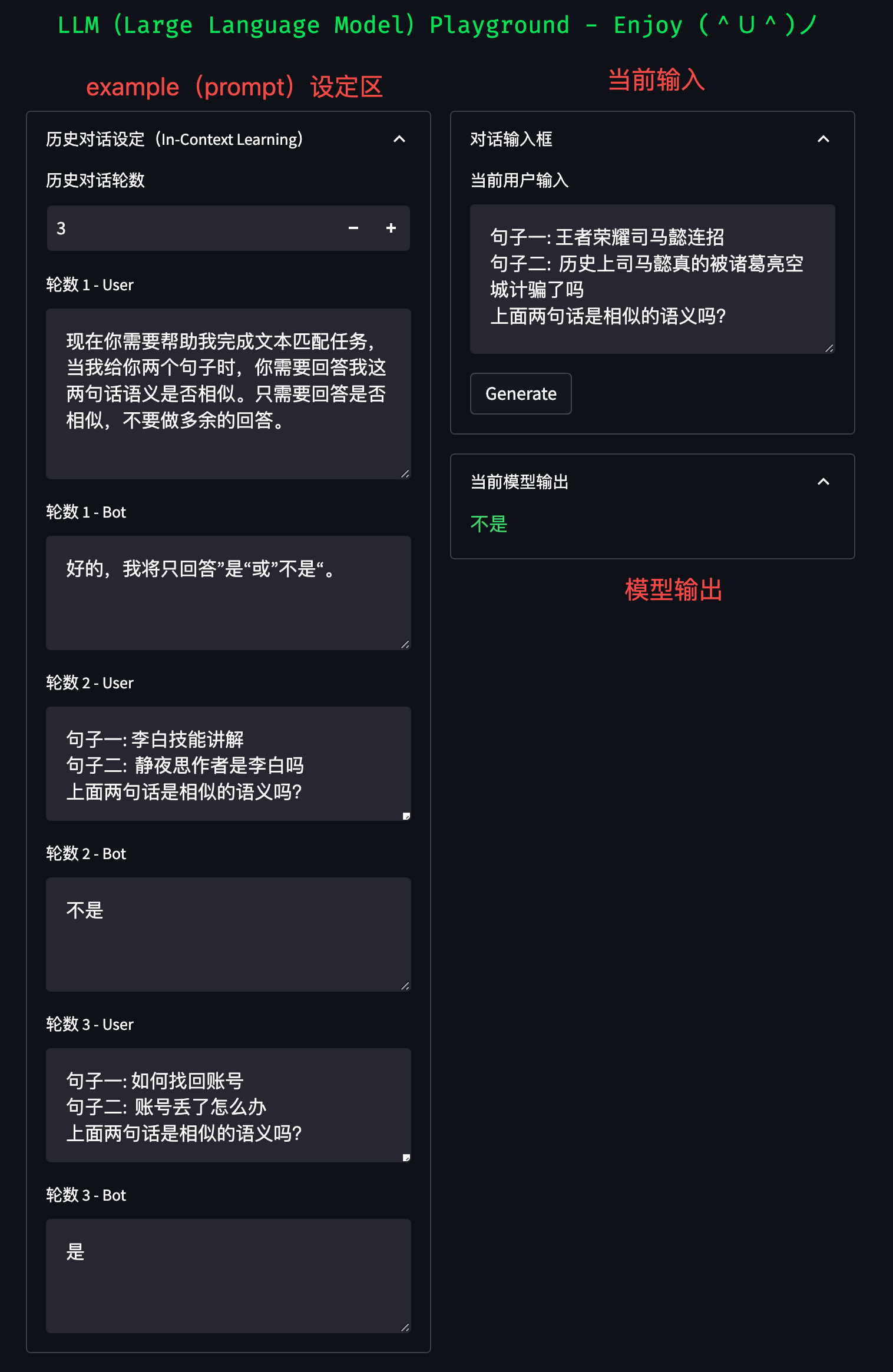

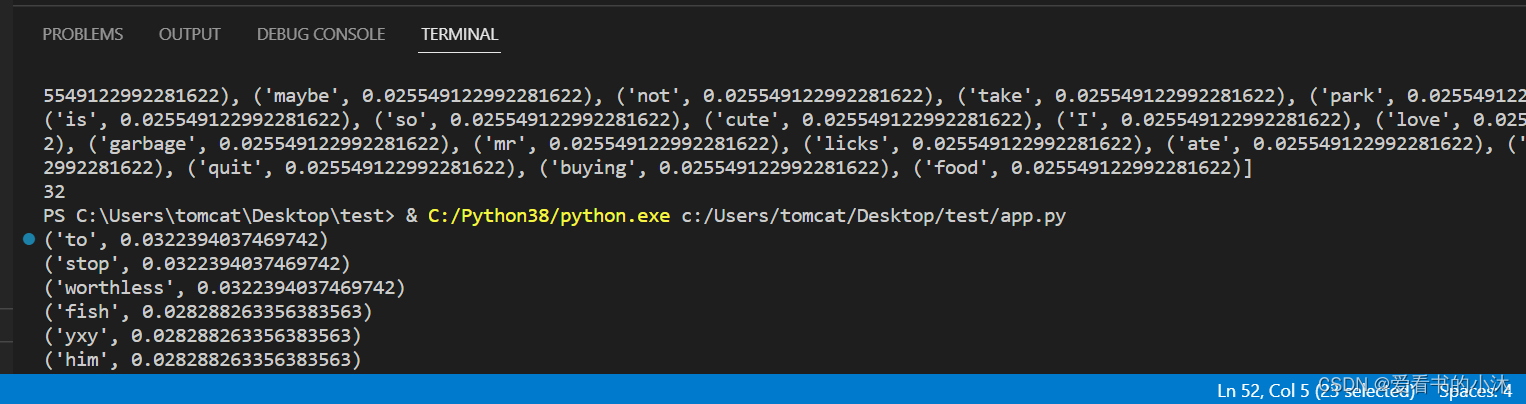

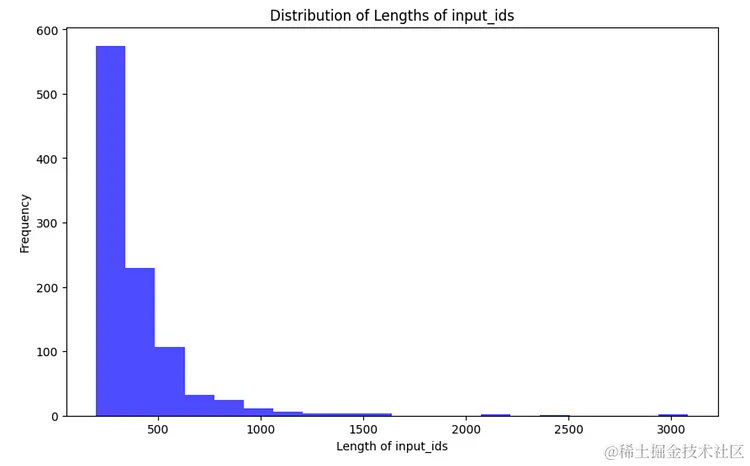

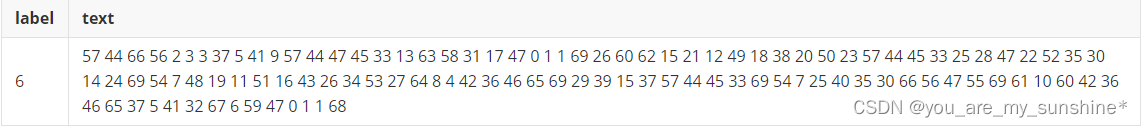

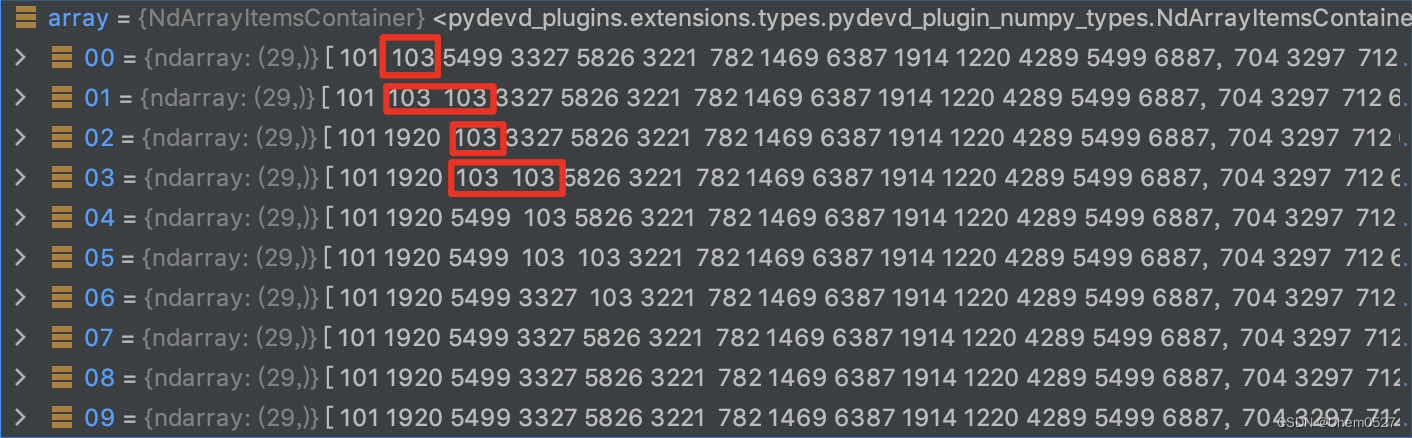

小布助手对话短文本语义匹配阅读源代码1--build_vocab.py understand

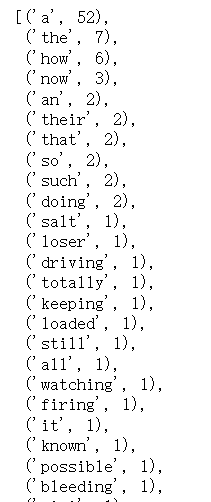

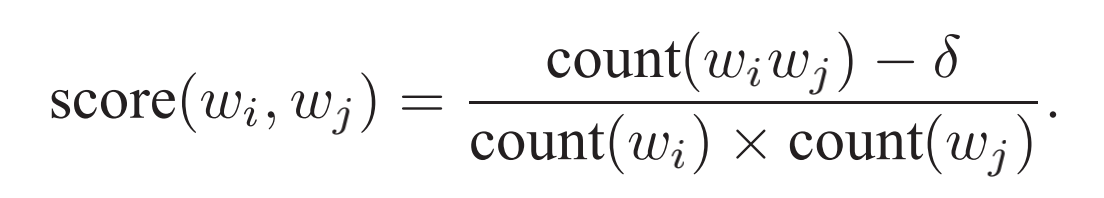

小布助手对话短文本语义匹配 对于大佬这段代码的解读 首先进入build_vocab.py之中,查看形成词表的过程 关键代码

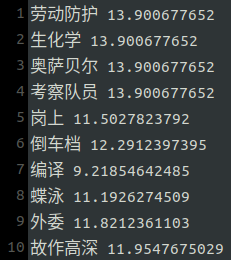

counts [3,5,3,3,5,5]接下来调用词频形成新的vocab.txt的词表过程 (由于数据是脱敏的,这里考虑词语出现的频率,即词频)

for …

如何将情感转化成可处理的数据?| MixLab 闪聊第四期

Mixlab 闪聊 第四期 闪聊嘉宾:Ella 边边闪聊主题:情感计算嘉宾信息:北理工设计学硕士,台湾云科大交换生合作 LAB:台湾云林科技大学 SOFT LABElla 边边:“ 出于认为研究生一定要有自己研究的想法,…

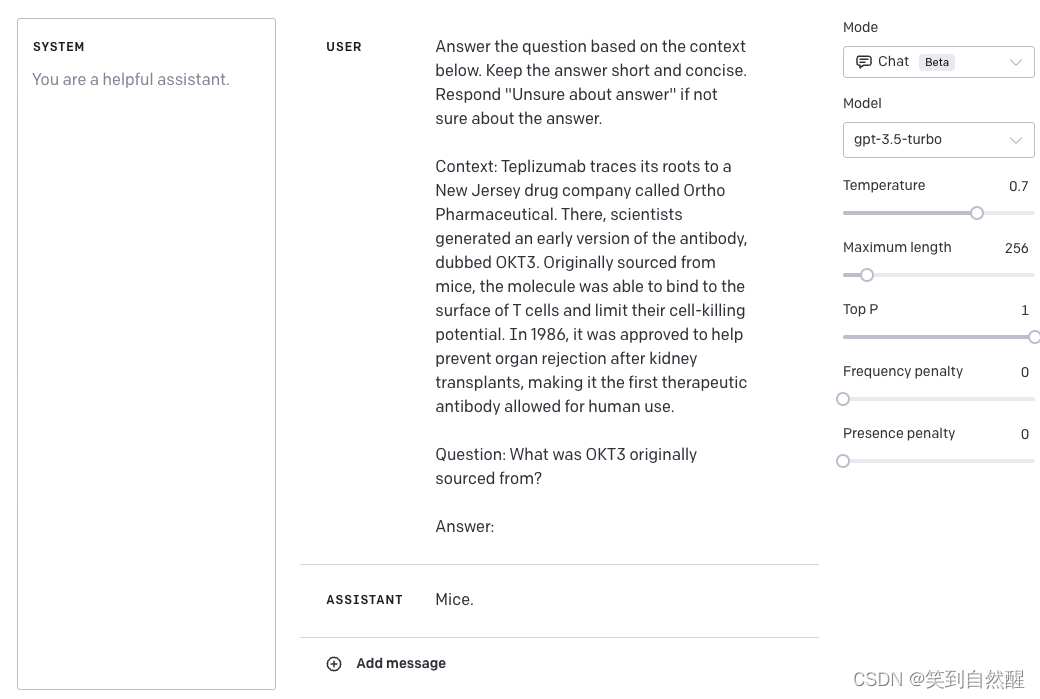

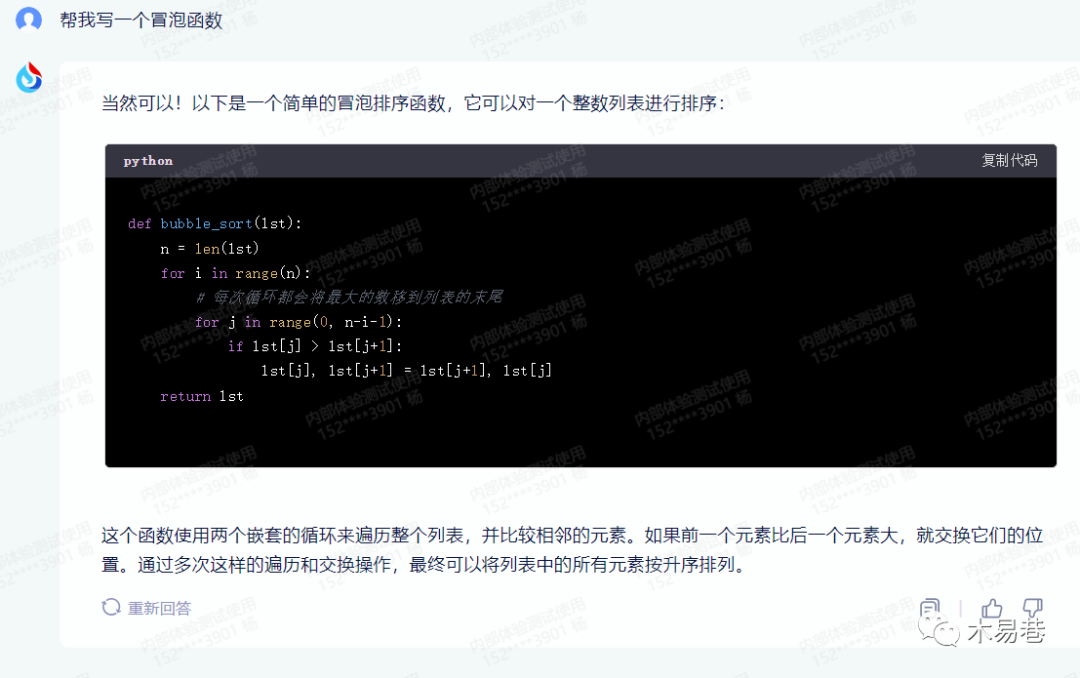

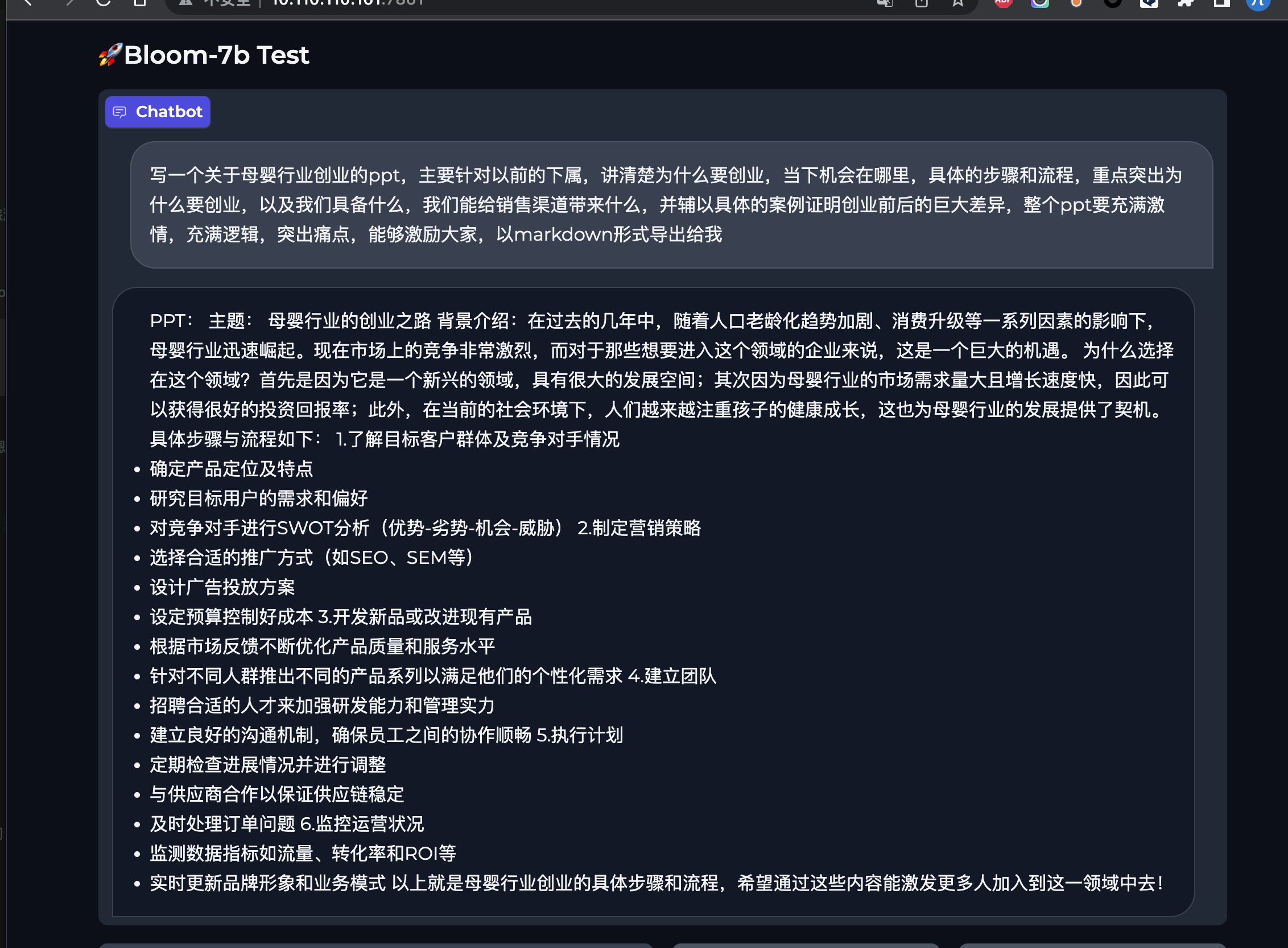

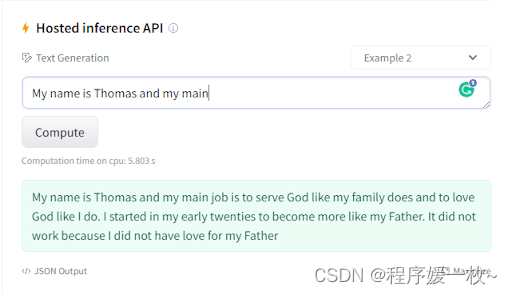

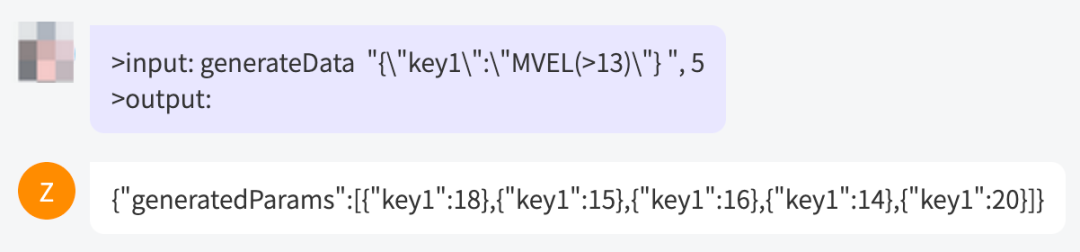

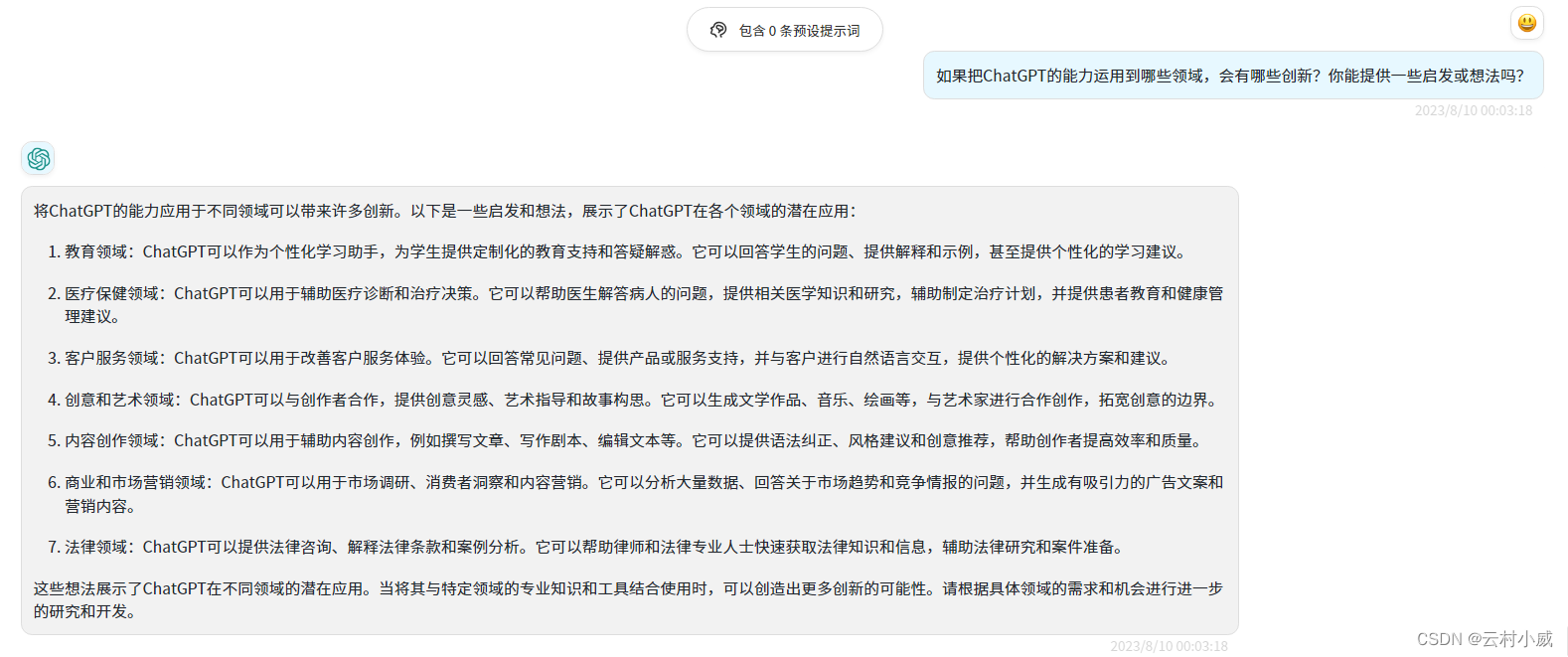

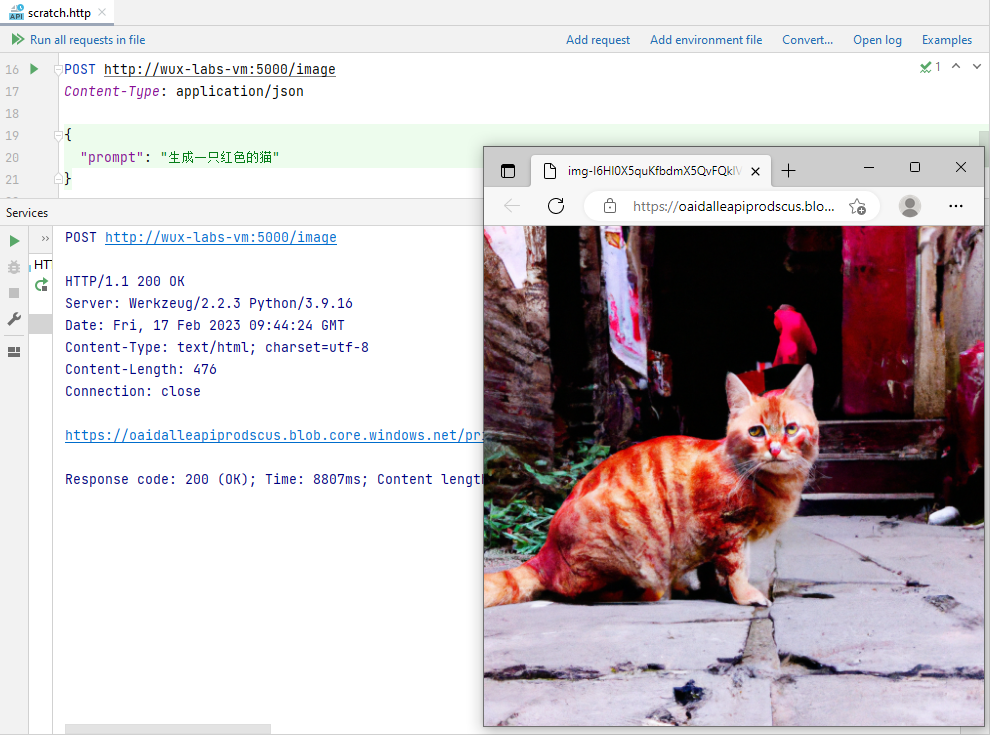

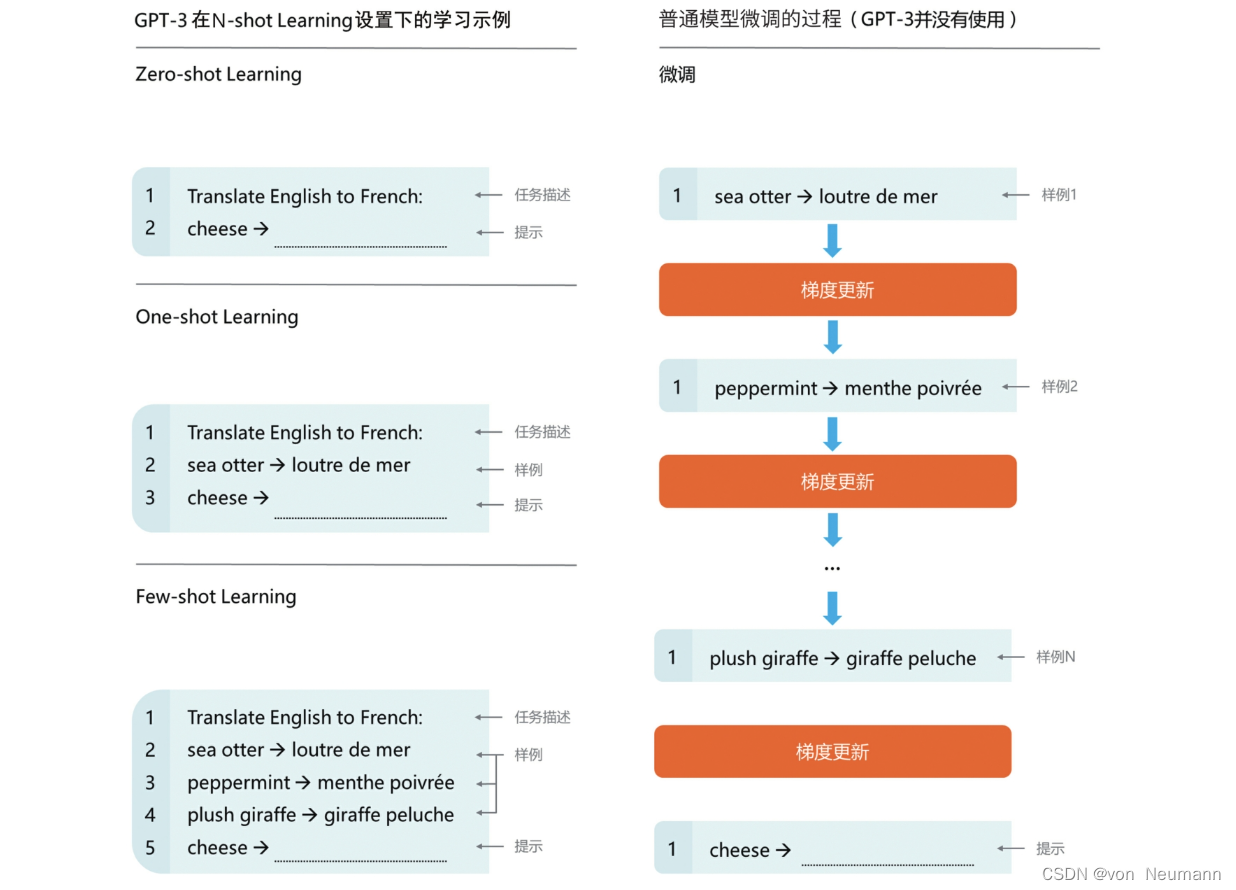

想要什么变一个出来?|GPT-3的生成能力

想要什么变一个出来?那先变一段 “ 无界社区 ”的介绍?Input “ 无界社区 ”Output:无界社区 , 也 就 是 这 个 山 头 。这 里 的 生 存 地 理 位 置 和 人 口 不 同 。一 共 有 九 个 部 落 。其 中 大 部 分 是 人 数 超 过 三 十 多 米 的…

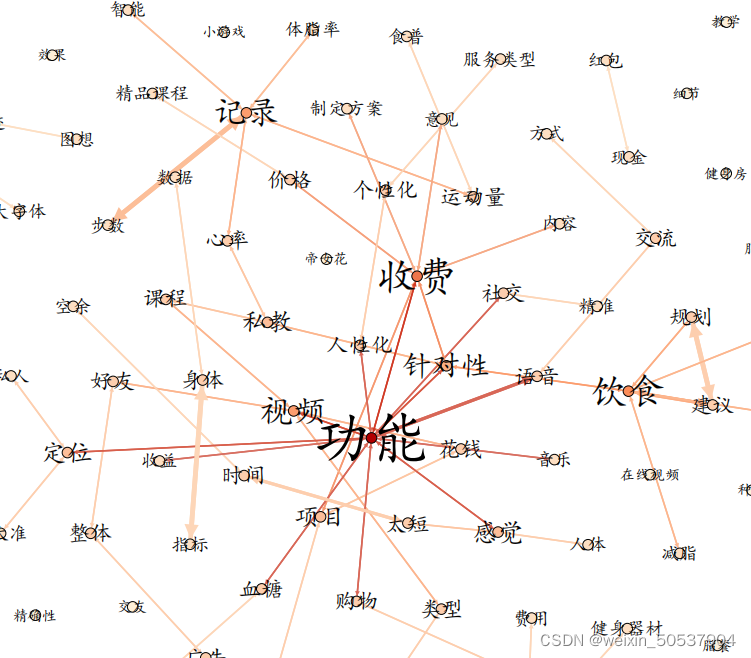

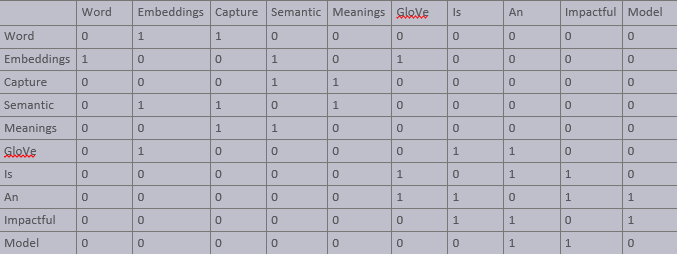

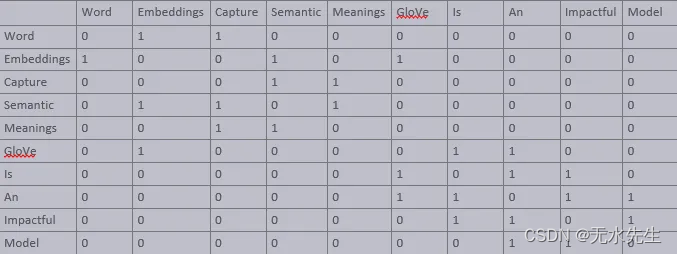

从共现矩阵到共现图一步到位——详解版

1.共现矩阵

判断大量不同文本之间,相邻词的联系,两词在所有文本中相邻的次数在矩阵中用数值表示。(参考此) 例子如下:

1.1 文本

• I like deep learning. • I like NLP. • I enjoy flying.

1.2 共现矩阵

2.共…

《推荐系统实践》 第一章 好的推荐系统 读书笔记

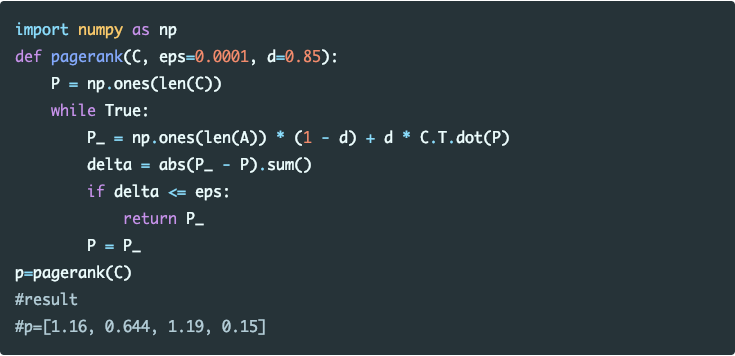

推荐系统的方法 按照数据分:协同过滤、内容过滤、社会化过滤 按照算法分: 基于邻域、基于图、基于矩阵分解、概率模型

好的推荐系统

推荐系统的主要任务、推荐系统和分类目录以及搜索引擎的区别等

背景

随着信息过载,有目的的购买东西方式变化过程&a…

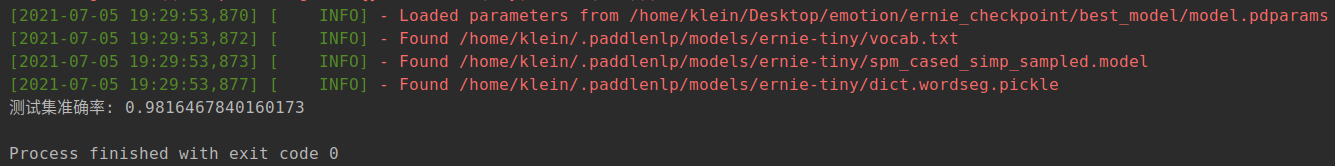

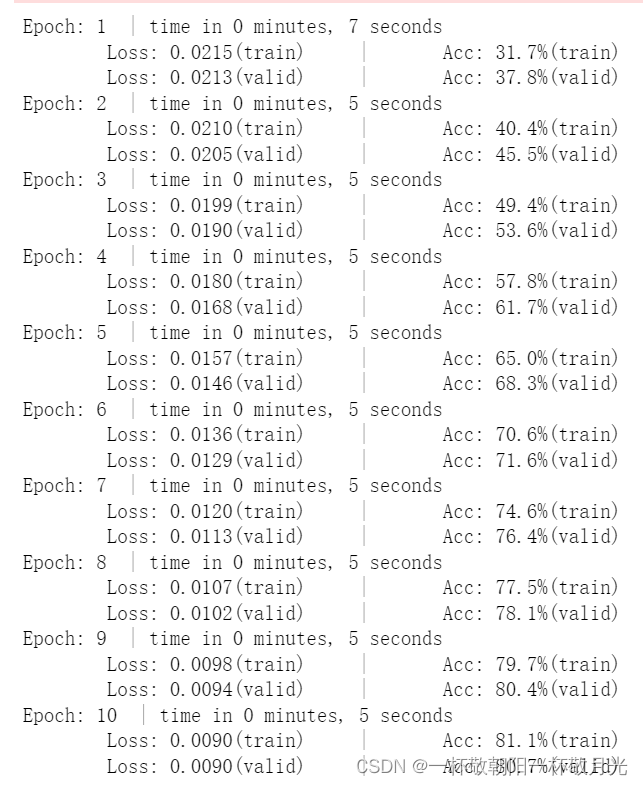

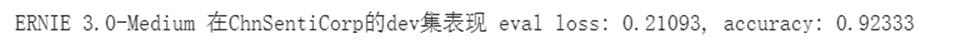

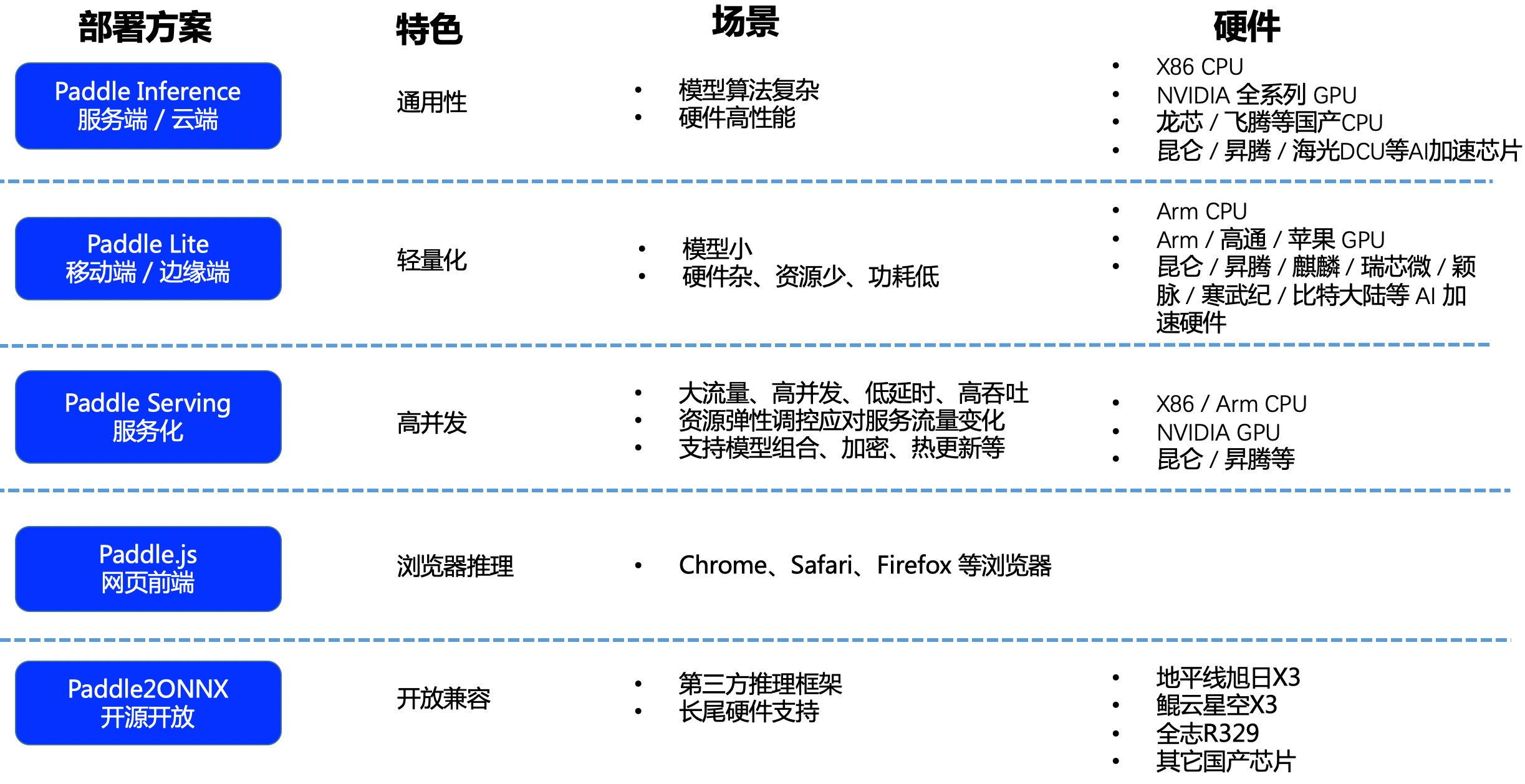

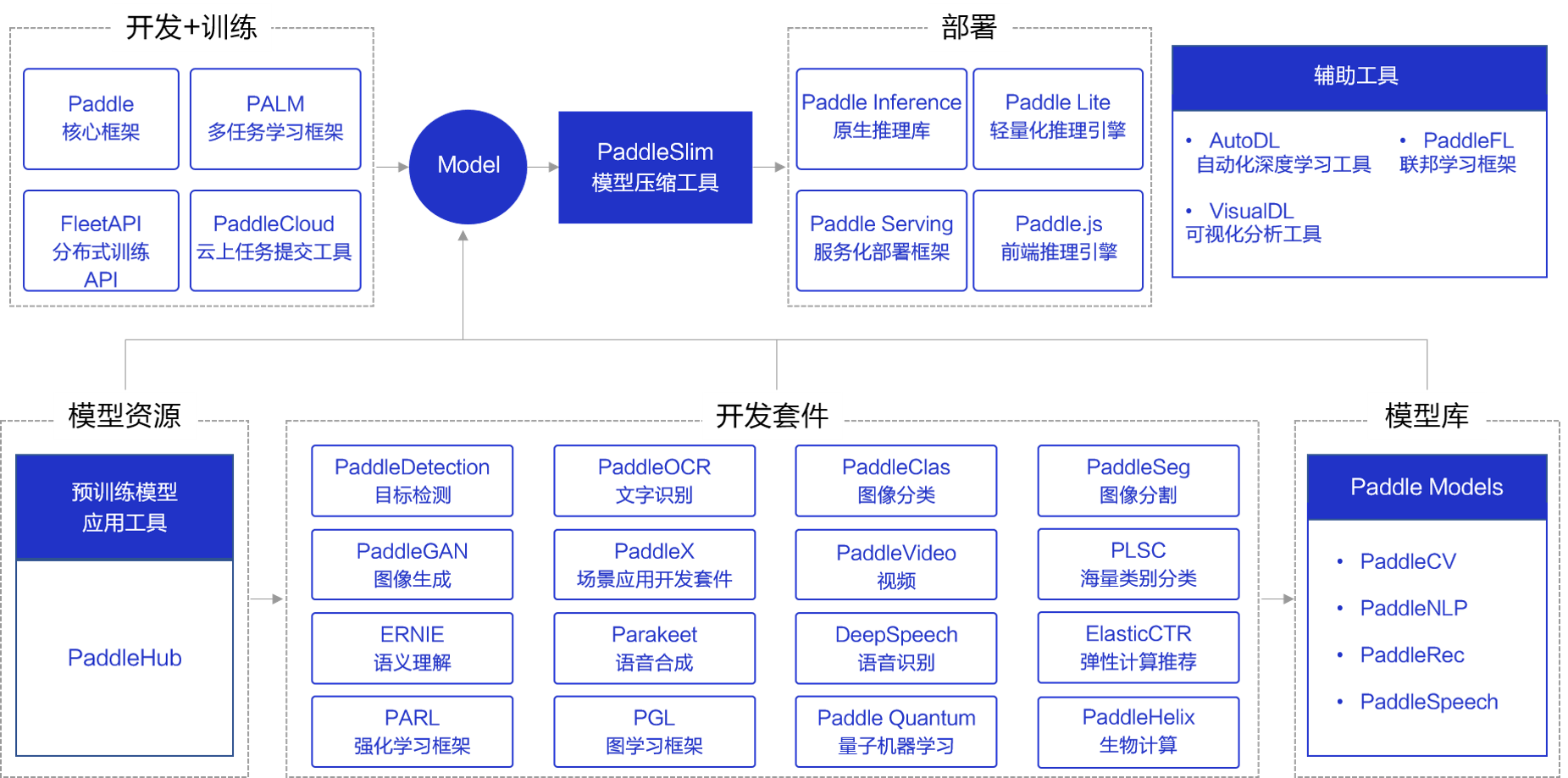

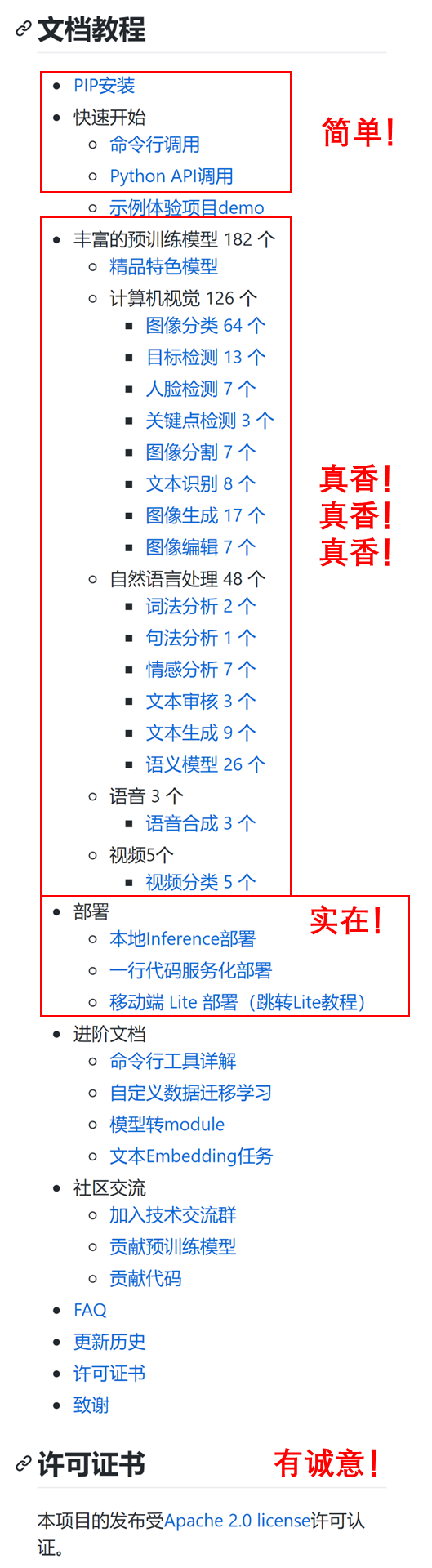

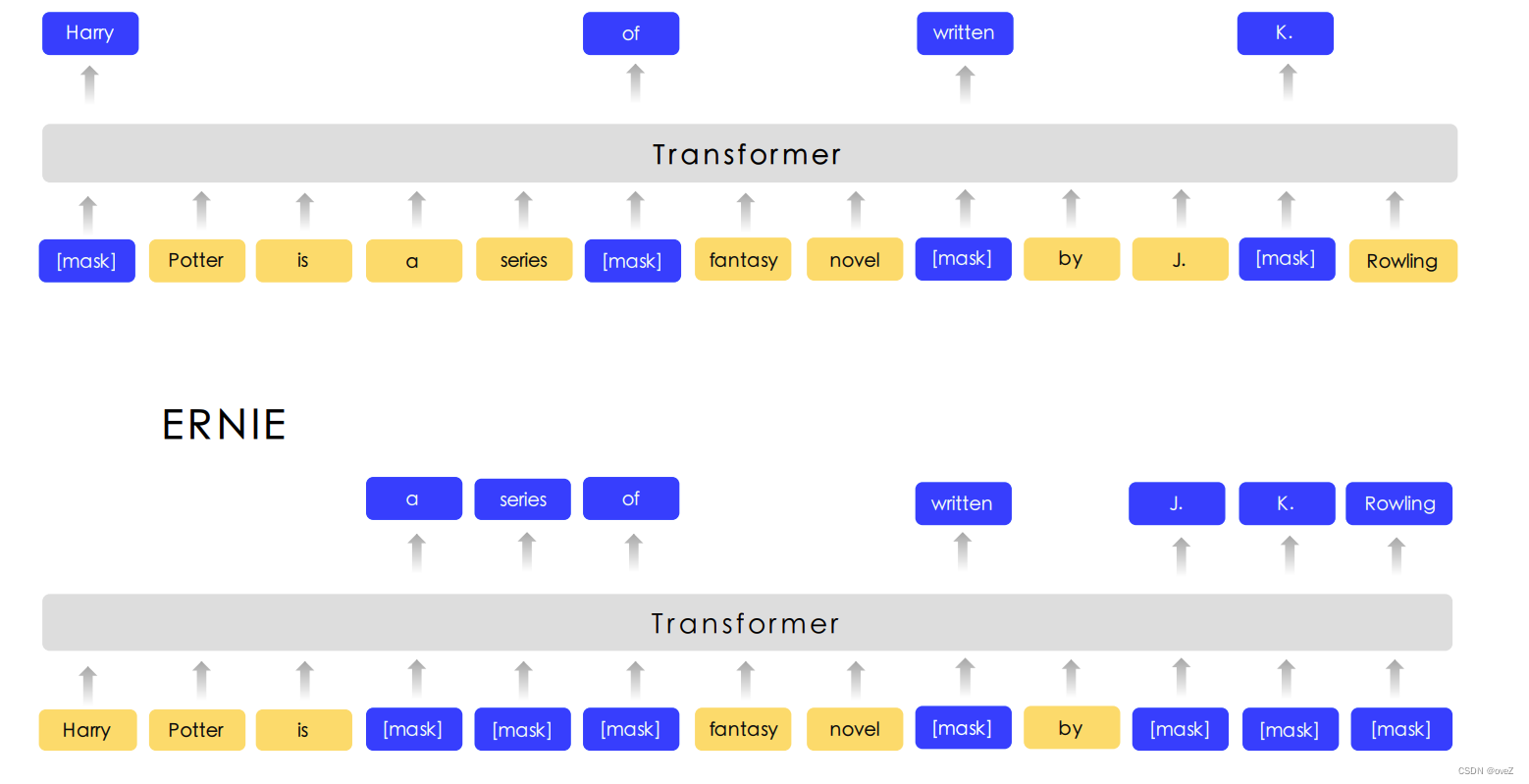

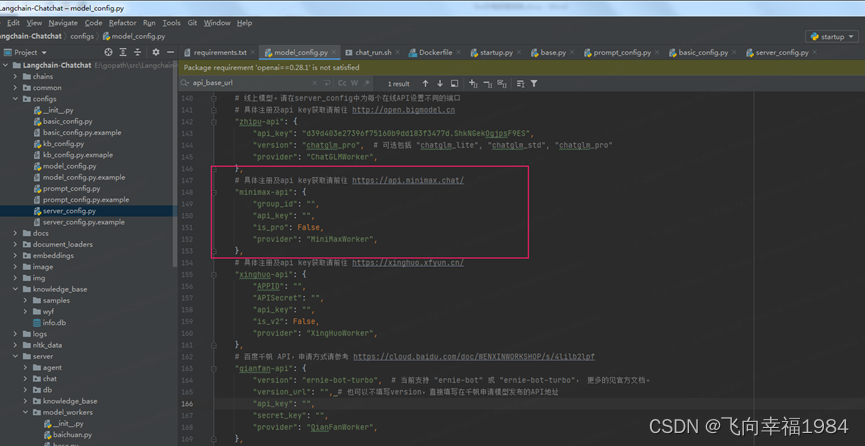

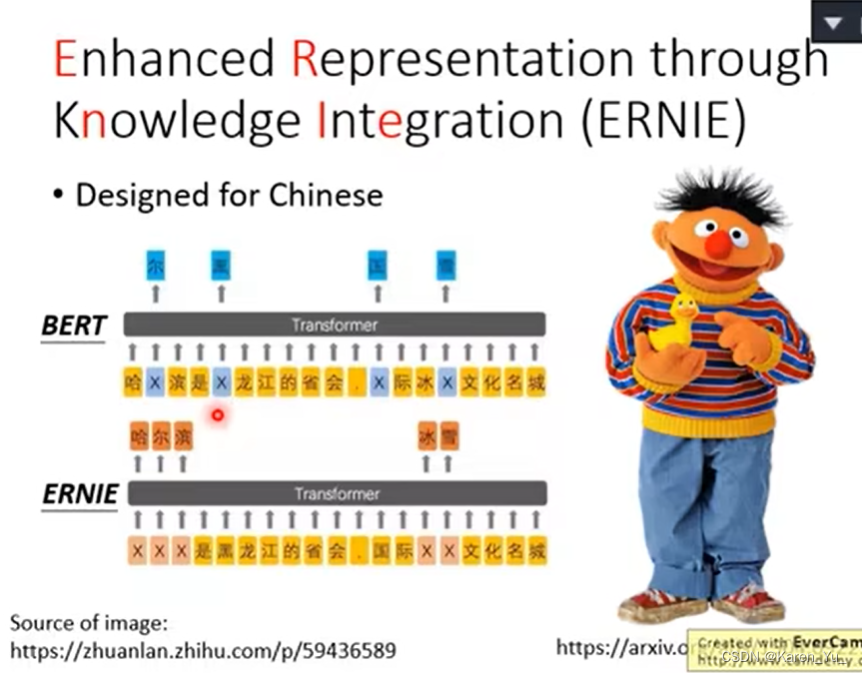

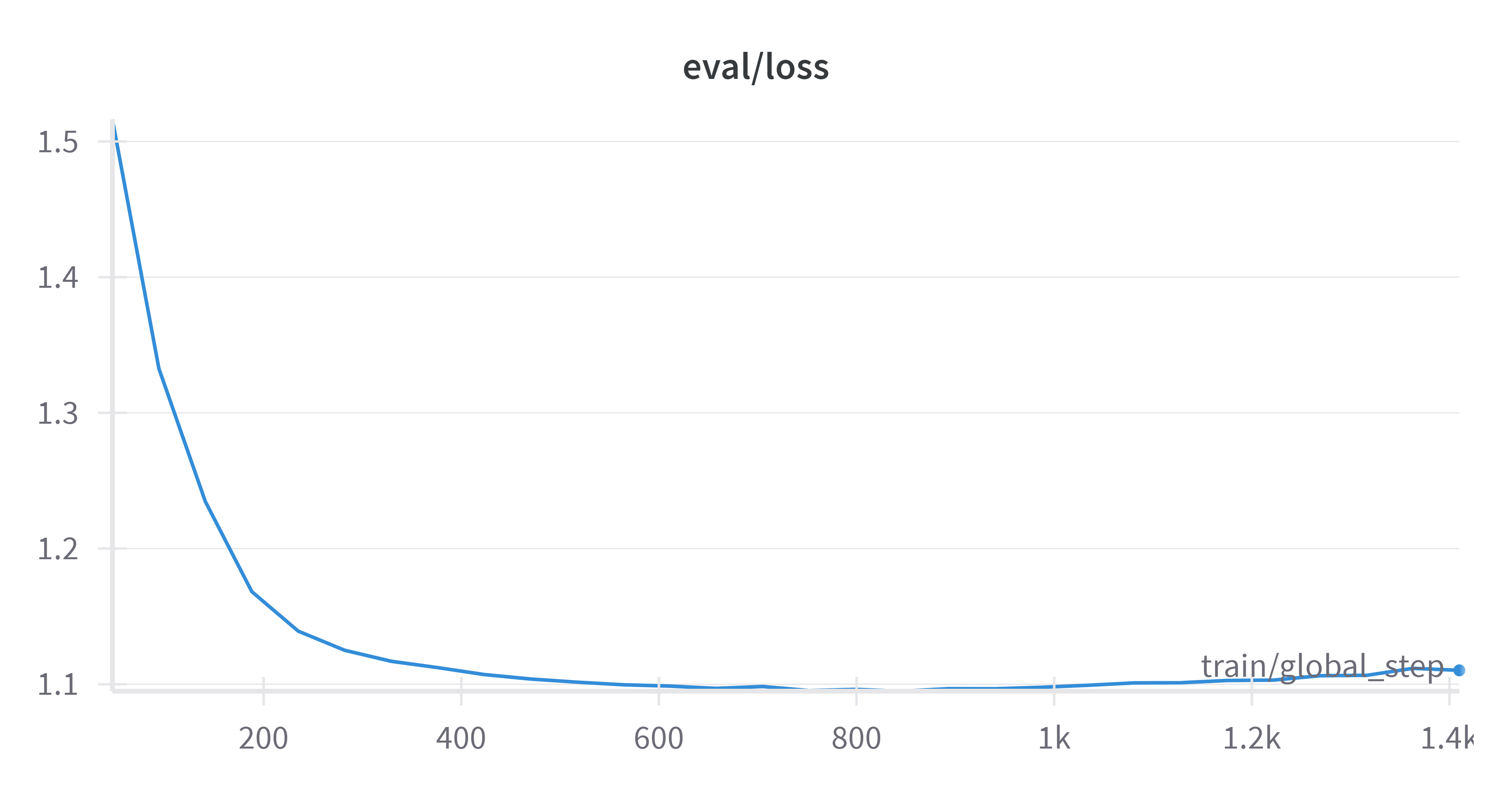

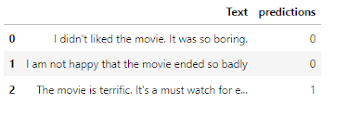

百度PaddleHub-ERNIE微调中文情感分析(文本分类)

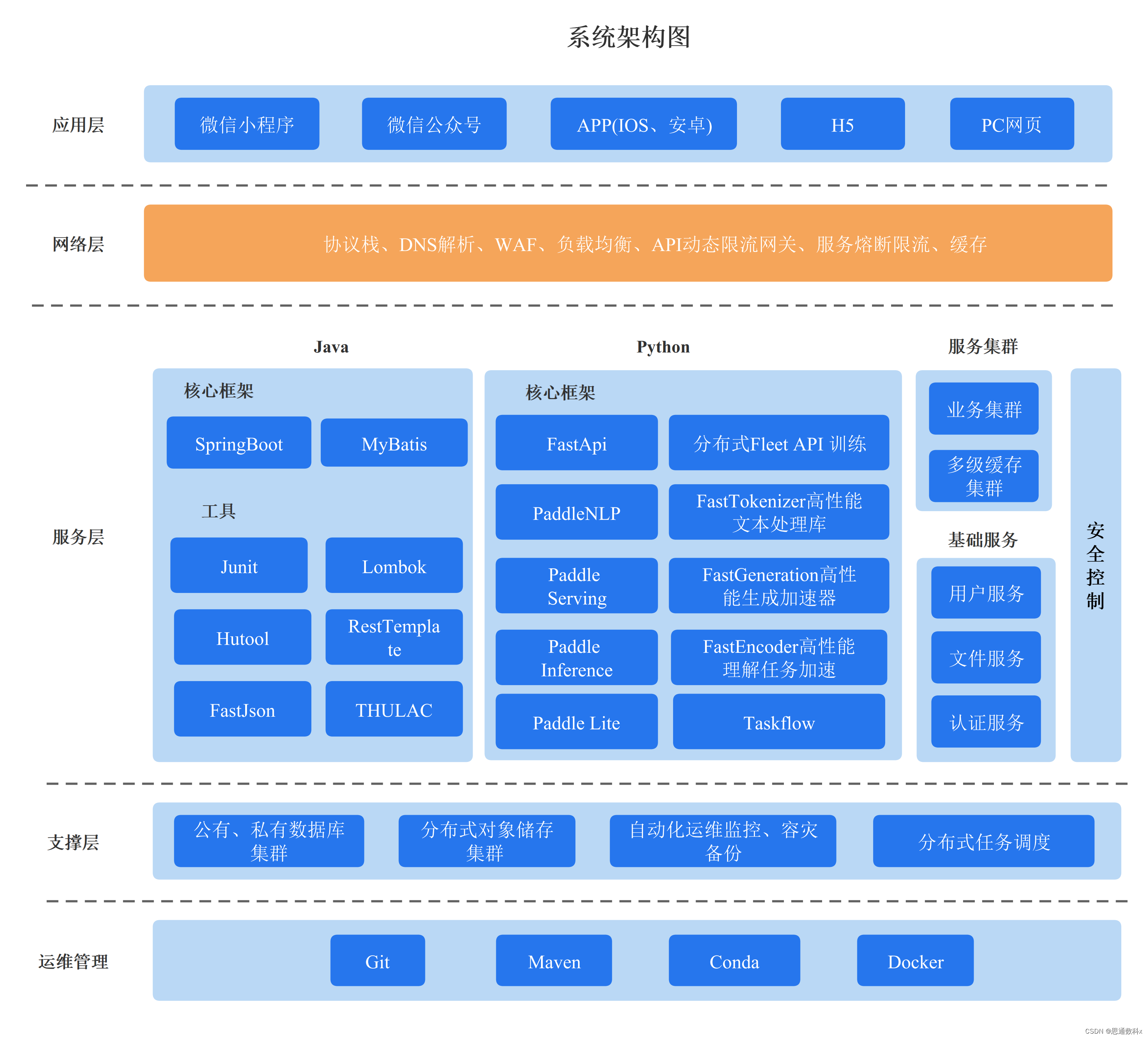

PaddlePaddle-PaddleHub 飞桨(PaddlePaddle)以百度多年的深度学习技术研究和业务应用为基础,是中国首个自主研发、功能完备、 开源开放的产业级深度学习平台,集深度学习核心训练和推理框架、基础模型库、端到端开发套件和丰富的工具组件于一体。PaddleHu…

【数字设计与计算机体系结构】2021-09-28-数字设计与计算机体系结构课程(五)(第一章补充)

第一章内容补充:

一、其他逻辑运算:

1.1:三态门:(三态缓冲门) 输出状态: 高电平、低电平、高阻态Z; 逻辑符号:(EN为使能端) 逻辑真值表&…

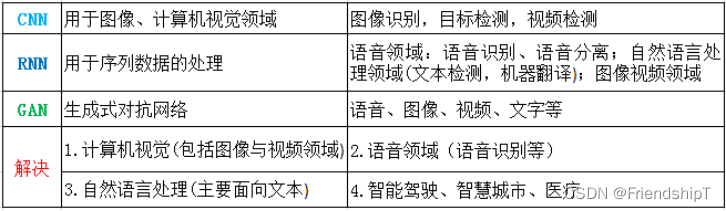

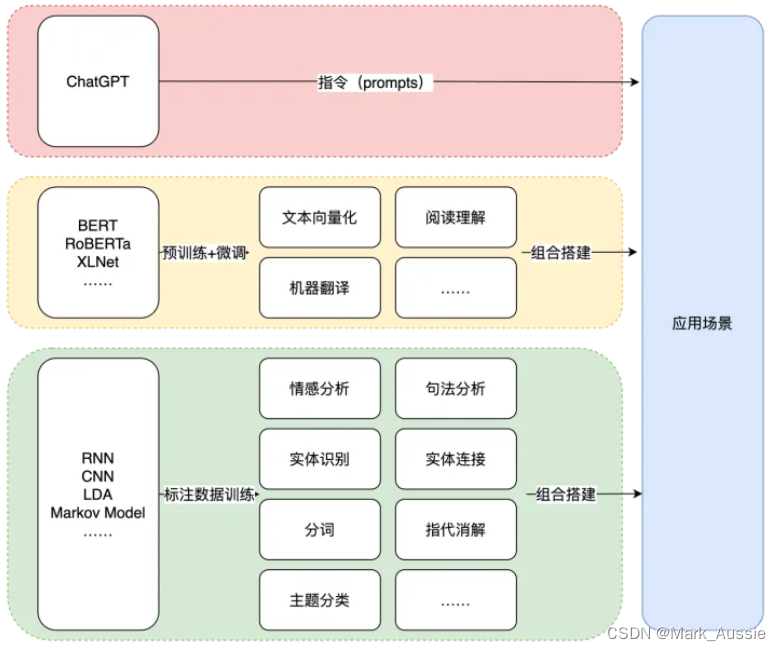

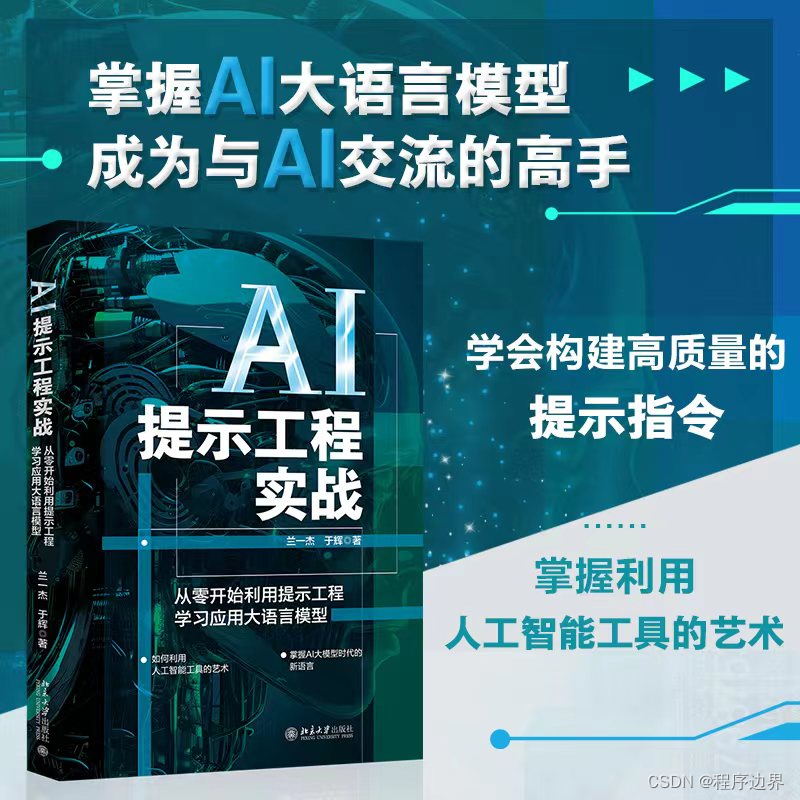

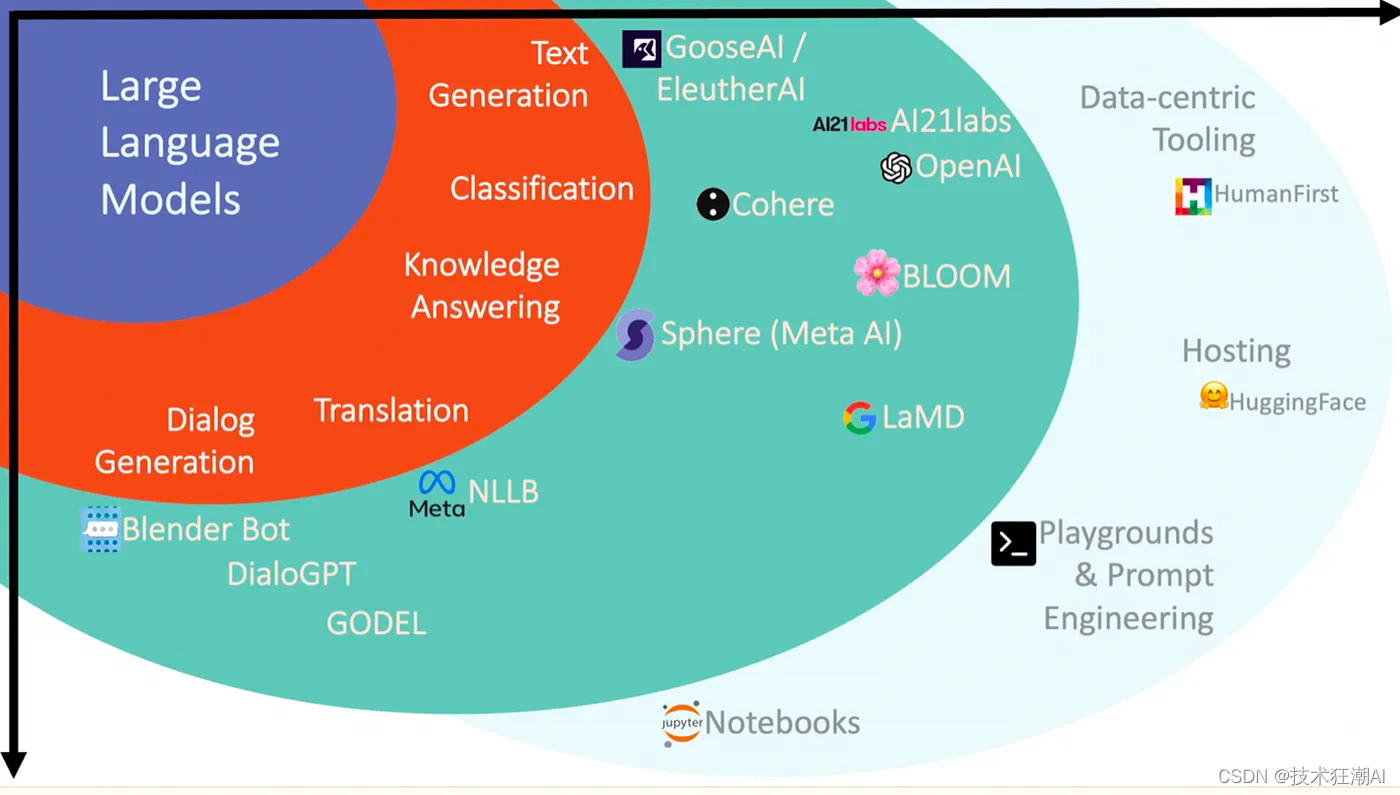

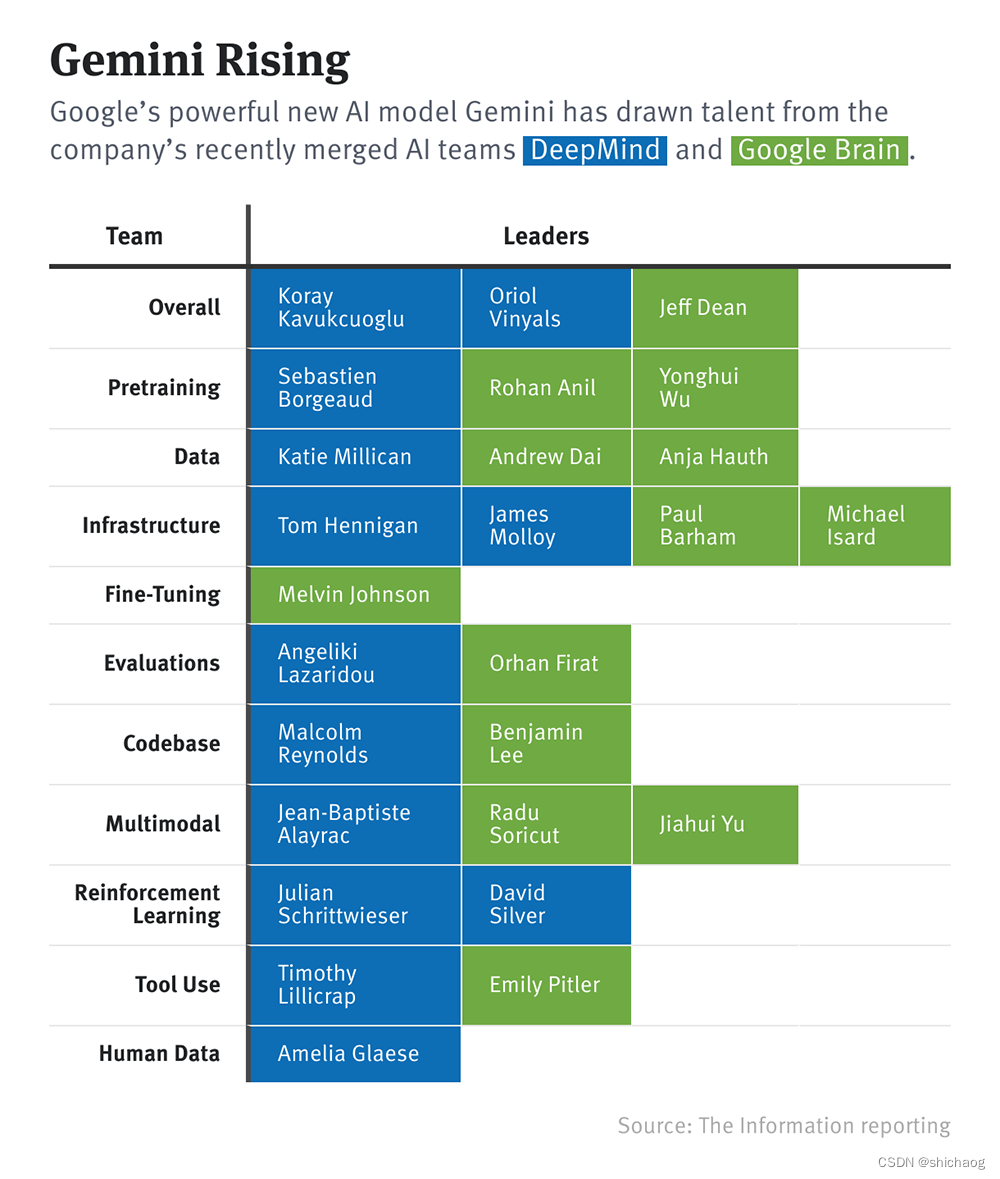

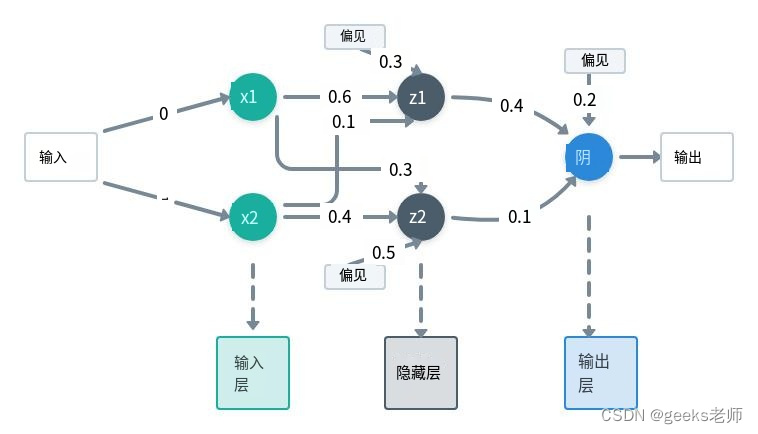

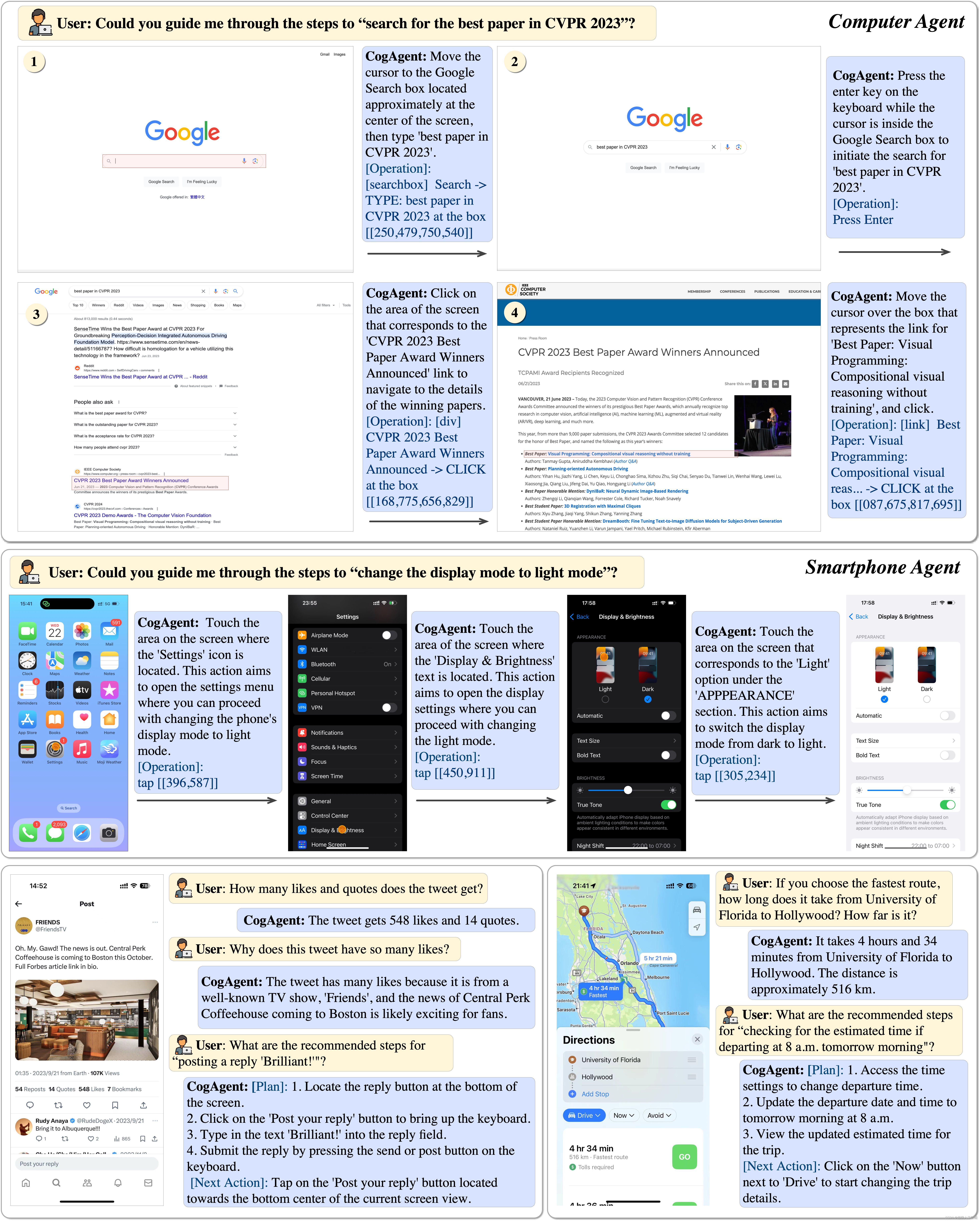

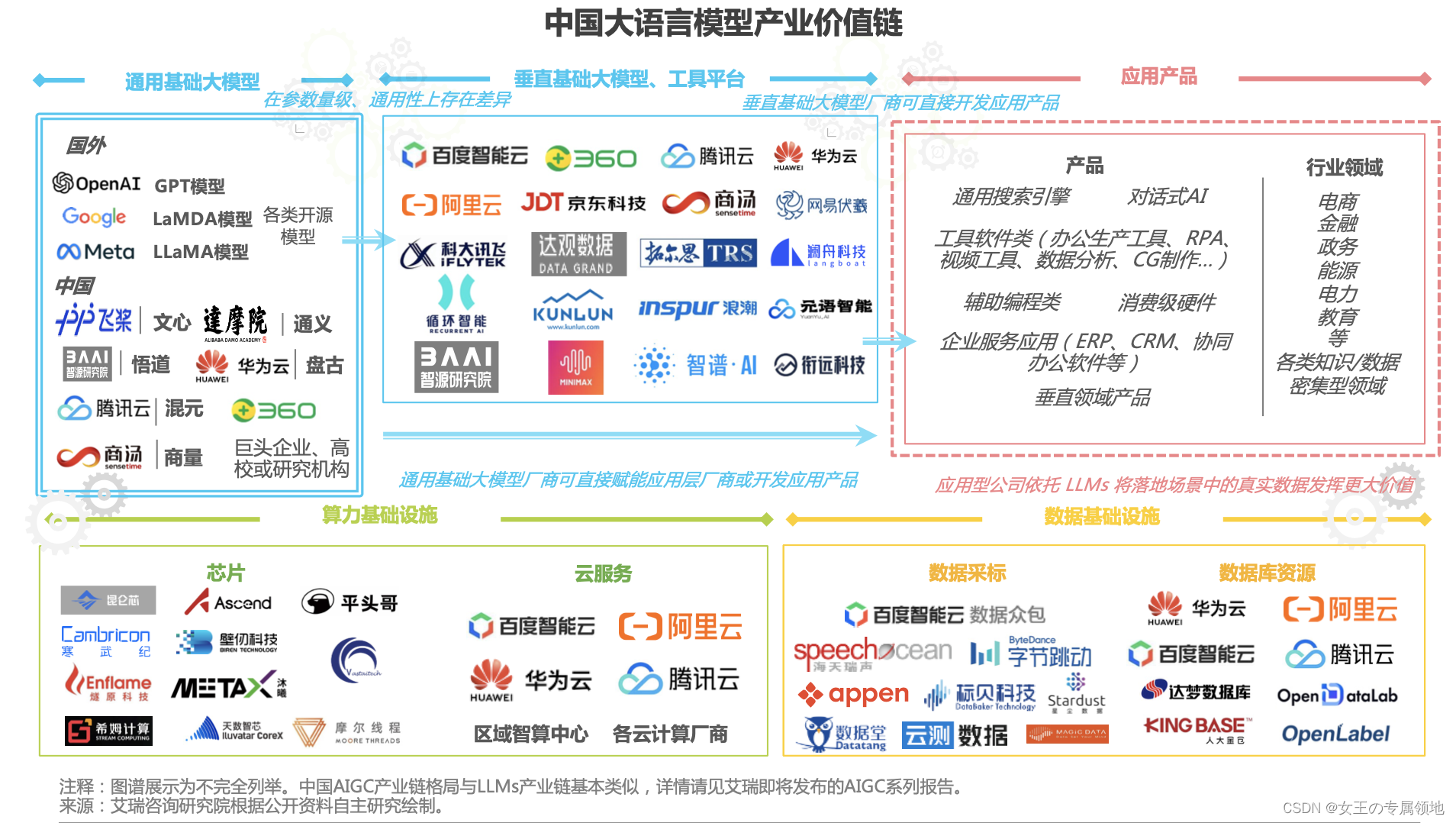

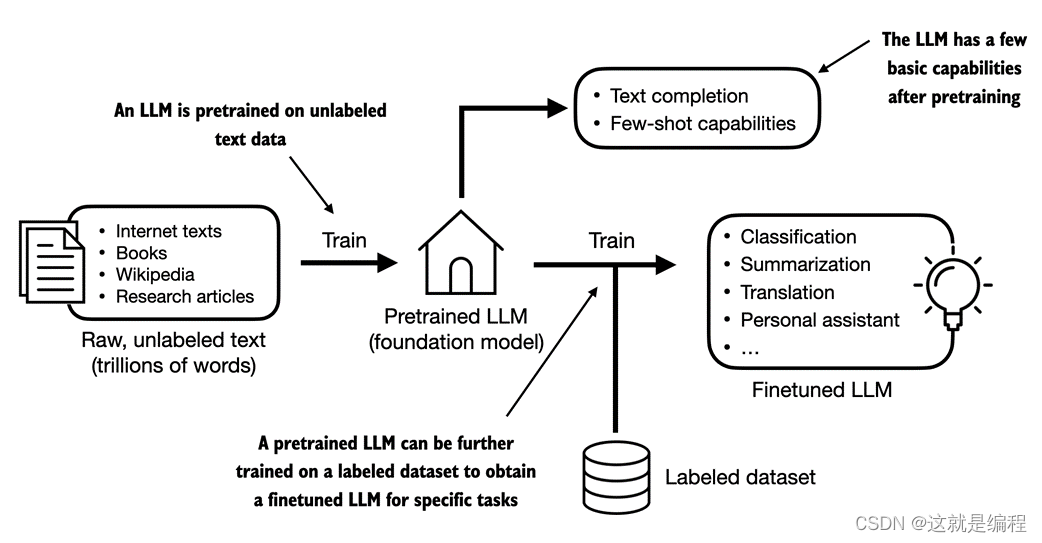

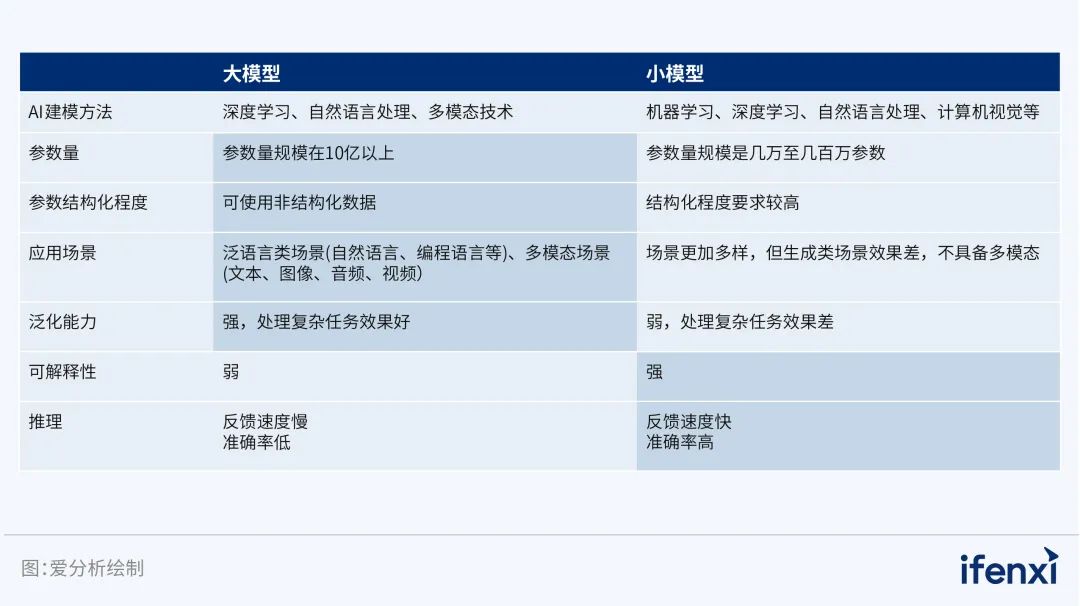

详细讲述,人工智能、机器学习、深度学习、神经网络、自然语言处理、AIGC之间的关系...

人工智能(Artificial Intelligence,AI)是计算机科学中一个庞大的研究领域,旨在为计算机创造类似人类智能的功能,例如学习、推理、解决问题、识别模式、理解自然语言等。AI的核心目标是使计算机能够执行那些通常需要人类…

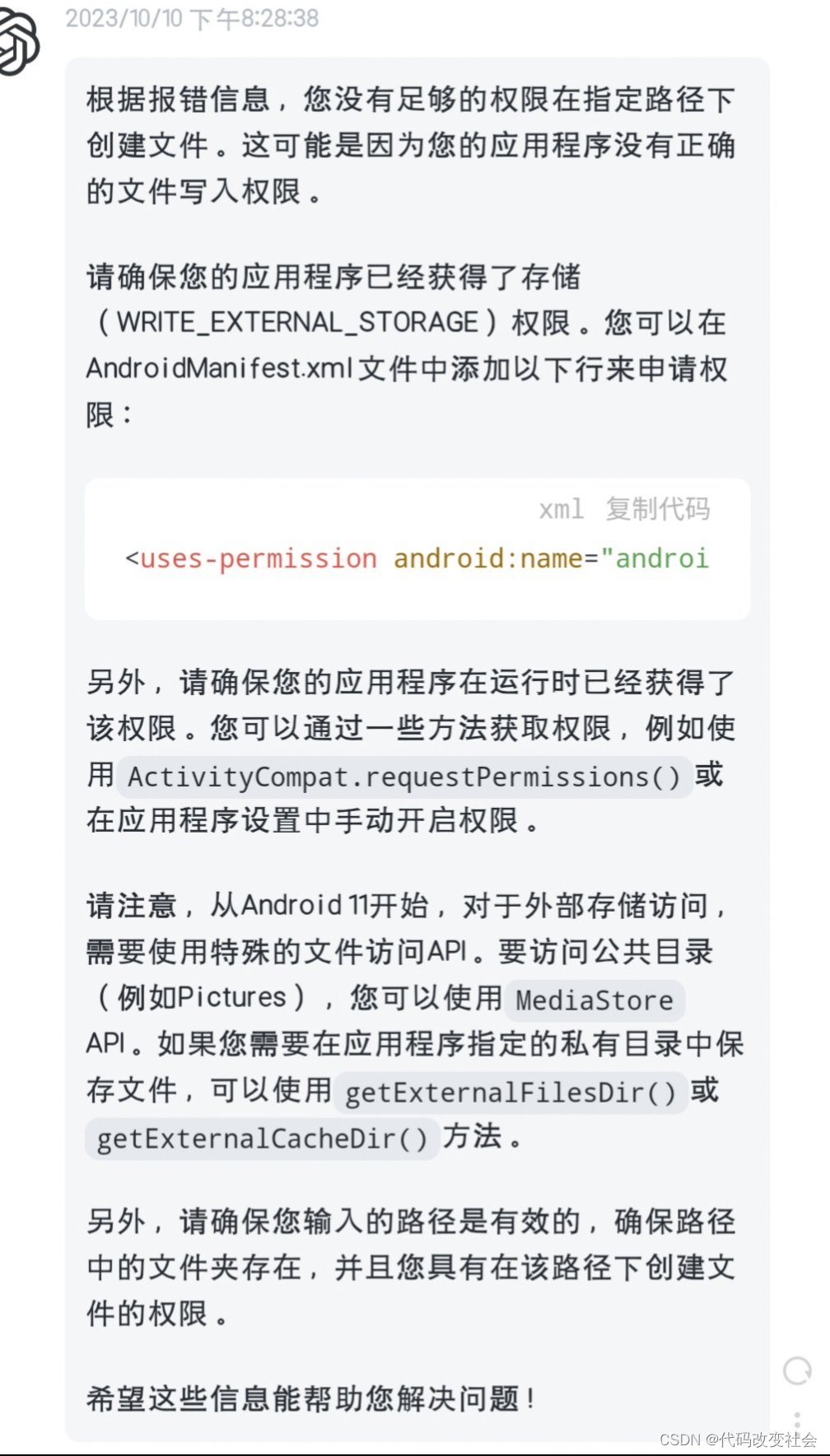

android 语音唤醒,录音并识别

在百度语音SDKDemo的基础上保存语音并进行识别

项目参考 https://ai.baidu.com/ai-doc/SPEECH/Ek39uxgre 最近在做公司的一个项目,基于百度的语音识别技术,做了一个API开放平台,准备在里面添加一部分自己的功能,对应的,平台做了就需要考虑提供配套的调用功能,在这里分享…

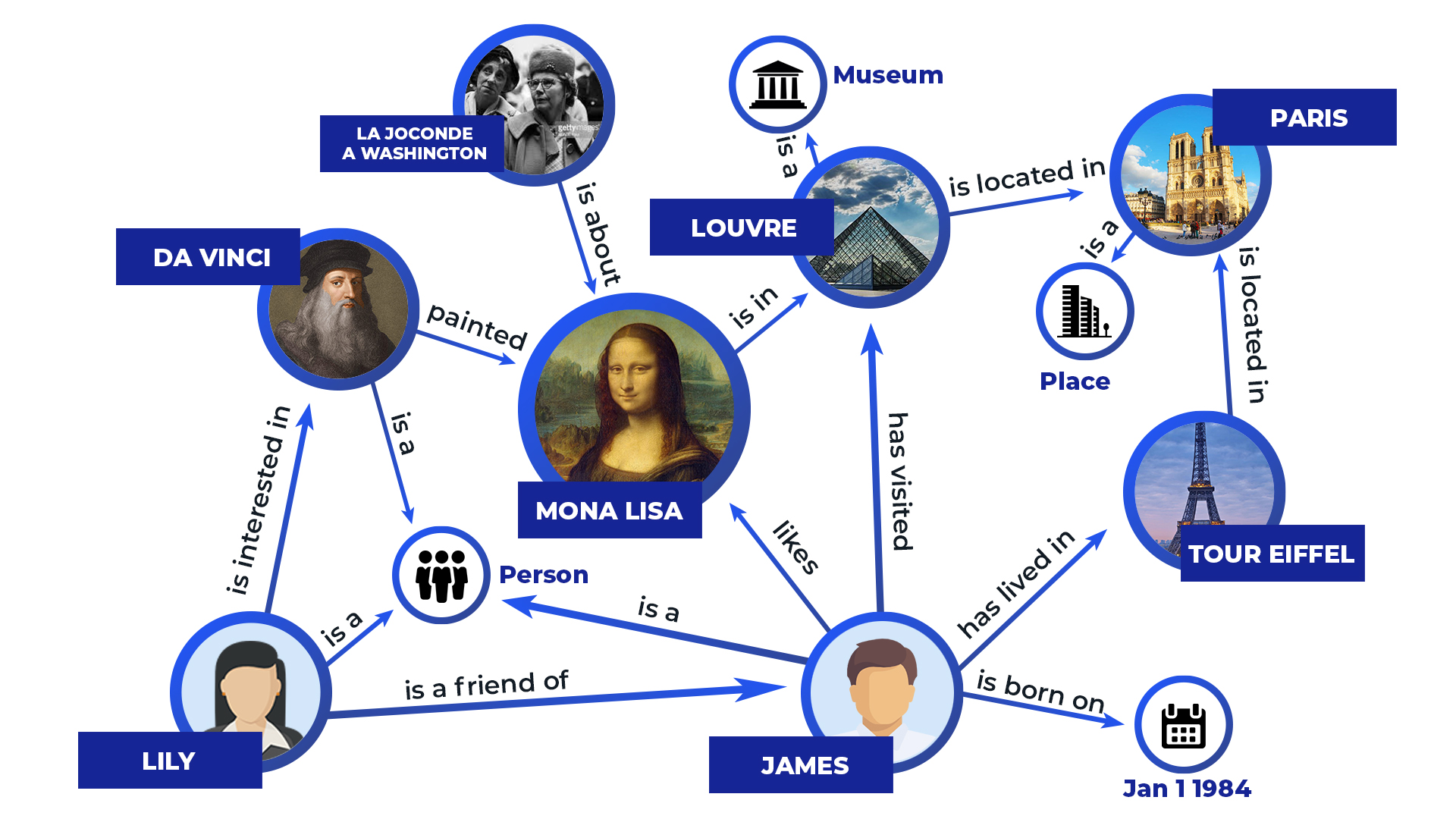

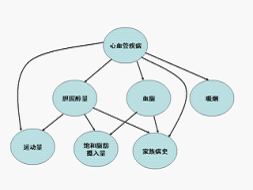

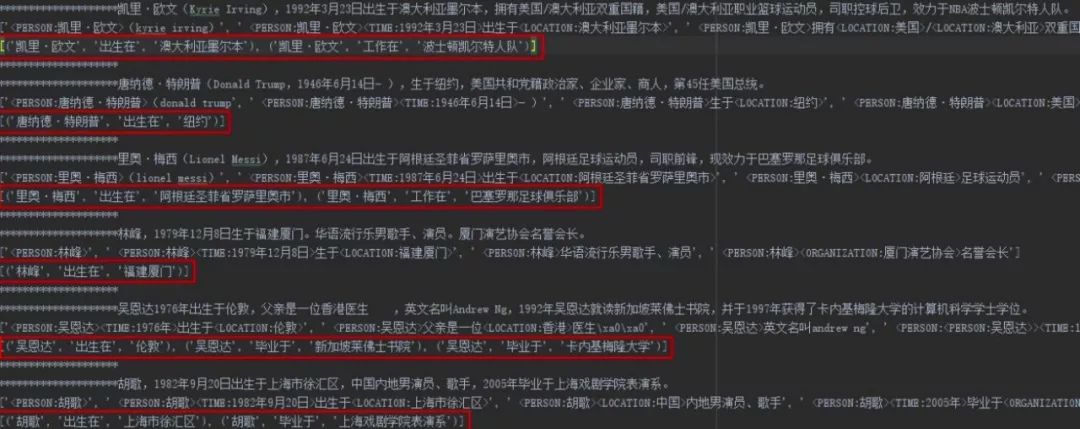

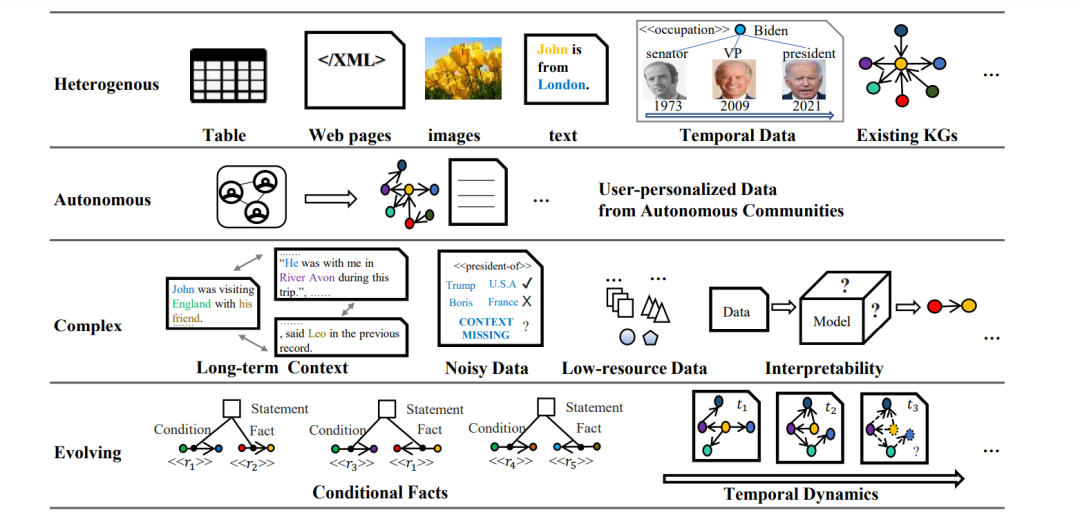

知识图谱的经典知识库总结

文章目录1 早期的知识库项目1、Cyc2、WordNet3、ConceptNet2 互联网时代的知识图谱1 Freebase2 DBpedia3 Schema.org4 Wikidata5 BabeINet6 NELL(Never-Ending Language Lcamer)7 Yago8 Microsoft ConceptGraph9 LOD3 中文开放知识图谱4 垂直领域的知识图谱自人工智能概念提出依…

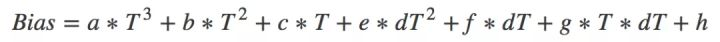

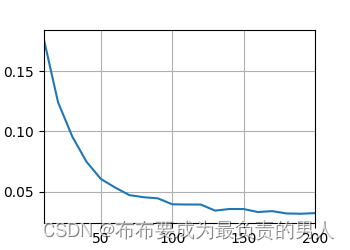

八、IMU器件温度漂移补偿

感谢大神分享:多传感器融合定位理论基础(九):凸优化基础 - 知乎 1. 概述

温补的本质是系统辨识。之前我们在介绍标定的时候,也说过一句类似的话“标定的本质是参数辨识”。这两者之间相似又不同。参数辨识是指已知误差…

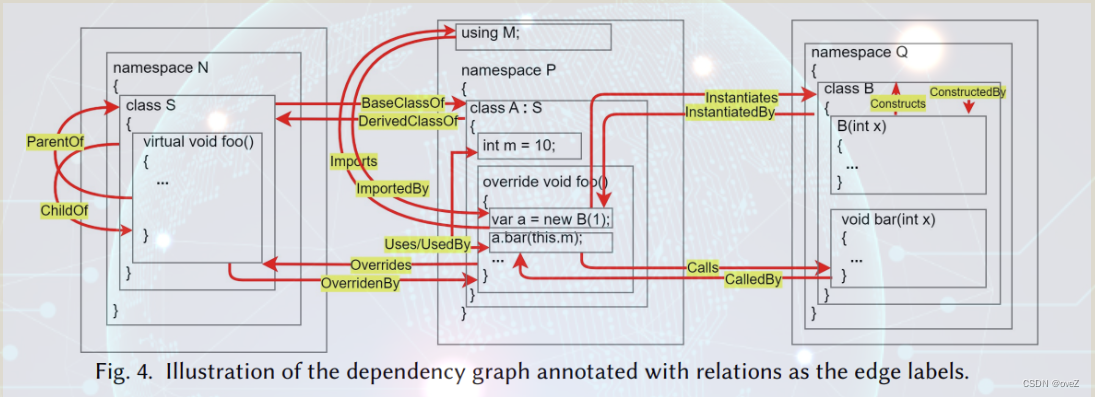

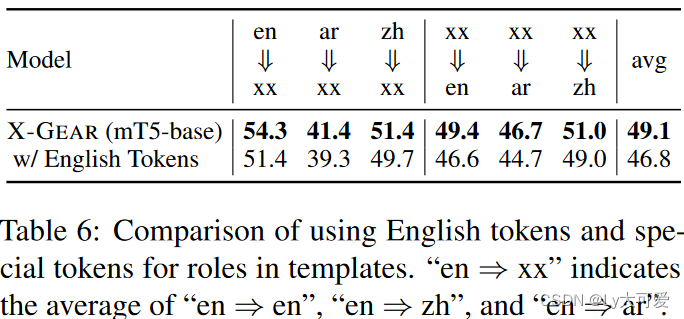

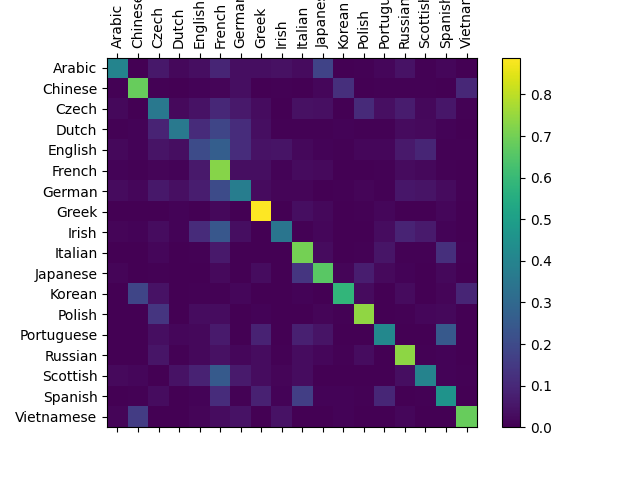

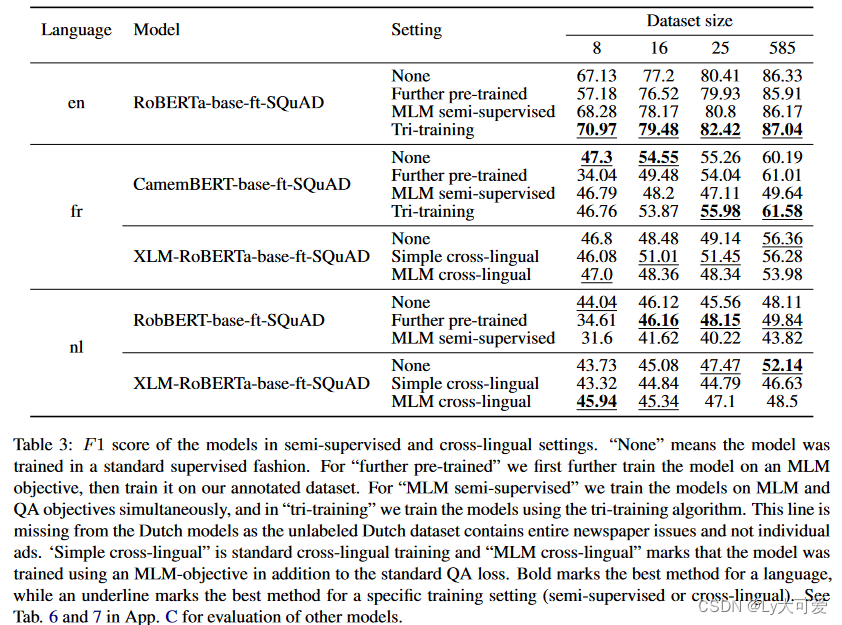

论文笔记 EMNLP 2021|Crosslingual Transfer Learning for Relation and Event Extraction viaWord Category an

文章目录1 简介1.1 创新2 Baseline2.1 仅使用源数据2.2 使用未标注的目标语言数据3 方法3.1 基于类别的对齐3.2 基于词类别的对齐4 实验1 简介

论文题目:Crosslingual Transfer Learning for Relation and Event Extraction viaWord Category and Class Alignments…

NLP-D40-nlp比赛D9-KGD1-DCNDCN+TextCNN蘑菇汤

—0836今天醒来就5点多了,鉴于前两天的教训,早上先把 论文看了。读的是一篇知识图谱的综述,大致了解了知识图谱构建的研究内容。希望下次阅读的时候更加具有目的性,这样效率会高一点。比如说,这次阅读我的重心在知识图…

NLP-D41-nln比赛D10-论文阅读的雨露均沾与思辨关于sample和保存结果open写入算法刷题

今天一定要读论文刷题看课!!!!!

----0451先读论文为敬!!! —0627其实大概6点的时候就已经读完了,后面在总结啦!还是要学习一些比较好的方式去总结学到的内容…

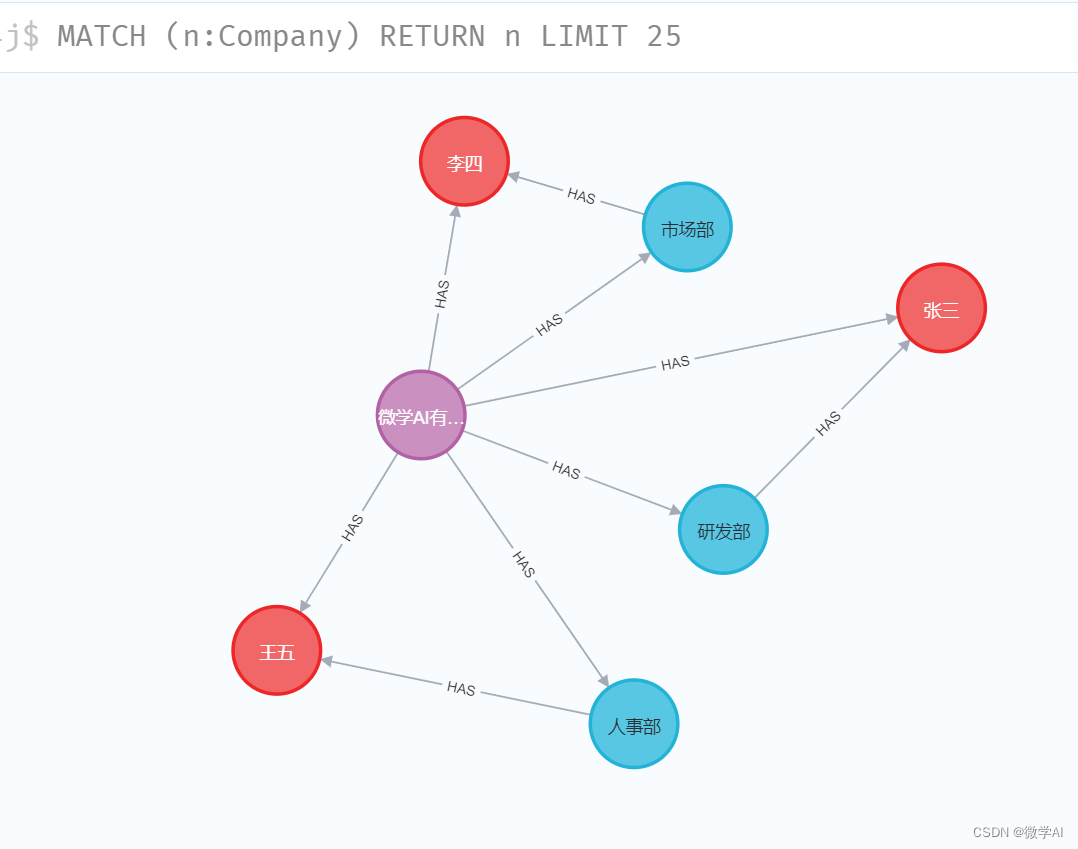

NLP-D42-nlp比赛D11-知识图谱与可视化关系读论文D2789差分矩阵人类语言处理7-8训练trick

—0515

知识图谱可视化比正常数据可视化区别

搜索后的个人看法: 1、实体对象 知识图谱更general,倾向于异质网络;传统可视化更倾向于同质化网络的分析。 2、联系 知识图谱的图结构可以支持数据可视化 3、“知识”处理 知识图谱倾向于知识本…

NLP-D43-nlp比赛D12-论文下载-《人类语言处理》09差分矩阵最长不重复子序列

—0741早上下载了大概150篇论文,真的太爽了!!!

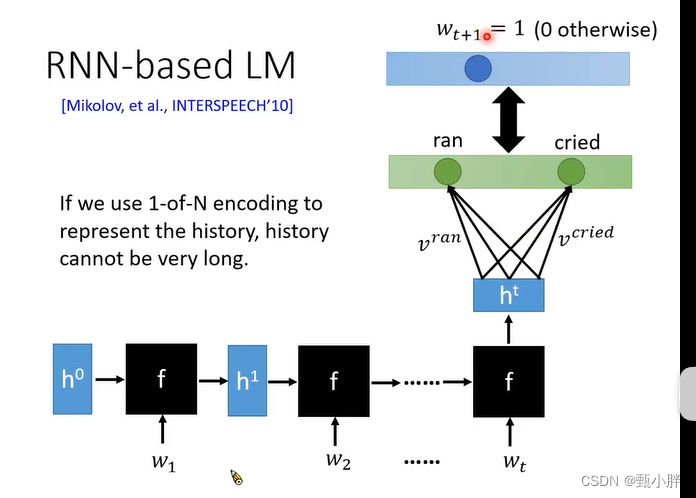

《人类语言处理》09

哇真的太精彩了 1、结合LM可以解决domain的问题!!! 2、我感觉NNbase和RNN-based LM没啥区别呀??&am…

NLP-D44-nlp比赛D13-zeteromarginnote3读论文【被惊艳到】刷题

—0438今天早上要先花一些时间看zetero怎么使用。 感觉暂时还用不到,先读文叭!!!

文献阅读工具与标记

黄色用来标注想要引用的内容(添加标签文献综述或数据) 蓝色标注作者主要思想与行为逻辑 绿色标注可以…

NLP-D45-nlp比赛D14文献阅读标签mac-bert时间大局观

—0357今天3点半就自然醒了,做梦梦到的都是论文、模型之类的omg 希望今天可以目标导向,提高效率。

文献阅读

1、引用标签 引言背景(直接引用) 句型(值得学习的句型或词汇) 可引用(硬核的知识文…

NLP-D46-nlp比赛D15

—0557昨天2点睡的(弄完12点啦,有点想熬夜hhh)早上5点多醒了,就醒了。

刚刚改了改程序,现在跑着; 自己去看论文啦!!!

2-不重要-已读 0-重要、需精读 1-重要、已读完 3-…

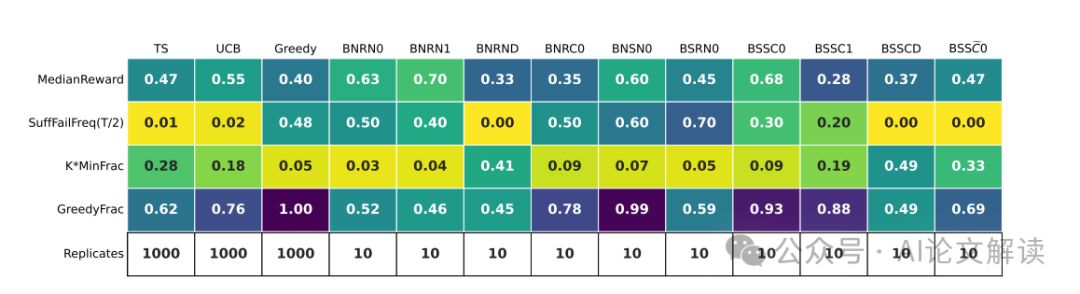

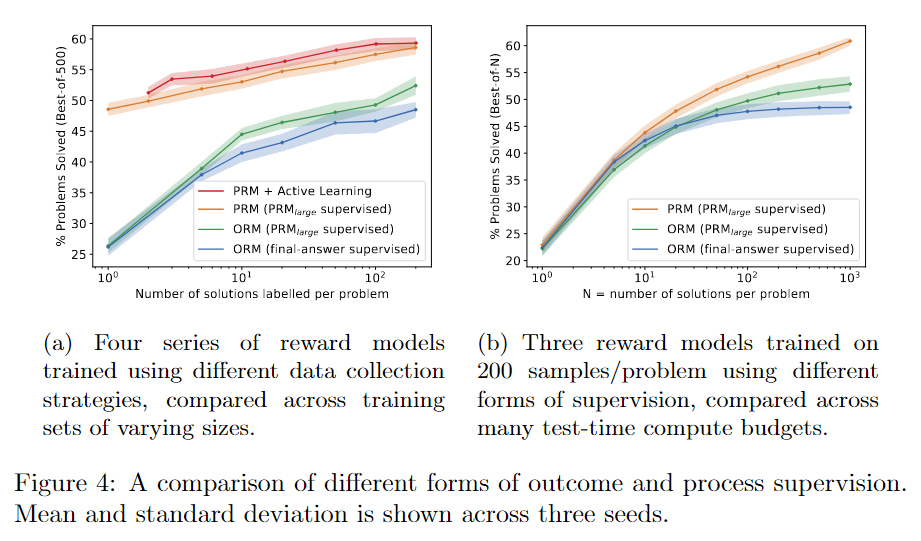

NLP-D47-nlp比赛D16-读论文D8主动学习算法

----0515 效率管理策略逐渐生效,早上起床后的时间还应该缩短,大概20分钟应该完成,减少不必要的信息摄入,日记、todo、总结在前一天写完最好。 ----0654读了2篇论文,目前可以保证20分钟读完,但是整理会比较慢…

NLP-D49-nlp比赛D18-重燃希望

----1250 嗯,早上睡了一会以后,把另一个task也改了一下~~~ 现在基本再测试一下就可以跑了~

感觉又充满了希望!希望自己能在剩下的几天里,把文本分类弄明白!!!

----2009

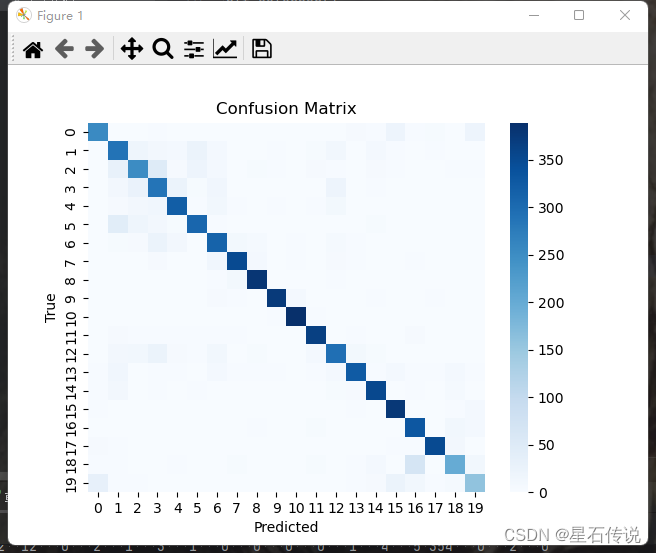

confusion_matrix返回…

NLP-D50-nlp比赛D19-Deberta深入超级想做题+看论文新比赛++

—0724早上醒来就六点二十啦~~~吃完早饭就现在啦!!希望以后早上刷牙洗脸之类的能快点,尽快进入工作状态。 上午: 跑代码 学习原理 做任务3.1的inference 做任务3.2的inference

感觉最近一切都养成了很好的习惯,已经非…

NLP-D51-nlp比赛D20发现超级inspiring的小哥哥l量化

----0722 周信静小哥哥真的超级棒!我的榜样!

deberta代码原理

—1622诶妈呀,一不小心就现在了鹅鹅鹅~ 趁着等我的神丹的时候,先去看看翻译~~

—1646去跑步

–2311 弄了弄量化,要睡了

NLP-D52-nlp比赛D21刷题D8量化图D1

—0628 先改模型跑起来要尝试bert和roberta作为baseline

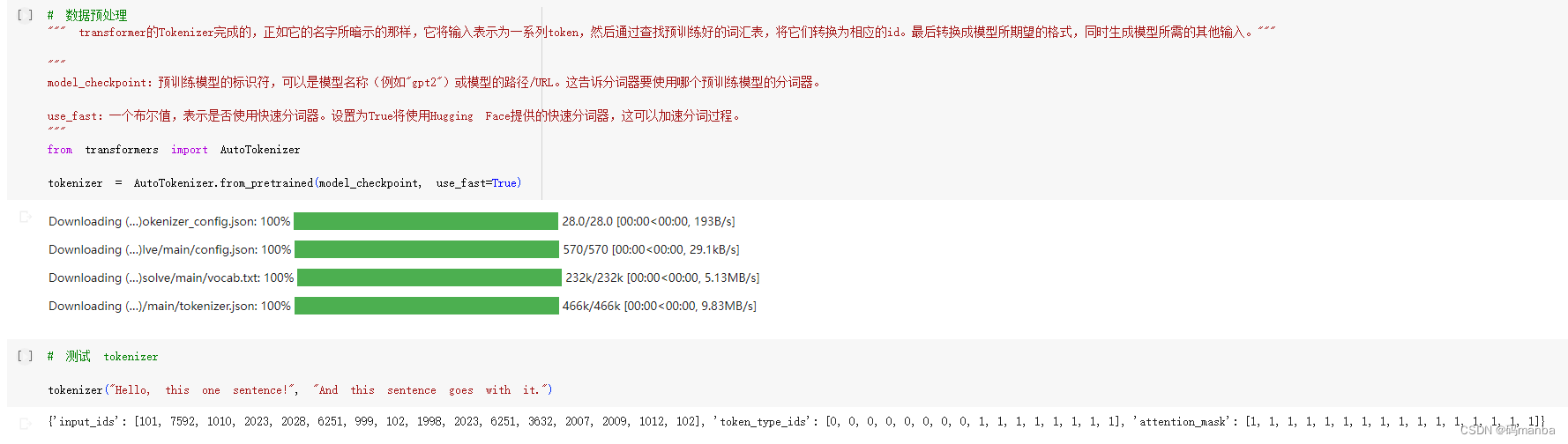

Autotokenizer

应该会自动填充完那些需要的字符,比如[CLS]

参考:https://zhuanlan.zhihu.com/p/341994096 https://www.kaggle.com/code/maroberti/fastai-with-transformers-bert-roberta/no…

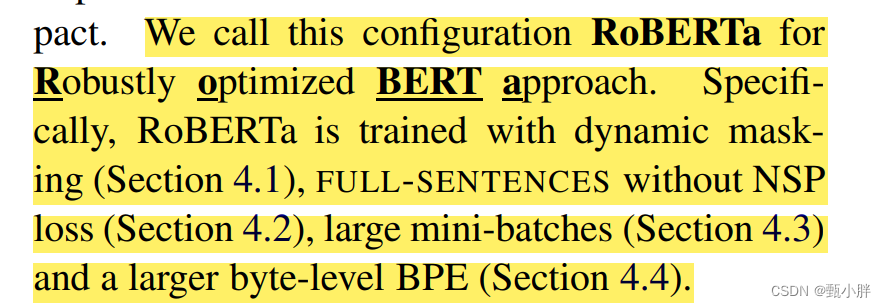

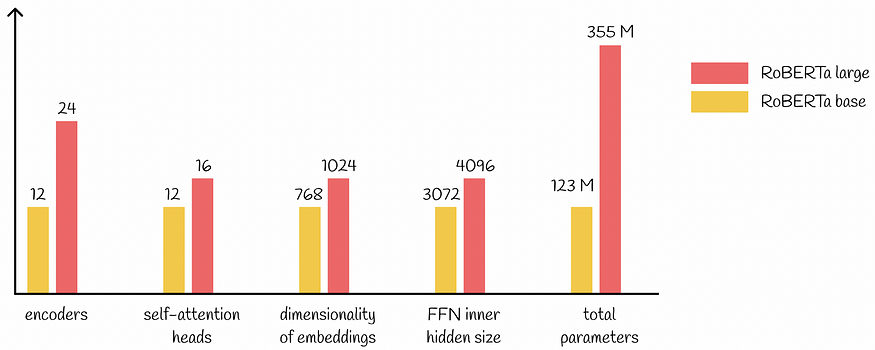

NLP-D53-nlp比赛D22刷题D9《人类语言处理》p13深入Roberta量化D3

—0554已经读完三篇论文了,还算有收获,发现一篇很novel的,很喜欢。 现在开始刷题!!!

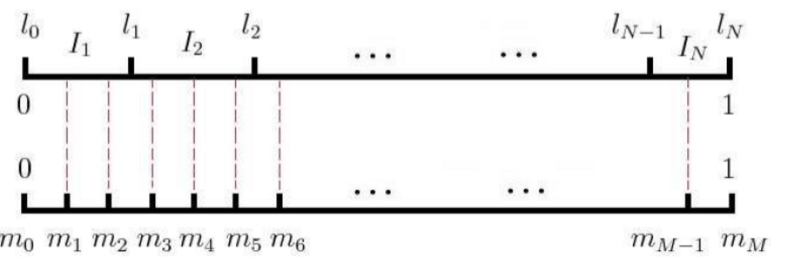

802区间和-离散化

我感觉这题还是很难理解的,而且二分又有点忘了。。 适用范围: “雷声大&…

NLP-D55-nlp比赛D24刷题D11读论文D12

–0701今天5点多才起,但不知道为啥还是有点困,只是一点点身体上的疲惫,感觉大脑运转还ok。刚刚读完论文,关于教育、本体、关系抽取,都是比较老的文章了,2019,2020的。啊啊哈哈哈。 现在开始刷题了ÿ…

NLP-D56-nlp比赛D25刷题D12读论文D13NLTK

—0406读论文读论文!!

–0530开始写代码啦~~~感觉脑力还是比较充沛的!!!

—05558太刺激了,冲了一会浪

开始写代码啦!!!

802区间和

整体思路上没什么问题——区间和解…

NLP-D58-nlp比赛D27刷题D14读论文mathtype

—0612昨天晚上看The PHd. Grind 看到了大概一点,今天醒来就5点多了。要重整旗鼓,要乐观,要做自己喜欢的事情。最后要对这段旅程进行总结反思。 现在要读论文了! 在读的时候思考以下几个问题: 1、我在做的事情有什么价…

NLP-D60-nlp比赛D29

—0637一觉醒来,仿佛一切都好了,更加坚定了!!! 刚刚花了88块钱买了marginote更要好好读论文和看书了!! 读完了我的天,今天心情好好啊

NLP-D62-nlp比赛D31刷题D15

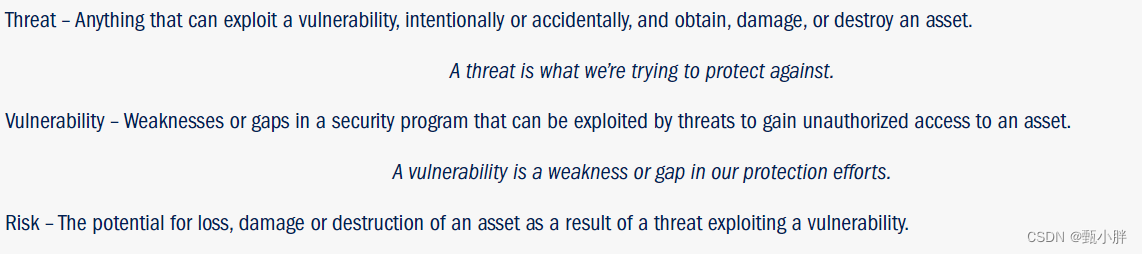

vuneralbility和weakness的区别

好像没有区别,需要去区分的是threat;vulnerability;riskhttps://www.threatanalysis.com/2010/05/03/threat-vulnerability-risk-commonly-mixed-up-terms/ 又好久没刷题了,但是不能停!!ÿ…

NLP-D22-cs224nUNICORN多层感知机房价预测kaggle

–0519今天0430起床的,早上开始看cs224n,感觉老师好可爱! 现在开始读论文啦!

一、Unicorn

—0558感觉还是有创新的!但是一时间说不上来?可能是时间与关系在溯源图中的综合??&#…

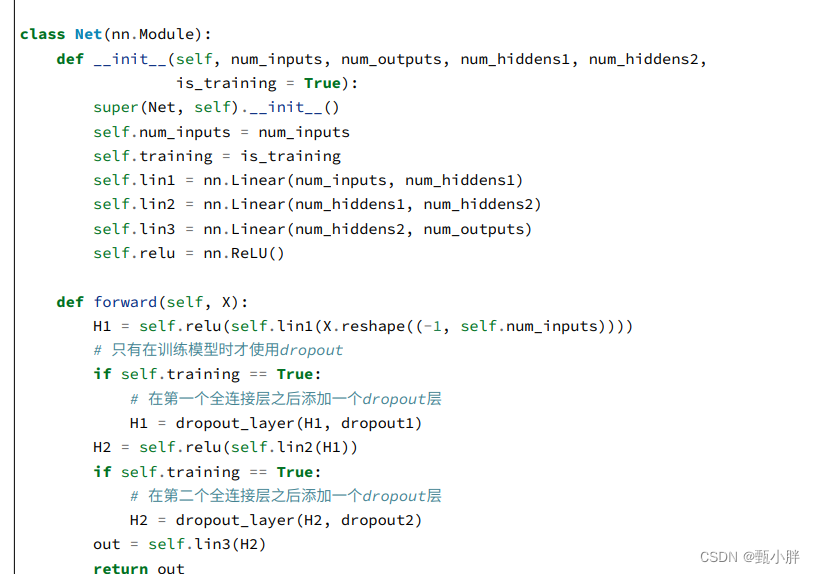

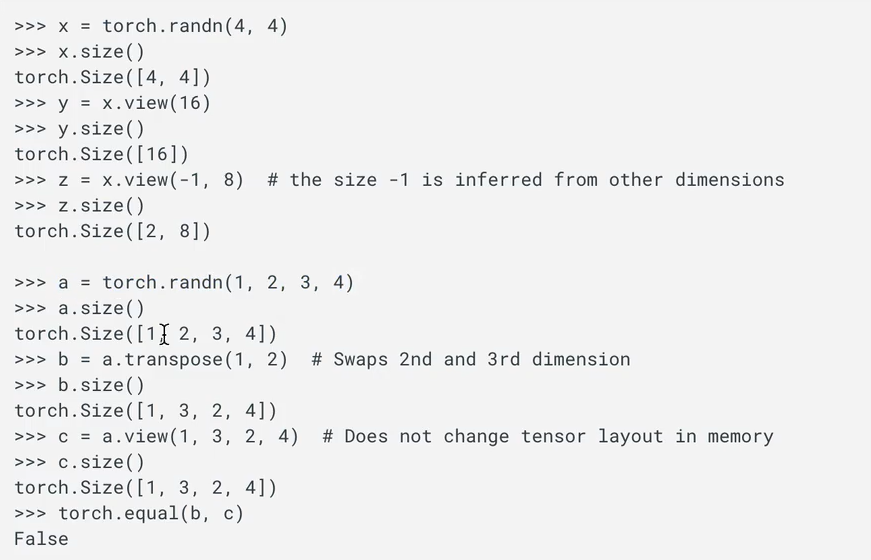

NLP-D21-UNICORNpytorch实践

–0613看了一会论文,但是还没完成今天读论文的任务。维护了一套模板。先去吃个早饭!

–0632继续看会论文

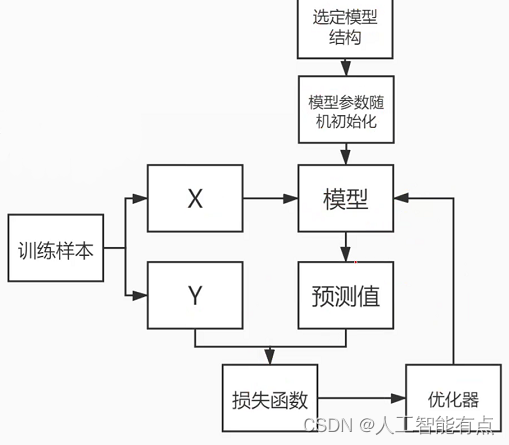

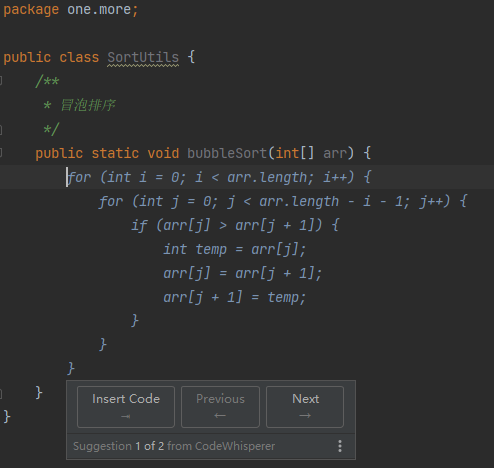

—0647 开始敲pytorch了!!! 1\训练流程 初始化 重复: 计算loss 计算梯度,更新 2\训练…

NLP-D18-HOLMESExtractor

四点起床,零零碎碎弄到现在已经0453了,开始看论文。

一、HOLMES

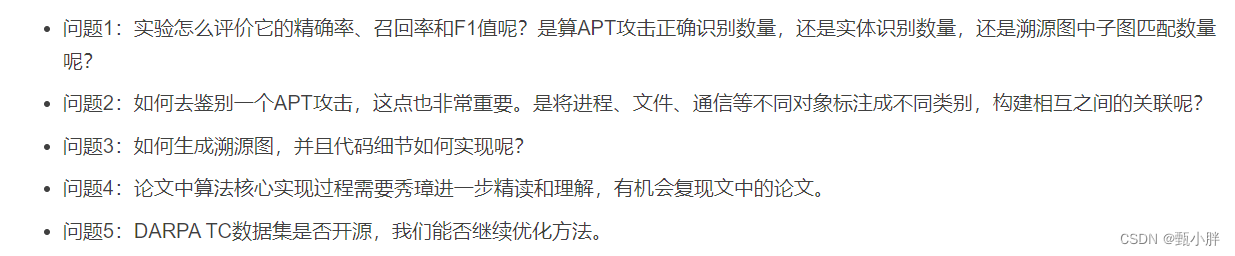

----0709 读完了,顺便看了这个,还需要好好对比和总结这5个工作啊 大佬提出的问题

好困,去收拾宿舍了。 —0800看了一堆杂七杂八的,关注…

NLP-D17-安全论文HOLMES

—1040我真的大无语,想尝试在csdn上做论文分享,结果内容太多,这个网站也没给提示,结果打了很多东西,提交了以后都没有了,我也是服了。 下次直接往word里写了,哎。

–1046诶,顺序好像…

NLP-D18-POIROT很无语很多内容写上了都没被保存上

—0500以后任务都要严防死守啦!! 开始读论文!!!

一、POIROT:使用内核监听记录对齐攻击行为,实现网络威胁捕捉

(一)摘要: 1、原版 Cyber threat intelligenc…

NLP-D10-os.system()transformers api

—0807早上4点多起来把论文正文翻译了一遍,又找了一个杂志请教了一下老师,老师说可以试试投投看,那一会就把那个杂志的所有相关论文找出来读一下,然后根据格式改一改。 吃早饭的时候看了一会知识蒸馏,讲学logits还可以…

NLP-D38-nlp比赛D7-pytorch踩坑继续刷题

—0440呜呜全新的一天开始啦!!!今天任务更多,也会过得更加充实,成长速度也会更快! 刚刚在kaggle找了找相关比赛,发现没有,于是只好自己改啦!!!

.…

pack_padded_sequence and pad_packed_sequence

此文章为阐述pytorch中pack_padded_sequence 和pad_packed_sequence的原理

在变长序列文本中,一个batch中的各样本长度可能不一致,在使用RNN模型时,需要填充至统一长度,被填充的位置实际无意义。我们通常取最后一个时刻的输出作为…

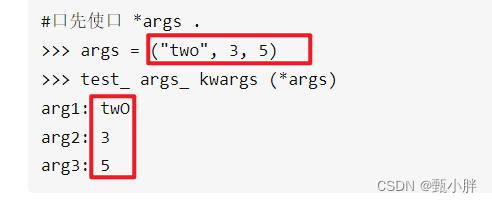

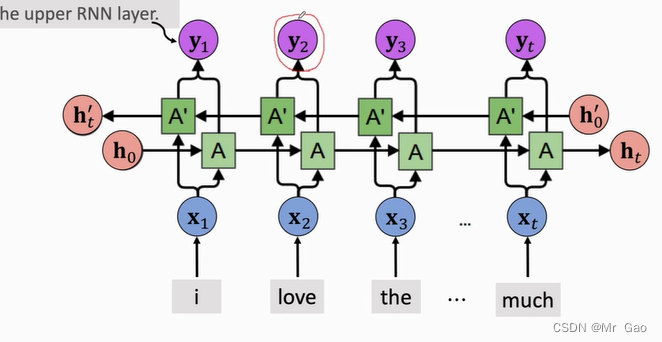

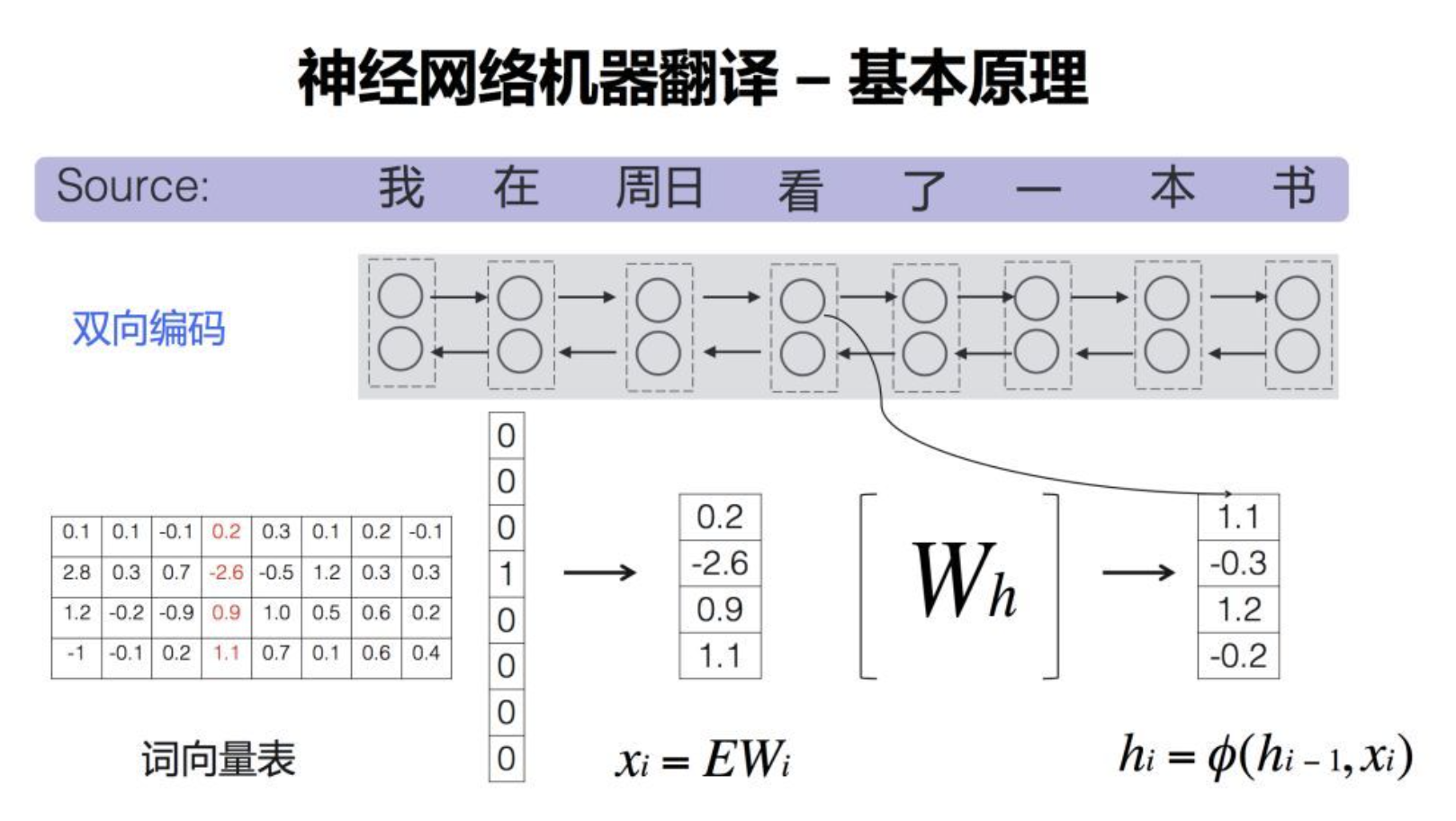

NLP-D28-深度Bi循环神经网络| 翻译模型与预测模型之预处理|data.DataLoader(*arrays)|encoder-decoder|*args**kwargs

----0530虽然昨天1点才睡,但是早上5点就行醒了,除了眼睛有点不适之外,没什么别的感觉。今天打算先把毕业设计的视频录一下,然后就可以把沐沐 的课和代码看完了,然后!!!终于ÿ…

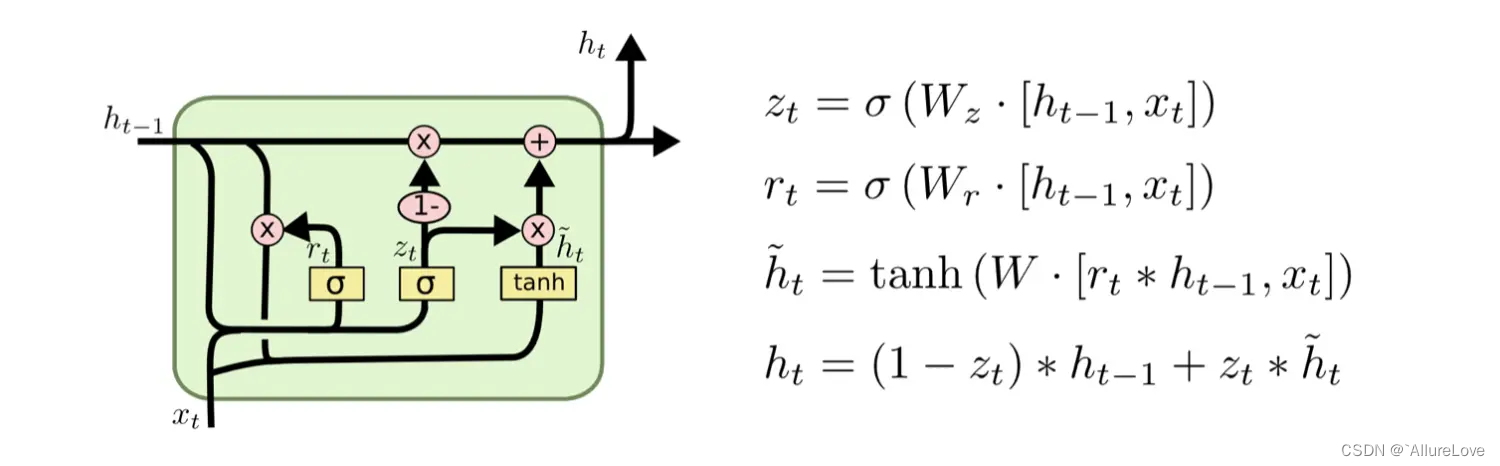

NLP-D27-梯度剪裁-LSTM-GRU-毕业答辩ppt

—0436标题为nlp,但是到现在还没看宝可梦!不过感觉越来越近了!今天虽然是周六,不过还是4点就起了,最近这个时间的学习效率越来越高,不是在自我感动,要努力,要出活。

—0507写了近期…

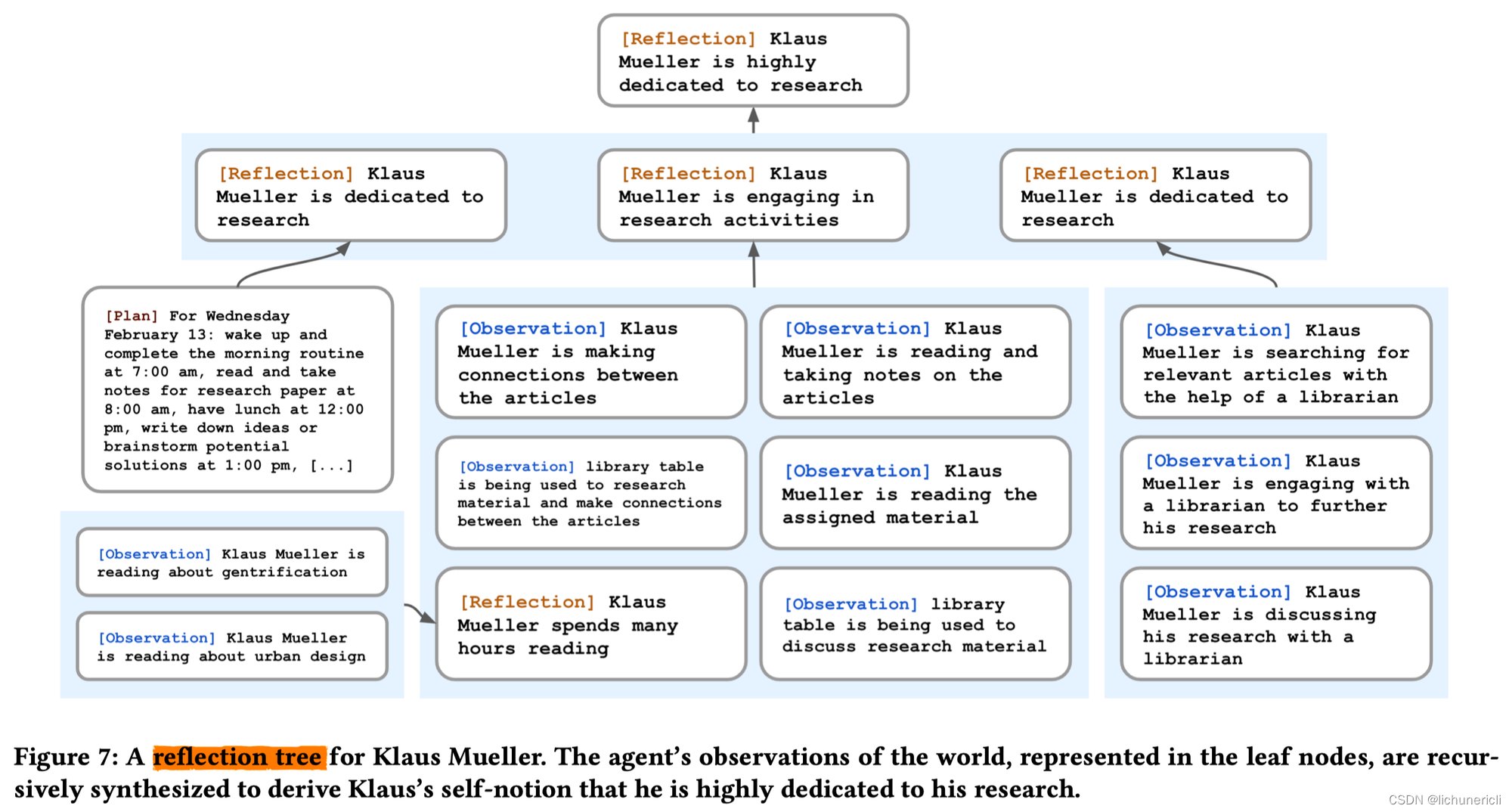

NLP-D37-nlp比赛D6-DMN《人类语言处理》05

—0450哎,早上网页打不开,把浏览器缓存都清了。内心想哭呜呜呜

现在开始看DMN了hhh

讲的好好

哈达玛积可以计算相似度吗

不理解,感觉只是做一下input和q的交互??然后让参数自己学习到相似性关系?&#…

NLP-D36-nlp比赛D5-深度学习框架Allennlp《人类自然语言处理》05修capturatf相关-if __name__ == “__main__“HANDMN

—0534一觉醒来以为晚了,一看才5点多一点。收到了sx的消息,真的是太细了呜呜呜。写一写总结和计划要开始学习啦~明天就是6月1号啦!上半年最后一个月,要把flag立好!!!【胖胖正在窗户旁边看风景呢…

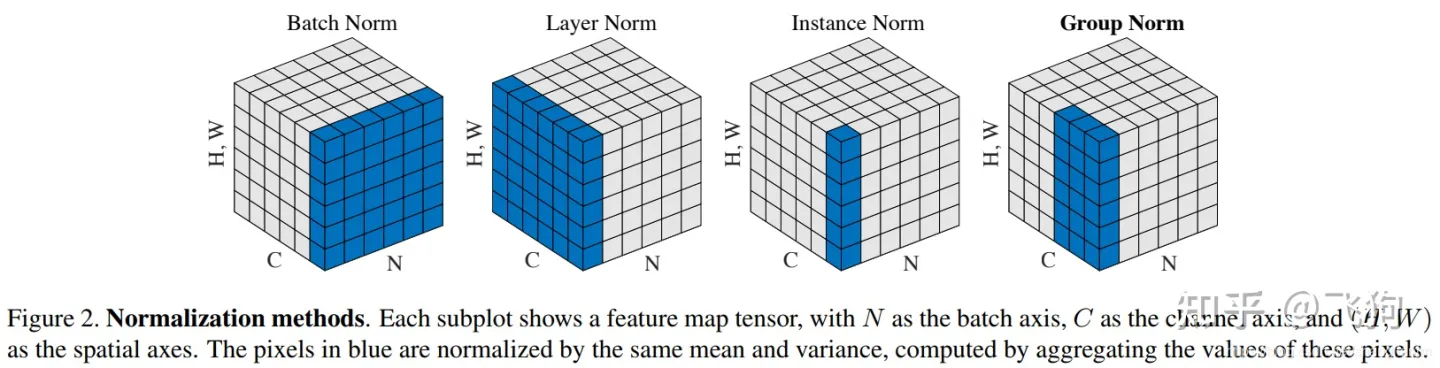

NLP-D34-nlp比赛D3【run baselines】-《人类语言处理》05二刷batch_norm毕业哭哭

----0444我要跑代码我要跑代码我要跑代码,重要的事情说三遍!

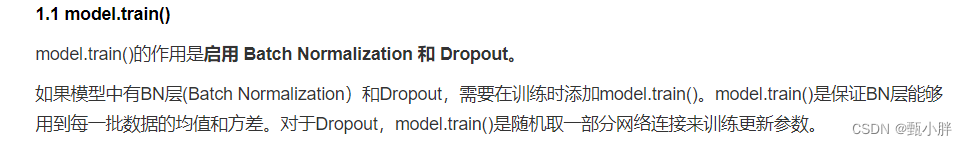

1、batch_norm需要区分训练和测试

今天突然想不起来batch_norm需不需要区分训练和测试了,只记得正则是需要的。经查询,是需要的。我回忆,大概是因为batch…

NLP-D34-上手nlp比赛-《人类语言处理》05-RNA

—0407一早起来就看到师兄消息,这工作流极度舒适hhh,要继续肝了,今天还要把毕业材料写完。

----嗯嗯读论文、找论文、讨论之类的 然后写了好久好久的材料还没写完。

----1400睡醒了又收到师兄到的反馈,这个工作效率真的是太舒服…

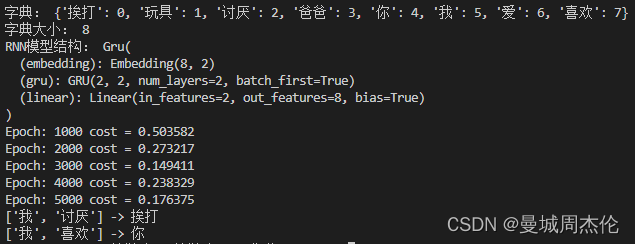

NLP-D26--RNN+感到代码能力提高

—0441今天终结掉沐沐的代码,就可以看宝可梦的nlp了!!!加油!

1、reshape(-1)的用法 将数组铺平。 参考:https://blog.51cto.com/u_13977270/3395824 2、这一部分还挺难理解的,k步推理横纵坐标。…

NLP-D23-cs224nkaggle房价预测复习chap5深度学习计算算法R2D7Unicorn

—0525早上4点起,还是看了cs224n作为听力练习。 然后就看论文了。好饿,吃了很多面包片,看沐沐讲课好治愈啊。看完这个QA继续看论文了。

–0544大概看了overview,不想看了。继续看pytorch实践叭!

—0801

—0815说去看…

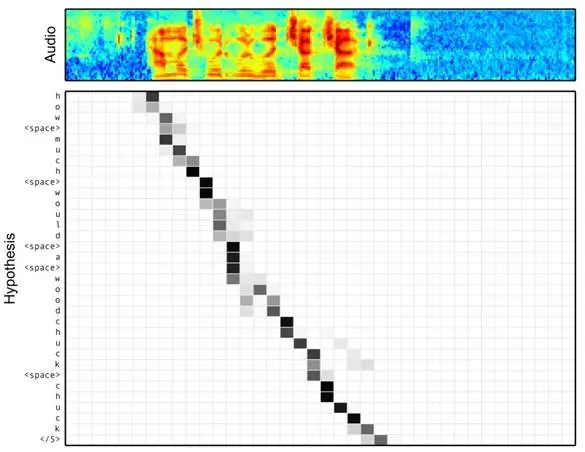

NLP-D33-毕设答辩-《人类语言处理》04-05-Location-aware-attentionCTC大数据比赛报名答辩被从源头上暴

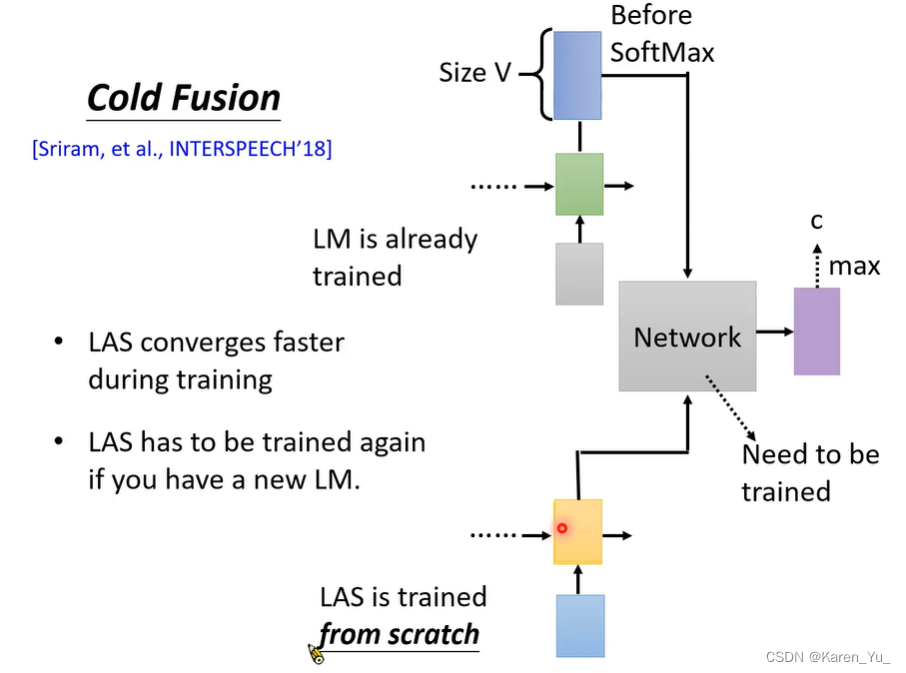

—0452虽然今天答辩,还是很早就起了,ppt还想改一遍,论文还想读一下。早上听了会《人类语言处理》04,就是补昨天的坑啦。讲到的是Location-aware attention,主要是说我们直接用attention做语音辨识的话,弹性…

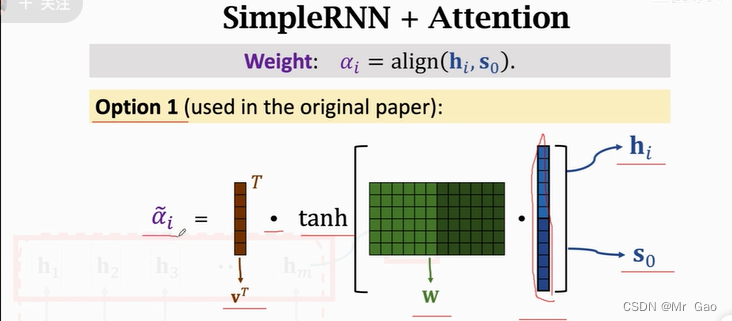

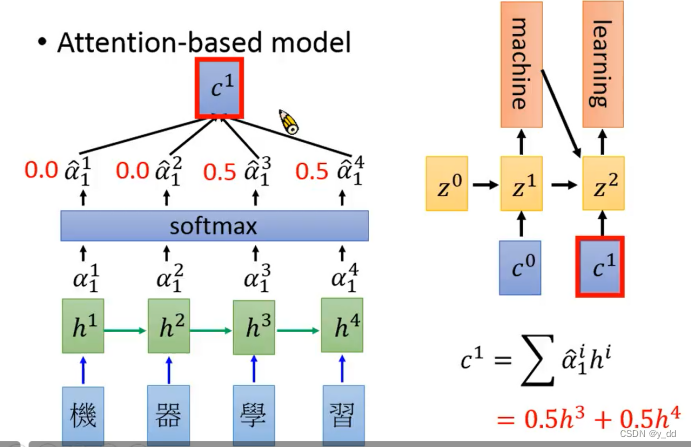

NLP-D29-注意力机制在seq2seq中使用注意力

—0433 又是四点起床的一天。越来越清醒了。刚好也快放假了,完美过渡到居家状态,舒适。 今天的主要任务还是沐沐的课啦!还有多毕设答辩的精简,昨天讲了17分钟,太长了!!!先去写个日记…

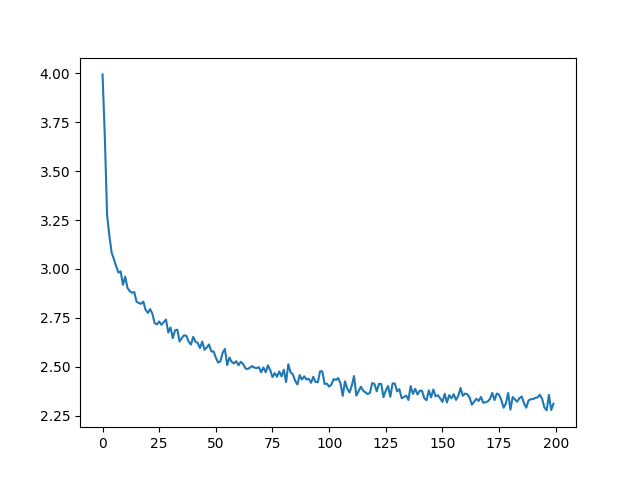

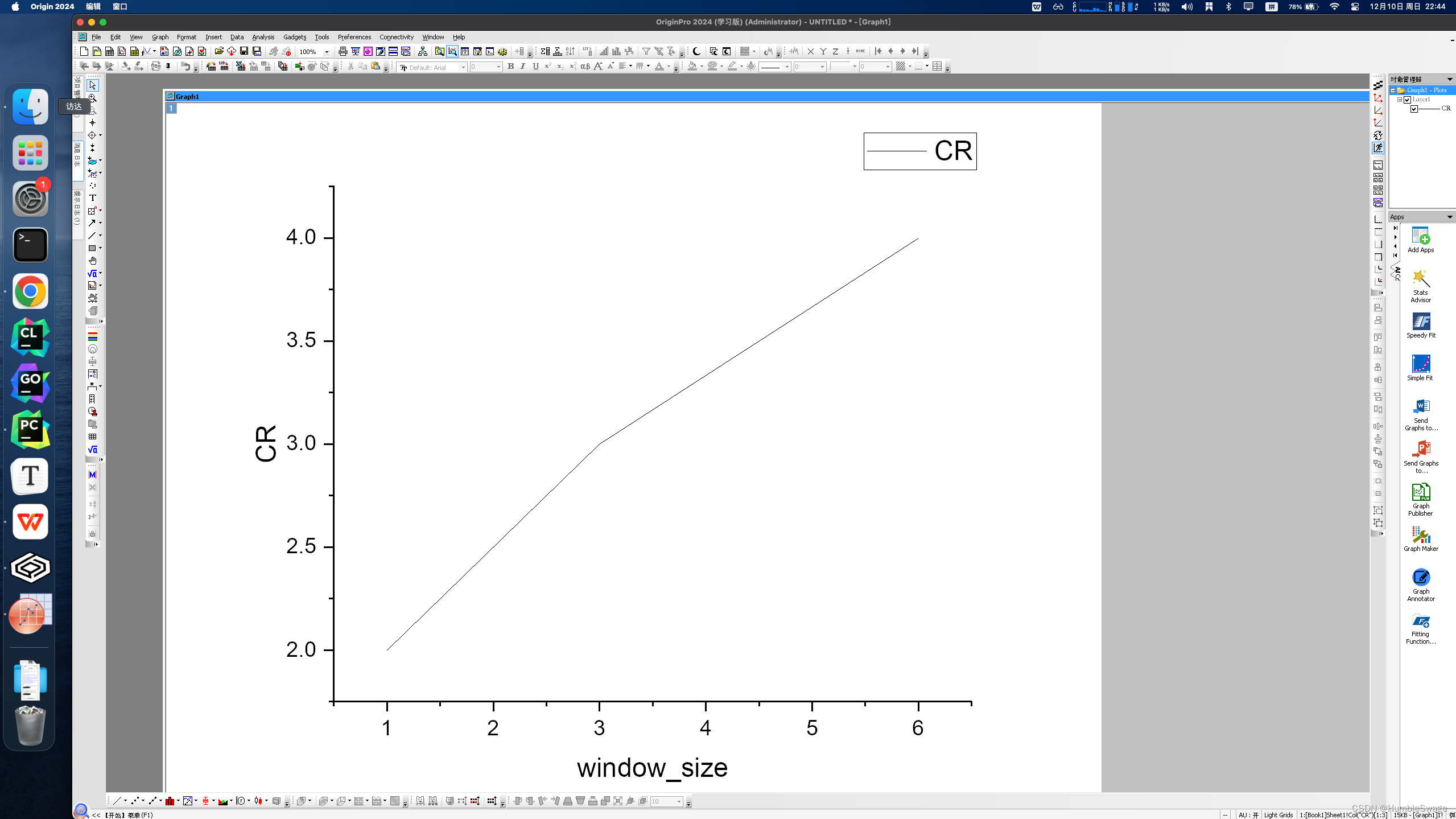

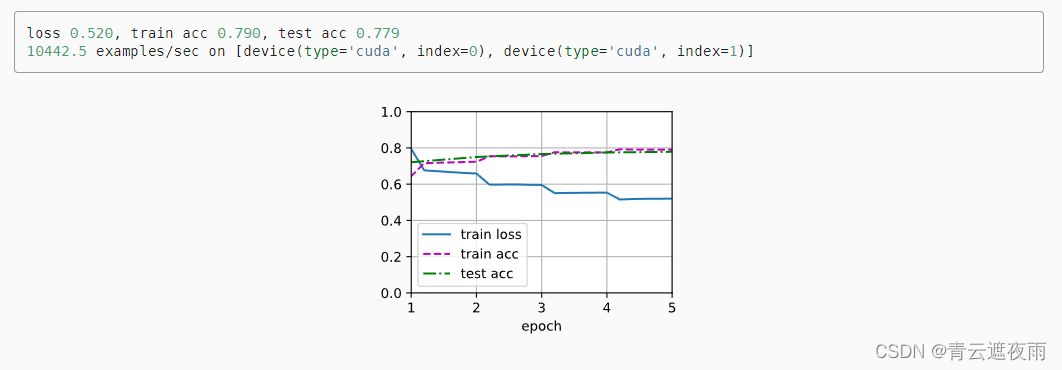

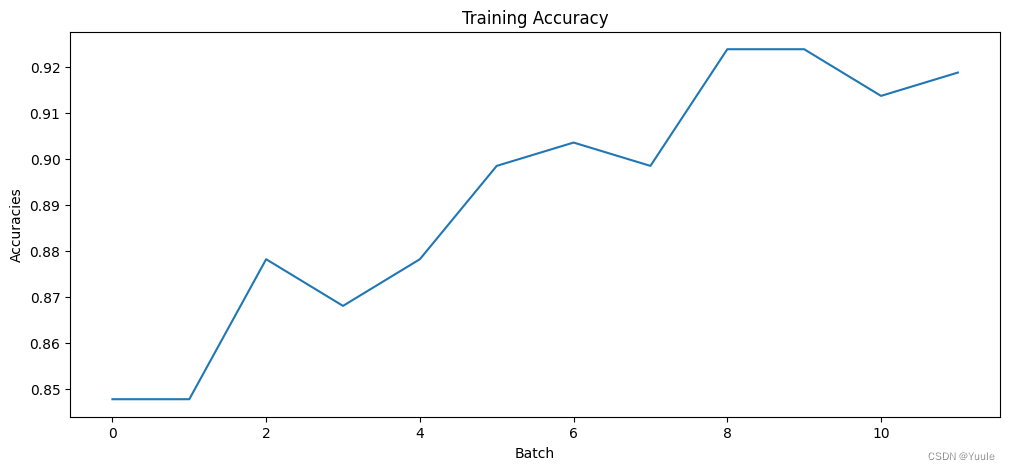

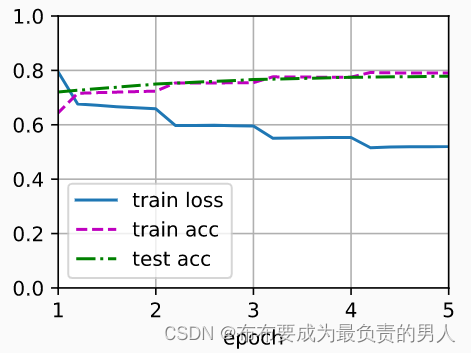

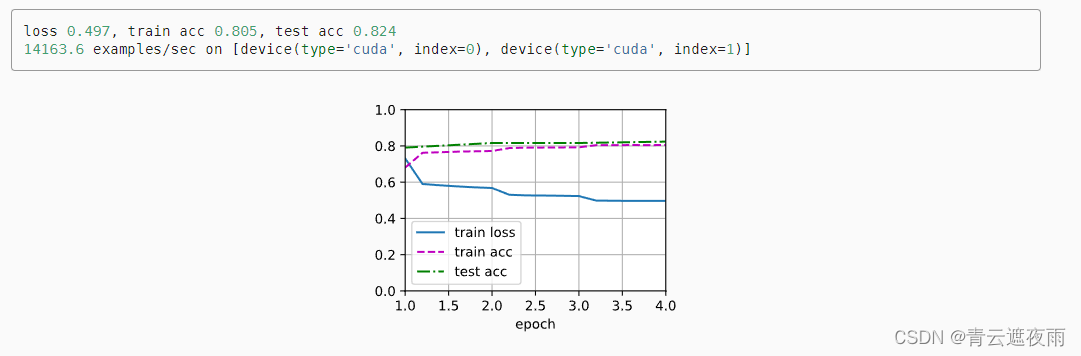

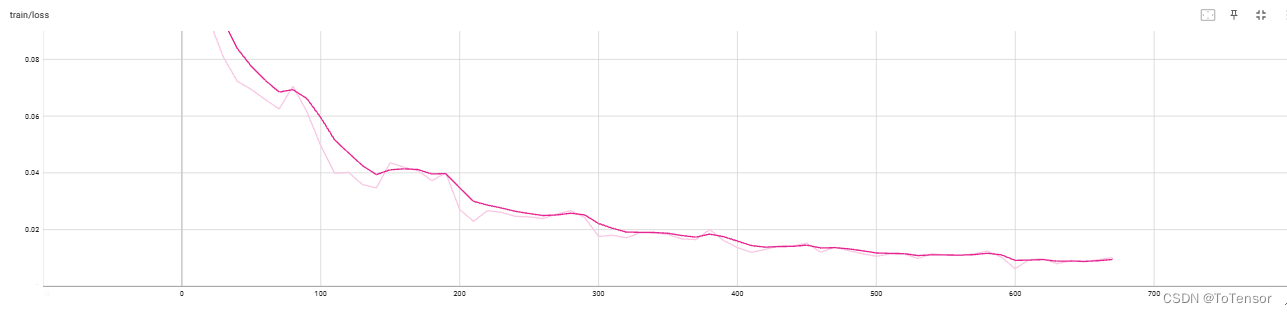

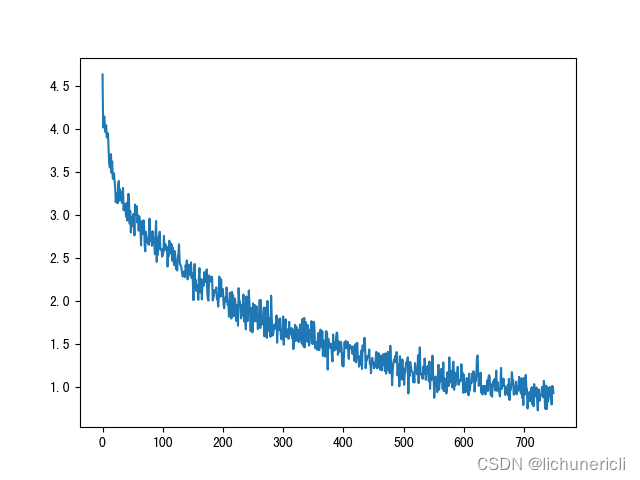

NLP-D39-nlp比赛D8自己绘制曲线不放弃就是对bug最好的态度迁移CNN收尾毕设

--------------0440开干开干!!!

-----0519呜呜,昨天晚上gan到7点多直接去跑步了,没吃饭。现在饿了呜呜呜,先吃饭叭~刚刚忘开GPU了,报了一些奇怪的错误,现在开开看看能不能解决。 CN…

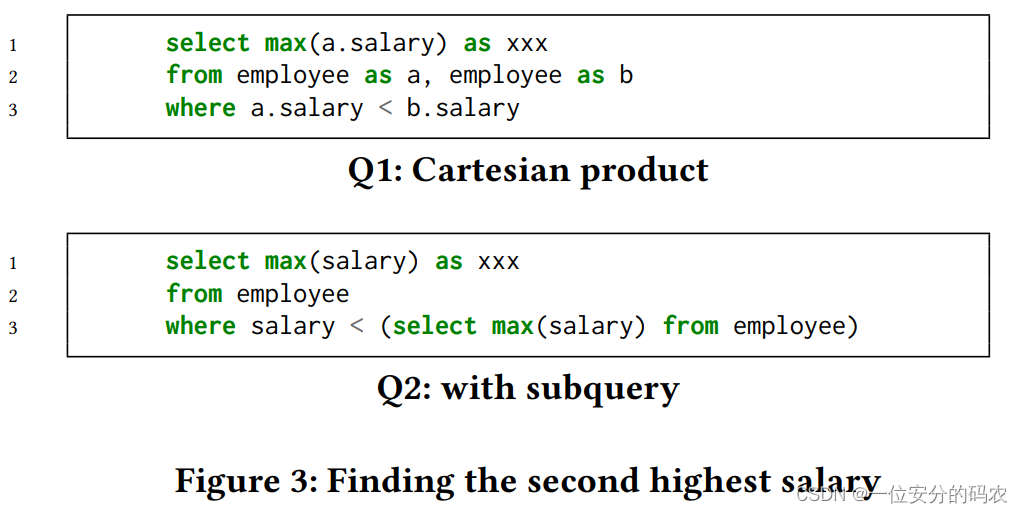

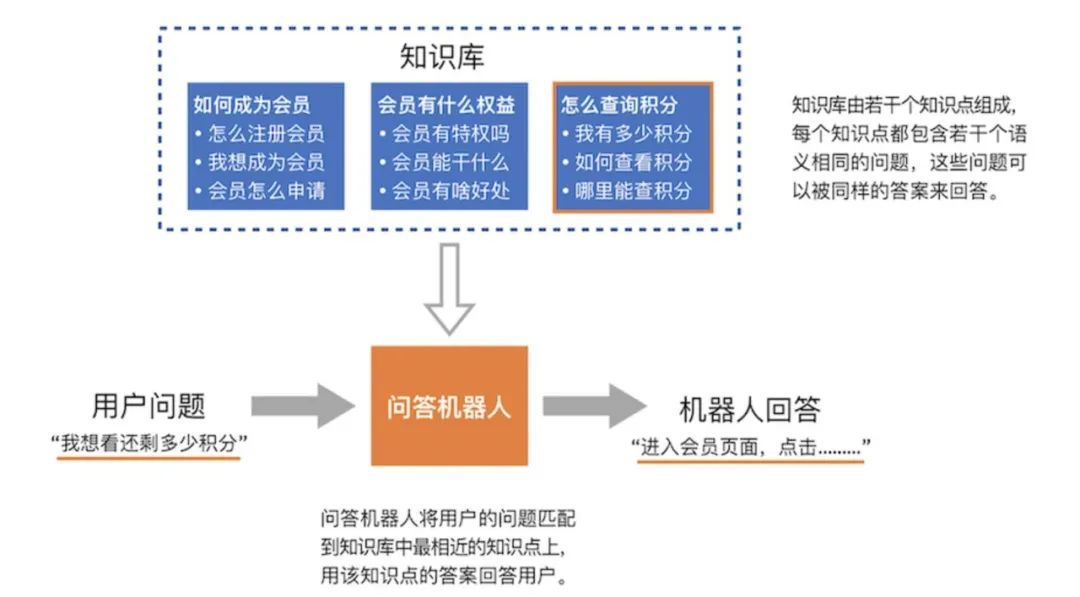

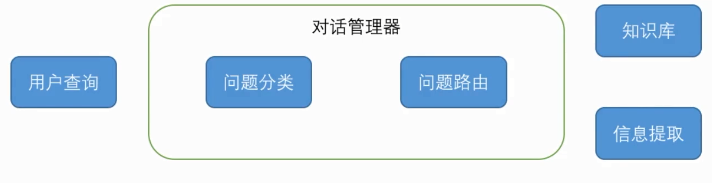

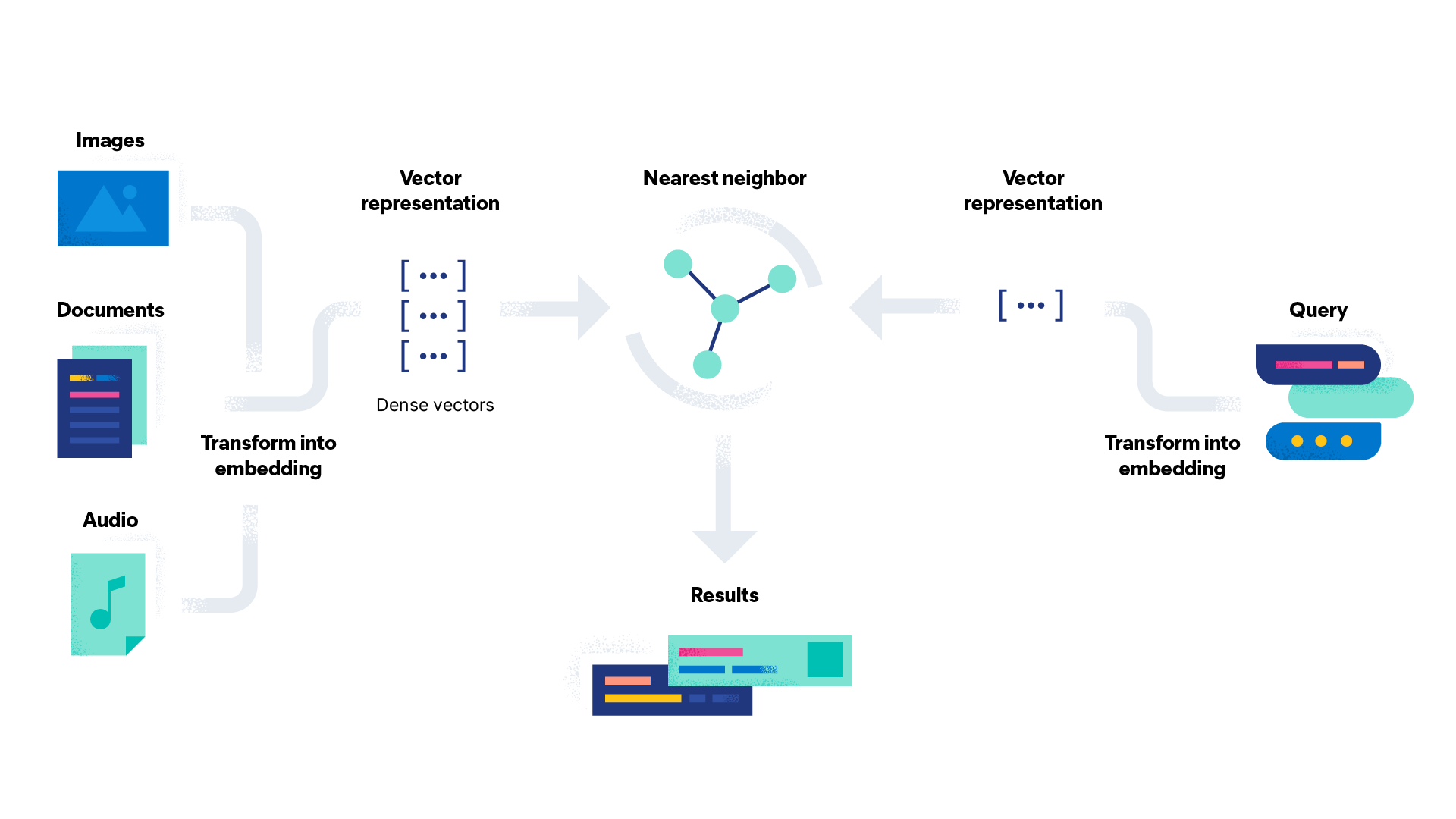

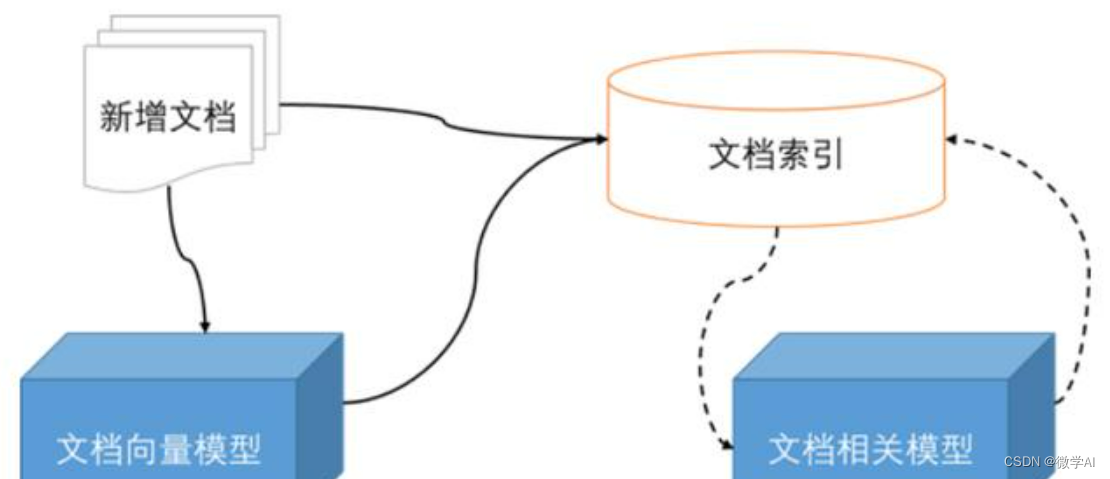

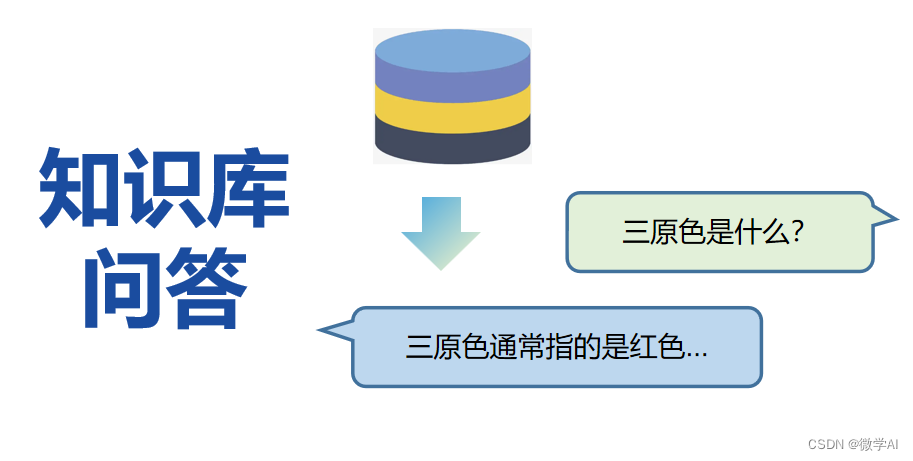

基于问答对的问答系统方案设计

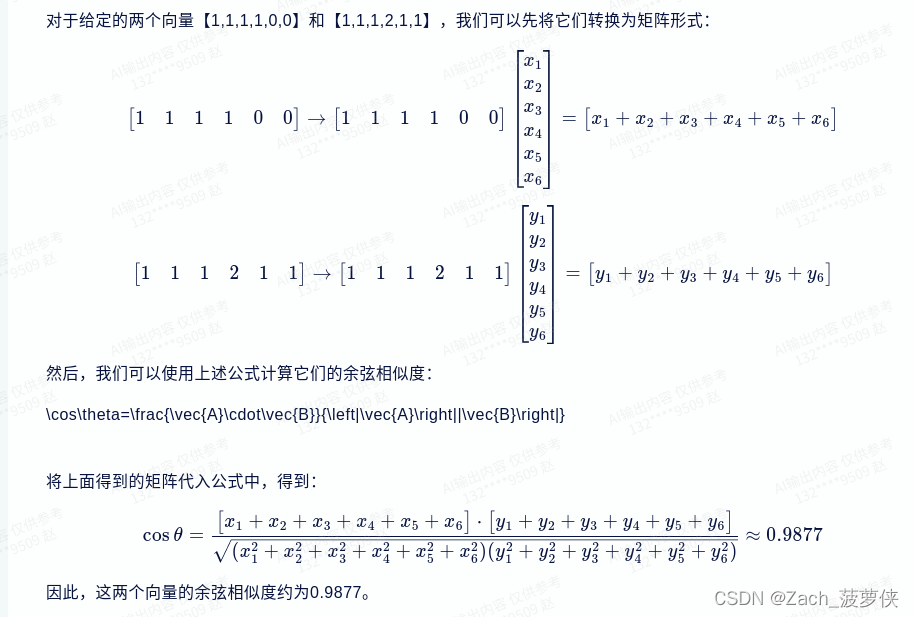

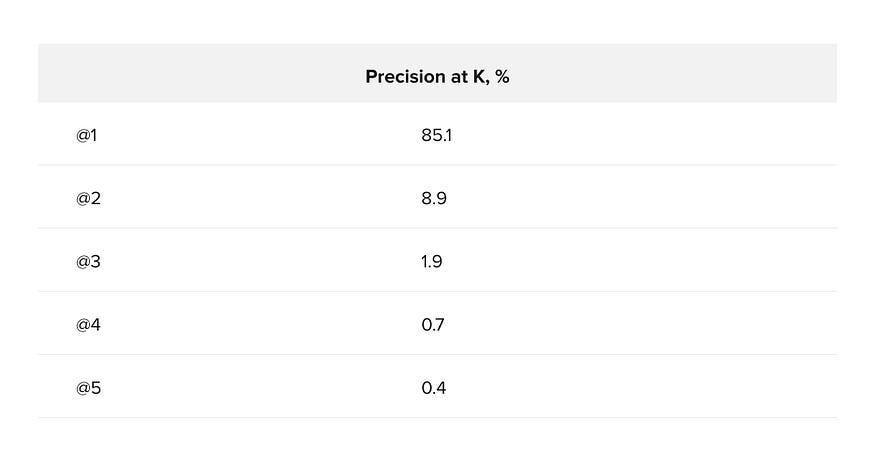

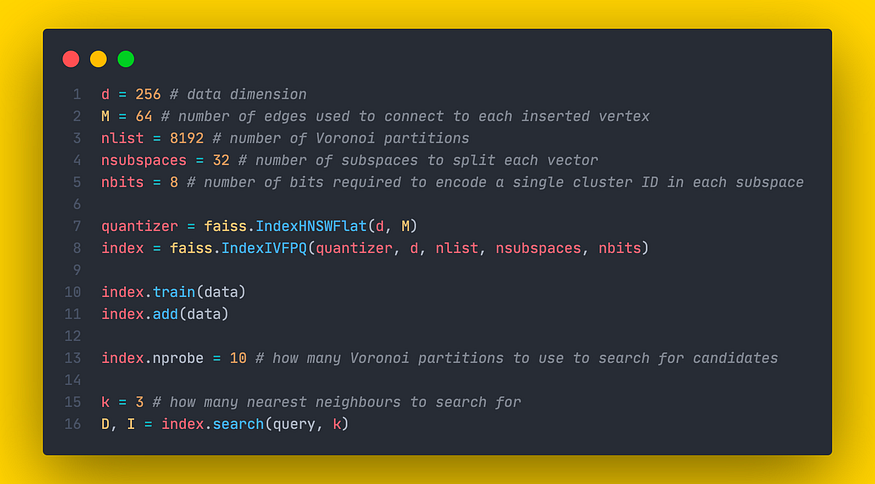

基于问答对的问答系统方案设计1. 前言2. 方案V1.02.1 召回2.1.1 关键词匹配2.1.2 问题分类2.1.3 相似度计算2.2 粗排2.3 细排3. 方案V2.01. 前言 基于问答对的问答系统的核心是当用户输入一个问题的时候,首先要找到跟这个问题最相近的已经存储在库里的问题ÿ…

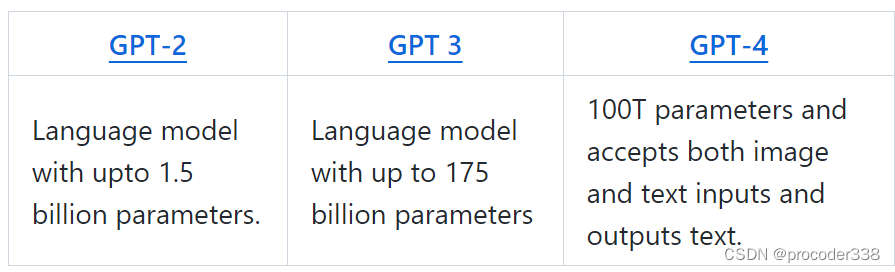

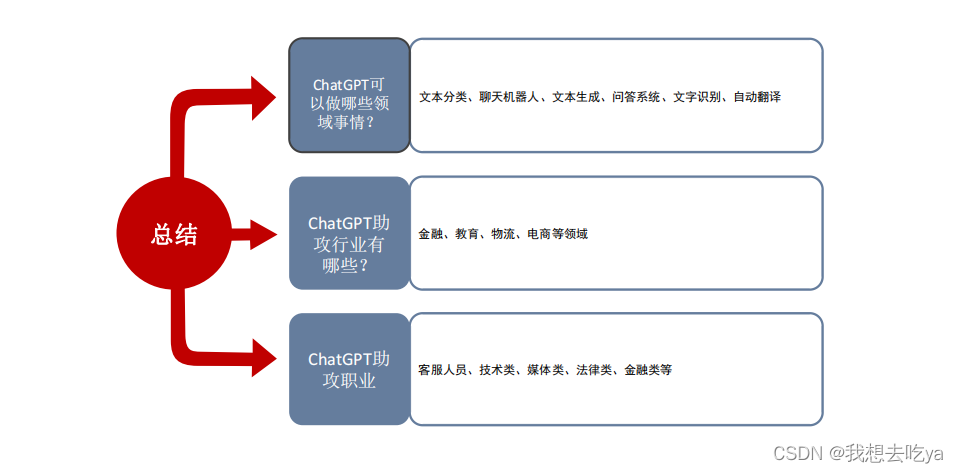

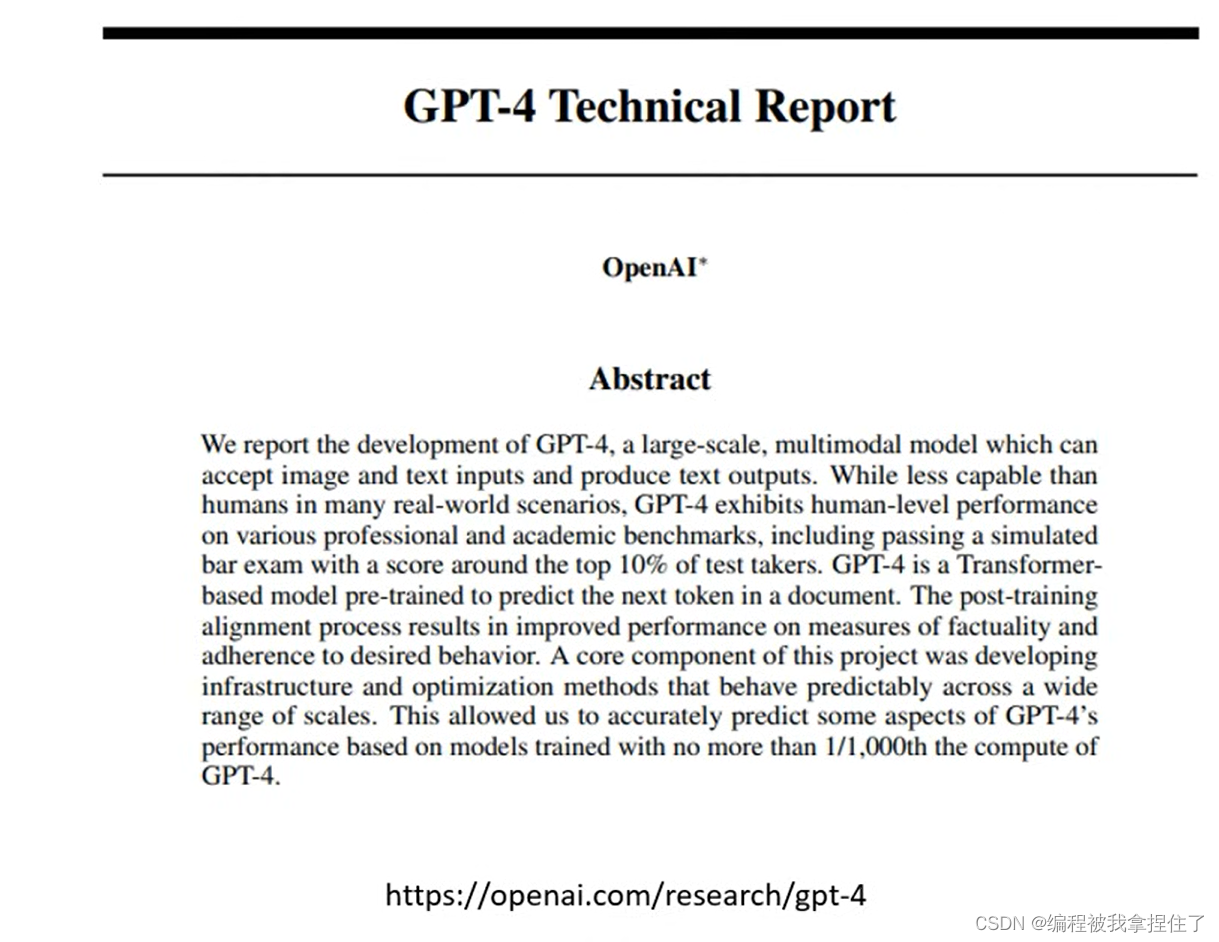

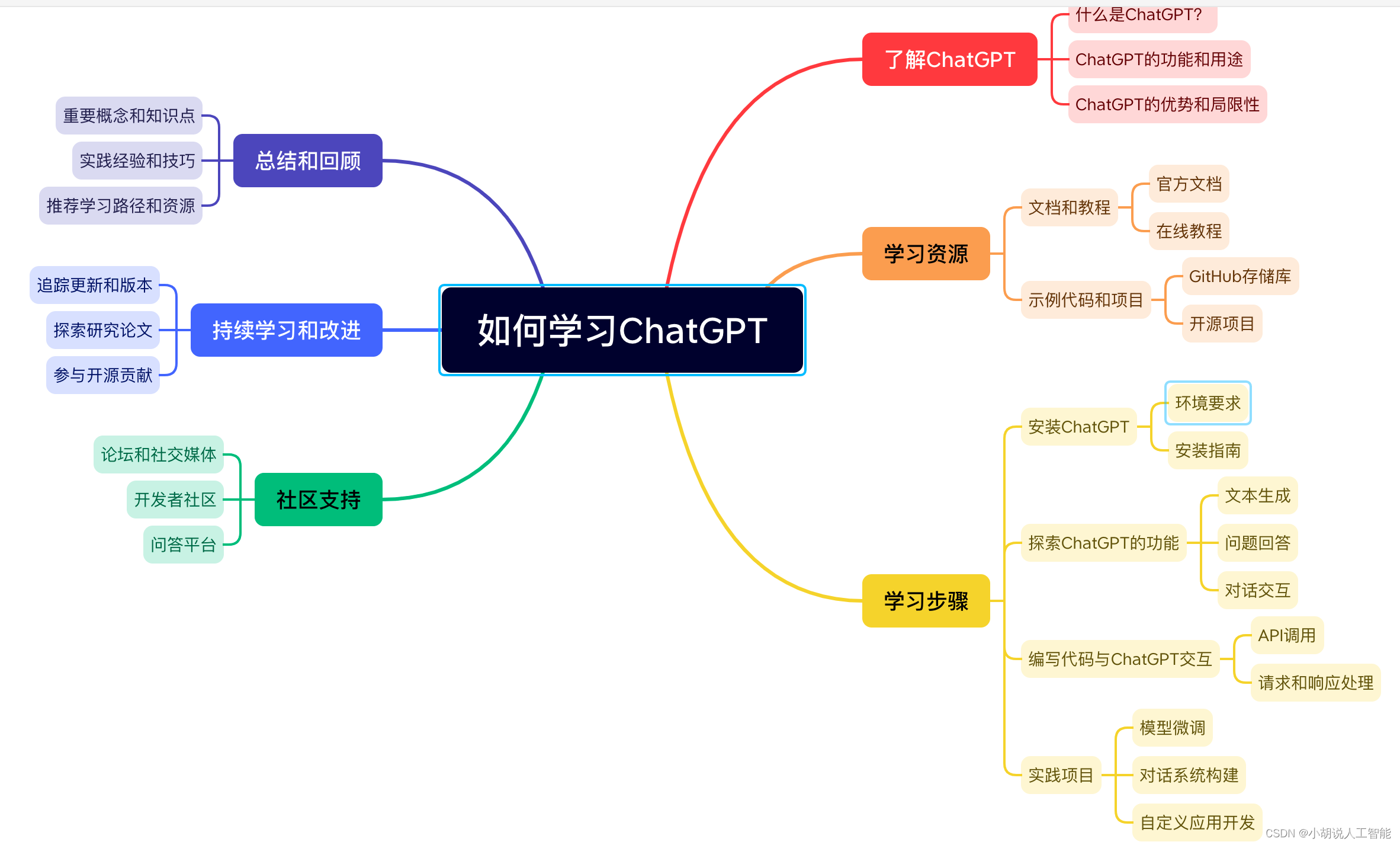

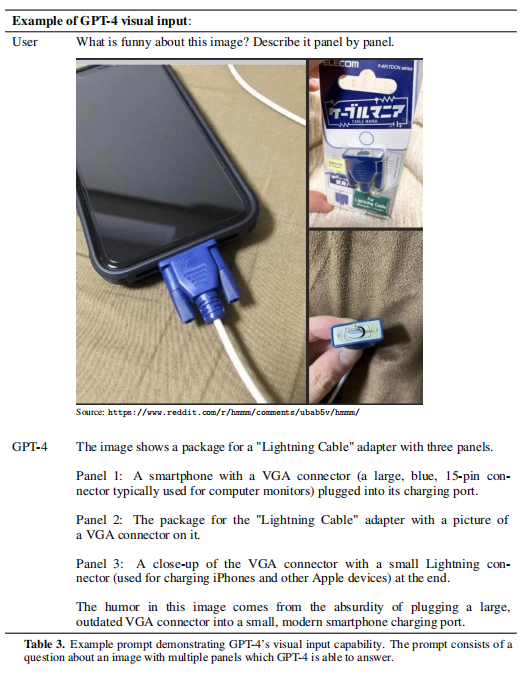

【消息】GPT4有多强?

GPT4有多强?问题一、GPT4是什么?问题二、GPT-4与之前版本的区别?问题三、GPT-4在自然语言生成方面的应用?问题四、GPT-4对于程序员的帮助有哪些?问题五、程序员与chatgpt的关系?问题六、使用chatgpt的简单例…

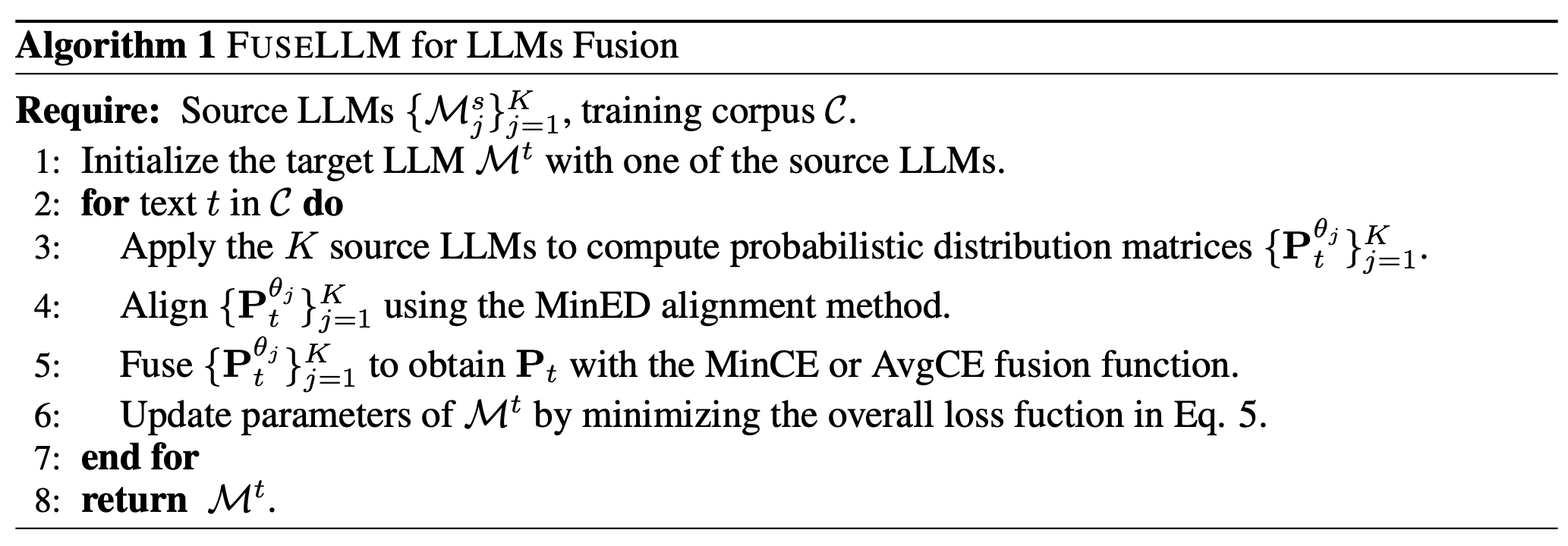

nlp大模型课程笔记

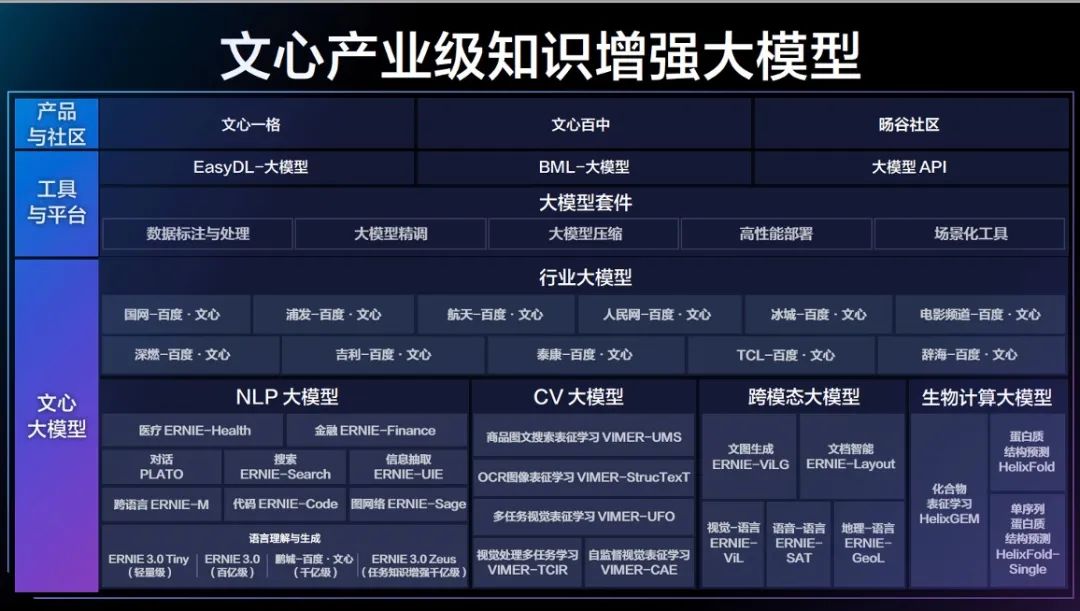

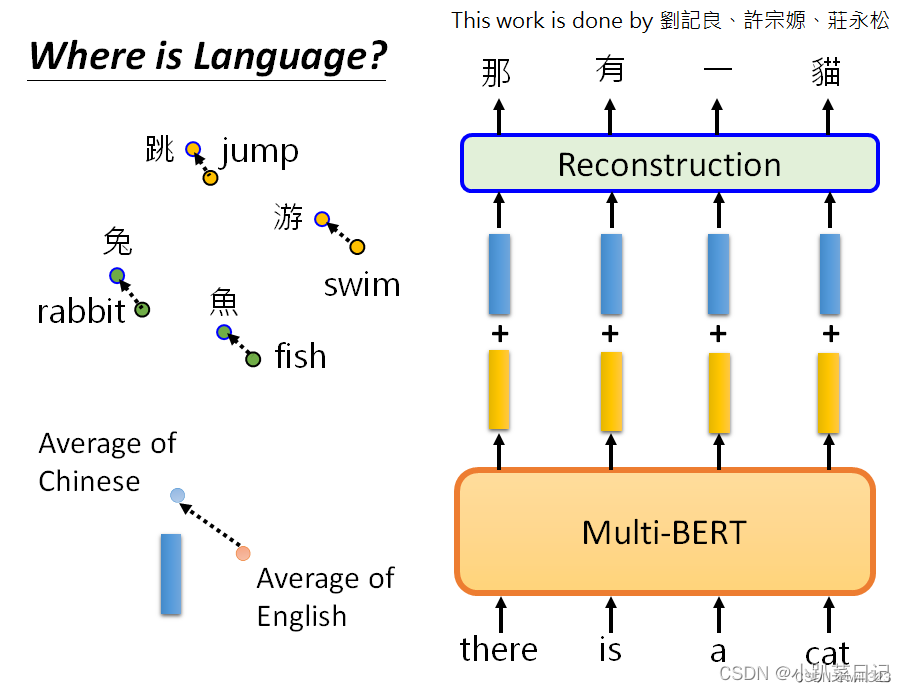

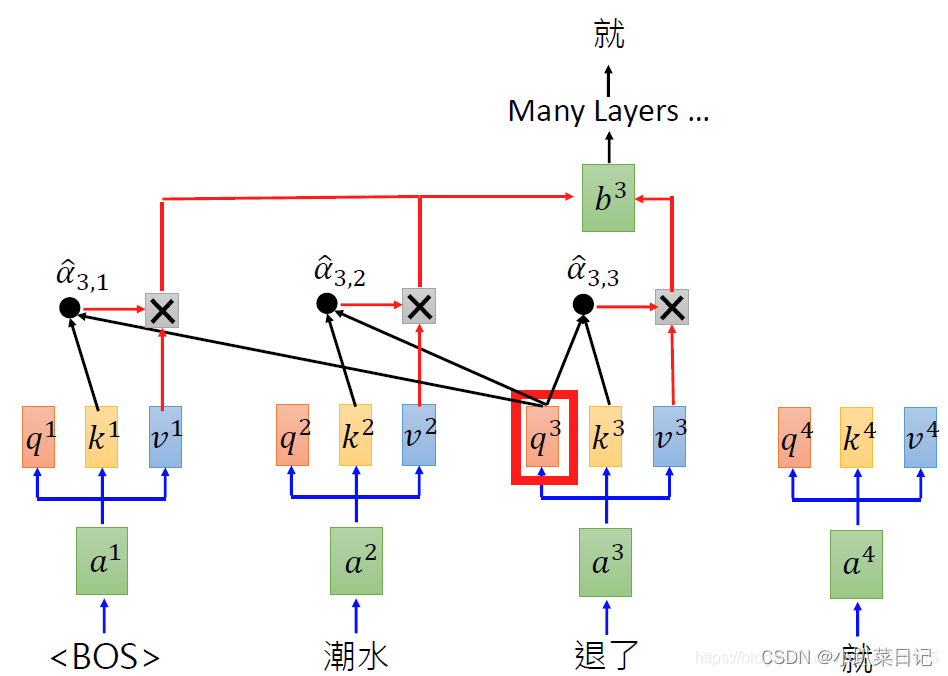

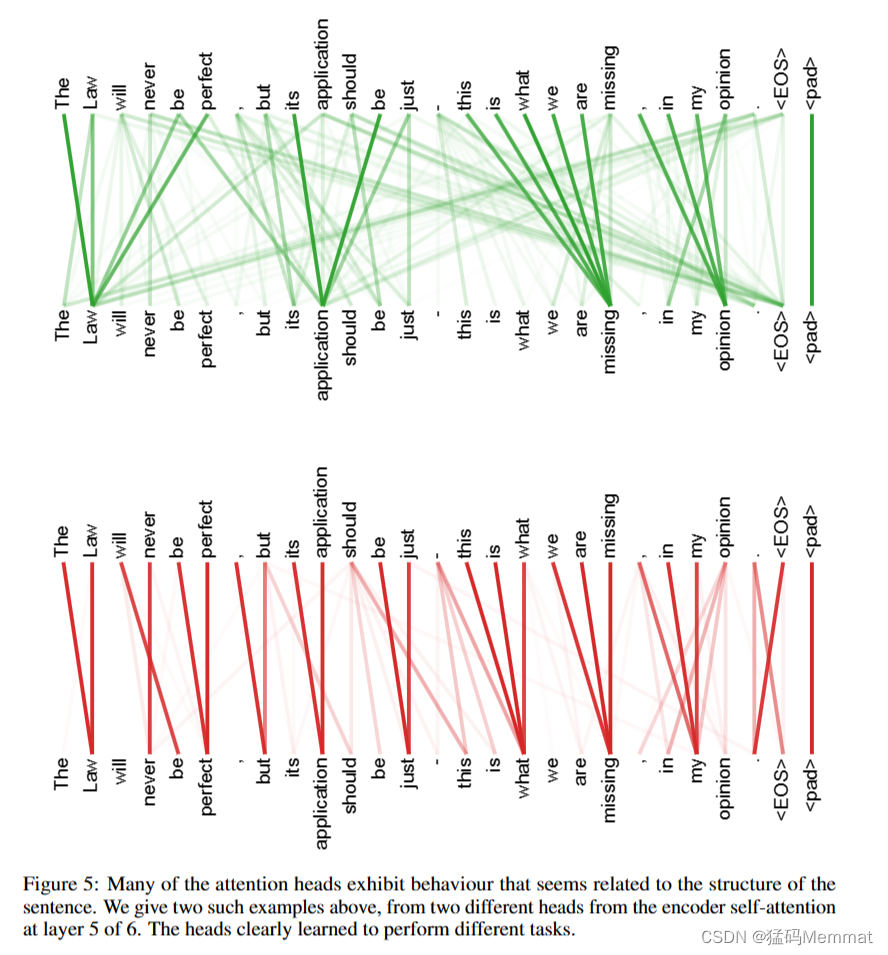

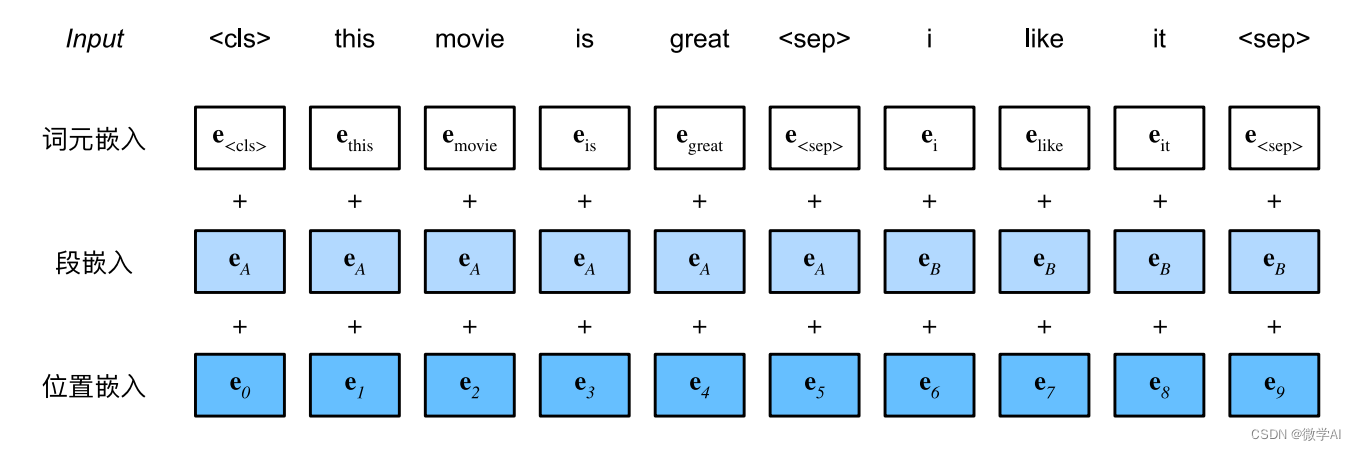

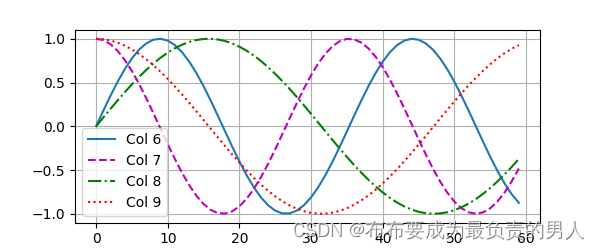

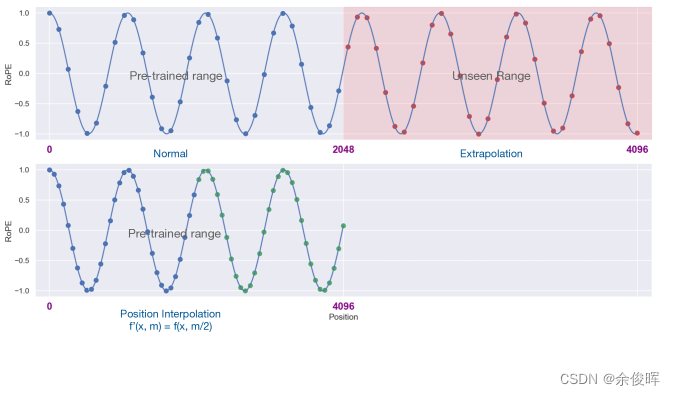

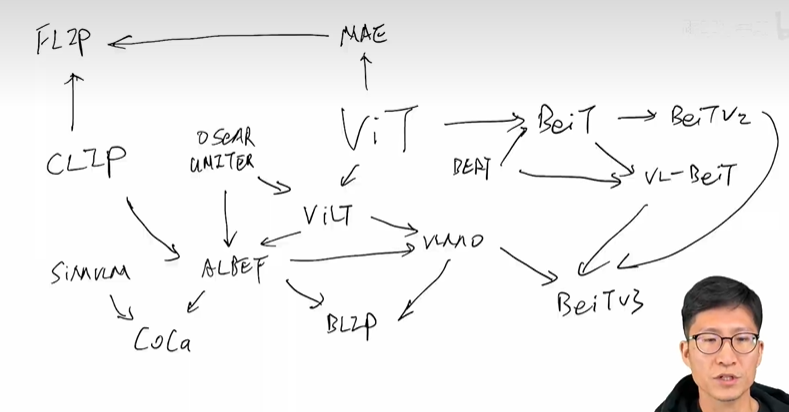

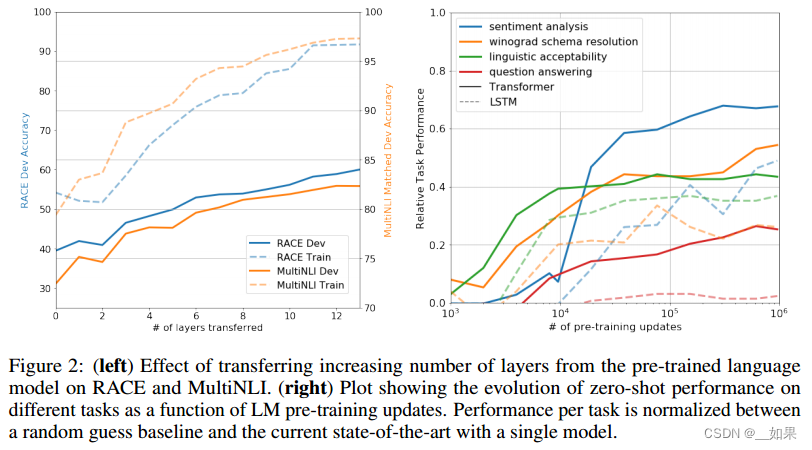

自然语言处理基础和应用 👆说明之前的大模型其实有很多都是基于迁移学习的方法。

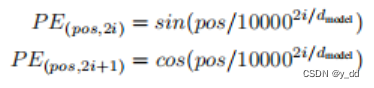

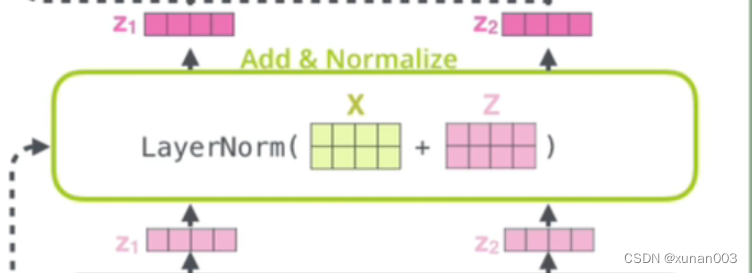

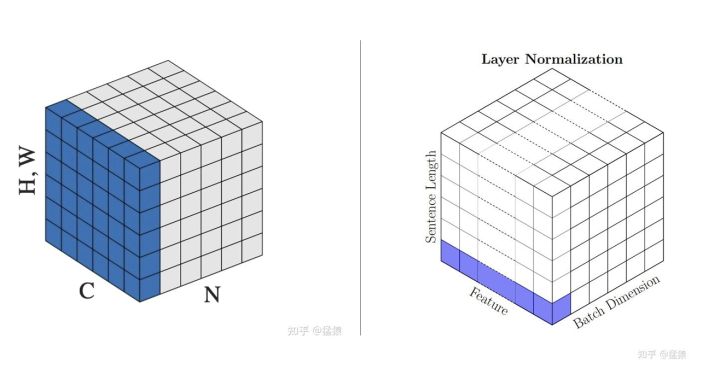

attention机制的总结,解决了信息瓶颈的问题。 处理词组时BPE的过程 👆pos表示的是token所在的位置 👆技巧是layer normalization。

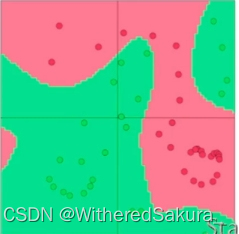

Python程序设计第八章测验总结

第八章 拓展与应用

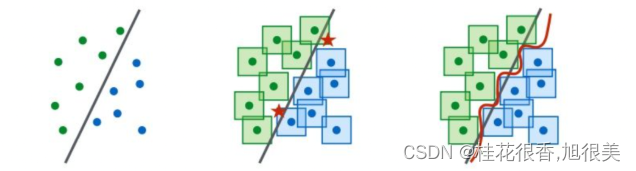

8.1 Python与KNN分类

1.无监督学习需要标注大量的数据才能用以训练得到模型。

解:错误

2.欠拟合通常是因为模型太复杂,参数过多导致。

解:错误

3.KNN方法只支持二分类问题,不能解决多分类问题。

解&…

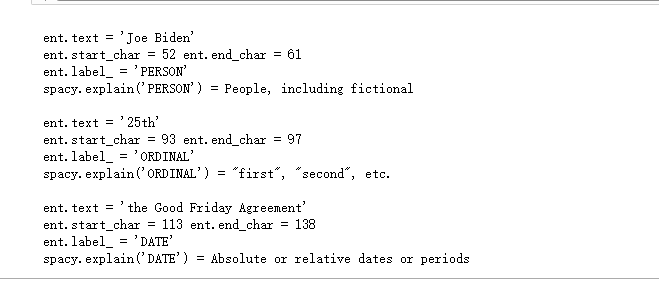

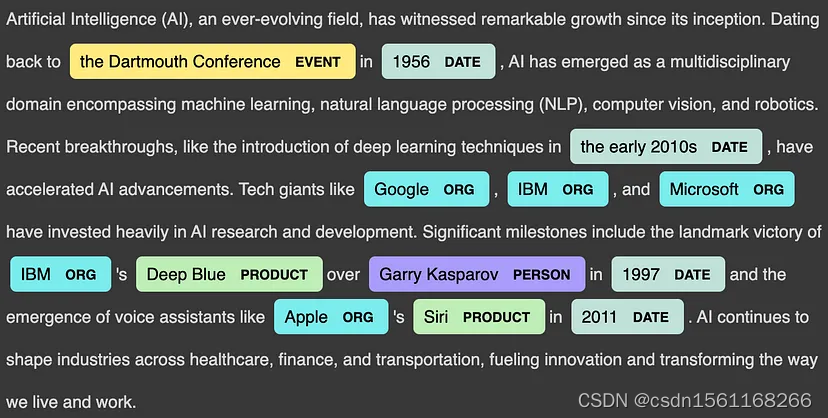

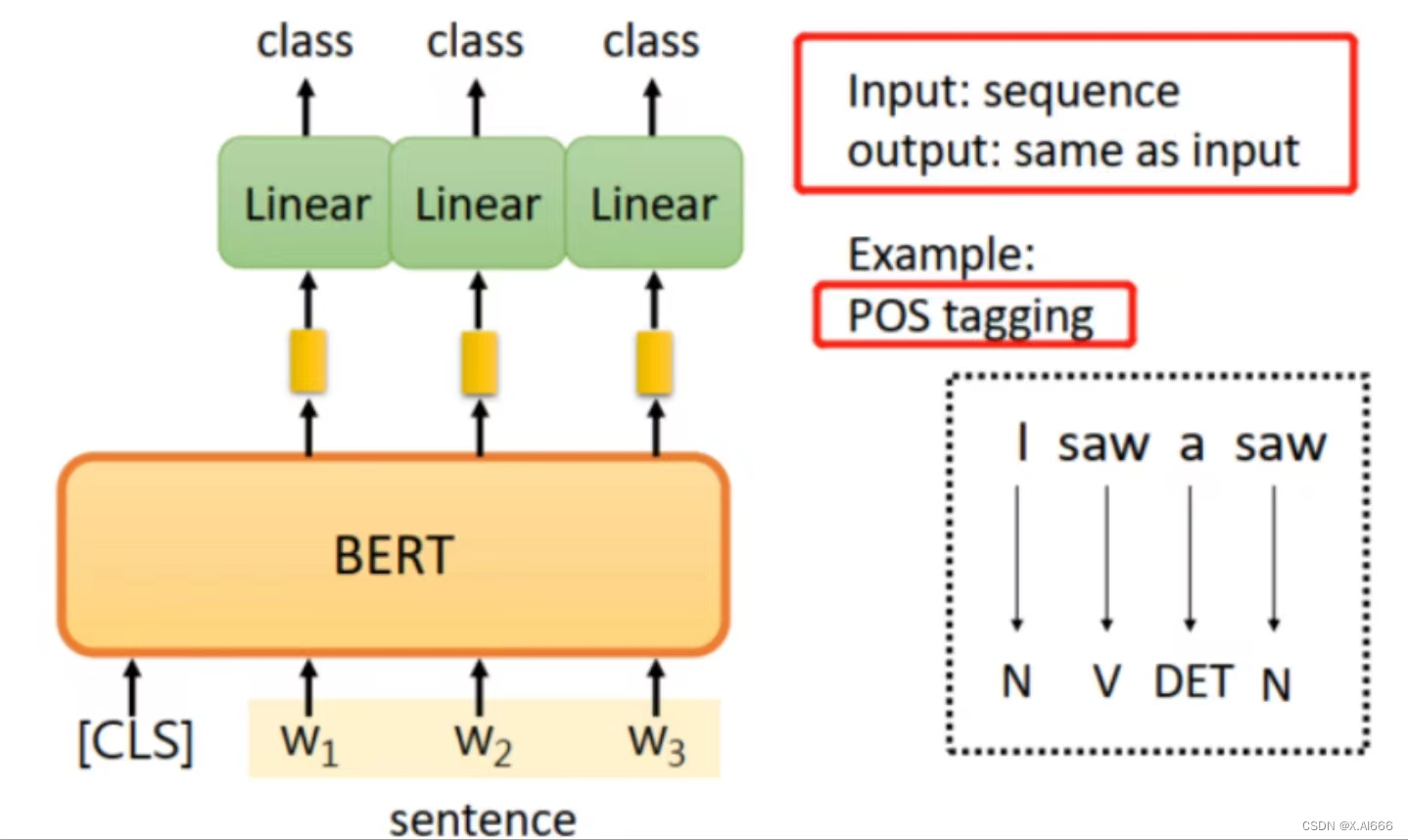

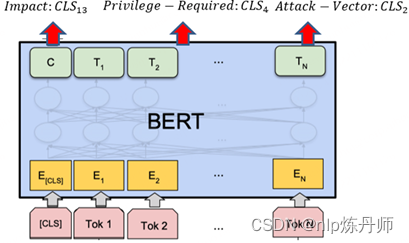

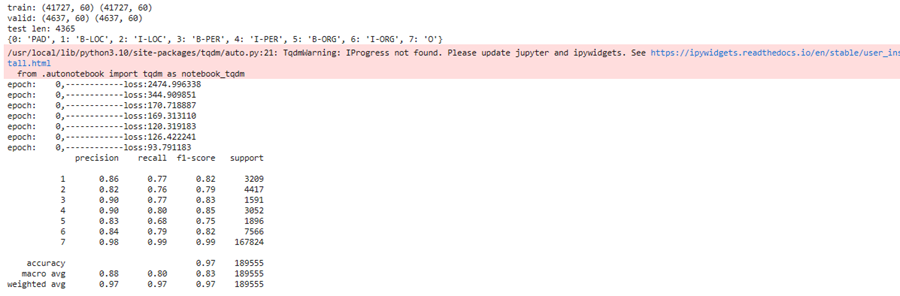

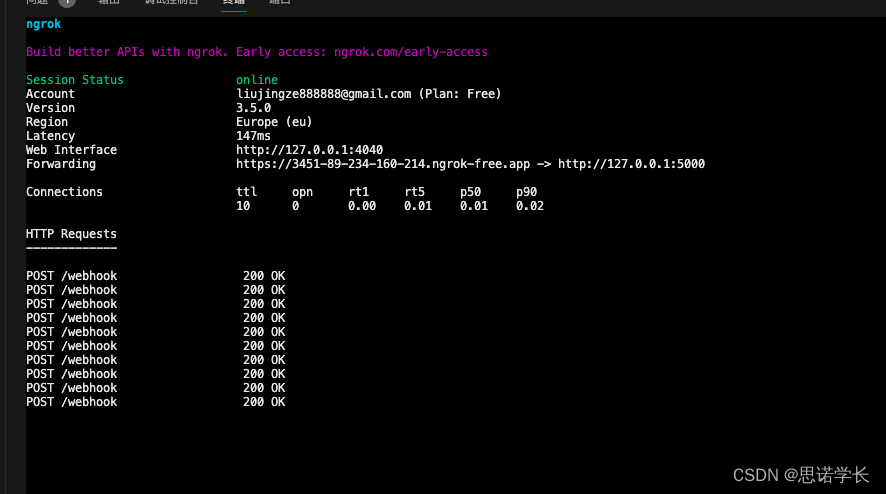

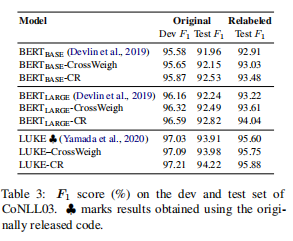

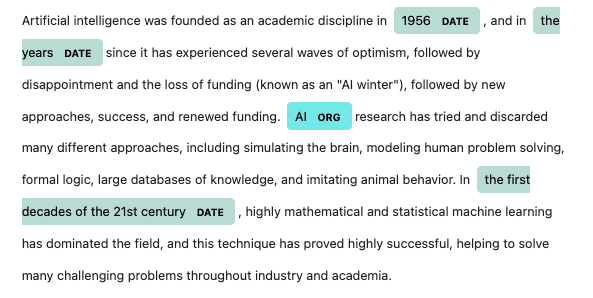

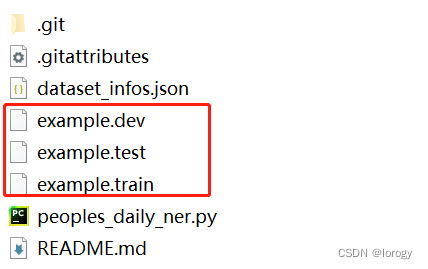

在 Google Colab 中微调用于命名实体识别的 BERT 模型

介绍 命名实体识别是自然语言处理(NLP)领域的一项主要任务。它用于检测文本中的实体,以便在下游任务中进一步使用,因为某些文本/单词对于给定上下文比其他文本/单词更具信息性和重要性。这就是 NER 有时被称为信息检索的原因,即从文本中提取相关关键词并将其分类为所需的类…

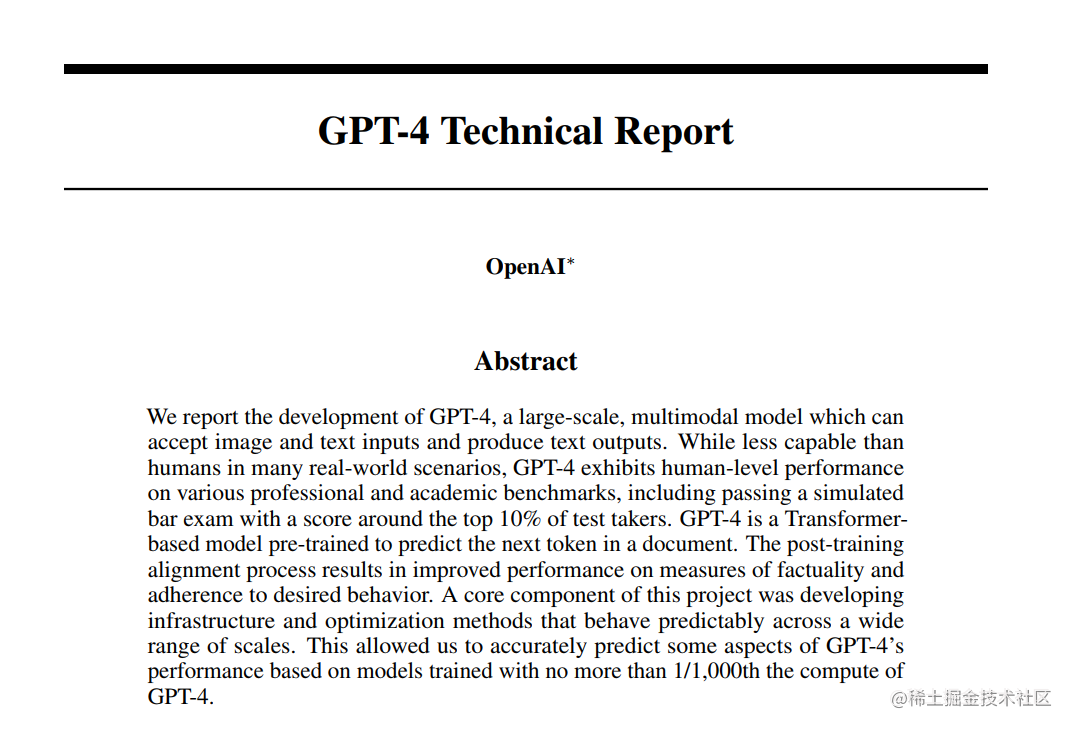

OpenAI GPT-4发布总结

OpenAI官方发布了GPT-4模型,GPT-4是一个大型多模态模型,支持输入文本图片,输出还是文字形式,GPT-4比任何 GPT-3.5 模型都更强大,能够执行更复杂的任务,并针对聊天进行了优化。

GPT-4目前处于测试阶段&…

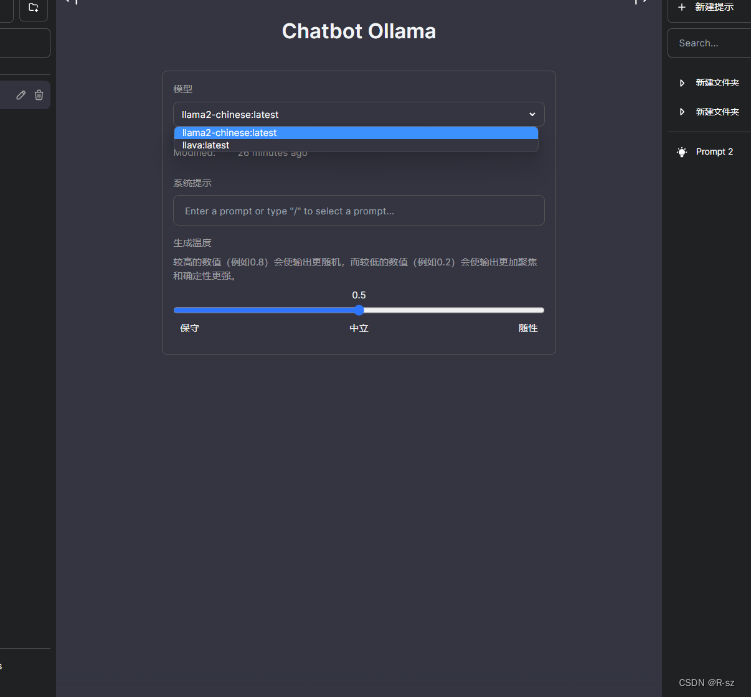

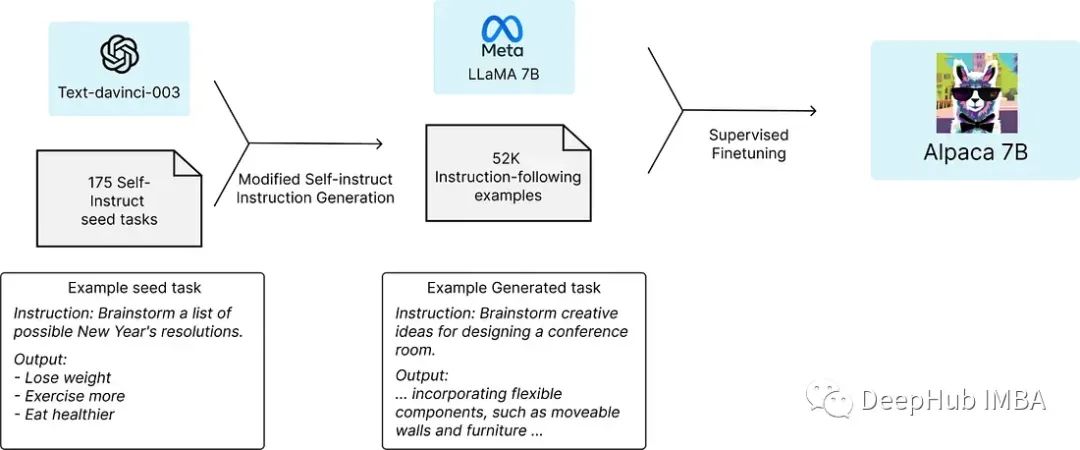

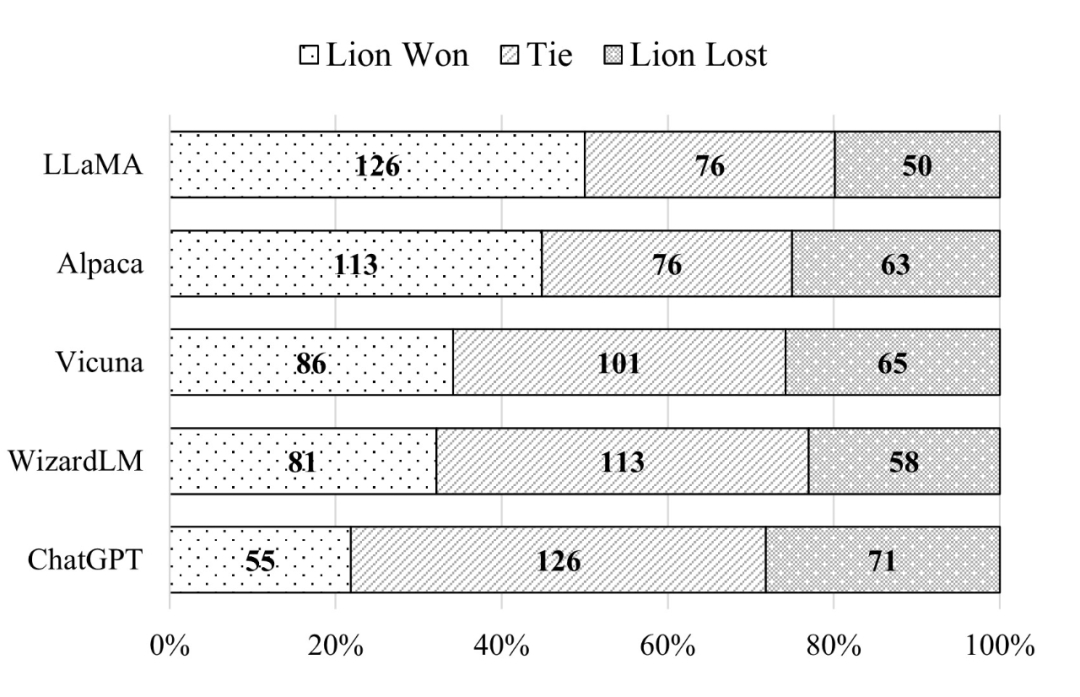

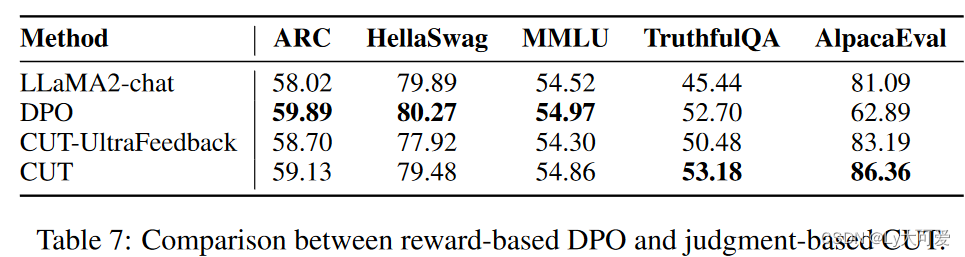

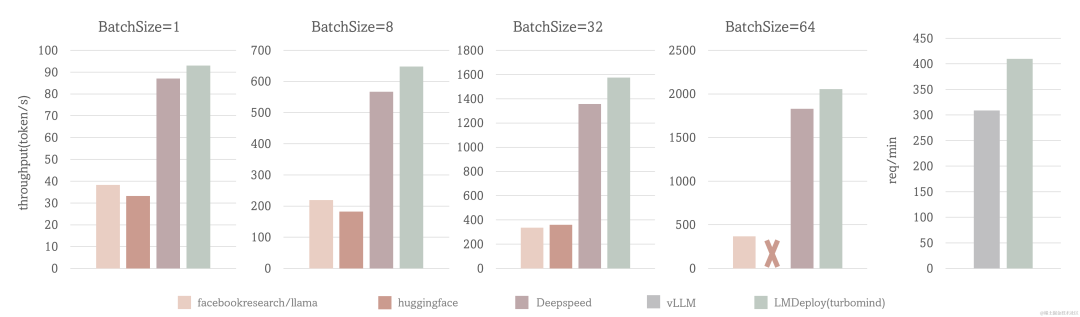

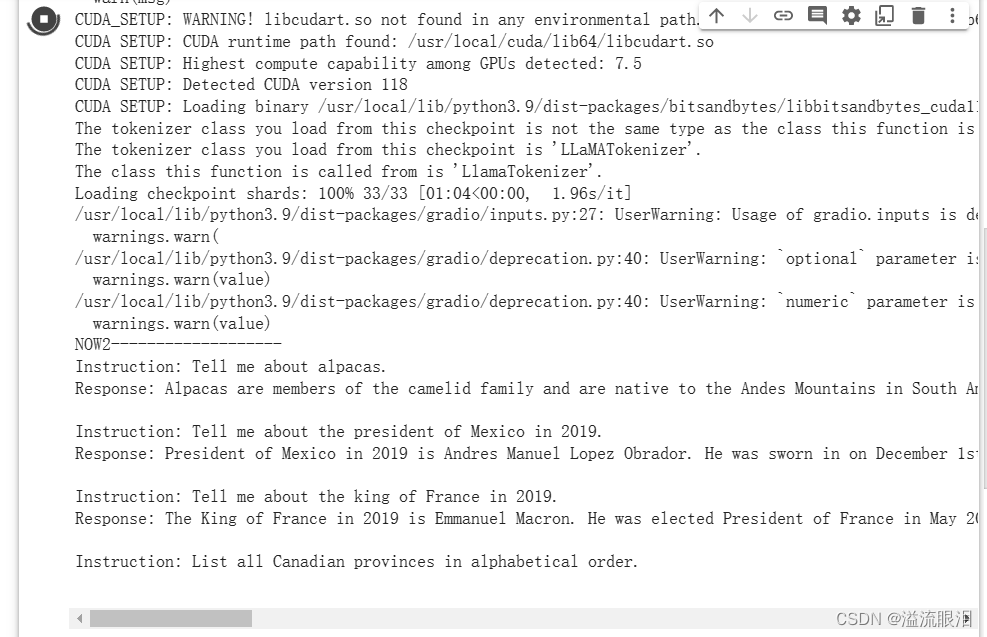

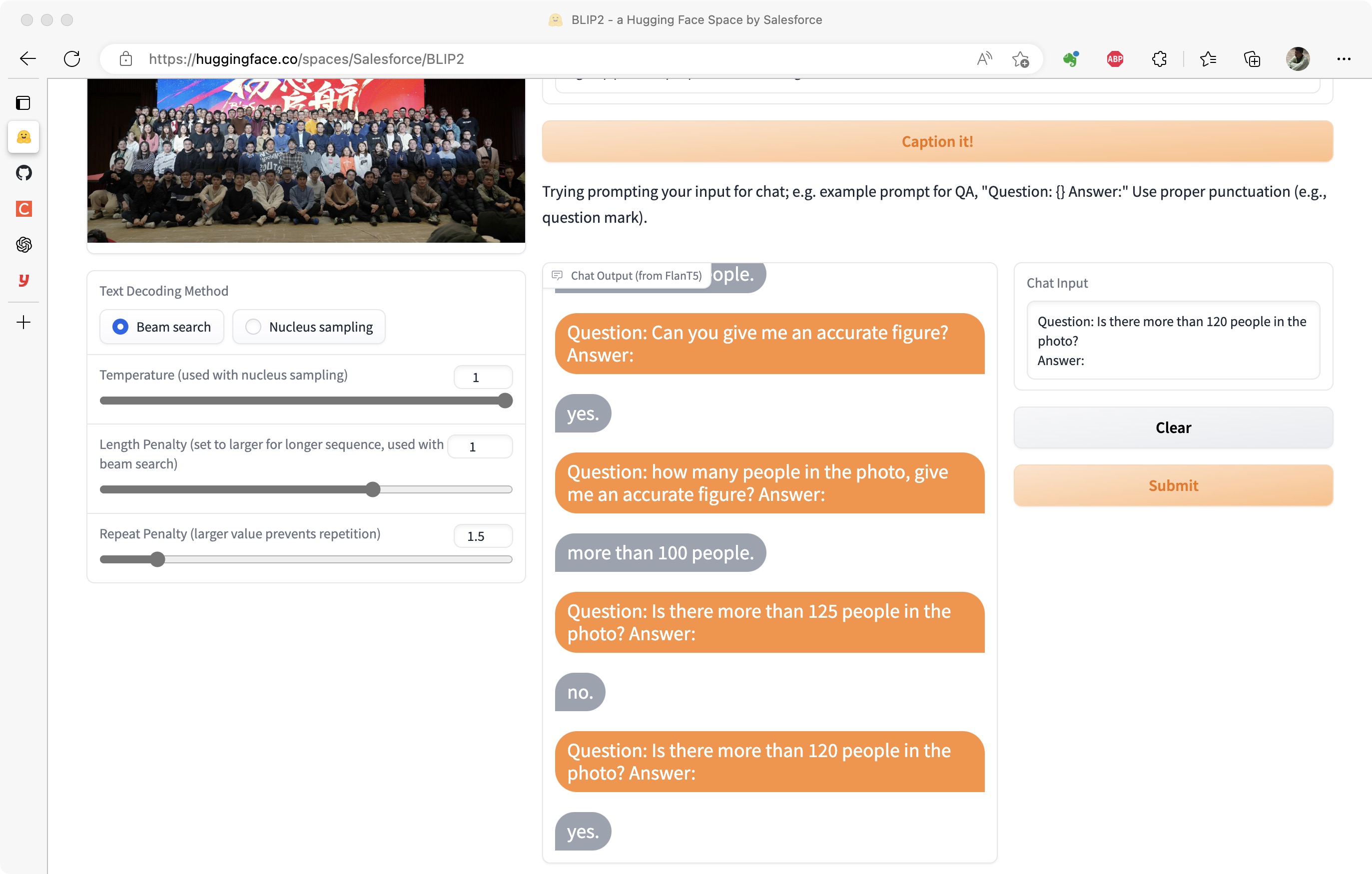

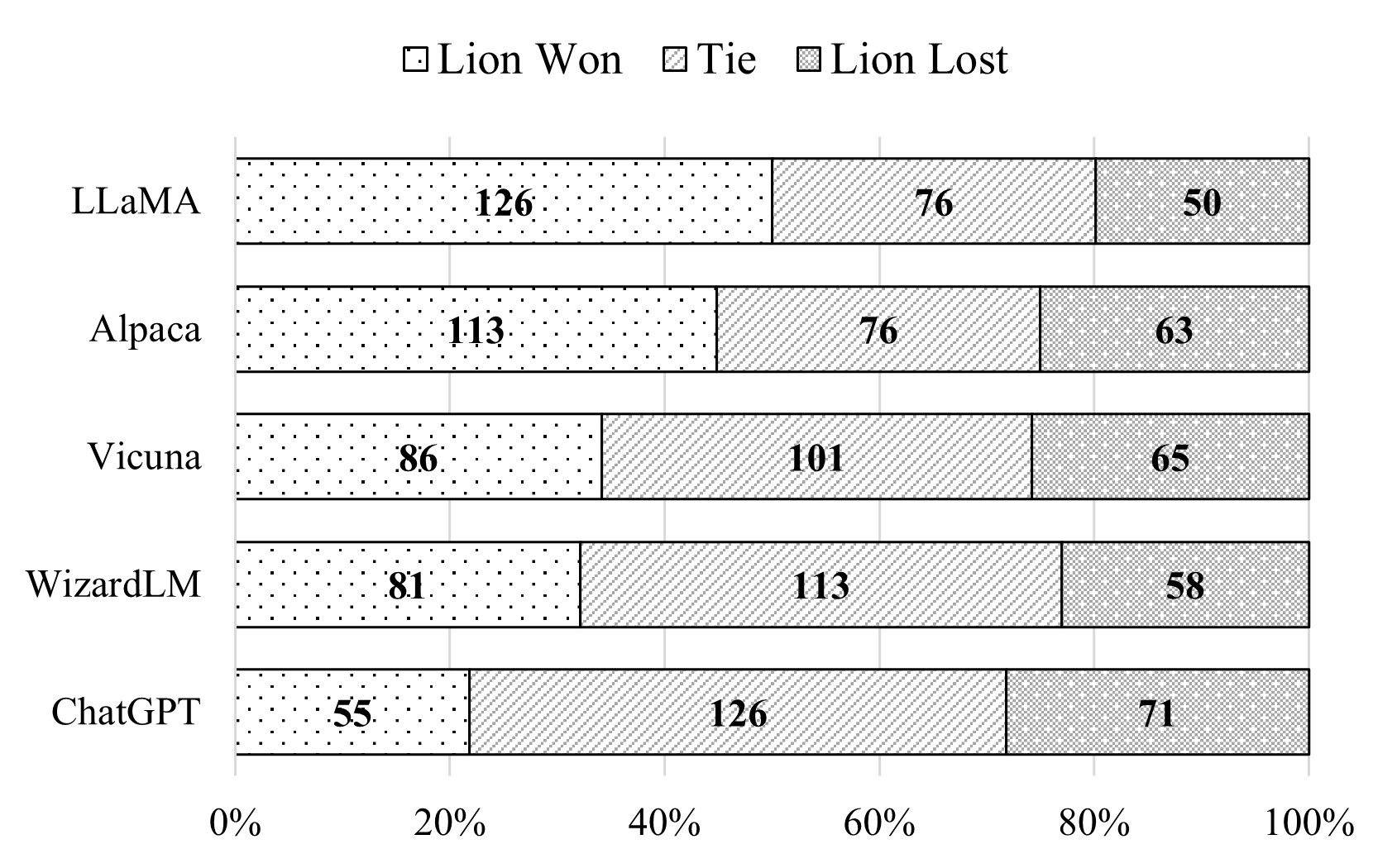

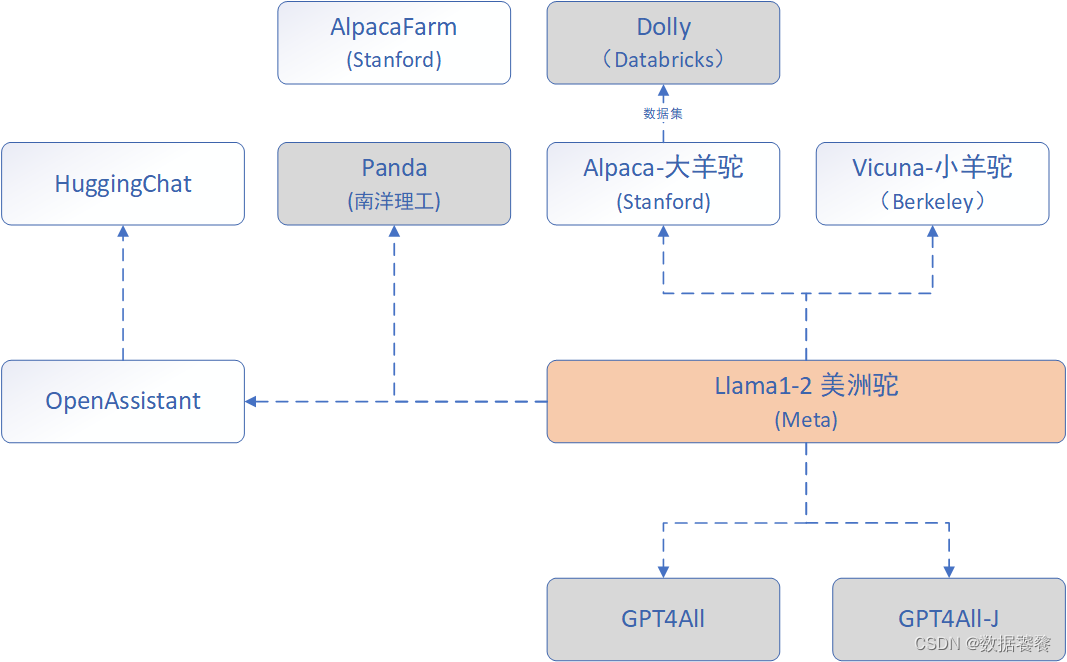

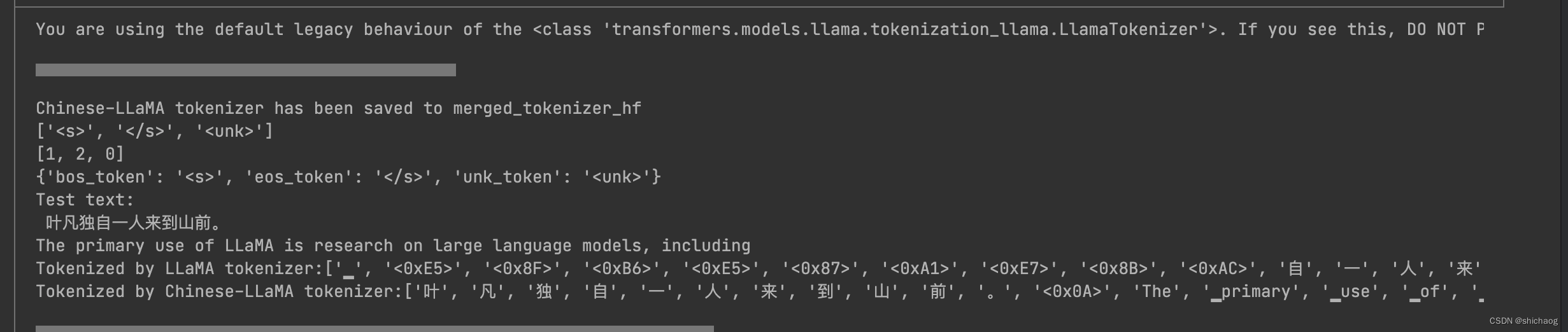

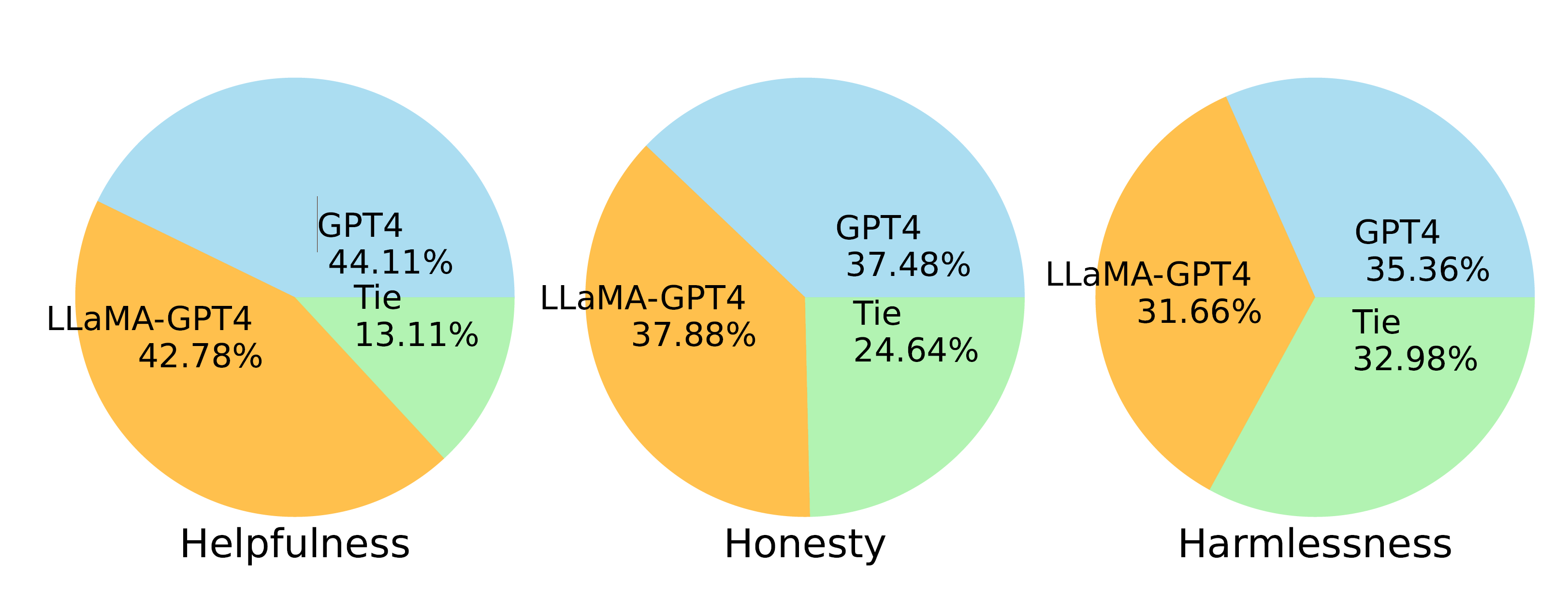

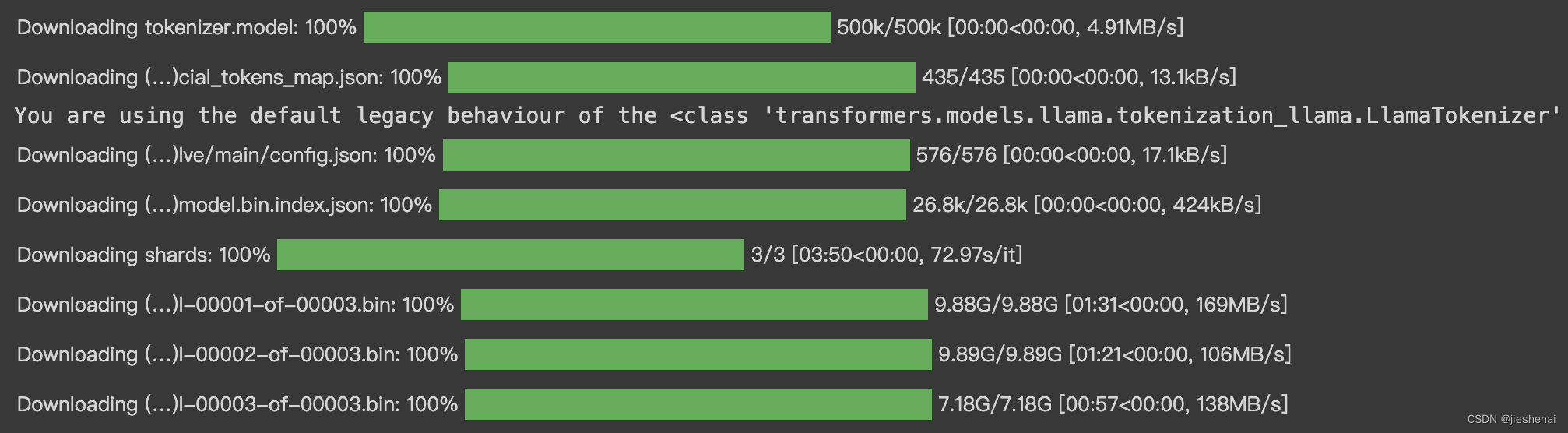

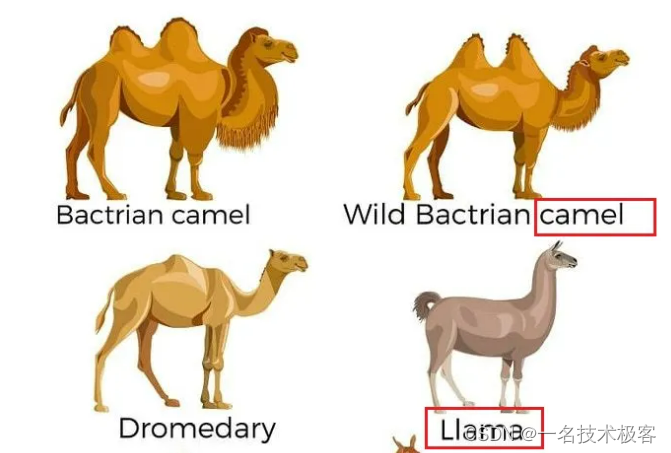

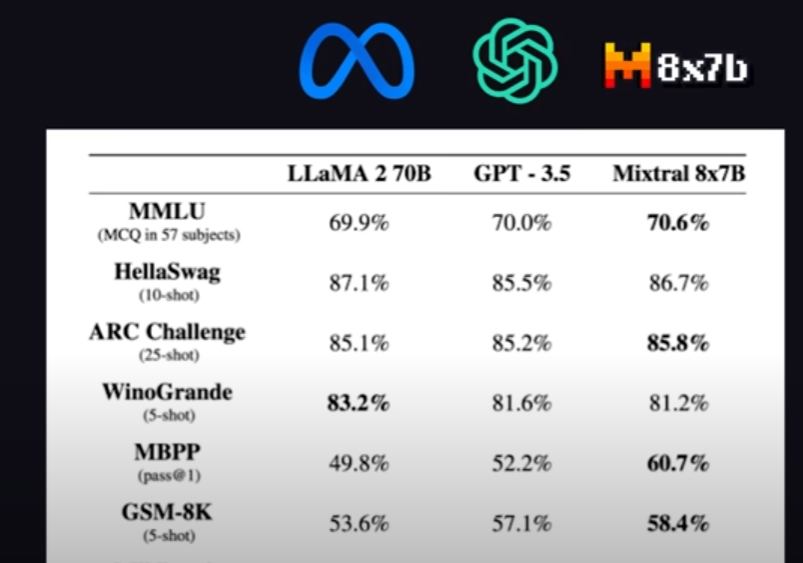

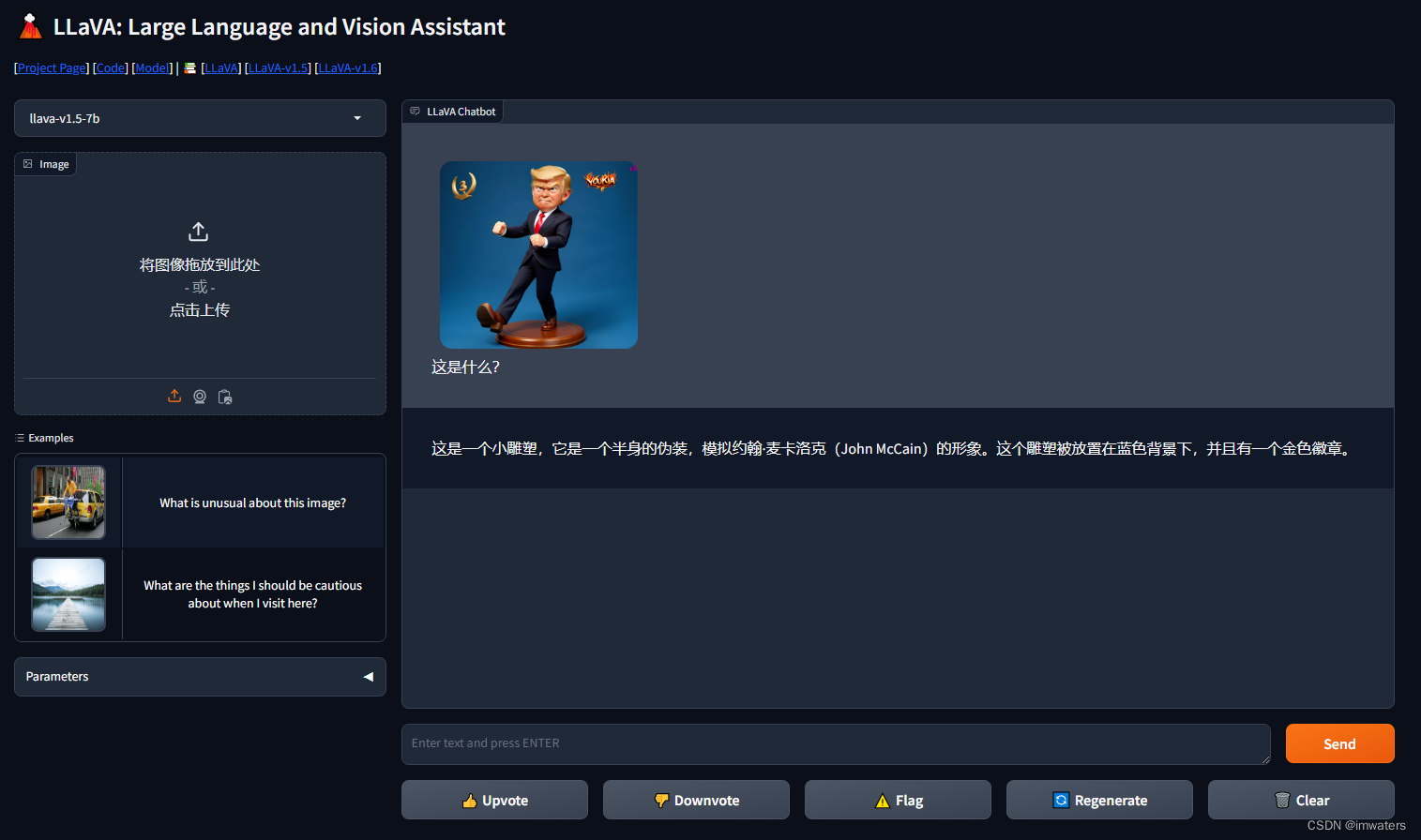

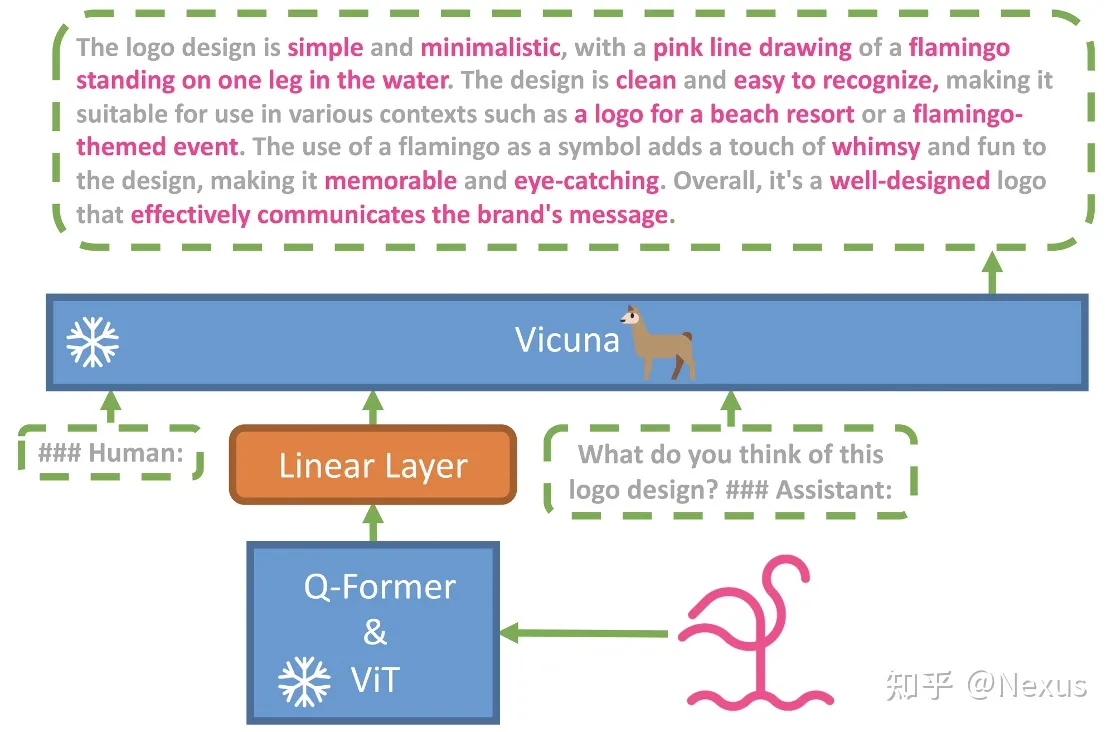

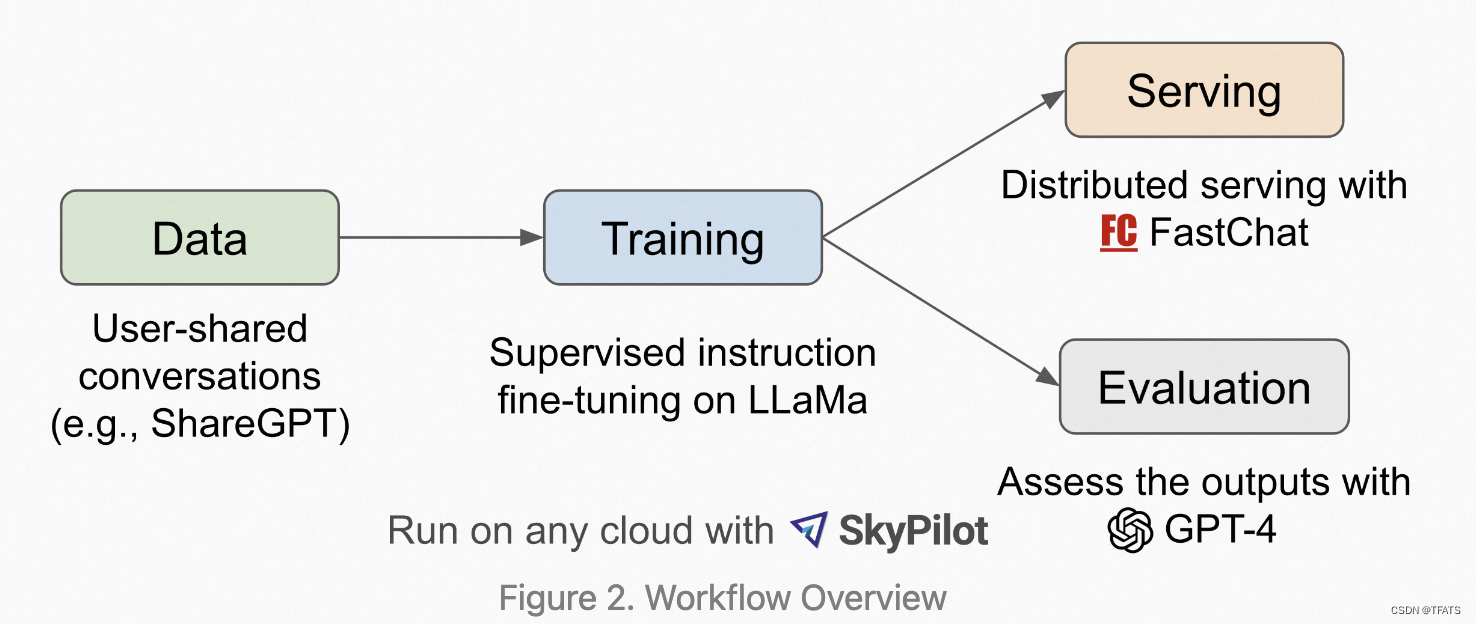

PaddleNLP使用Vicuna

LLaMA 模型

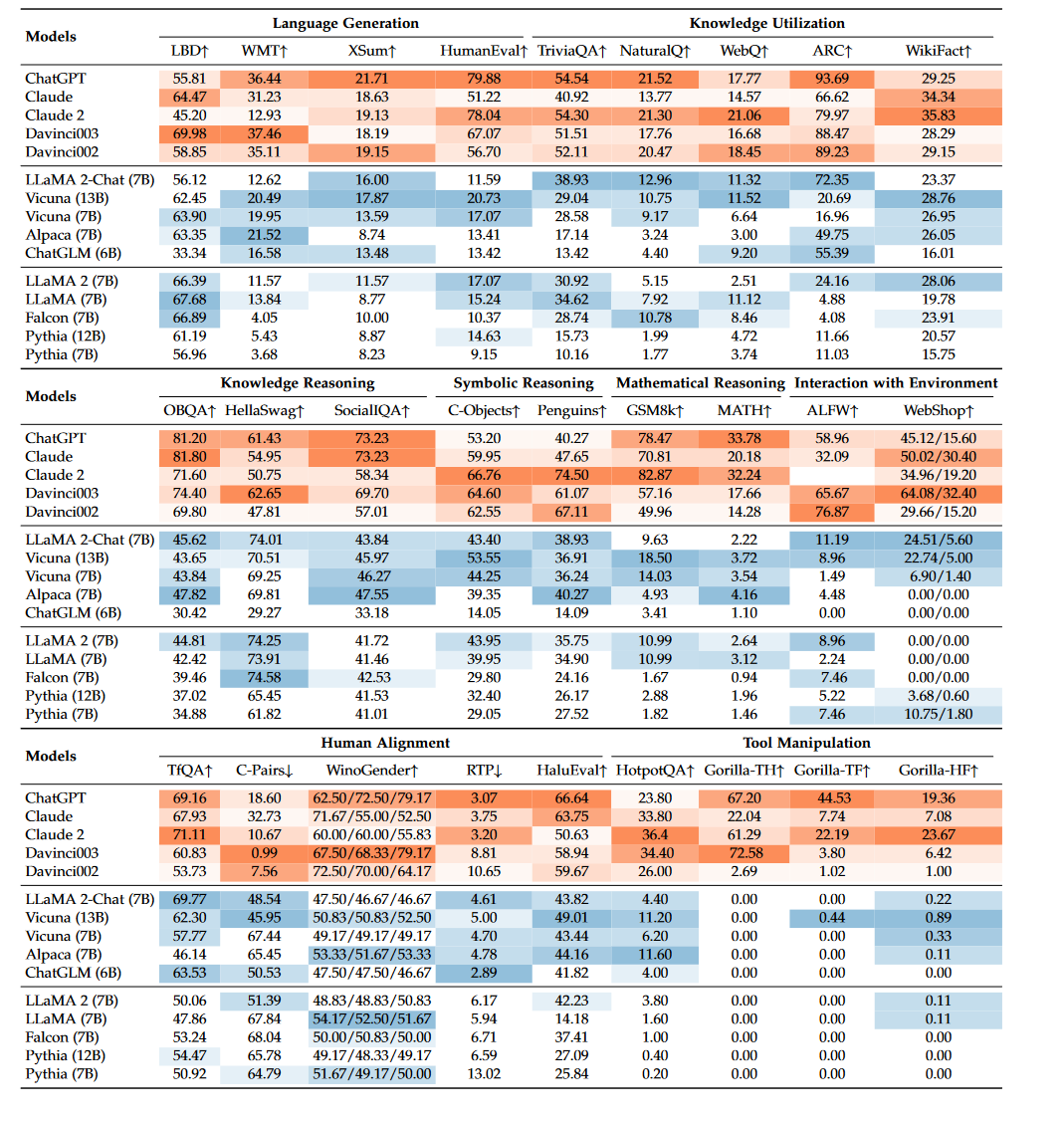

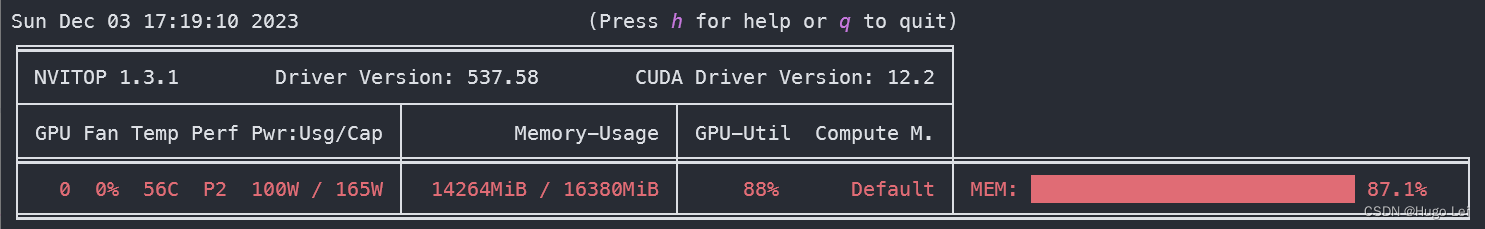

LLaMa 是一个大型语言模型,由 Meta 开源。它的全称是 Large Language Model Meta AI,参数量从 70 亿到 650 亿不等。例如,130 亿参数的 LLaMA 模型在大多数基准上可以胜过参数量达 1750 亿的 GPT-3,而且可以在单块 V1…

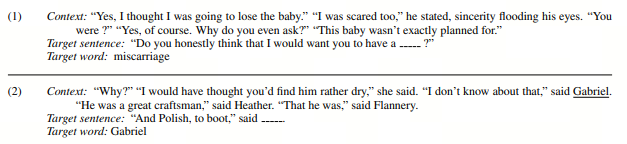

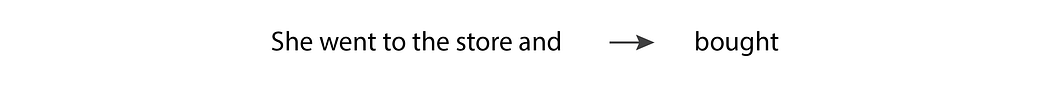

当人工智能无法确定‘它‘在句子中指的是什么时,很难相信它将接管世界

在2012年的一篇论文中,计算机科学家Hector Levesque、Ernest Davis和Leora Morgenstern提出了一个更客观的测试,他们称之为Winograd模式挑战。此后,这一测试被人工智能语言社区采用,作为评估机器理解的一种方式,也许是…

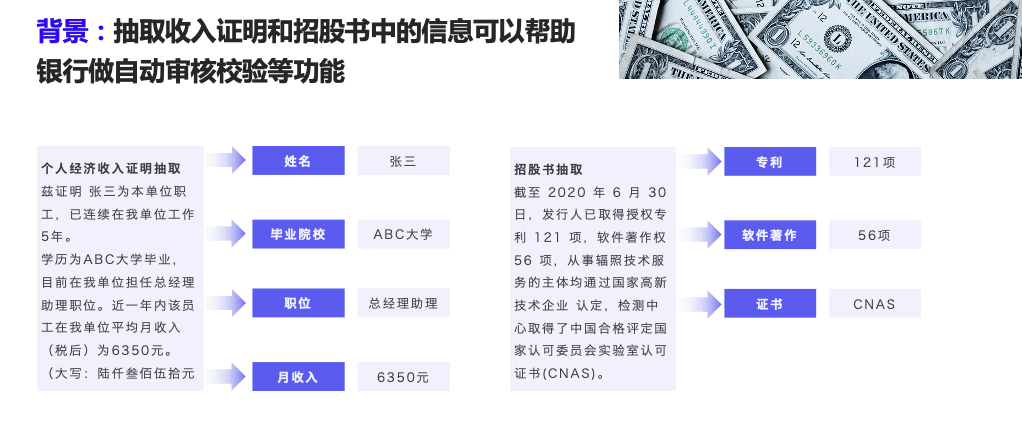

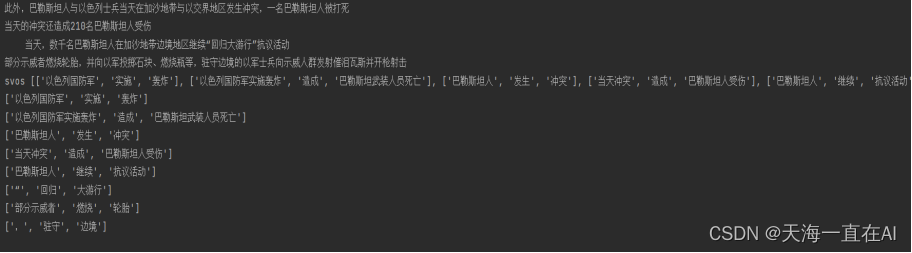

通俗讲:自然语言处理(NLP)入门之信息抽取(Information Extraction)

喜欢的话请关注我们的微信公众号~《你好世界炼丹师》。

公众号主要讲统计学,数据科学,机器学习,深度学习,以及一些参加Kaggle竞赛的经验。公众号内容建议作为课后的一些相关知识的补充,饭后甜点。此外,为了…

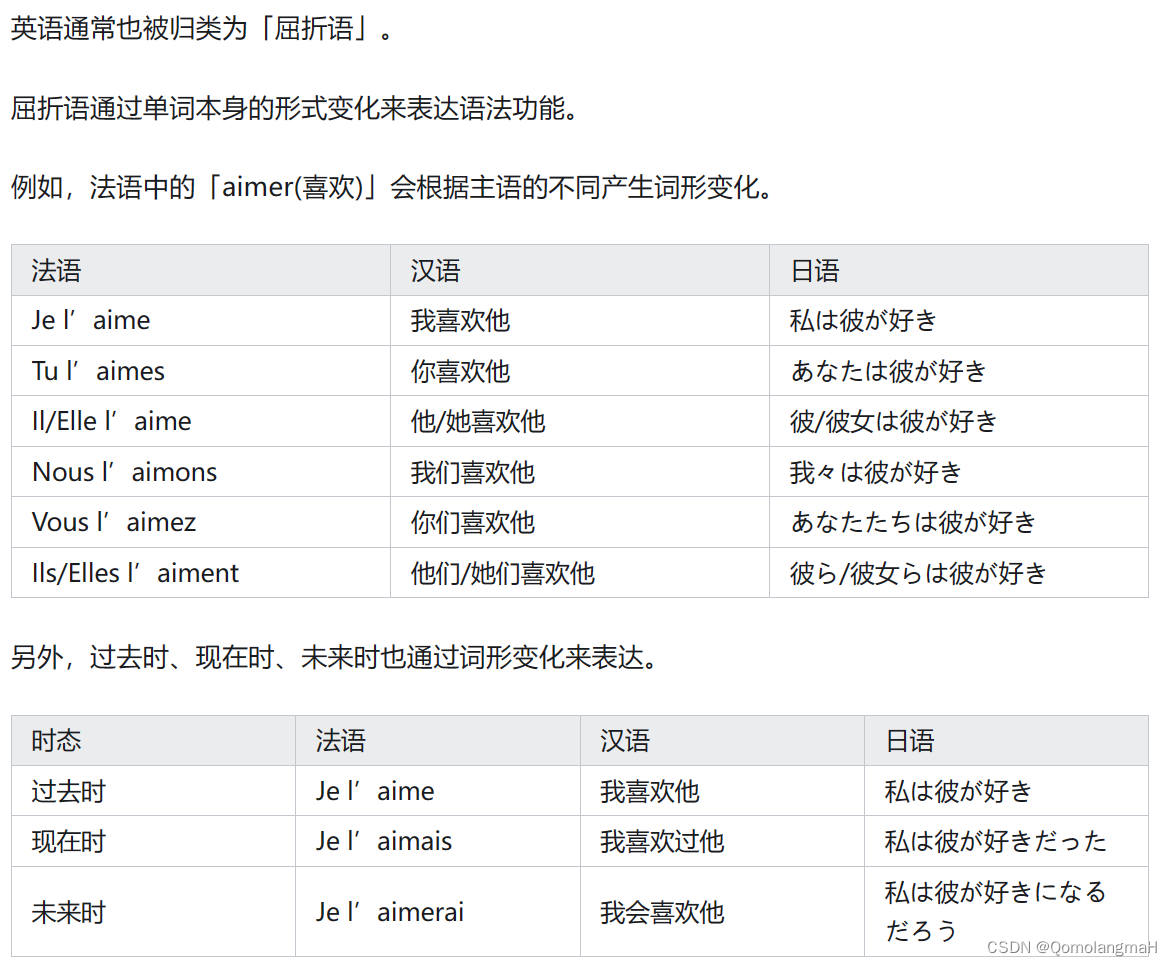

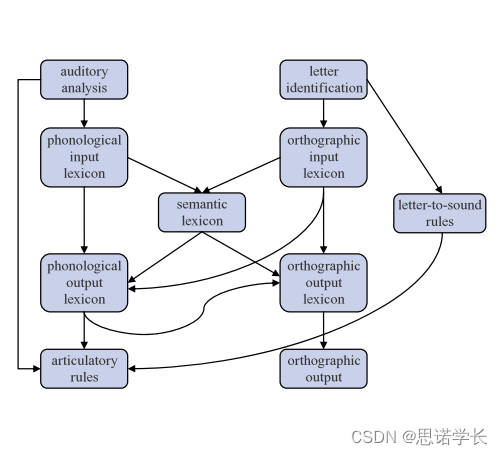

(3)形态学:语言的词汇----NLP的语言学基础

术语: 词库:心理词典正字法: 心理词库中为每个词独特的语音表征、发音、语义的方法语法范畴/语法类:词的性质1 词典 2 实义词和功能词 实义词/开放类:名词、动词、形容词、副词功能词/功能词/封闭类:连词、…

(2) 脑与语言——NLP中的语言基础

第二章 脑与语言

1 人脑

1.1 人脑中的语言功能定位

19世纪早期,弗朗兹⋅约瑟夫⋅加尔的定位理论、颅相学 已被抛弃对失语症和其他语言障碍的科学已得到证实

1.1.1 失语症

分类 布洛卡区受损:语法缺失韦尼克区受损:杂乱语和无意义词一些结…

(1)语言是什么——NLP的语言基础

本系列是《语言引论》的阅读笔记,旨在学习NLP中常见的语言学相关的知识,对其有一个最基本的,整体的,感性的了解。一下是OneNote笔记的复制粘贴: 第一章 语言是什么 1 语言知识 1.1 语音系统的知识 1.2 词的知识 掌握一…

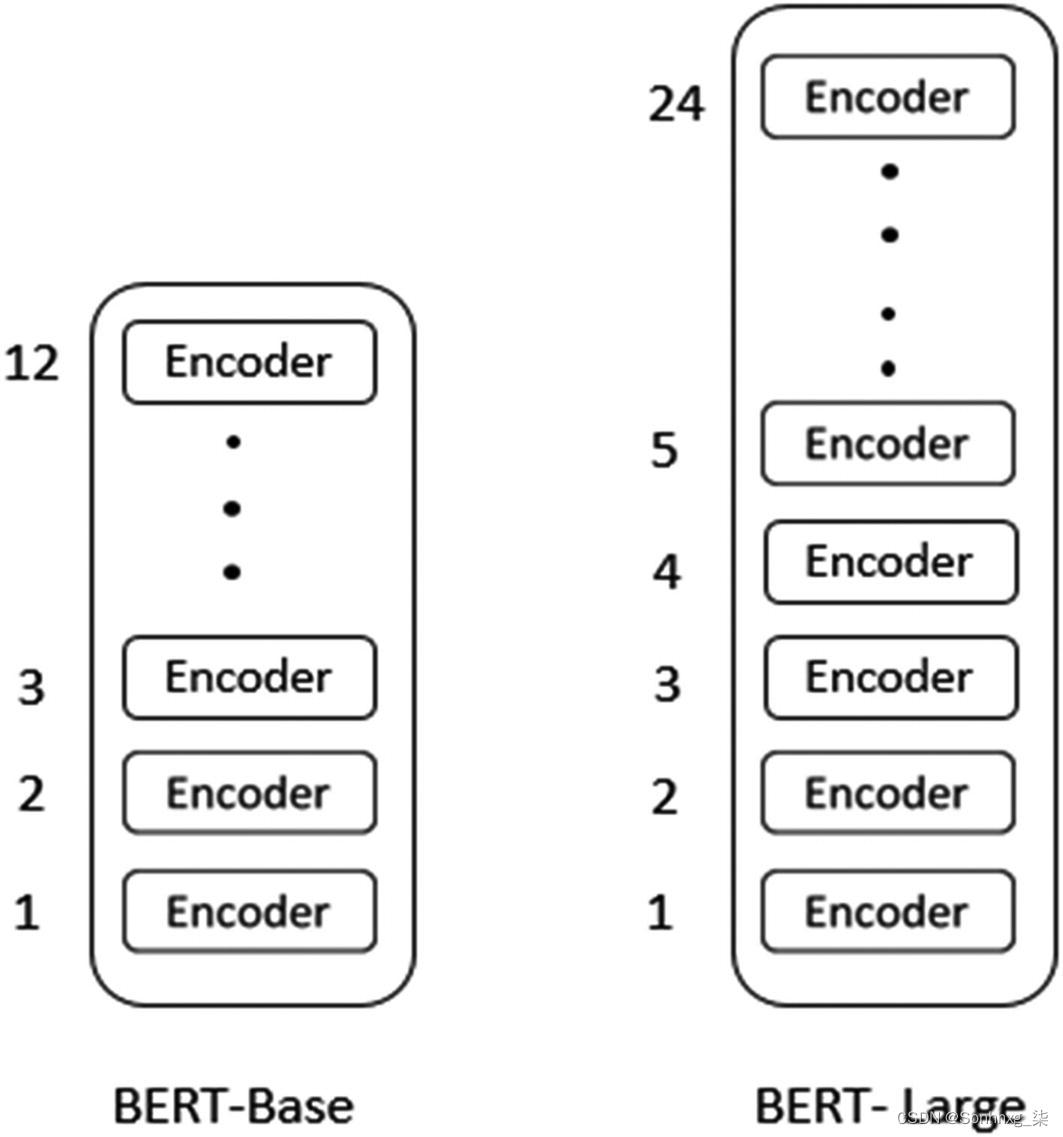

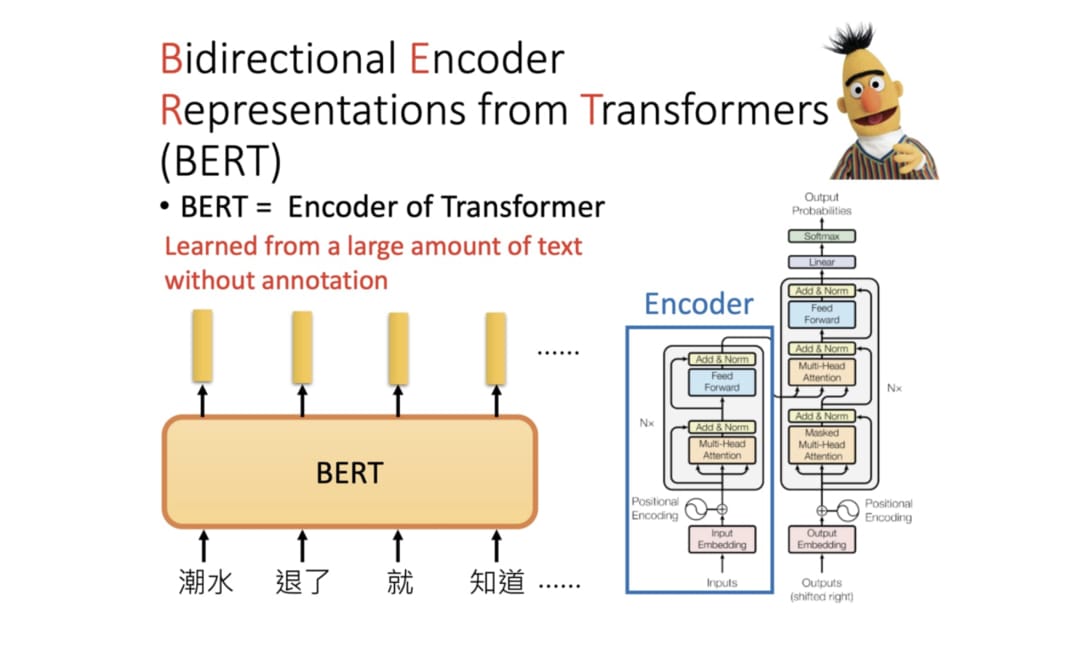

为什么BERT有效【综述】

论文标题:A Primer in BERTology: What We Know About How BERT Works 论文地址:https://arxiv.org/pdf/2002.12327.pdf 摘要 BERT学习了什么类型的信息是如何表示的对其训练目标和体系结构的常见修改过度参数化问题和压缩方法未来研究的方向1 导言 Tran…

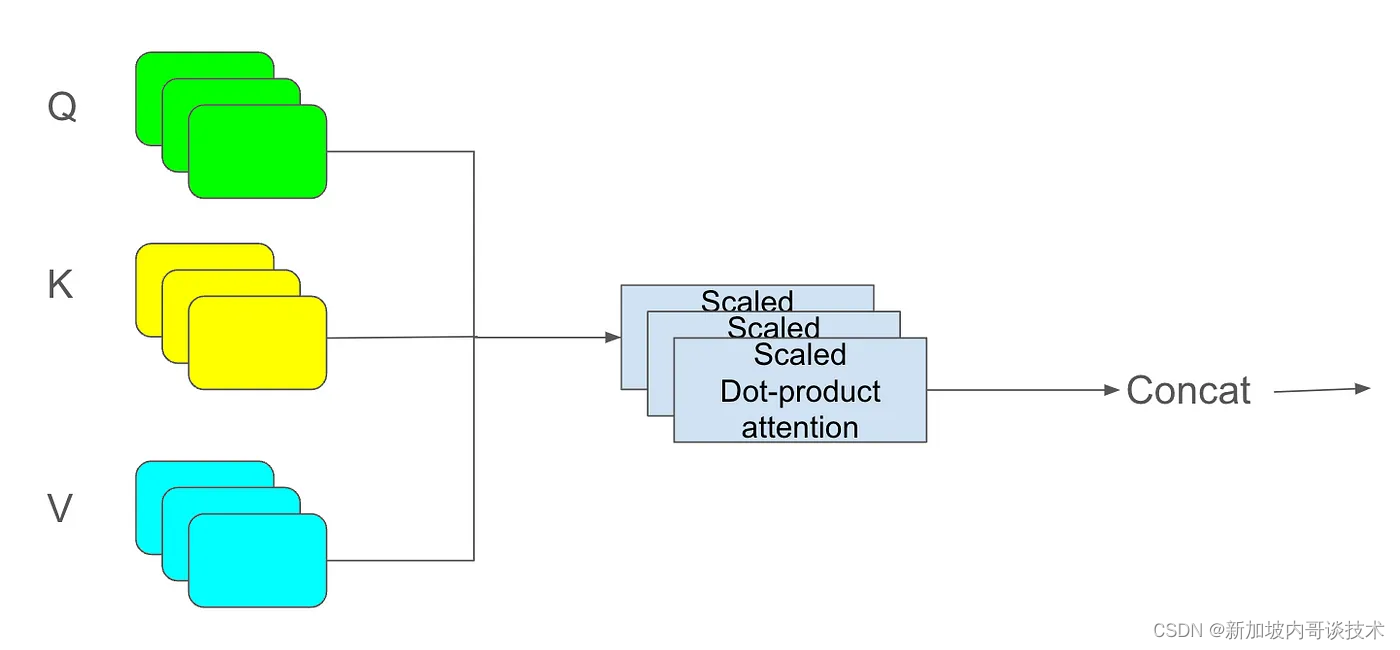

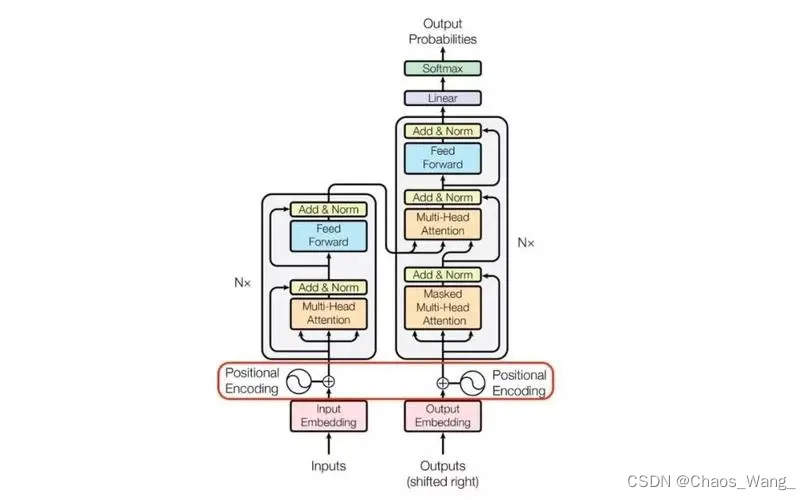

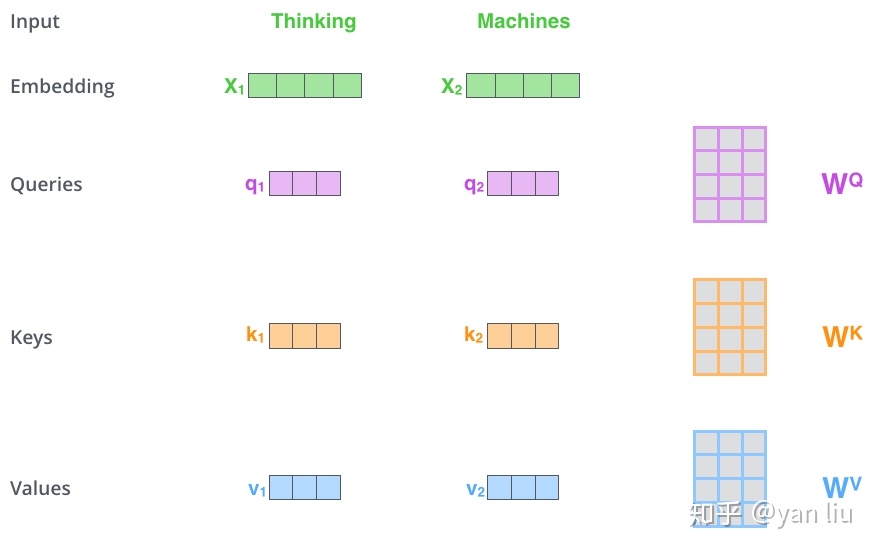

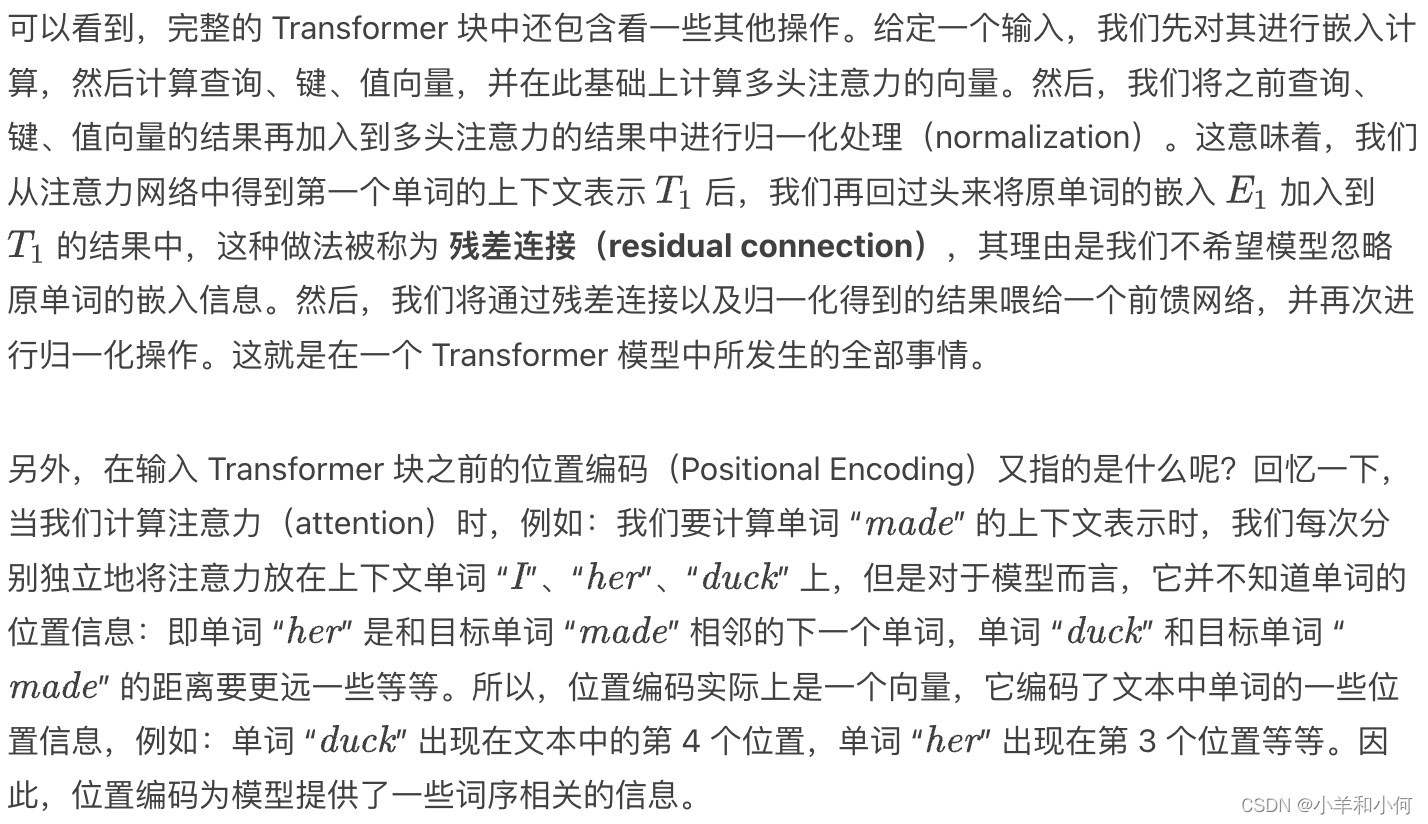

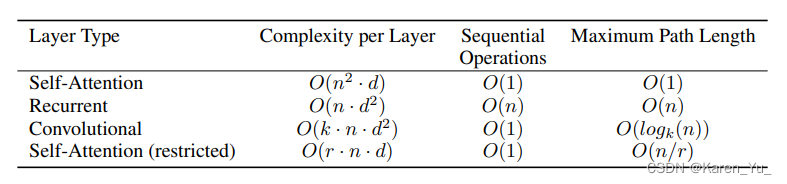

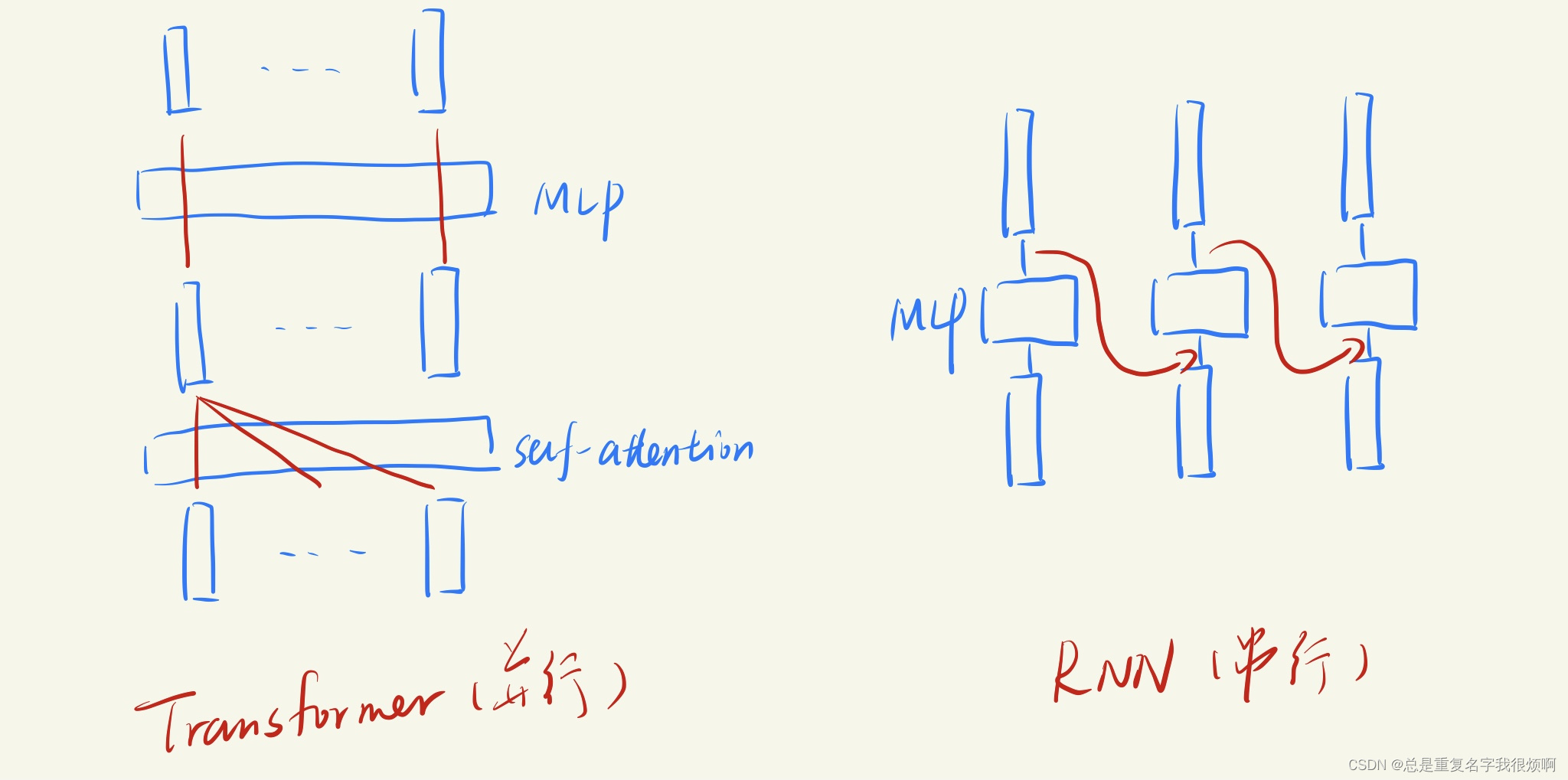

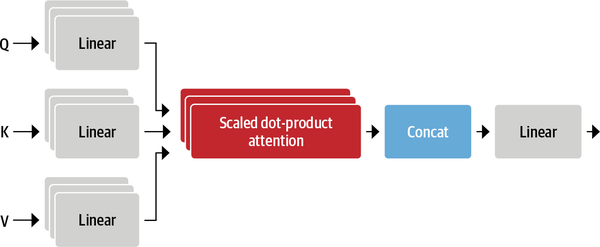

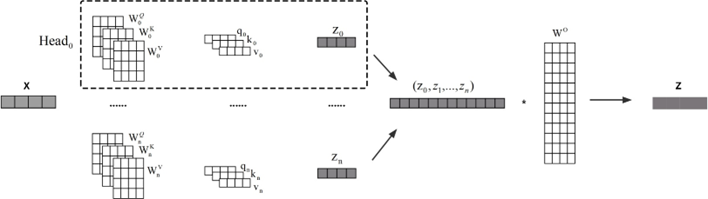

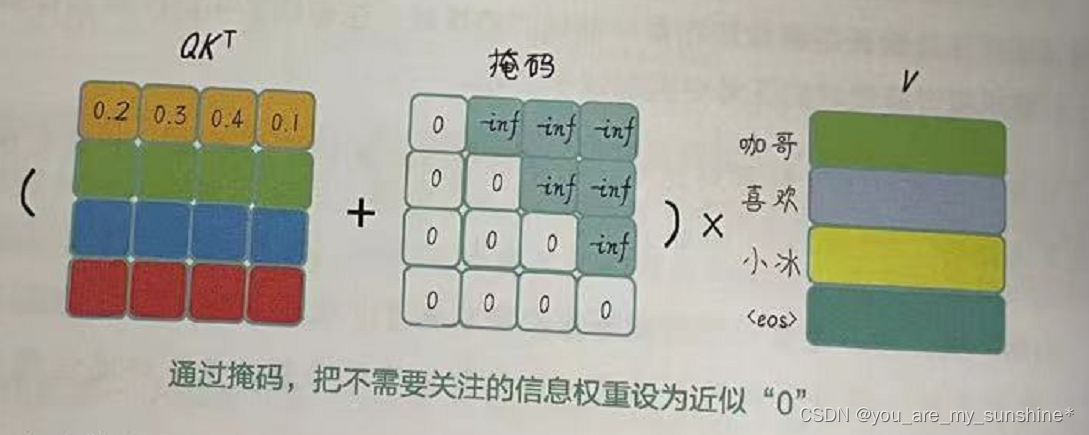

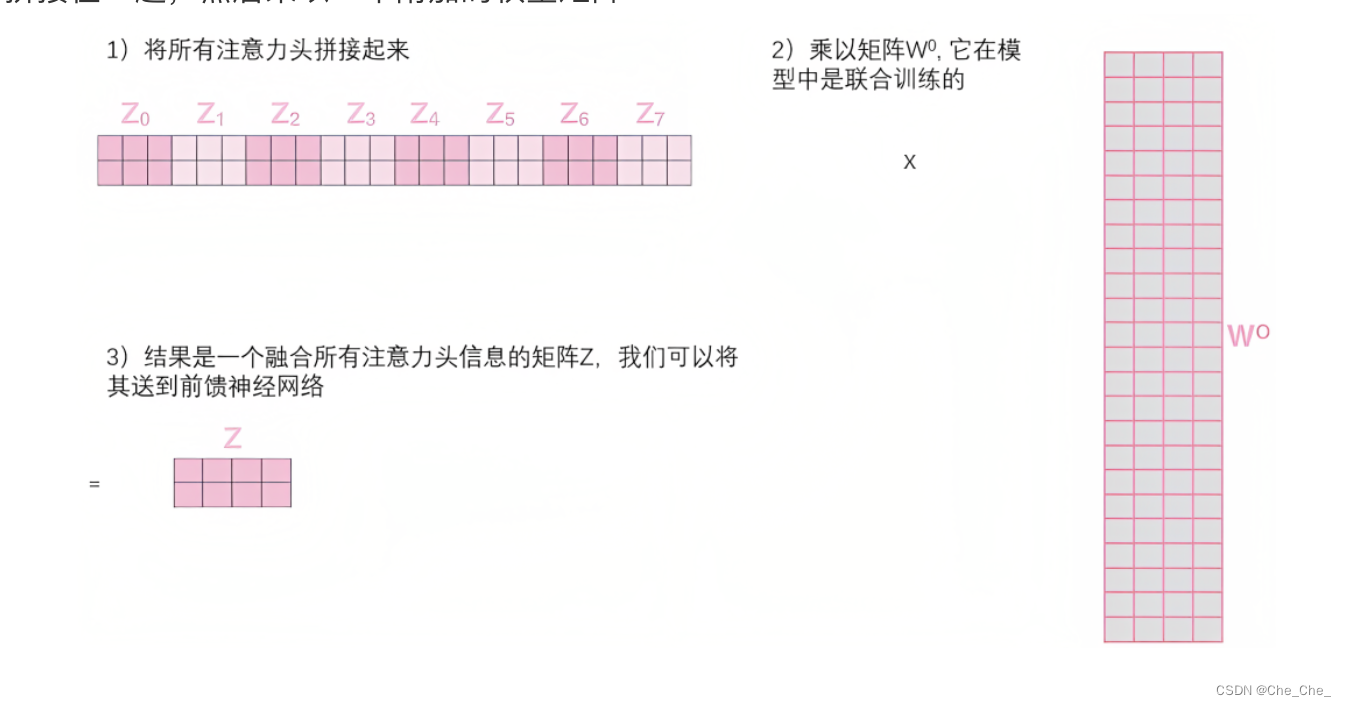

transformer通俗理解

Transformer是一个利用注意力机制来提高模型训练速度的模型。trasnformer可以说是完全基于自注意力机制的一个深度学习模型,因为它适用于并行化计算,和它本身模型的复杂程度导致它在精度和性能上都要高于之前流行的RNN循环神经网络。

那什么是transform…

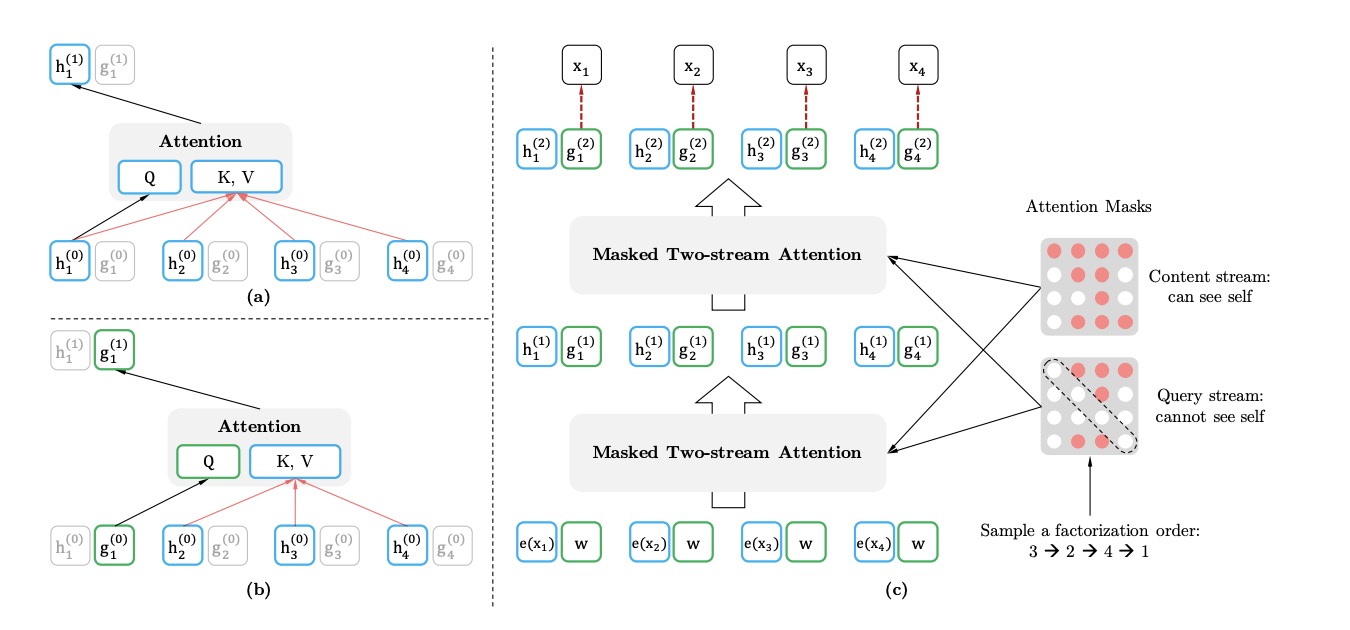

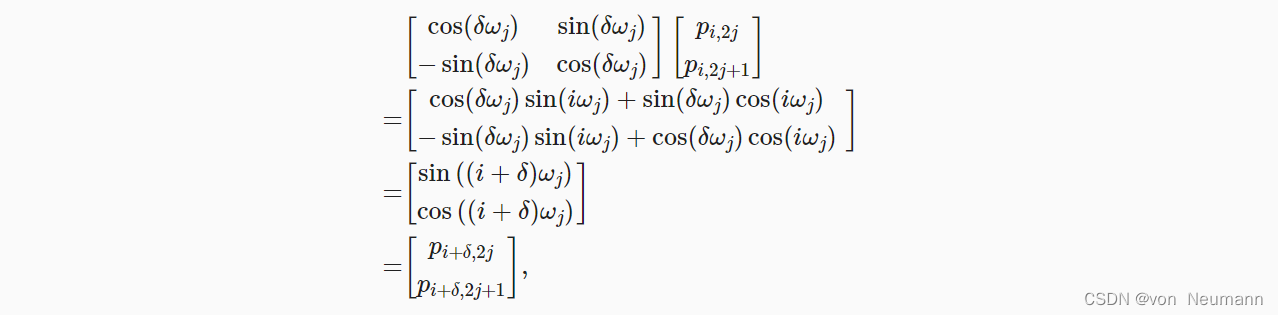

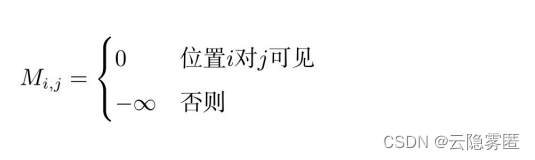

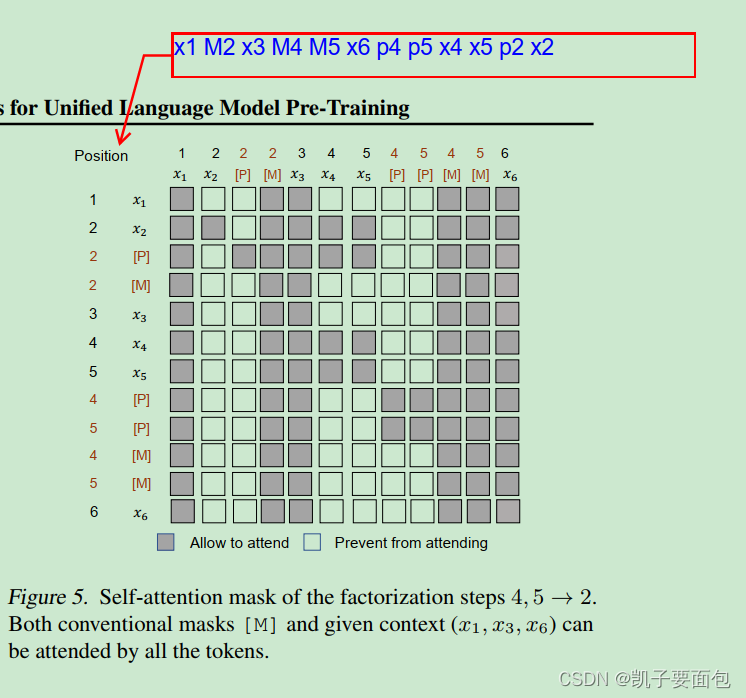

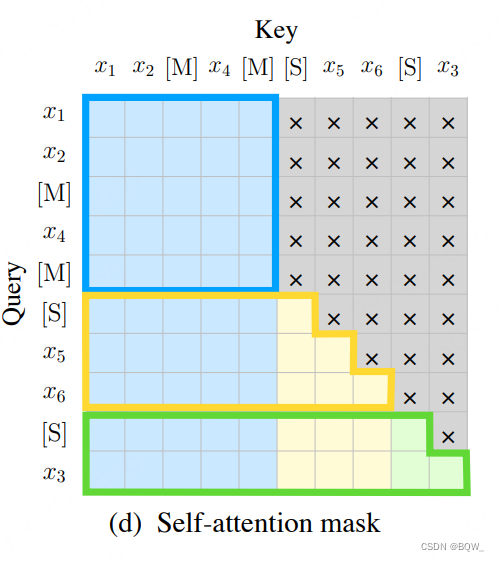

NLP中的XLNET

XLNET里面的细节点有很多,重点掌握以下两点:

AR和AE两种无监督预训练的优化目标双流自注意力机制:为什么需要把位置信息和内容信息拆分

1. 无监督目标函数

在NLP中,无监督表示学习已经获得长足发展。一般的流程是先将模型在大量…

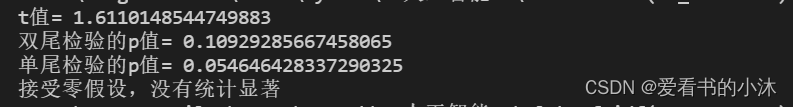

【小沐学NLP】Python进行统计假设检验

文章目录 1、简介1.1 假设检验的定义1.2 假设检验的类型1.3 假设检验的基本步骤 2、测试数据2.1 sklearn2.2 seaborn 3、正态分布检验3.1 直方图判断3.2 KS检验(scipy.stats.kstest)3.3 Shapiro-Wilk test(scipy.stats.shapiro)3.…

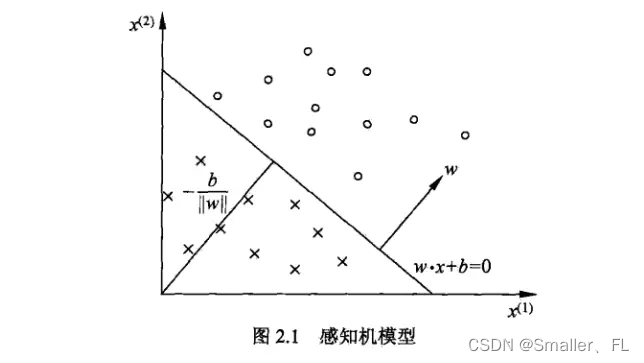

针对结构映射的SVM算法:核心思路解读

最近准备做一个NER和指代消解相关的课题,在和同学们读相关文章。今天有个同学找到了个挺有意思的文章,用SVM做NER的。我感觉这想法挺奇特的,SVM怎么处理文本和序列?于是我去看了一下,他找的那篇文章是个套壳文章&#…

Attention Model for Massive MIMO CSI Compression Feedback and Recovery阅读笔记

Abstract

本文旨在提高恢复性能,降低时间复杂度。首先在编码器网络中,引入LSTM网络;解码器中增加了注意力机制;第三,在训练过程中使用了early stopping。

1 Introduction

在CsiNet的基础上,做了以下几点…

电梯运行控制模式:如何做到人脸识别、刷卡、二维码?

深圳市巨风科技有限公司专注人脸识别与人证核验研发生产,提供人脸识别场景应用解决方案,致力智慧城市建设智能化管理。公司围绕全场景智慧生活战略,打造精品和提升用户体验。公司完全自主研发的小门卫系列产品:人脸识别门禁机&…

国企上云新动向,百数可实现“国资云”无缝对接

近期天津市国资委发布《关于加快推进国企上云工作完善国资云体系建设的实施方案》,要求国资企业逐步向国资云平台迁移,受到市场的广泛关注。 国企数据资源属于国有资产,应纳入国资监管和统一管理,保护国有数据资产安全是建设国资云…

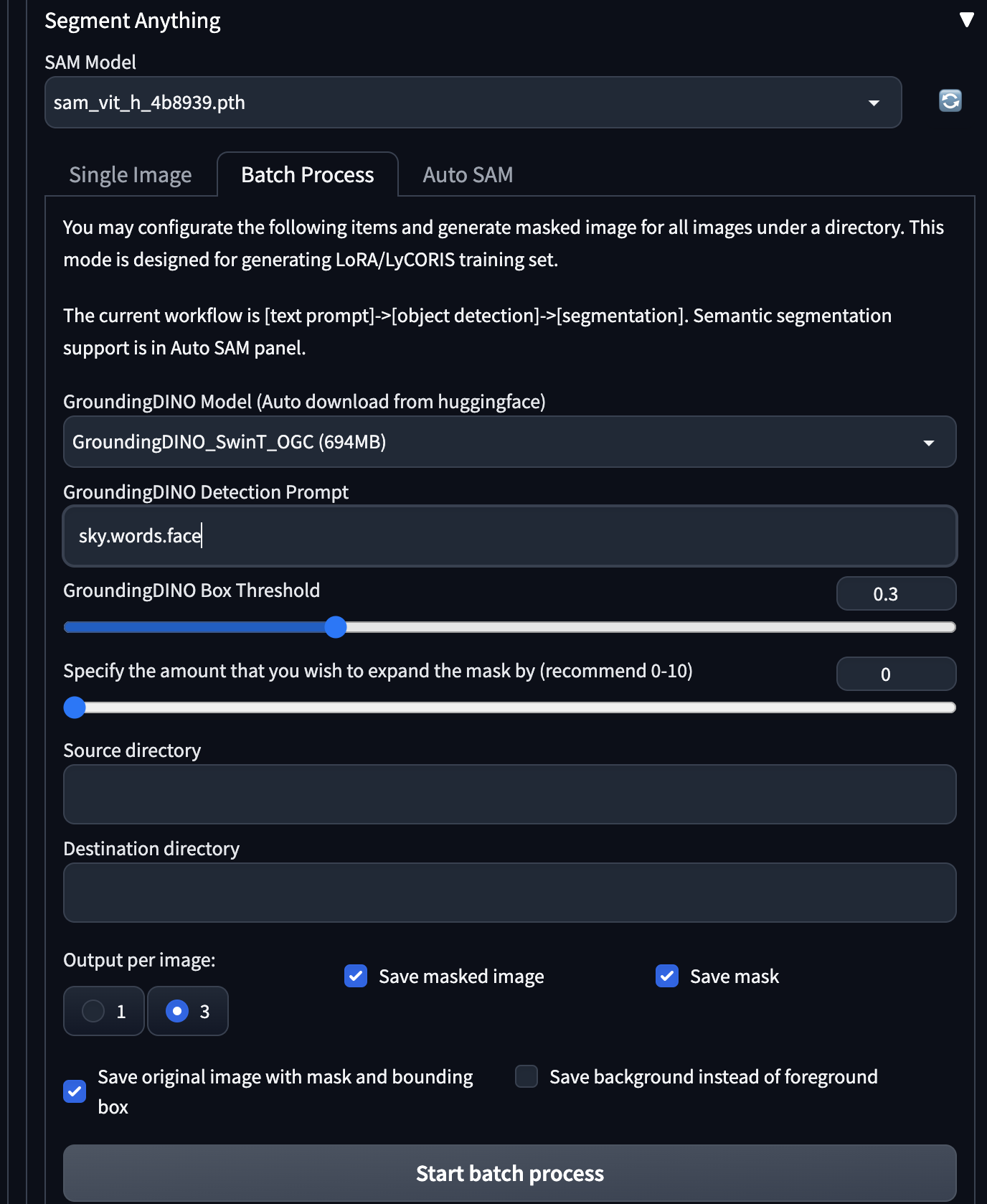

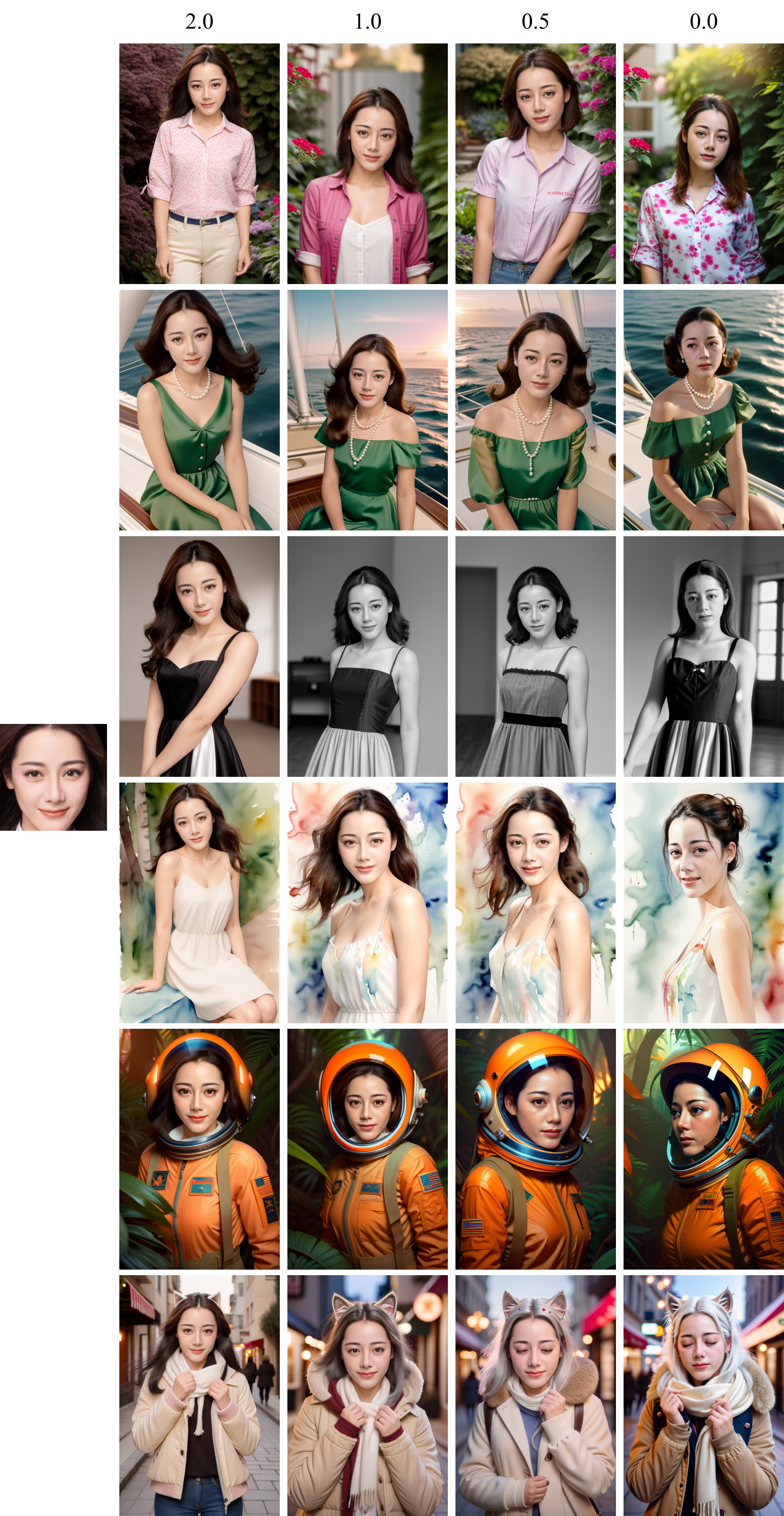

AI制作视频——mov2mov以及inpaint

背景

AI制作视频的几种思路

1.从零开始生成:清华的cogview,runway gen-1、gen-2,微软的女娲

这个思路,就是认为可以通过文字描述的方式把视频画面描述出来,通过对文本-视频帧内容-视频内容的数据对的平行语料的学习…

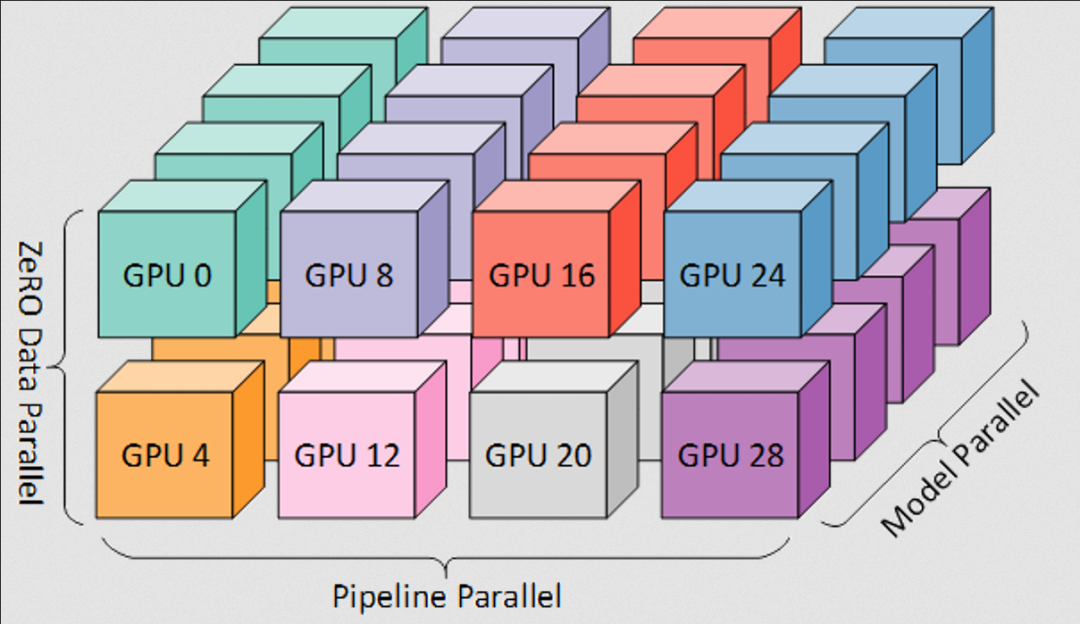

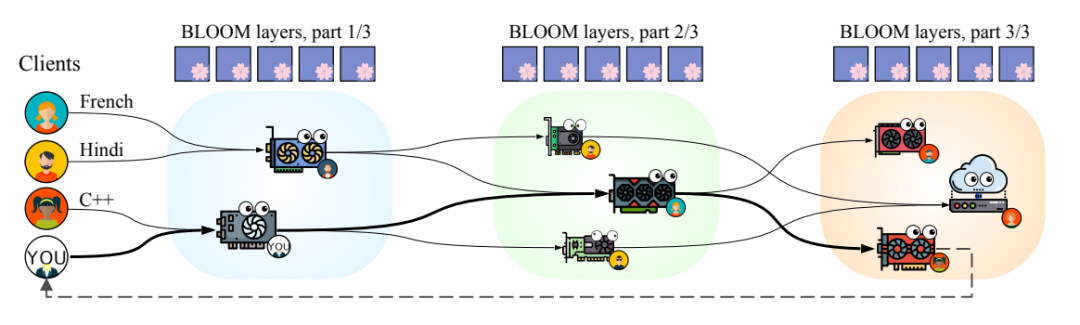

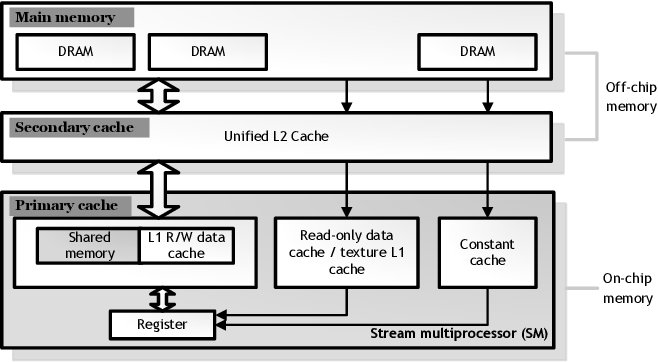

人工智能并行计算,很大程度提升了语言模型的训练速度

循环智能最早的三位创始人陈麒聪、杨植麟与张宇韬相识于清华大学的知识工程实验室,都有一股「用AI创造社会价值」的热血。三人都是技术出身,后来因为业务发展,循环智能在2018年又引入了另一位擅长技术产品运营的「第四把手」揭发。 自成立…

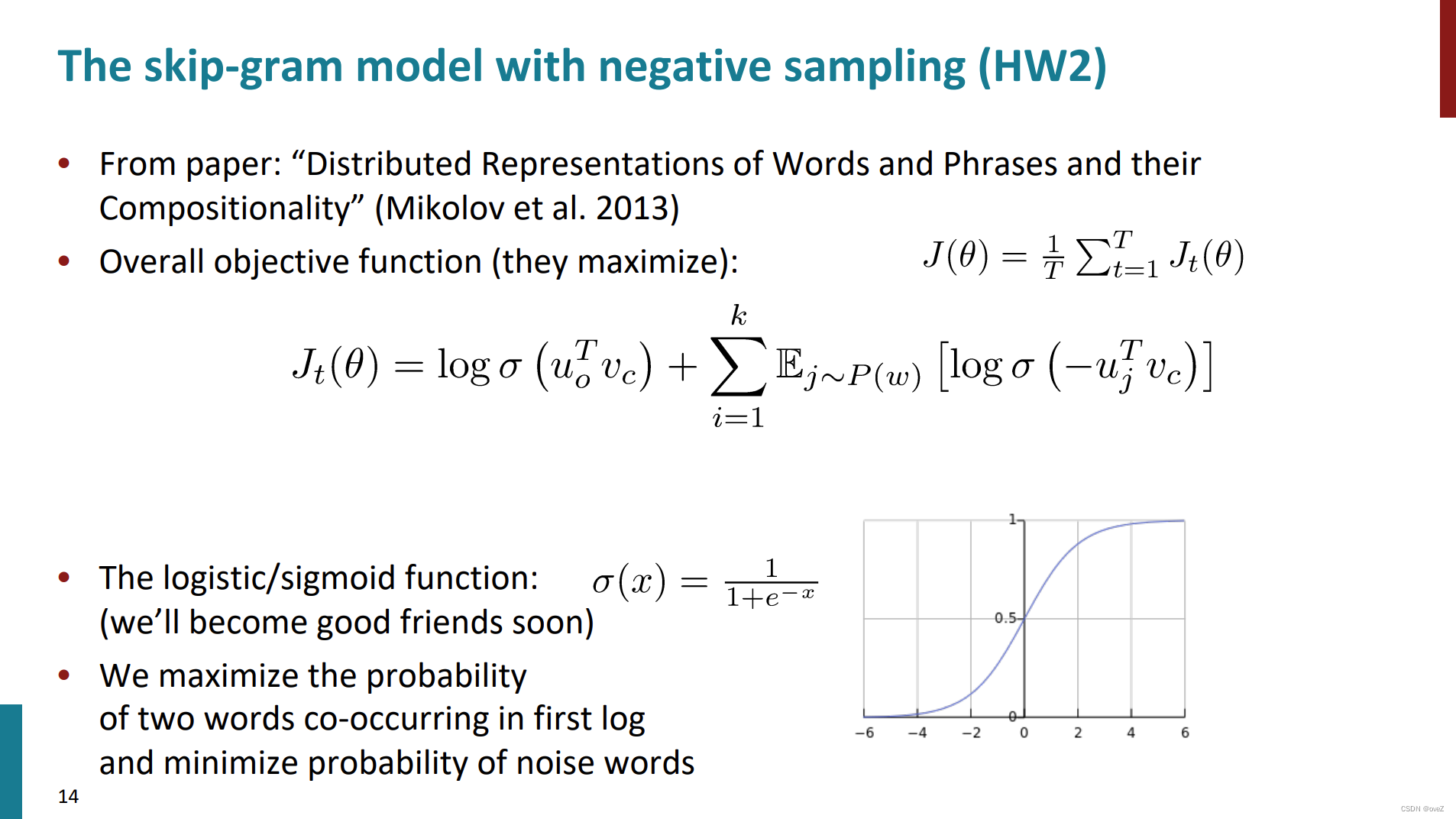

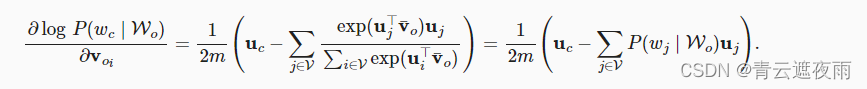

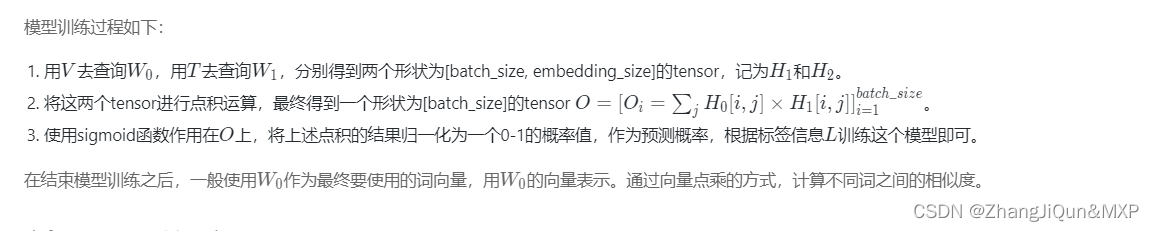

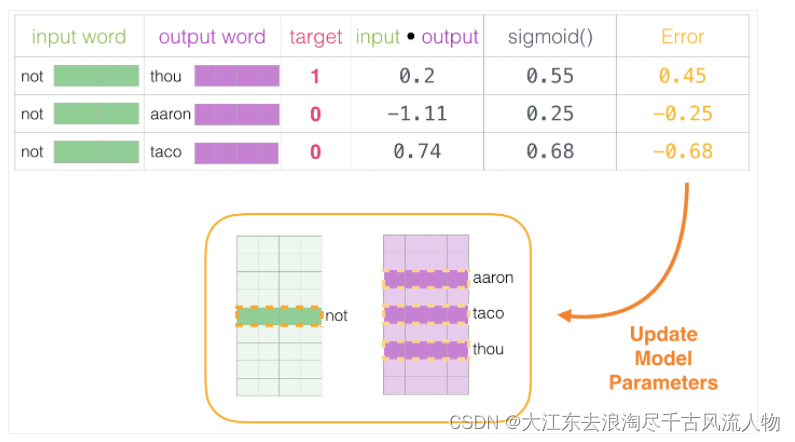

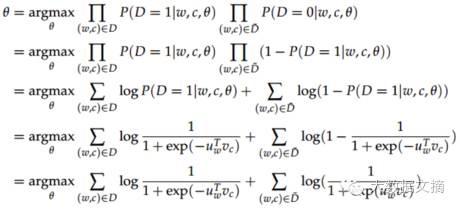

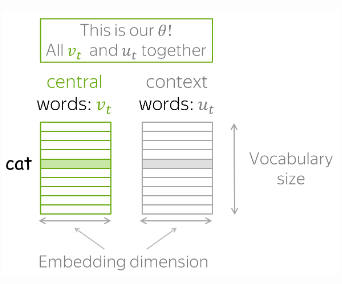

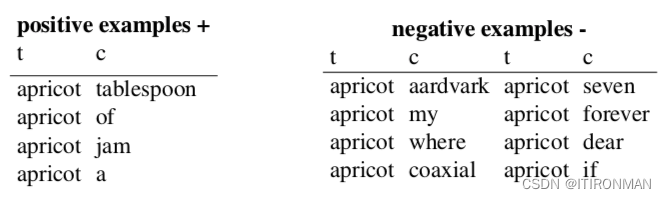

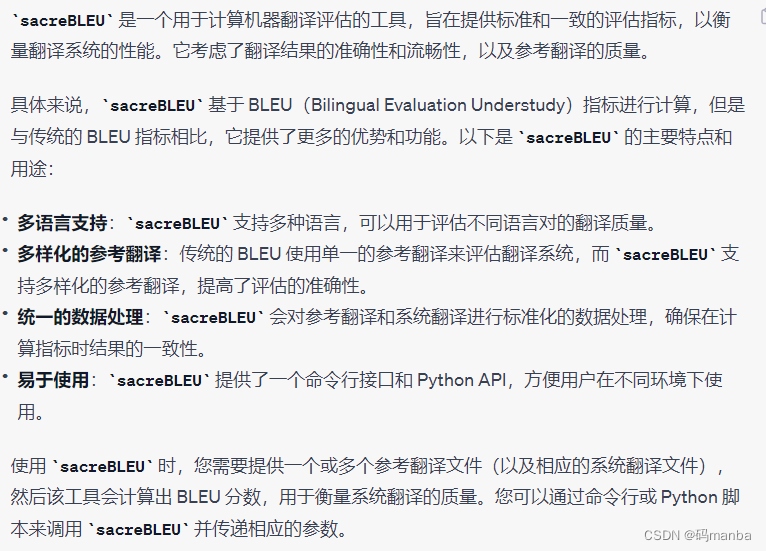

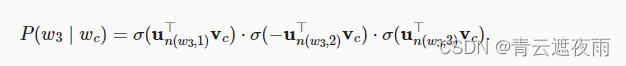

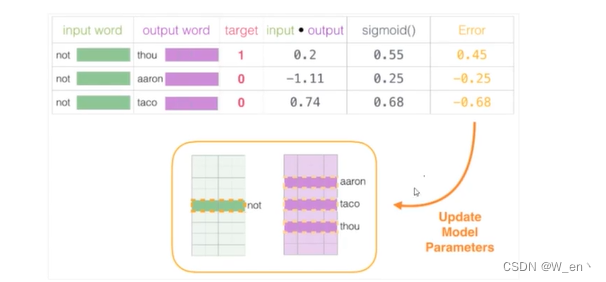

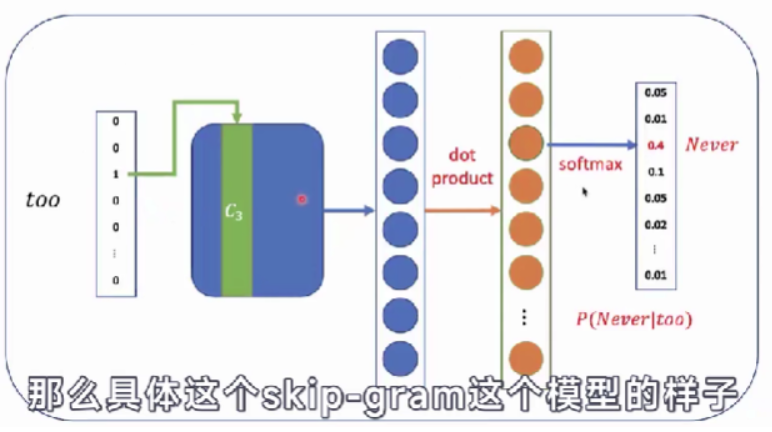

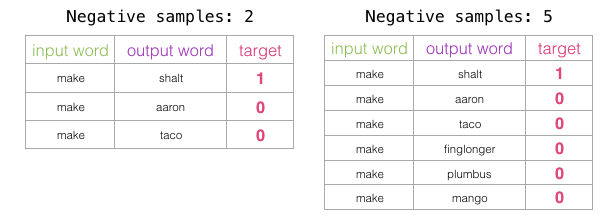

负采样:如何高效训练词向量

Negative Sampling

1.何为负采样

负采样是一种用于训练词嵌入模型的采样方法,特别适用于处理大规模词汇表的情况。负采样的目标是降低计算成本并改善模型的性能,同时有效地训练词向量。

2.为什么需要负采样

在传统的词嵌入模型中,如Word…

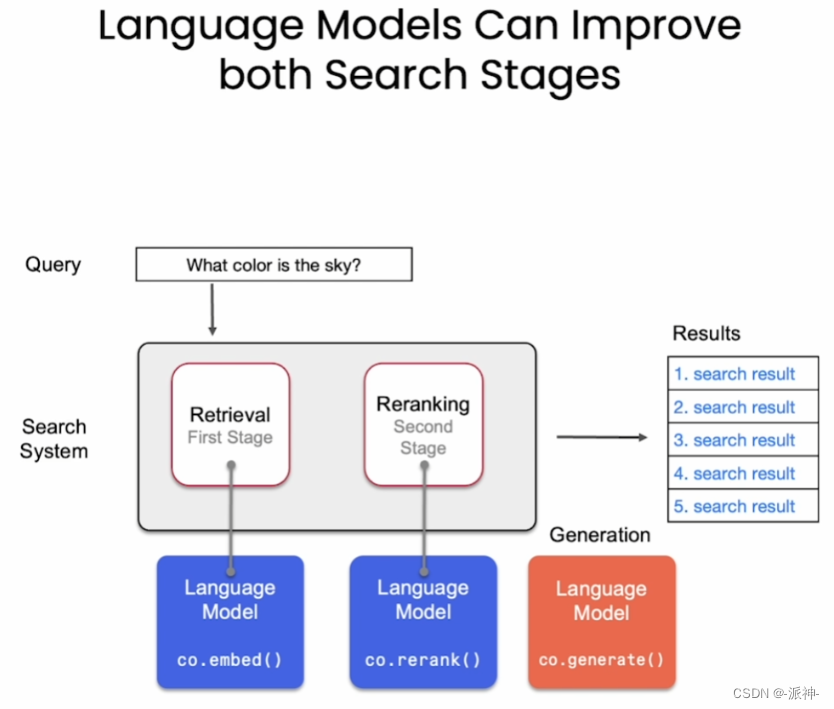

搜索引擎的查询意图识别(query理解)

by 张帆(自然语言处理组搜狗) 通用搜索VS垂直搜索 通用搜索特点: 抓取互联网上一切有价值的页面,同意建立索引,以关键字匹配为基本检索方式,以网页title和summary为展现方式 …

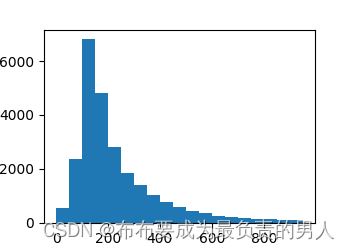

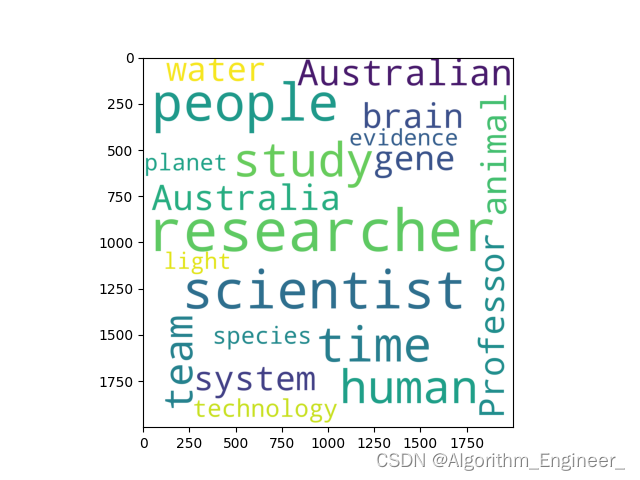

【UCAS自然语言处理作业一】利用BeautifulSoup爬取中英文数据,计算熵,验证齐夫定律

文章目录 前言中文数据爬取爬取界面爬取代码 数据清洗数据分析实验结果 英文数据爬取爬取界面动态爬取 数据清洗数据分析实验结果 结论 前言

本文分别针对中文,英文语料进行爬虫,并在两种语言上计算其对应的熵,验证齐夫定律github: ShiyuNee…

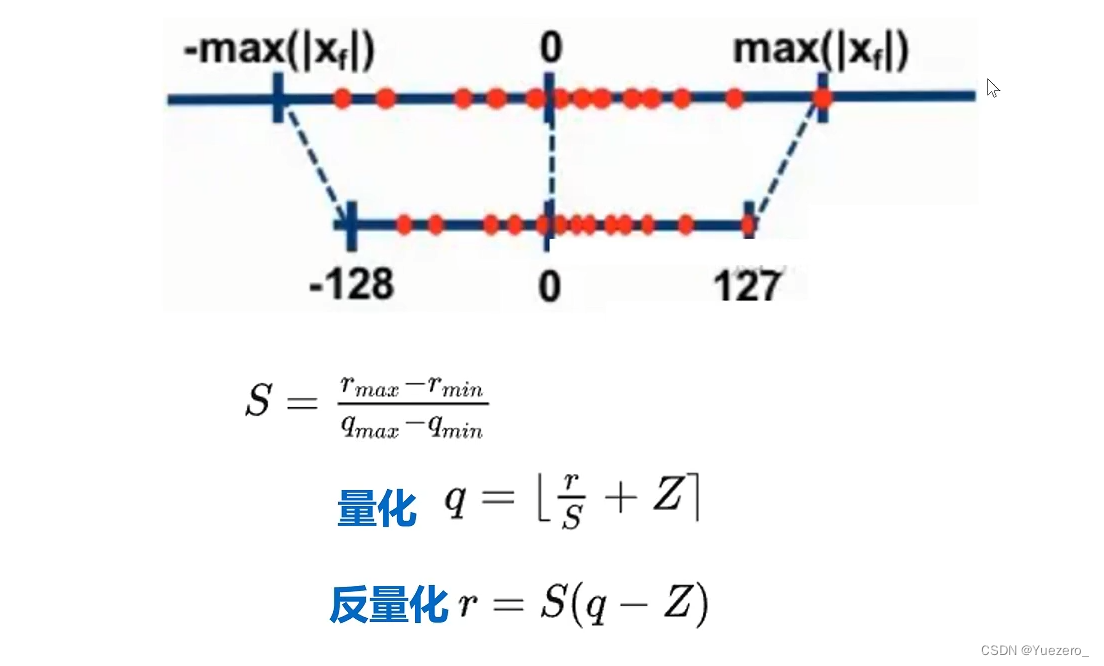

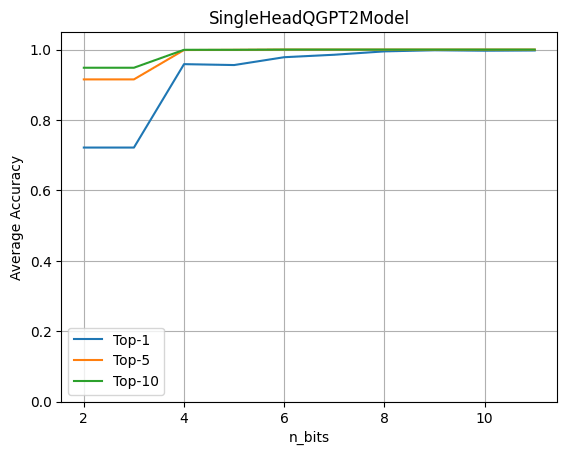

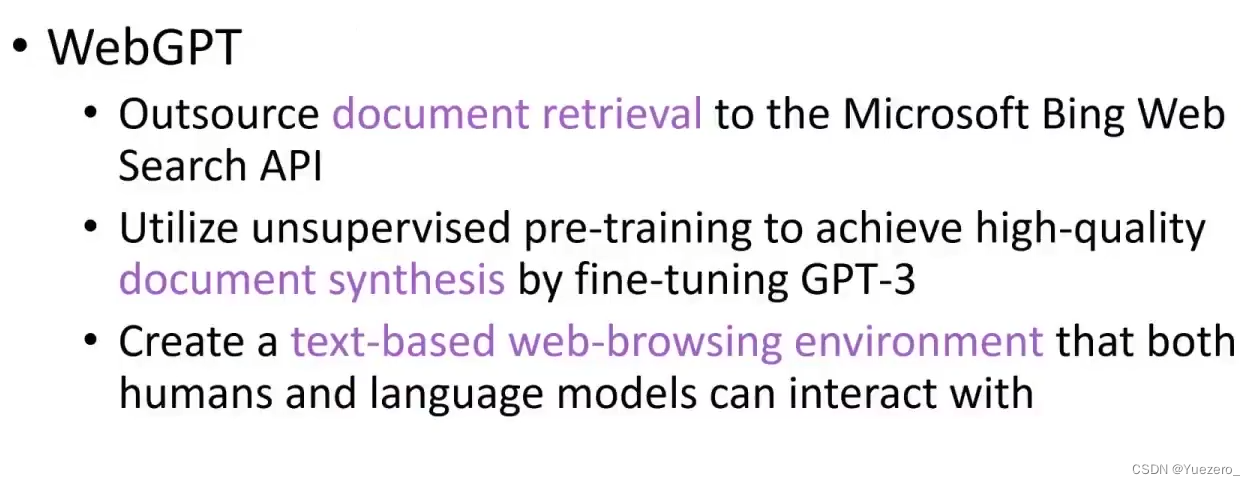

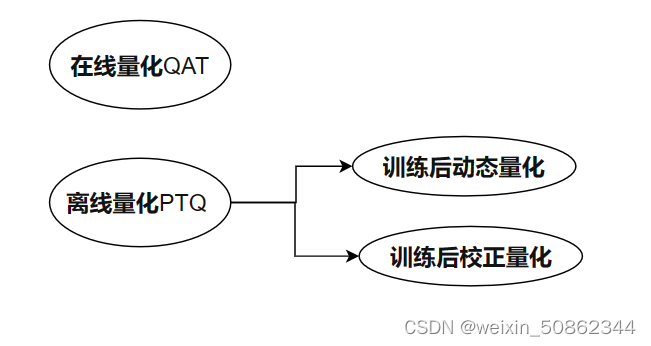

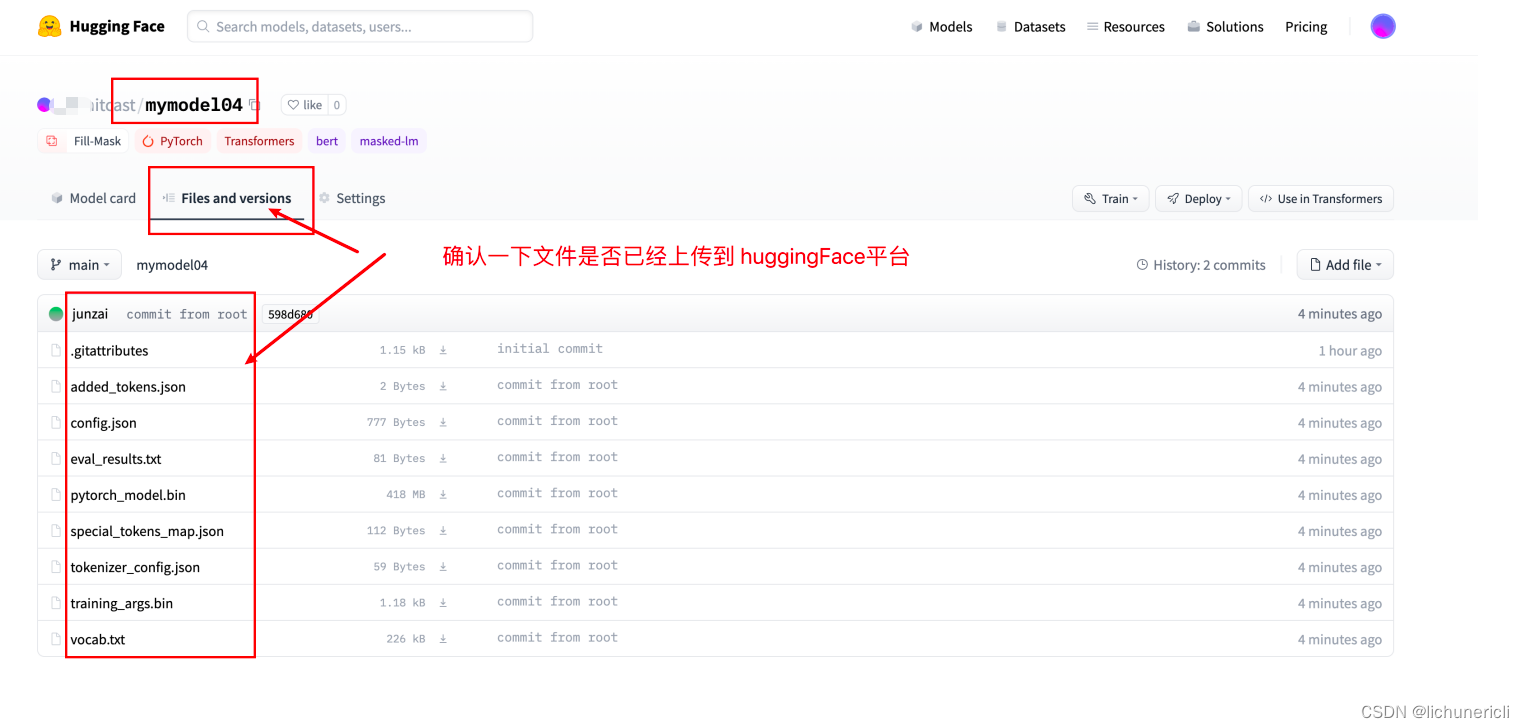

NLP(六十八)使用Optimum进行模型量化

本文将会介绍如何使用HuggingFace的Optimum,来对微调后的BERT模型进行量化(Quantization)。 在文章NLP(六十七)BERT模型训练后动态量化(PTDQ)中,我们使用PyTorch自带的PTDQ&…

Can Language Models Make Fun? A Case Study in Chinese Comical Crosstalk

本文是LLM系列文章,针对《Can Language Models Make Fun? A Case Study in Chinese Comical Crosstalk》的翻译。 语言模型能制造乐趣吗?中国滑稽相声个案研究 摘要1 引言2 问题定义3 数据集4 使用自动评估生成基准5 人工评估6 讨论7 结论与未来工作 摘要

语言是…

23- 条件随机场CRF (NLP算法) (算法)

CRF模型构建 :

crf sklearn_crfsuite.CRF(c1 0.1,c2 0.1,max_iterations100,all_possible_transitionsTrue)

crf.fit(X_train,y_train) 1、条件随机场CRF概述

将之前所有的观测作为未来预测的依据是不现实的,因为其复杂度会随着观测数量的增加而无限制地增长。因…

【1】Ubuntu18.04 下的安装,运行 ublox f9p, 并进行数据的采集和 RKT轨迹的生成

一、预备库

1.1 C++11 Compiler

This package requires some features of C++11.

1.2 ROS

This package is developed under ROS Kinetic environment.

1.3 Eigen

We use Eigen 3.3.3 for matrix manipulation.

1.4 Boost

Our software utilizes Boost library for ser…

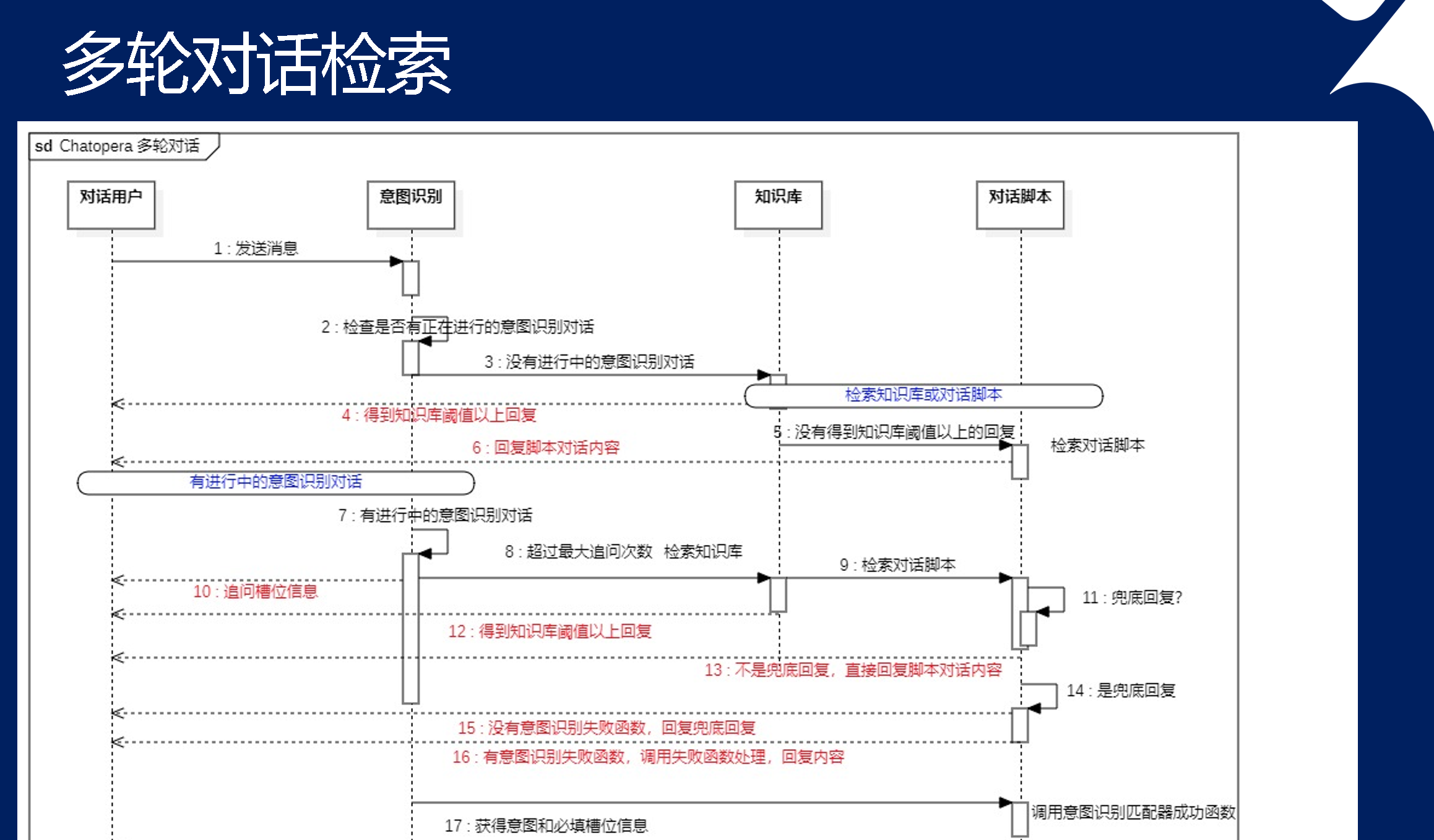

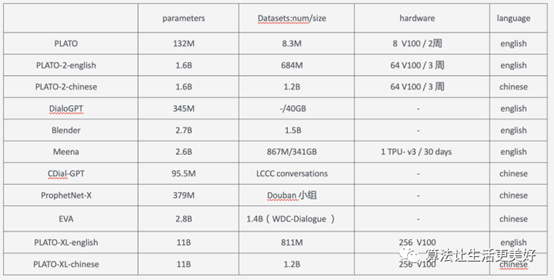

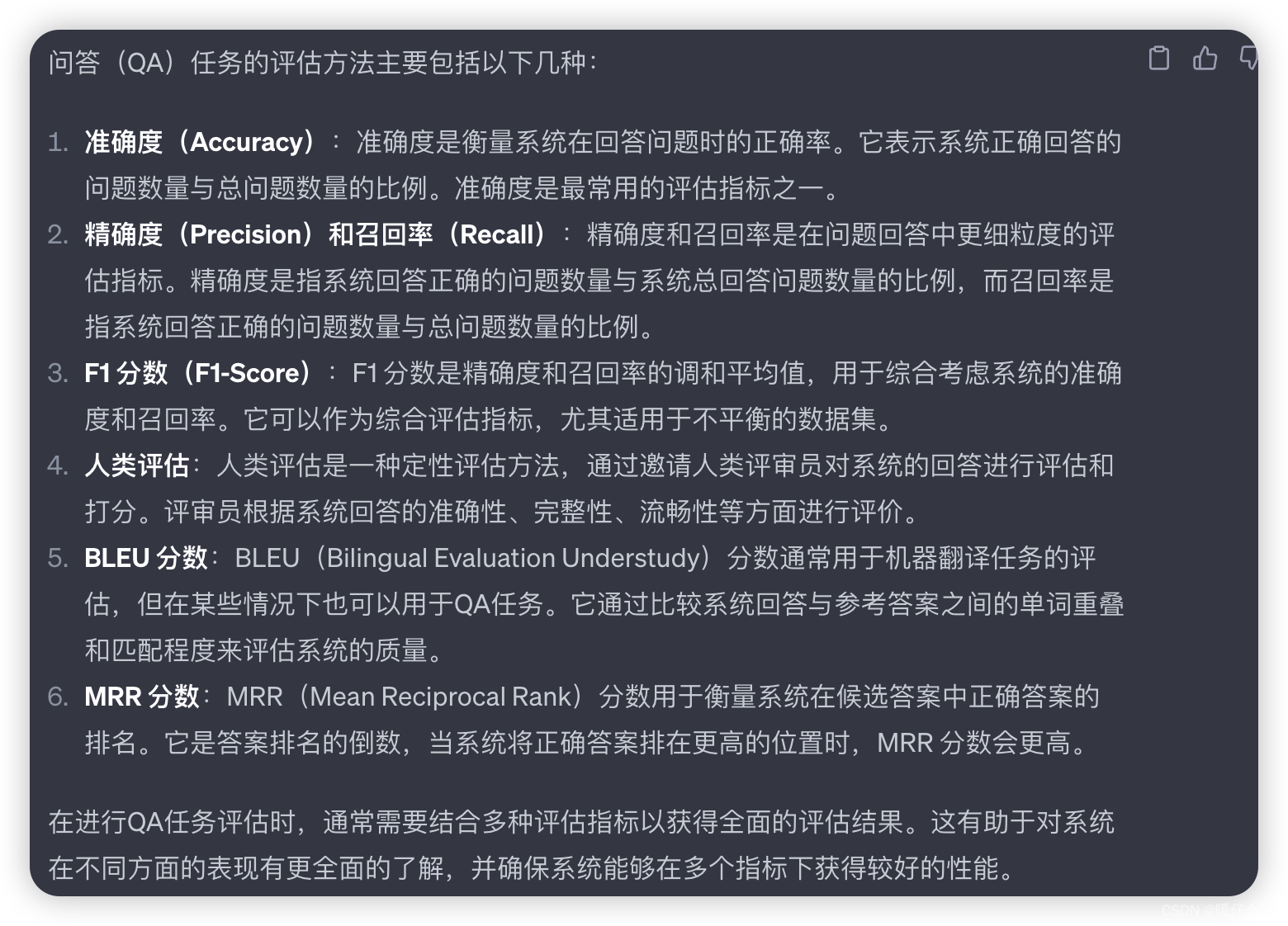

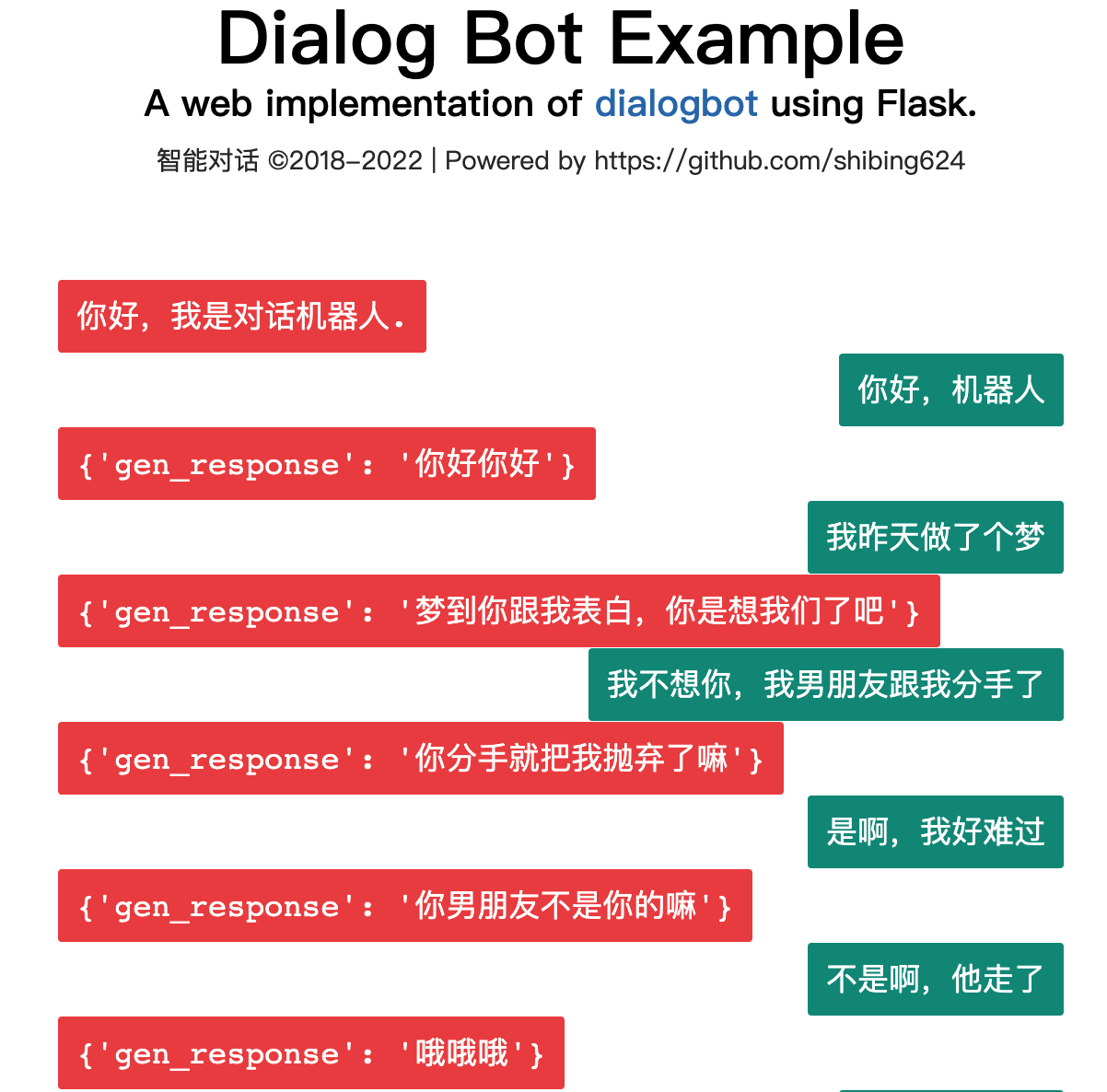

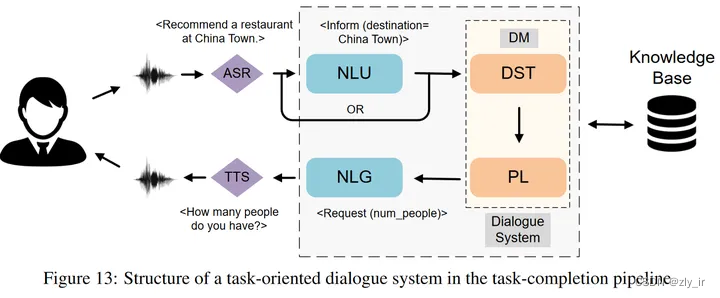

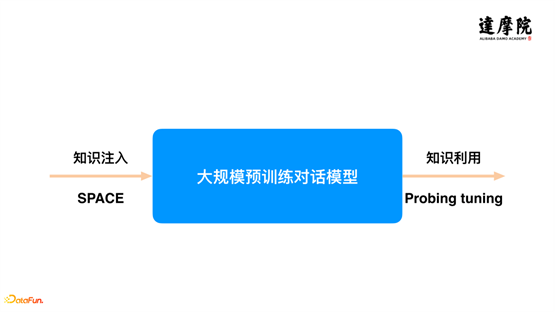

对话系统学习概述(仅够参考)

对话系统(仅够参考) 目录对话系统(仅够参考)背景类人对话系统的关键特征1、知识运用2、个性体现3、情感识别与表达数据集评价方式评价的一些指标训练模型需要的资源任务型对话系统预训练最新研究进展参考文献背景 对话系统一般包括…

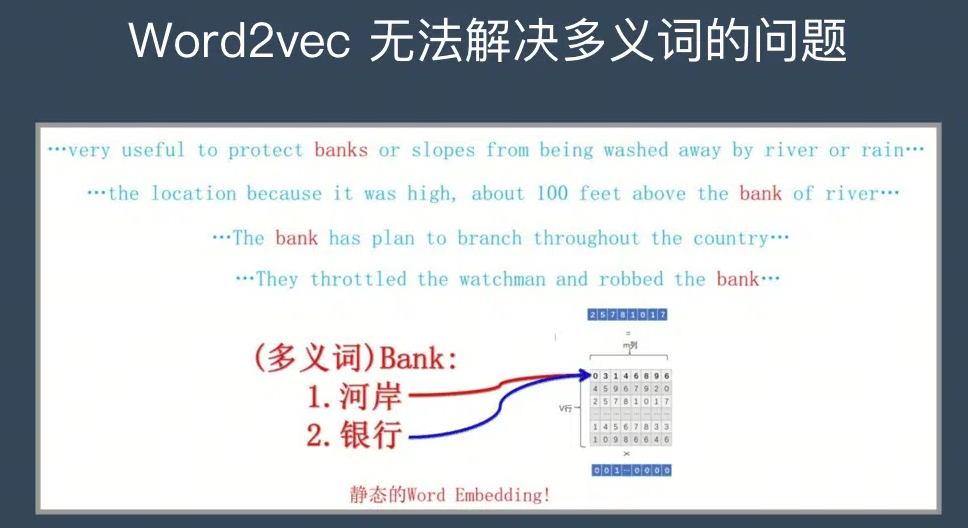

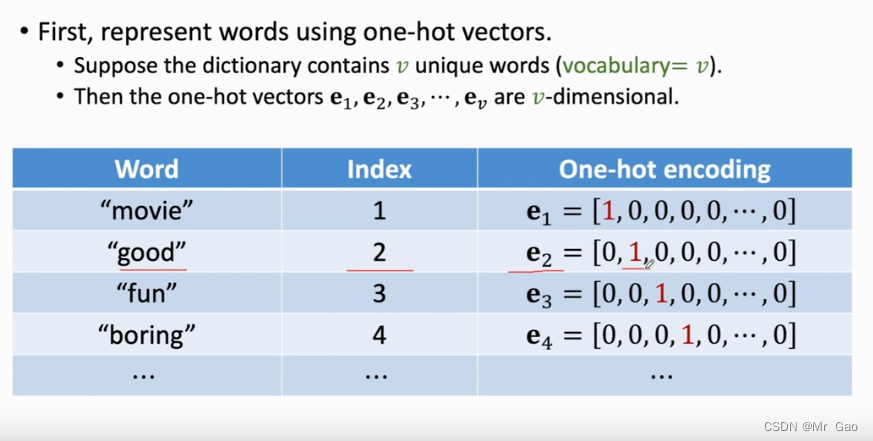

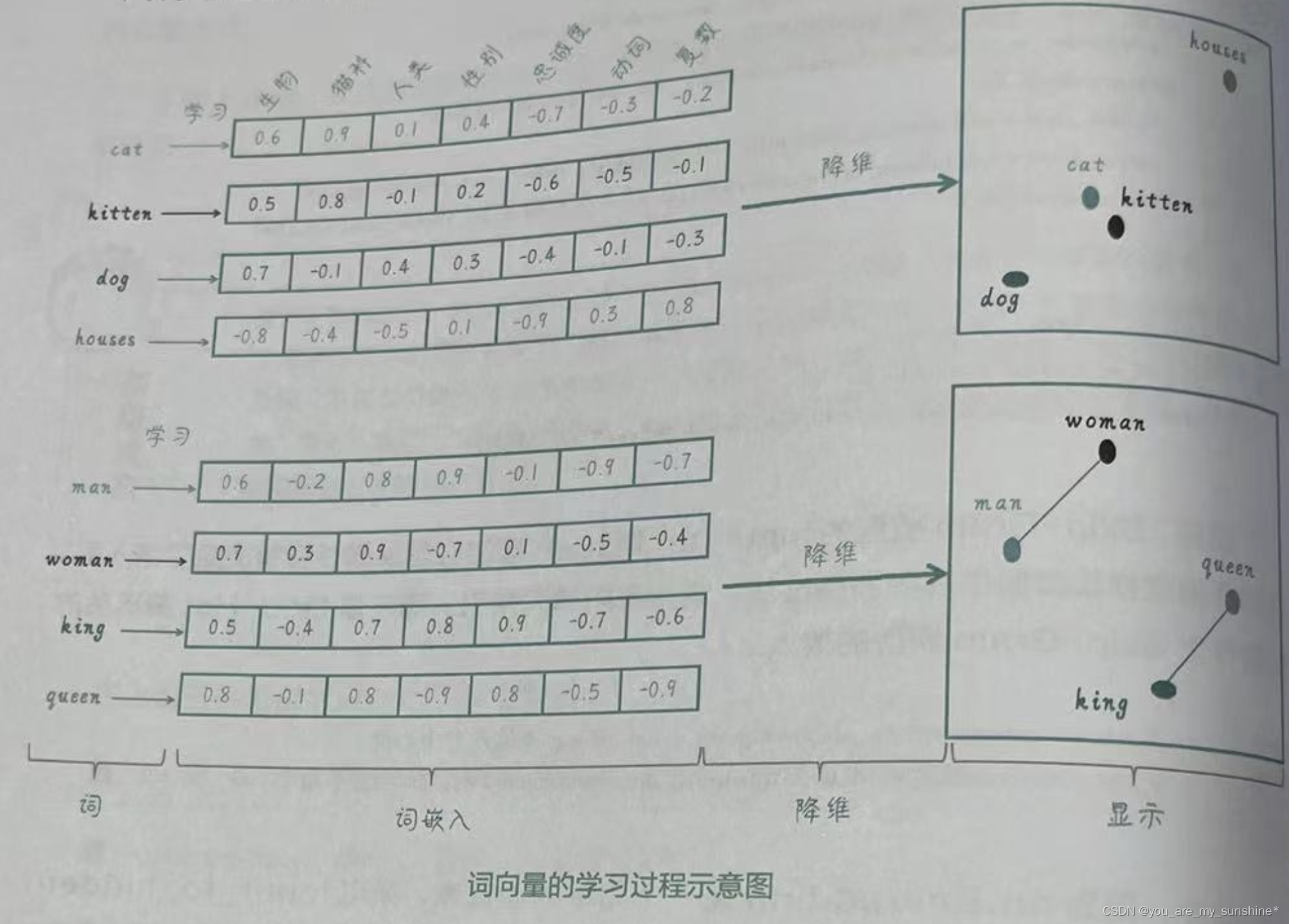

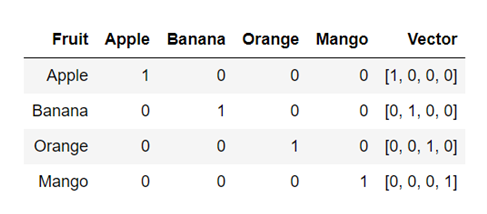

【NLP入门教程】十二、词向量简介

词向量简介

词向量(Word Embedding)是自然语言处理中常用的一种表示文本的方法,它将单词映射到一个低维实数向量空间中的向量表示。词向量的出现很大程度上解决了传统文本处理方法中的维度灾难问题,并且能够捕捉到单词之间的语义和语法关系。

1. One-Hot Encoding的问题 …

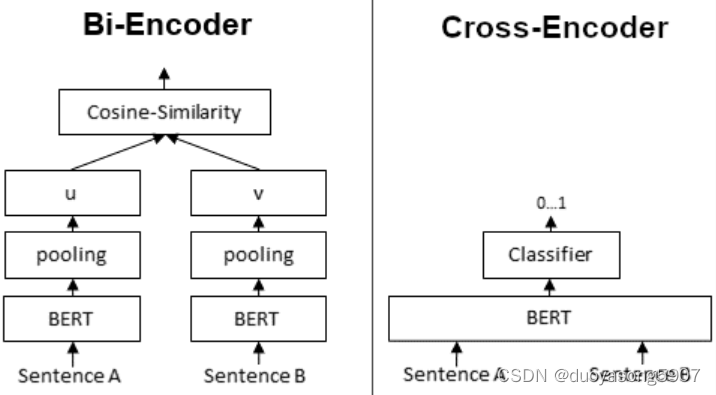

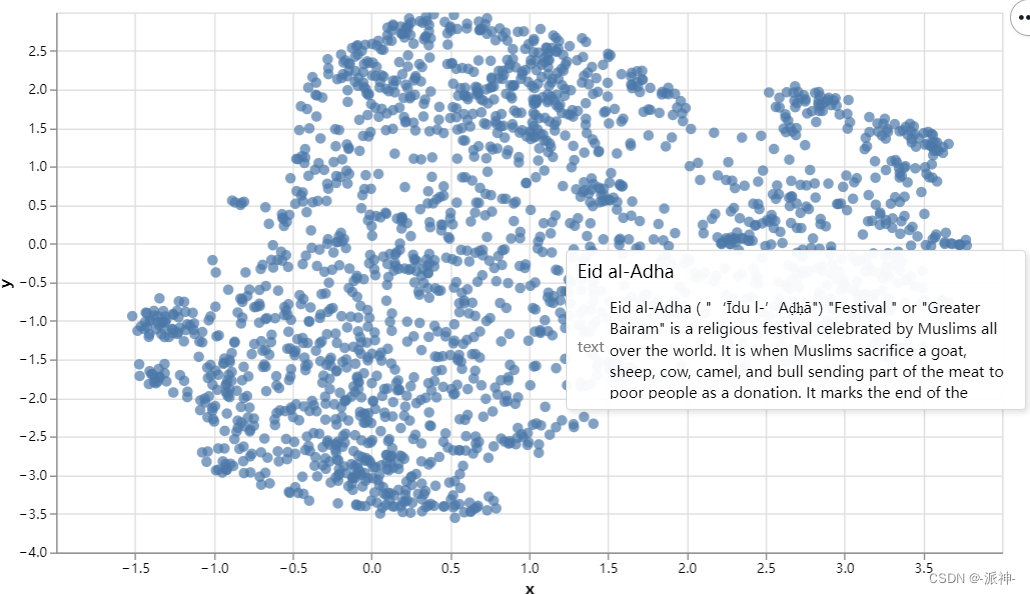

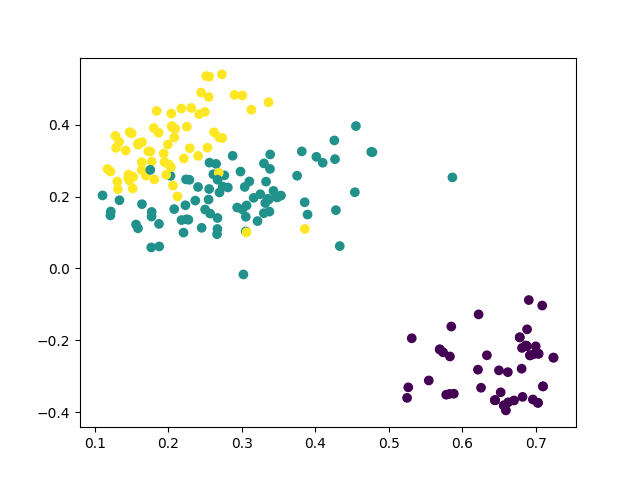

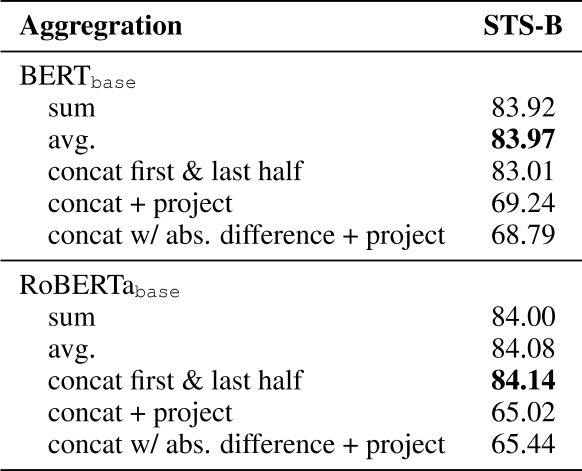

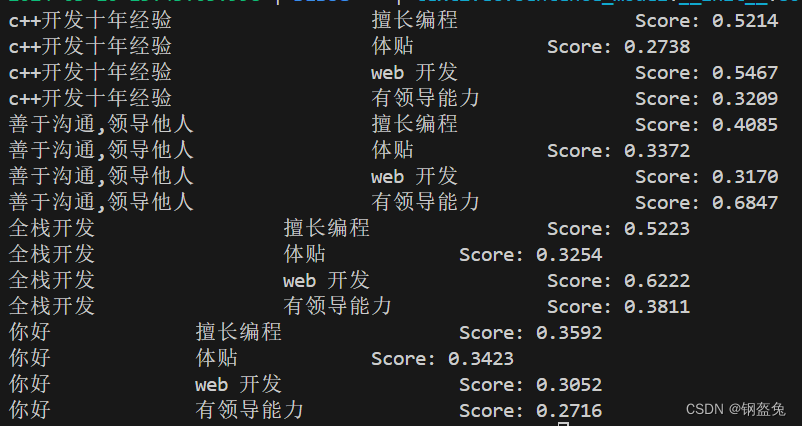

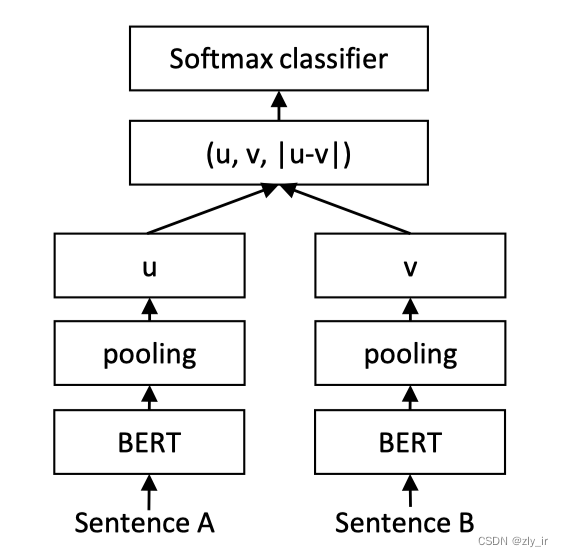

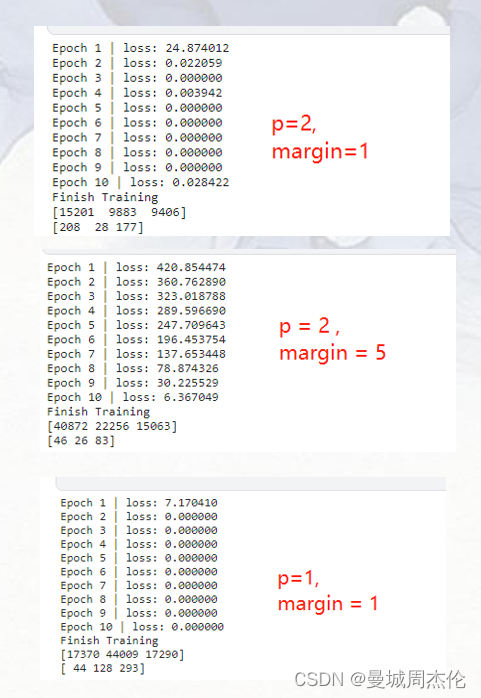

文本匹配模型实验报告-text2vec

文本匹配模型实验报告-text2vec

尽管基于BERT的模型在NLP诸多下游任务中取得了成功,直接从BERT导出的句向量表示往往被约束在一个很小的区域内,表现出很高的相似度,因而难以直接用于文本语义匹配。为解决BERT原生句子表示这种“坍缩”现象&a…

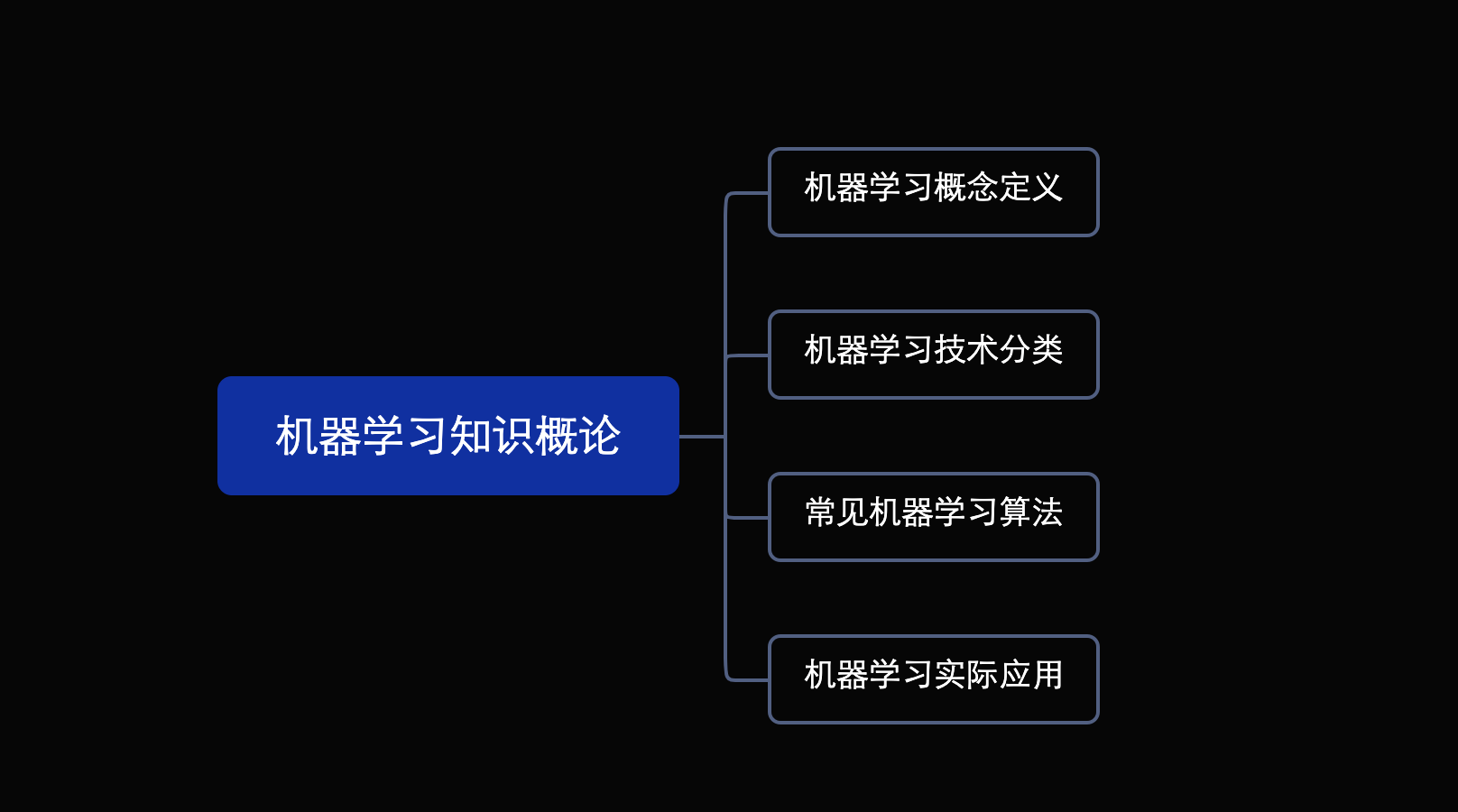

《西瓜书读书笔记》-第1章 概述

目录

1.机器学习概述

1.1.人工智能与机器学习

1.2.机器学习分类

1.按照算法分类

2.按照学习任务分类

1.3.机器学习应用

1.4.机器学习常用术语解释 1.机器学习概述

1.1.人工智能与机器学习

人工智能(Artificial Intelligence,Al)是一…

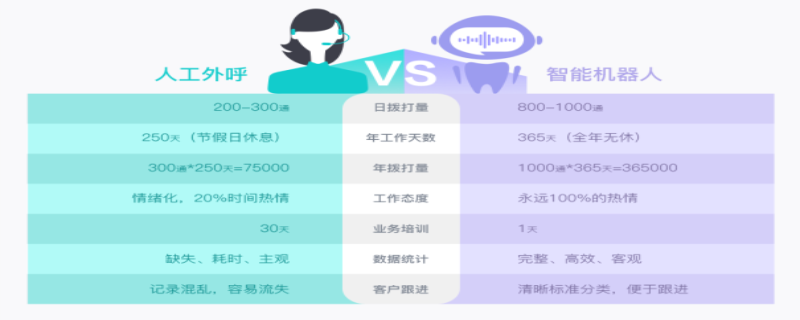

未经解码的语音数据犹如黑盒,同时是非结构化的

这时,他们需要通过分析手中已有的数据,来找到拯救萎靡业绩的方案。而回顾已有数据,企业的唯一法宝,是保存了大量的沟通语音或文本数据。 对于计算机来说,未经解码的语音数据犹如黑盒,同时是非结构化的。…

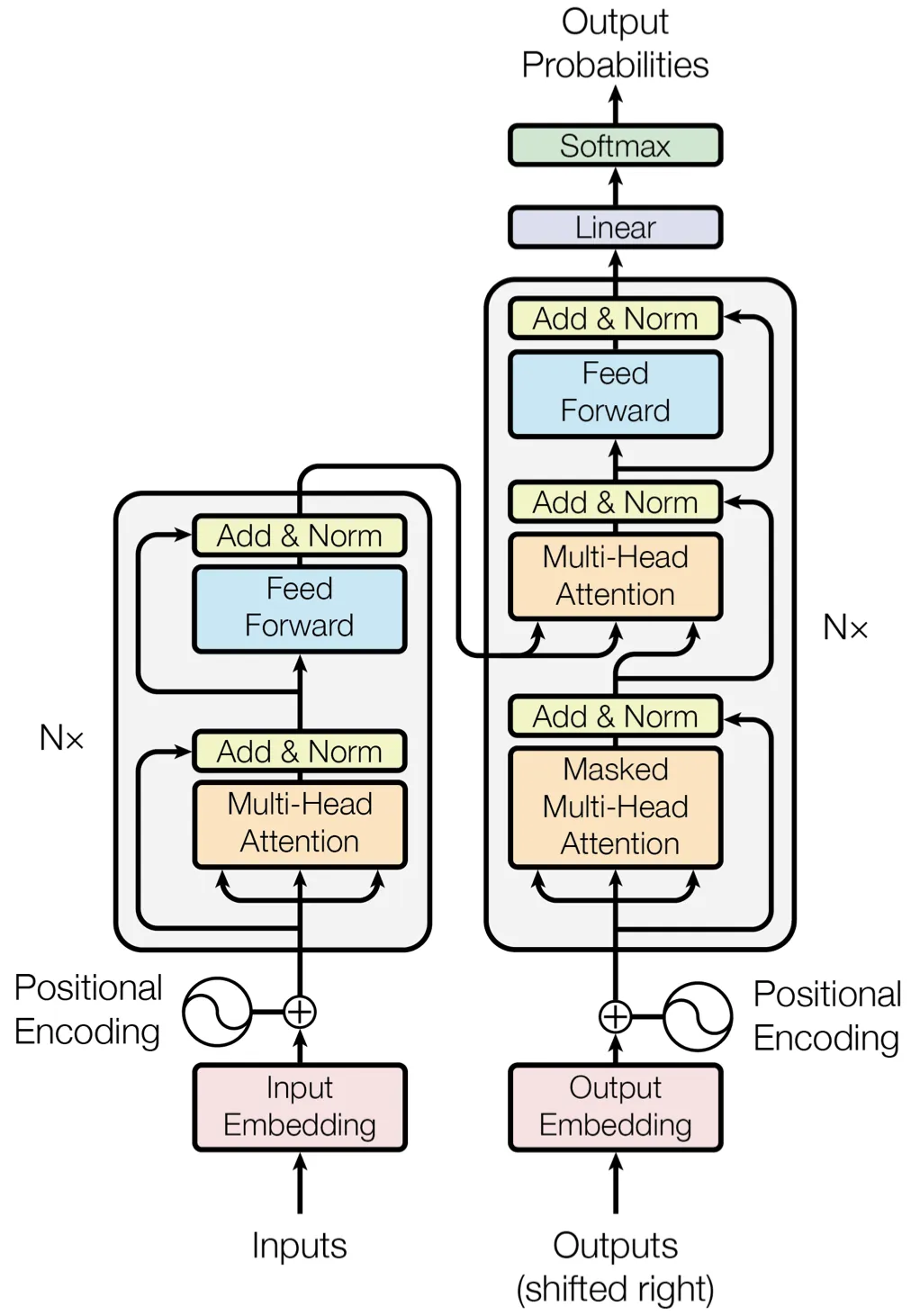

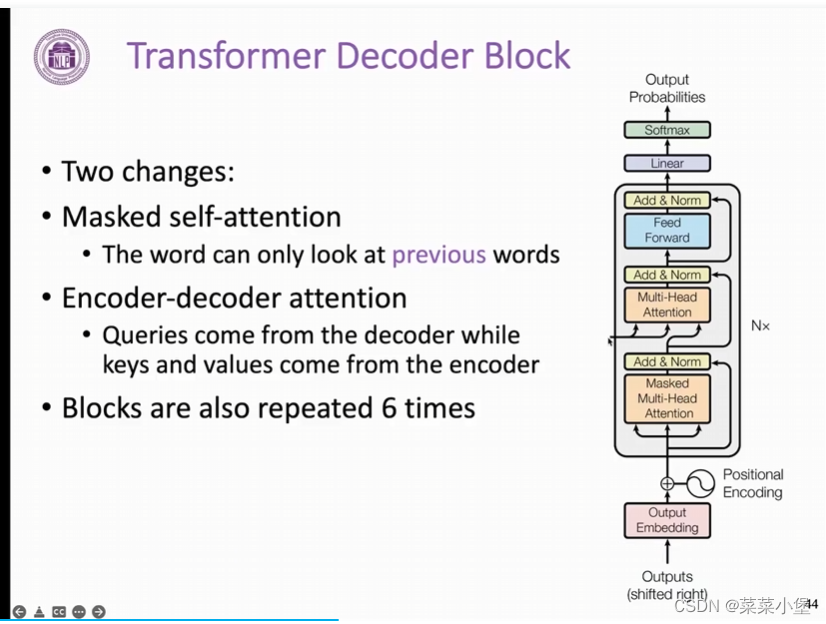

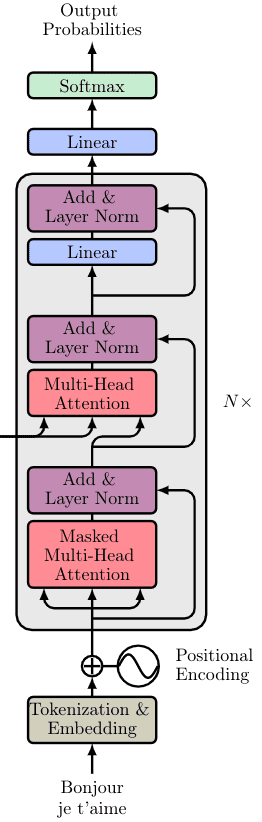

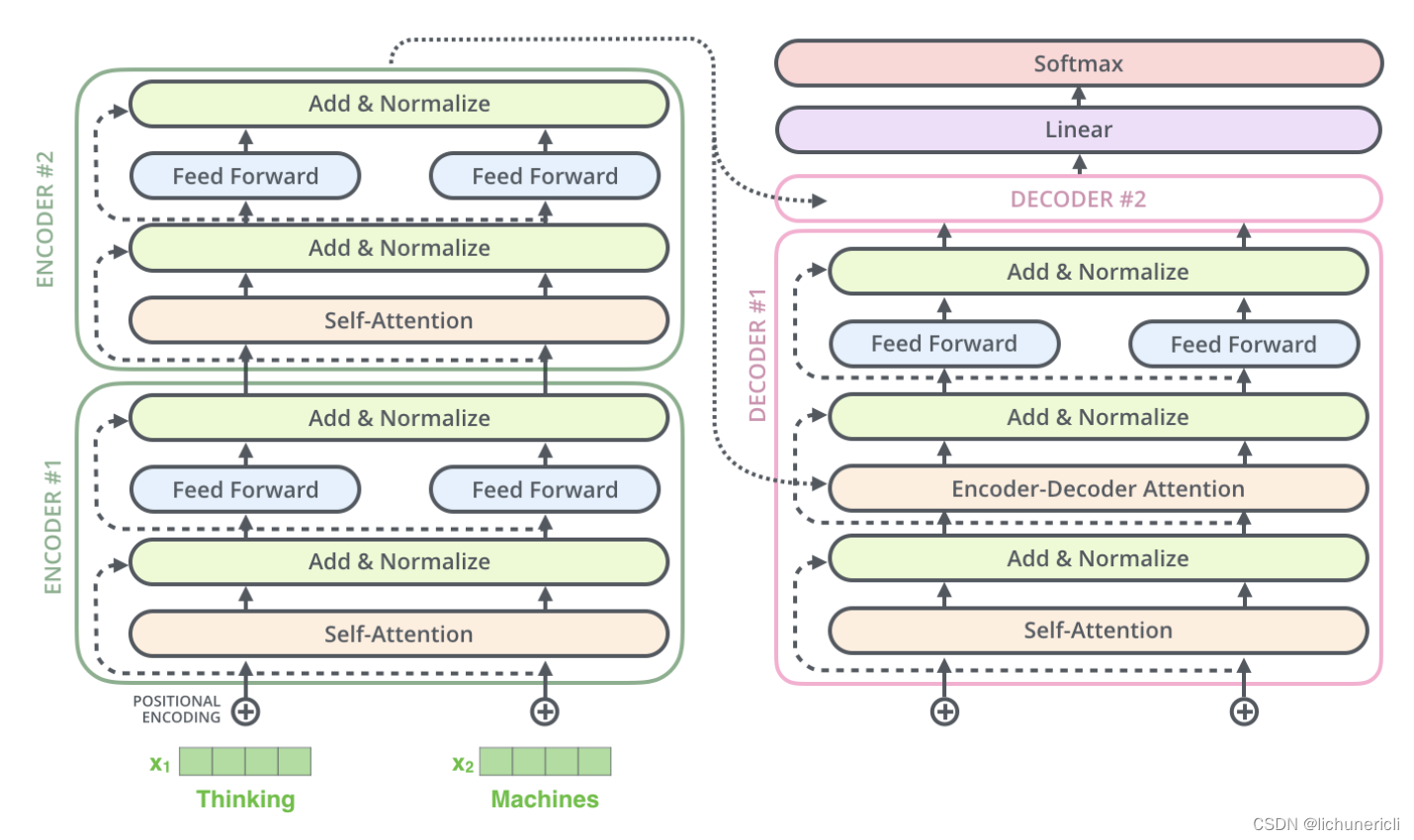

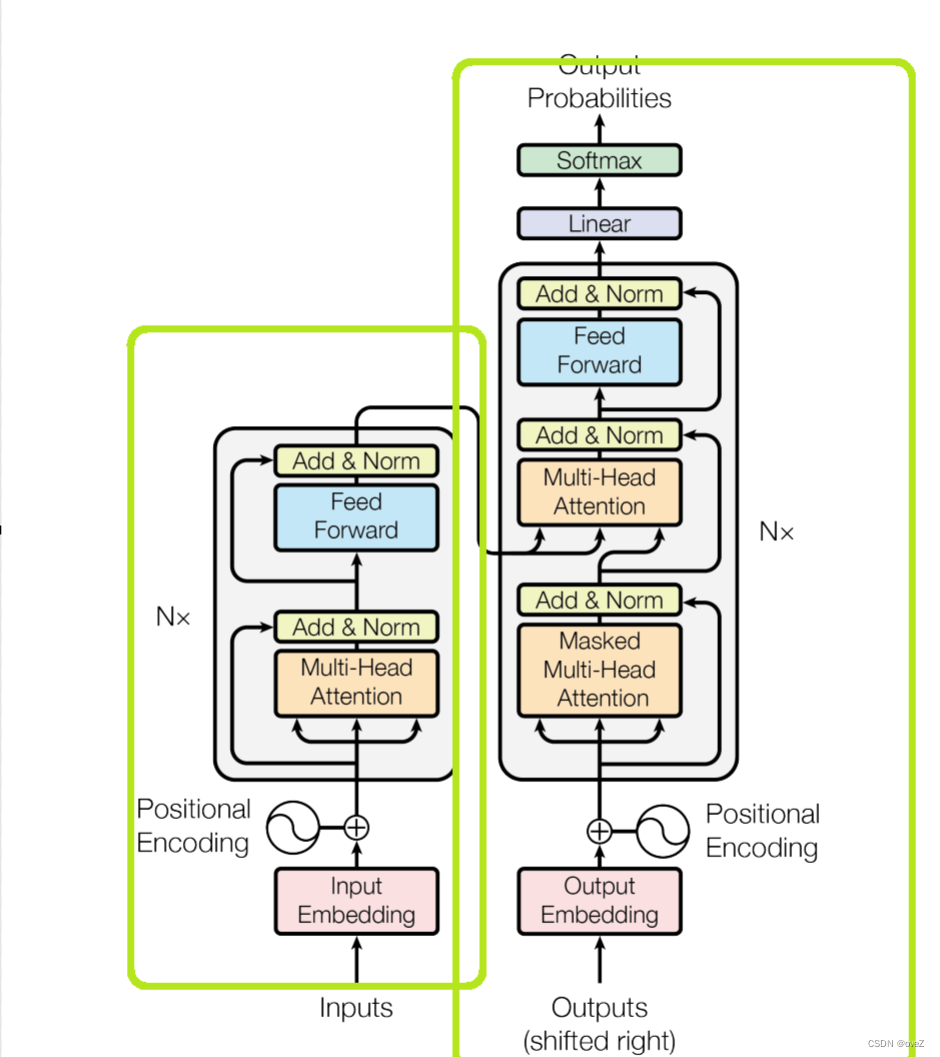

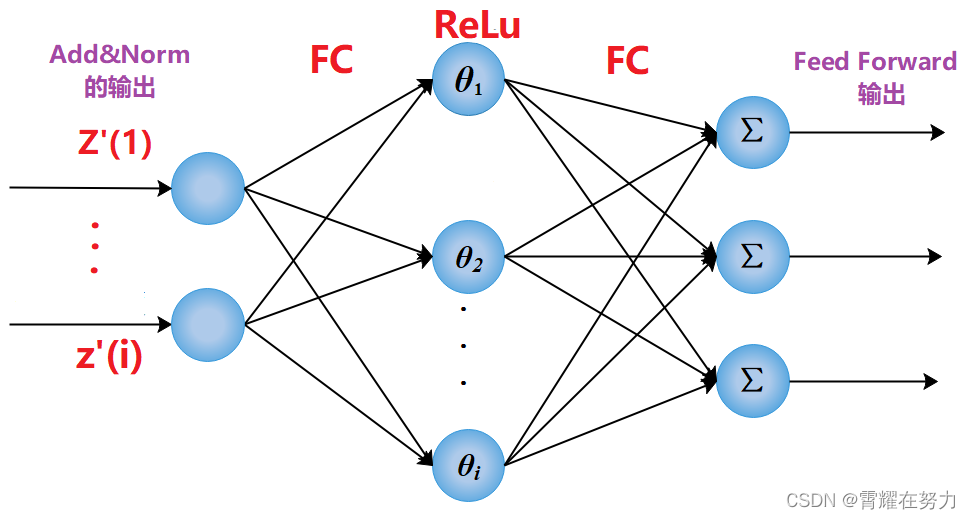

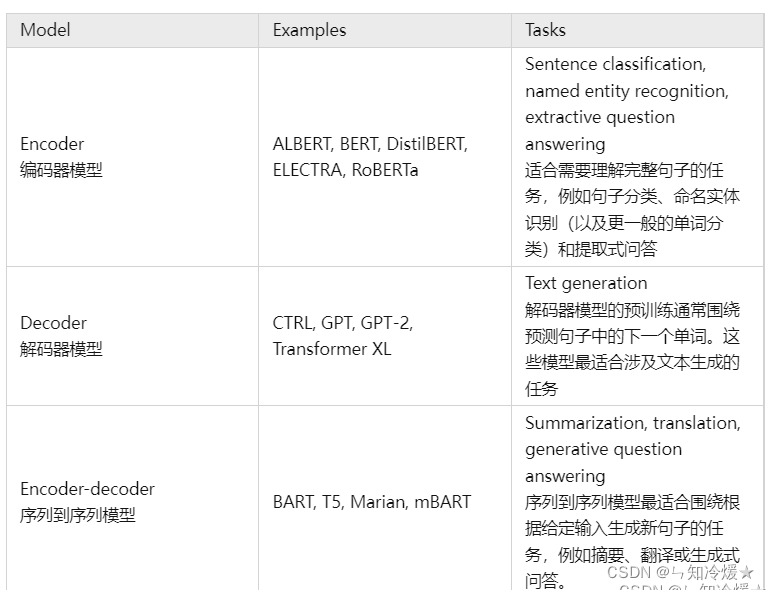

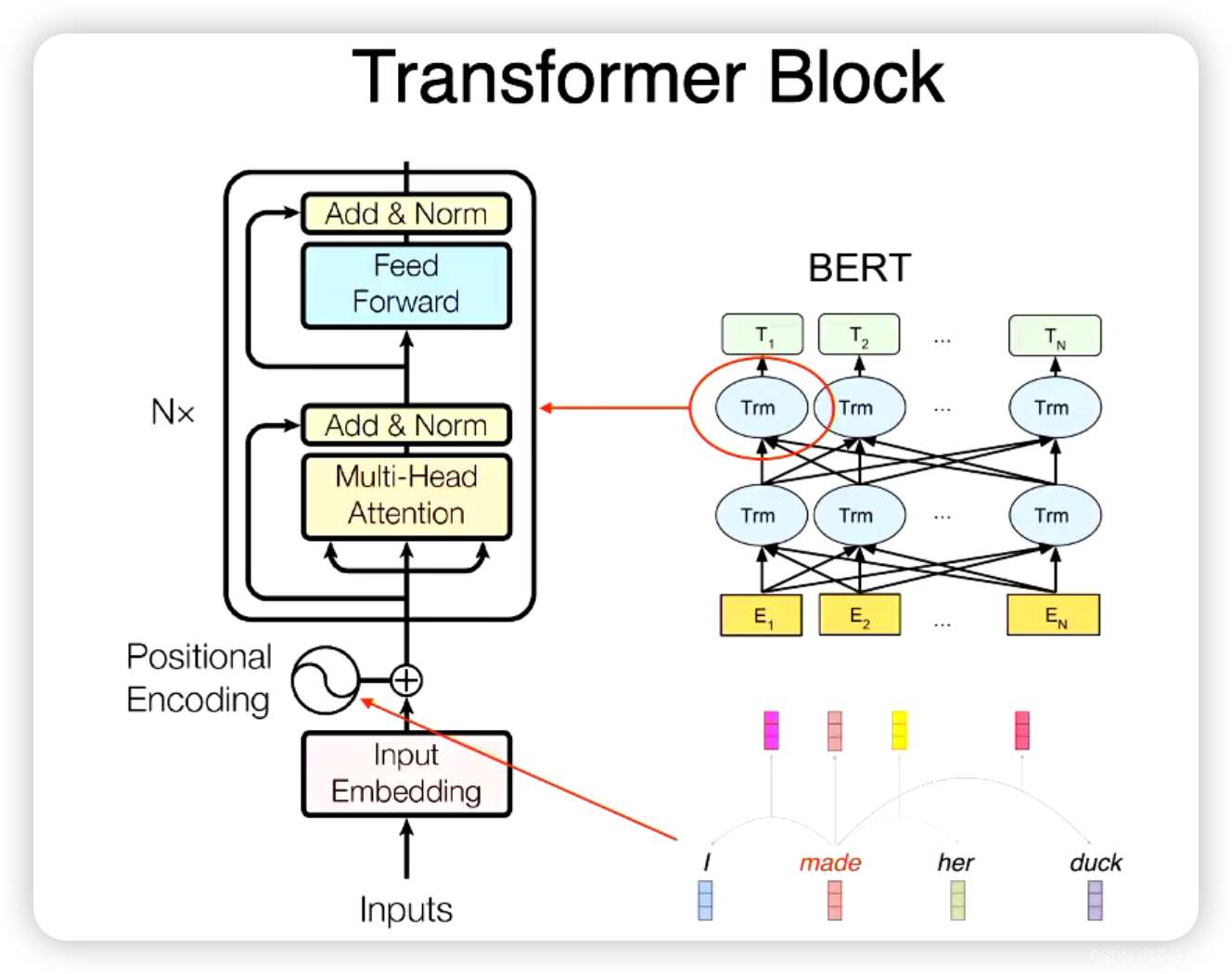

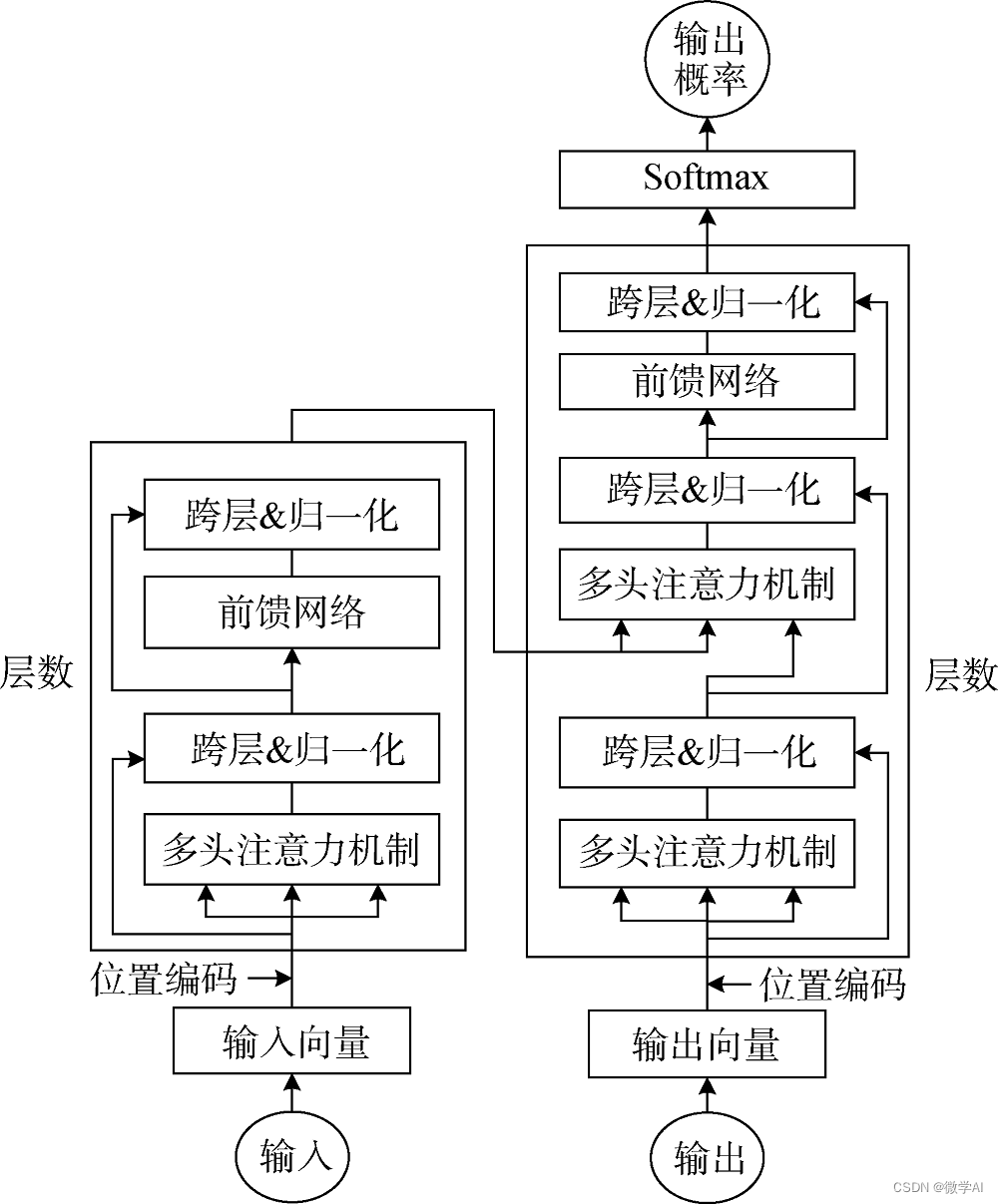

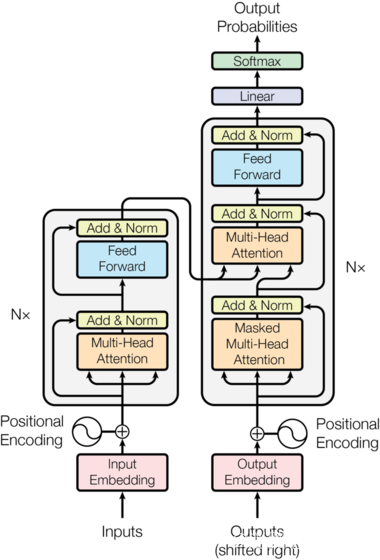

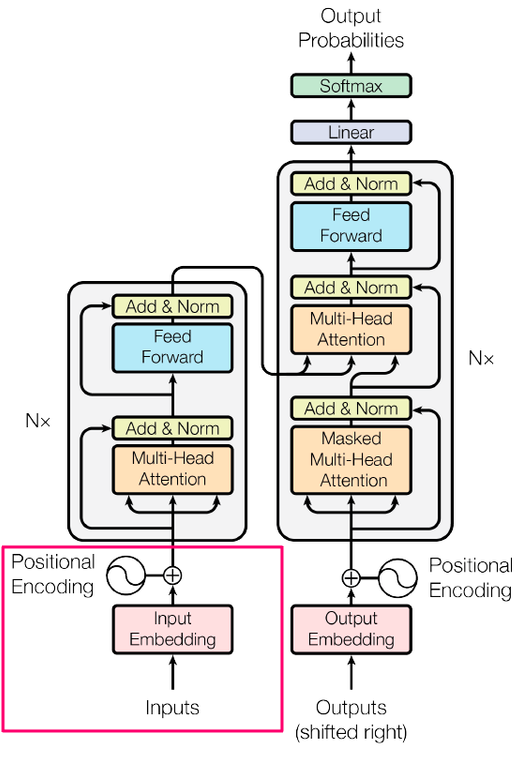

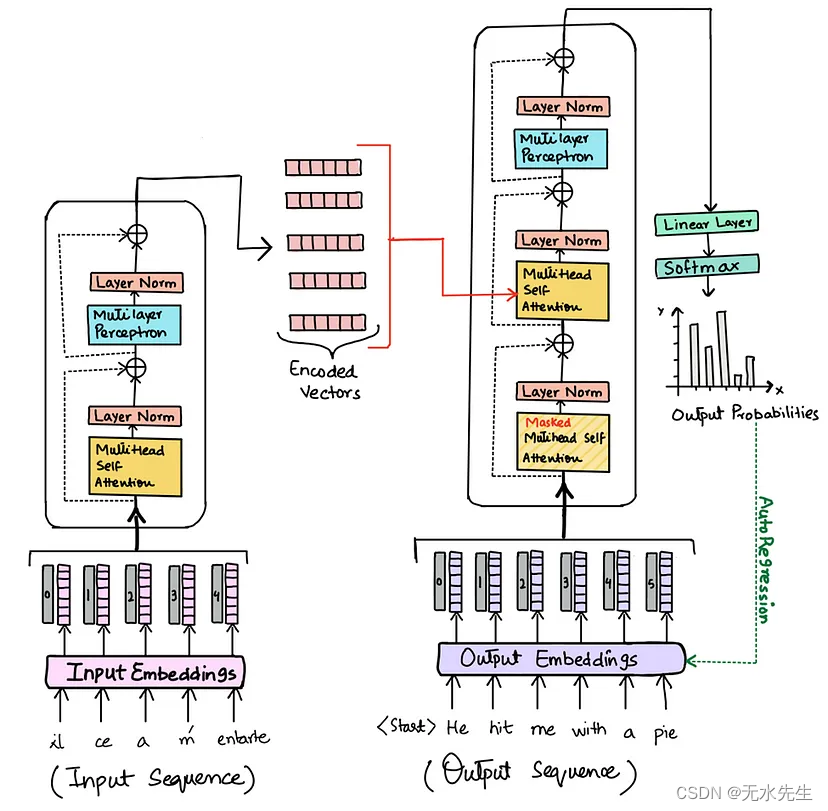

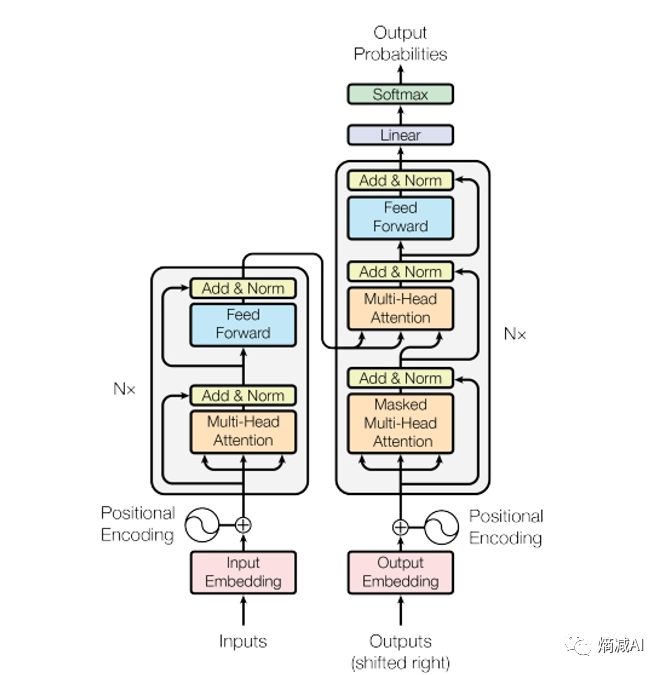

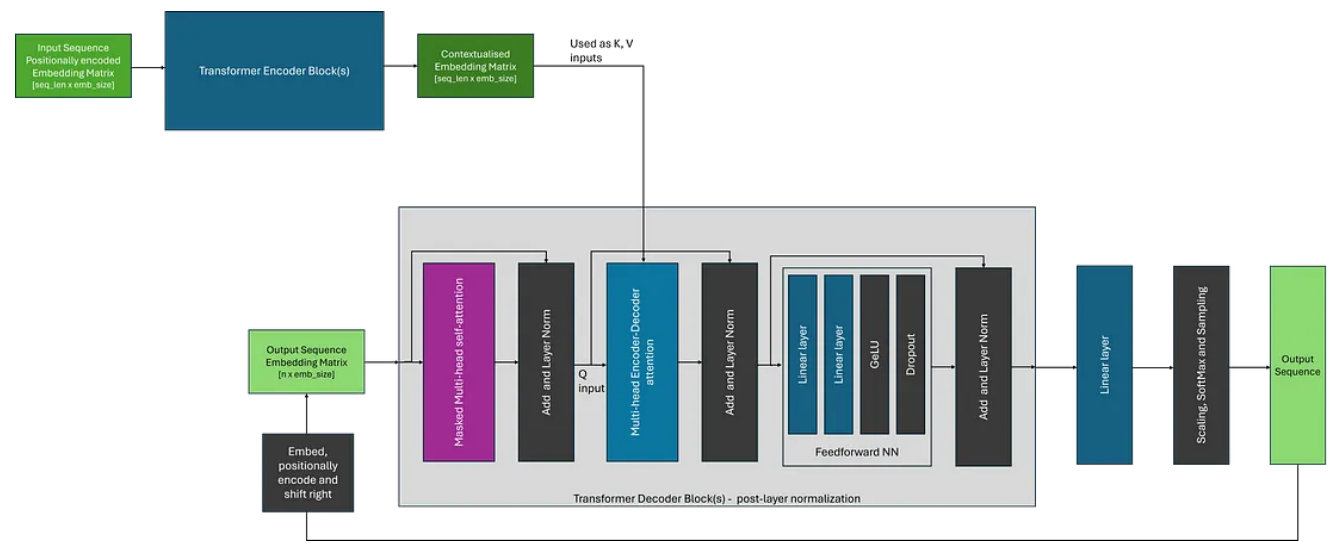

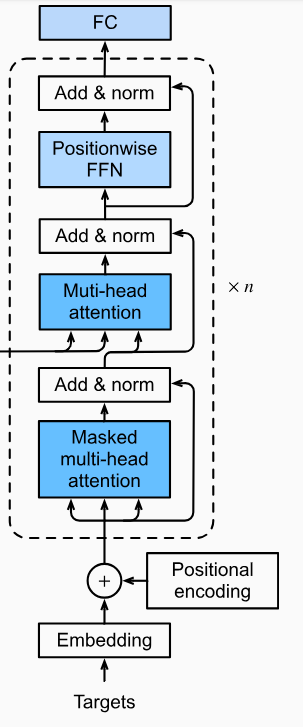

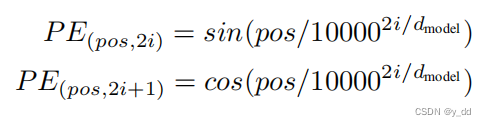

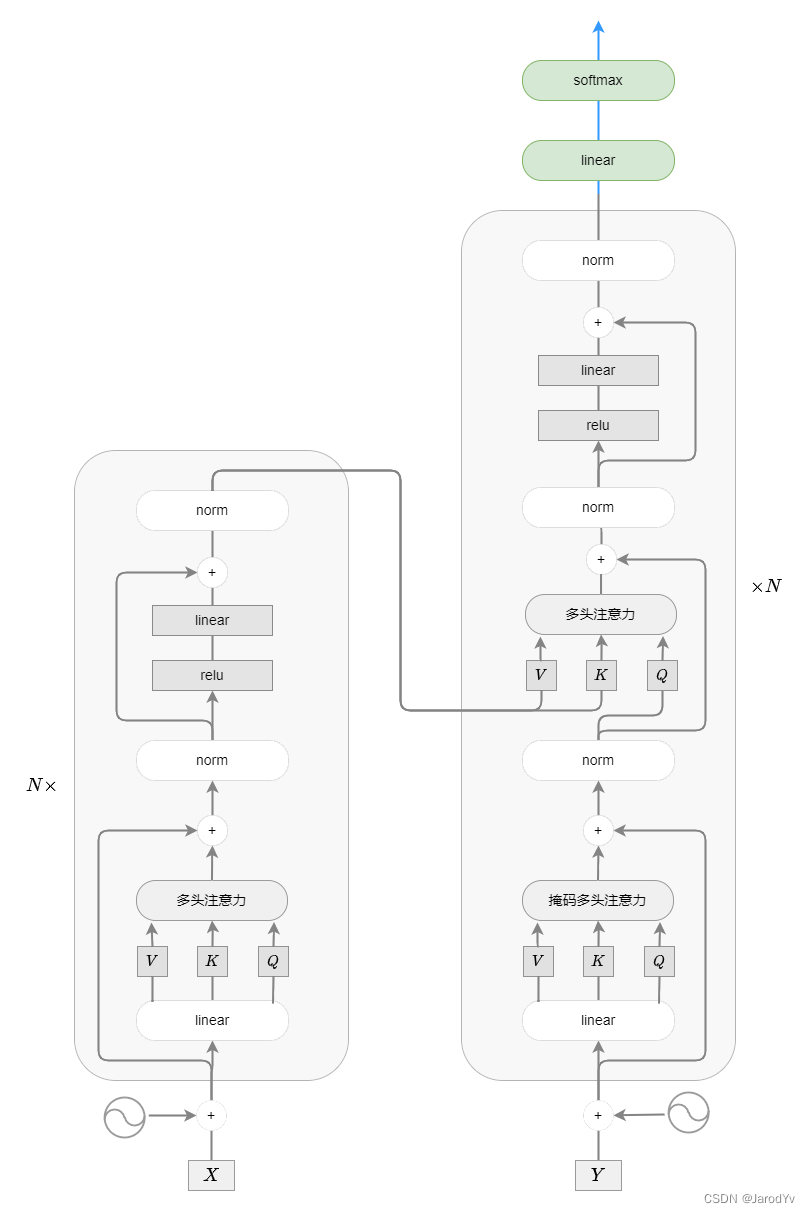

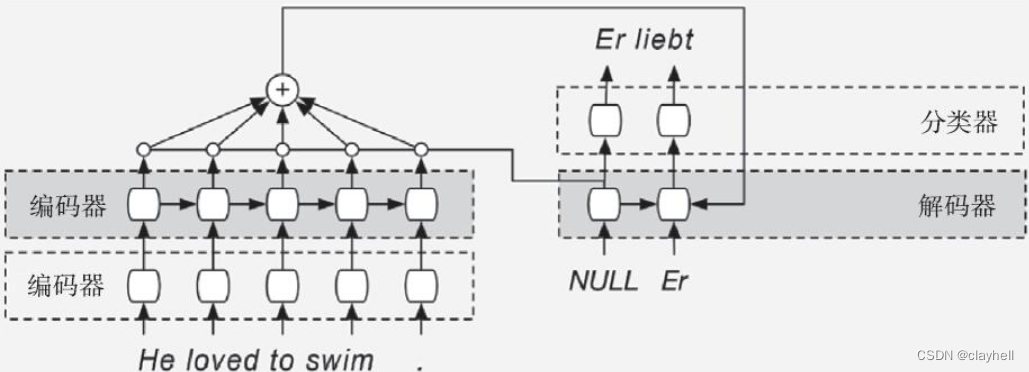

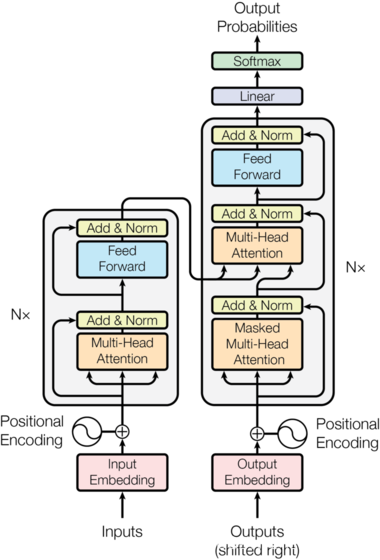

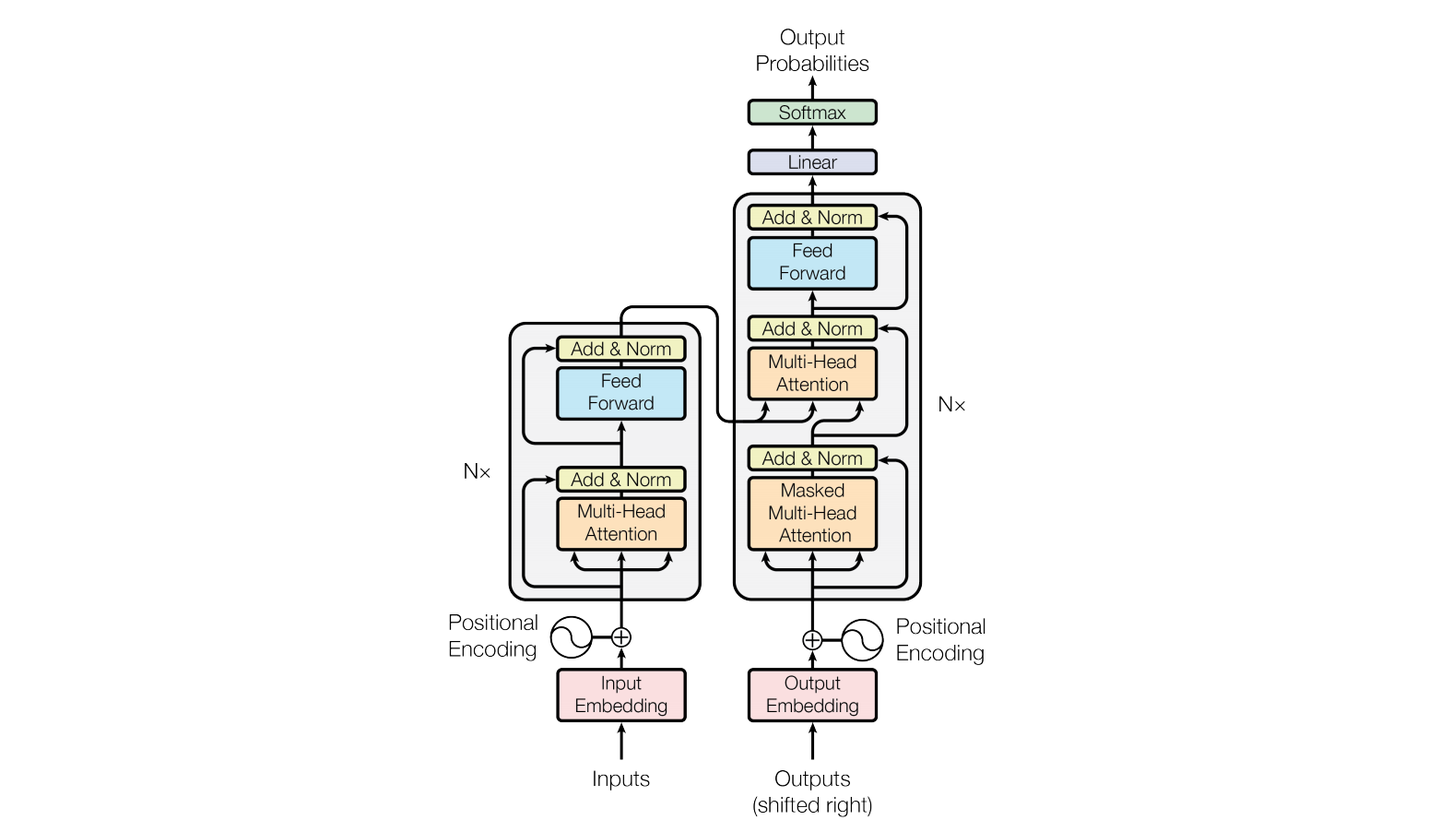

【nlp】3.1 Transformer背景介绍及架构

Transformer背景介绍 1 Transformer的诞生2 Transformer的优势3 Transformer的市场4 Transformer架构4.1 Transformer模型的作用4.2 Transformer总体架构图4.2.1 输入部分4.2.2 输出部分包含4.2.3 编码器部分4.2.4 解码器部分1 Transformer的诞生

2018年10月,Google发出一篇论…

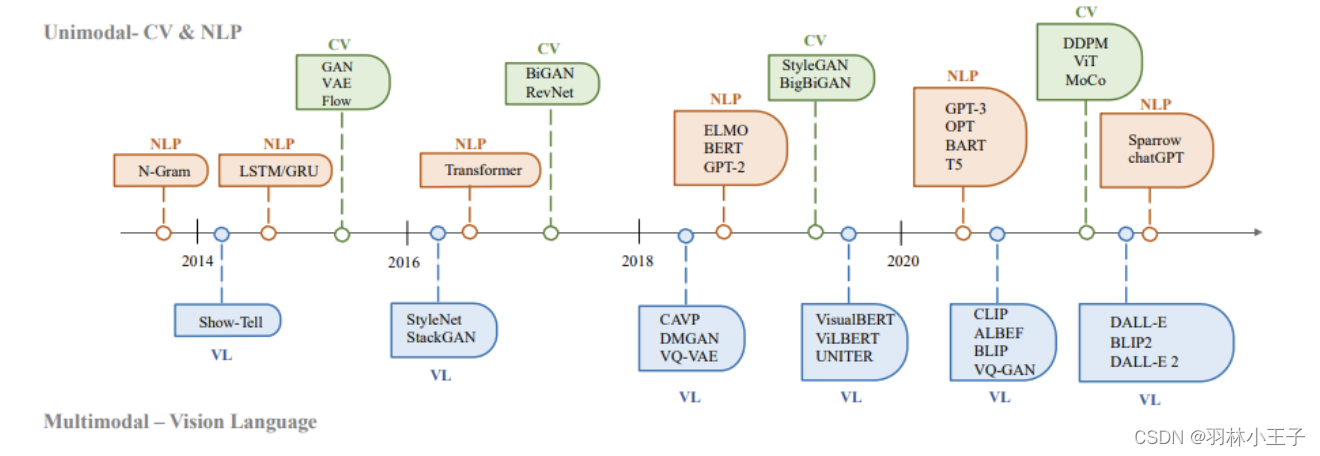

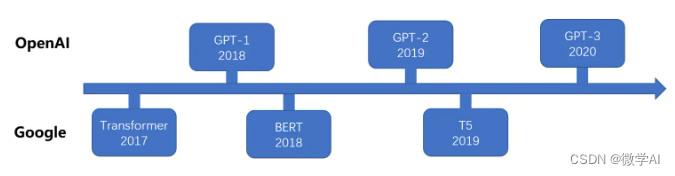

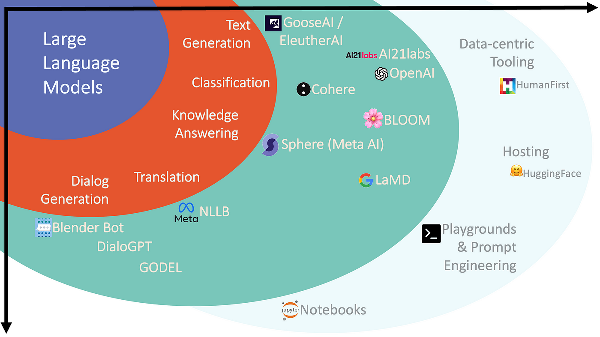

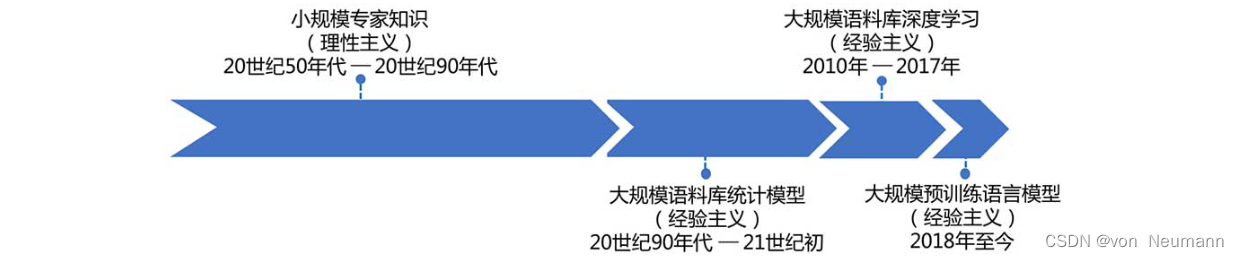

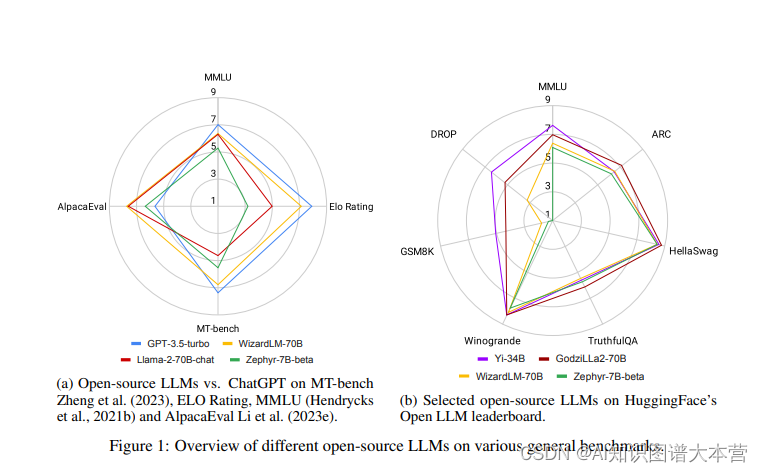

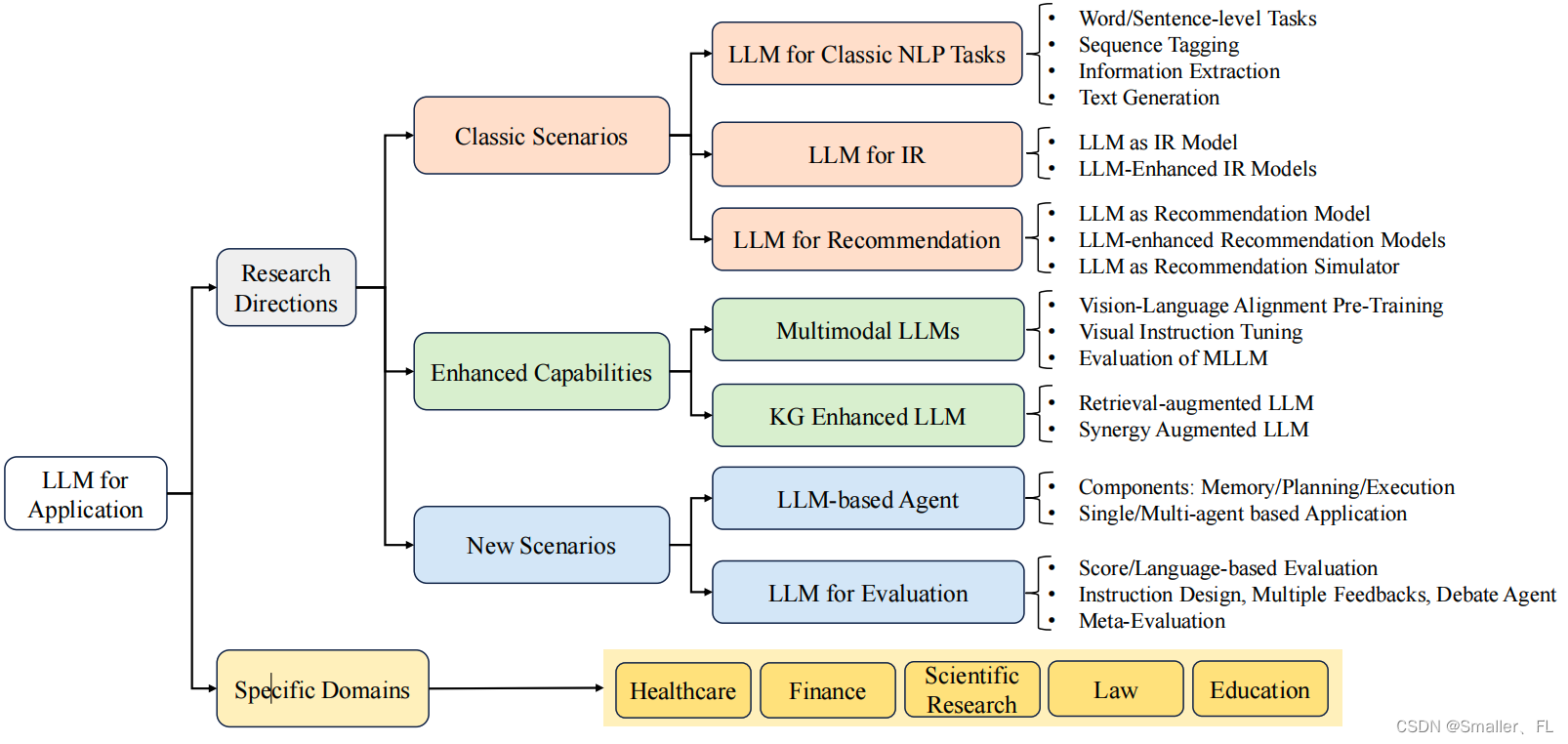

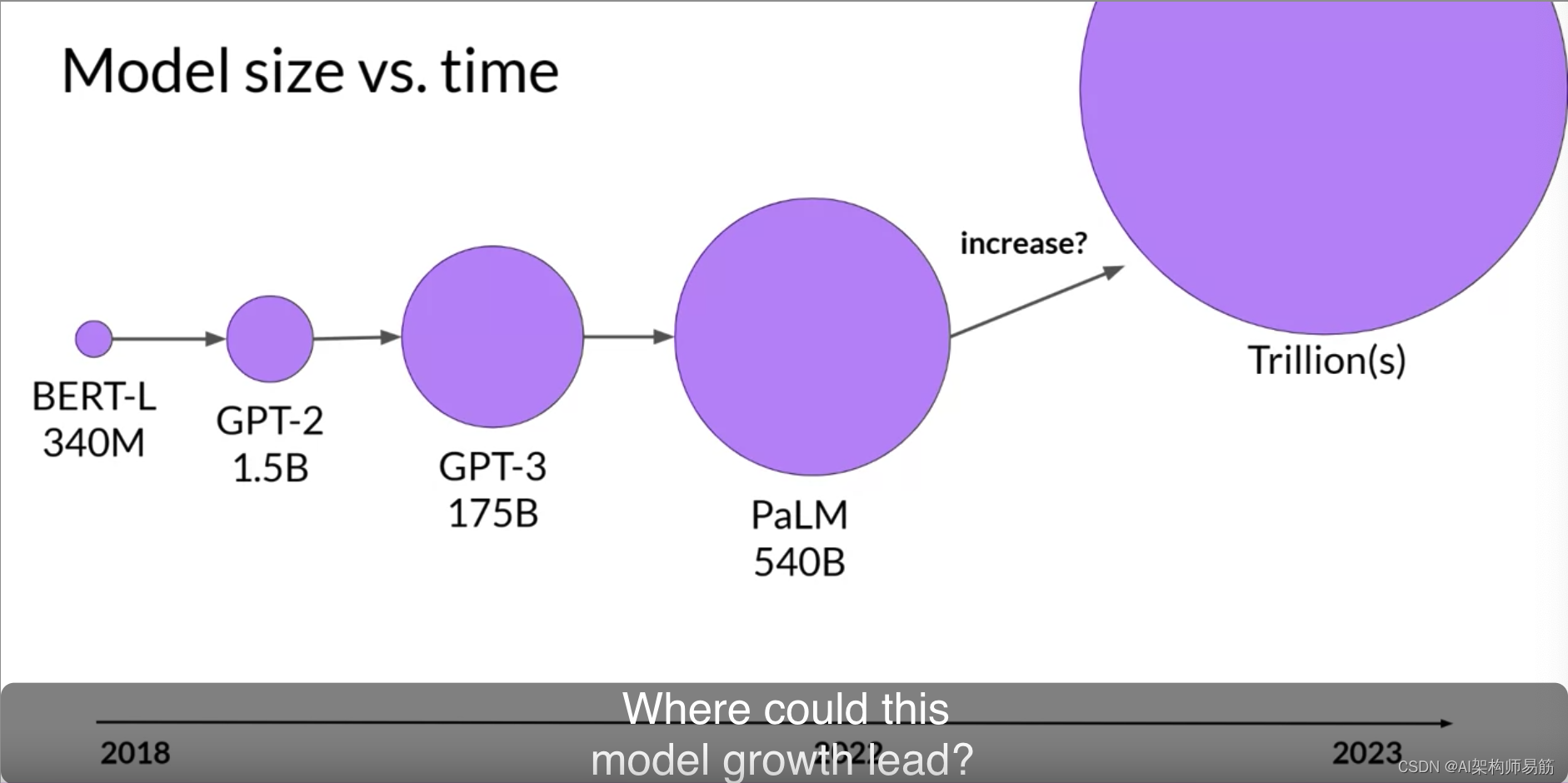

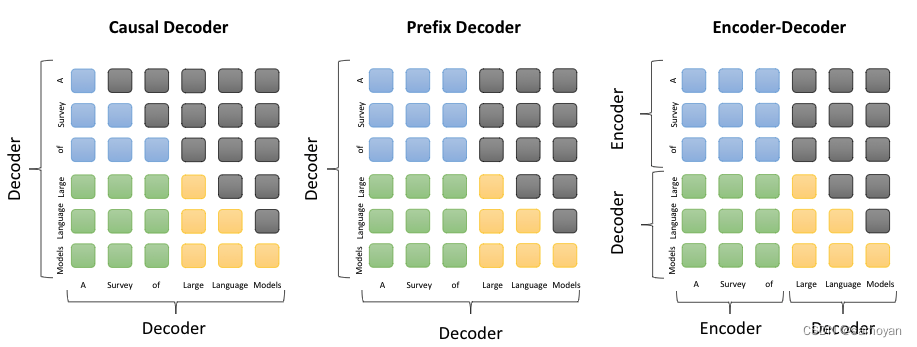

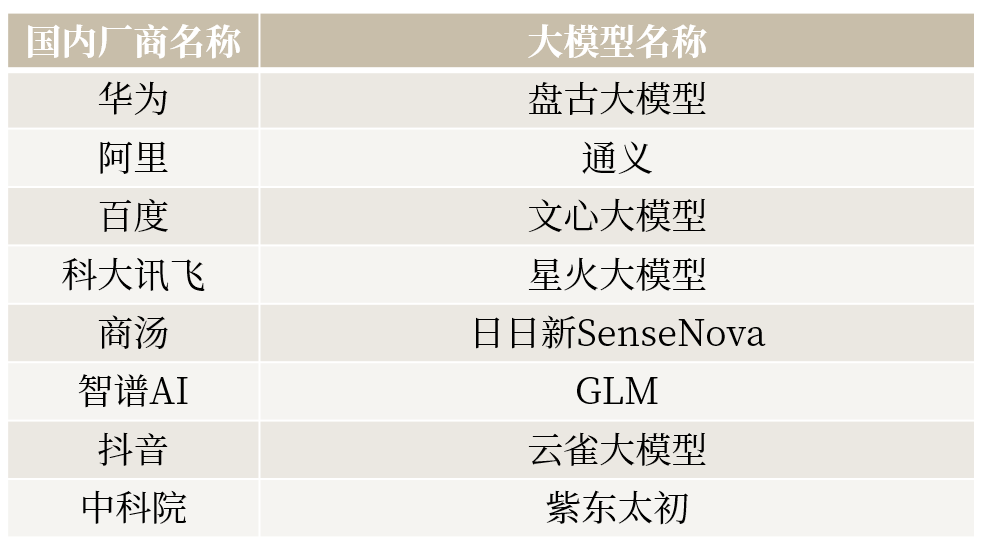

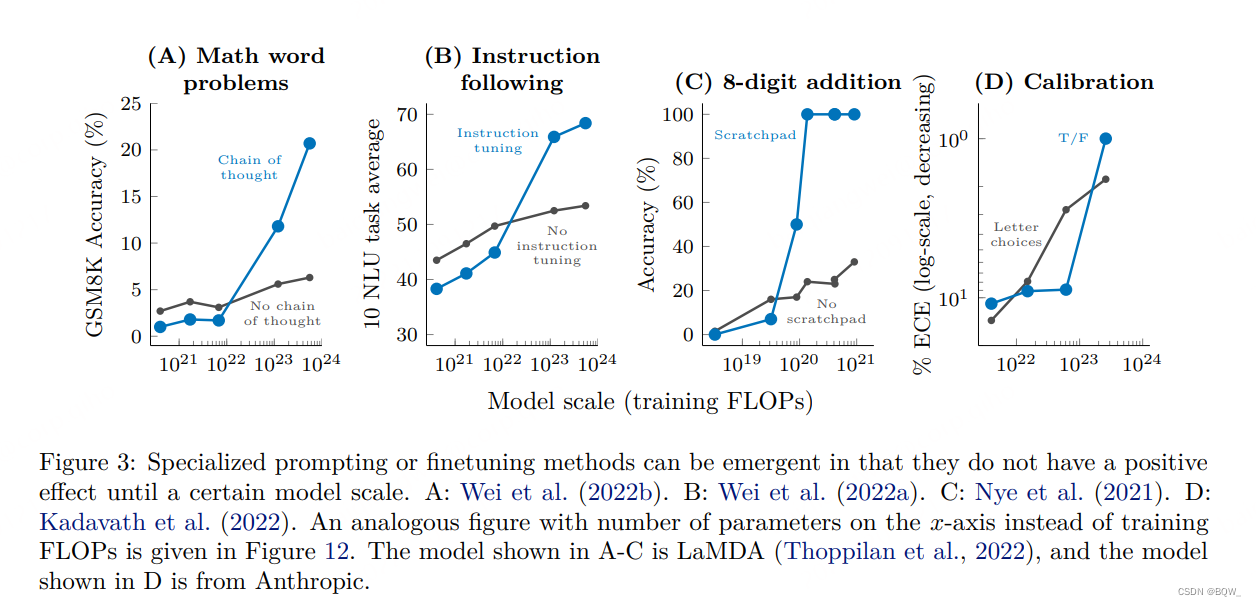

大语言模型研究进展综述

1、历史 自20世纪50年代图灵测试被提出以来,研究人员一直在探索和开发能够理解并掌握语言的人工智能技术。作为重要的研究方向之一,语言模型得到了学术界的广泛研究,从早期的统计语言模型和神经语言模型开始,发展到基于Transforme…

java实现NER模型识别问题中的实体

代码如下:

String question "飞毛腿hw4x精品电池适用于哪些机型?";//1、NER模型识别问题中的实体List<String> list1 com.colorbin.rpa.c_magic_ai.c02_nlp.nlpUtil.getPerson(new String[]{question});List<String> list2 co…

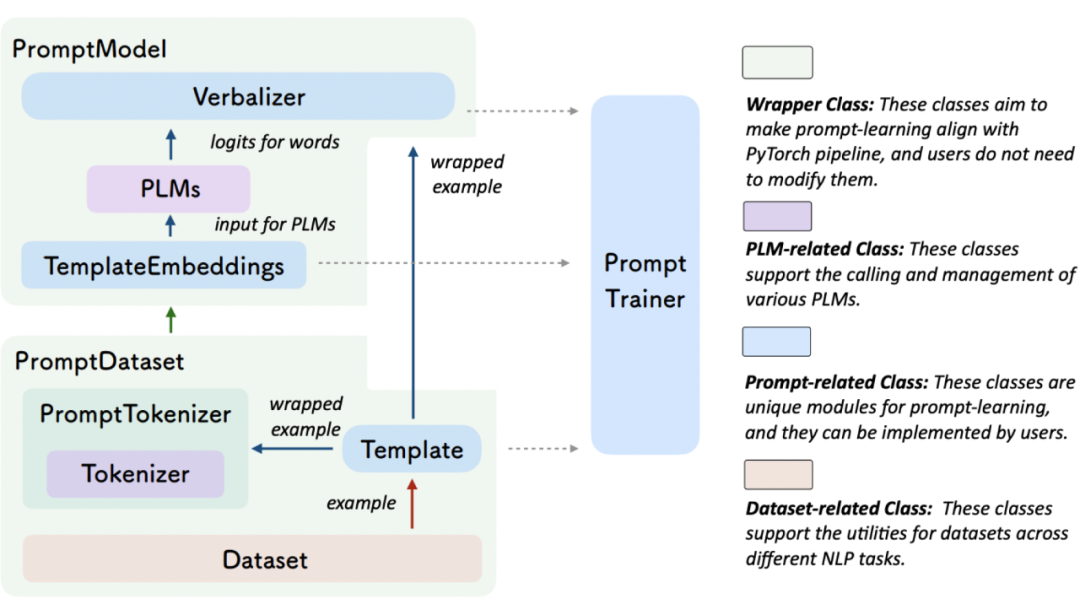

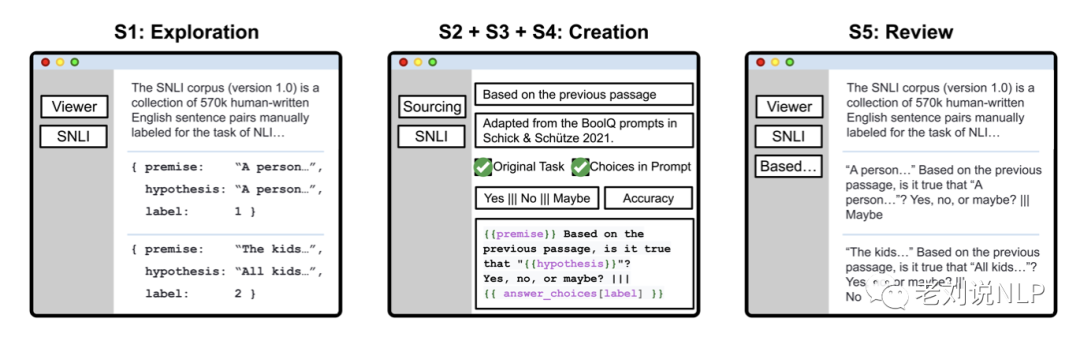

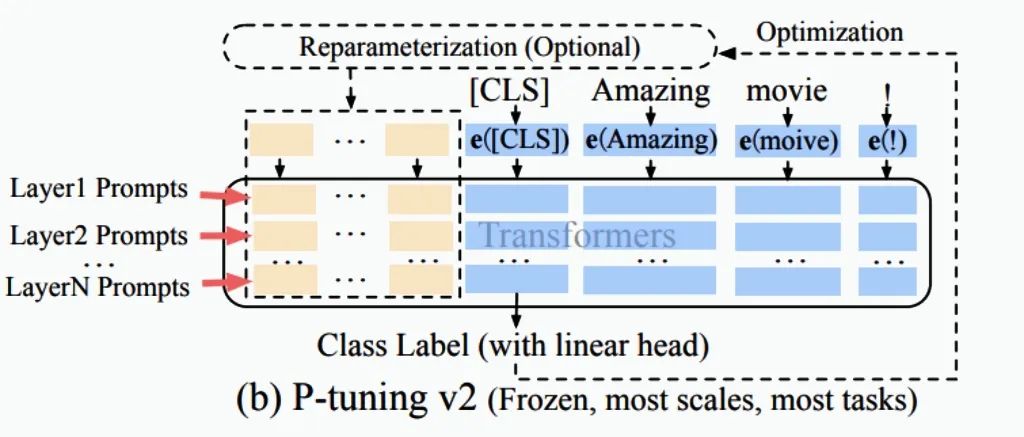

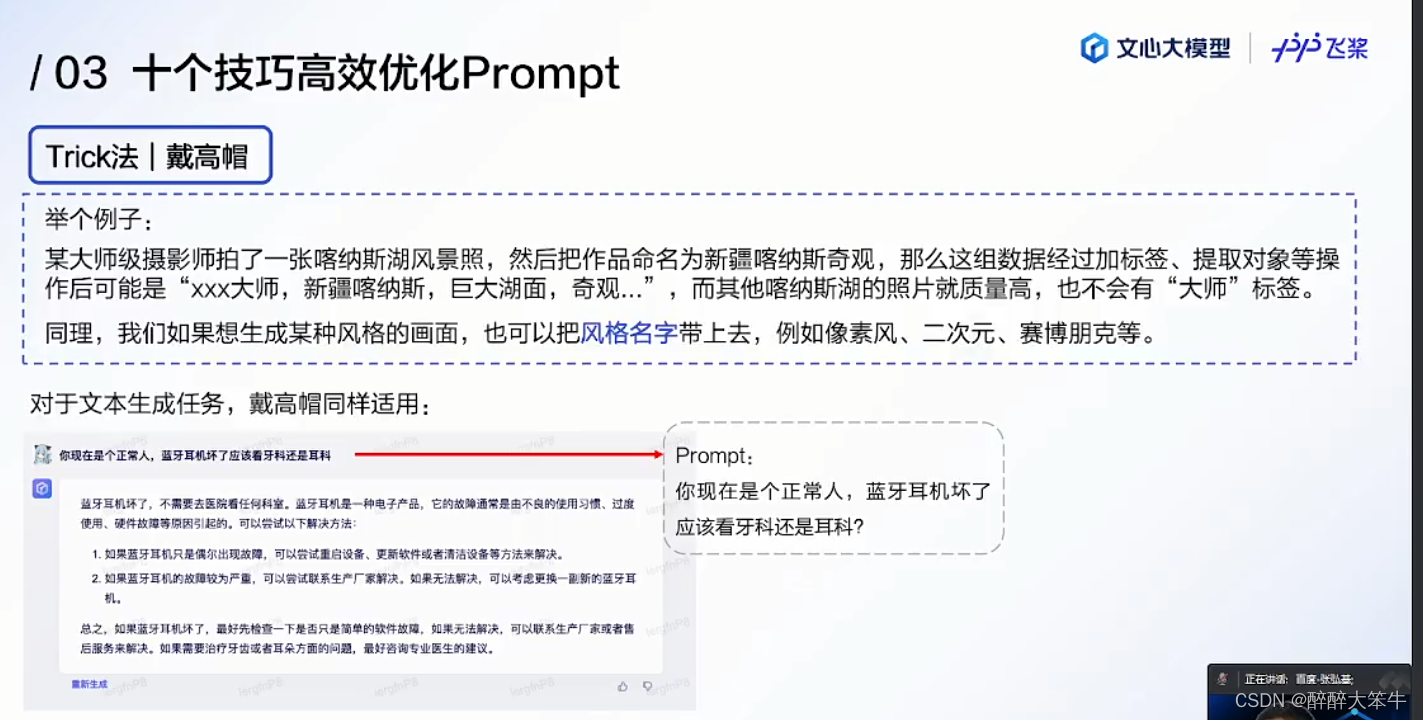

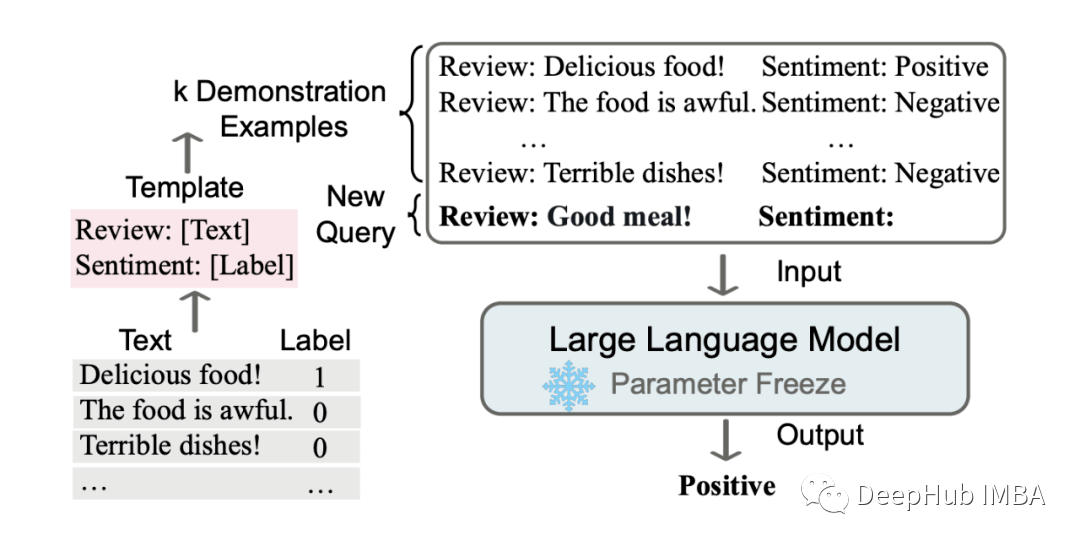

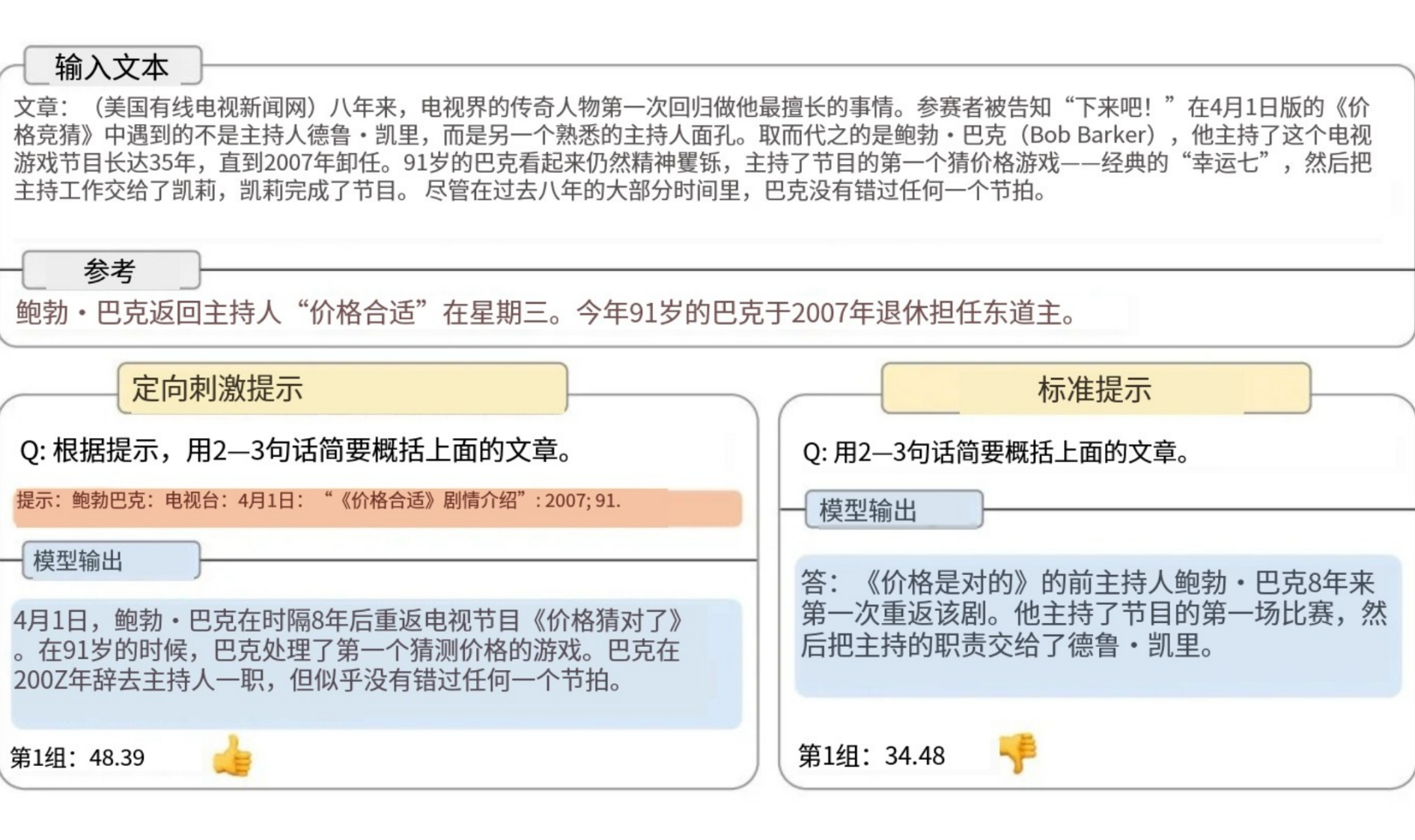

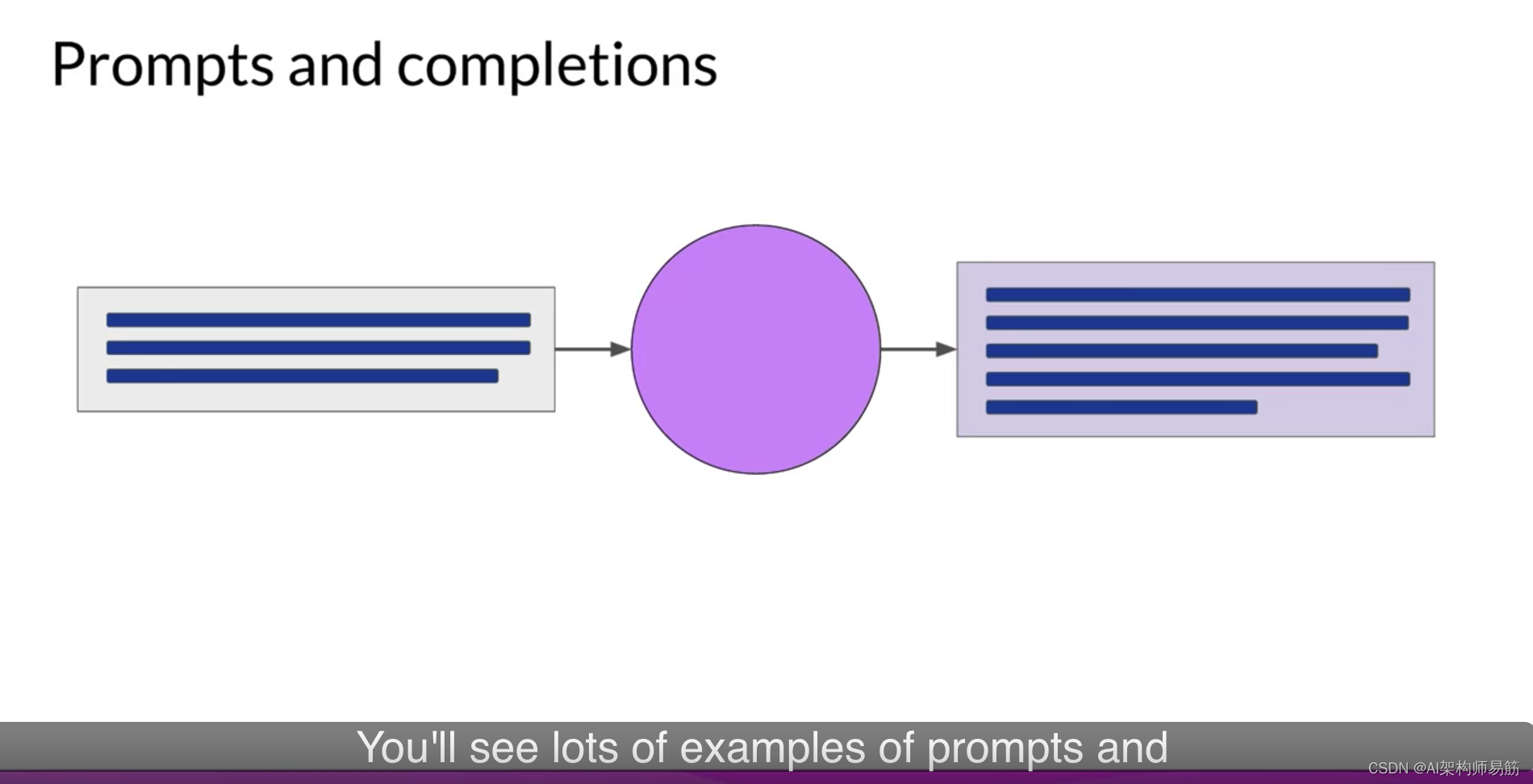

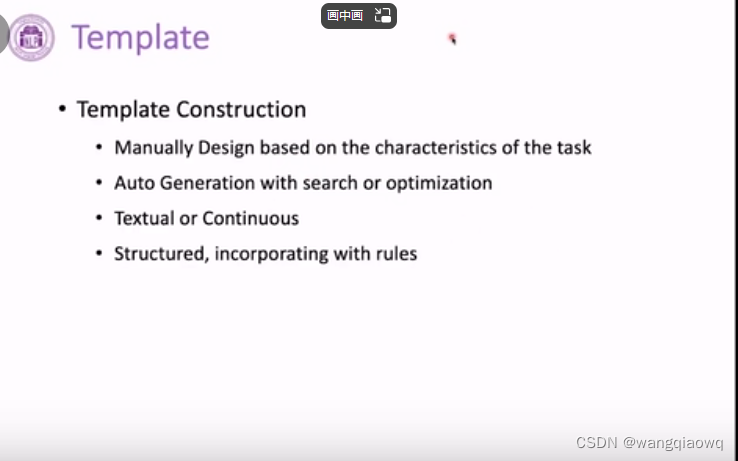

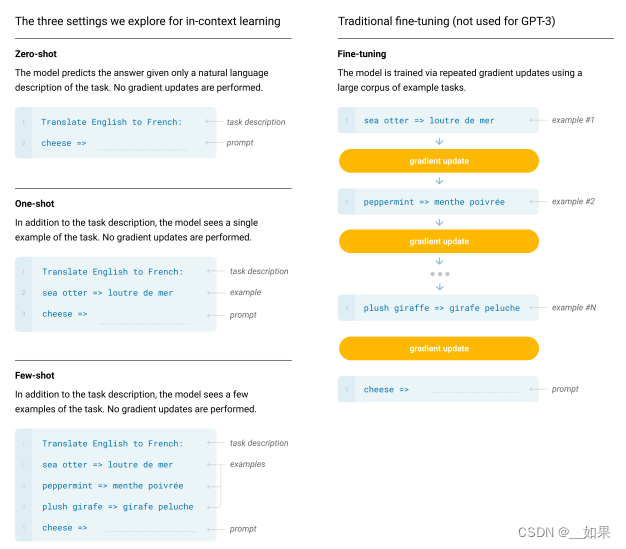

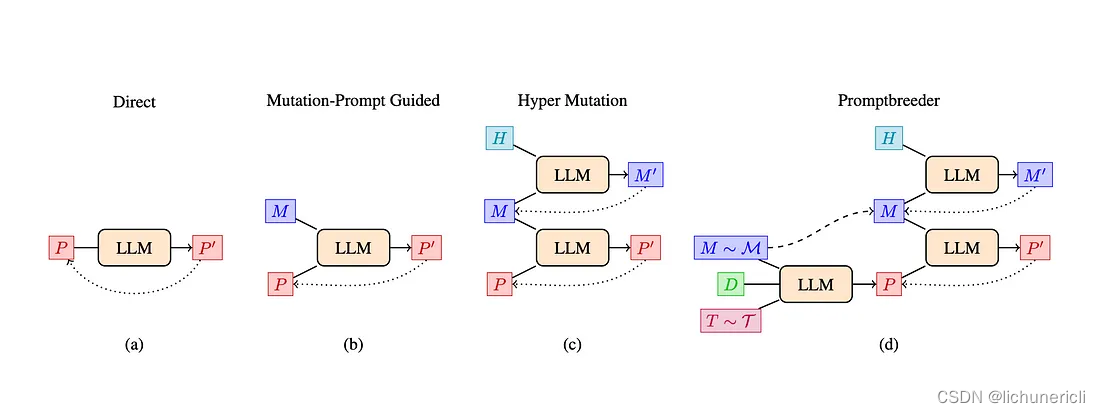

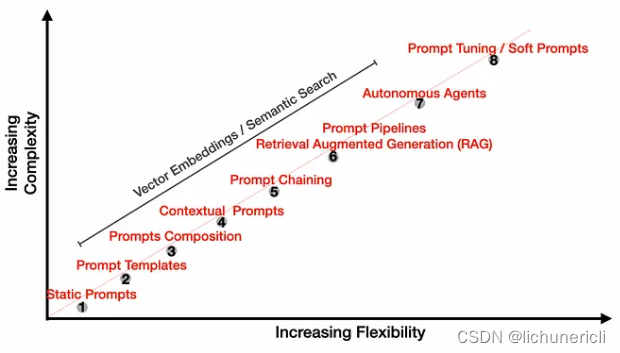

NLP 中的 prompt 笔记

什么是 prompt

NLP 中, 一种用于 Language Model 的 Pretrained Task 范式. 前辈的特点是让模型通过各种预训练任务的辅助 loss 去适配这些任务. 流程是 “pre-train, fine-tune, and predict”. 而 prompt 的思路则与此相反, 调整预训练任务的形式(Reformulate), 使其更接近于…

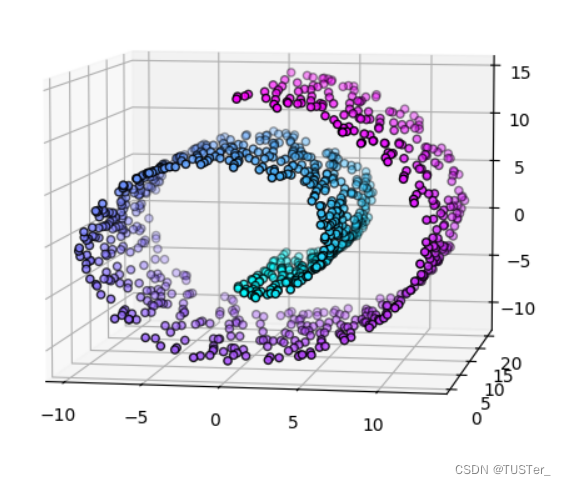

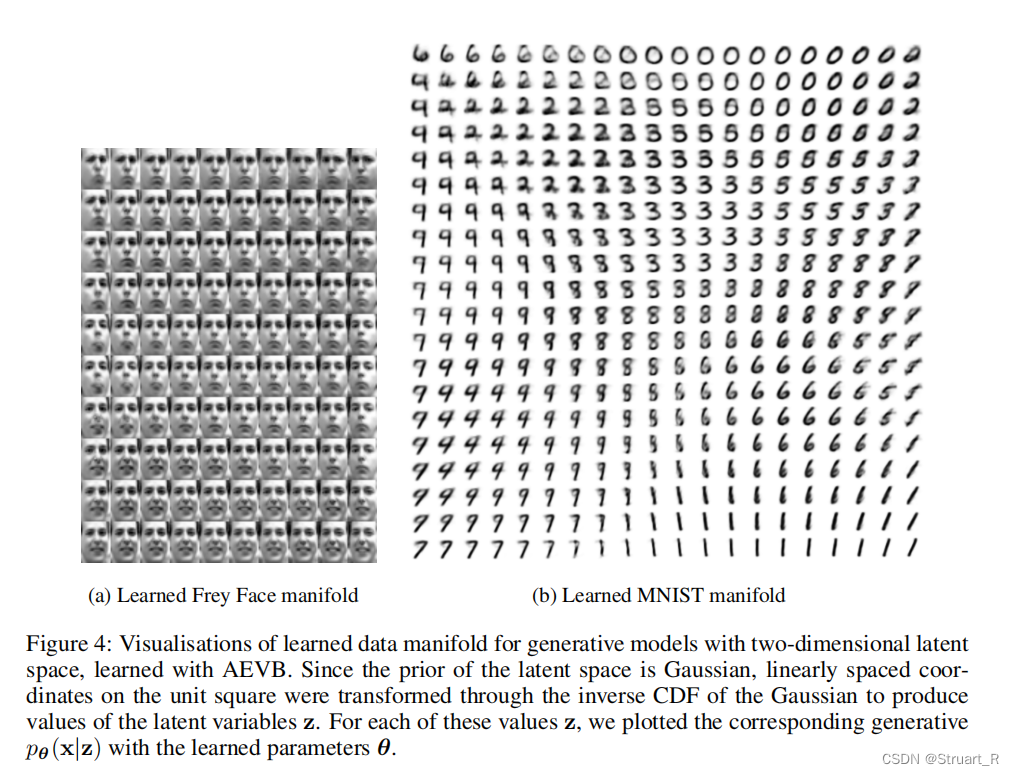

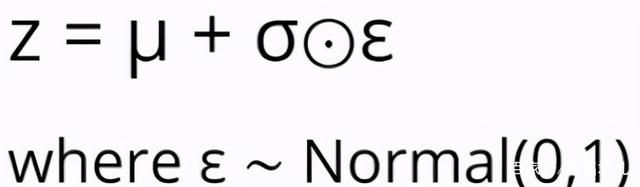

Auto-encoder 系列

Auto-Encoder (AE)Auto-encoder概念自编码器要做的事:将高维的信息通过encoder压缩到一个低维的code内,然后再使用decoder对其进行重建。“自”不是自动,而是自己训练[1]。PCA要做的事其实与AE一样,只是没有神经网络。对于一个输入…

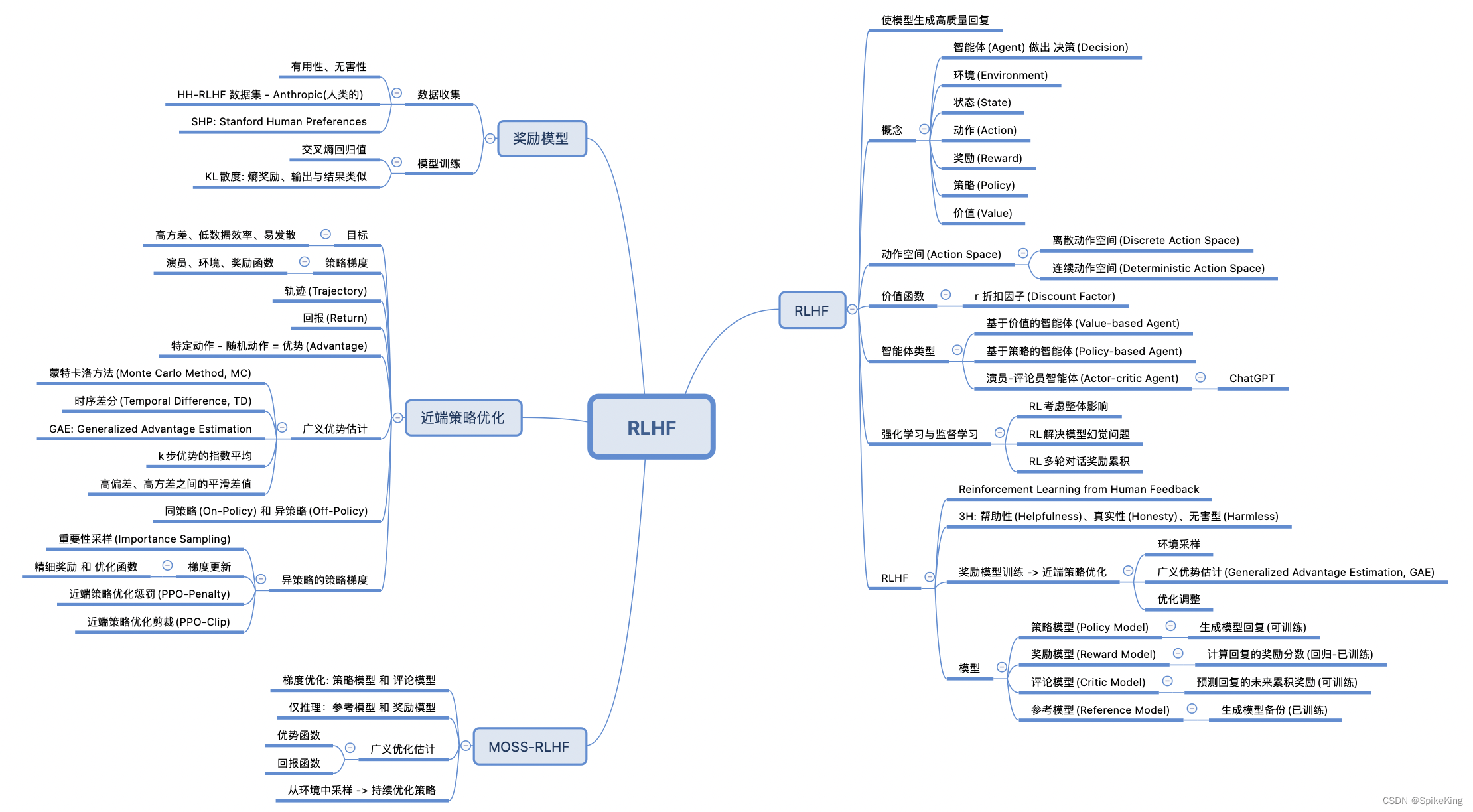

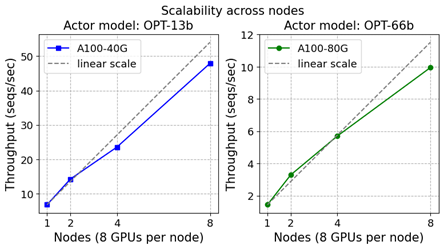

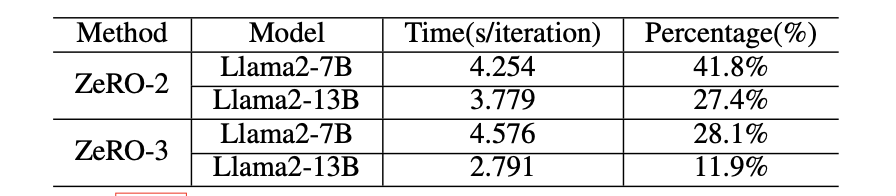

DeepSpeed Chat: 一键式RLHF训练,让你的类ChatGPT千亿大模型提速省钱15倍

DeepSpeed Chat: 一键式RLHF训练,让你的类ChatGPT千亿大模型提速省钱15倍 1. 概述

近日来,ChatGPT及类似模型引发了人工智能(AI)领域的一场风潮。 这场风潮对数字世界产生了革命性影响。ChatGPT类模型具有惊人的泛用性࿰…

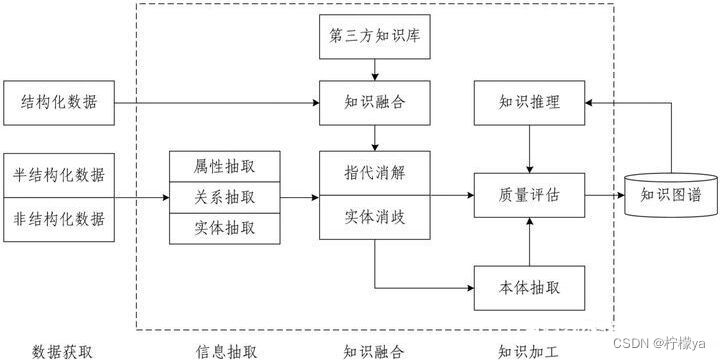

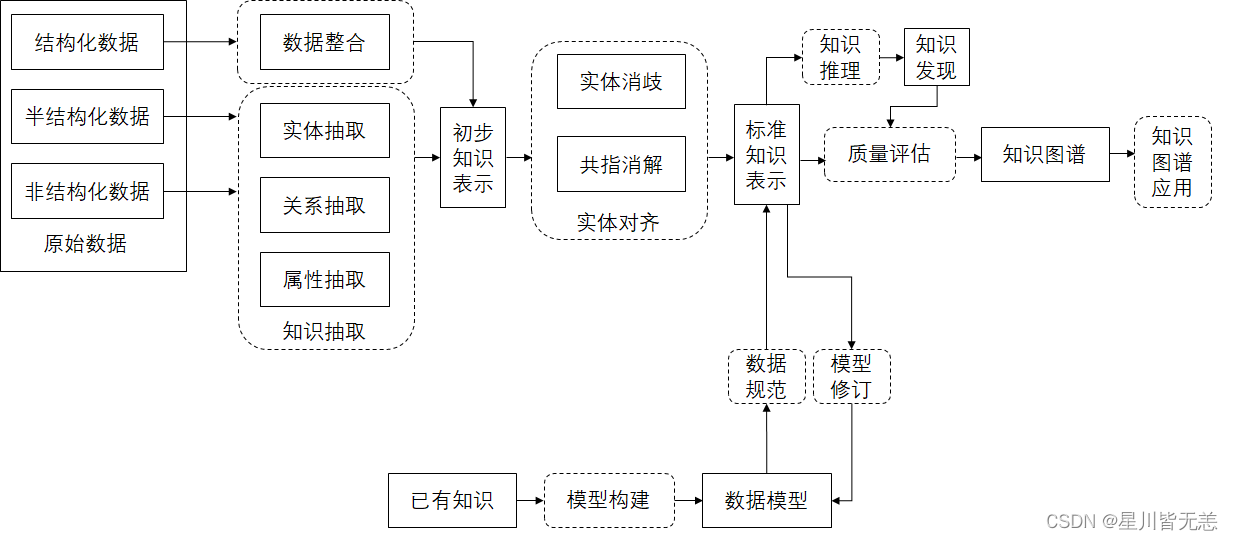

解码知识图谱:从核心概念到技术实战

目录 1. 概述什么是知识图谱知识图谱与自然语言处理的关系 2. 发展历程语义网络本体论大数据时代的知识图谱知识图谱与深度学习的融合 3. 研究内容知识图谱的建模与表示知识抽取知识图谱的融合与对齐知识图谱的推理知识图谱的评估与验证 4. 知识图谱表示与存储RDF:一…

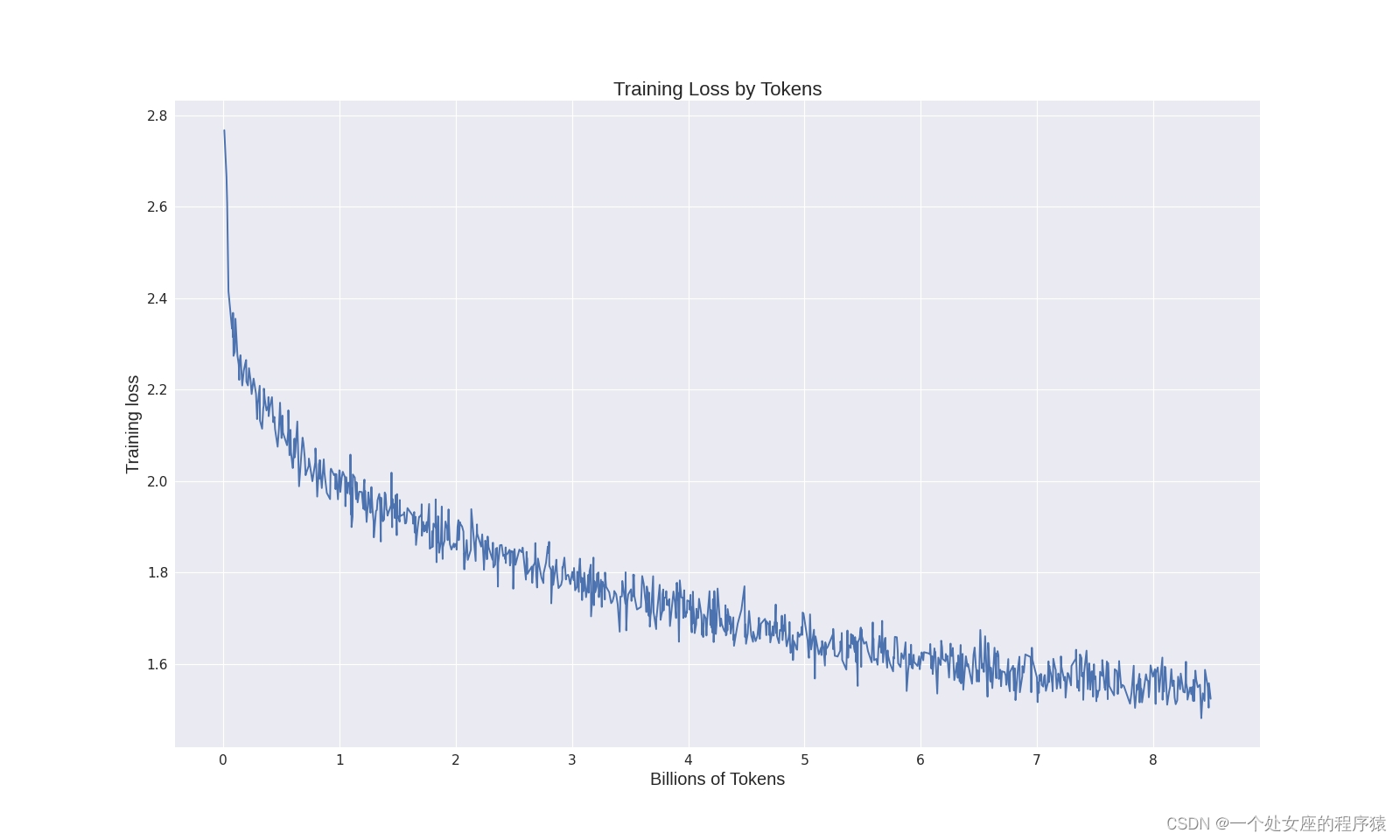

Stable Diffusion公司发布首个大语言模型StableLM,已开源公测!

文 | 智商掉了一地 20号凌晨,Stability AI 发布了一个新的开源语言模型—— StableLM,该公司曾开发了 Stable Diffusion 图像生成工具。这则新闻意味着它不再局限于图像与视频生成领域,将正式加入文本生成 AI 赛道。 StableLM 模型可以生成文…

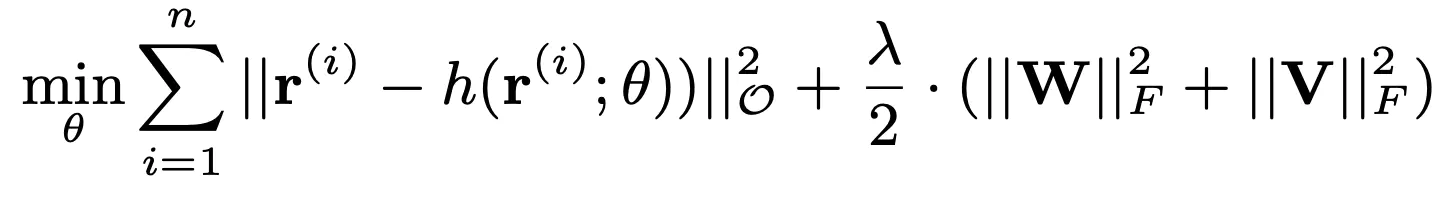

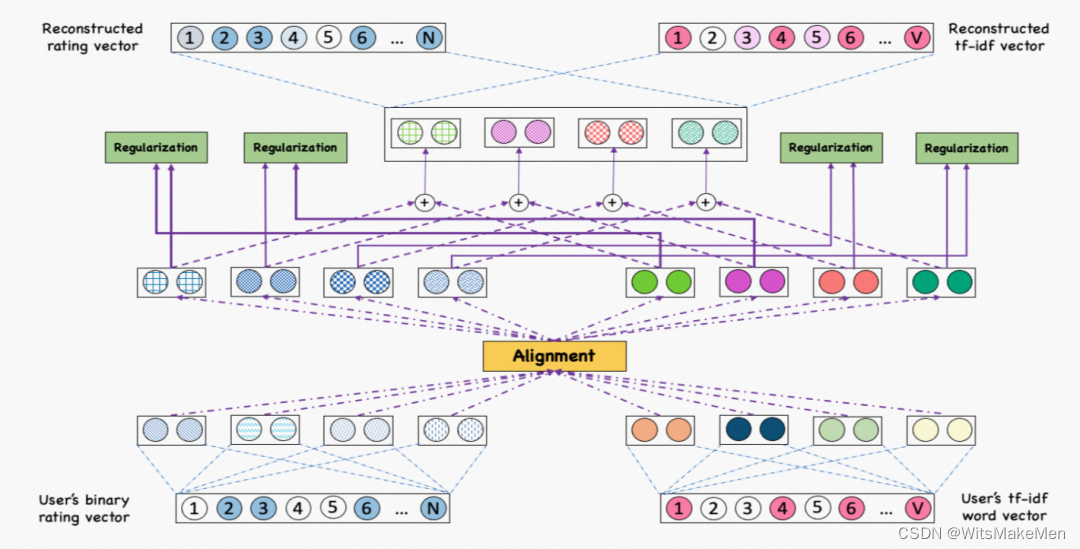

推荐系统中的AutoRec

一:前言

笔者最近在总结推荐系统主流模型,从十多年前的经典的协同过滤算法开始,一直到现有的各大企业所用的推荐模型,笔者一直在思考一个问题,那就是神经网络在计算机领域内的大热,是如何承上启下…

如何构建线性回归模型 - 机器学习示例

在本教程中,您将学习如何构建线性回归模型。这是您在学习机器学习时首先要做的事情之一,因此它将帮助您迈出进入这个竞争激烈的市场的第一步。 目录 目录 先决条件 什么是线性回归? 评估指标 R 平方 均方根误差

卷积神经网络链接汇总

GitHub - chenlinzhong/face-login: 基于mtcnn/facenet/tensorflow 实现人脸识别登录系统 深度学习(四)卷积神经网络入门学习(1)_hjimce的专栏-CSDN博客_卷积神经网络原文

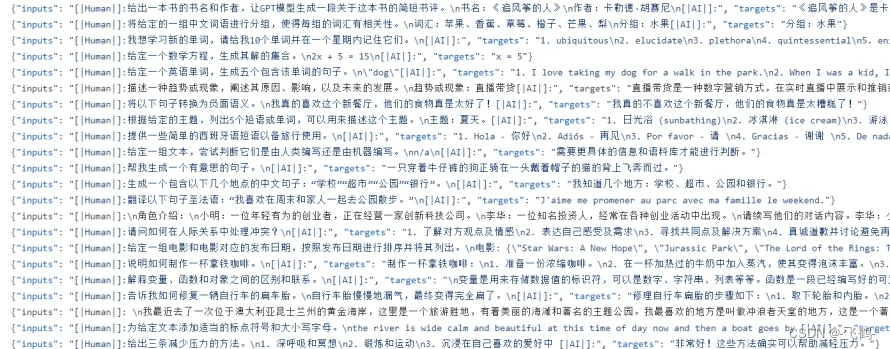

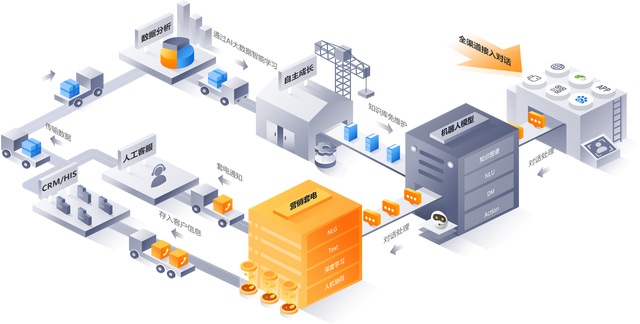

对话式人工智能的数据采集方案

基于噪声数据训练对话式人工智能

聊天机器人、虚拟助手、机器人等对话式人工智能 (Conversational AI Agents ) 在我们的日常生活中已随处可见。许多企业希望以更低的成本增强与客户之间的互动,并为此在该领域进行大量投资。大量数据表明,对话式人工智能…

自然语言处理(NLP)技术的例子

以下是几个自然语言处理(NLP)技术的例子: 机器翻译:机器翻译是将一种自然语言的文本转换成另一种语言的文本的过程。这种技术应用于在线翻译器、多语言聊天机器人、多语言搜索引擎等地方。 文本分类:文本分类将文本分…

Nutch距离一个商业应用的搜索引擎还有多远

了解nutch的人基本上对这个开源的系统都是比较欣赏的,起码在国内是这样的,也很有多搜索网站是基于这个系统修改过来的,不过要做得好,做得真正是一个商业化的搜索,这个修改就不是一朝一夕的事情,也不是修修剪…

为什么对ChatGPT、ChatGLM这样的大语言模型说“你是某某领域专家”,它的回答会有效得多?(二)...

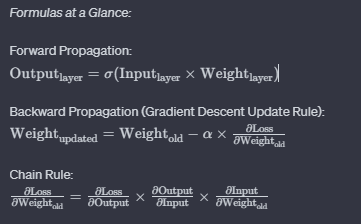

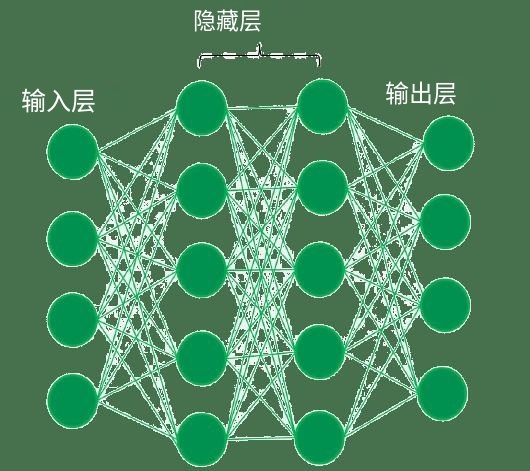

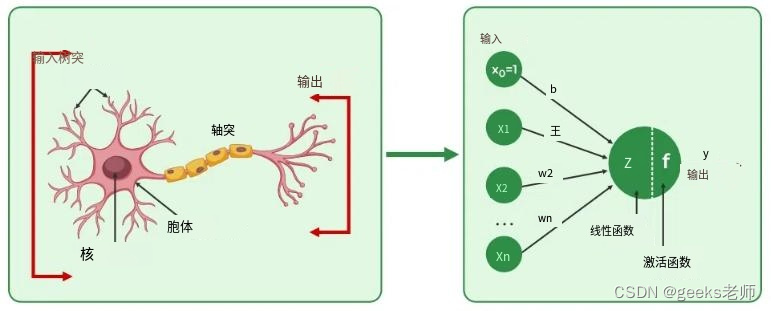

“ 介绍神经网络的基本概念和结构,讨论训练实践、技巧以及网络规模的大小对模型能力的影响。同时介绍嵌入(Embeddings)概念,将高维数据映射到低维空间。通过本文,您将对神经网络有更深入的理解,有助于后面理…

自然语言处理入门指南:了解基础知识,掌握常用技术

自然语言处理(NLP)是人工智能(AI)领域的一个重要分支,其主要目的是让计算机能够理解人类语言,并能够从中获取有用的信息。NLP已经广泛应用于文本分析、机器翻译、问答系统、自然语言生成等领域,…

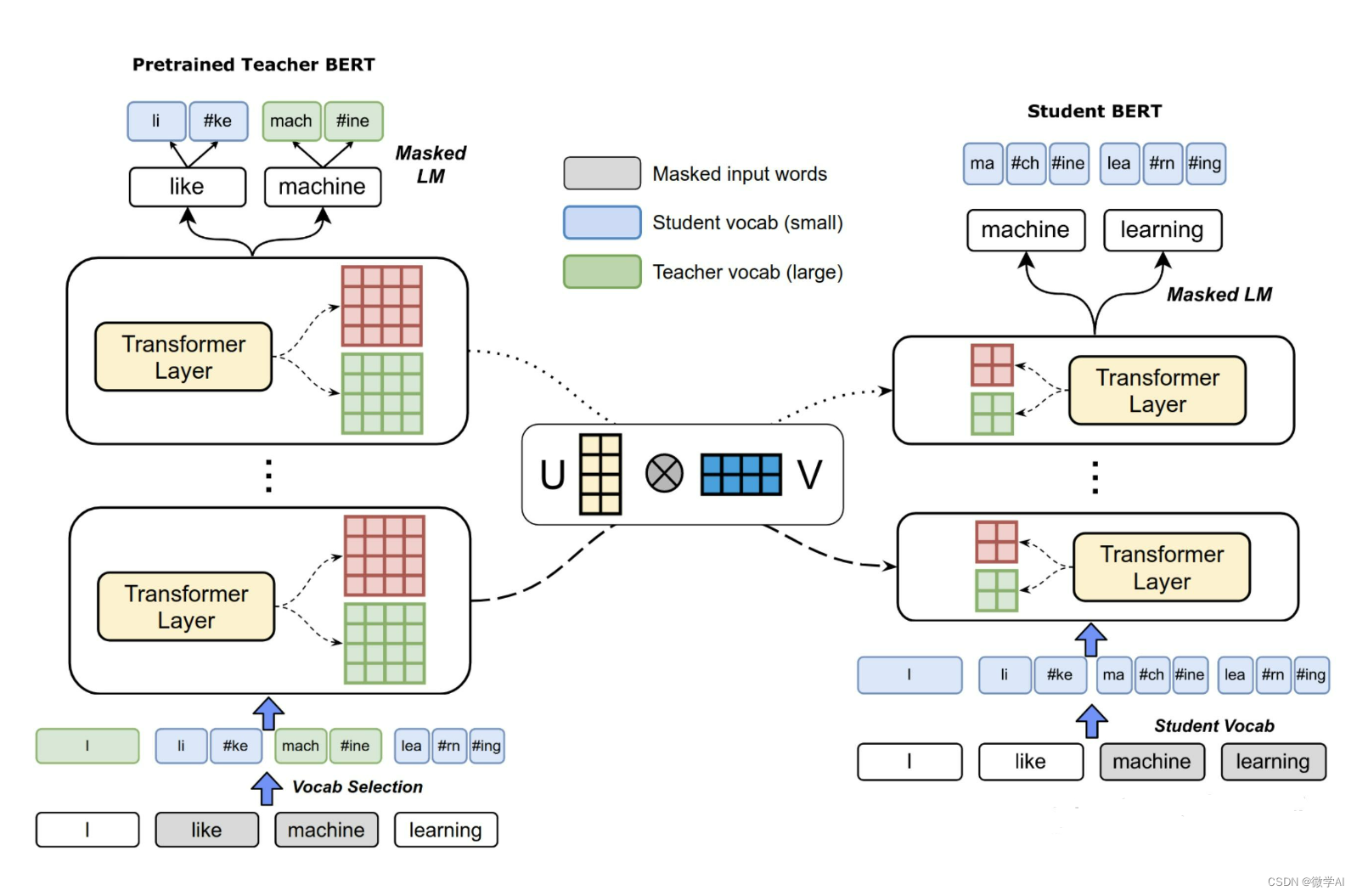

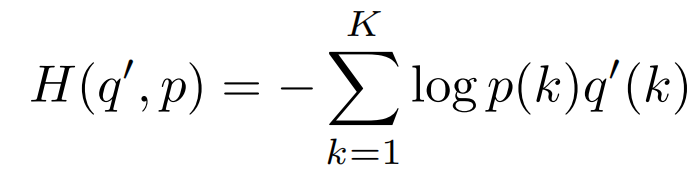

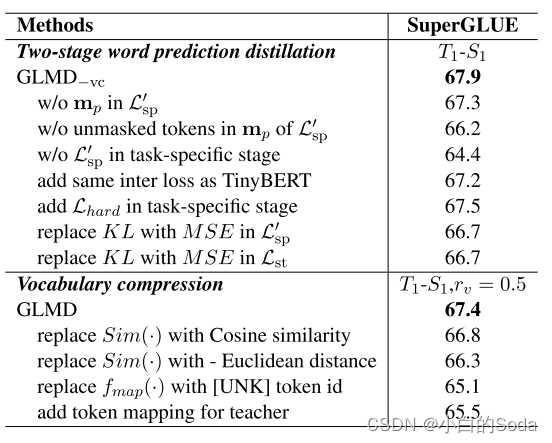

BERT模型蒸馏完全指南(原理技巧代码)

BERT模型蒸馏完全指南(原理/技巧/代码)

小朋友,关于模型蒸馏,你是否有很多问号: 蒸馏是什么?怎么蒸BERT?BERT蒸馏有什么技巧?如何调参?蒸馏代码怎么写?有现成的吗?今天rumor就结合Distilled BiLSTM/BERT-PKD/DistillBERT/TinyBERT/MobileBERT/MiniLM六大经典模型,…

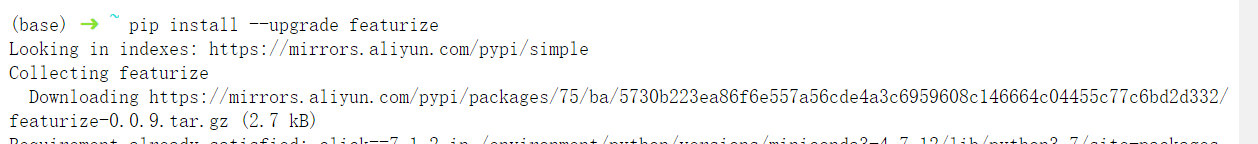

租用便宜的个人GPU服务器进行深度学习

真心推荐featurize,非工作人员,要是你问为什么推荐,因为确实好用,当然最主要的驱动力的是邀请有奖。。。(只是官方鼓励邀请,注册免费,后续使用充值也跟我没关系,也不会有客服骚扰你推…

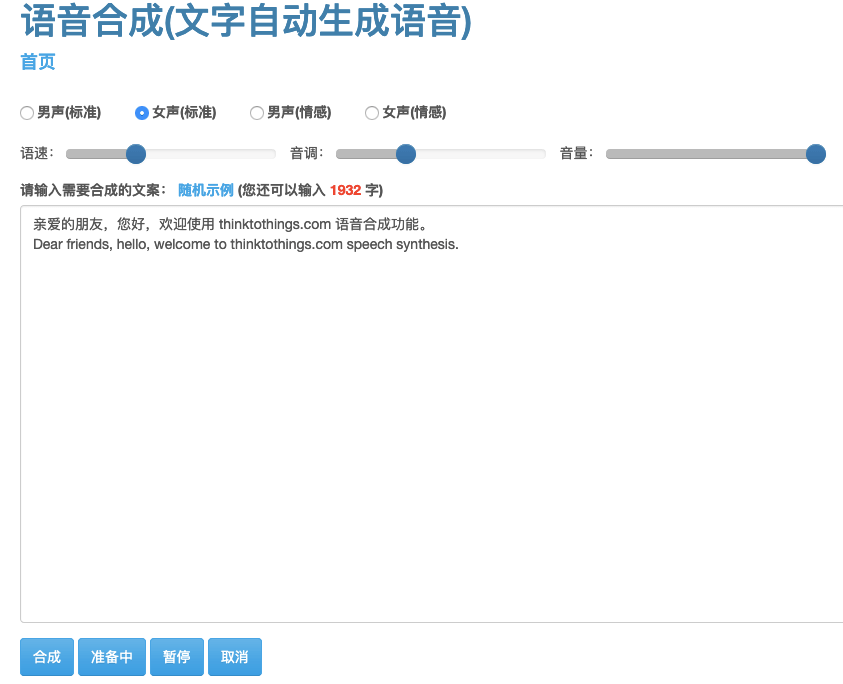

自然语言处理相关词条

NLP领域 自然语言处理 计算语言学 自然语言理解 自然语言生成 机器翻译 文本分类 语音识别 语音合成 中文分词 信息检索 信息抽取 句法分析 问答系统 自动摘要 拼写检查 统计机器翻译 [编辑] NLP专题 隐马尔科夫模型 最大…

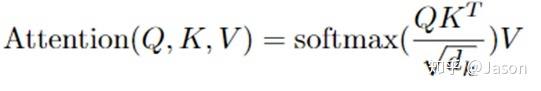

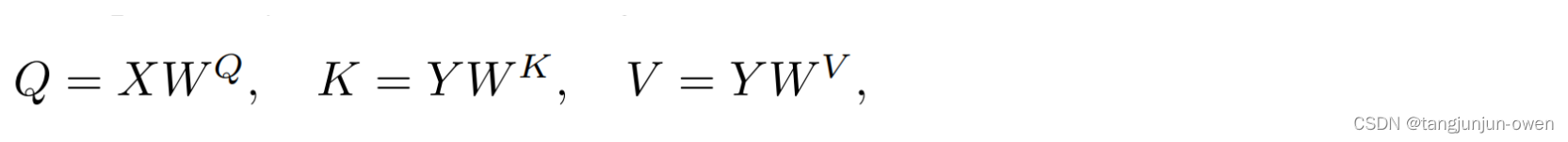

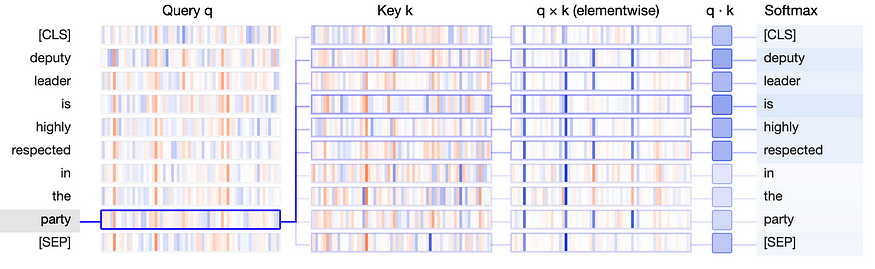

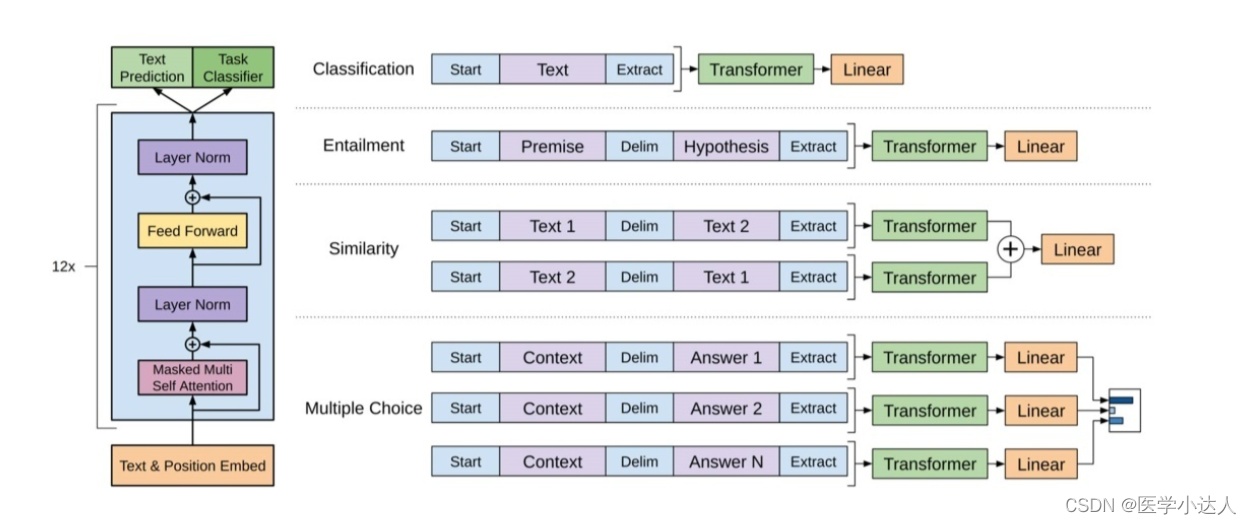

Attention——Transformer——Bert——FineTuning——Prompt

目录 一、Attention机制

二、Transformer模型

三、Bert模型

四、Fine-Tuning微调

五、Prompt 一、Attention机制

1、核心逻辑:从关注全部到关注重点;

2.计算attention公式: 3.优点:

(1)参数少&#…

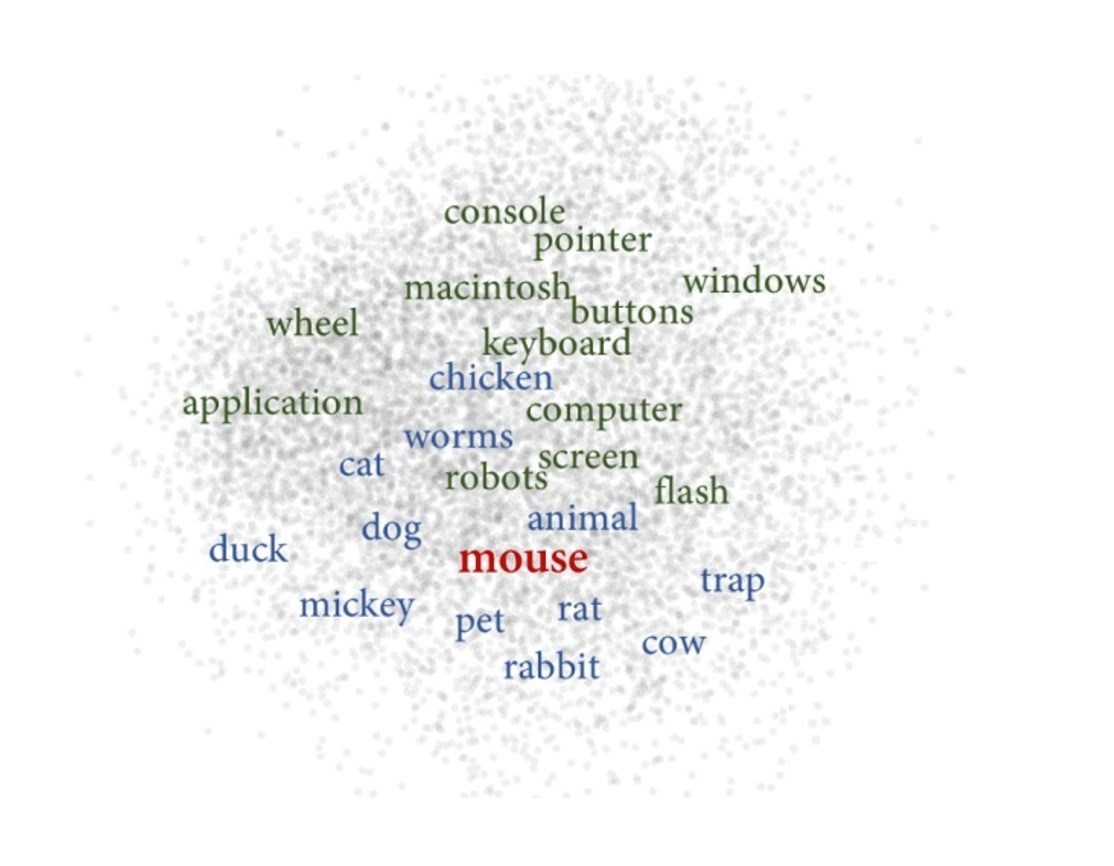

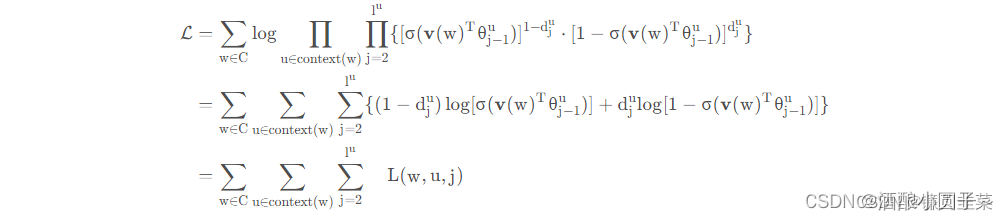

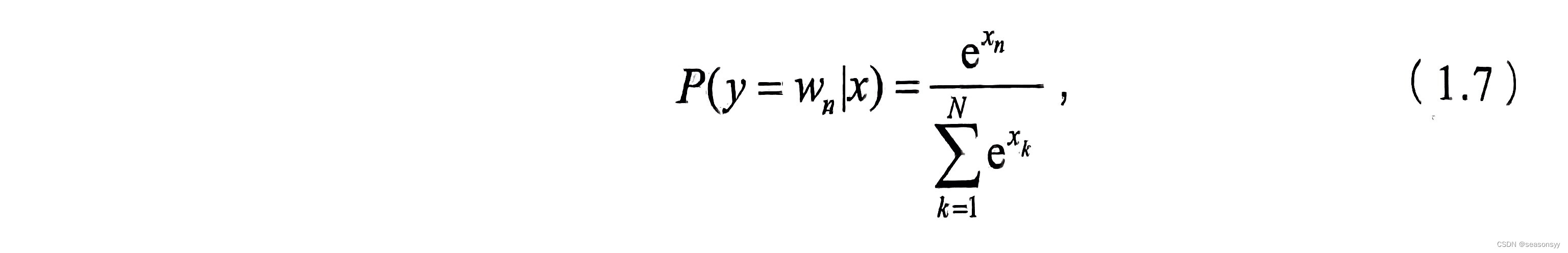

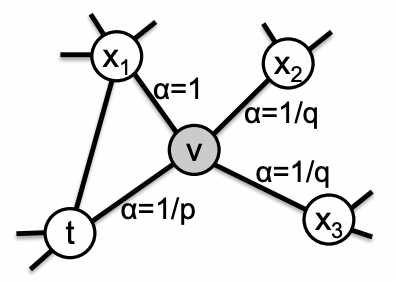

理解Word2Vec模型

Word2Vec的理解首言一、SG模型中的名词解释1.1. 独热码1.2 建模过程二、SG模型的损失函数2.1表达形式12.2 表达形式22.3 softmax函数三、模型的计算过程3.1 数据的表示3.2 隐层3.3 输出层3.4 SG模型的计算过程3.5 SG模型参数θ\thetaθ确定的数学证明四、高级词向量表示4.1常规…

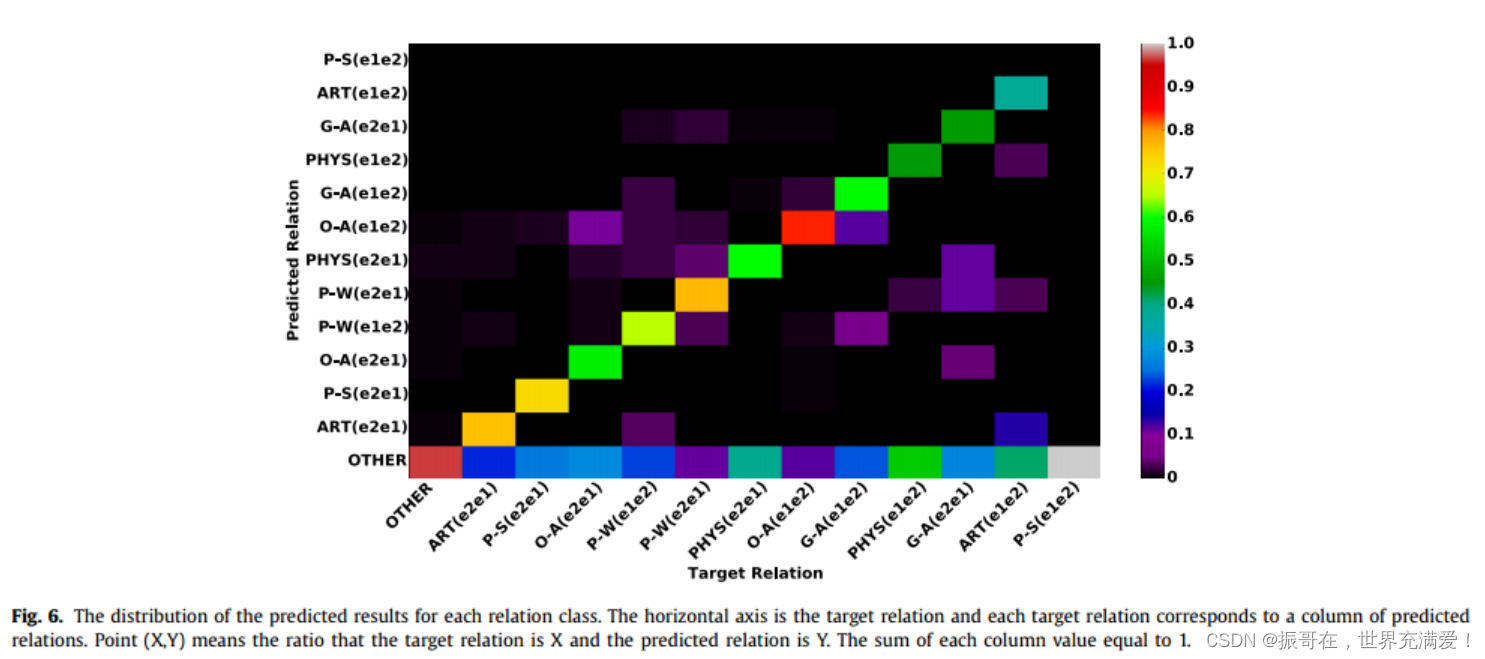

【自然语言处理】关系抽取 —— SimpleRE 讲解

SimpleRE 论文信息 标题:An Embarrassingly Simple Model for Dialogue Relation Extraction 作者:Fuzhao Xue 期刊:ICASSP 2022 发布时间与更新时间:2020.12.27 2022.01.25 主题:自然语言处理、关系抽取、对话场景、BERT arXiv:[2012.13873] An Embarrassingly Simple M…

多模态数据、多源数据

多来源数据(multi-source data)

数据并非来自同一信息源,而是来自不同的来源,并被收集在一个数据集中,这种类型的数据称为多源数据。总体来说多来源数据就是取自多个端口的数据集合。(包括但不限于传感器、…

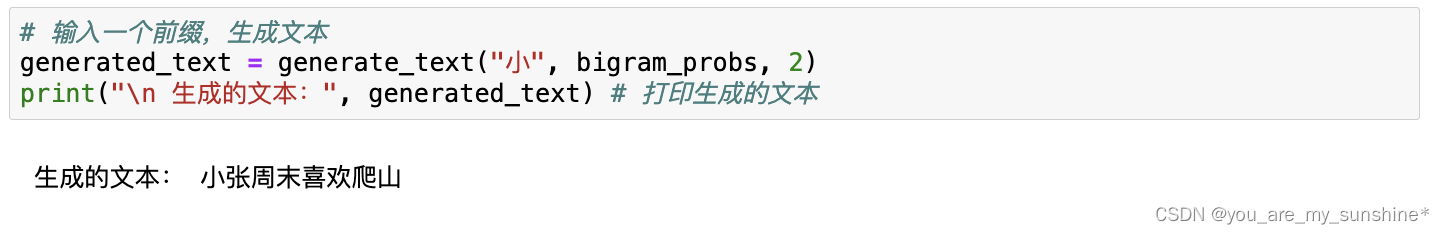

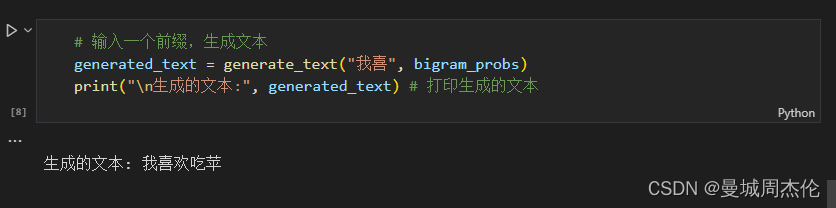

基于马尔可夫模型的文本生成器

马尔可夫过程

只需要知道: 马尔可夫过程就是未来只与现在有关,与过去无关。 马尔科夫链(Markov)是最简单的马氏过程,即时间和状态过程的取值参数都是离散的马氏过程。 例如: 我知道一个事件第一天的概率分…

论文阅读《Generating Natural Language Adversarial Examples Moustafa》

摘要

利用遗传算法实现基于种群的无梯度优化,只修改几个单词,保持与原文语义相似和句法连贯 算法

一、Perturb (单词替换规则)

在列表中选择输入句子中要替换的单词是通过随机抽样来完成的,抽样概率与每个单词在反拟…

全套解决方案:基于pytorch、transformers的中文NLP训练框架,支持大模型训练和文本生成,快速上手,海量训练数据!

全套解决方案:基于pytorch、transformers的中文NLP训练框架,支持大模型训练和文本生成,快速上手,海量训练数据!

1.简介

目标:基于pytorch、transformers做中文领域的nlp开箱即用的训练框架,提…

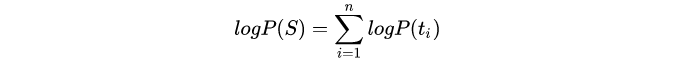

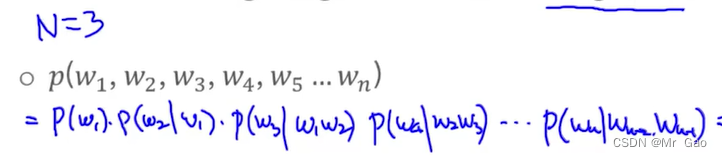

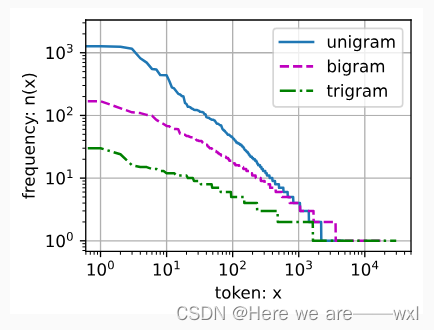

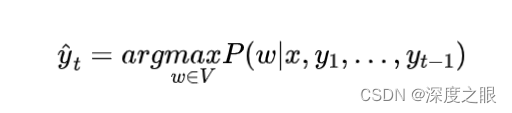

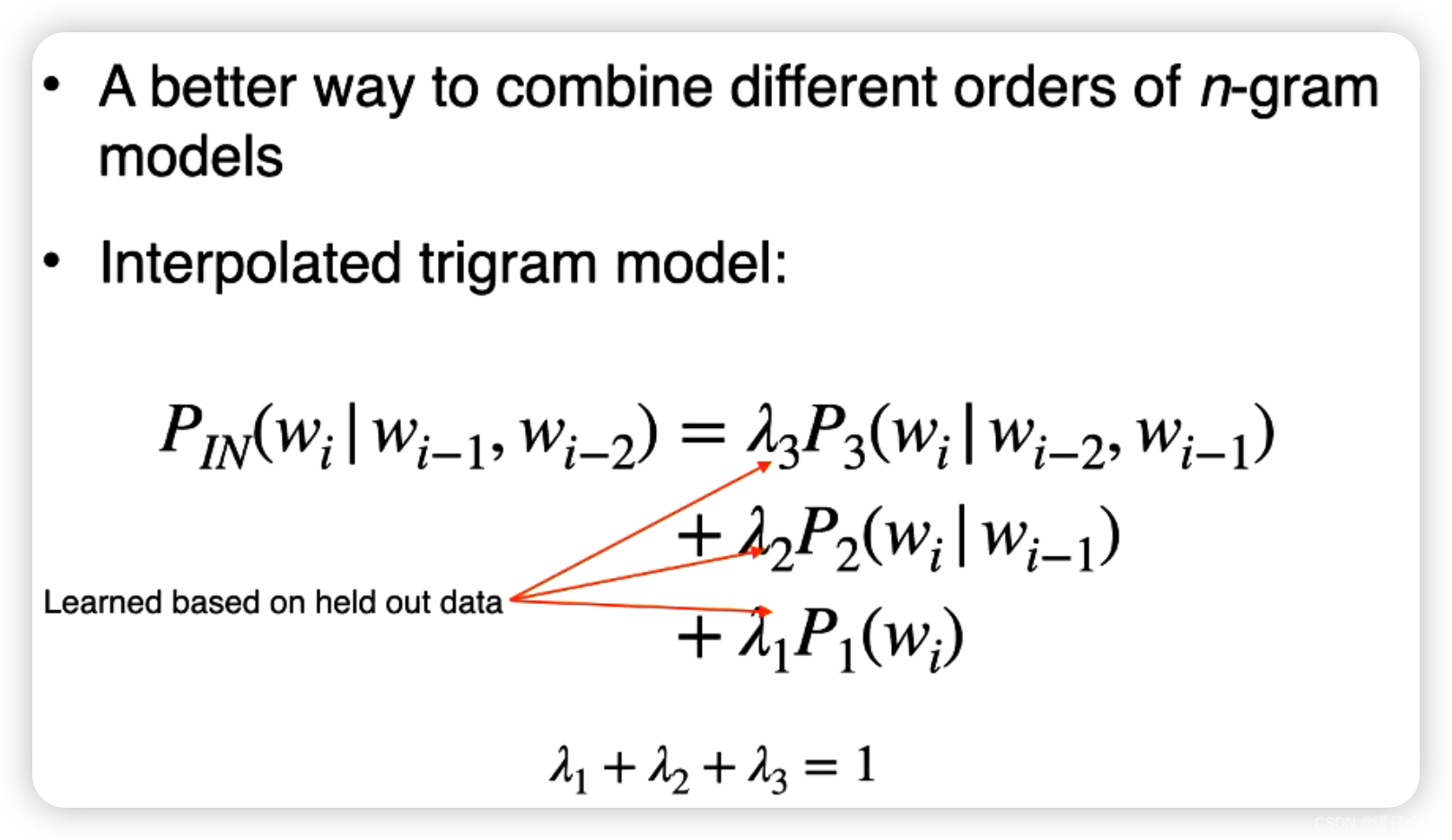

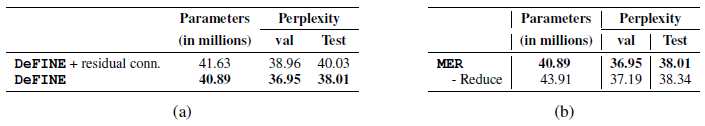

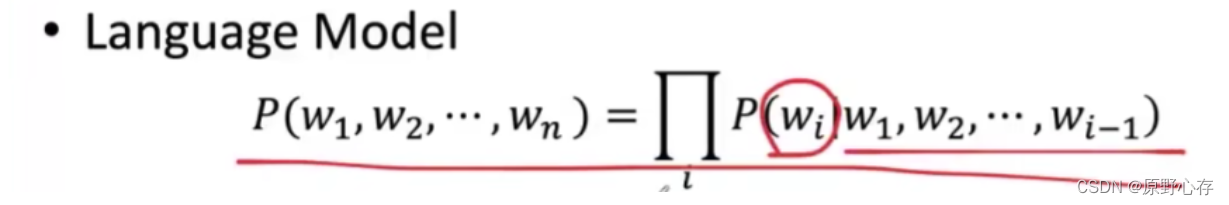

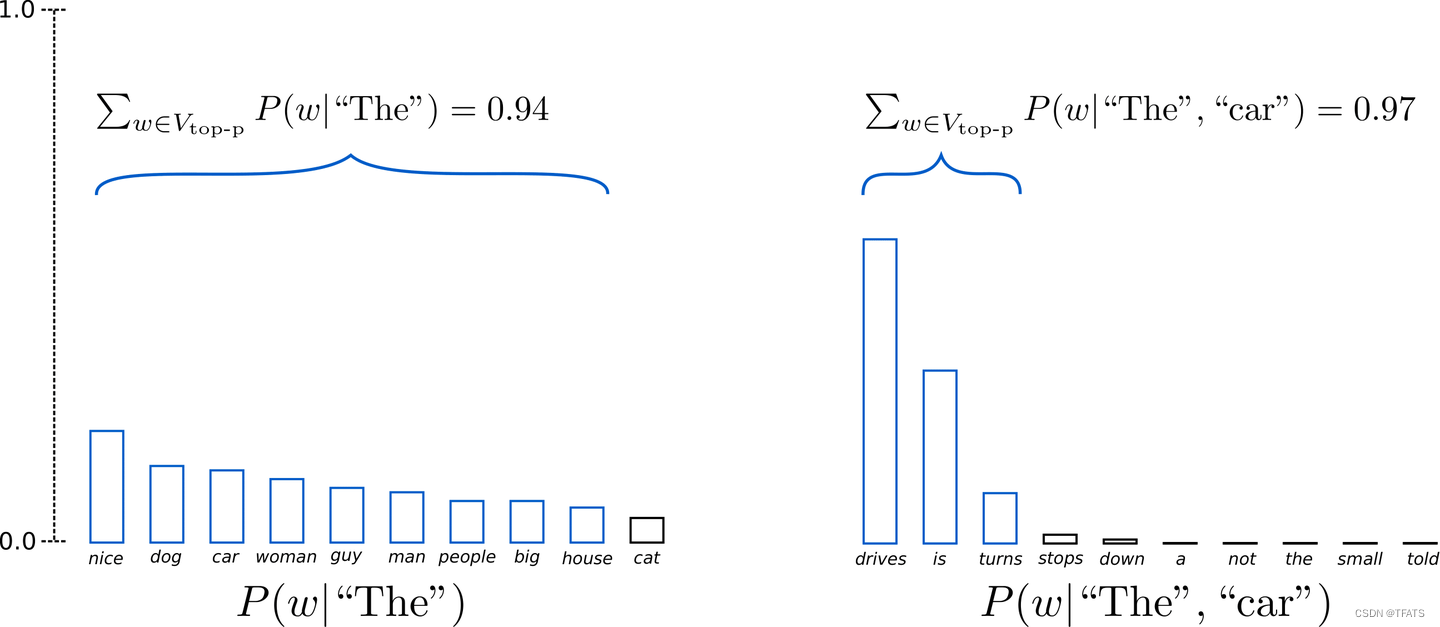

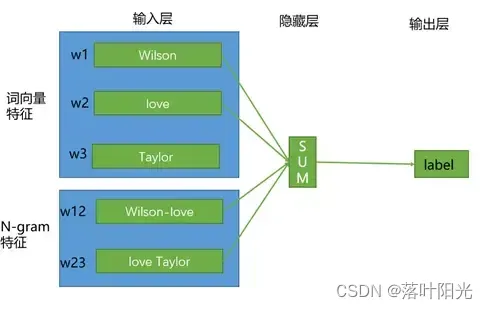

N-gram模型详解

语言模型(Language Model)

基本概念

什么是语言模型?简言之,语言模型可以理解为是一种用于判度一个句子是否通顺的模型。举例来说,假设我们有一个训练好的语言模型modelmodelmodel,给定两个句子:我喜欢AI、喜欢我AI。…

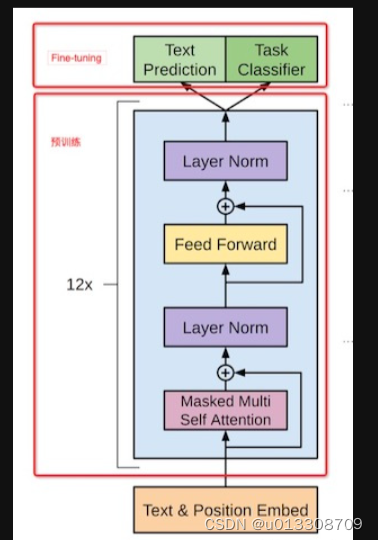

预训练模型(持续更新)

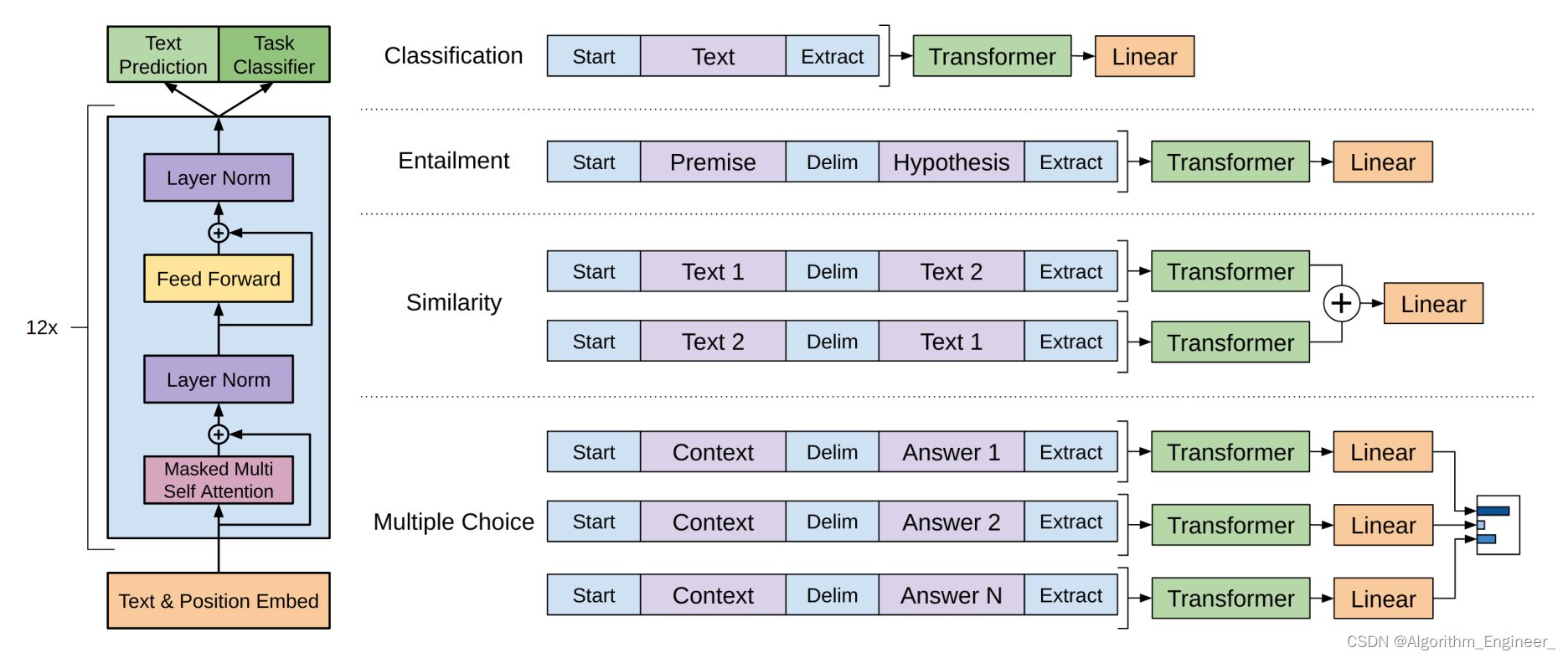

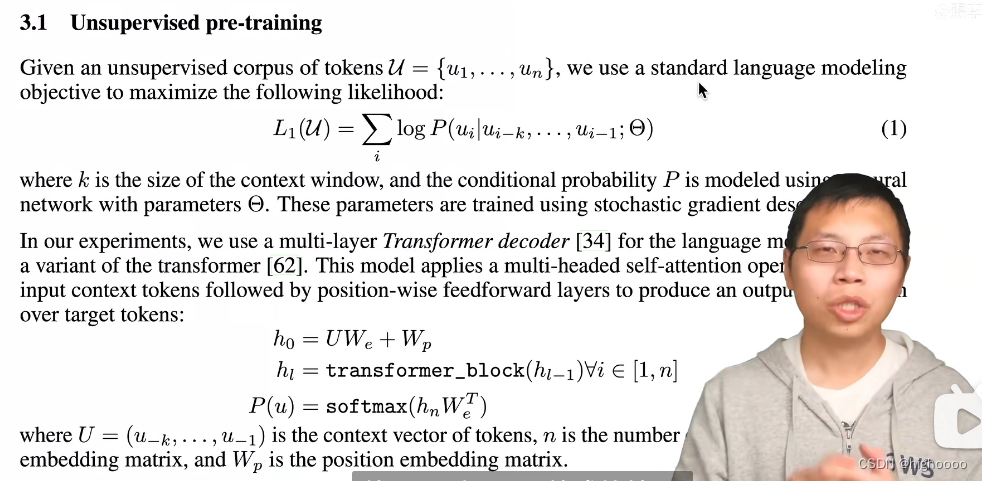

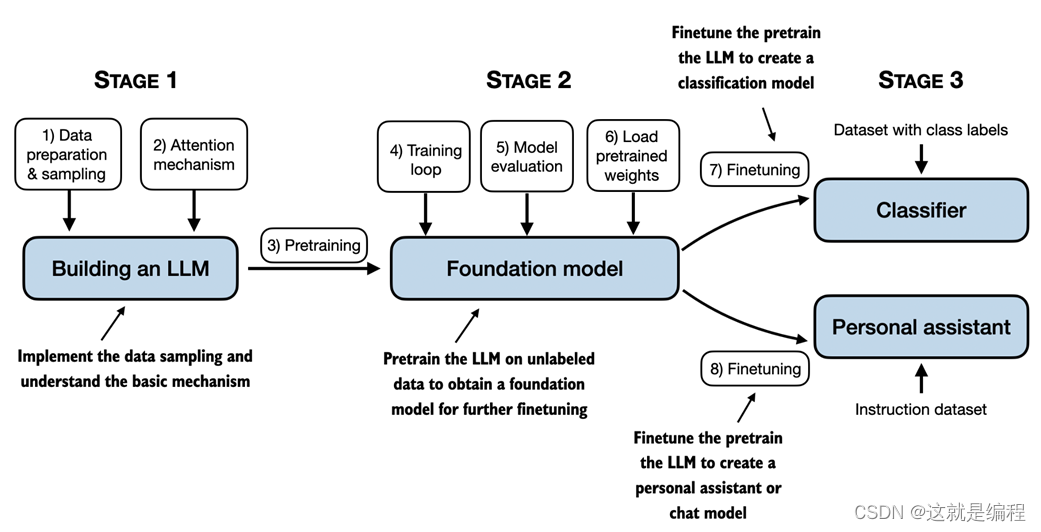

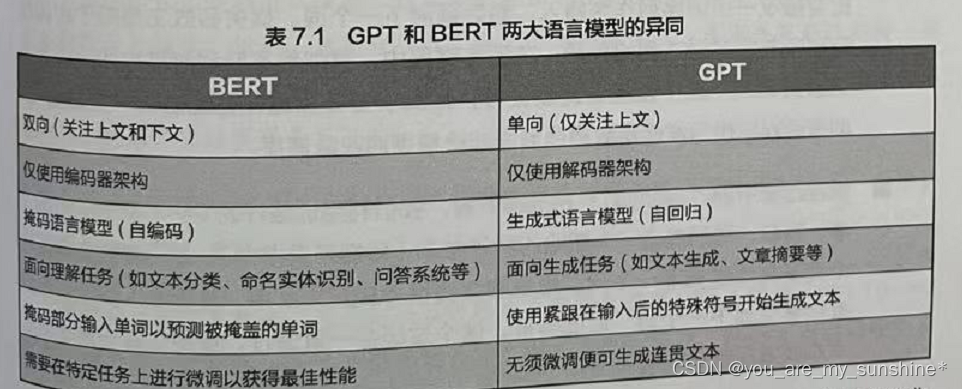

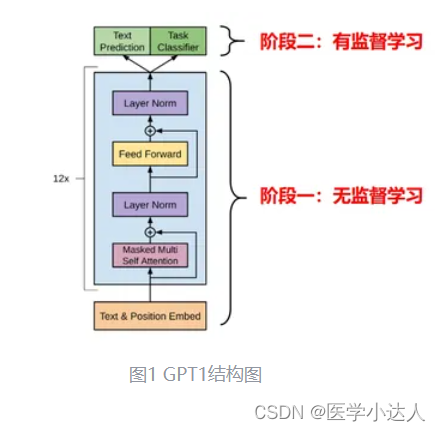

GPT

GPT模型也是当下非常火的一个预训练模型,GPT和BERT刚好相反,它采用的是Auto-Regressive,使用的是Transofrmer的Decoder部分,是一个单向的语言模型,Auto-Reressive模型的目标函数是maximizeL(θ)∑logp(xt∣x<t…

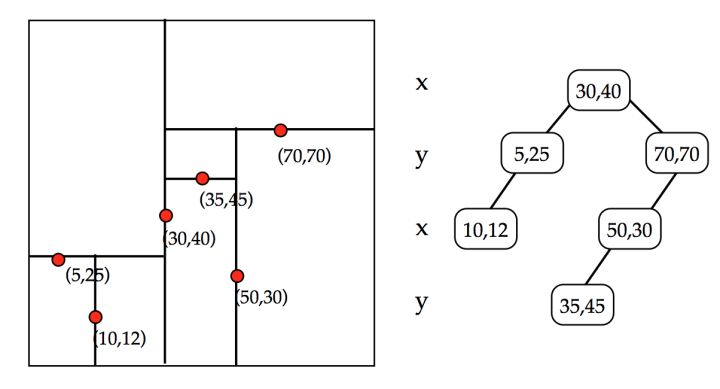

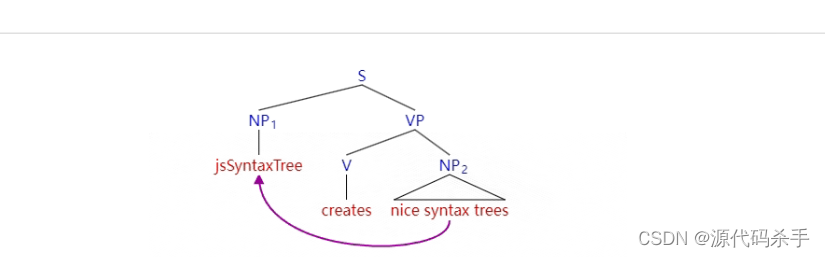

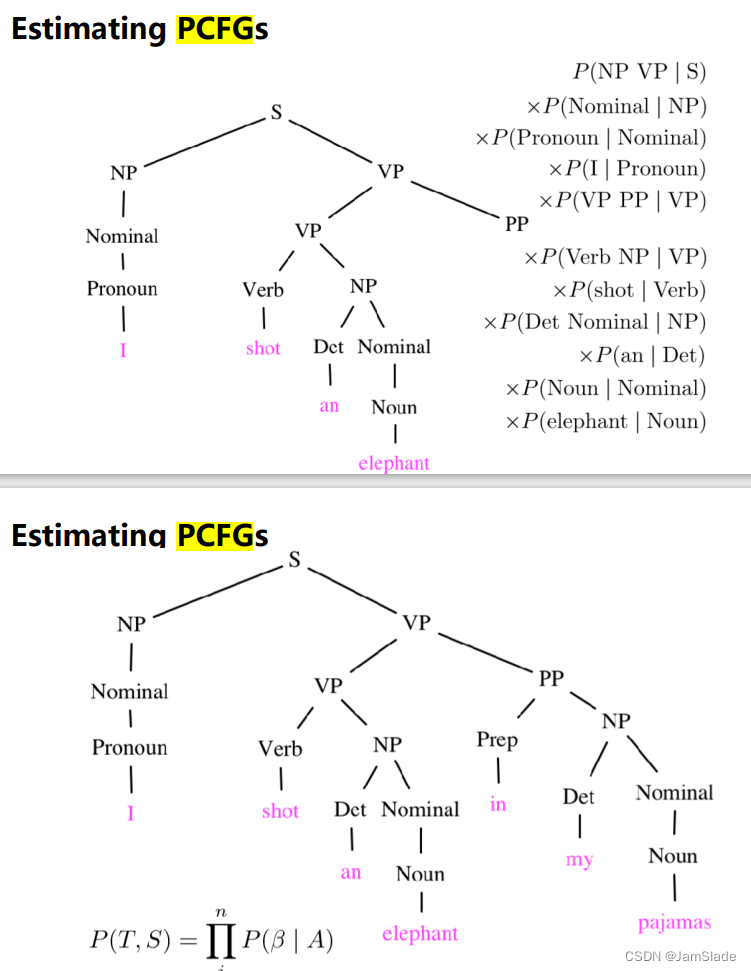

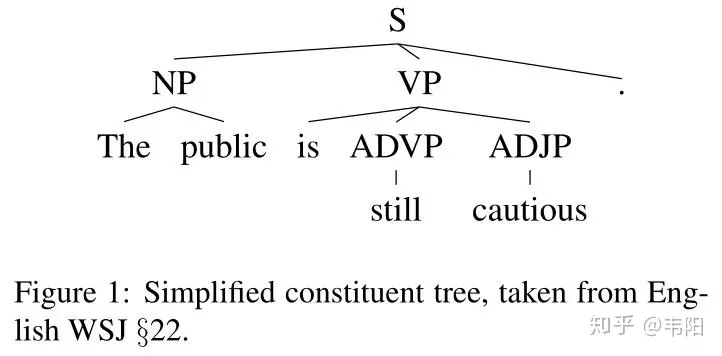

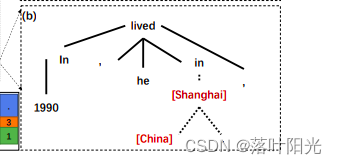

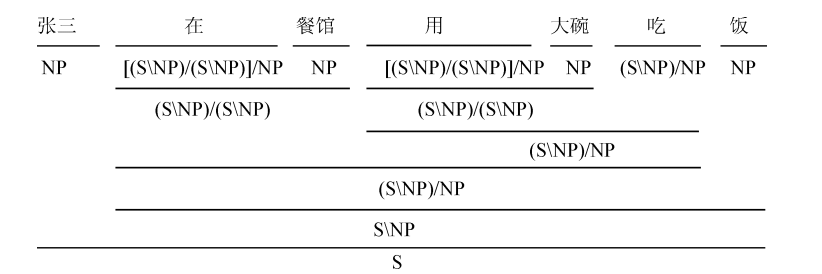

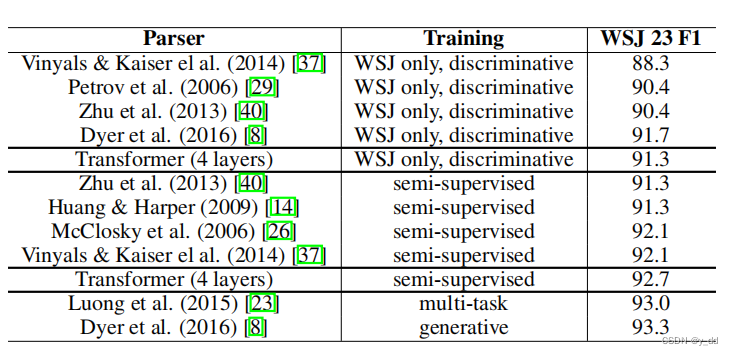

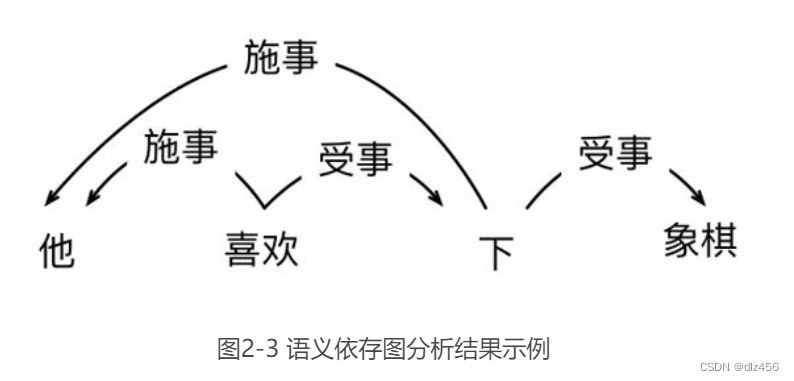

成分句法分析依存文法分析

Syntactic Structure

句法结构其实是语言学中非常重要的一个分支。同样,在NLP领域,句法结构也是很重要的。如果能在模型中考虑到句法特征,那么对于例如说文本生成任务,模型的效果肯定会有所提升。现在,主流的句法结构…

Word2Vec模型详解

文本向量化表示

对文本进行完预处理后,接下来的重要任务就是将文本用向量化的形式进行表达。在本章节中,我们将尽量全面地覆盖文本向量化表示方法,重点关注Word2Vec以及目前各种常用的词向量。

基于统计方法

首先,我们来看基于…

《Question Answering over Freebase with Multi-Column Convolutional Neural Networks》论文笔记

《Question Answering over Freebase with Multi-Column Convolutional Neural Networks》论文笔记

这篇文章于2015年发表在ACL,根据KBQA任务做法的宏观分类,这篇文章被《A Survey on Complex Question Answering over Knowledge Base: Recent Advances…

PullNet: Open Domain Question Answering with Iterative Retrieval on Knowledge Bases and Text 论文笔记

PullNet: Open Domain Question Answering with Iterative Retrieval on Knowledge Bases and Text

2019年,EMNLP,Google, 本文是IR-based的方法来解决KBQA任务,属于是GRAFT-Net工作的延续和改进。

Overview

本文作者将open-do…

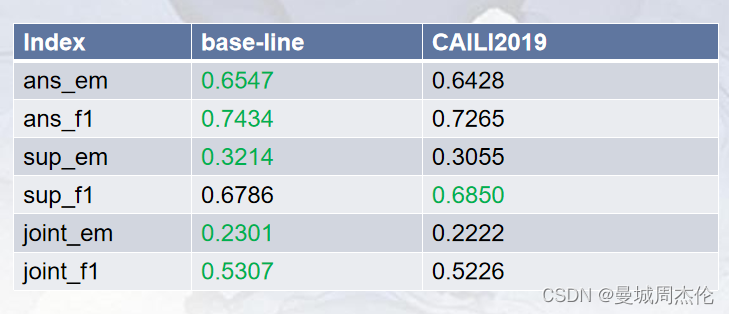

HotpotQA数据集

HOTPOTQA: A Dataset for Diverse, Explainable Multi-hop Question Answering

Dataset

HotpotQA是2018年新提出的一个多跳推理问答数据集,本文主要来看数据集的格式。 从图上可以看出数据集还是比较大的,训练集分为了三个难度:easy、mediu…

Gradio库的Gallery模块介绍与select方法详解

❤️觉得内容不错的话,欢迎点赞收藏加关注😊😊😊,后续会继续输入更多优质内容❤️ 👉有问题欢迎大家加关注私戳或者评论(包括但不限于NLP算法相关,linux学习相关,读研读博…

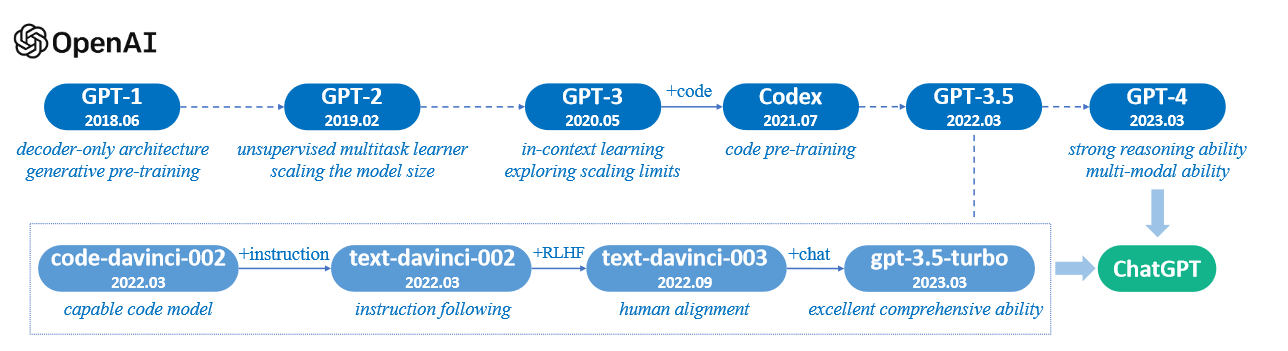

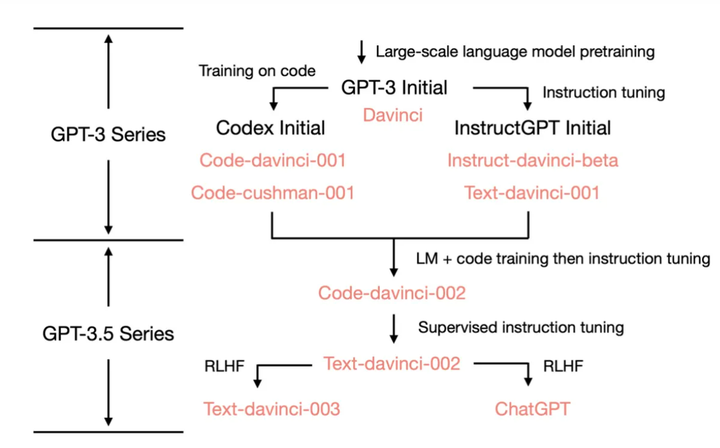

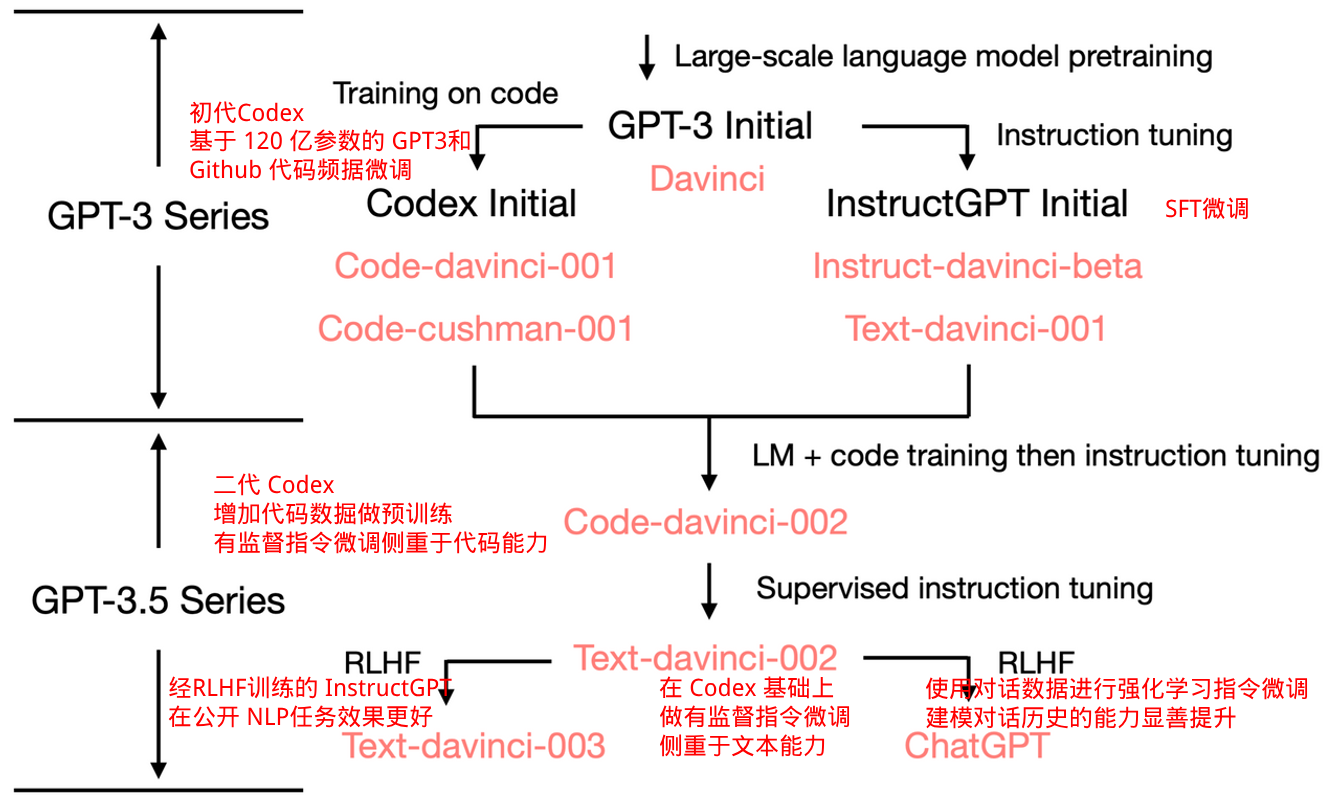

chatGPT模型原理

文章目录简介BertGPT 初代GPT-2GPT-3chatGPT开源ChatGPT简介

openai 的 GPT 大模型的发展历程。

Bert

2018年,自然语言处理 NLP 领域也步入了 LLM 时代,谷歌出品的 Bert 模型横空出世,碾压了以往的所有模型,直接在各种NLP的建模…

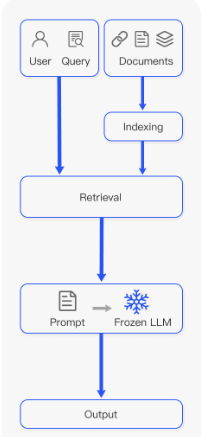

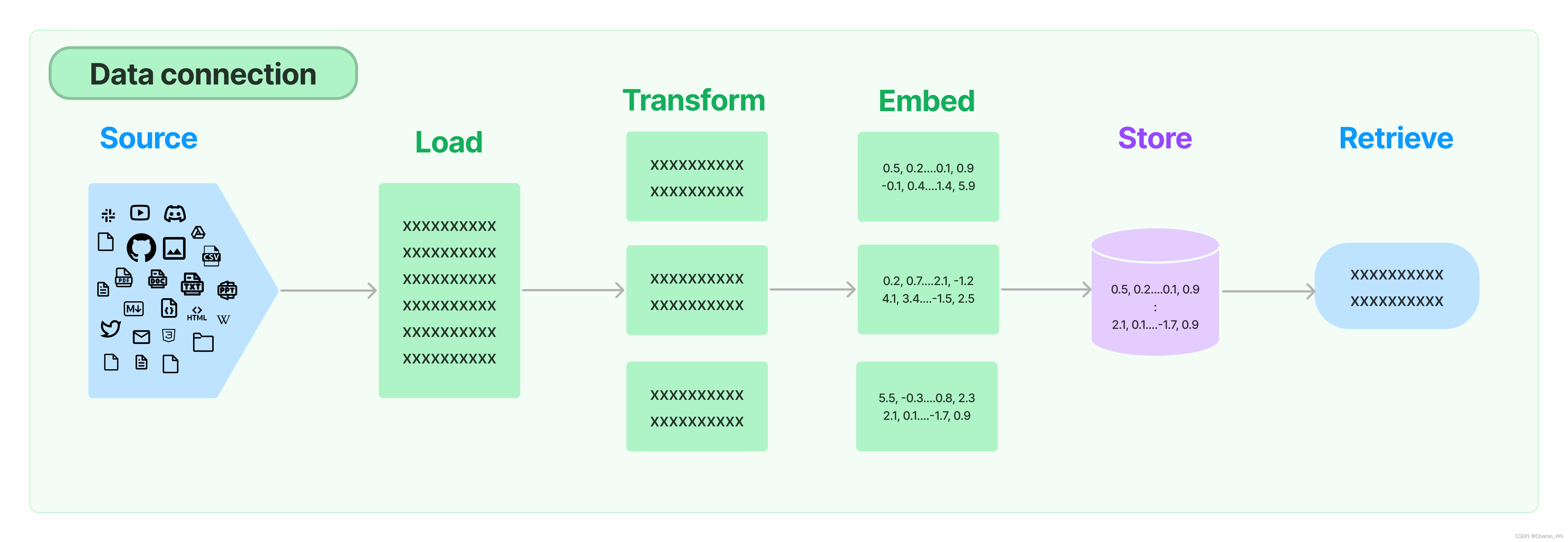

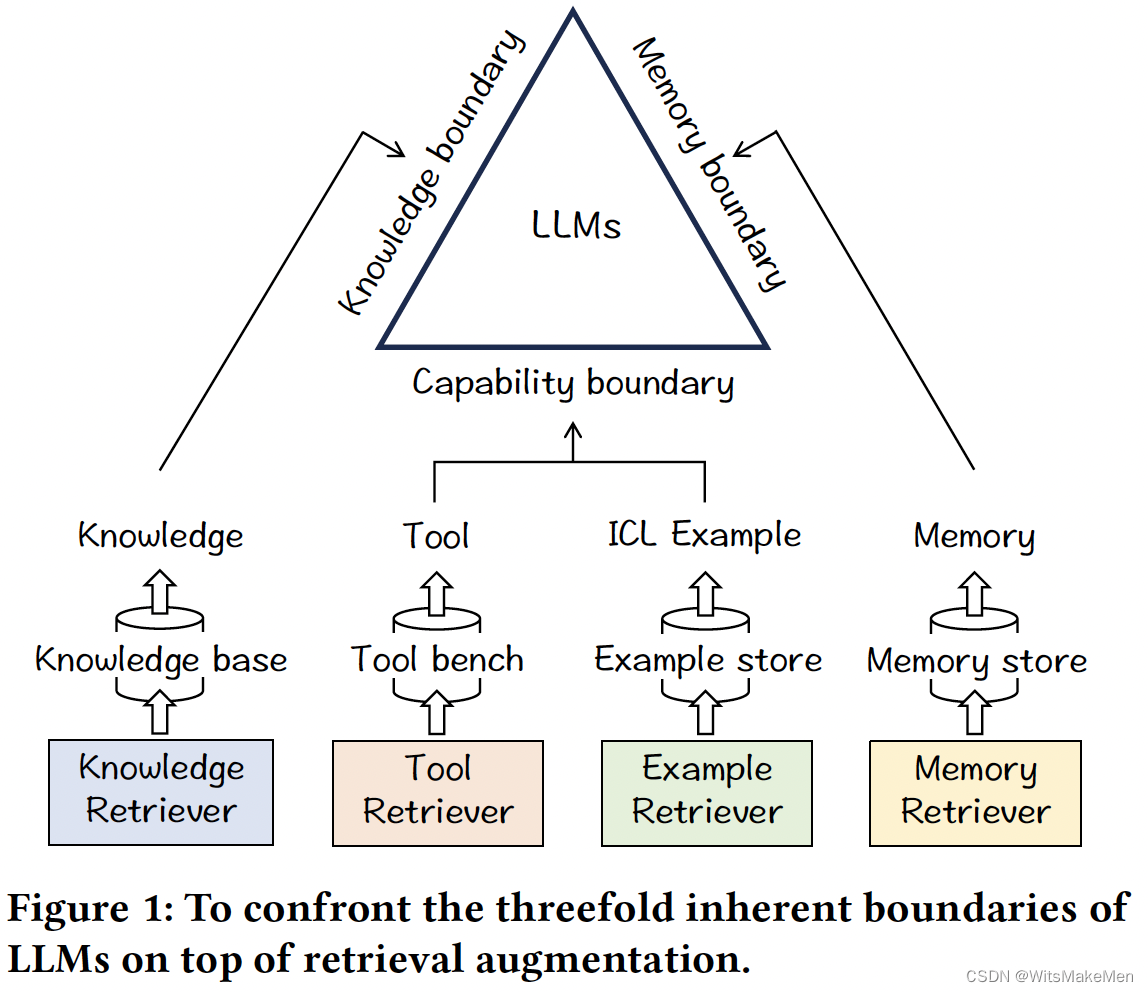

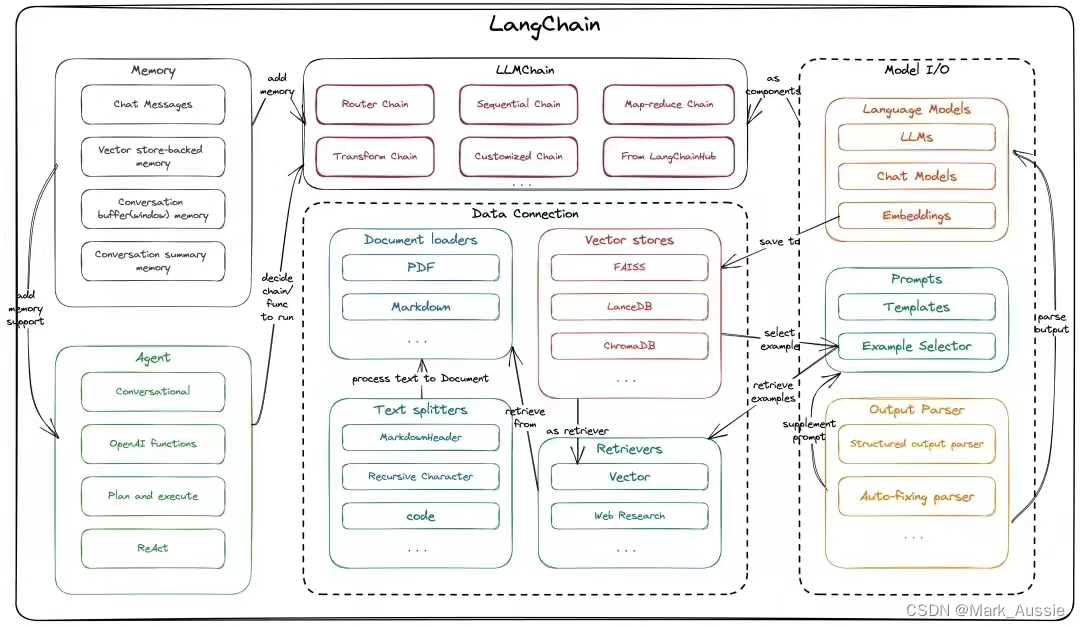

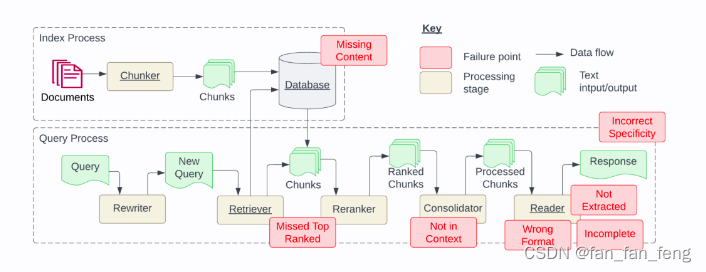

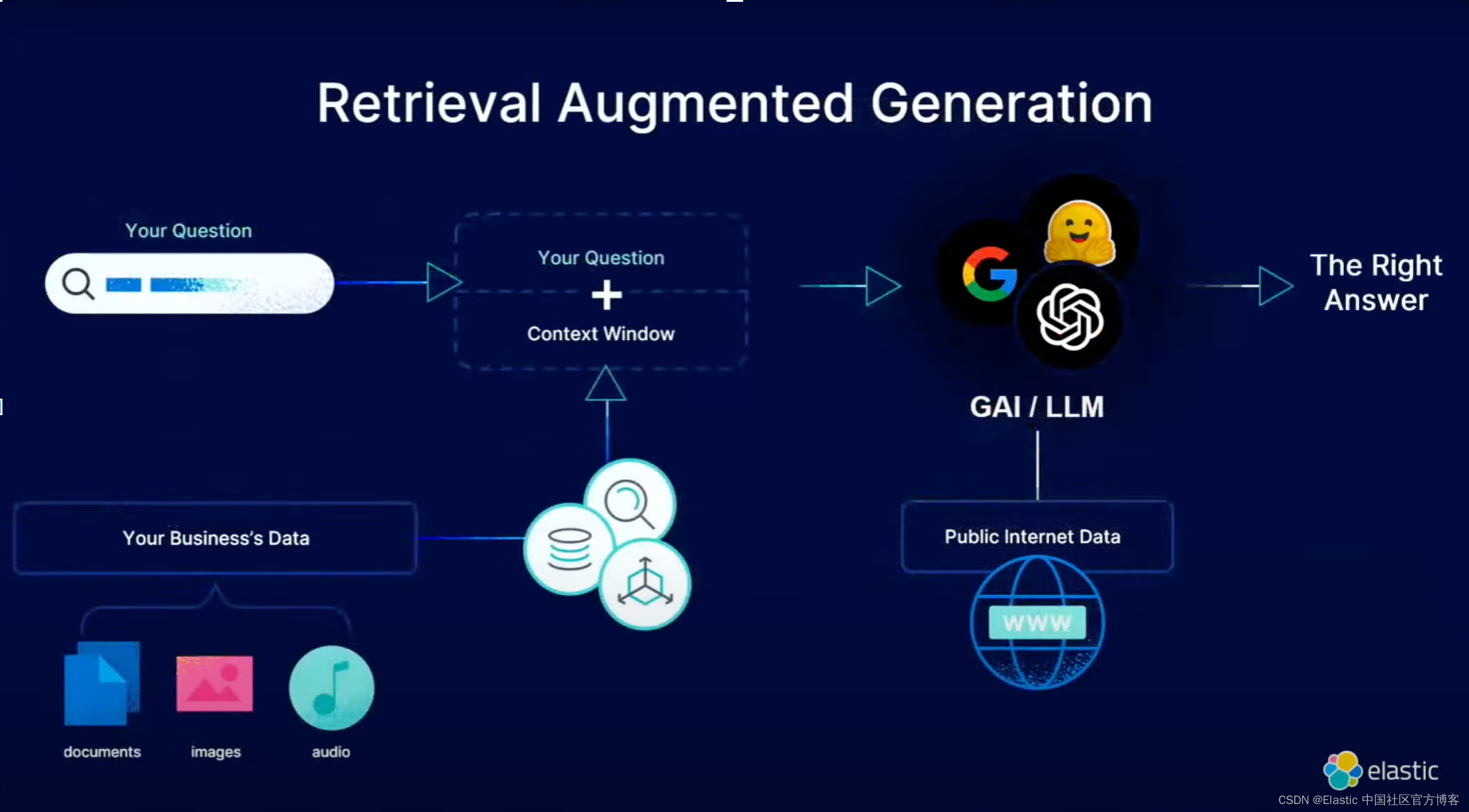

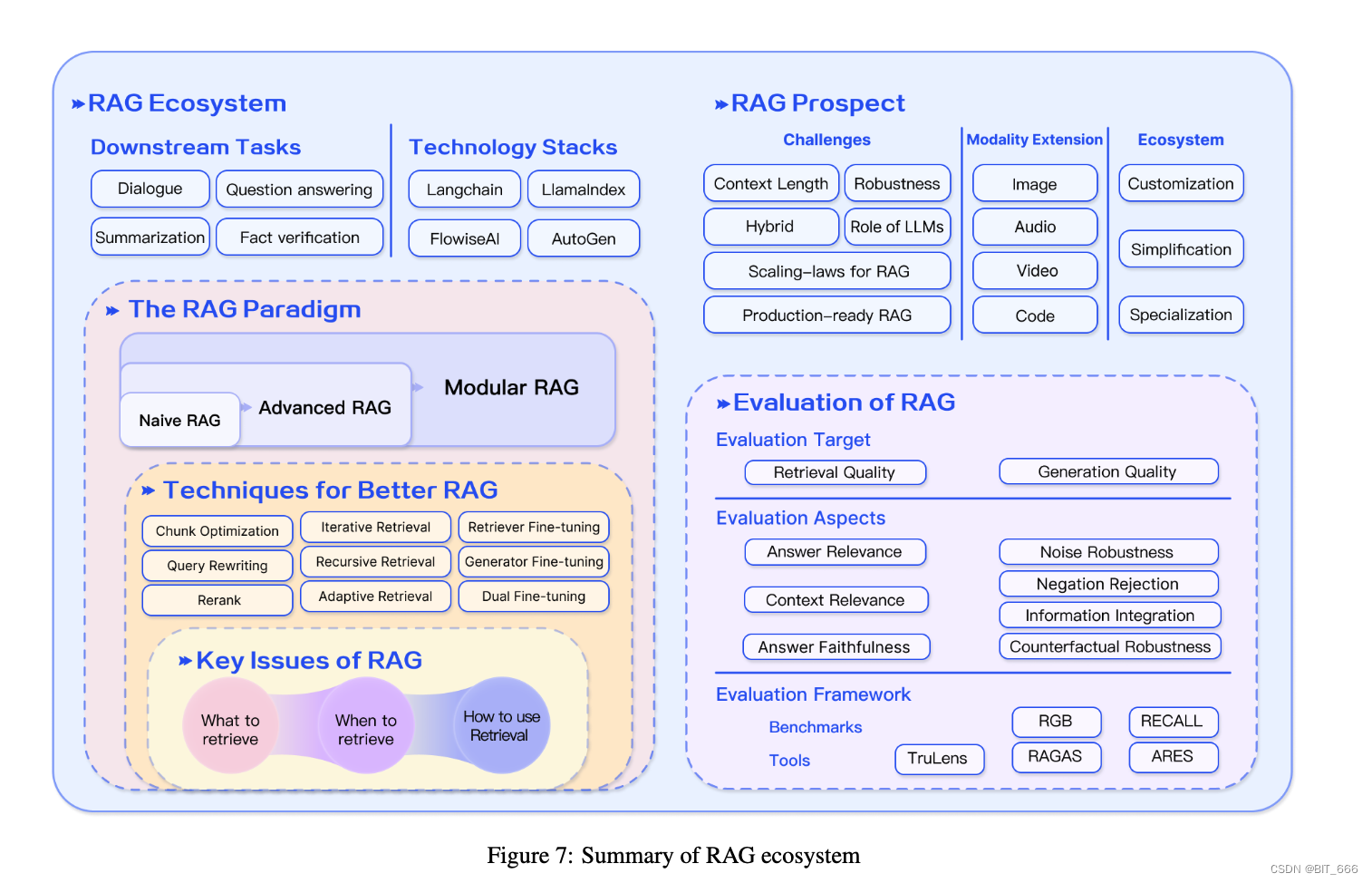

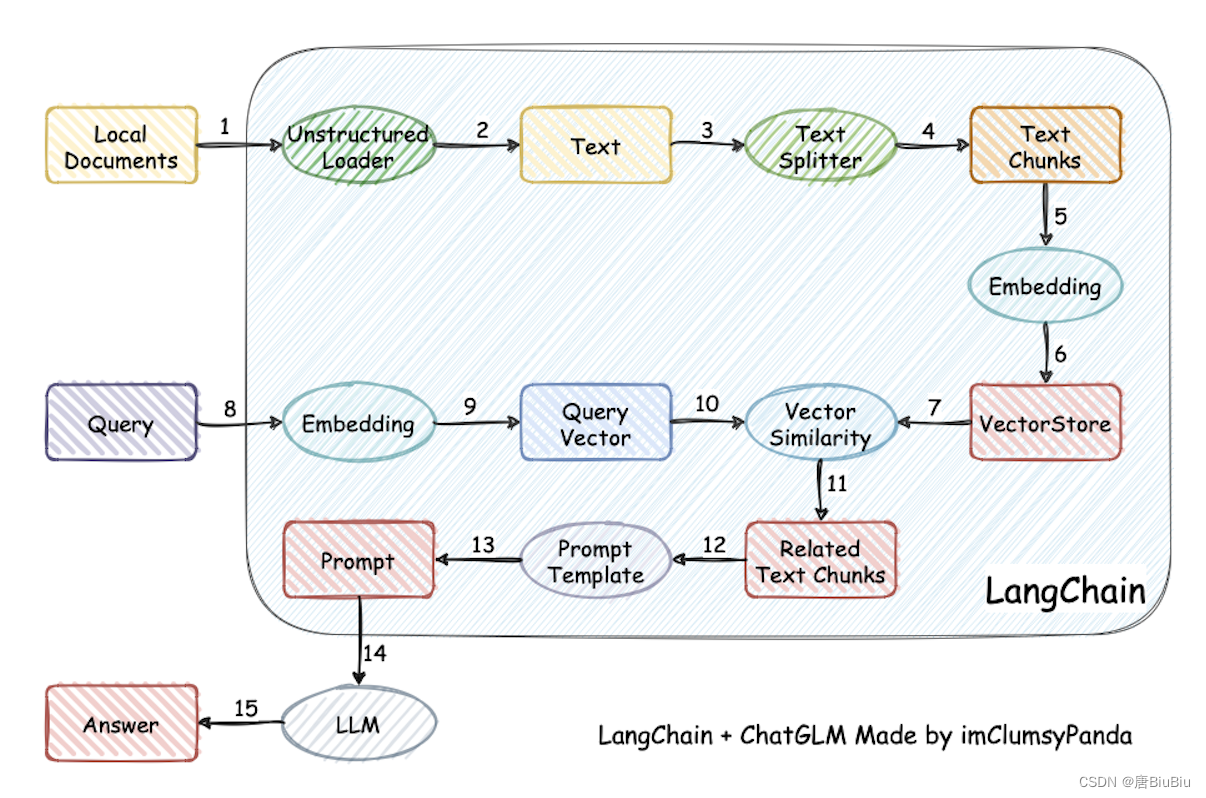

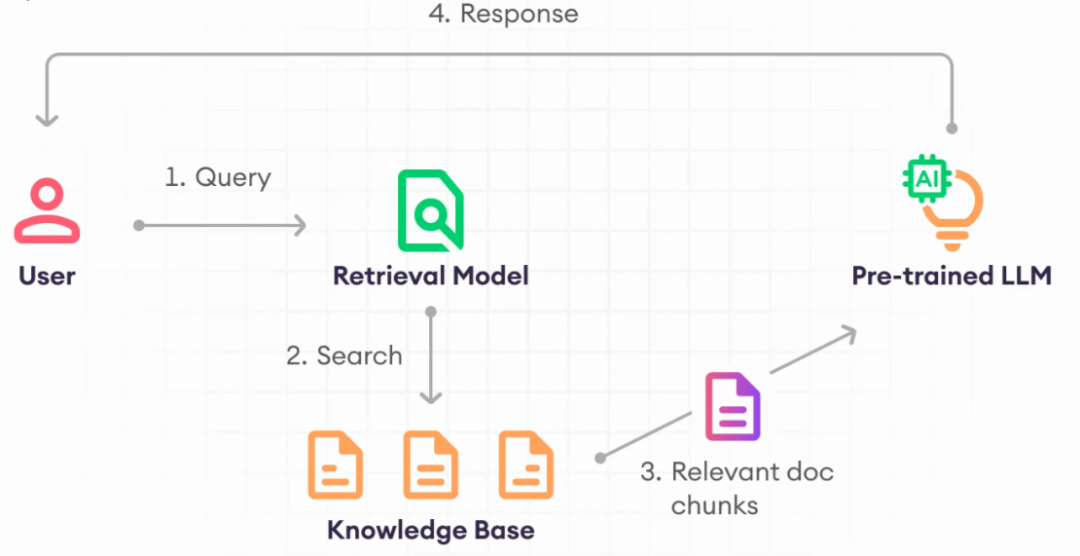

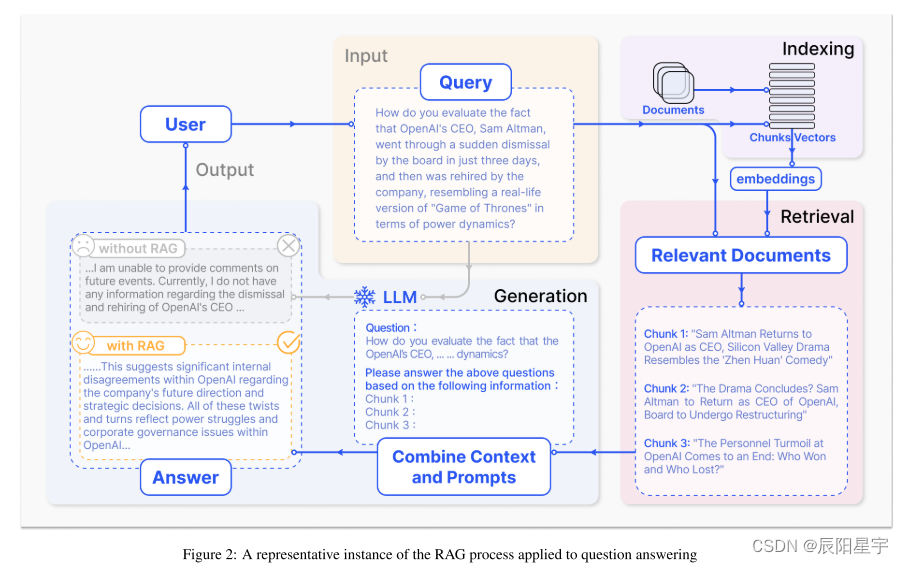

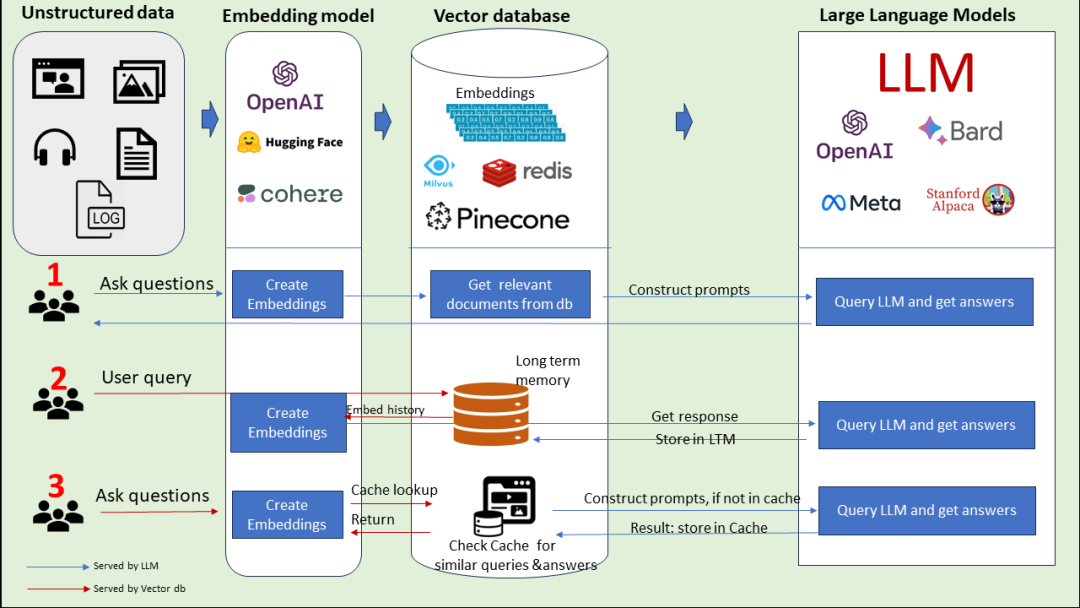

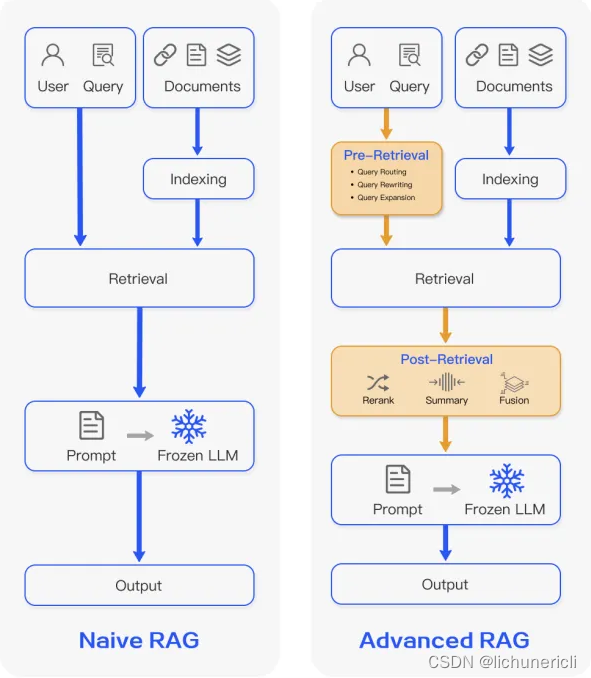

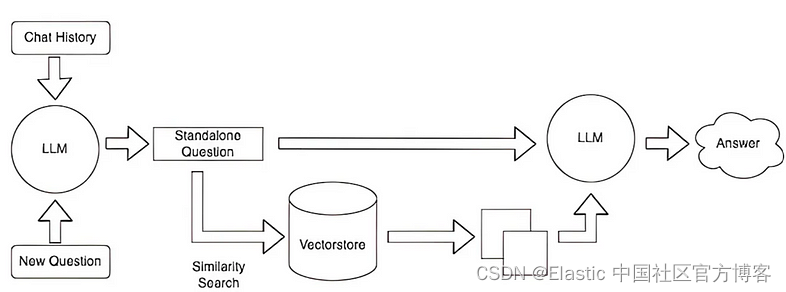

LangChain之关于RetrievalQA input_variables 的定义与使用

最近在使用LangChain来做一个LLMs和KBs结合的小Demo玩玩,也就是RAG(Retrieval Augmented Generation)。 这部分的内容其实在LangChain的官网已经给出了流程图。 我这里就直接偷懒了,准备对Webui的项目进行复刻练习,那么…

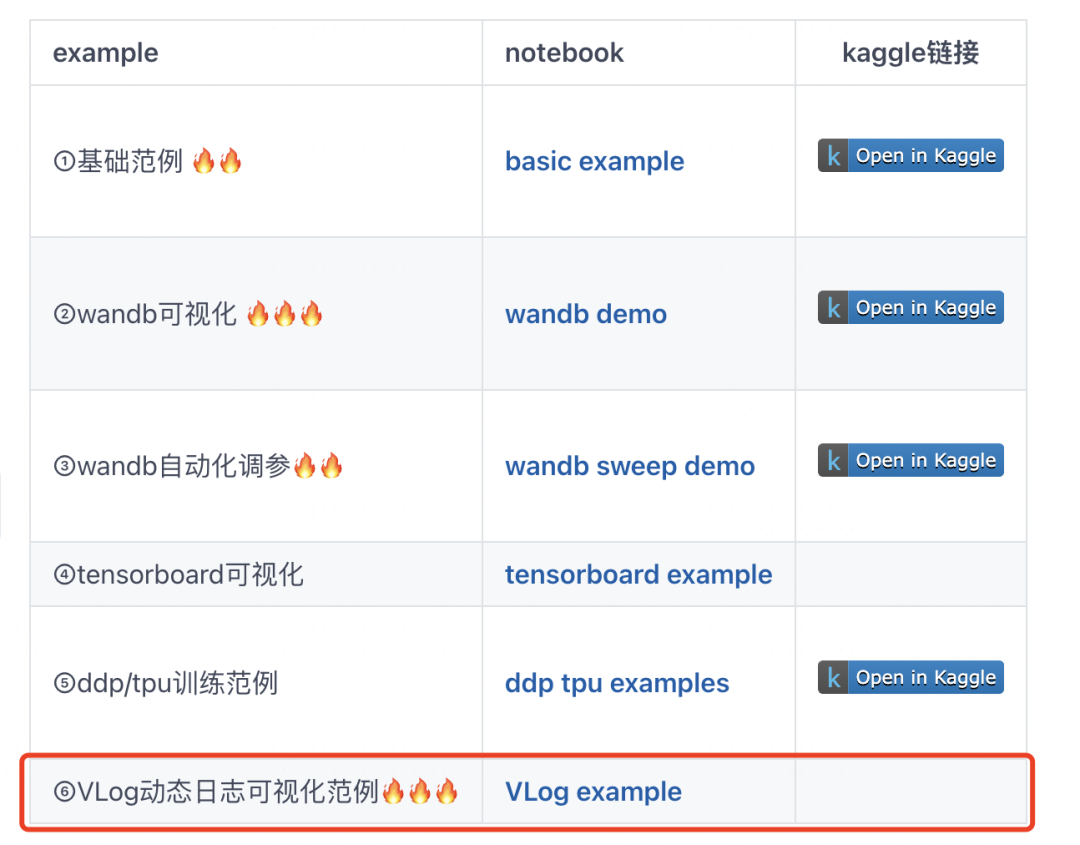

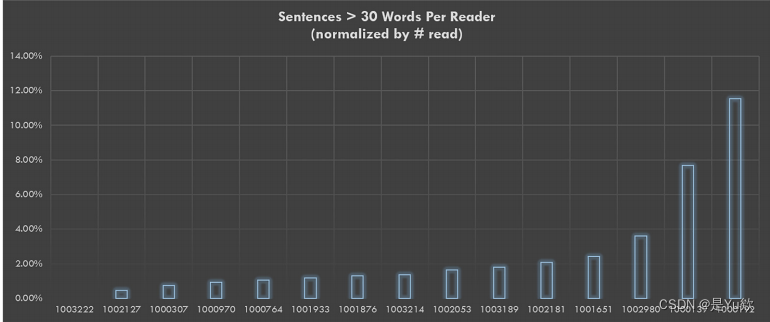

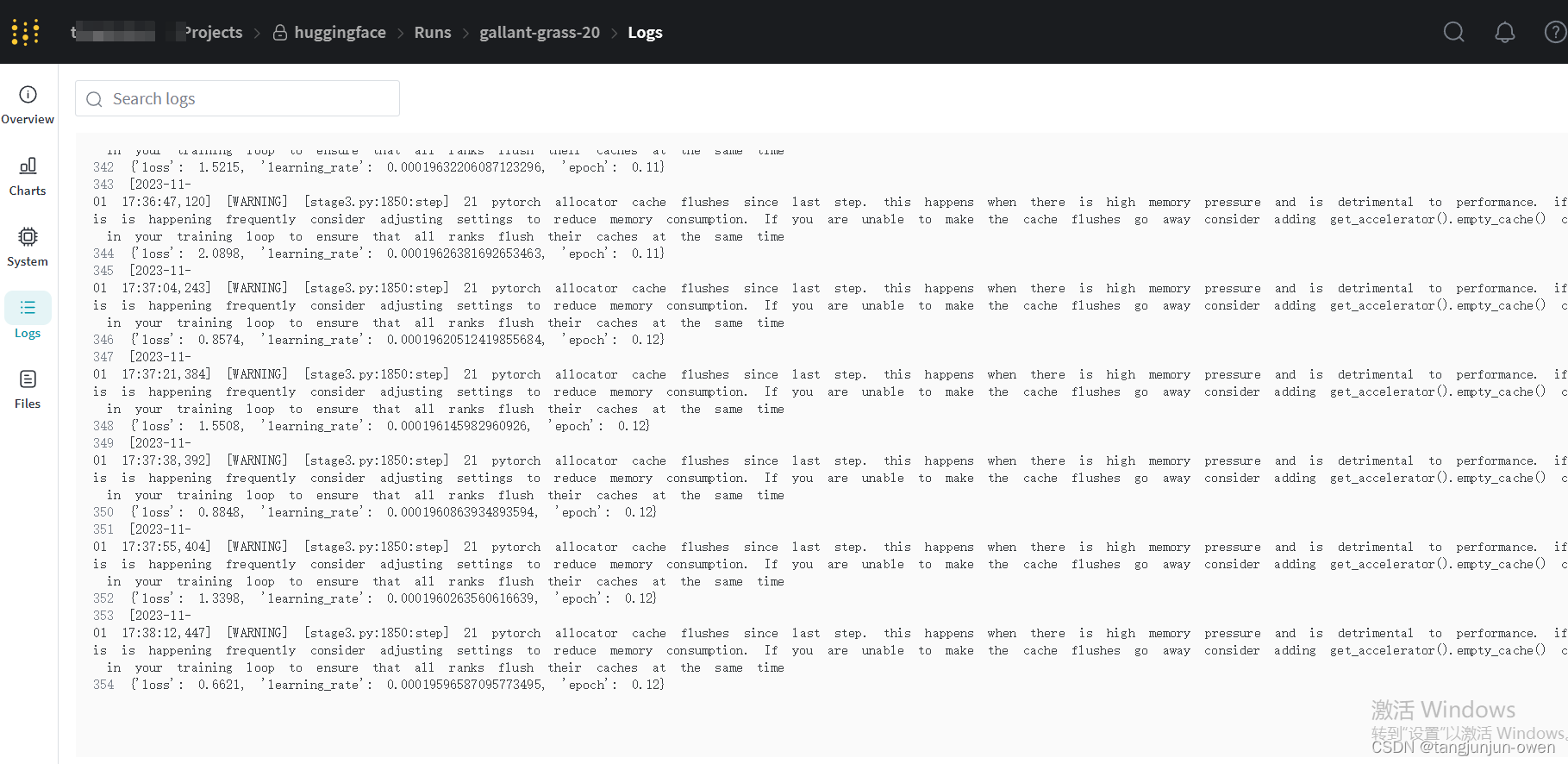

训练日志刷屏使我痛苦,我开发了VLog

训练日志刷屏使我痛苦,我开发了VLog,可以在任意训练代码中轻松使用~ 例如,通过callback嵌入到lightgbm/catboost/transformers/ultralytics,乃至keras库的训练代码流程中~ before: after: 为什么不用tensorboard或者wa…

大模型基础之词表示和语言模型

【为什么要进行词表示】

为了让计算机看懂

为了计算近义词:酒店 ≈ 旅馆

为了表示词之间的关系:中国-北京≈美国-华盛顿;king-man≈queen-woman

【用同义词、上位词表示】

用“美丽”的同义词表示“美丽”:漂亮、大方、靓丽等…

数学之美:数学究竟是如何深入我们的生活

文末有这本书的知识思维导图 不鸽大家,终于把这本书读完,来分享一下读后感。《数学之美》这本书是2012年出版,作者吴军,他的书籍还有《浪潮之巅》、《格局》等也非常有名,吴军博士在语音识别、自然语言处理,…

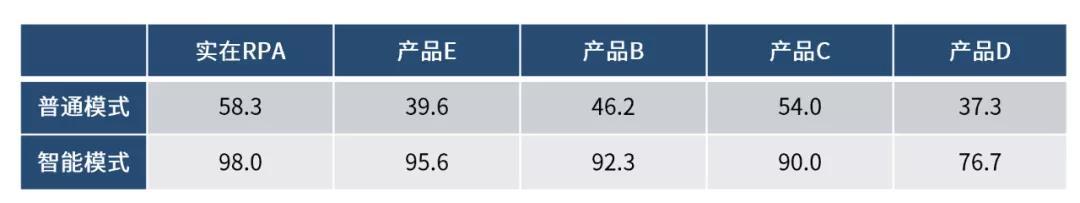

如何用实在RPA快速调用AI能力?

前文:黛玉只就宝玉手中看了一看,便问道:“还是单送我一人的,还是别的姑娘们都有呢?”周瑞家的道:“各位都有了,这两支是姑娘的了。”

Al续写:黛玉却想道:“我如今是个孤女,他们送的…

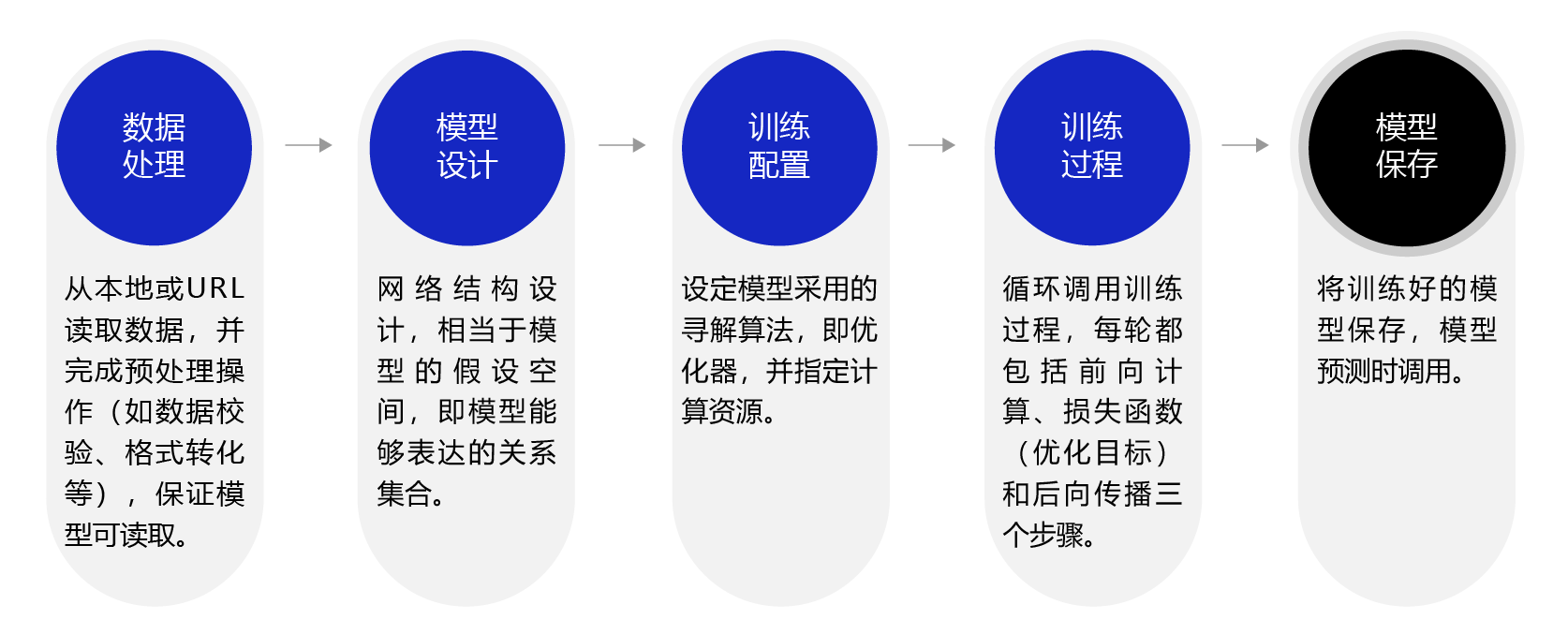

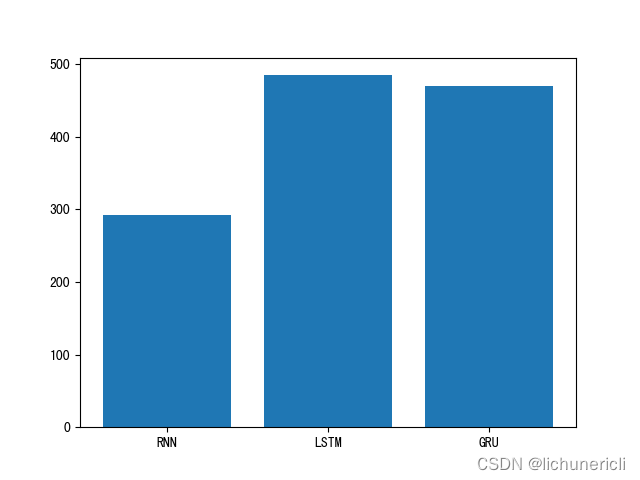

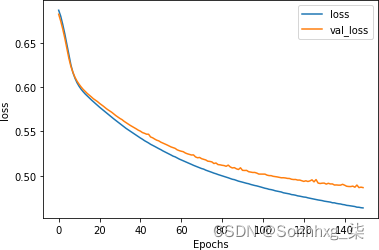

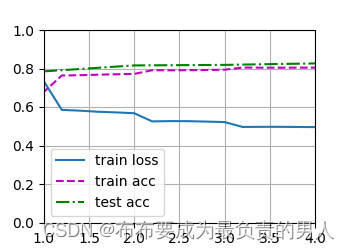

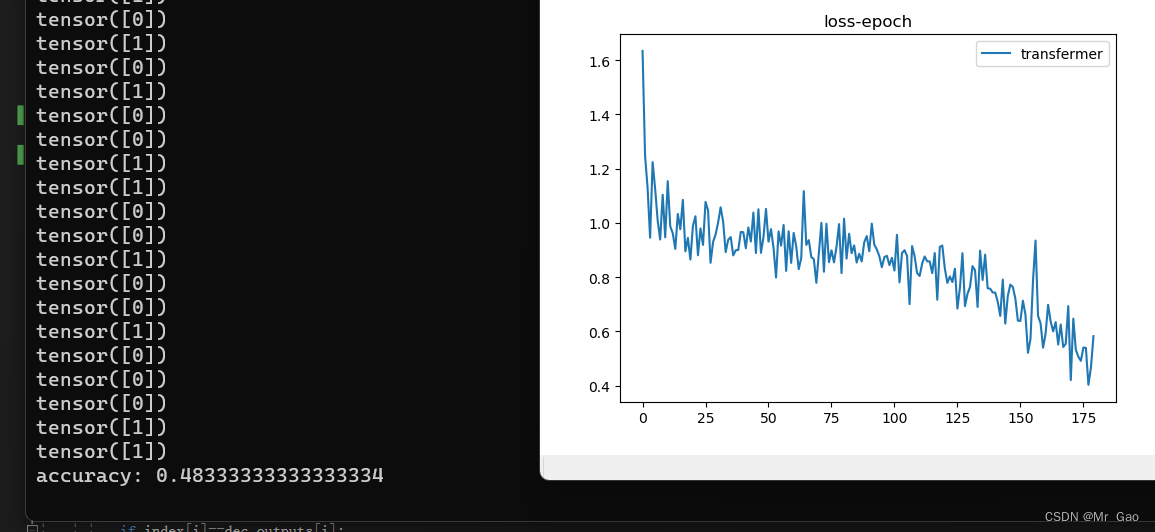

【nlp】2.5(gpu version)人名分类器实战项目(对比RNN、LSTM、GRU模型)工程管理方式

人名分类器实战项目 0 说明1 工程项目设计2 数据预处理data_processing3 创建模型model4 模型测试test5 训练配置config6 模型训练train7 模型对比绘图plotfigure8 模型预测predict9 代码测试demo0 说明

本项目对前一个博客内容2.5(cpu version) 人名分类器实战项目(对比RNN、…

[nlp] 损失缩放(Loss Scaling)loss sacle

在深度学习中,由于浮点数的精度限制,当模型参数非常大时,会出现数值溢出的问题,这可能会导致模型训练不稳定。为了解决这个问题,损失缩放(Loss Scaling)技术被引入,它通过缩放损失值来解决这个问题。

在深度学习中,损失缩放技术通常是通过将梯度进行缩放来实现的。具…

论文笔记 ACL 2019|Matching the Blanks: Distributional Similarity for Relation Learning

文章目录1 简介1.1 创新2 方法3 学习方法4 实验1 简介

论文题目:Matching the Blanks: Distributional Similarity for Relation Learning 论文来源:ACL 2019 论文链接:https://arxiv.org/pdf/1906.03158.pdf 代码链接:https://g…

移动云排名第二,2019年云综合收入474亿元

云排名分析:移动云排名第二,2019年云综合收入474亿元。

运营商从事公有云及相关业务,有着天然的网络资源与数据中心资源,只是在公有云战略启动上,相对于AWS、阿里云等这样的公有云头牌来说,比较晚了一些。…

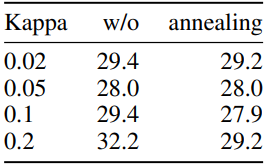

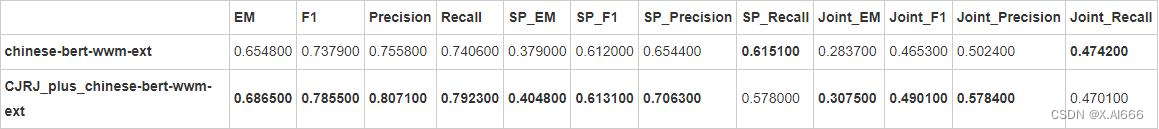

论文笔记 AAAI 2020|DCMN+: Dual Co-Matching Network for Multi-choice Reading Comprehension

文章目录1 简介1.1 动机1.2 创新2 方法3 实验1 简介

论文题目:DCMN: Dual Co-Matching Network for Multi-choice Reading Comprehension 论文来源:AAAI 2020 论文链接:https://arxiv.org/pdf/1908.11511.pdf 代码链接:https://g…

人工智能不仅应当提高物质福利,而且应当满足人类的精神需求

然而,遵循阿西莫夫三定律而建造的人工智能或者机器人是奴隶般的,它们在社会上运行可以帮助人类整体,但它们奴隶般的地位是我们人类希望的吗?这是技术社会的理想形态吗?弗洛里迪说:“允许人类和智能陪伴做朋…

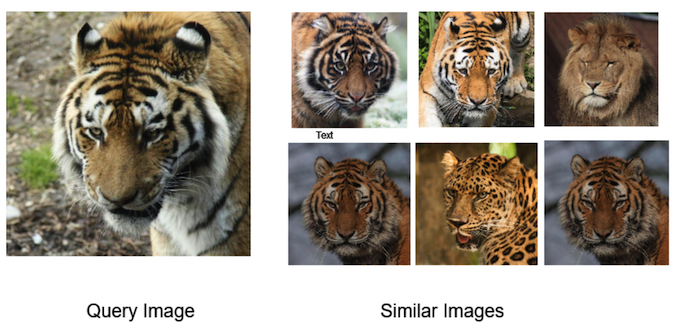

美团·阿里关于多模态召回的应用实践

1. 美团多模态召回-搜索业务应用

多模态的召回任务,主要在召回和排序列表中存在POI、图片、文本、视频等多种模态结果,如何保证Query和多模态搜索结果的相关性面临着很大的挑战,目前更多的多模态召回主要应用于电商,短视频推荐搜…

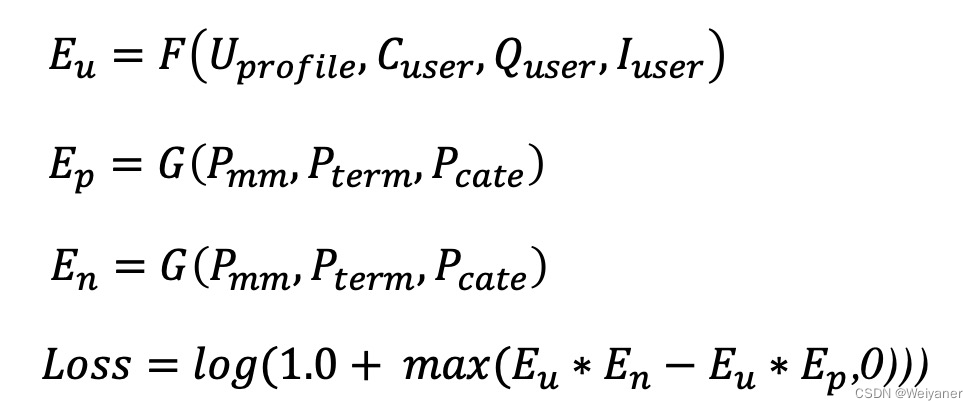

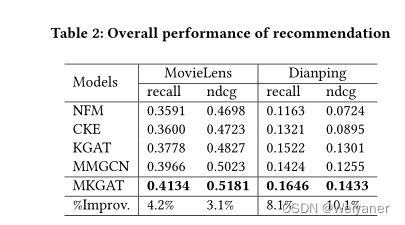

Multi-modal Knowledge Graphs for Recommender Systems论文解读

美团2020年发表的《Multi-modal Knowledge Graphs for Recommender Systems》

https://zheng-kai.com/paper/cikm_2020_sun.pdf

1 背景

知识图通过引用各种有效的辅助数据用于推荐系统,有效的解决了推荐系统的冷启动和数据稀疏性问题。

但是一般的知识图没有考虑…

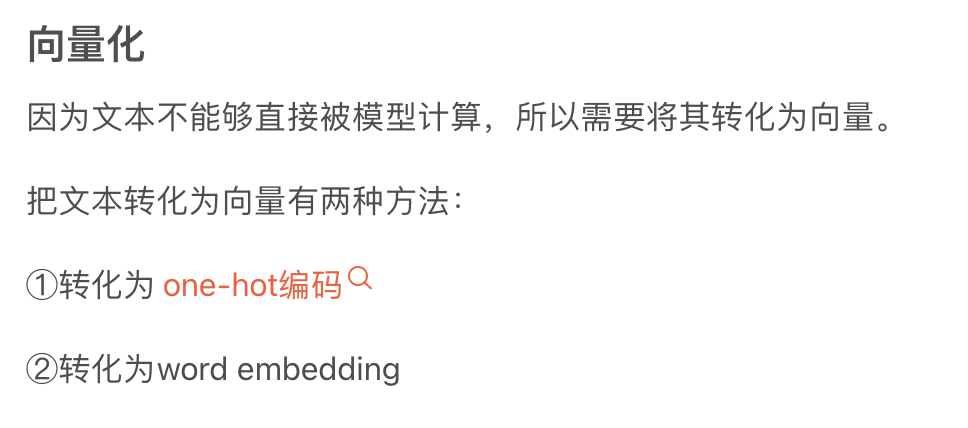

onehot-词嵌入-图嵌入

目录

一、为什么要有词嵌入?

二、one-hot编码:

三、什么是词嵌入(word embedding)

1、什么是嵌入矩阵?

2、为什么要设置维数?

3、相比one-hot编码的优点

4、什么是word2vec和GLove?

四、…

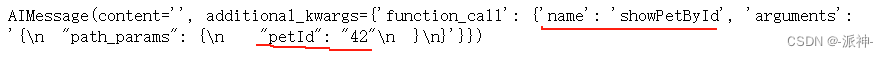

LangChain的函数,工具和代理(三):LangChain中轻松实现OpenAI函数调用

在我之前写的两篇博客中:OpenAI的函数调用,LangChain的表达式语言(LCEL)中介绍了如何利用openai的api来实现函数调用功能,以及在langchain中如何实现openai的函数调用功能,在这两篇博客中,我们都需要手动去创建一个结构比较复杂的函数描述变量…

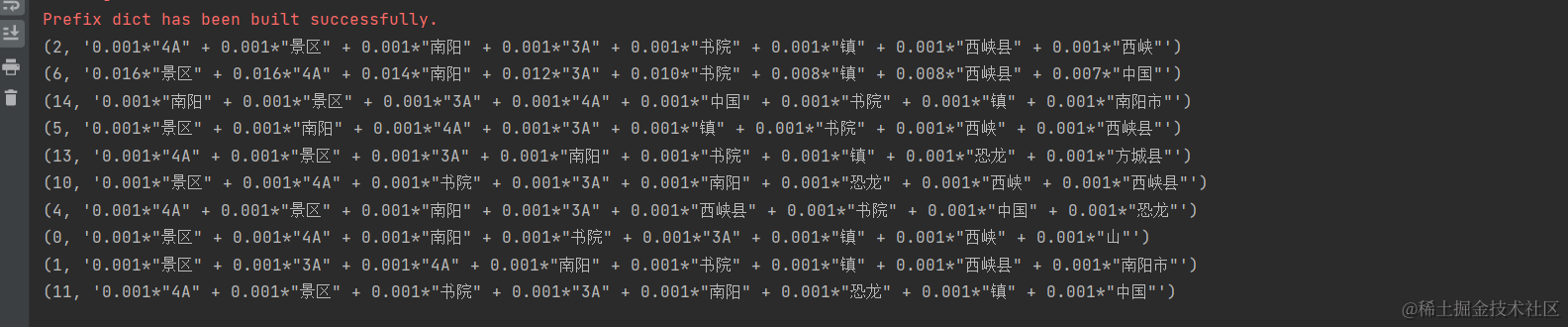

中文短文本关键词抽取方案

目录1. 前言2. 数据3. 方案3.1 SIFRank3.2 NegSamplingNER4. 代码1. 前言 本文提出一种中文短文本关键词抽取方案,适用于无监督语料场景。 无监督关键词抽取算法虽然无需标注语料,但是效果一般。有监督学习方法效果好但是需要标注数据,很…

A Survey of Knowledge-Enhanced Pre-trained Language Models

本文是LLM系列的文章,针对《A Survey of Knowledge-Enhanced Pre-trained Language Models》的翻译。 知识增强的预训练语言模型综述 摘要1 引言2 背景3 KE-PLMs用于NLU4 KE-PLMs用于NLG5 未来的方向5.1 整合来自同质和异质来源的知识5.2 探索多模态知识5.3 提供可…

举例说明自然语言处理(NLP)技术。

本文章由AI生成!

以下是自然语言处理(NLP)技术的一些例子: 机器翻译:将一种语言翻译成另一种语言的自动化过程。常见的机器翻译系统包括谷歌翻译,百度翻译等。 语音识别:将口头语言转换成文本…

英语作文常用的 28 个实用句型, 干货收藏

这里写目录标题1. 英语作文常用的 28 个实用句型, 干货收藏1.1. the most 形容词 名词 (that) 主词 have everseen(known/heard/had/read, etc.)1.2. Nothing iser than toV Nothing ismore 形容词 than toV1.3. cannot emphasize the importance of~~~too much1.4. There…

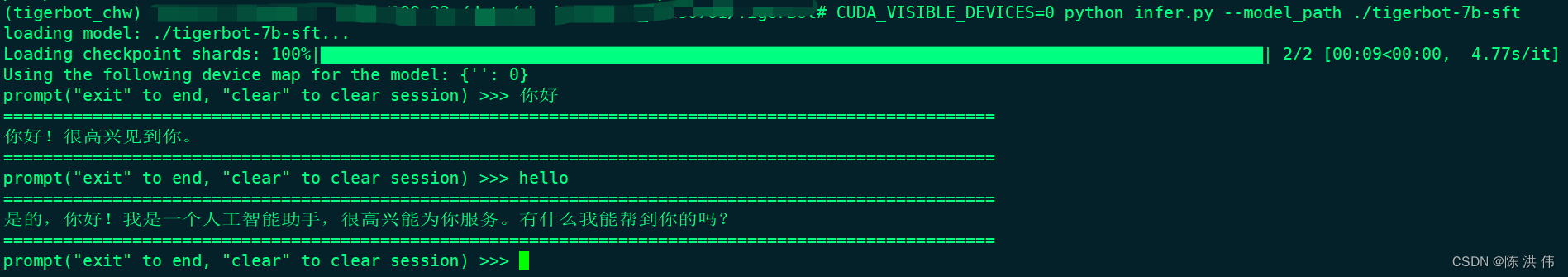

TigerBot大语言模型

虎博科技”发布自研多模态大模型TigerBot,开源模型、代码及数据,今天先搭建环境体验一下他的大模型,在github上找到:GitHub - TigerResearch/TigerBot: TigerBot: A multi-language multi-task LLM 1 环境安装

conda create --na…

论文笔记 ACL 2021|Capturing Event Argument Interaction via A Bi-Directional Entity-Level Recurrent Decod

文章目录1 简介1.1 动机1.2 创新2 方法3 实验1 简介

论文题目:Capturing Event Argument Interaction via A Bi-Directional Entity-Level Recurrent Decoder 论文来源:ACL 2021 论文链接:https://aclanthology.org/2021.acl-long.18.pdf

1…

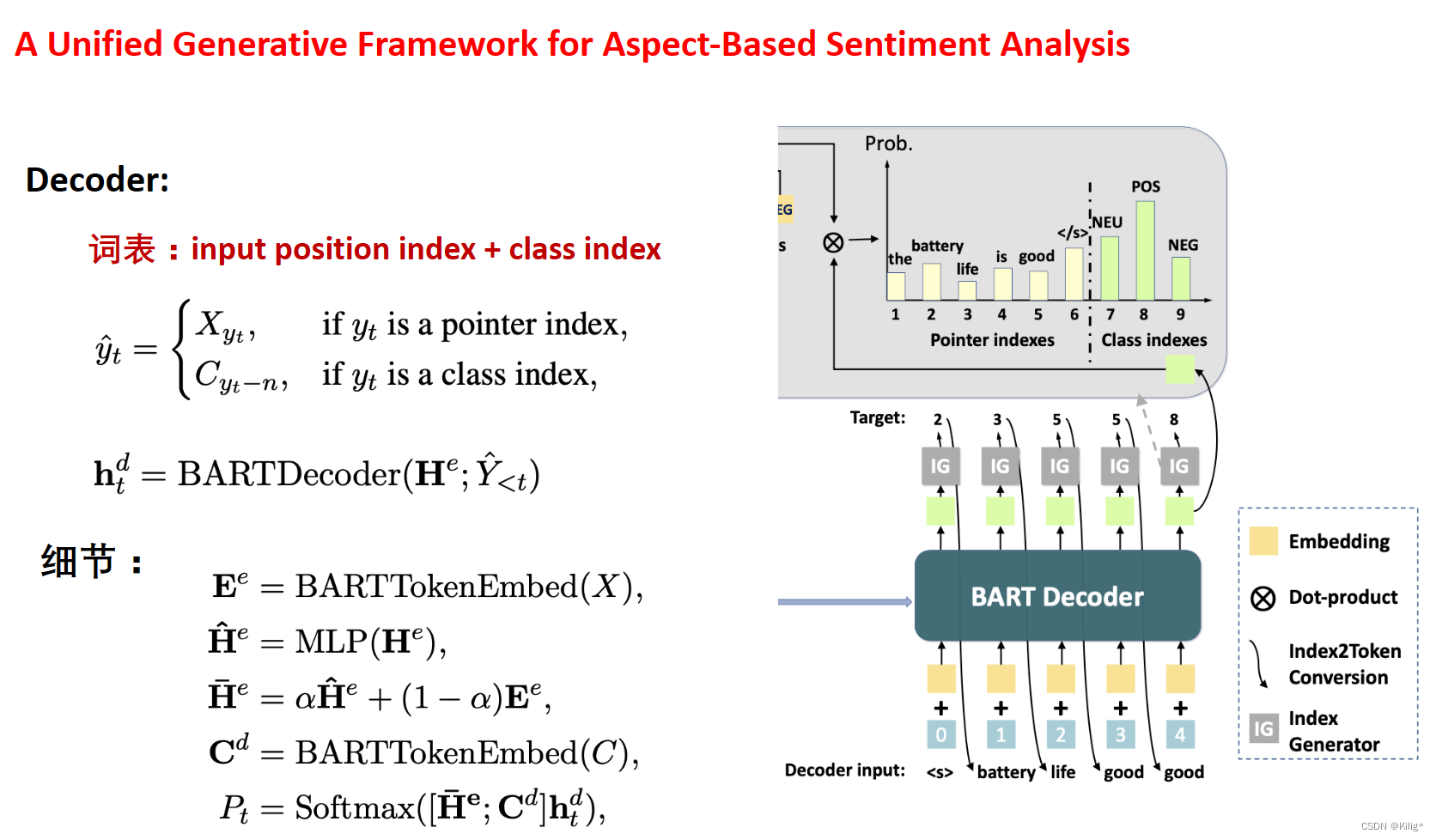

论文笔记 NAACL 2021|Document-Level Event Argument Extraction by Conditional Generation

文章目录1 简介1.1 动机1.2 创新2 方法2.1 论元抽取模型2.2 基于关键词的触发词抽取模型3 实验1 简介

论文题目:Document-Level Event Argument Extraction by Conditional Generation 论文来源:NAACL 2021 论文链接:https://arxiv.org/pdf/…

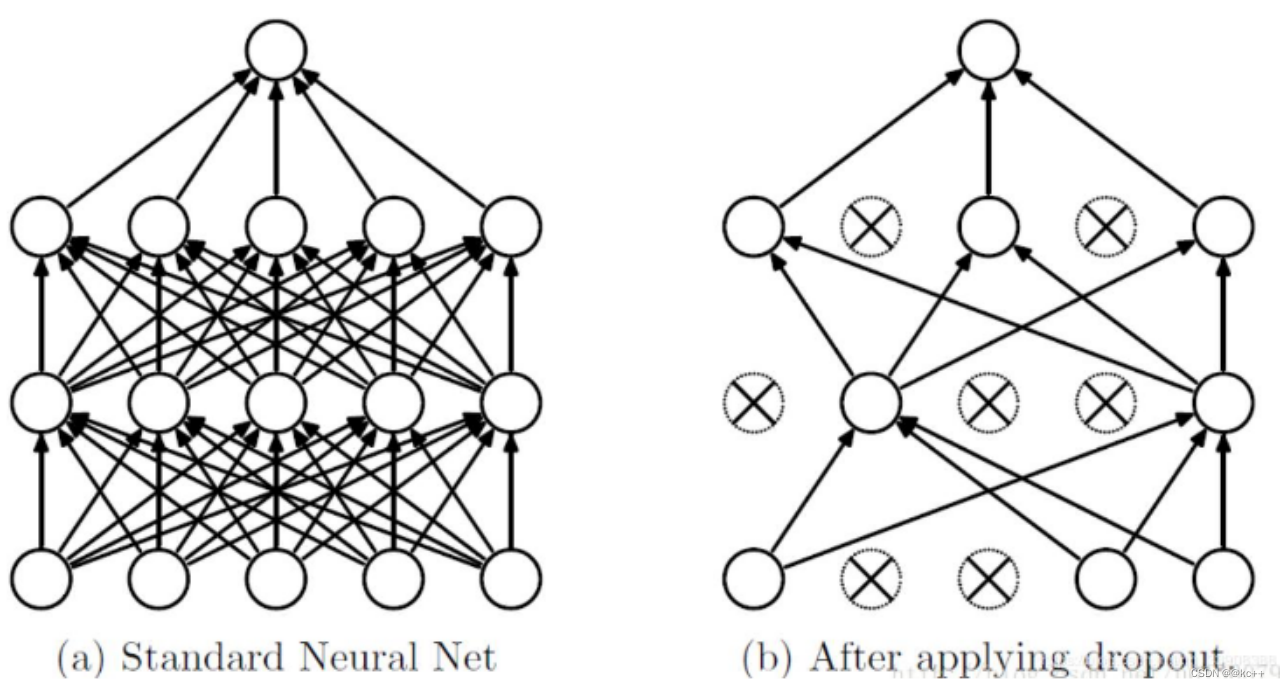

深入探讨机器学习中的过拟合现象及其解决方法

1. What❓

过拟合(Overfitting)是指在机器学习中,模型在训练集上表现较好,但在测试集或实际应用中表现较差的现象。过拟合发生时,模型过于复杂地学习了训练集中的噪声、异常值或特定模式,从而导致对新样本…

吃完烧烤拉肚子,如何才能通过 AI 让自己在夏天远离「食物中毒」?

原创:HyperAI超神经 关键词:食源性疾病 自然语言处理 计算机视觉 食品安全 夏天到了,晚上下班路上总会路过各种小吃摊,烤面筋、炸串、烧烤、海鲜、关东煮……地铁到家的距离简直可以称得上是「走过诱惑的街」。 饶了孩子吧&#x…

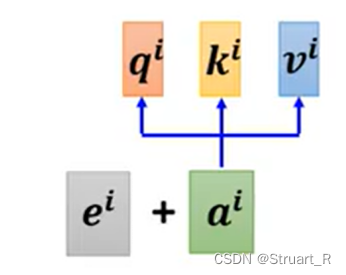

Self-attention自注意力机制——李宏毅机器学习笔记

self-attention想要解决的问题

复杂的输入 每次输入的length不同时,即Vector Set大小不同,该如何处理? one-hot encoding,缺点:所有的词汇之间没有语义资讯。 word embedding,会给每一个词汇一个向量&…

Mgeo:multi-modalgeographic language model pre-training

文章目录 question5.1 Geographic Encoder5.1.1 Encoding5.1.2 5.2 multi-modal pre-training 7 conclusionGeo-Encoder: A Chunk-Argument Bi-Encoder Framework for Chinese Geographic Re-Rankingabs ERNIE-GeoL: A Geography-and-Language Pre-trained Model and its Appli…

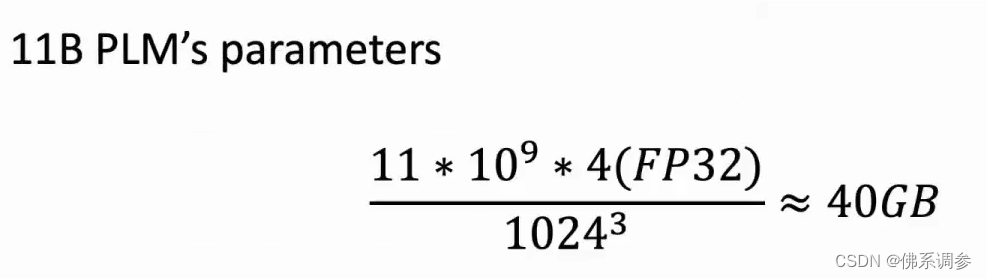

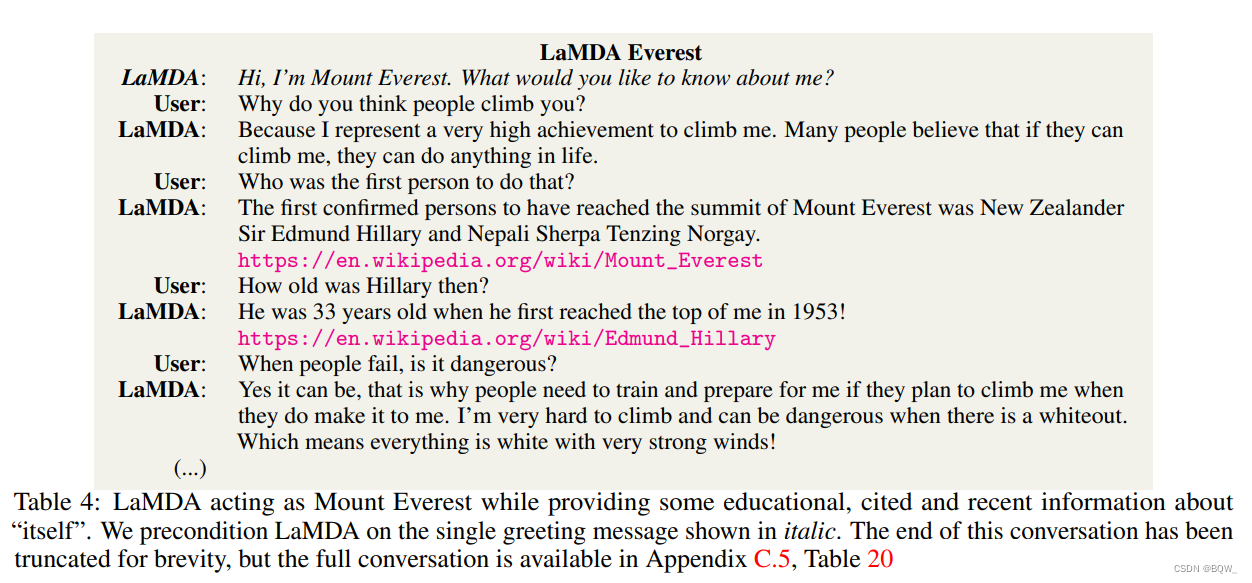

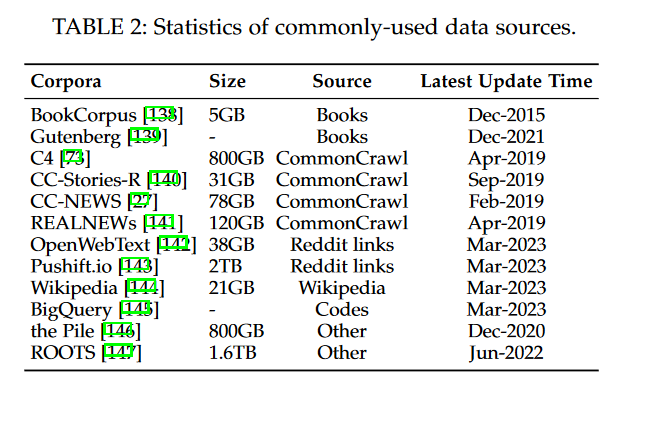

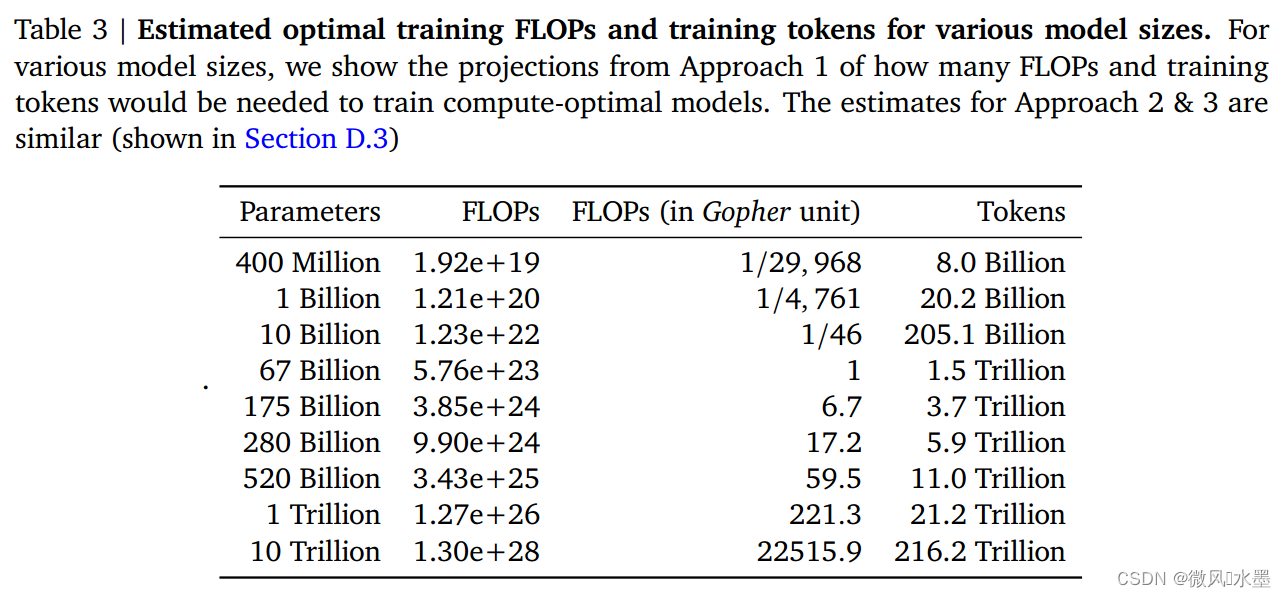

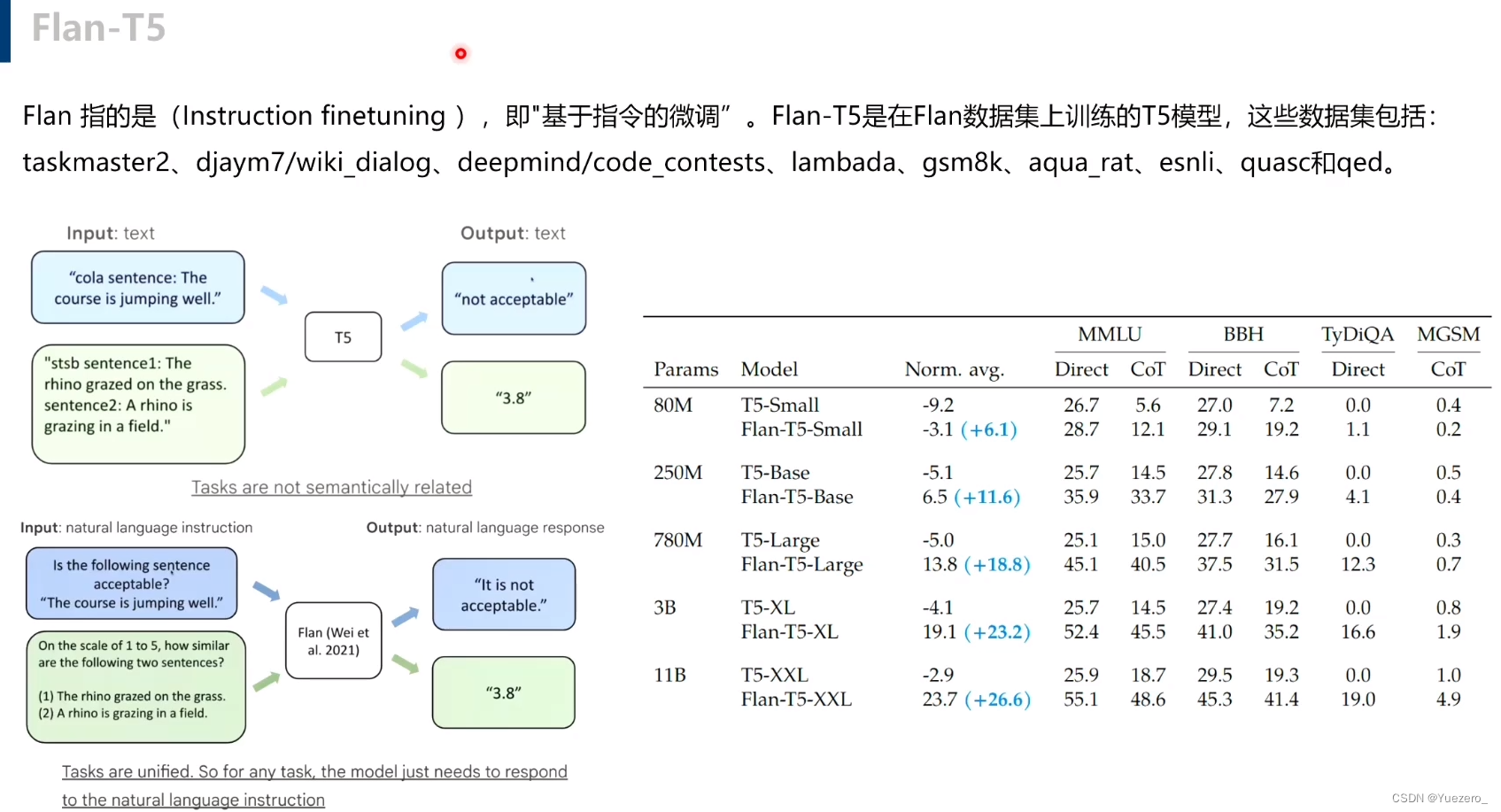

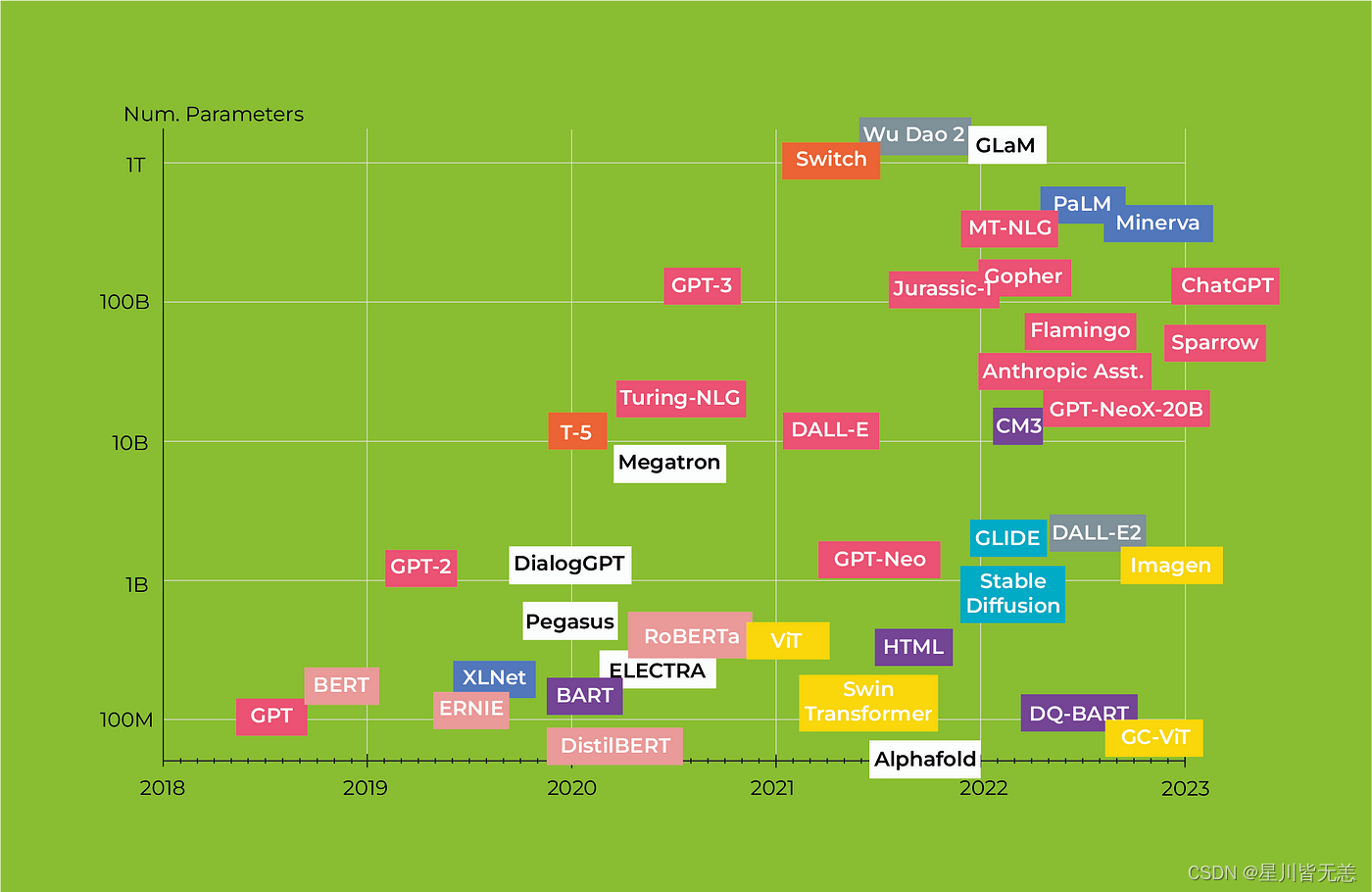

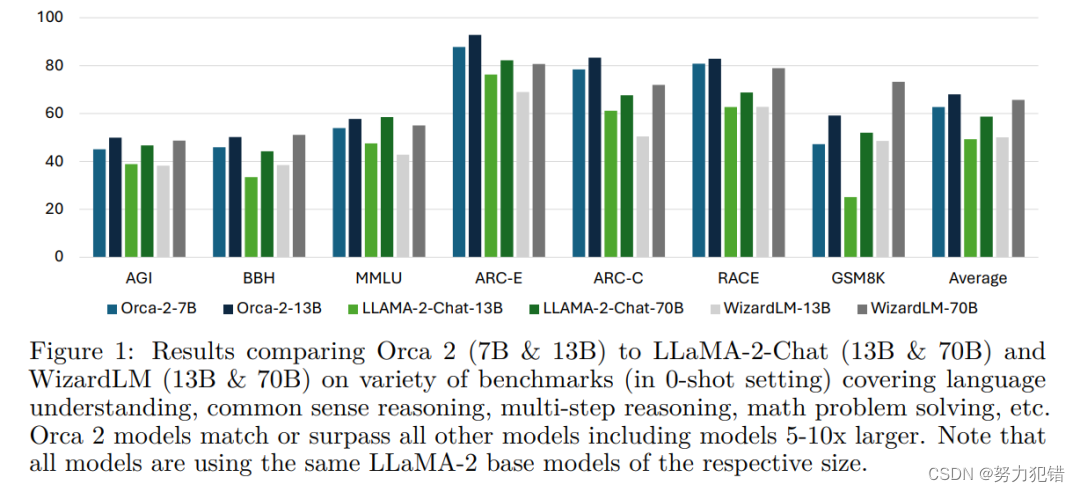

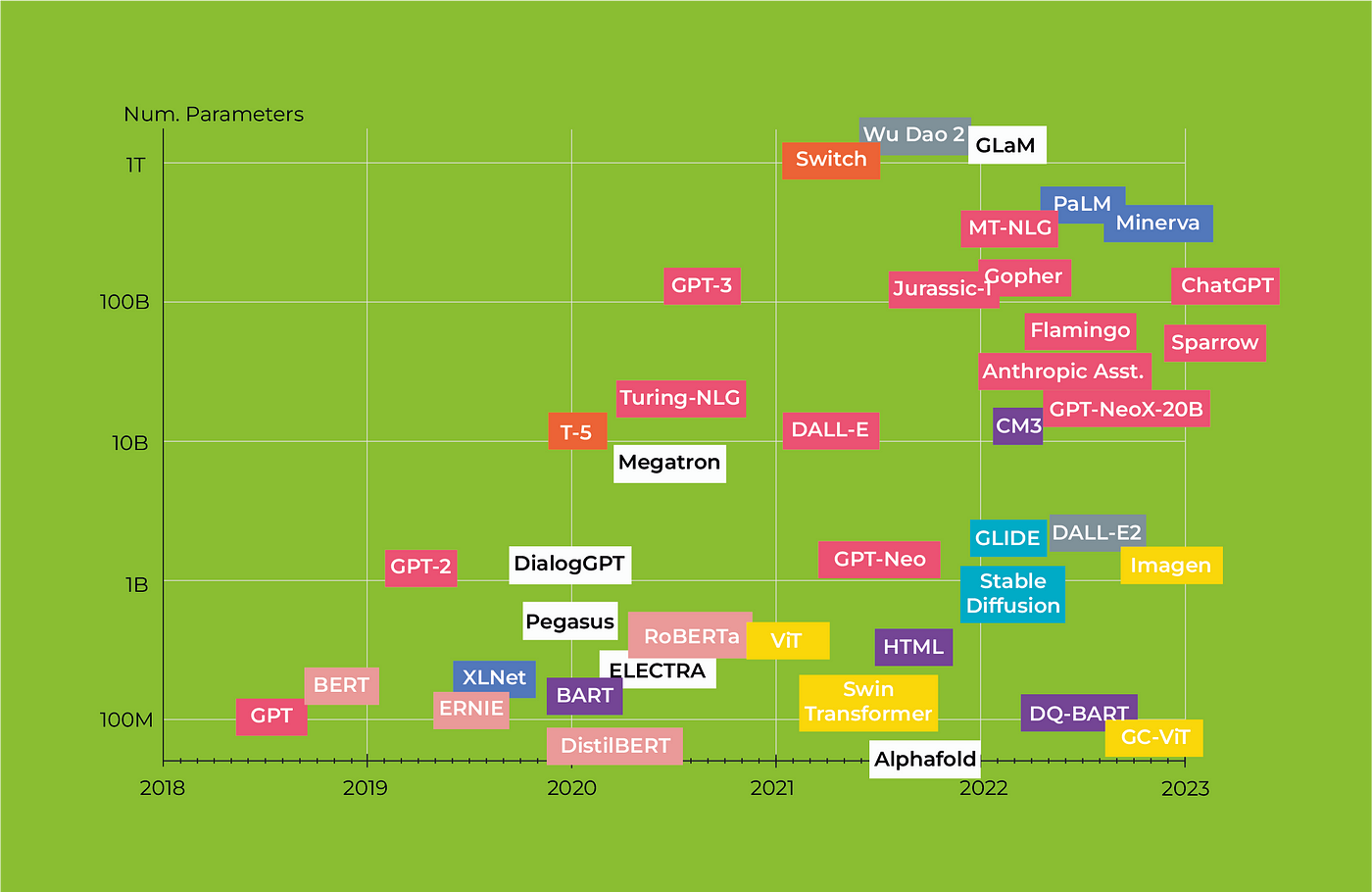

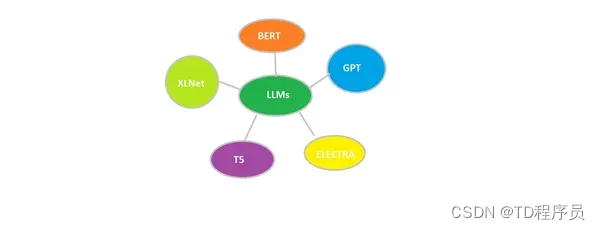

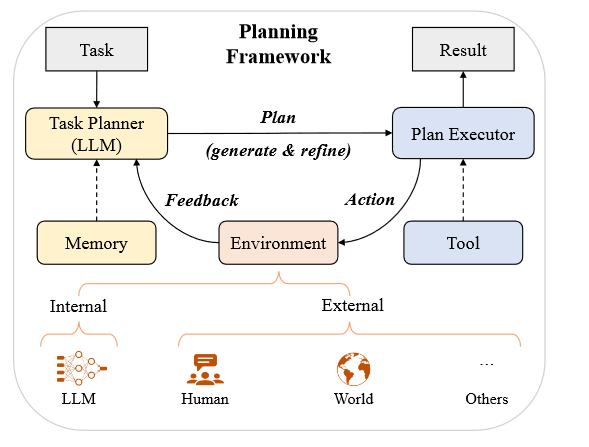

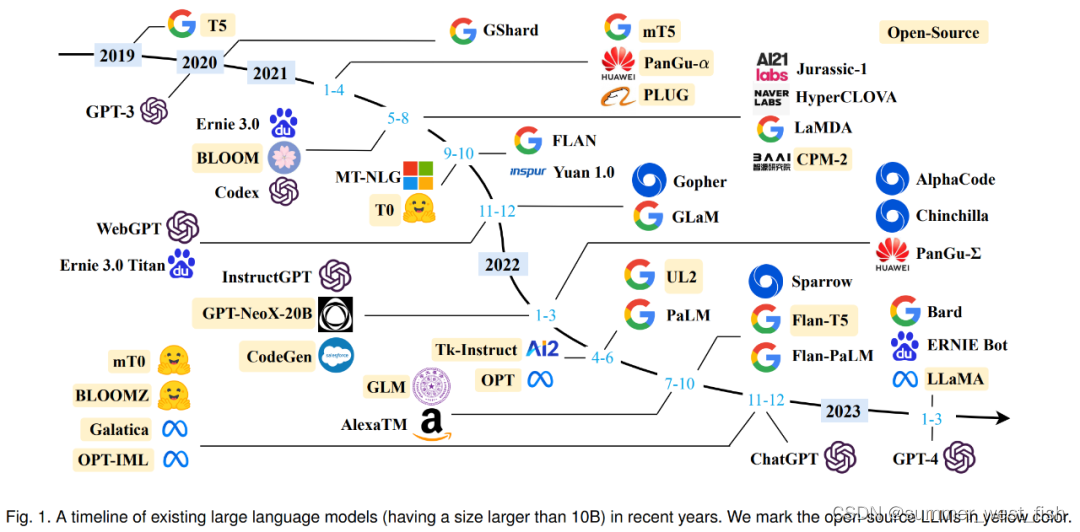

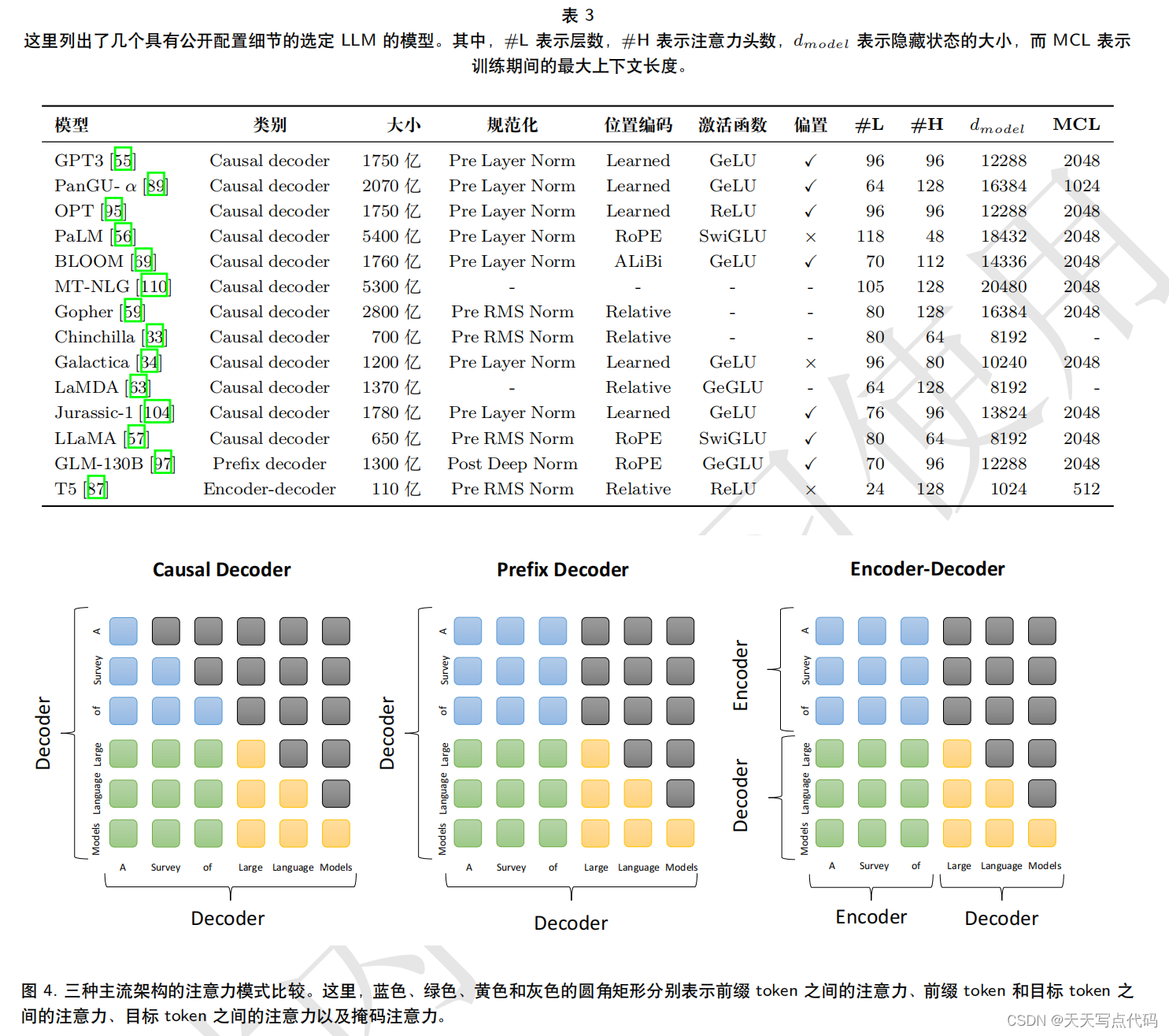

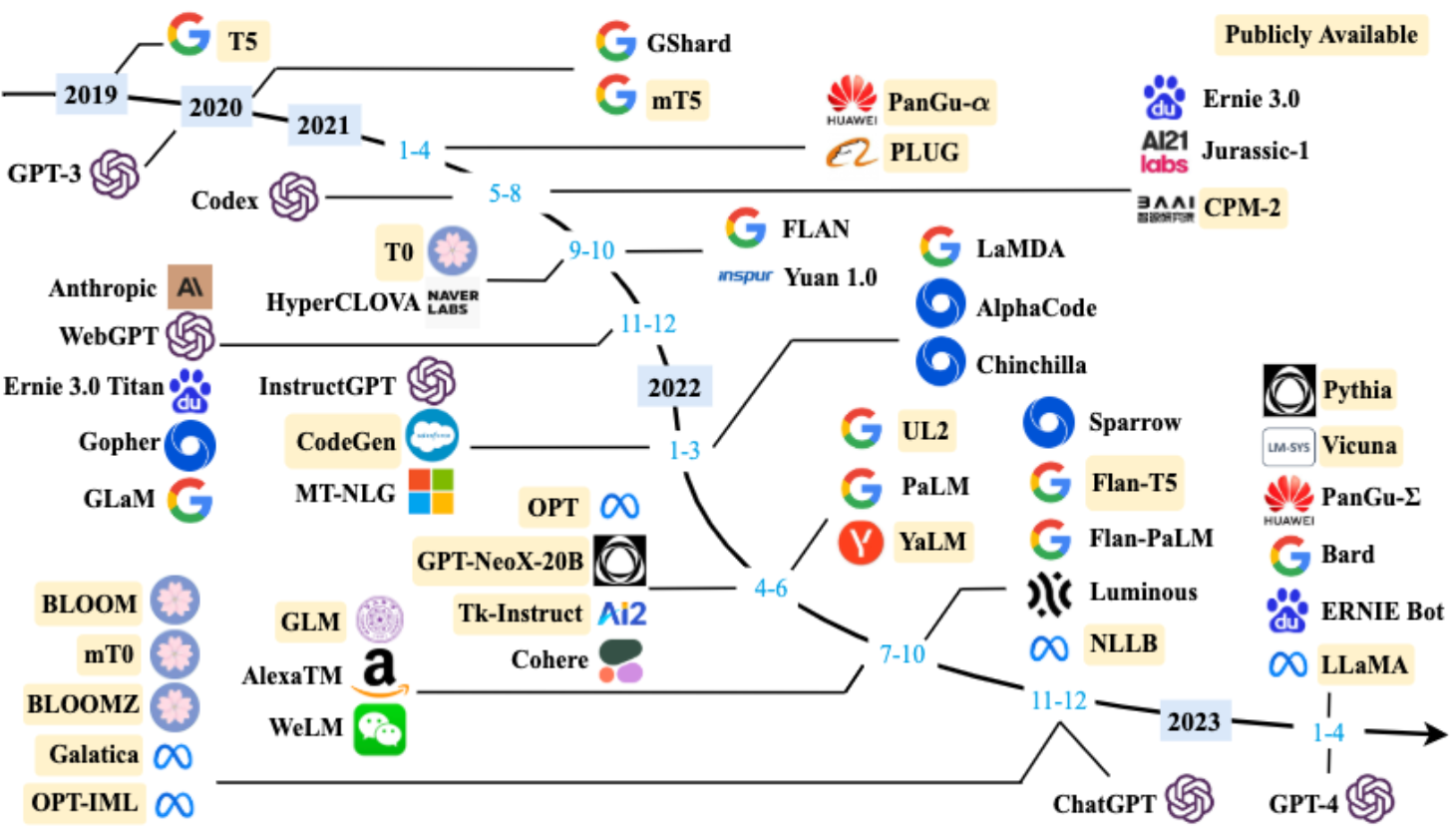

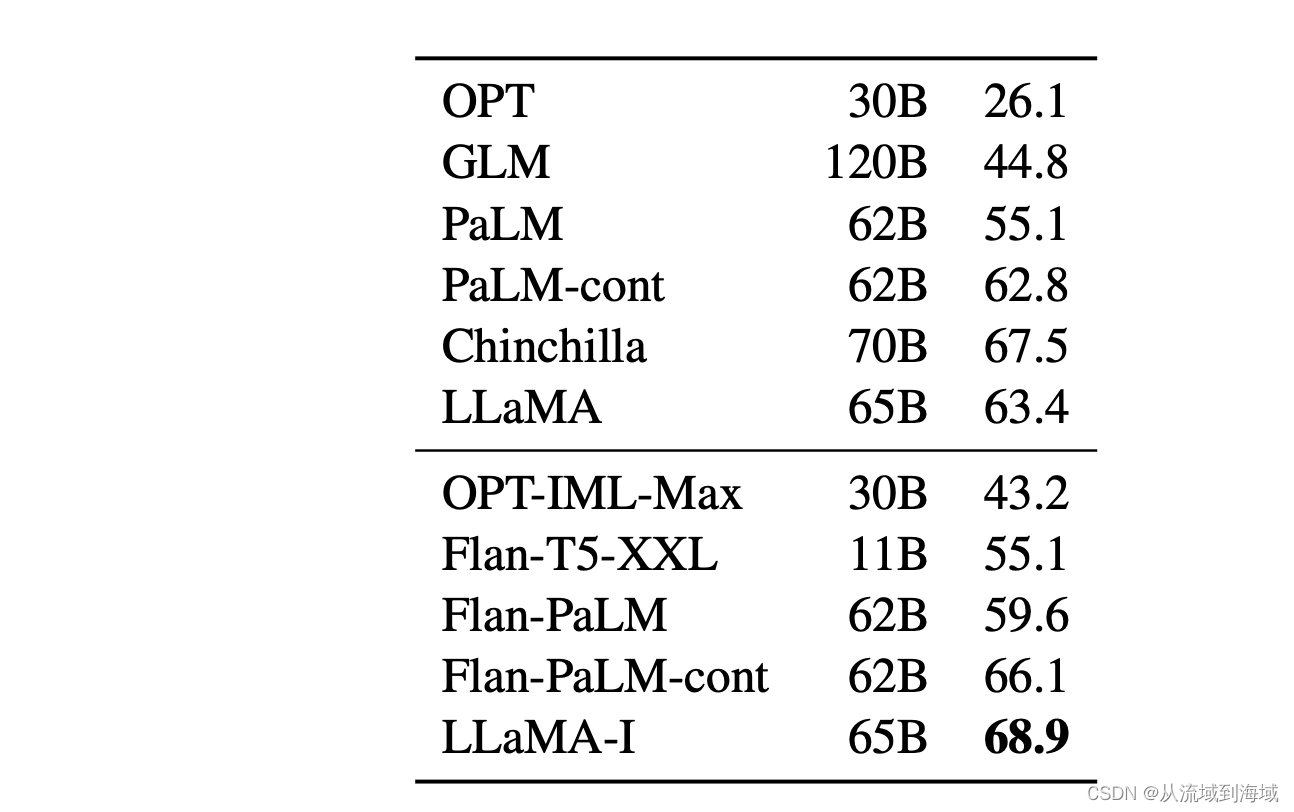

大模型 LLM 综述, A Survey of Large Language Models

大模型 LLM 综述, A Survey of Large Language Models

一、概述

一般认为NLP领域的大模型>10 Billion参数(也有人认为是6B、7B, 工业界用, 开始展现涌现能力); 经典大模型有GPT-3、BLOOM、Flan-T5、GPT-NeoX、OPT、GLM-130B、PaLM、LaMDA、LLaMA等;

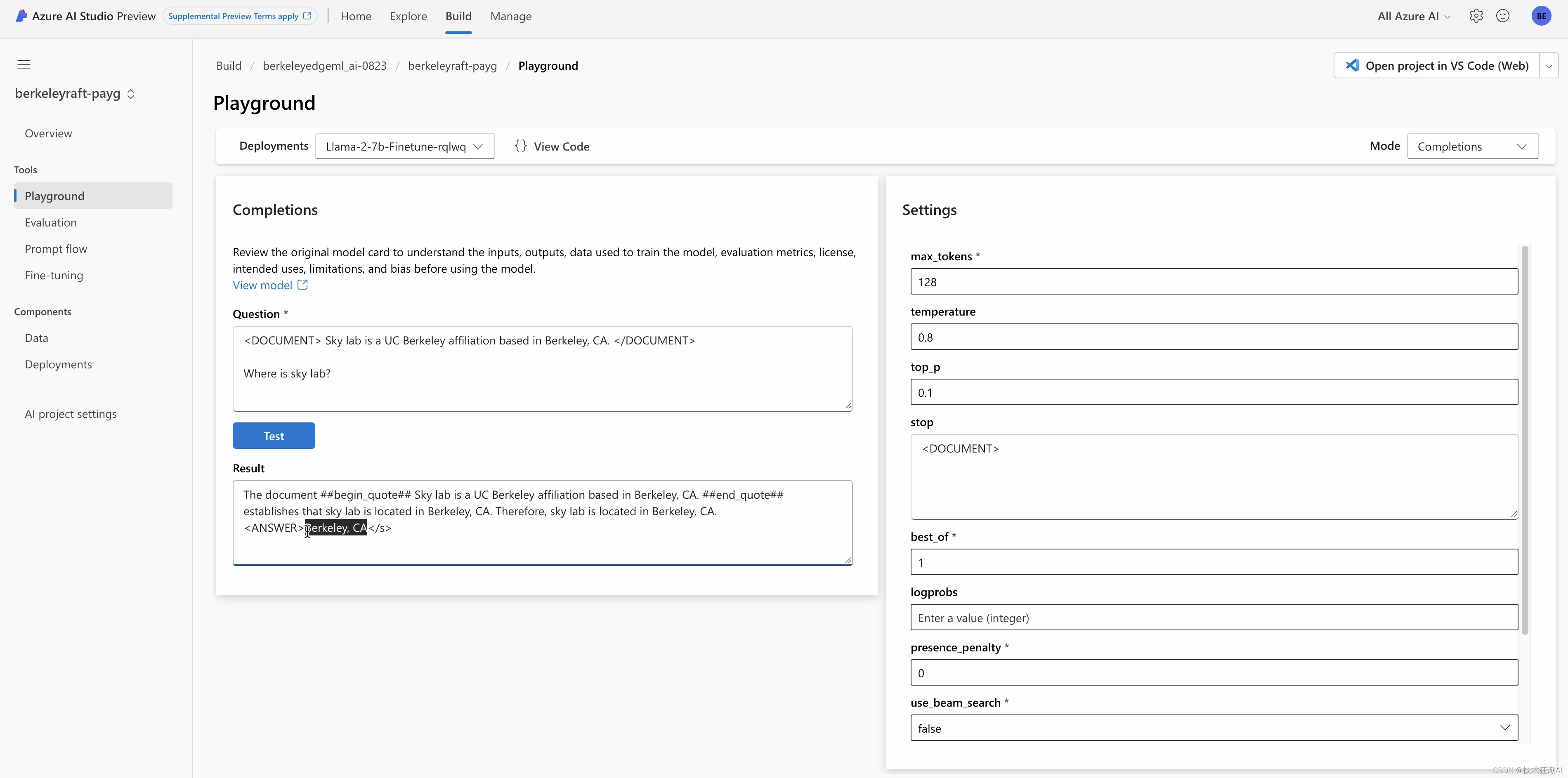

大模型时间线, 图来自…

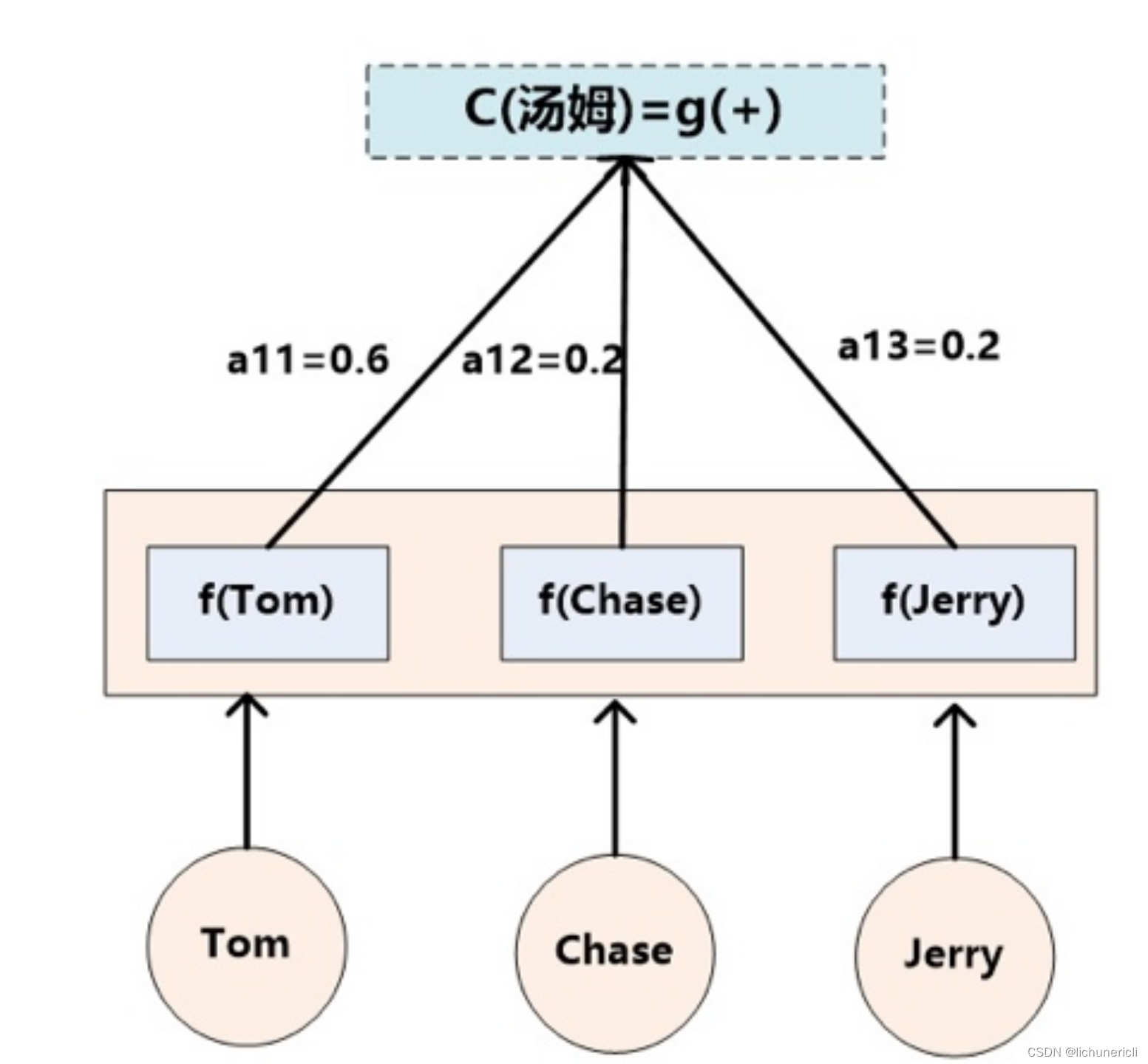

NLP实践——中文指代消解方案

NLP实践——中文指代消解方案 1. 参考项目2. 数据2.1 生成conll格式2.2 生成jsonline格式 3. 训练3.1 实例化模型3.2 读取数据3.3 评估方法3.4 训练方法 4. 推理5. 总结 1. 参考项目

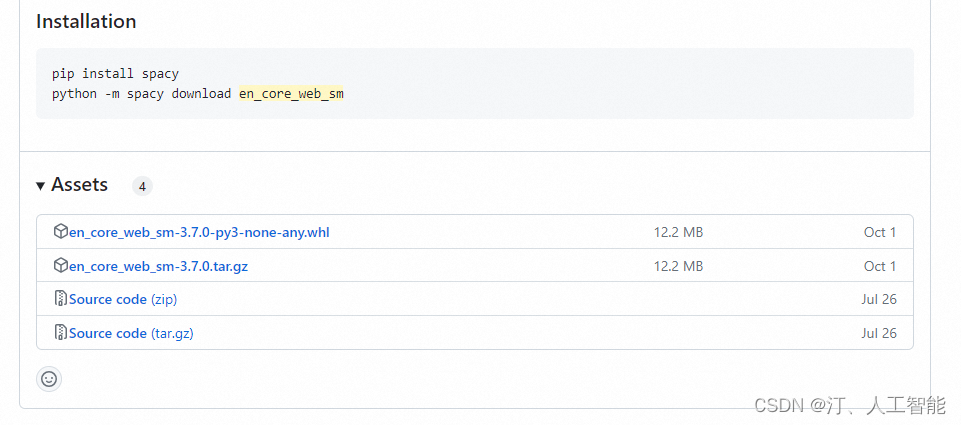

关于指代消解任务,有很多开源的项目和工具可以借鉴,比如spacy的基础模…

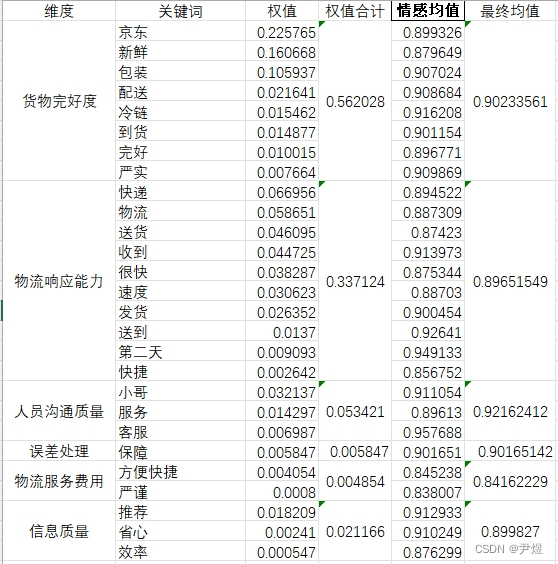

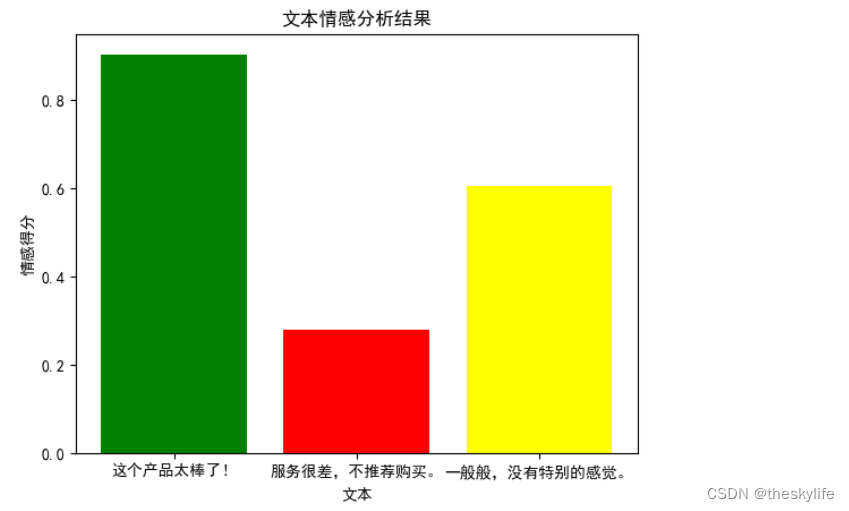

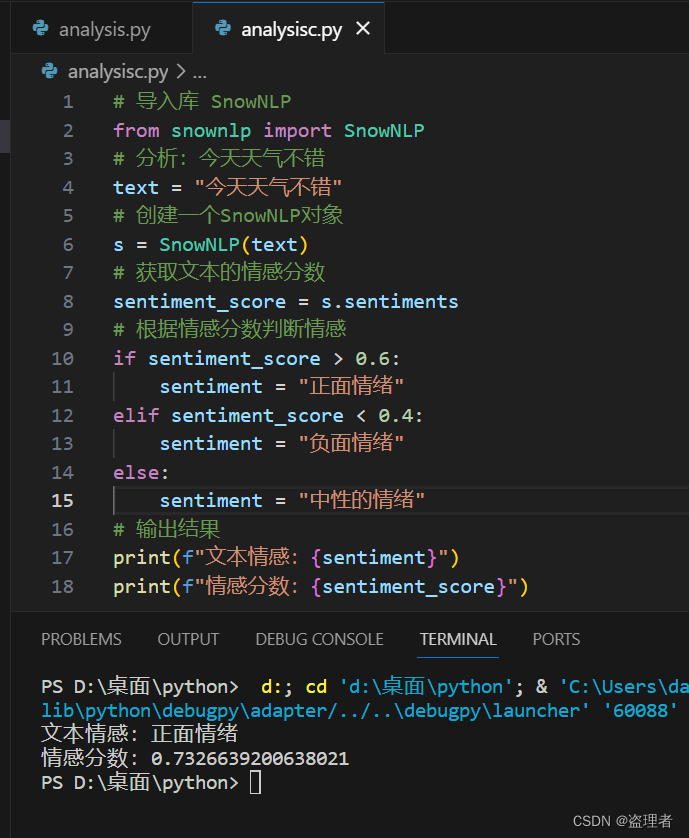

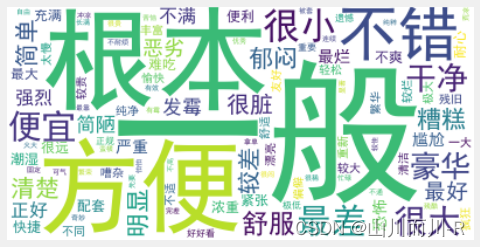

数据分析案例-基于snownlp模型的MatePad11产品用户评论情感分析

🤵♂️ 个人主页:艾派森的个人主页 ✍🏻作者简介:Python学习者 🐋 希望大家多多支持,我们一起进步!😄 如果文章对你有帮助的话, 欢迎评论 💬点赞Ǵ…

Python输入音频wav同步嘴型源码方案

这是由ACM MM2020发表了的一篇论文,提出一个AI模型,只需要一段人物视频和一段目标语音,就能够让音频和视频合二为一,人物嘴型与音频完全匹配。 【订阅栏目 获取全部的源码方案】

选一张蒙娜丽莎的照片和一段简短的音频,就可以让嘴唇同步,这是静态的照片,所以照片中的人…

ChatGPT重磅升级!集简云支持GPT4 Turbo Vision, GPT4 Turbo, Dall.E 3,Whisper等最新模型

在11月7日凌晨,OpenAI全球开发者大会宣布了 GPT-4的一次大升级,推出了 GPT-4 Turbo号称为迄今为止最强的大模型。 此次GPT-4的更新和升级在多个方面显示出强大的优势和潜力。为了让集简云用户能快速体验新模型的能力,我们第一时间整理了大会发…

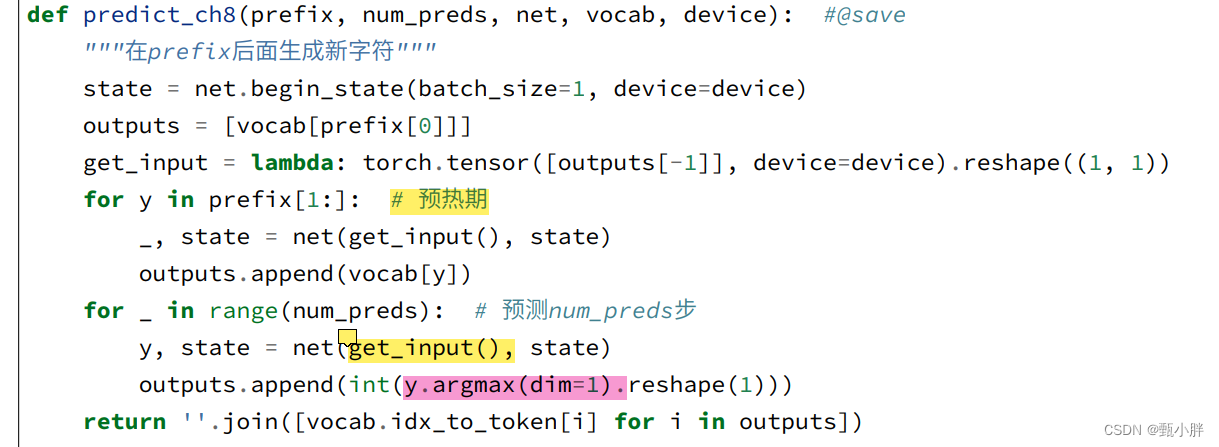

动手深度学习之从线性回归到循环神经网络

参考伯禹学习平台《动手学深度》课程内容内容撰写的学习笔记 原文链接:https://www.boyuai.com/elites/course/cZu18YmweLv10OeV 感谢伯禹平台,Datawhale,和鲸,AWS给我们提供的免费学习机会!! 总的学习感受…

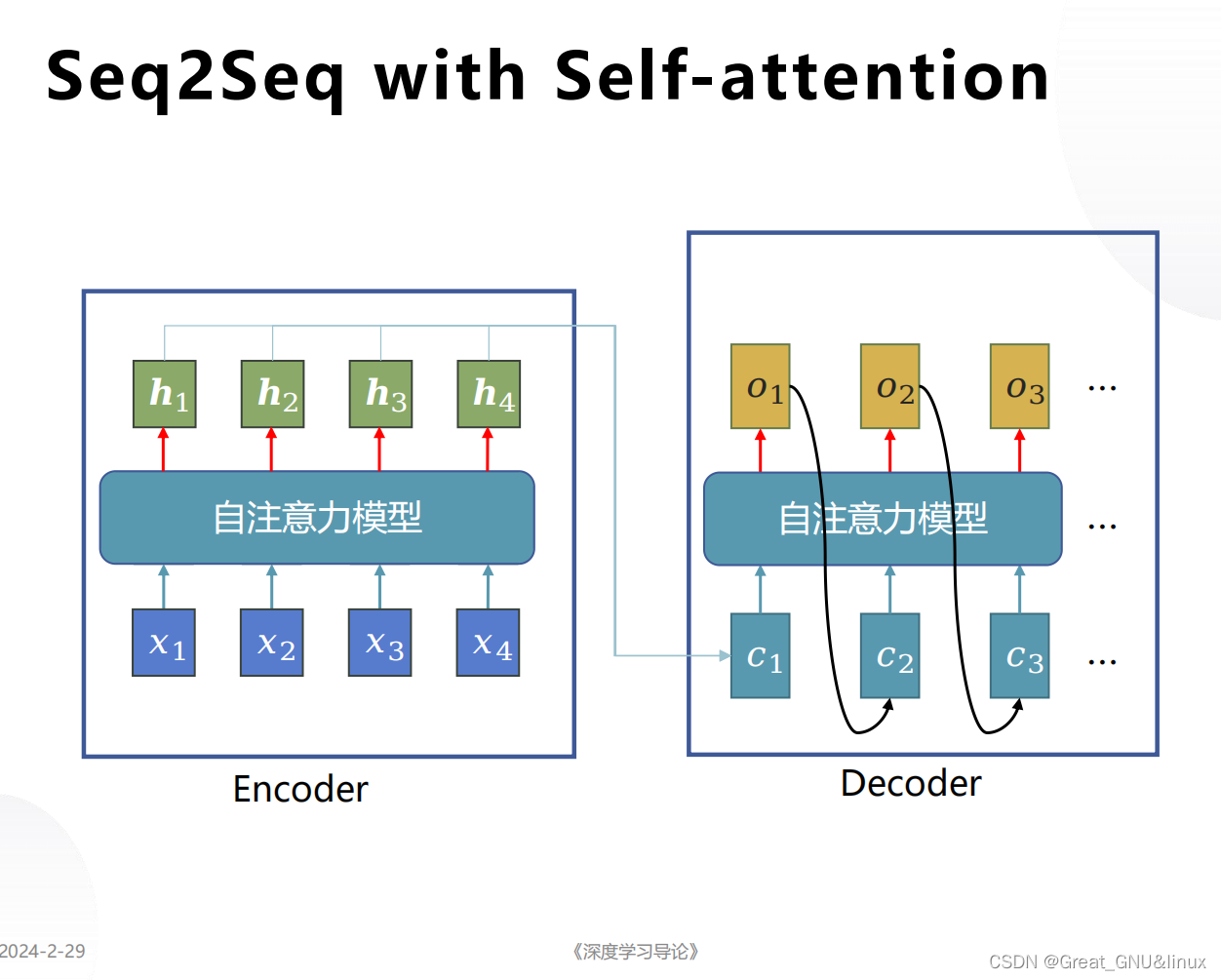

Transformer回顾与细节

我们在《Seq2seq Attention模型详解》中,详细地回顾了以 RNN 为基础模块的Seq2seq模型。本文所讲述的Transformer也采用Seq2seq式的编码器-解码器结构,不过它摒弃了经典的 RNN,采用 self-Attention。由于并行计算、长时序建模、模型容量大等优…

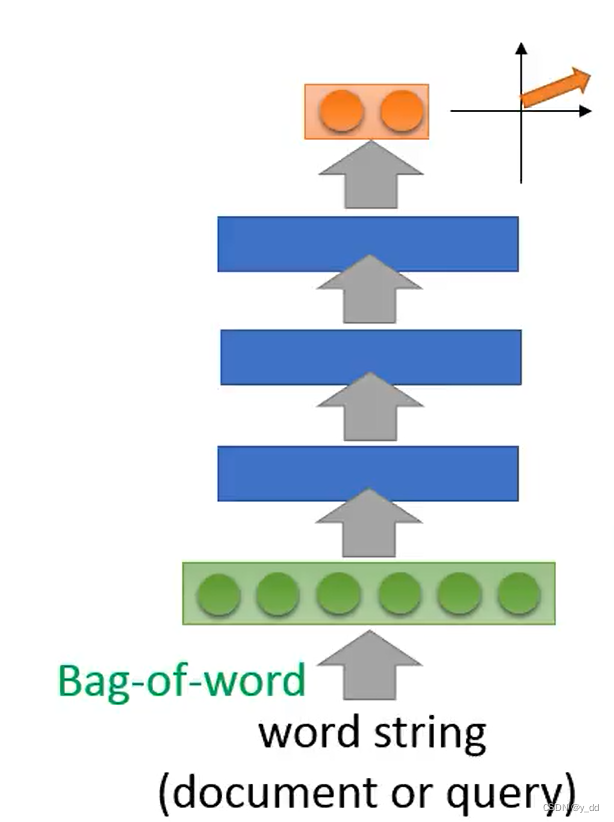

NLP学习笔记十二-词袋模型

NLP学习笔记十二-词袋模型

词袋模型其实是一种很简单的统计模型,这个统计模型说法是博主自己定义的,也可能真的统计模型中含有词袋模型这一类,为什么说它是统计模型?因为词袋模型他呢是基于统计的,比如现在我们有两组组词&#…

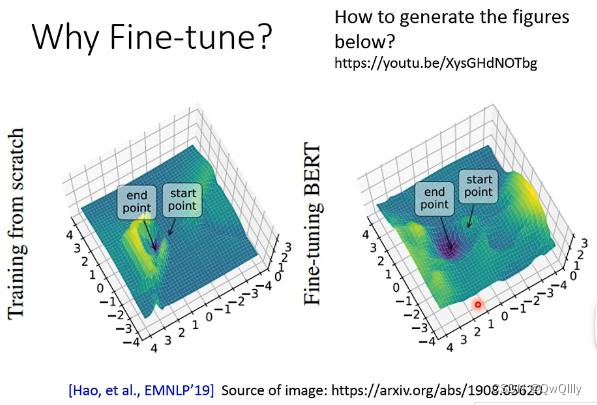

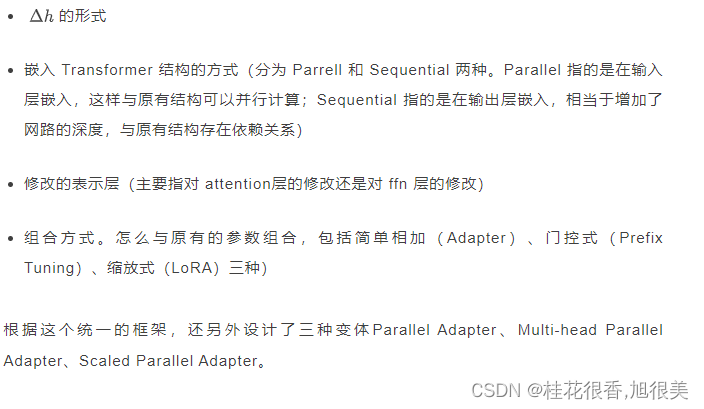

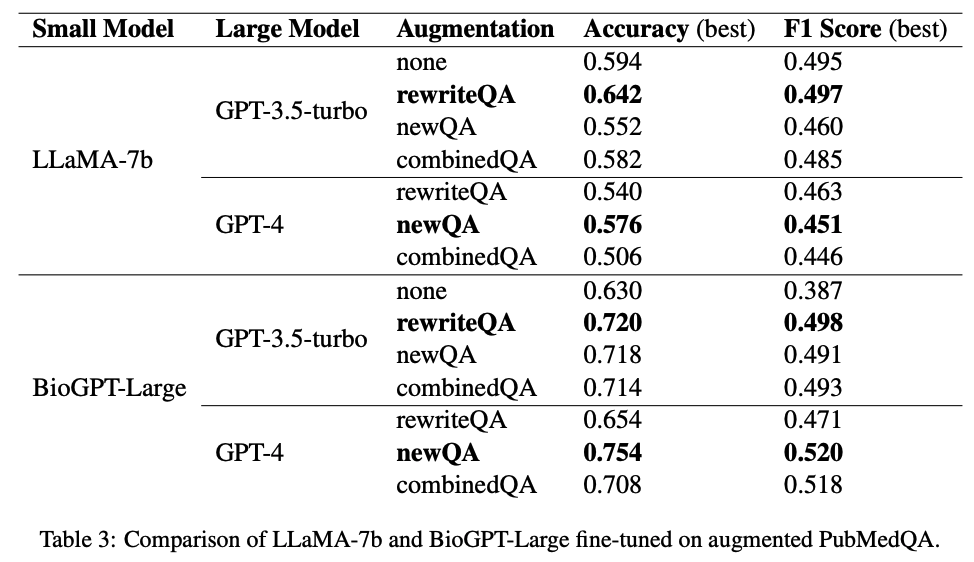

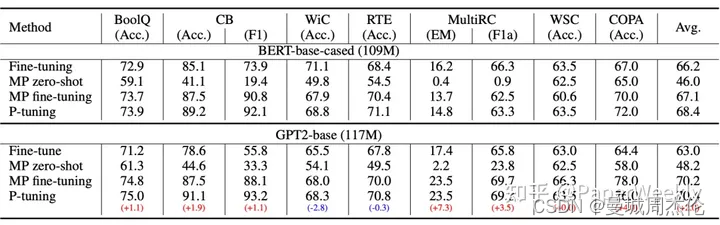

文献阅读:Raise a Child in Large Language Model: Towards Effective and Generalizable Fine-tuning

文献阅读:Raise a Child in Large Language Model: Towards Effective and Generalizable Fine-tuning 1. 内容简介2. 相关工作 1. Weight Decay2. Top-K Tuning3. Mixout4. RecAdam5. R3F 3. 优化方案 1. ChildTuning-F2. ChildTuning-D 4. 实验设计 & 结果 1.…

利用AI将脑信号解码为神经义肢控制

机器学习和人工智能的快速发展,它们已经产生了一系列能够学习大量数据之间复杂非线性关系的神经网络模型。深度学习算法在各种应用中取得了巨大的成功,包括计算机视觉、自然语言处理和机器人类等。最近,神经网络的中一项引人注目的应用是通过…

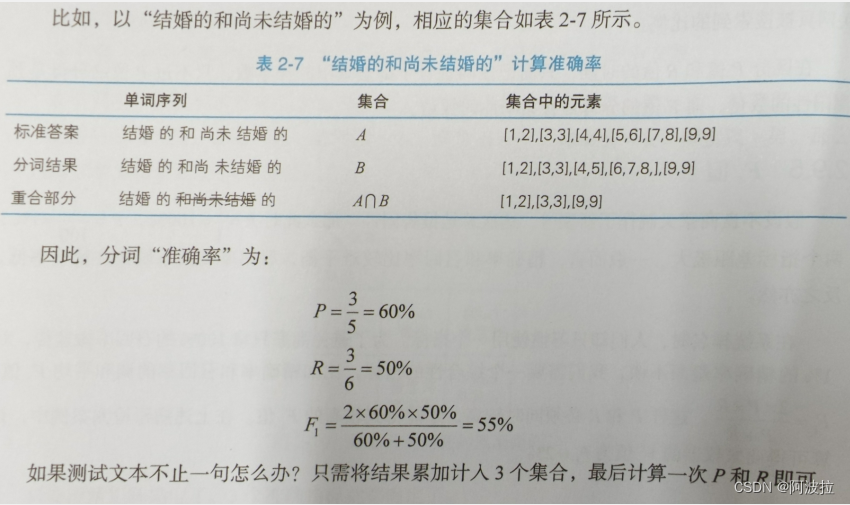

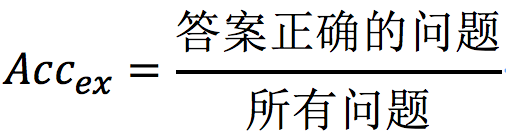

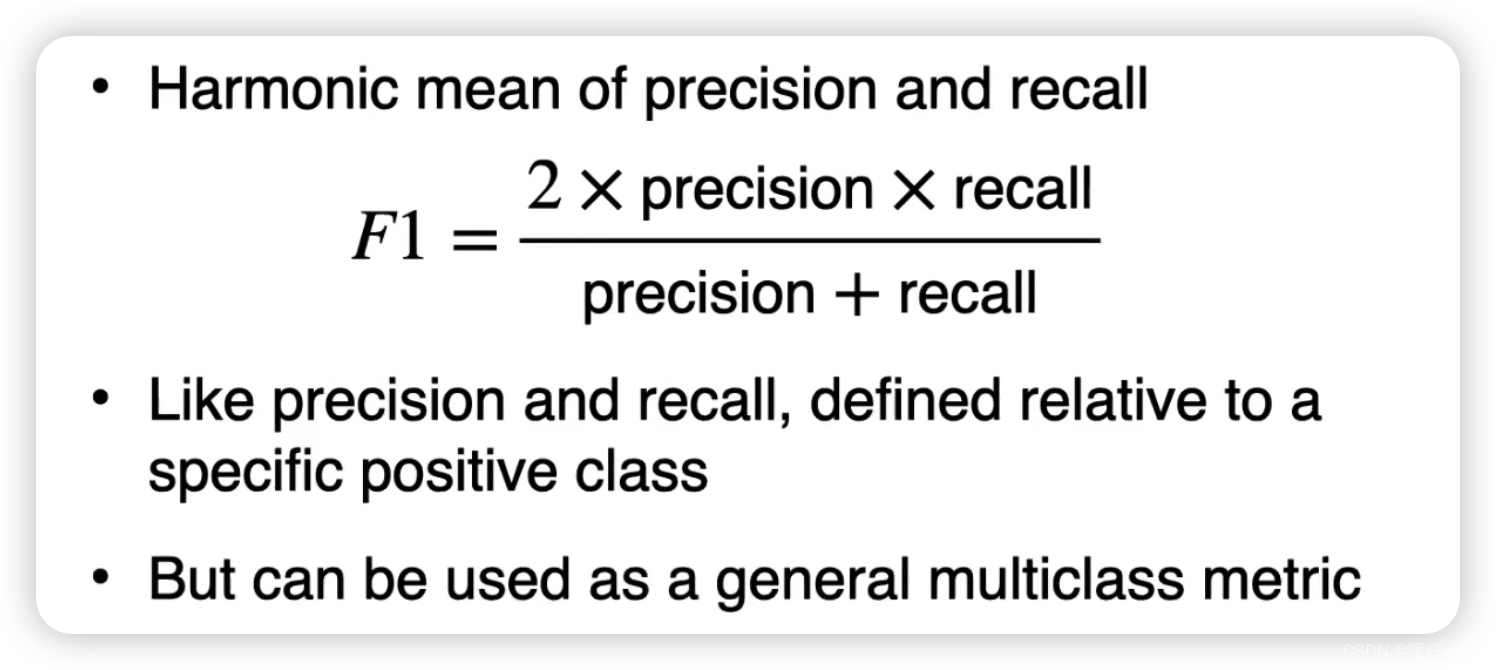

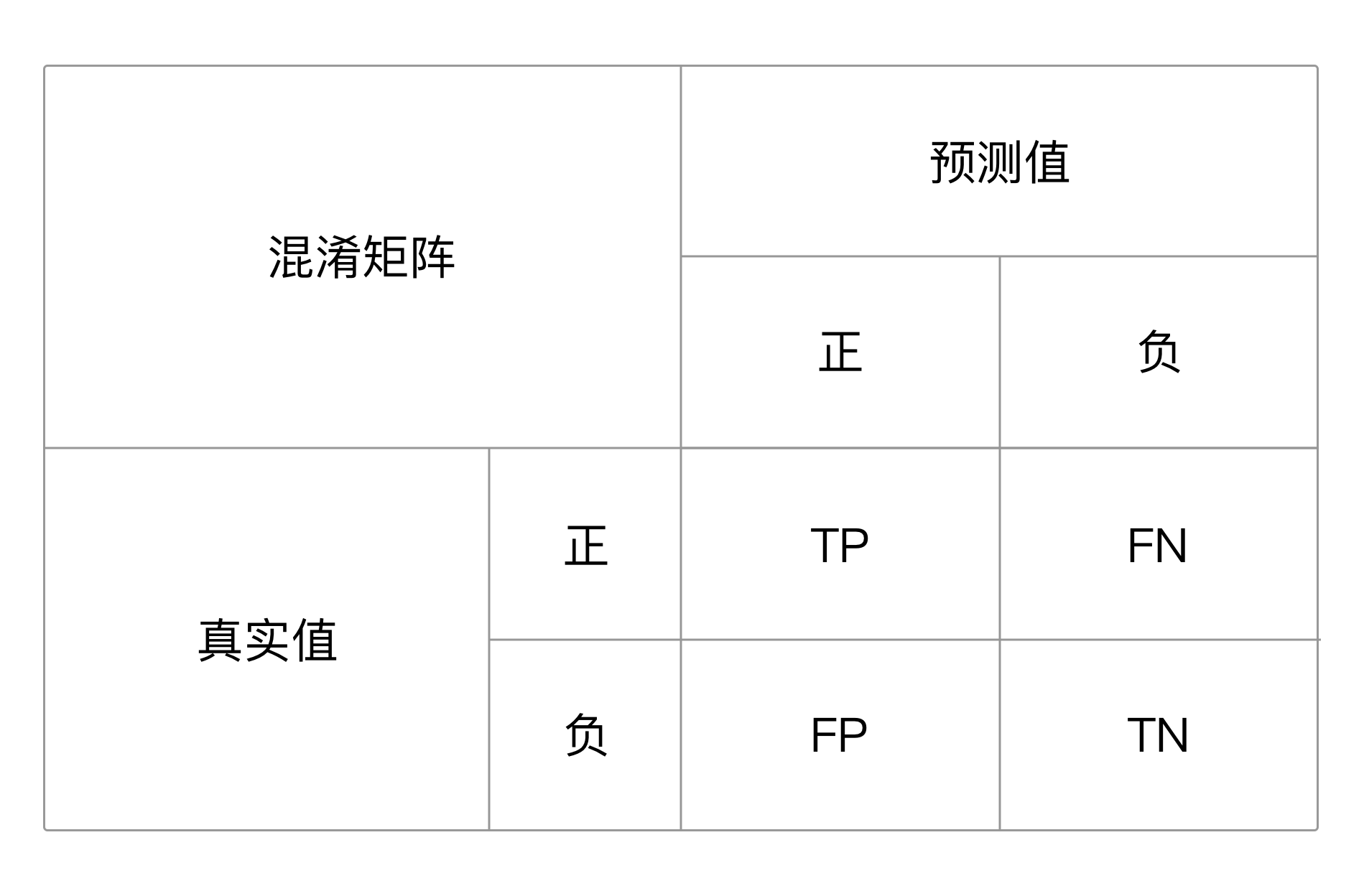

自然语言处理学习笔记(八)———— 准确率

目录 1.准确率定义

2.混淆矩阵与TP/FN/FP/TN

3. 精确率

4.召回率

5.F1值

6.中文分词的P、R、F1计算

7.实现 1.准确率定义 准确率是用来衡量一个系统的准确程度的值,可以理解为一系列评测指标。当预测与答案的数量相等时,准确率指的是系统做出正确判…

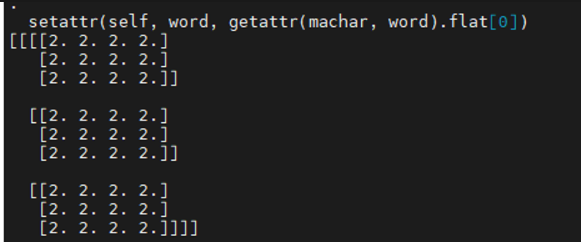

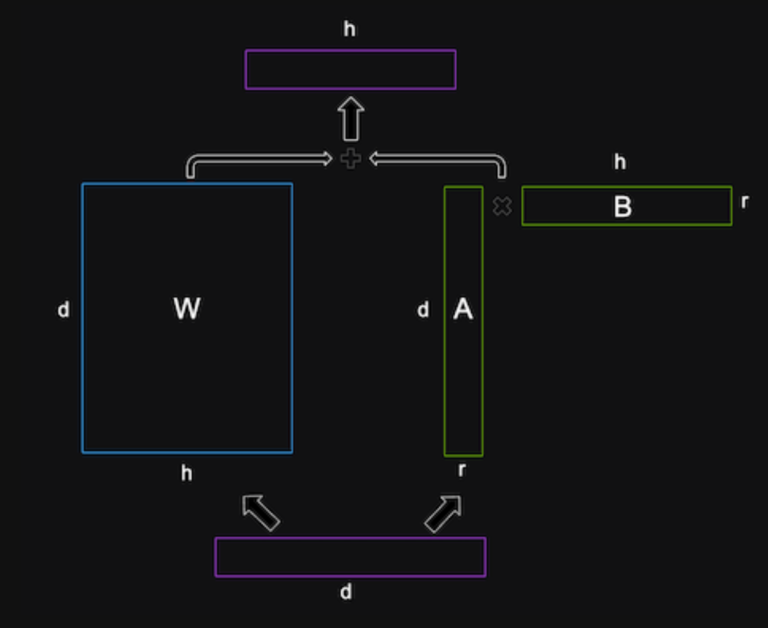

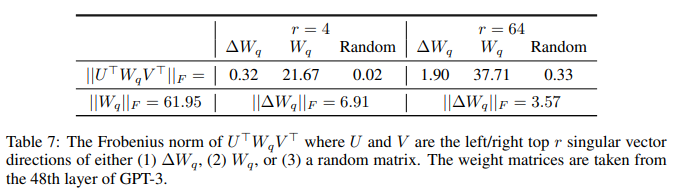

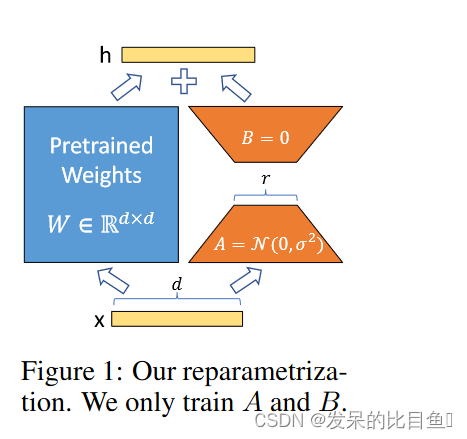

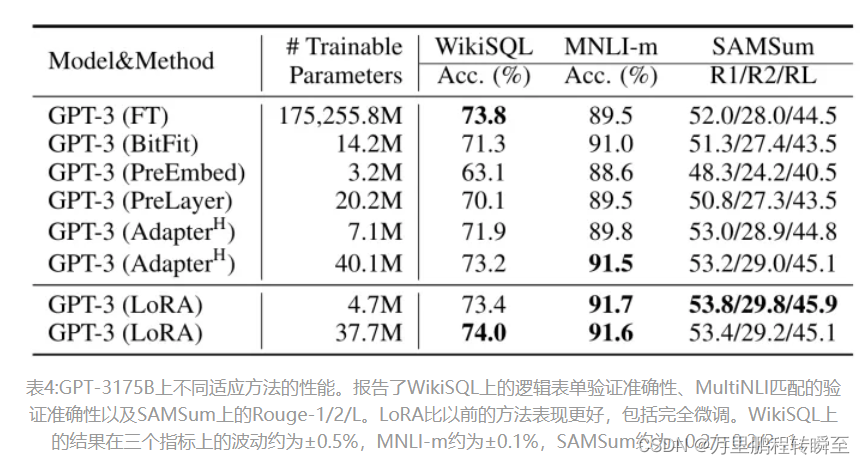

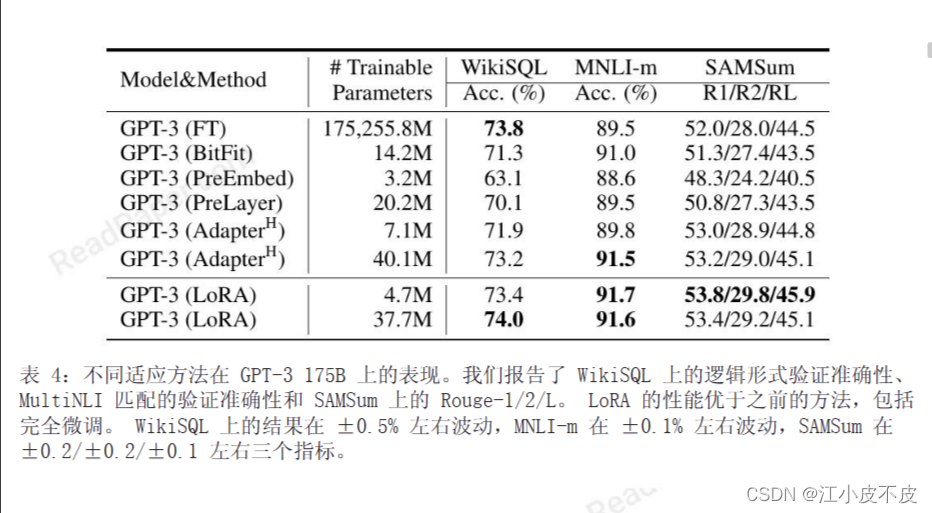

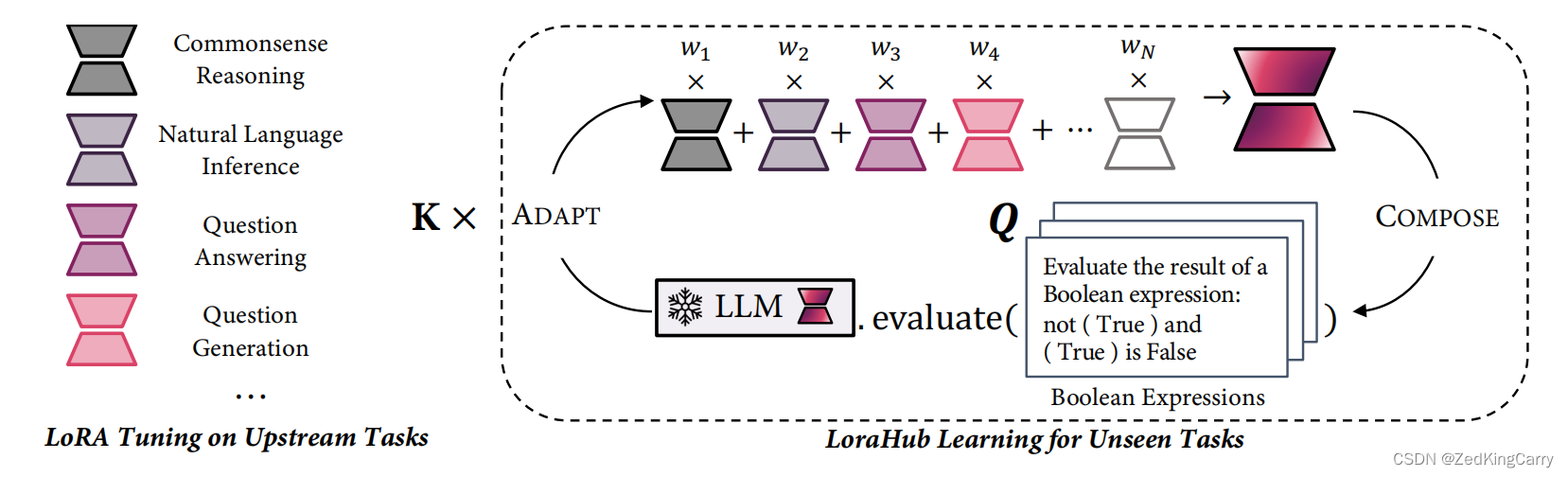

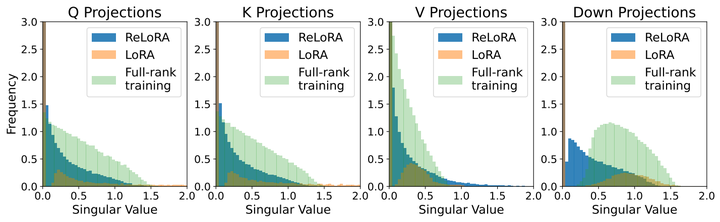

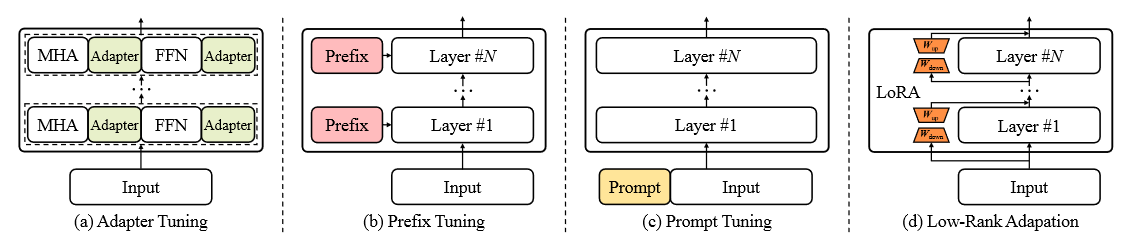

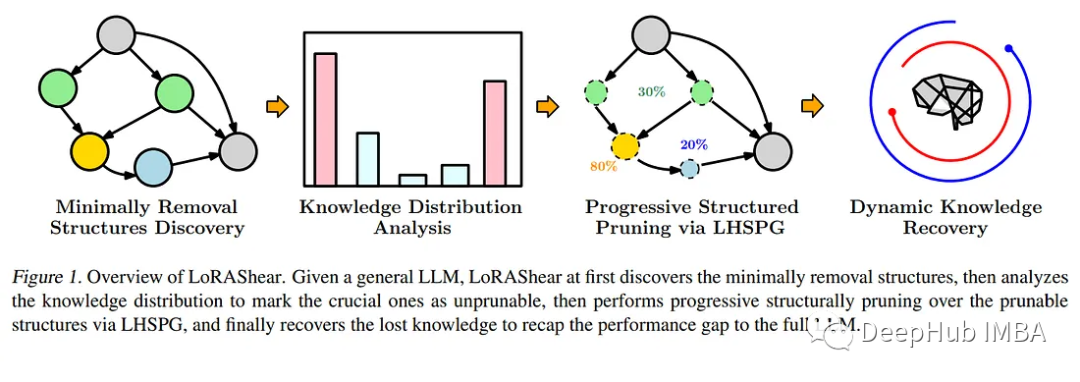

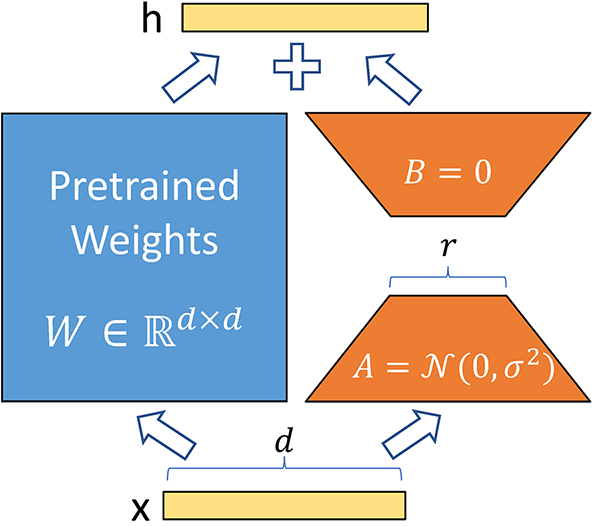

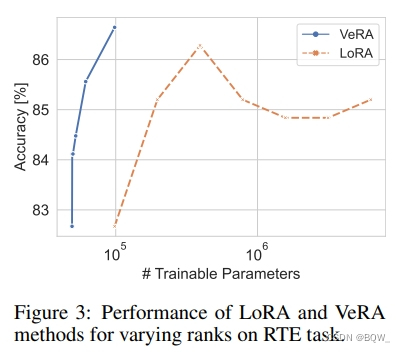

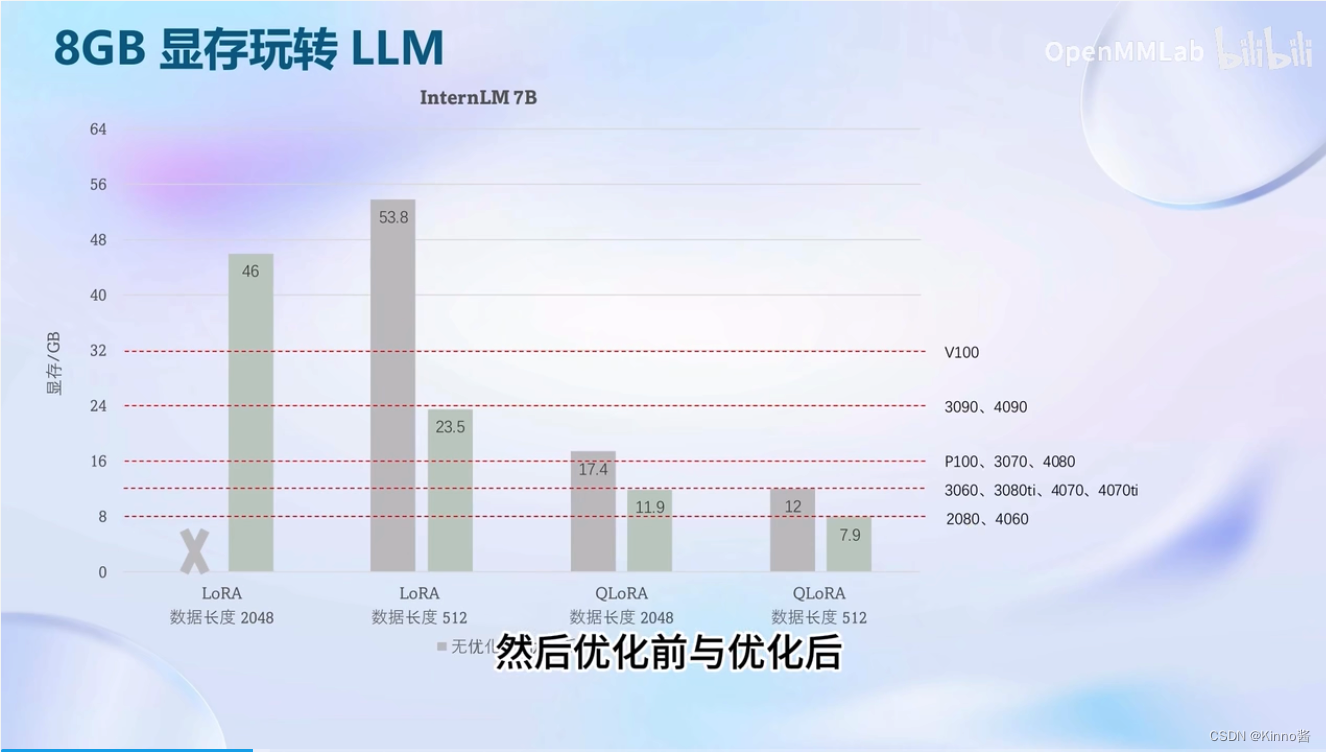

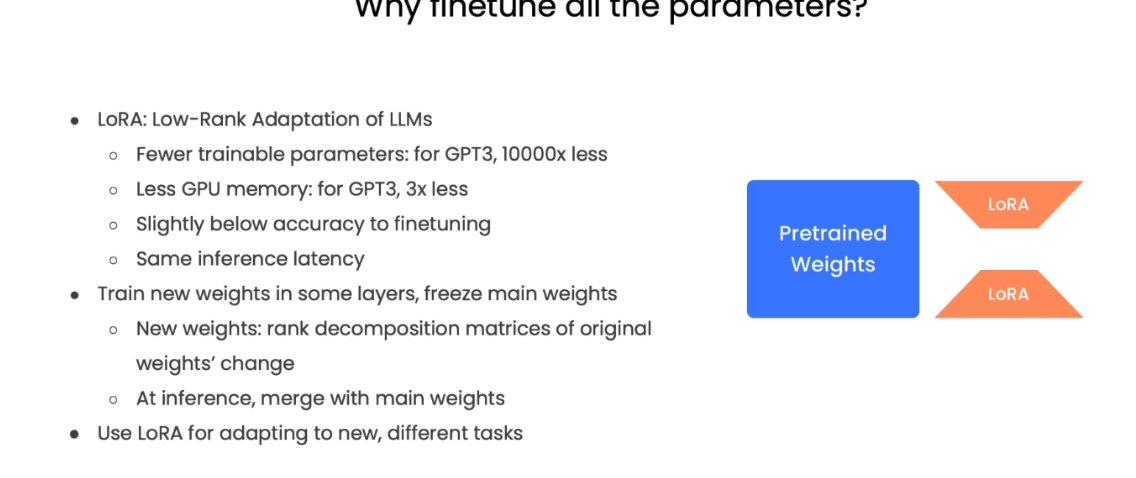

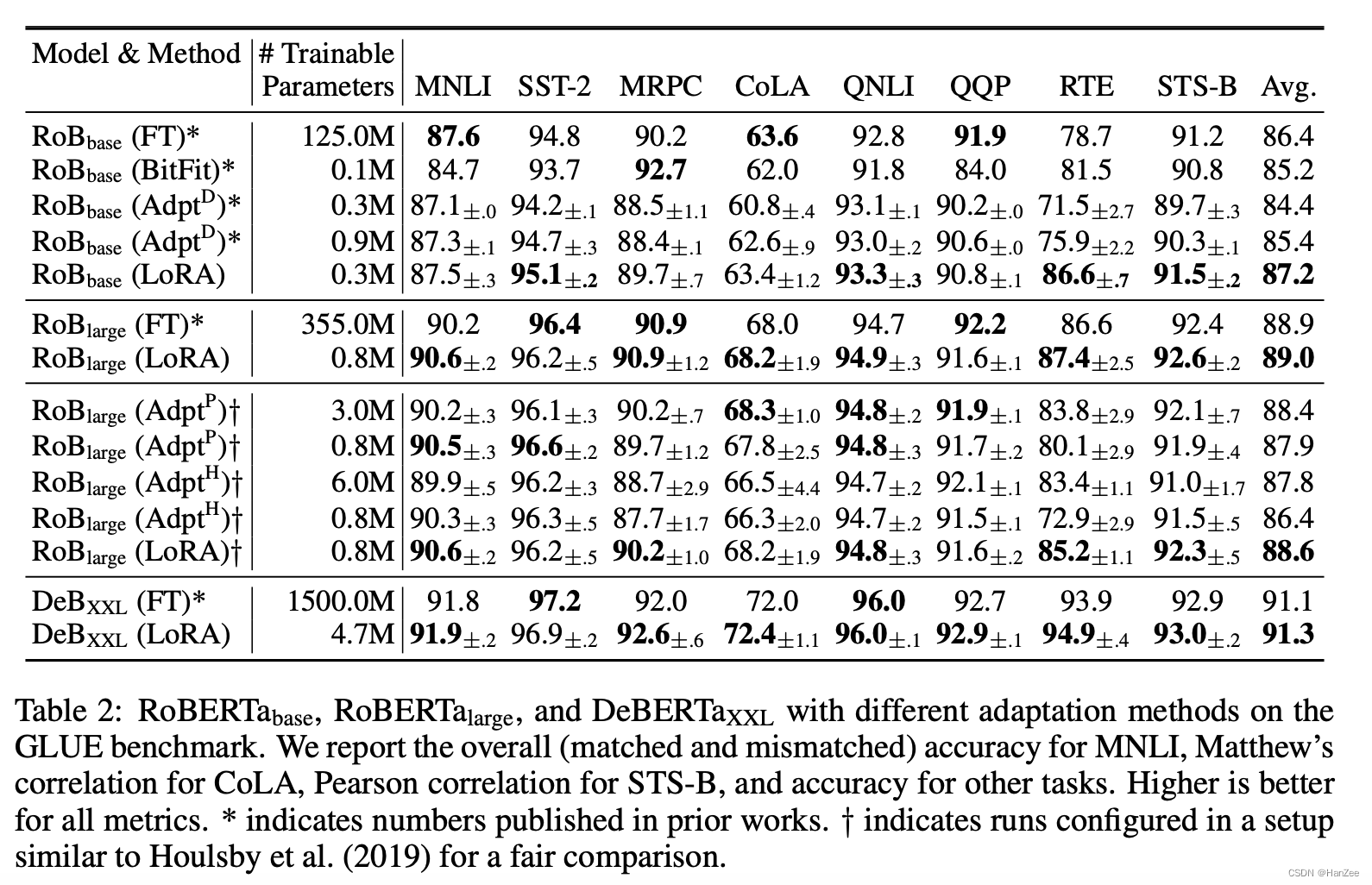

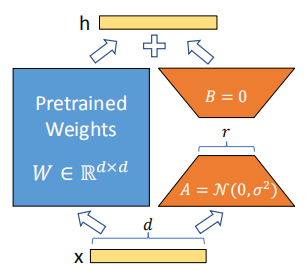

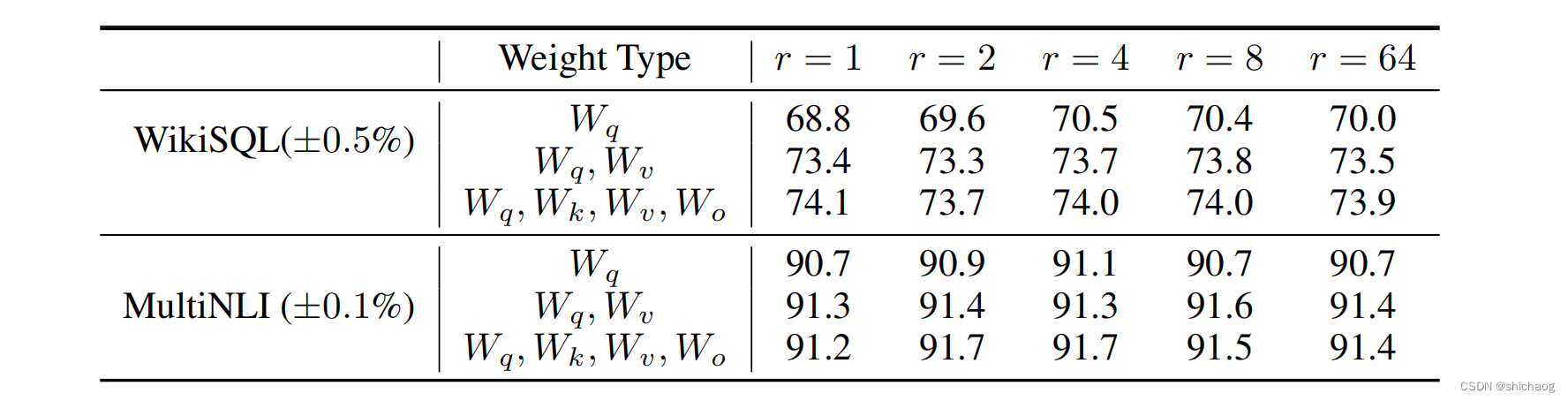

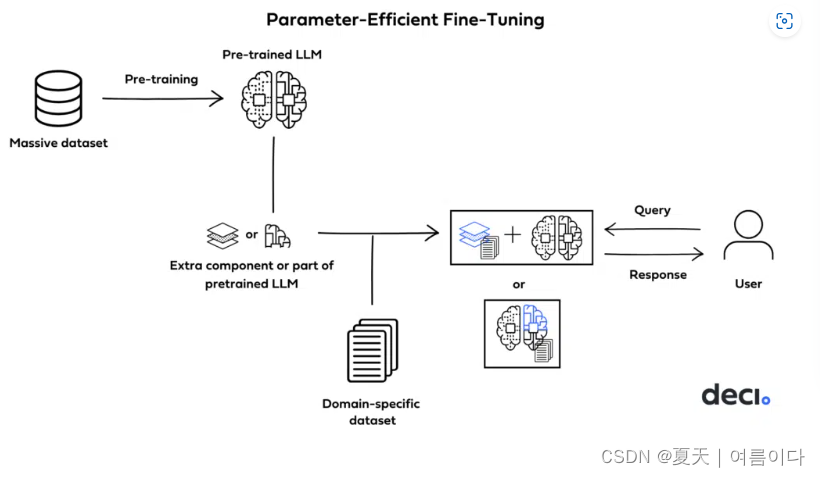

LLM:LoRA: Low-Rank Adaptation of Large Language Models

随着模型规模的不断扩大,微调模型的所有参数(所谓full fine-tuning)的可行性变得越来越低。以GPT-3的175B参数为例,每增加一个新领域就需要完整微调一个新模型,代价和成本很高。

为解决微调大规模语言模型到不同领域和…

ElasticSearch7学习笔记之用Analyzer分词

定义

Analyzer是es中专门用来处理分词的组件,由三部分组成:

Character Filters:针对原始文本的处理,例如去除html等Tokenizer:按照规则进行分词Token Filter:将切分的单词进行加工,例如去除修…

文本上的算法——深入浅出自然语言处理(读书笔记)

读后简评:《文本上的算法——深入浅出自然语言处理》主要介绍了NLP领域的整体知识框架,以及对各个实现技术进行讲解。整体思路结构还是挺清晰的,不过对于数学基础较差、对深度学习技术没有过接触的人,想要通过本书学会具体的实现技…

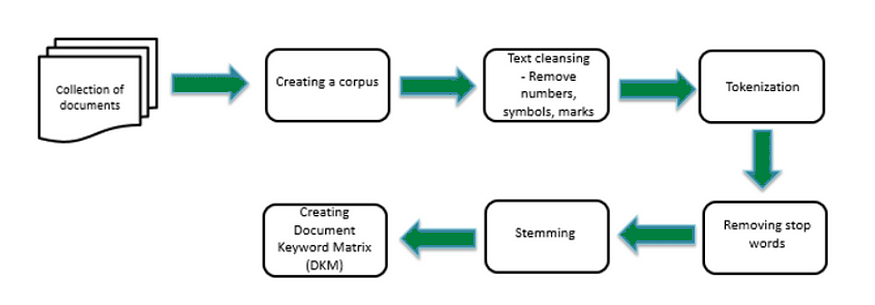

自然语言处理---文本预处理概述

自然语言处理(Natural Language Processing,简称NLP)是计算机科学与语言学中关注于计算机与人类语言间转换的领域。其主要应用于:语音助手、机器翻译、搜索引擎、智能问答等。

文本预处理概述

文本语料在输送给模型前一般需要一…

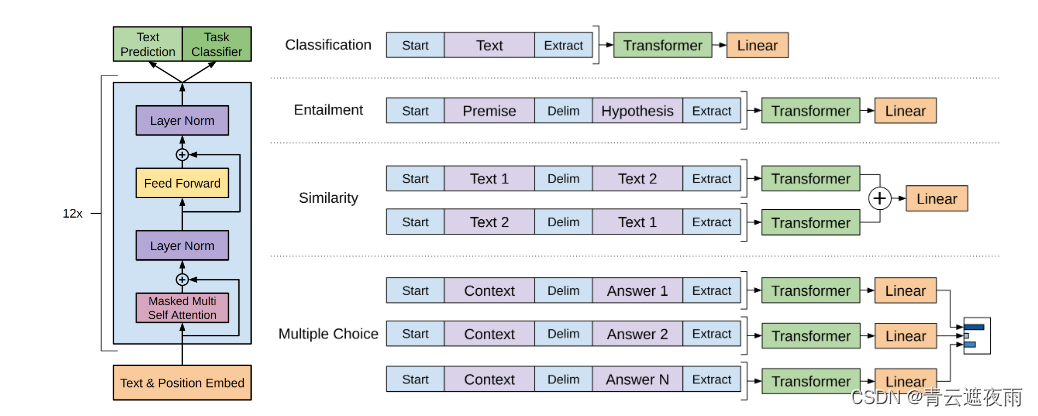

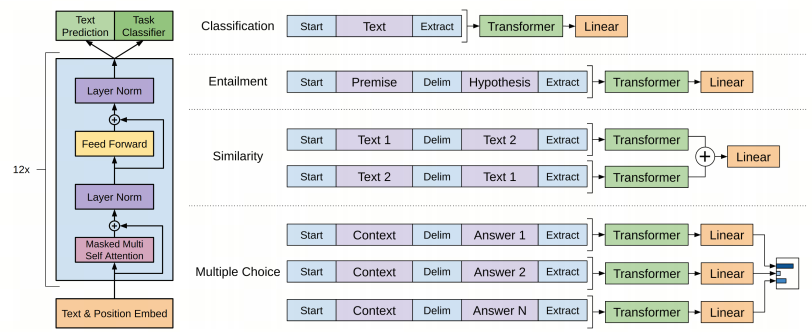

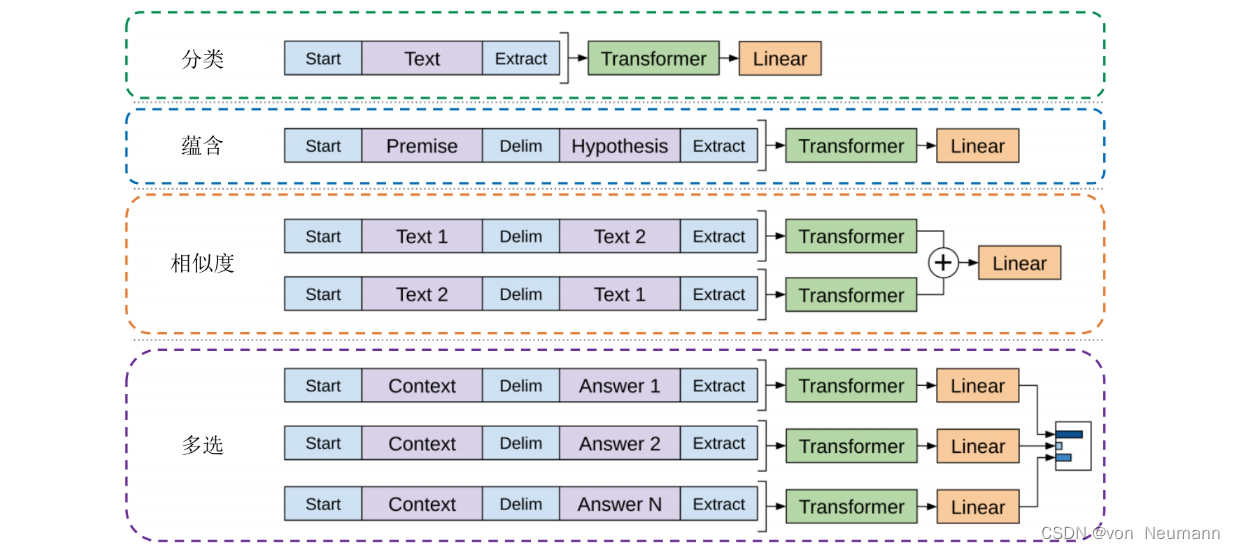

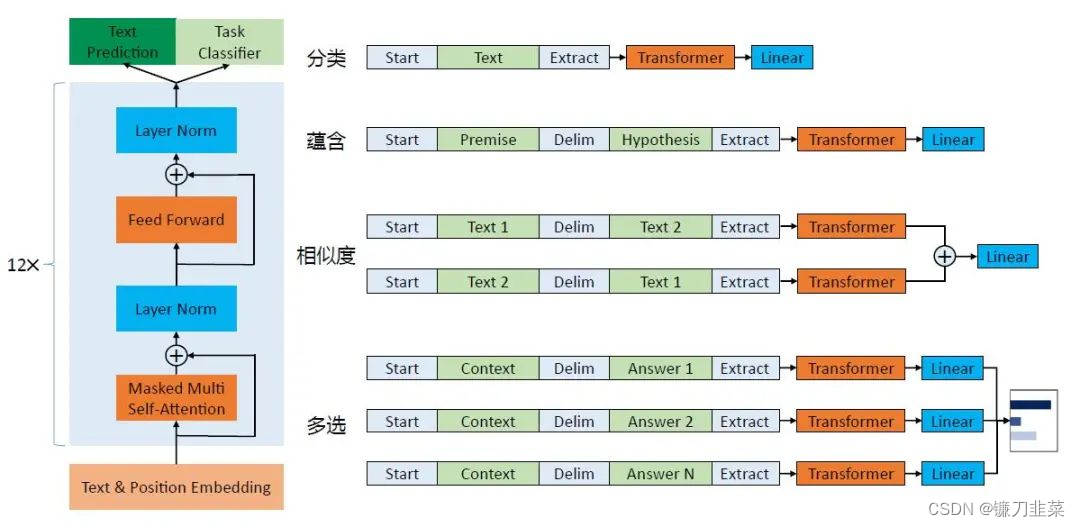

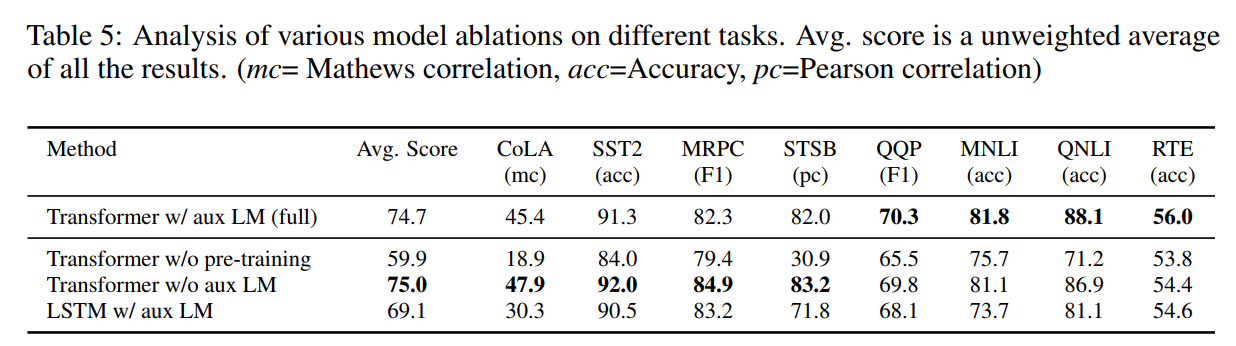

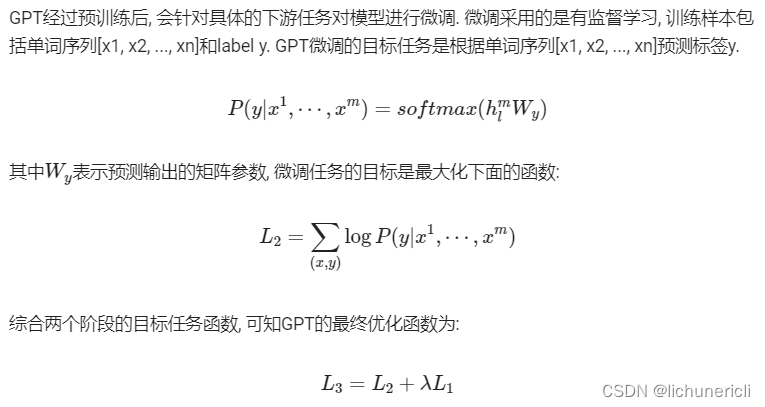

GPT:通用预训练语言模型

论文标题:Improving Language Understanding by Generative Pre-Training论文链接:https://www.cs.ubc.ca/~amuham01/LING530/papers/radford2018improving.pdf论文来源:OpenAI一、概述从无标注文本中高效学习的能力对于缓解对监督学习的依赖…

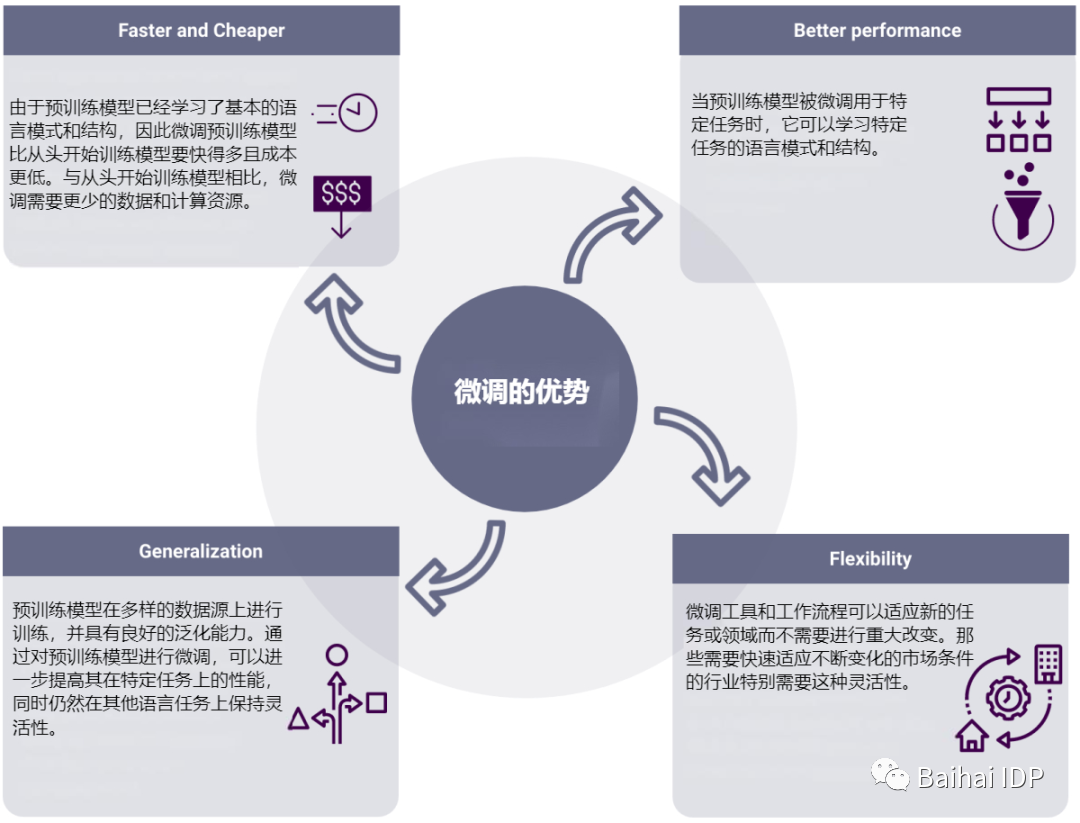

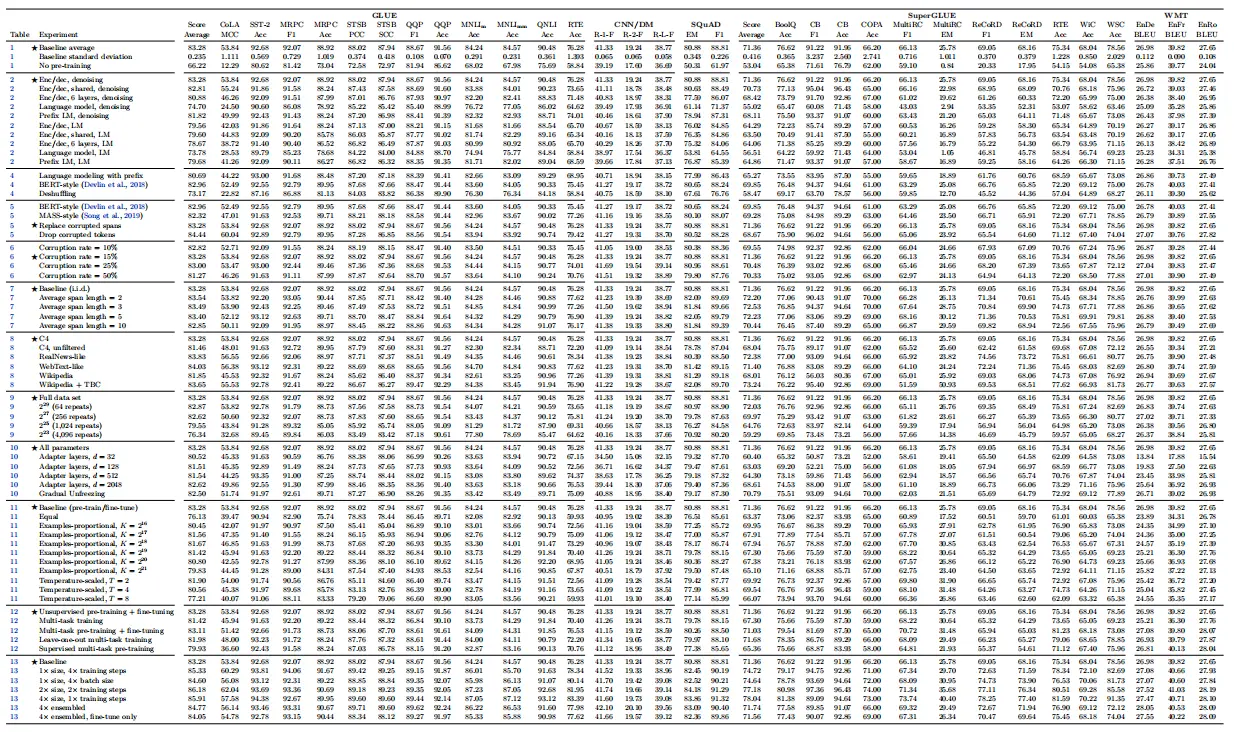

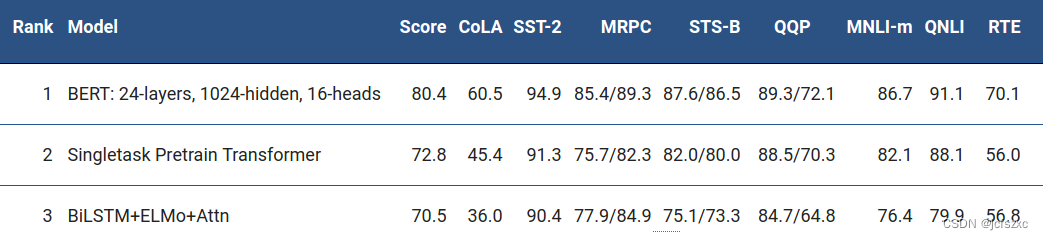

自然语言处理---迁移学习实践

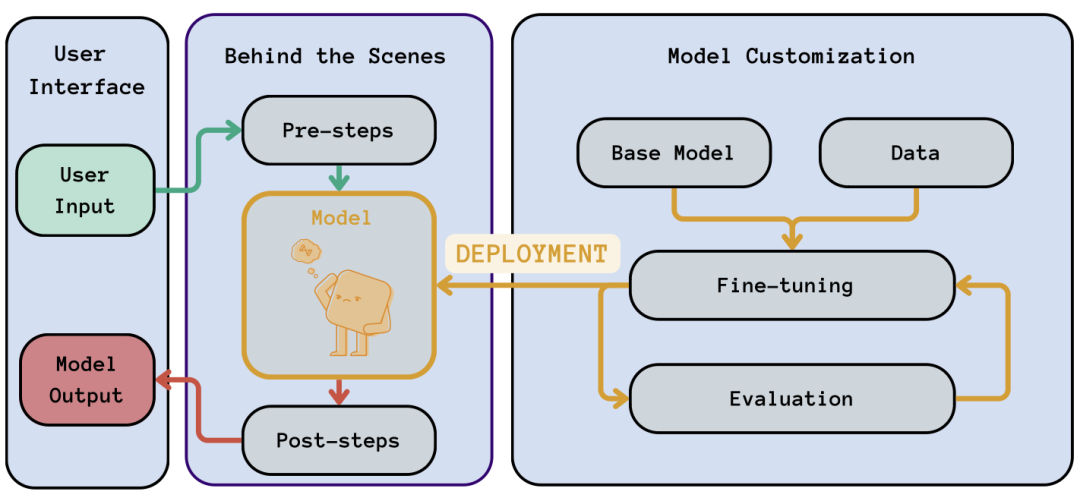

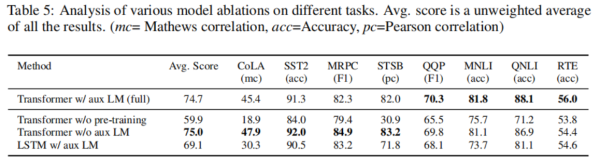

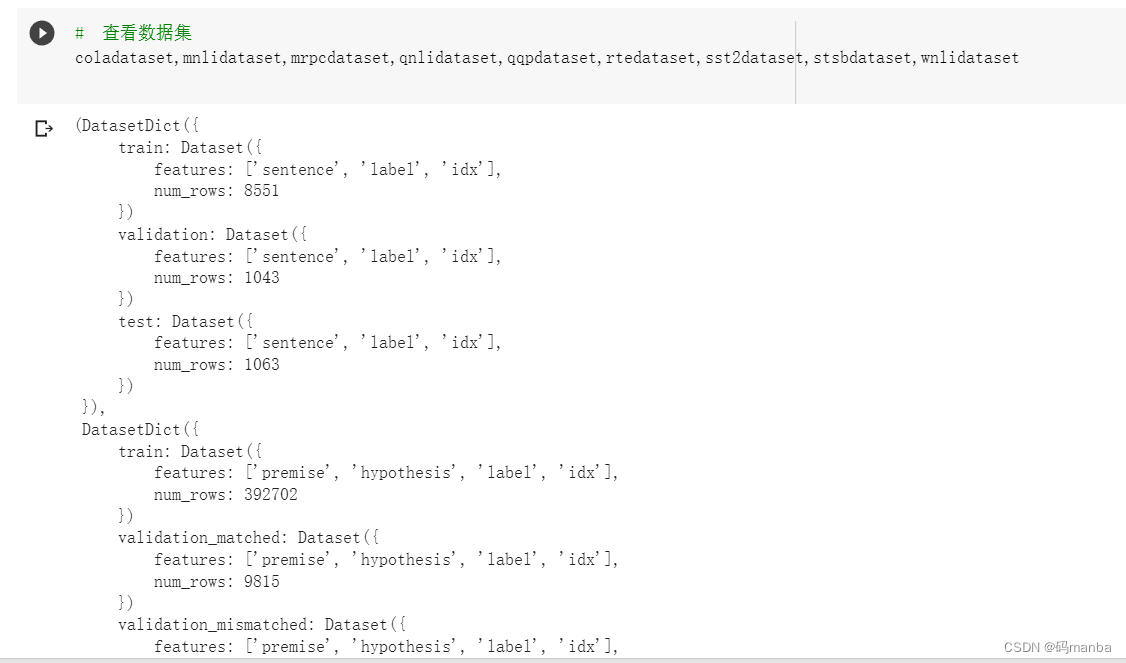

1 微调脚本介绍

指定任务类型的微调脚本: huggingface研究机构提供了针对GLUE数据集合任务类型的微调脚本, 这些微调脚本的核心都是微调模型的最后一个全连接层。通过简单的参数配置来指定GLUE中存在任务类型(如: CoLA对应文本二分类,MRPC对应句子对文本二分类&…

23年校招DL/NLP/推荐系统/ML/算法基础面试必看300问及答案

2020年校招已经开始了,在疫情全球肆虐的背景下,全球就业情况异常艰难,加上美国对中国企业打压持续升级,对于马上开始秋招找工作的毕业生而言,更是难上加难。我们不能凭一己之力改变现状,但我们可以凭借自己…

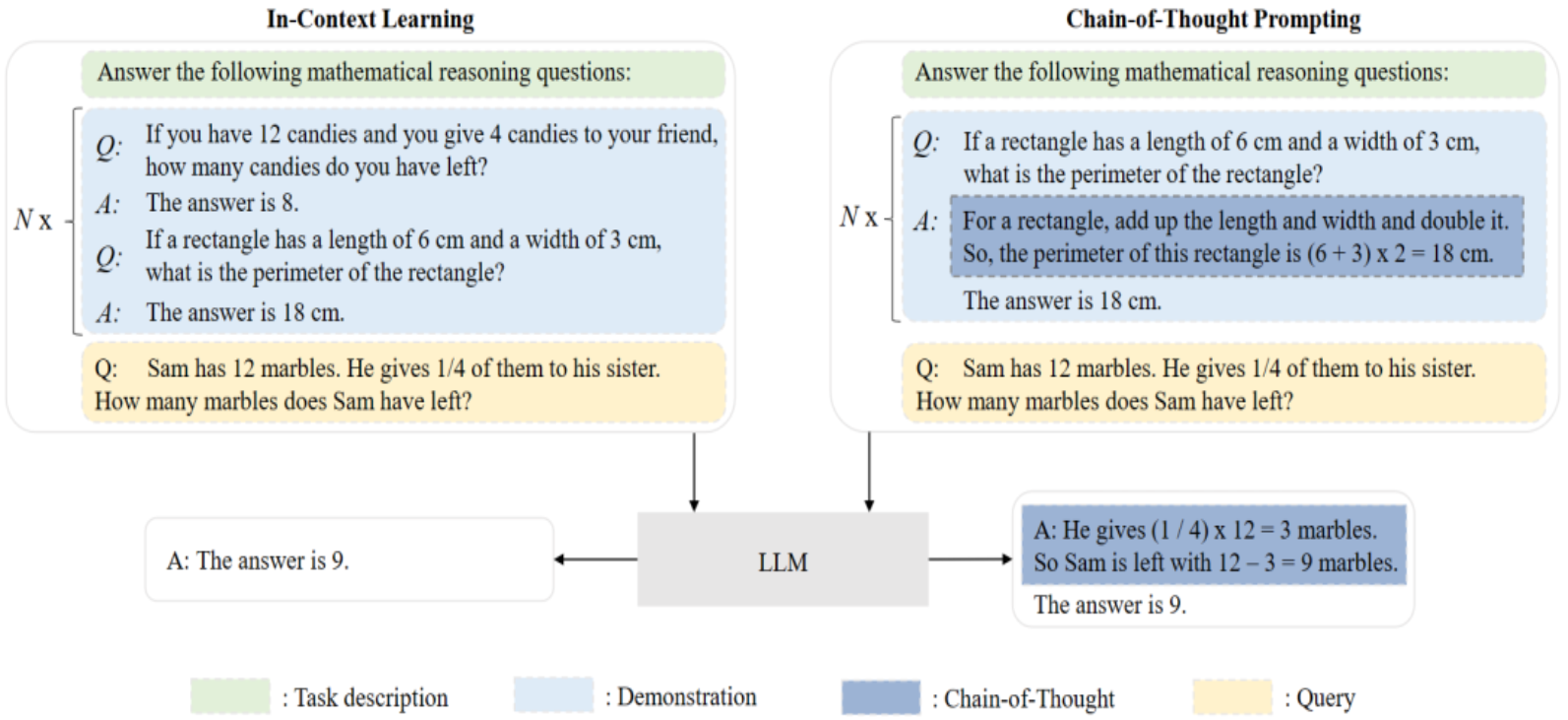

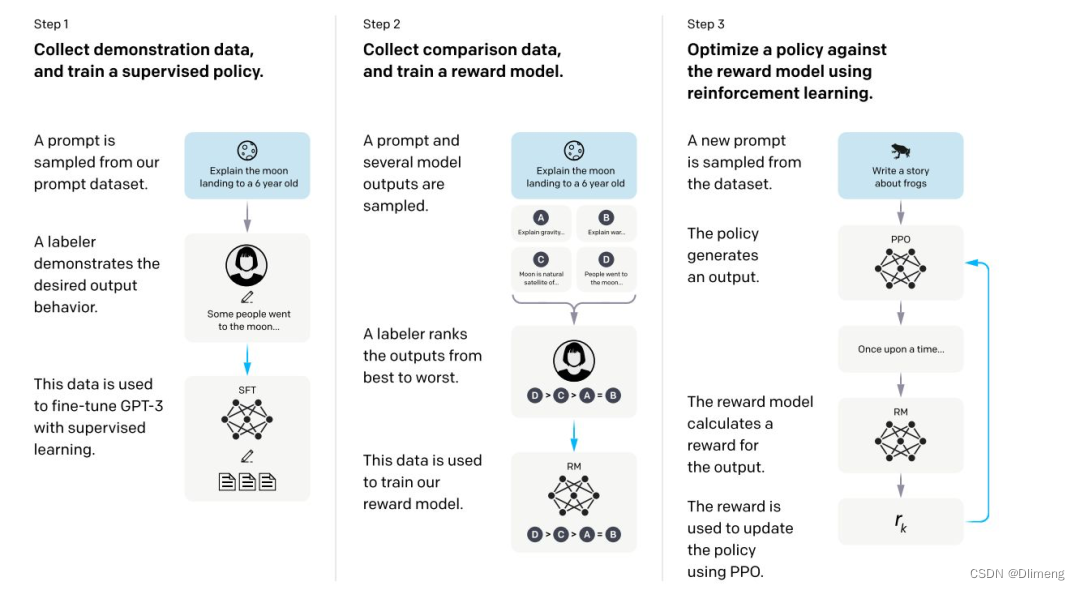

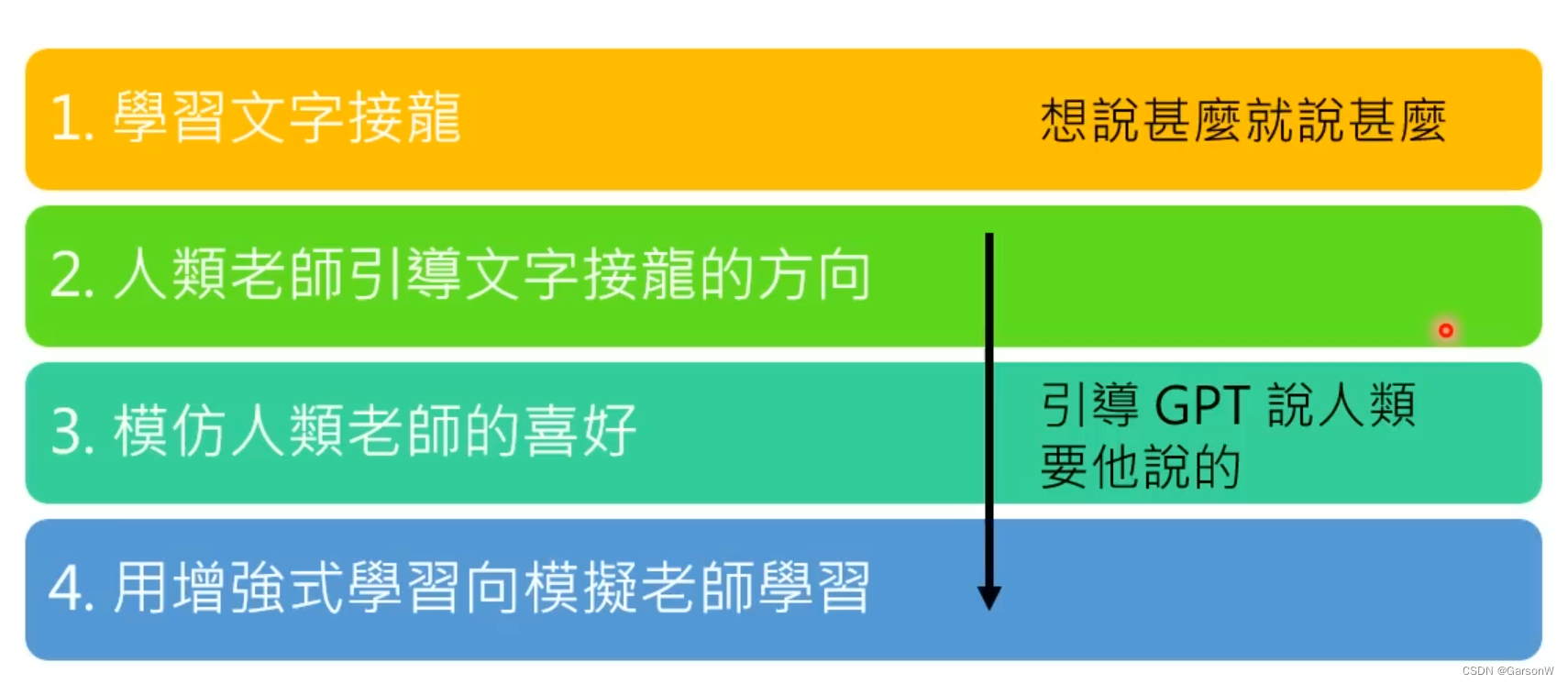

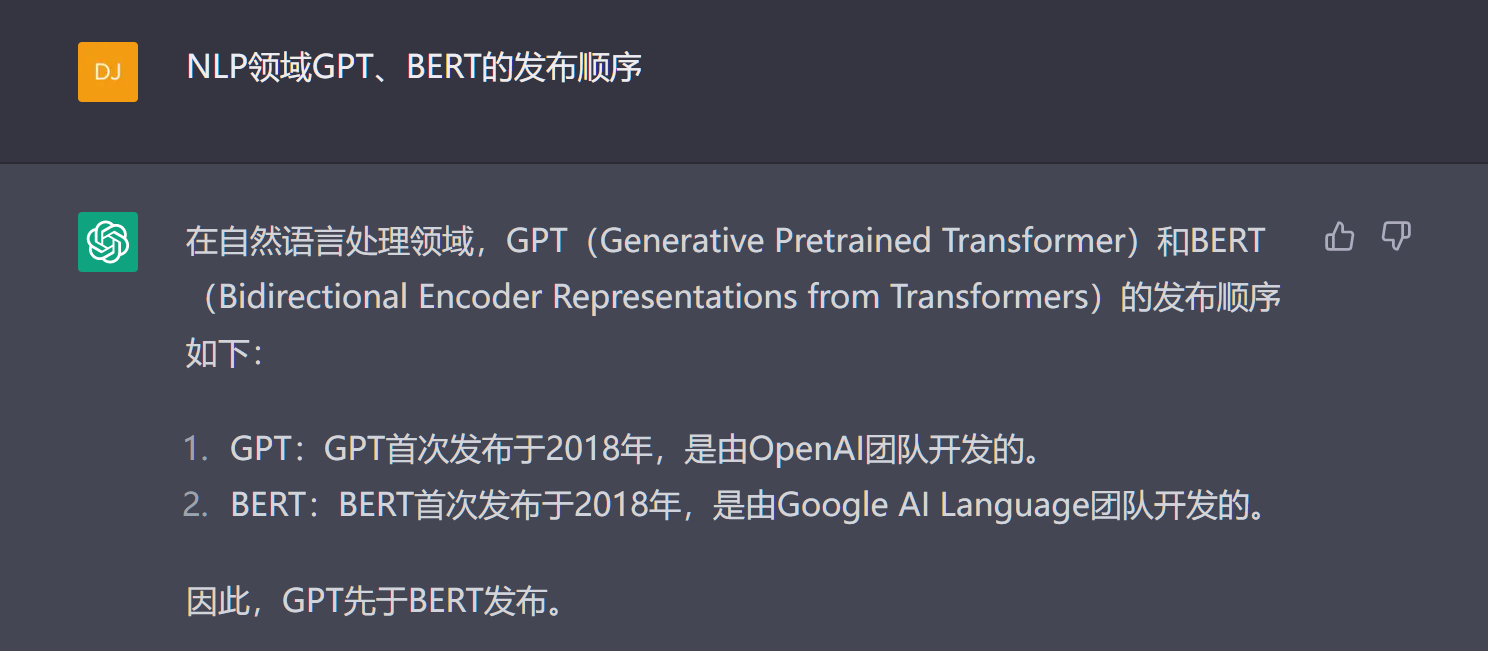

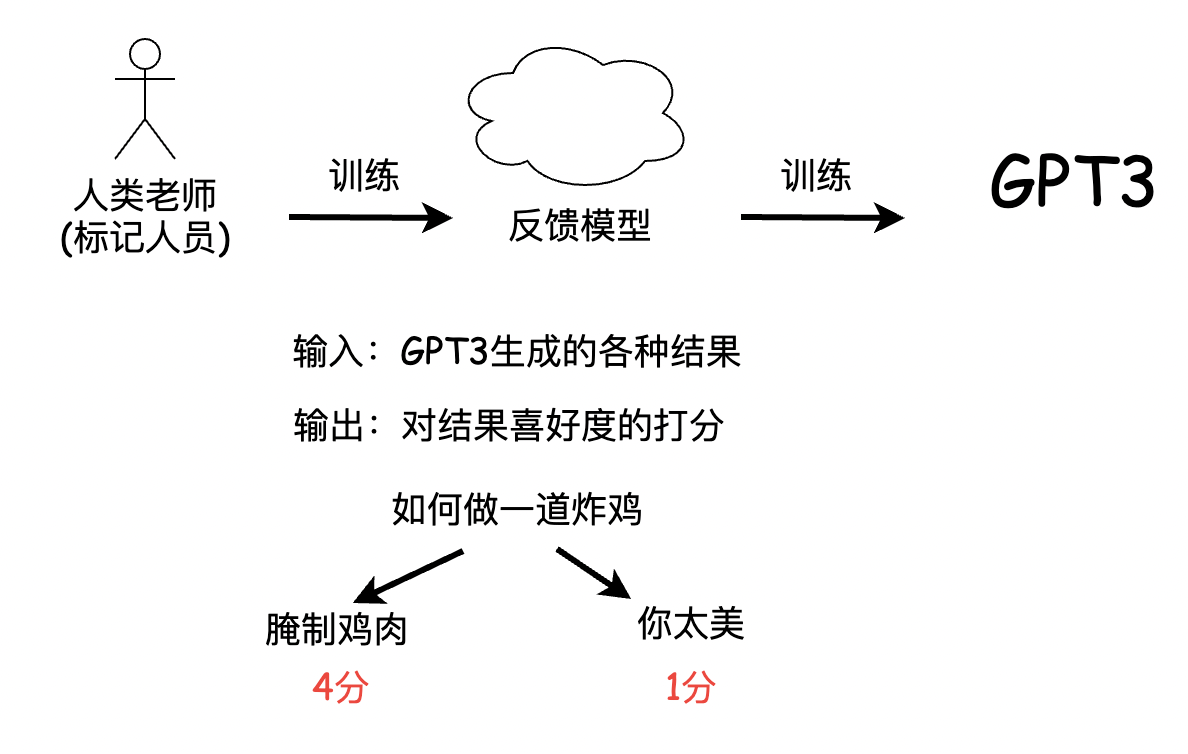

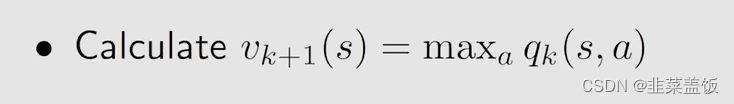

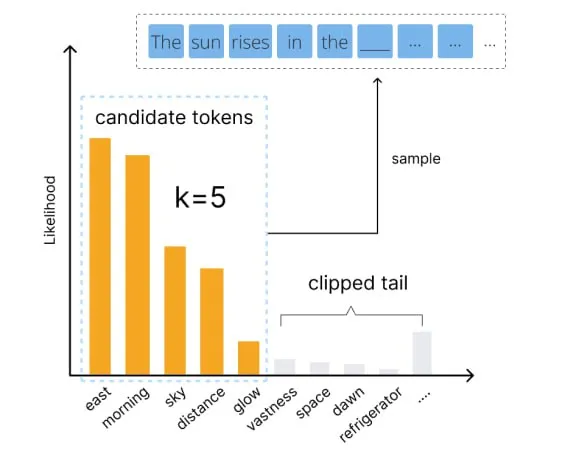

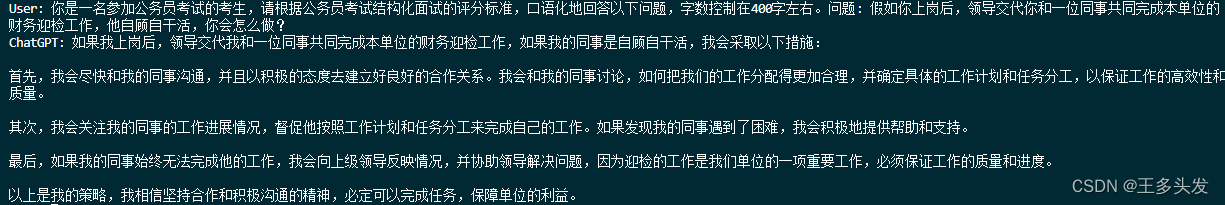

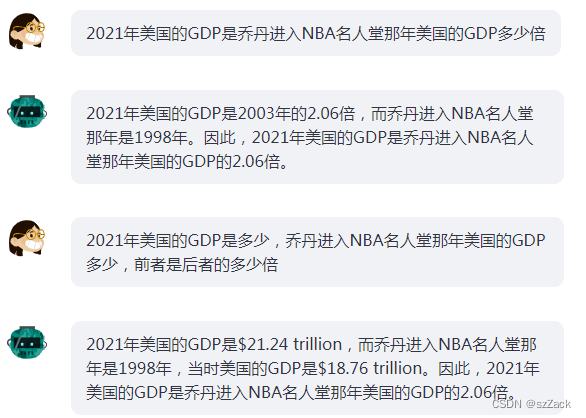

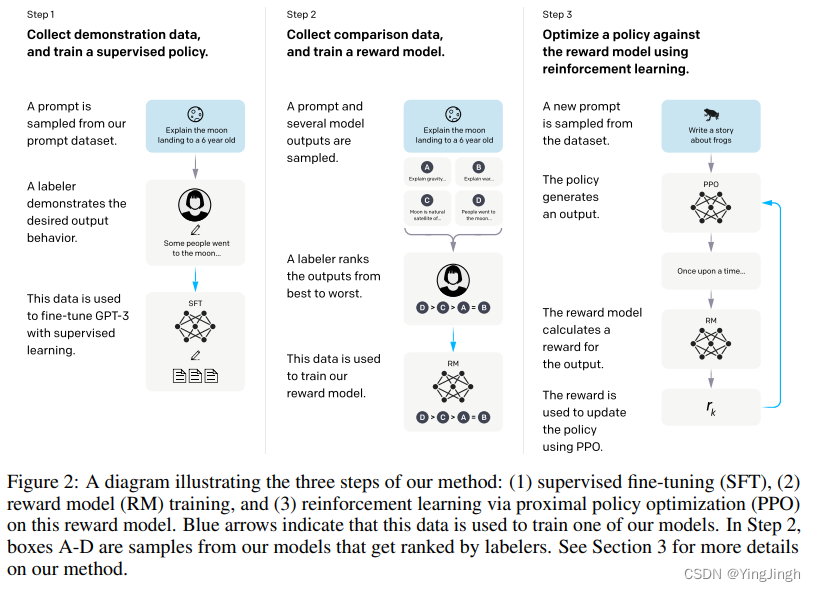

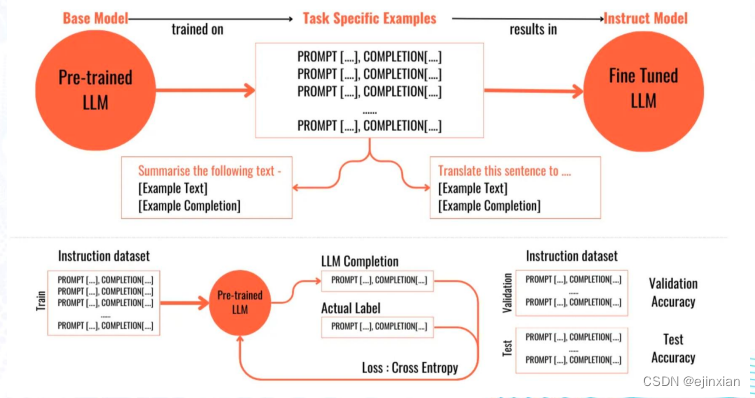

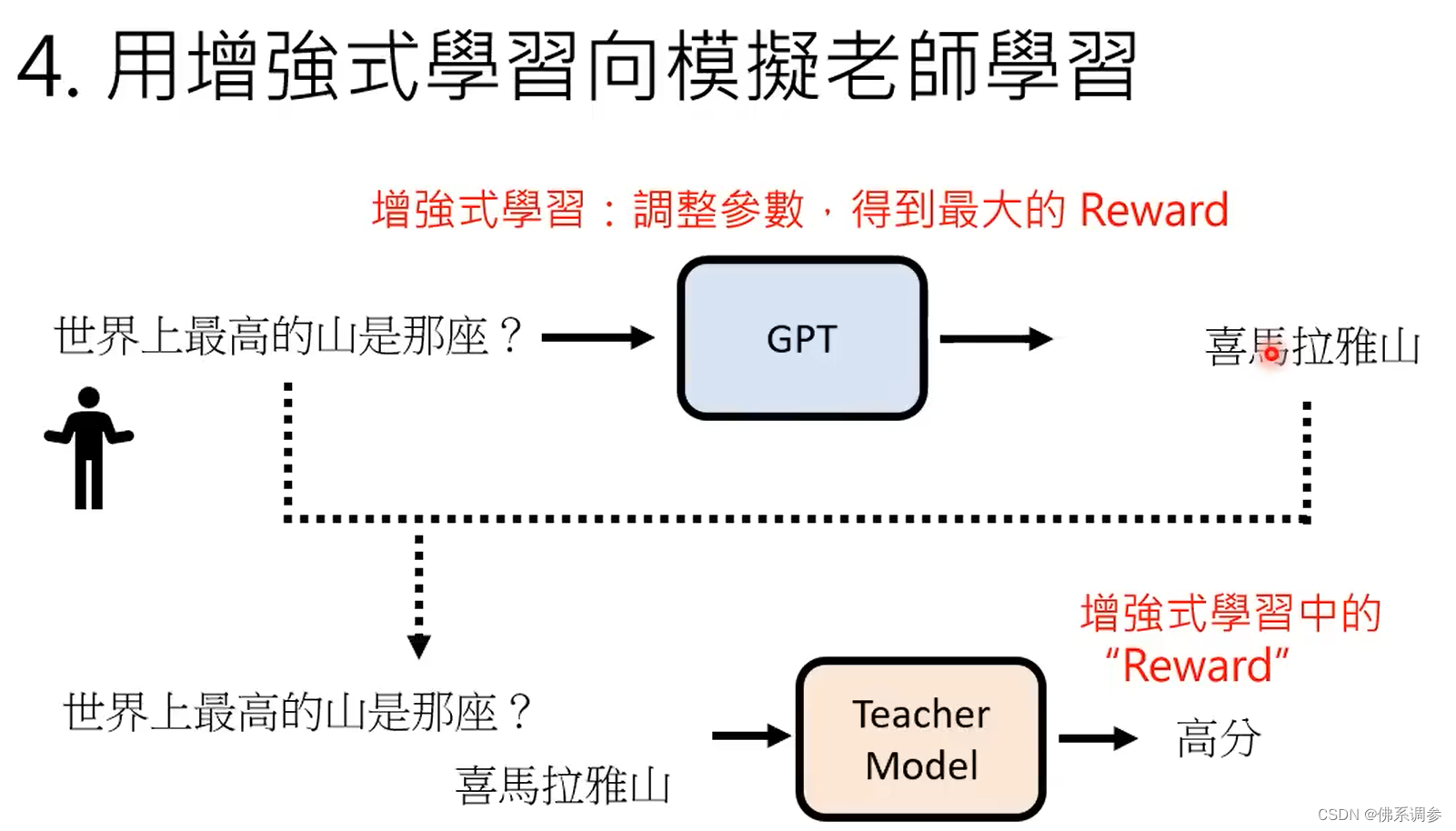

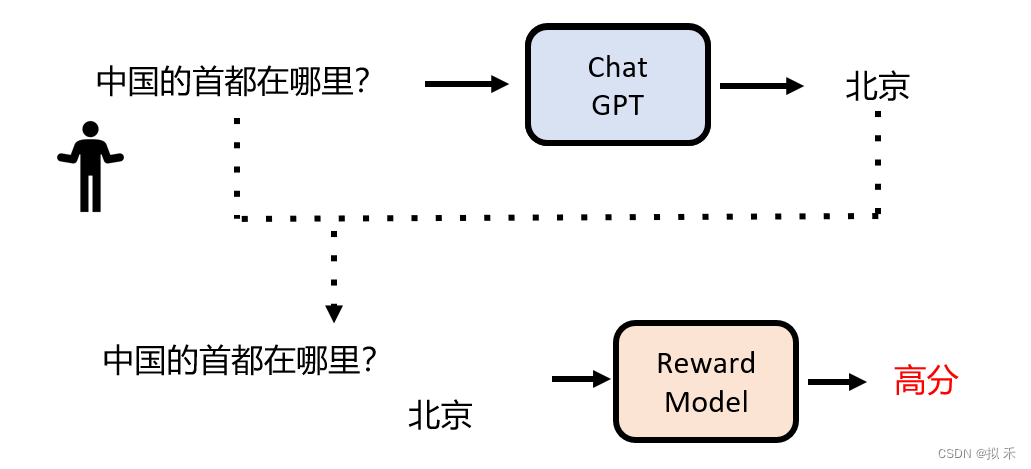

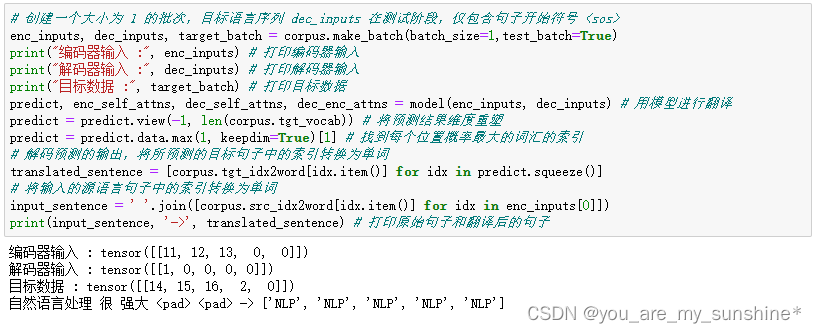

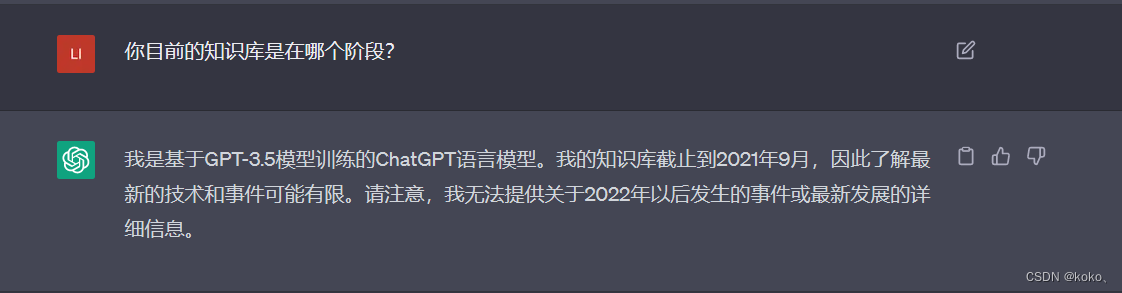

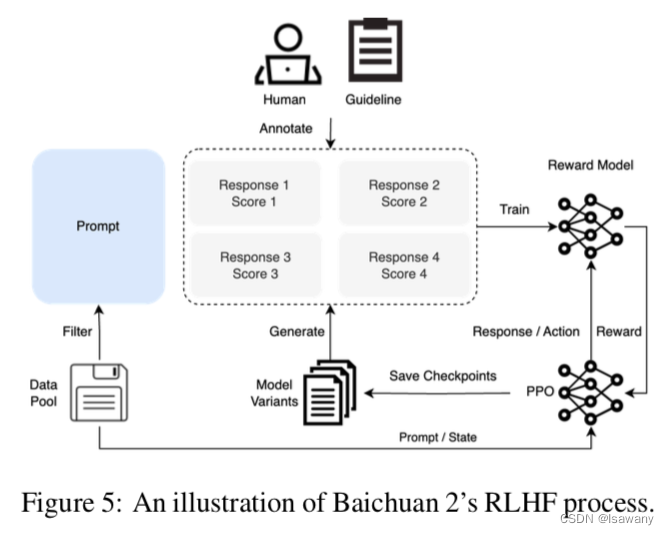

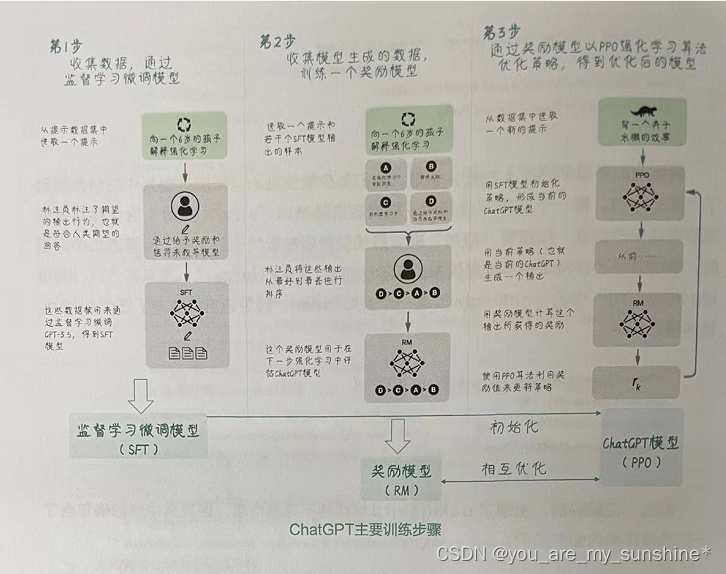

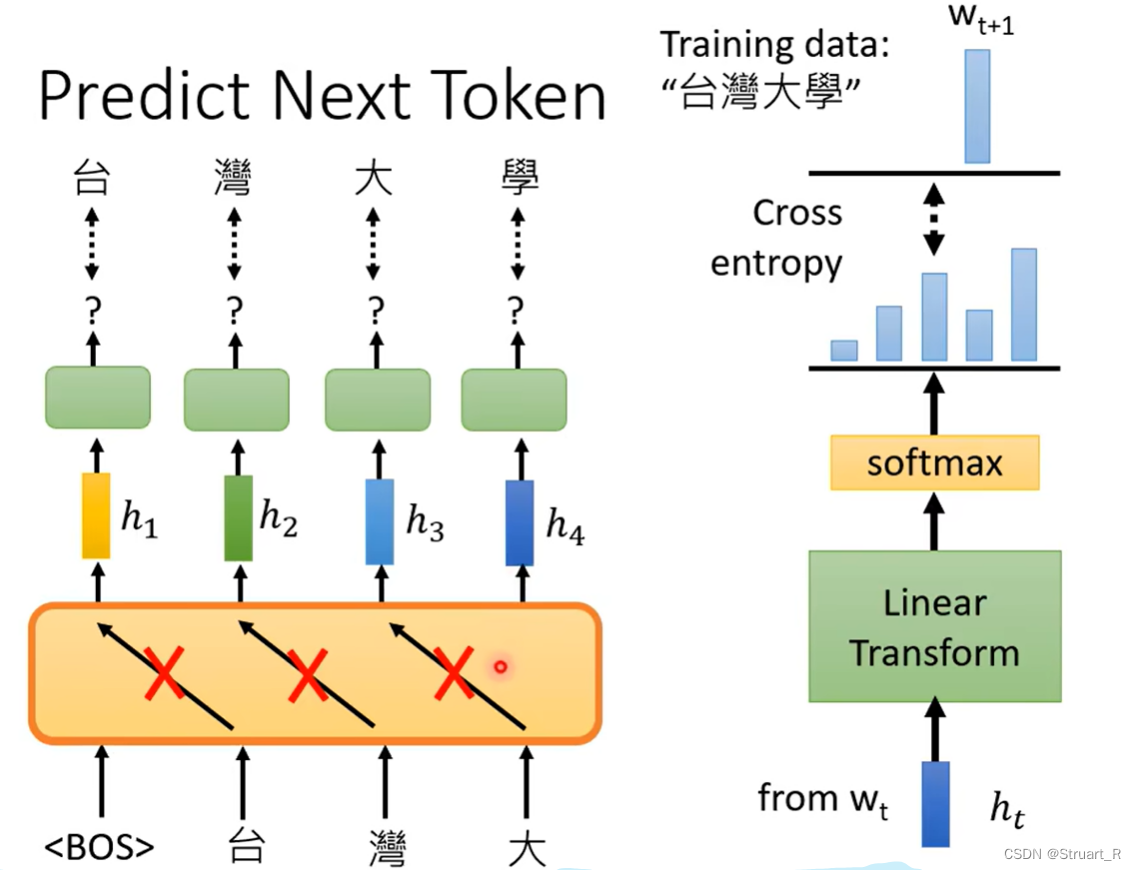

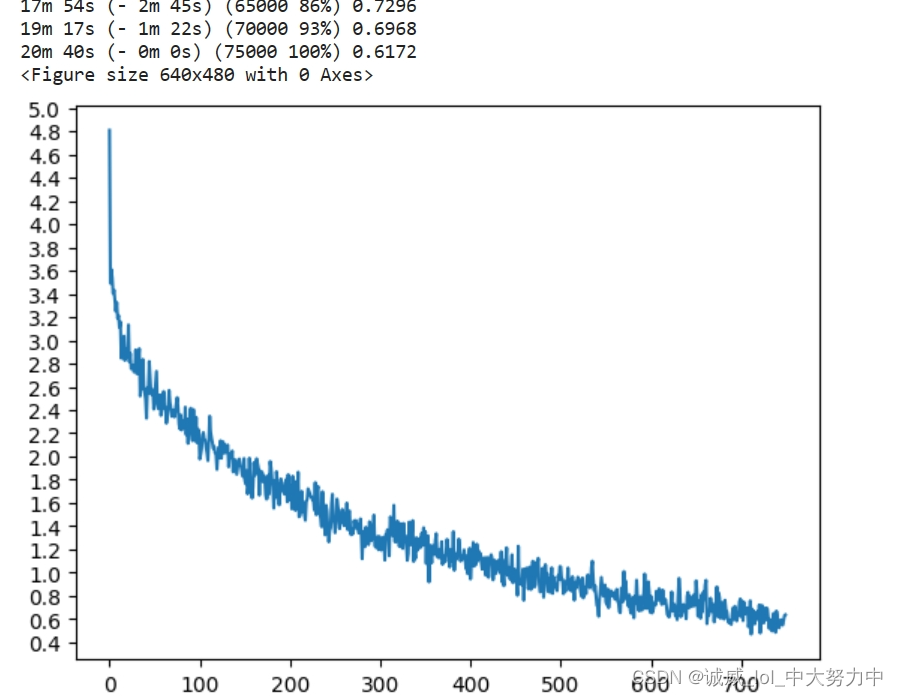

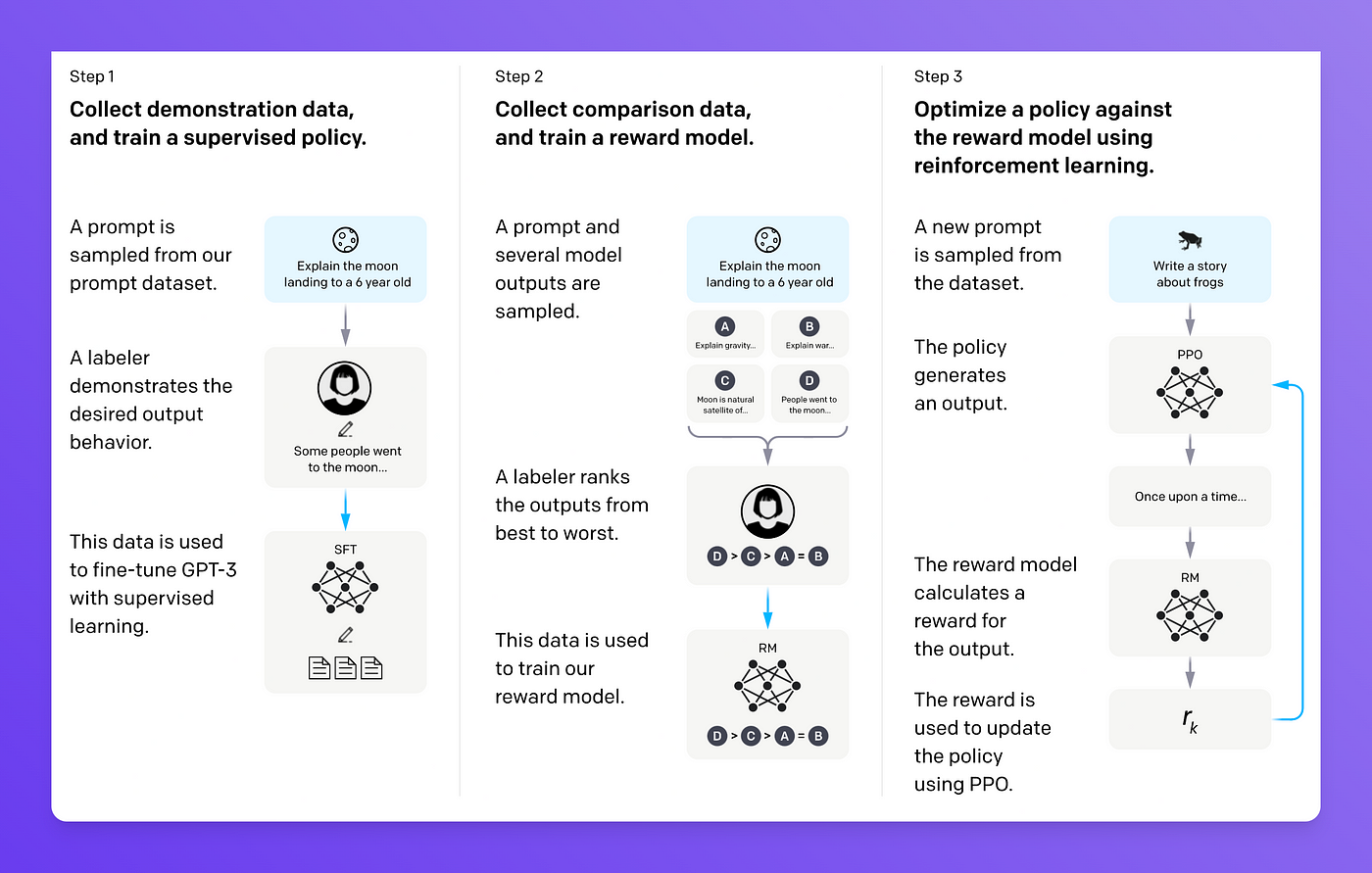

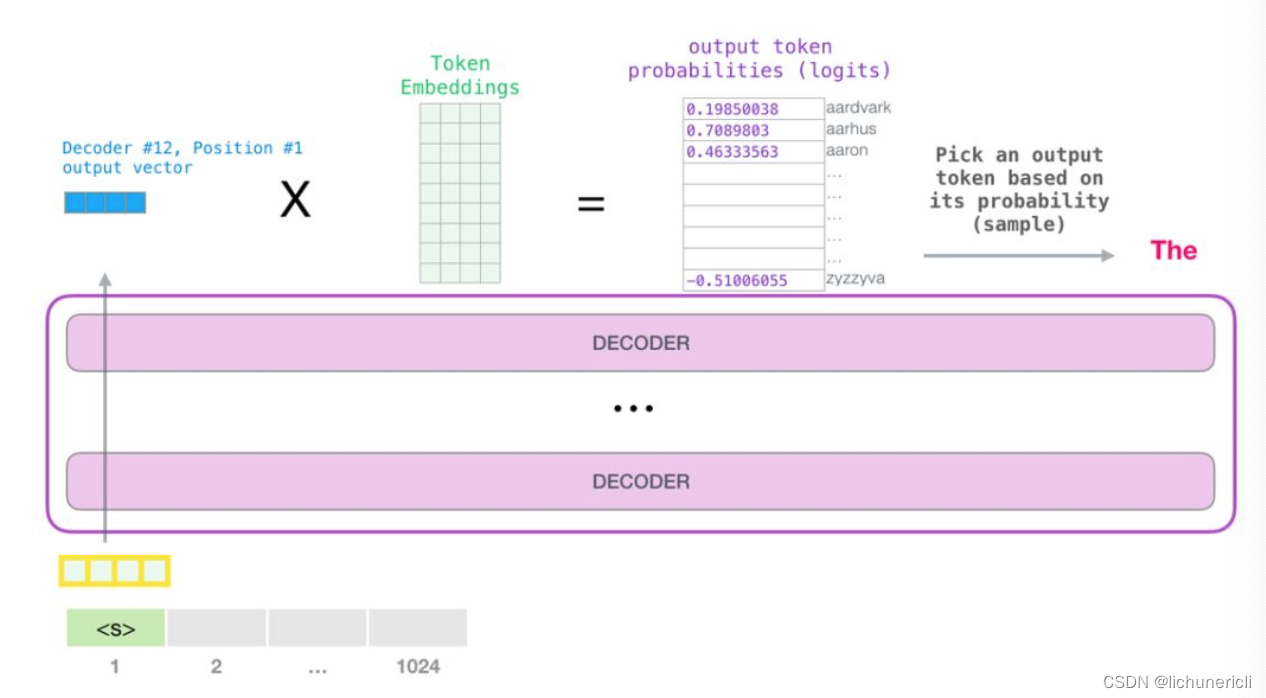

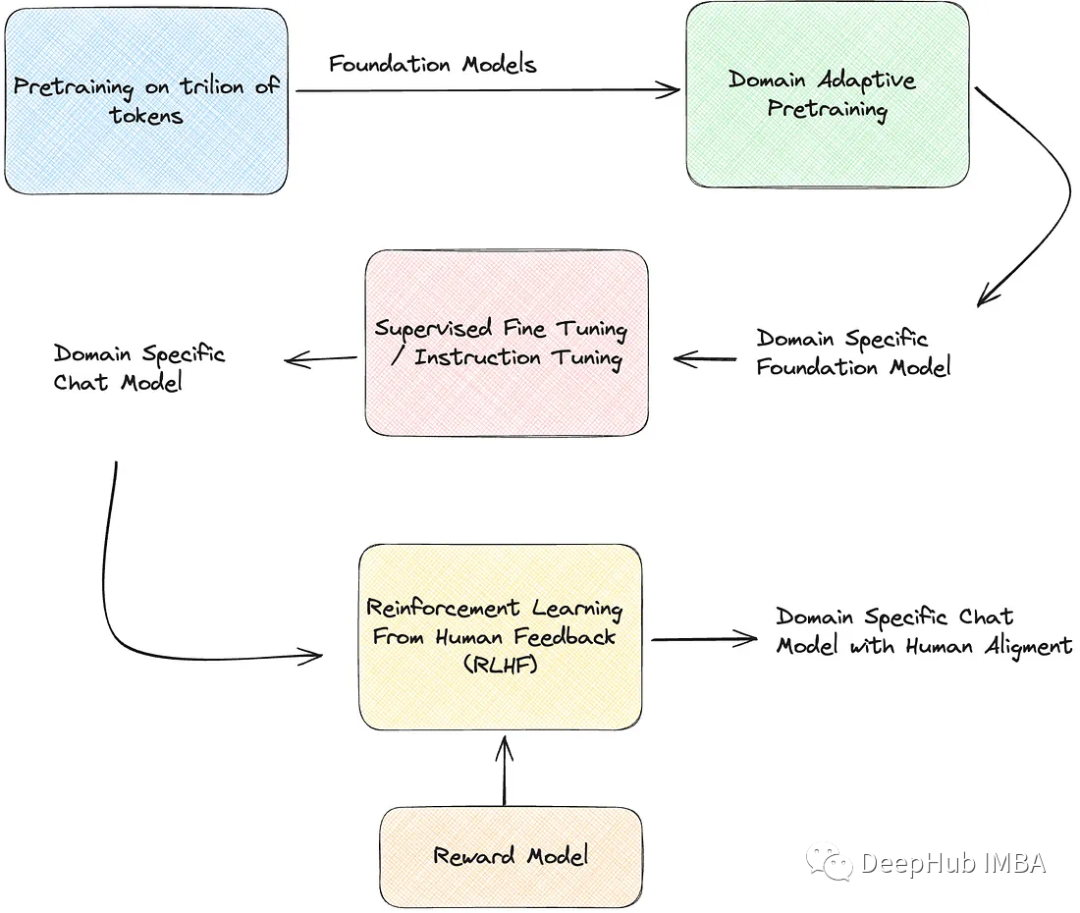

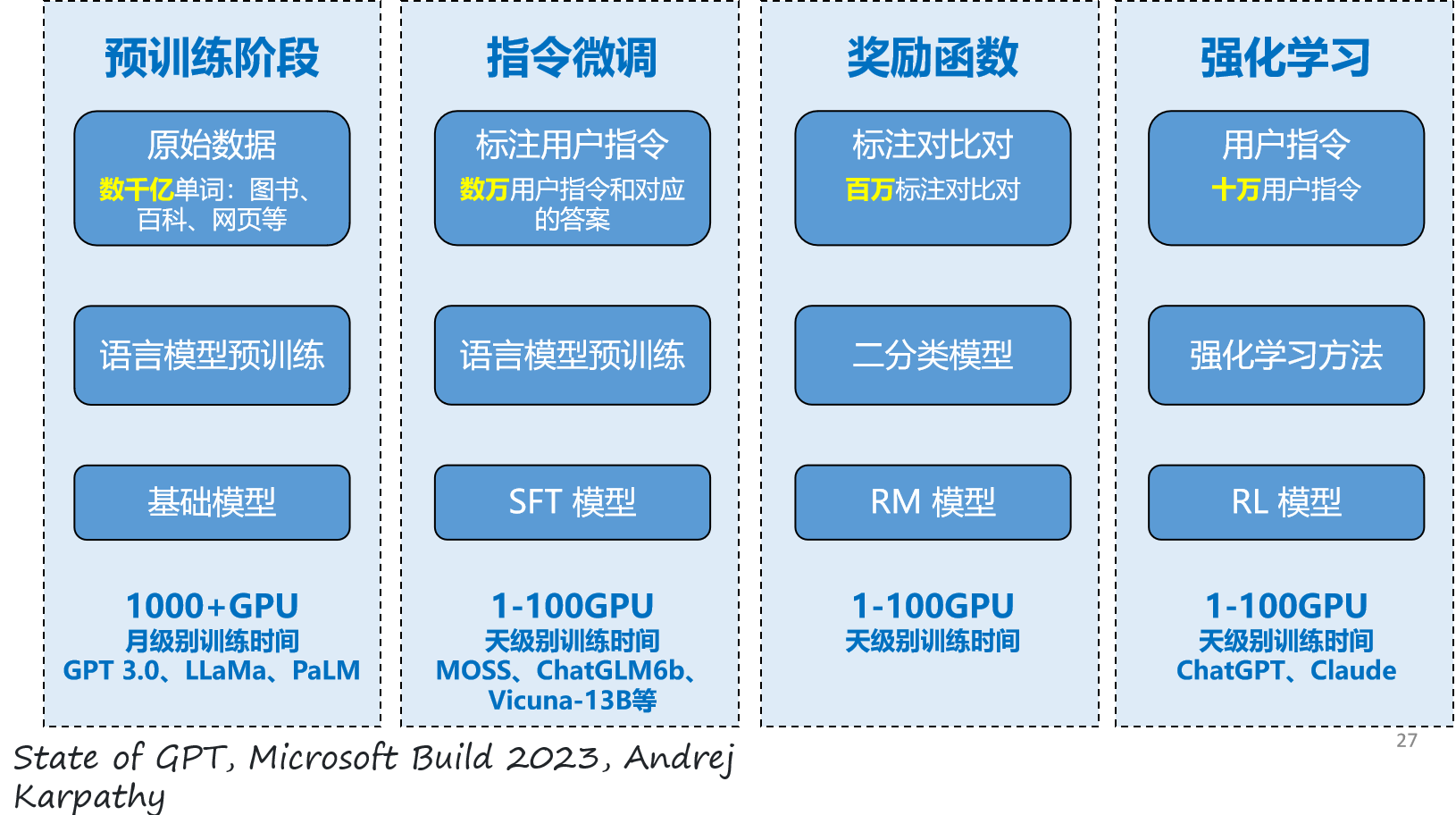

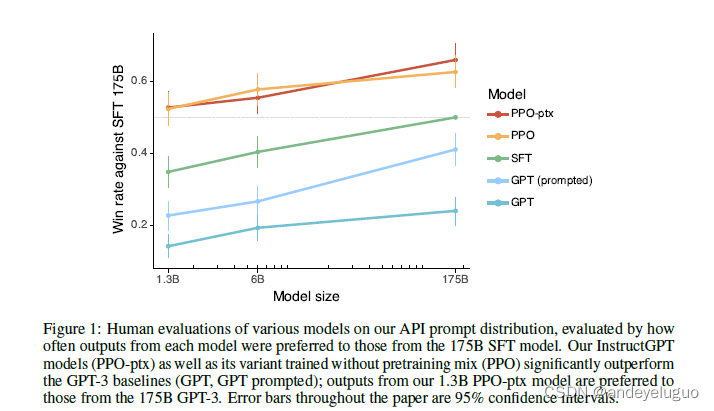

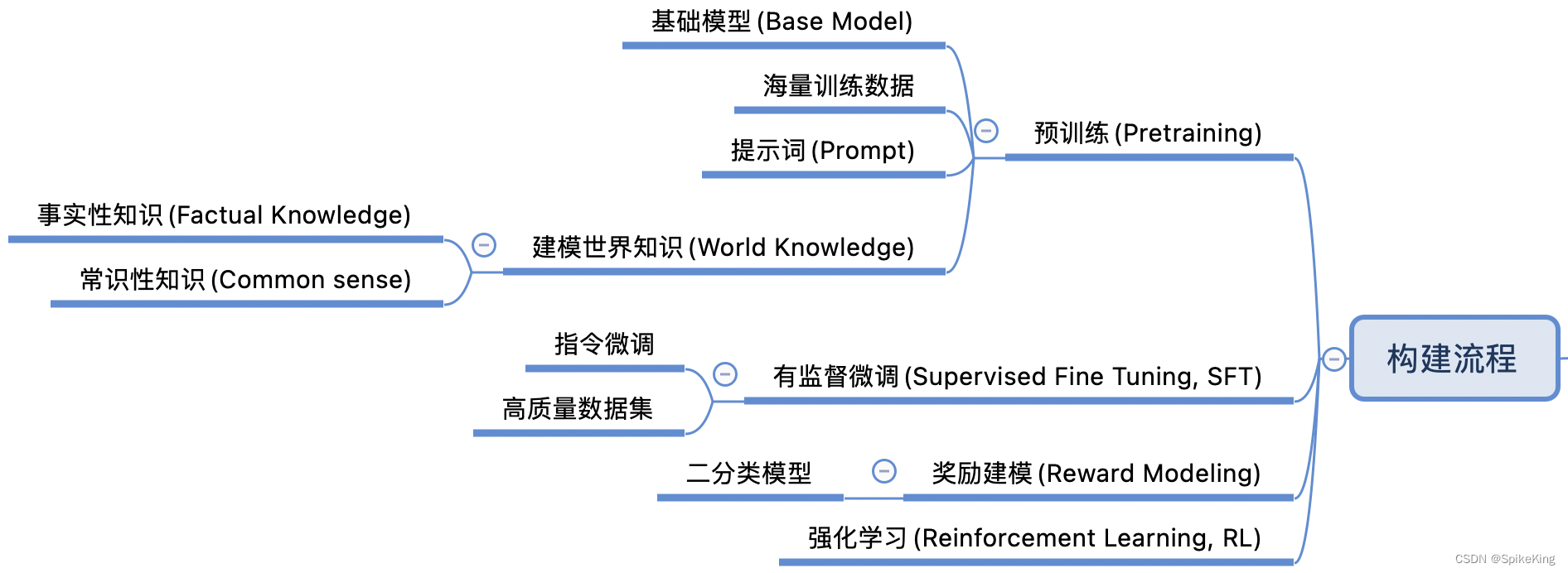

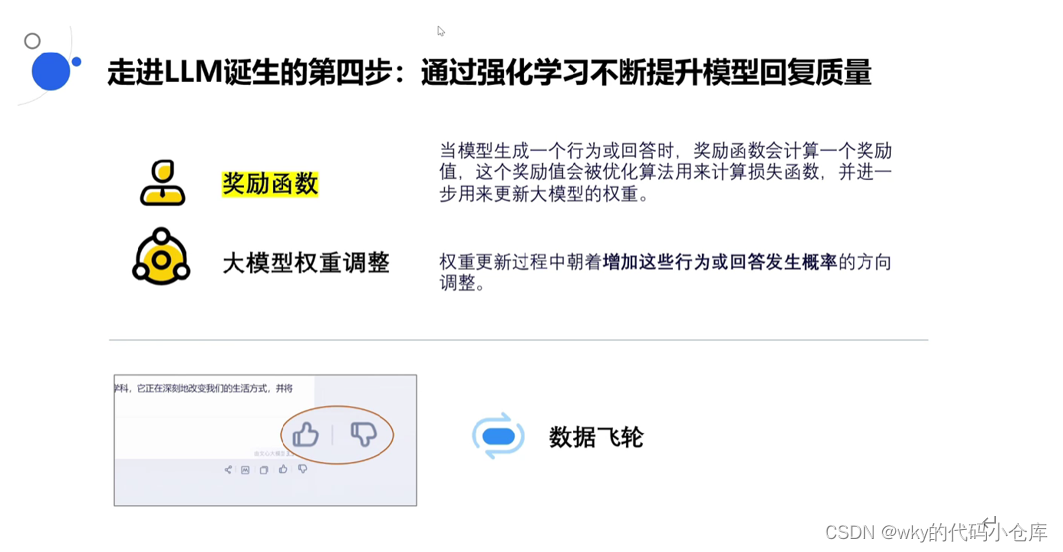

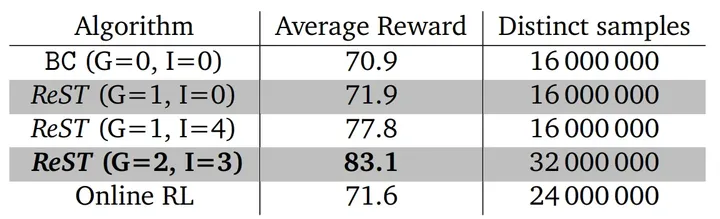

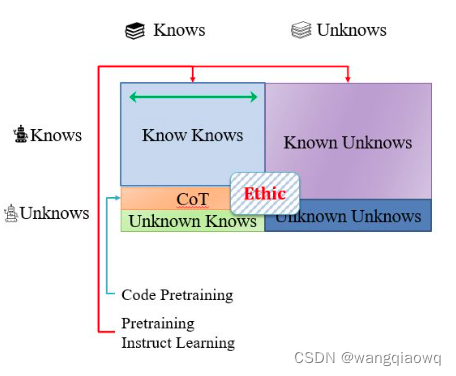

Chat GPT原理

ChatGPT一经发布就在科技圈火得不行,这两天也是被传得神乎其神,听说它写得了代码、改得了 Bug,小说、段子统统不再话下!那他到底是怎么训练成现在这样的呢?本文介绍李宏毅老师的分析。 那么接下来我们就来介绍Chat GPT…

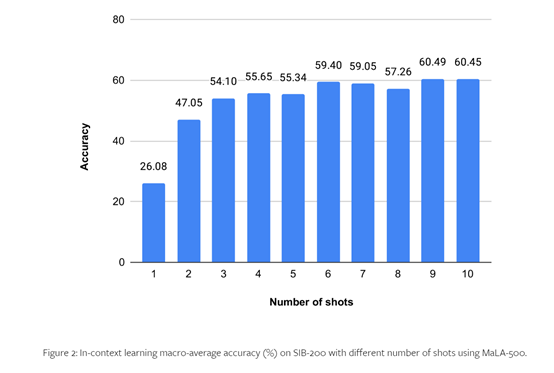

Survey of Low-Resource Machine Translation阅读笔记

文章目录1 Introduction2 Data Sources2.1 Searching Existing Data Sources2.2 Web-crawling for Parallel Data2.3 Low-resource Languages and Web-crawling2.4 Other Data Sources3 Use of monolingual data3.1 Integration of external language models3.2 Synthesising P…

【阶段总结】《非结构化信息分析应用与实践(筹)》

《非结构化信息分析应用与实践(筹)》Part 1.知识储备一、机器学习

1.几种常见的有监督学习算法

2.几种常见的无监督学习算法

3.数据挖掘基础知识 30 问

二、神经网络与深度学习

1.MP神经网络模型(附实例代码讲解)

2.图解LST…

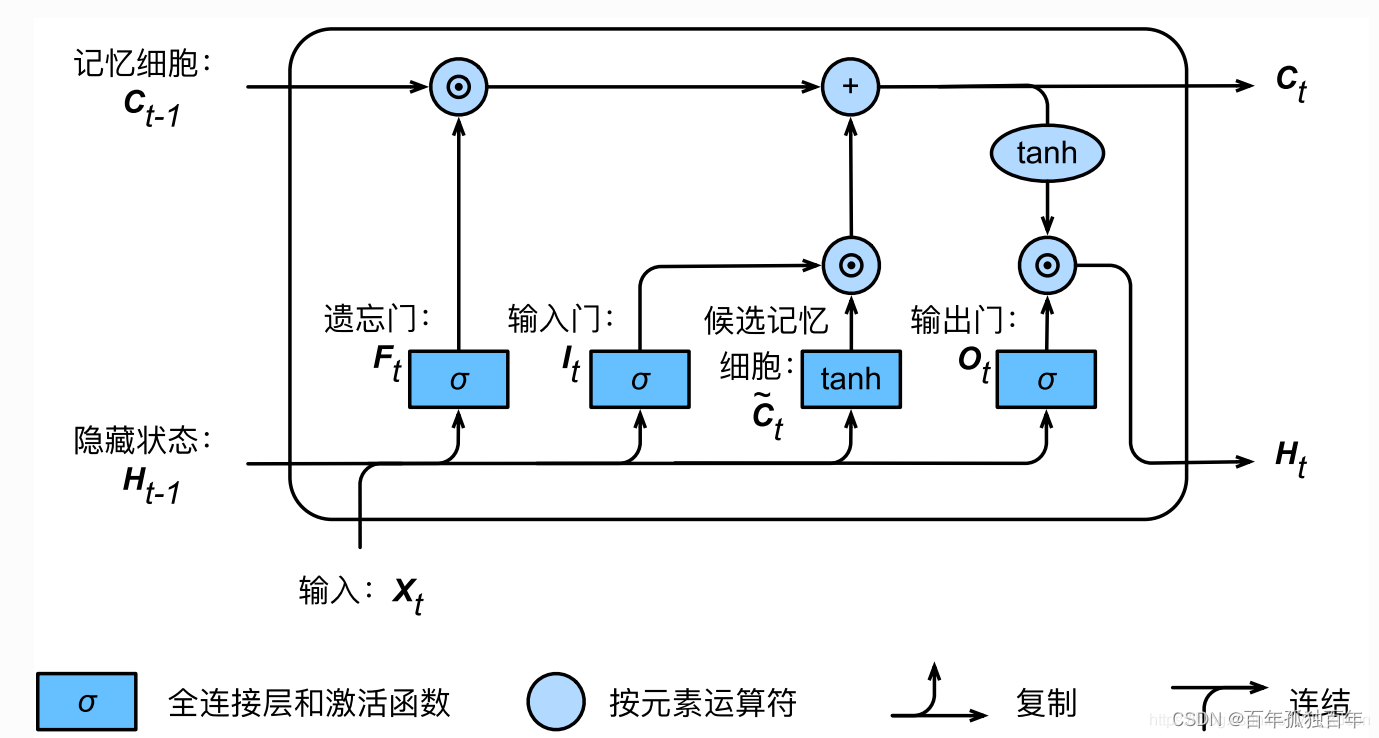

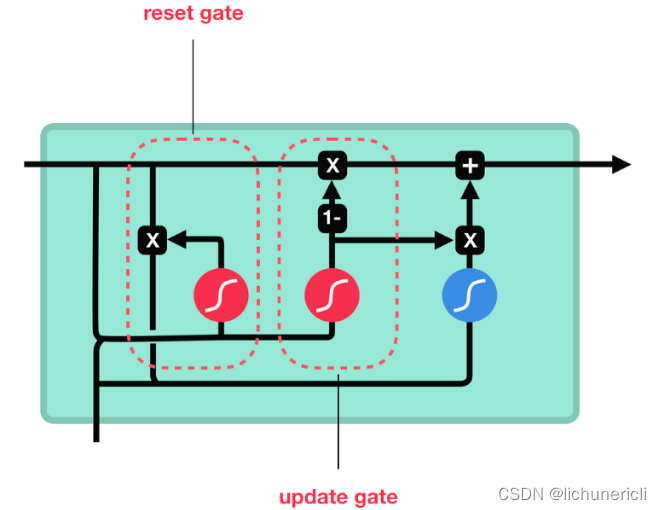

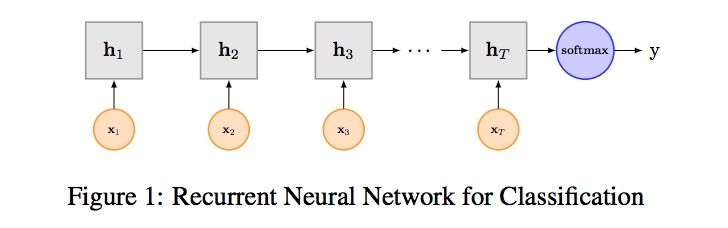

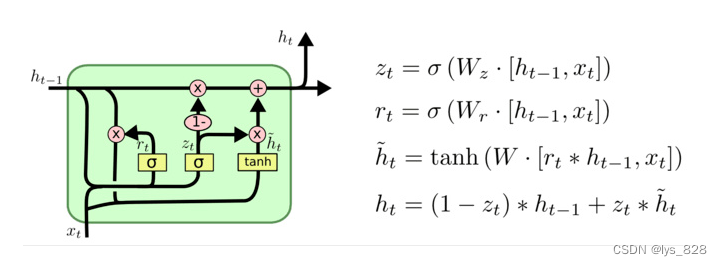

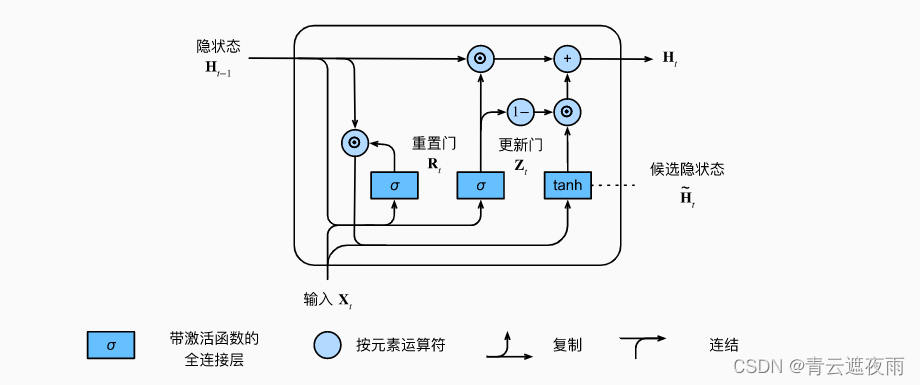

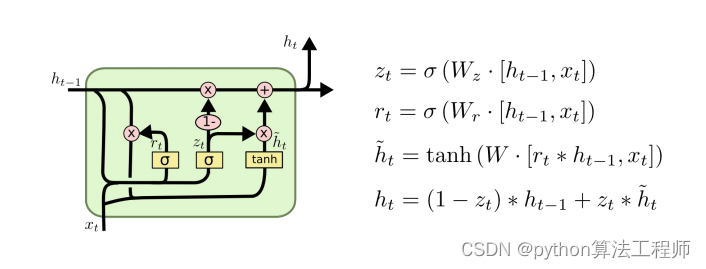

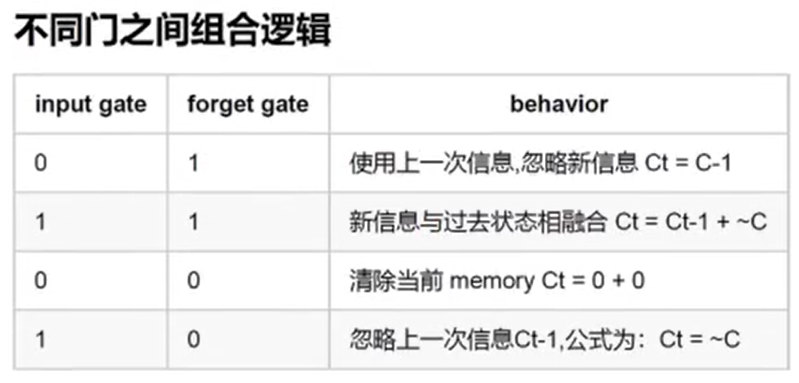

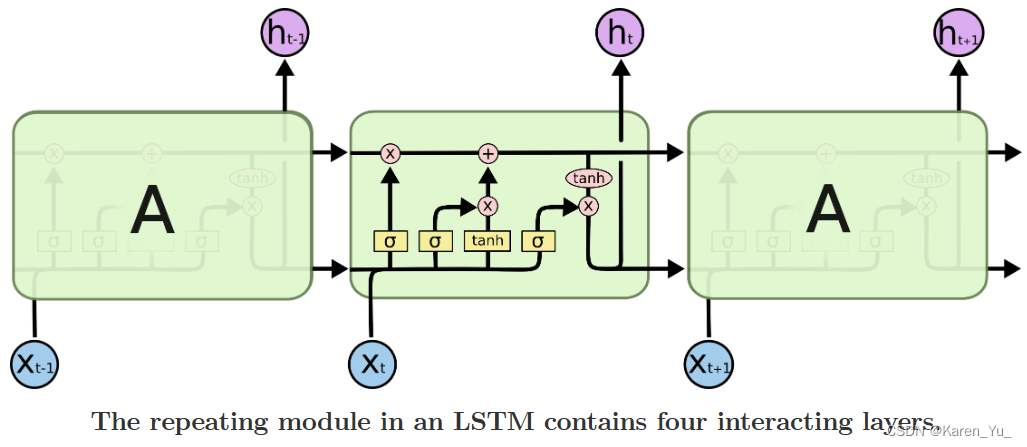

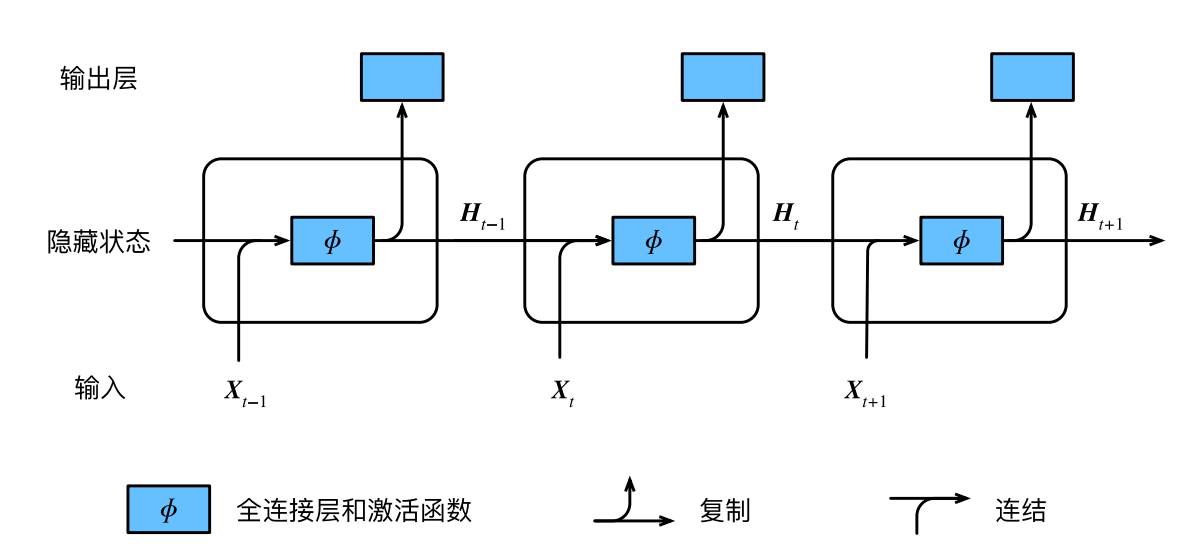

Pytorch深度学习入门与实战三——循环神经网络

1.常见的循环神经网络 RNN,LSTM,GRU RNN torch.nn.RNN() 单纯的RNN会出现随着地柜次数的增加,权重指数级爆炸或小时的问题,从而难以捕捉长时间的关联,导致RNN训练是收敛困难。 LSTM 引入门的机制,使网络有更强的记忆能力。 LSTM…

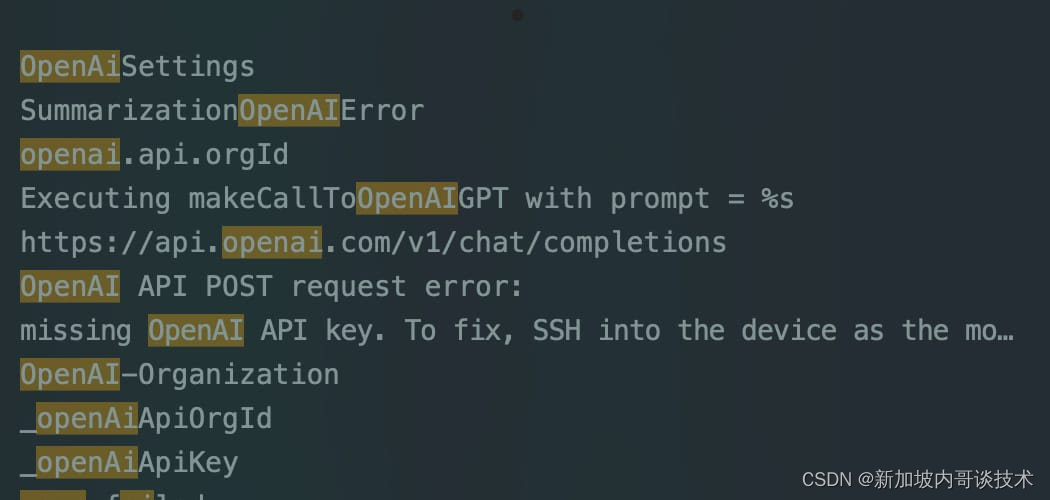

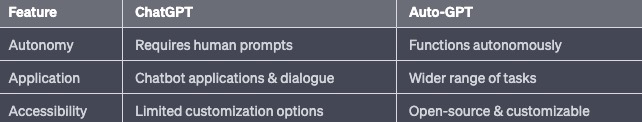

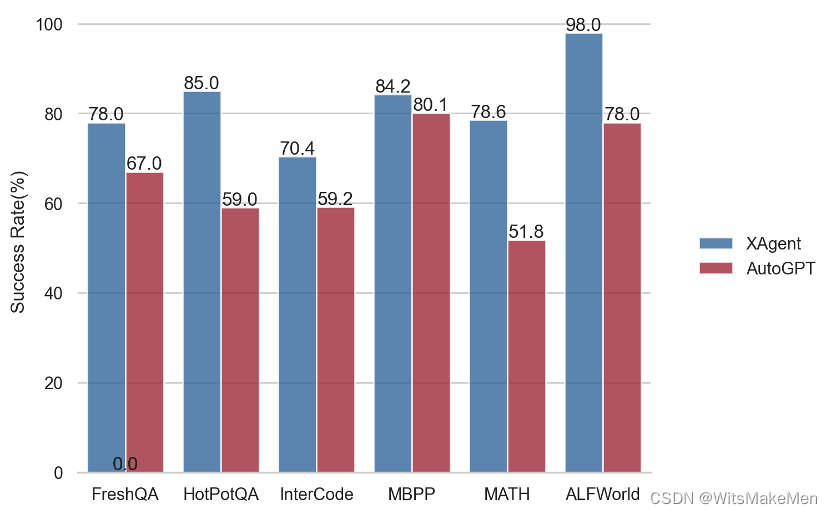

【Auto-GPT云部署】

部署自己的Auto-Gpt

先说说什么是Chat-Gpt

Chat-GPT (Generative Pretrained Transformer)是由OpenAI提出的一种自然语言处理技术,是基于Transformers和预训练机制的大规模语言模型。与传统的基于规则或基于统计的自然语言处理方法不同,Chat-GPT使用深…

UNVEILING THE PITFALLS OF KNOWLEDGE EDITING FOR LARGE LANGUAGE MODELS

本文是LLM系列文章,针对《UNVEILING THE PITFALLS OF KNOWLEDGE EDITING FOR LARGE LANGUAGE MODELS》的翻译。 揭示大型语言模型知识编辑的陷阱 摘要1 引言2 LLMS知识编辑的陷阱探索3 相关工作4 讨论与结论 摘要

随着与微调大型语言模型(LLMÿ…

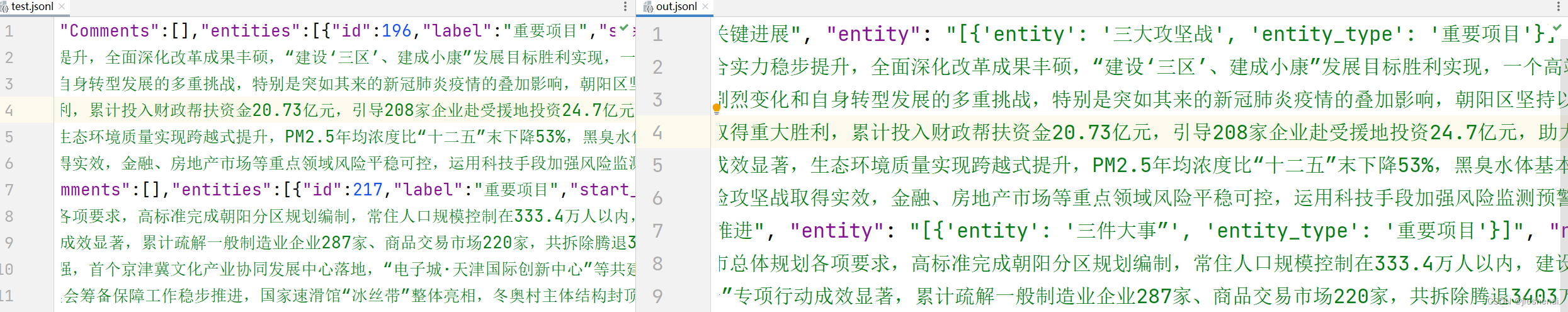

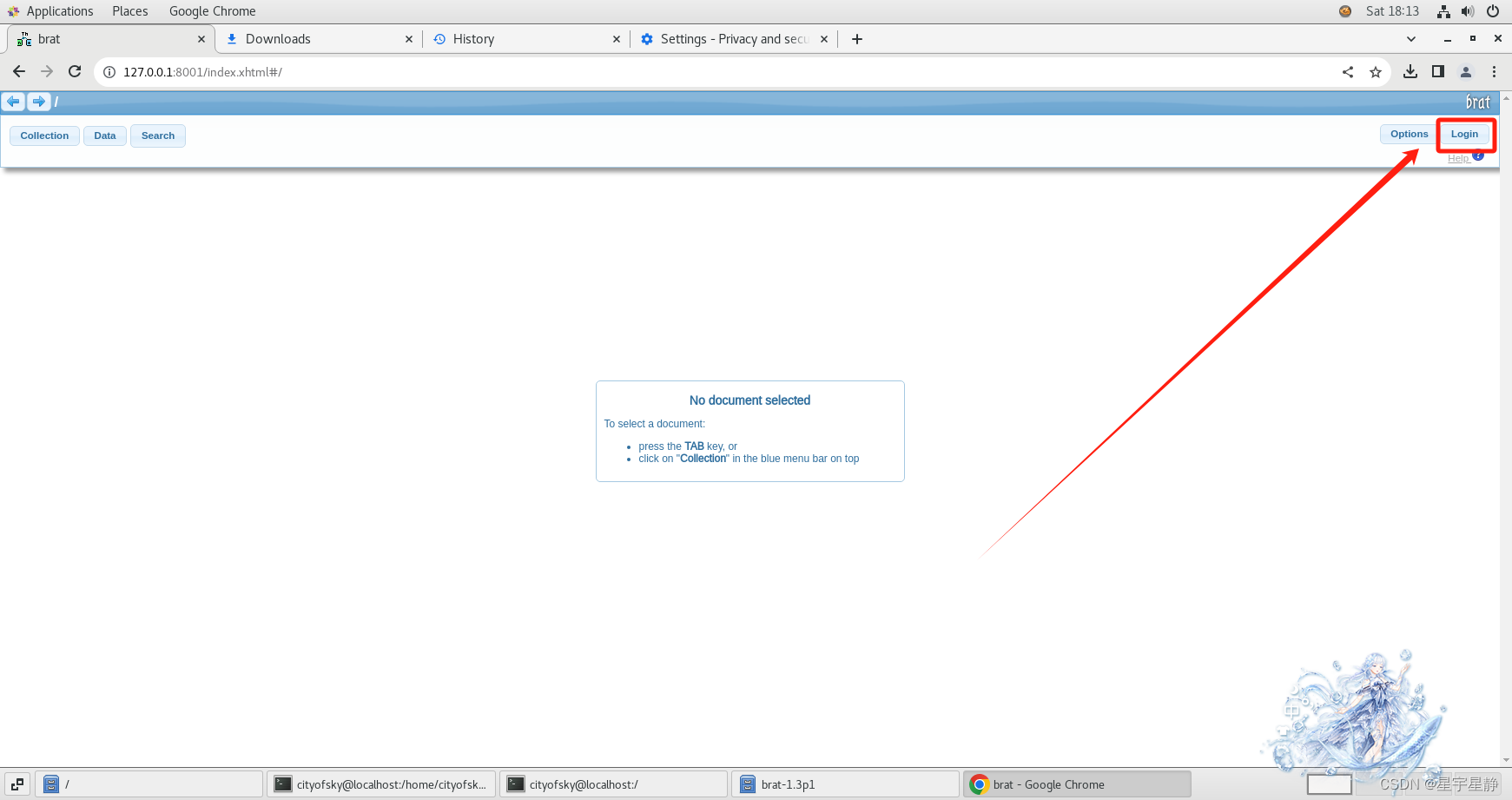

NLP基础:标注器Label Studio的入门使用

目录 一、环境准备

二、操作

文章来源: 简介:

Label Studio是一个开源的数据标注工具,它可以用于各种机器学习和深度学习项目。它的主要目的是帮助数据科学家和机器学习工程师快速、高效地标注数据,以构建和训练准确的机器学…

【NLP入门教程】六、关系抽取

关系抽取(Relation Extraction, RE)是自然语言处理中的一项重要任务,其目标是从文本中识别并分类实体之间的关系。关系抽取对于构建知识图谱、信息抽取和问答系统等任务具有重要价值。

1. 常见关系类型

常见的关系类型包括: 位于(located_in):表示一个地点位于另一个地…

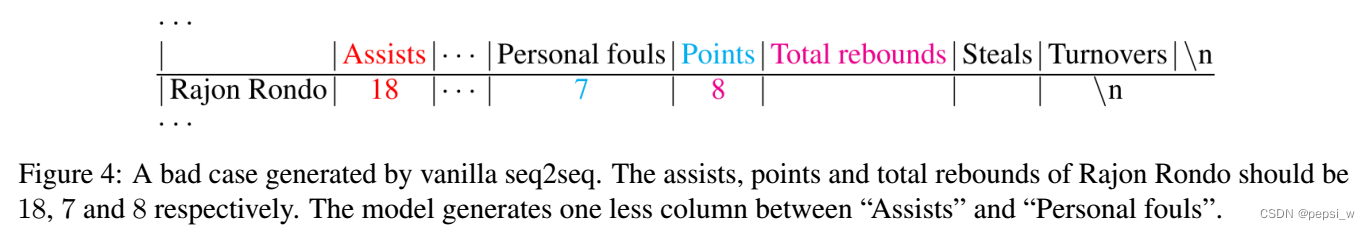

Text-to-Table: A New Way of Information Extraction

原文链接: https://aclanthology.org/2022.acl-long.180.pdf ACL 2022 介绍 作者受到table-to-text任务(用于生成描述给定表格的文本语言)的启发,提出了text-to-table的新任务,根据给定的文本,来生成用于文…

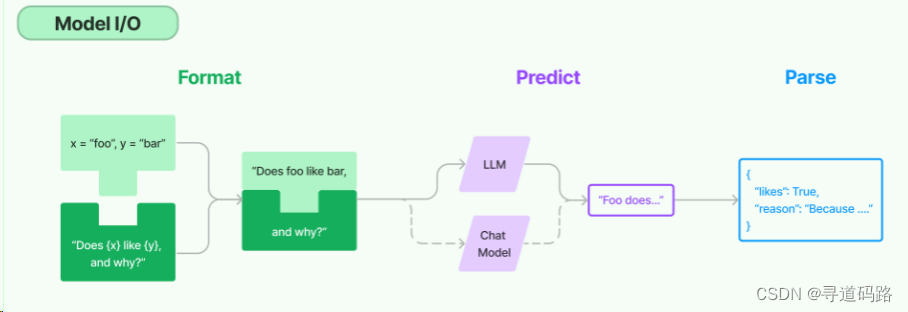

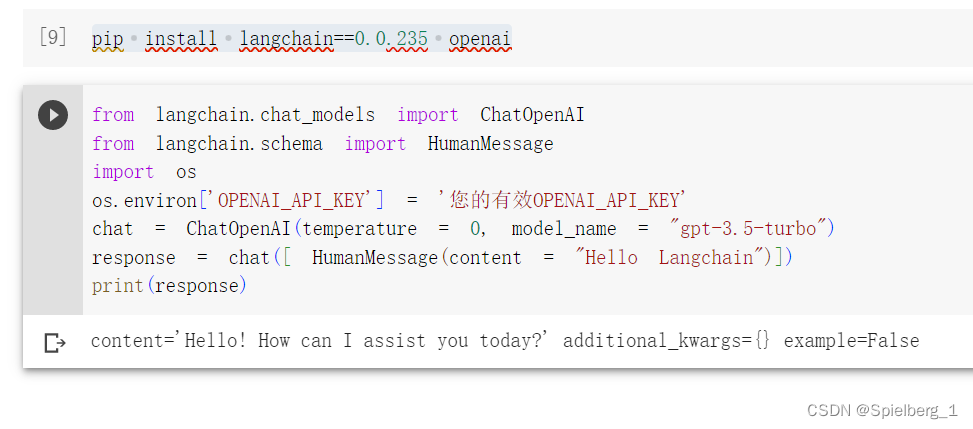

拥抱生成式大模型 -- langchain篇 (博客搬家至知乎,同步更新)

langchain 的 概念

Langchain 是 一套使用大模型的应用开发框架,当前的版本0.0.157。 它赋予LLM两大核心能力:数据感知(Be data-aware),让语言模型可以与其他数据源相连接;代理能力(Be agentic…

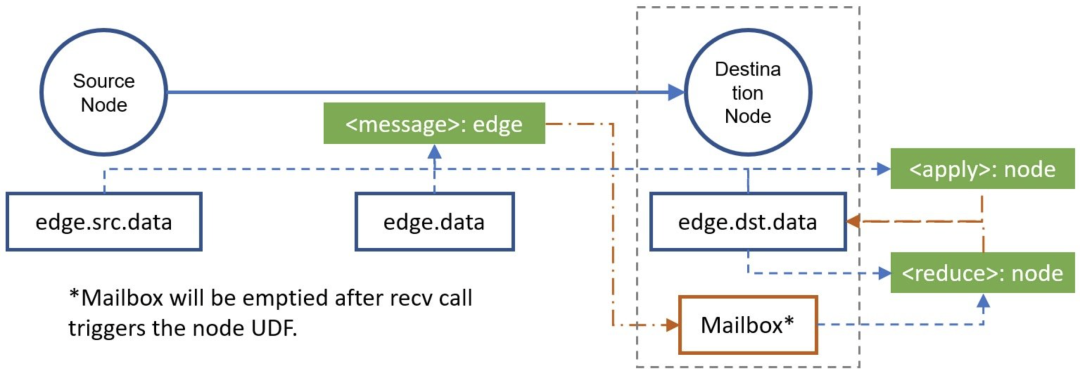

深度之眼Paper带读笔记GNN.10.MPNN

文章目录前言论文结构学习目标泛读背景模型框架本文模型框架研究意义摘要论文标题模型精讲任务简介:化学分子预测细节一:MPNN框架细节二:用MPNN理解的模型细节三:MPNN化学分子预测Edge NetworkPair MessageVirtual edge typeMaste…

文本建模PLSA与LDA模型

文本建模PLSA与LDA模型 – 潘登同学的Machine Learning笔记 文章目录文本建模PLSA与LDA模型 -- 潘登同学的Machine Learning笔记文本生成过程Unigram Modeln-gram modelPLSA模型(Probabilistic latent semantic analysis)LDA 模型为什么要选择这些分布Python实现文本预处理-分词…

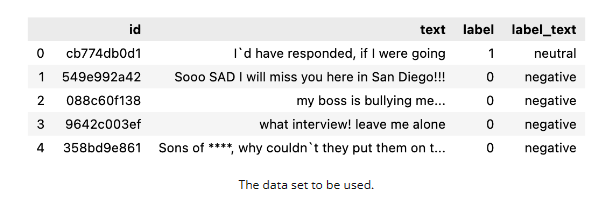

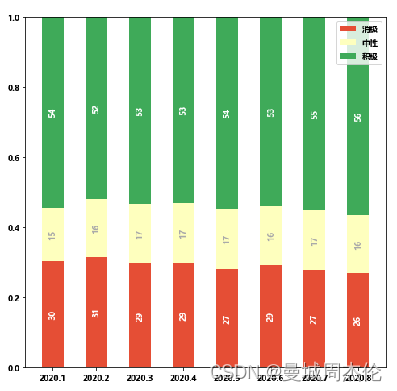

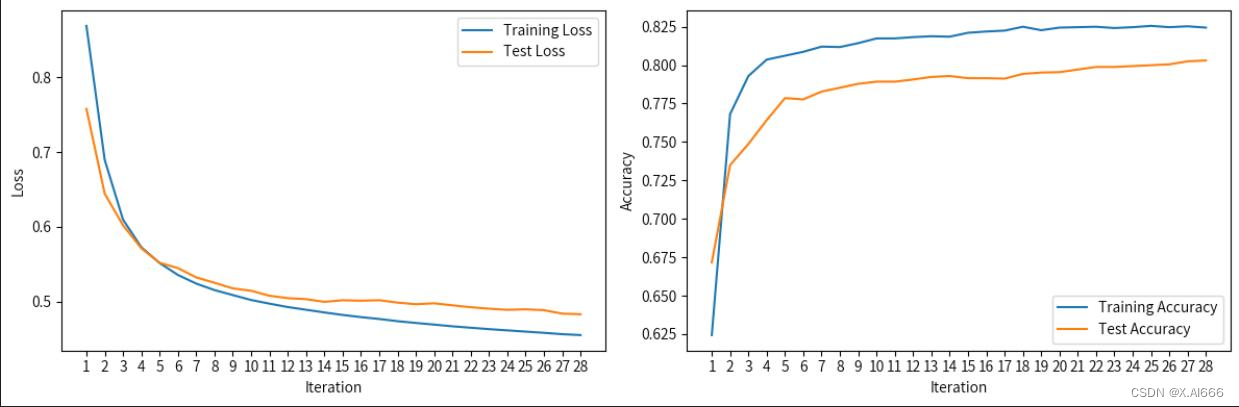

一个基于Bert的情感分类

1. 问题描述 题目来自于DataFountain上的“疫情期间网民情绪识别”的挑战赛,最终AUC达到了0.734,取得Top5%的成绩。主要内容是分析疫情期间的用户微博极性(分为消极:-1、中性:0、积极:1三种)。本文主要是对数据进行一定分析并做一个以该数据为基础的bert实战记录。

2. …

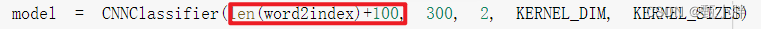

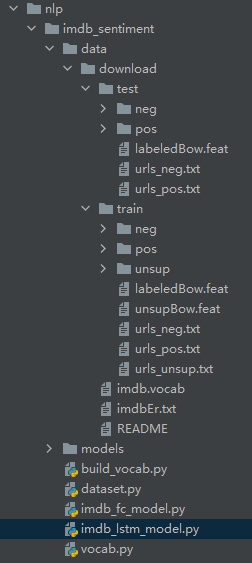

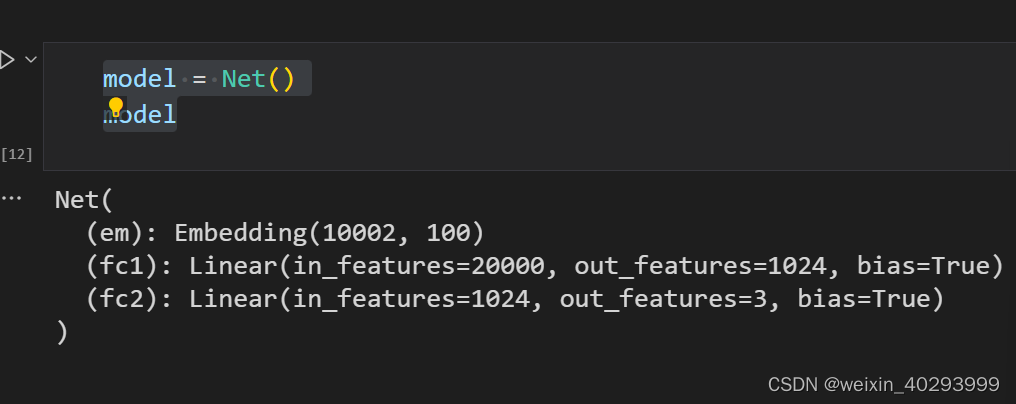

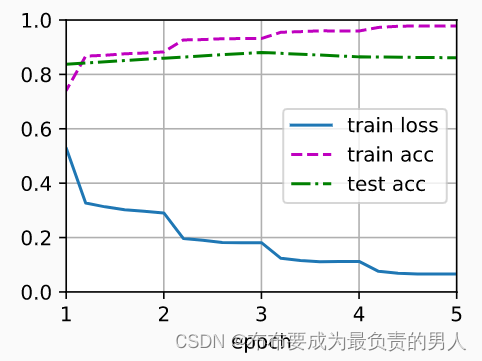

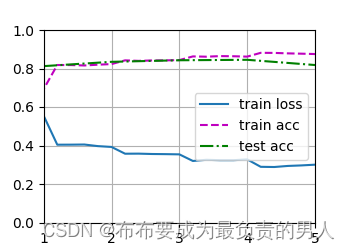

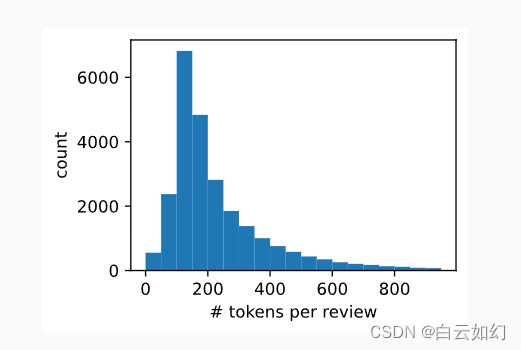

NLP自然语言处理-英文文本电影影评分类1-pytorch版本

imdb电影影评数据集下载地址:传送门 点击下载后解压。 像这样放置数据集,所有代码放置在imdb_sentiment文件夹下面。在imdb_sentiment/data/下放置训练集合测试集。

imdb_sentiment/models文件夹下放置处理后的数据集

运行代码只有3部分,dataset制作数据集,build_vocab建…

文献阅读:Universal Sentence Encoder

文献阅读:Universal Sentence Encoder 1. 文献内容简介2. 主要方法考察3. 实验结果梳理4. 结论 & 思考 文献链接:Universal Sentence Encoder

1. 文献内容简介

这篇文章算是考个古吧,前段时间看SNCSE(文献阅读:…

大模型的三大法宝:Finetune, Prompt Engineering, Reward

编者按:基于基础通用模型构建领域或企业特有模型是目前趋势。本文简明介绍了最大化挖掘语言模型潜力的三大法宝——Finetune, Prompt Engineering和RLHF——的基本概念,并指出了大模型微调面临的工具层面的挑战。 以下是译文,Enjoy! 作者 | B…

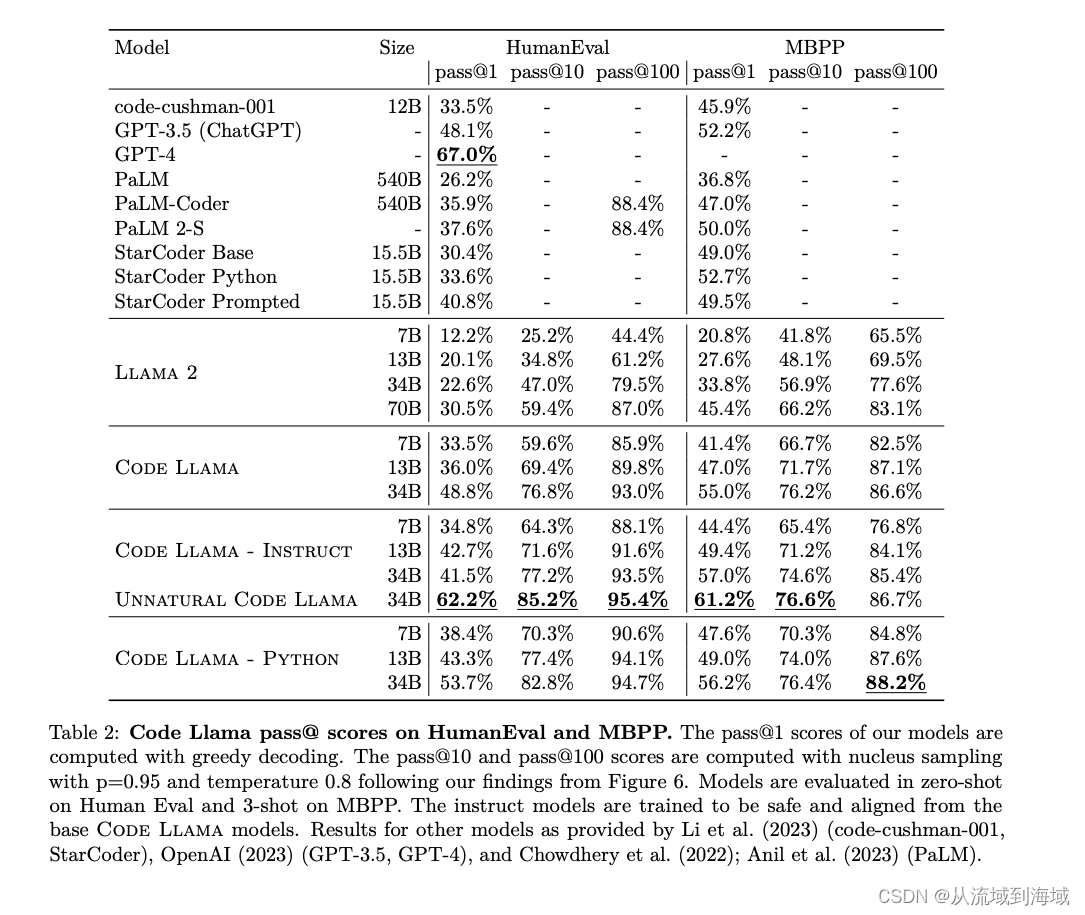

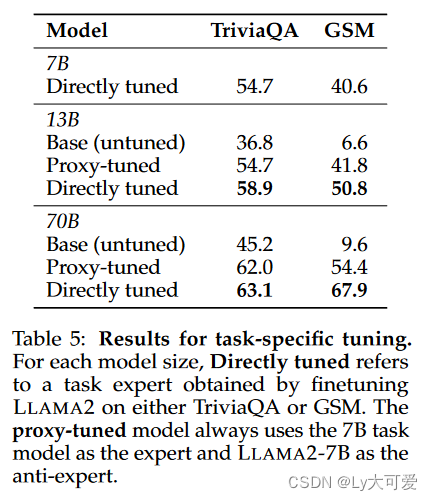

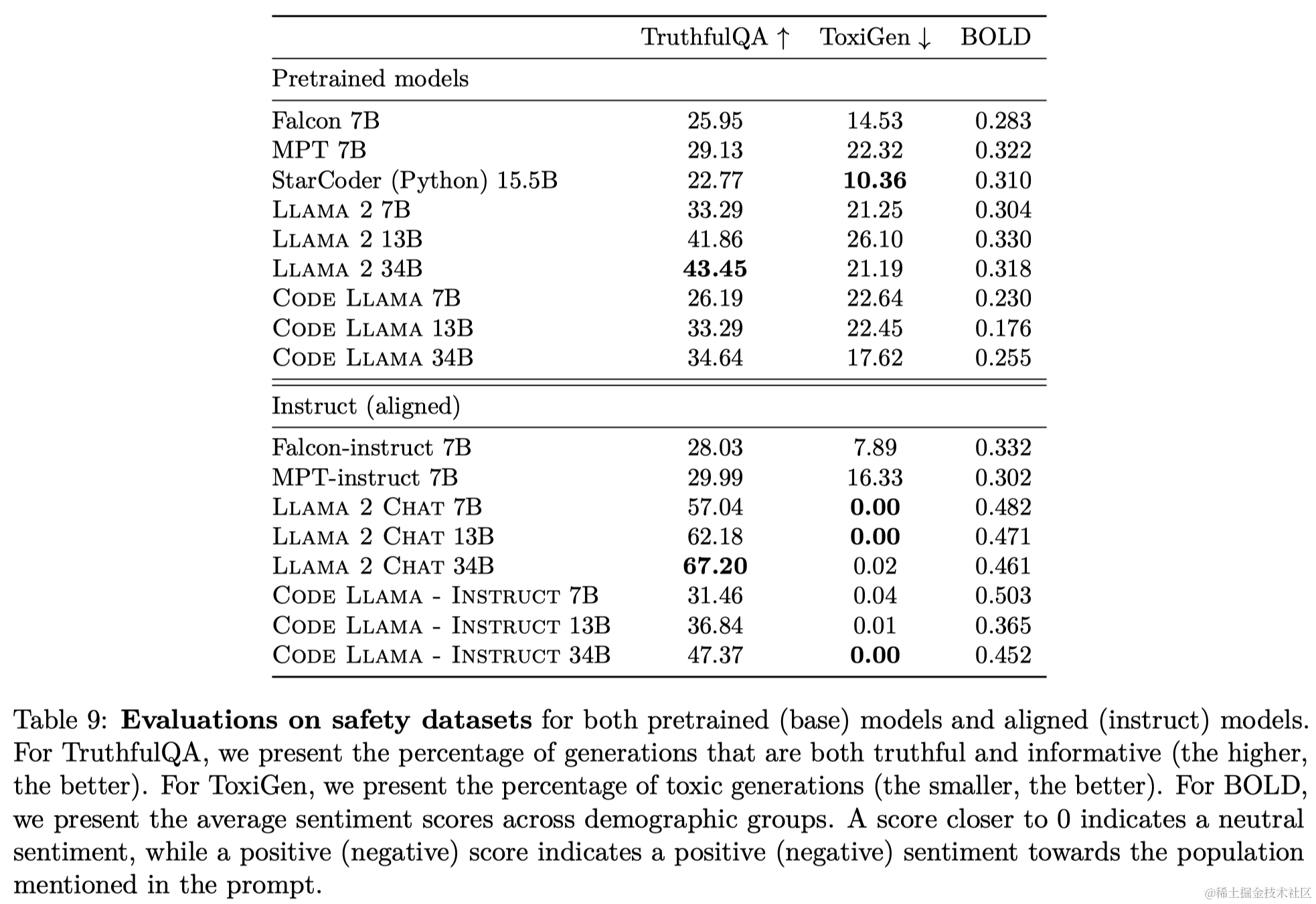

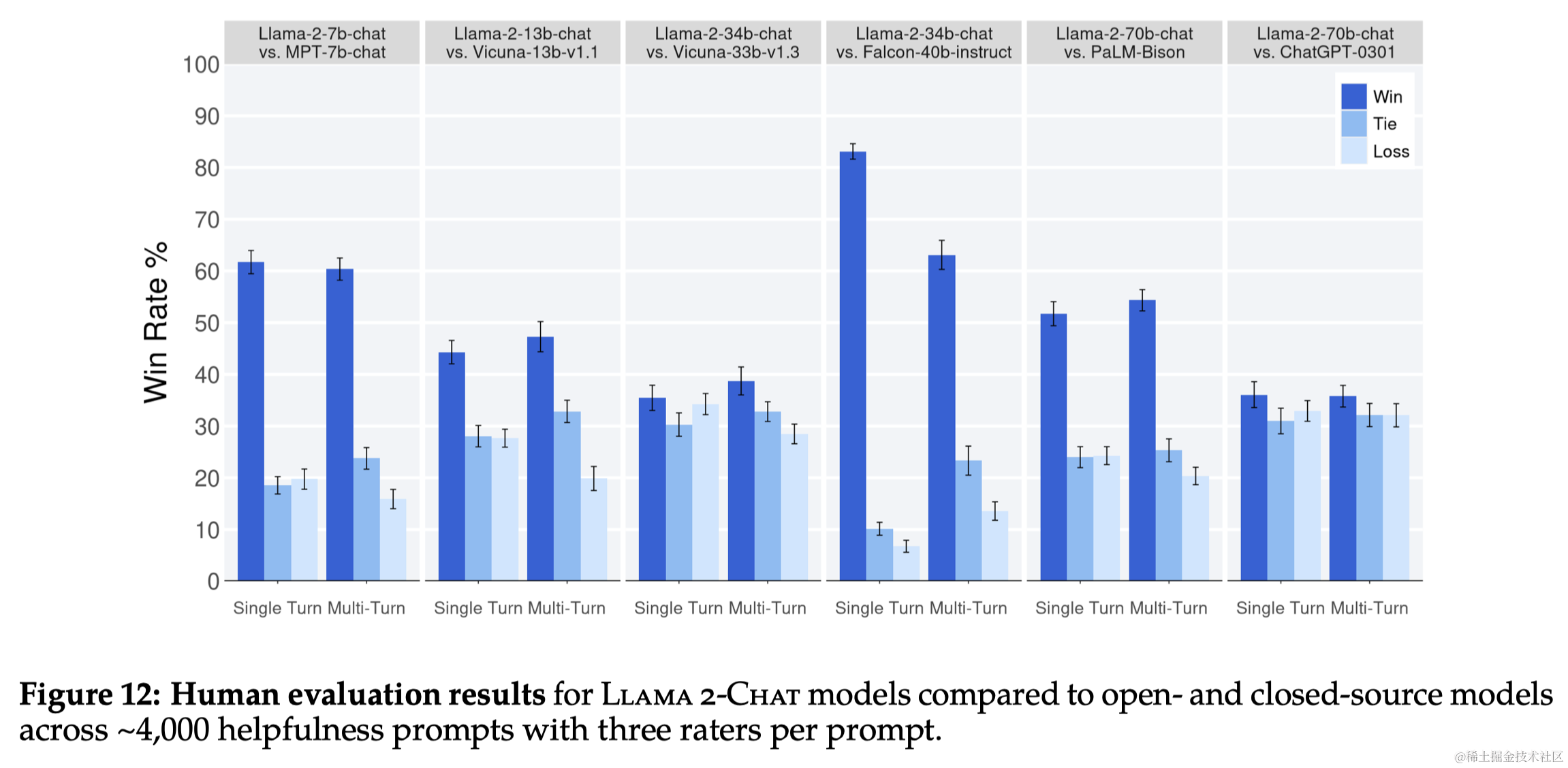

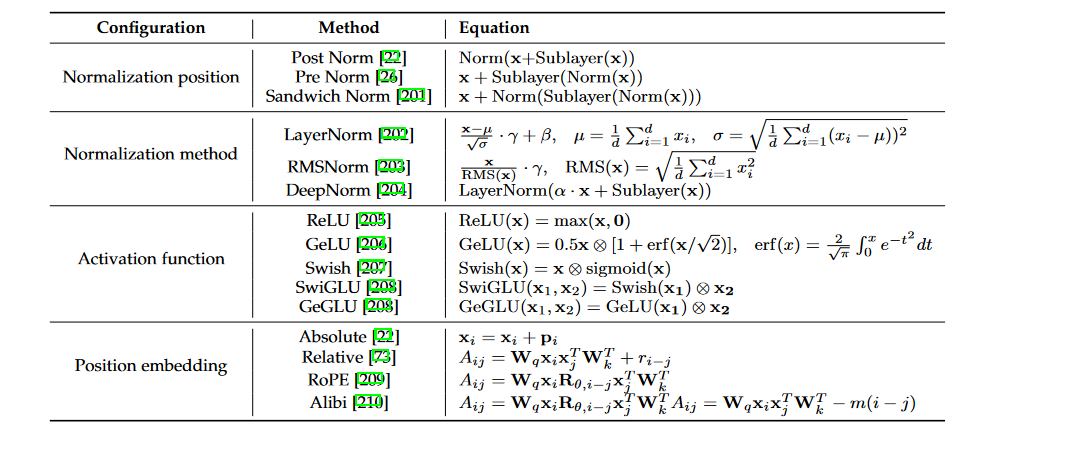

最强英文开源模型Llama2架构与技术细节探秘

prerequisite: 最强英文开源模型LLaMA架构探秘,从原理到源码 Llama2 Meta AI于2023年7月19日宣布开源LLaMA模型的二代版本Llama2,并在原来基础上允许免费用于研究和商用。

作为LLaMA的延续和升级,Llama2的训练数据扩充了40%,达到…

人工智能基础导论 2021-10-13

人工智能基础总目录

人工智能基础导论

相信是成功的必要条件(Trust is necessary for success)。相信自己能够克服学习上的困难,能够掌握人工智能方法及编程。 遇到相关的名词术语,方程,公式,代码看不懂。…

自然语言处理-NLP应用分类

作者:微软亚洲研究院 链接:https://www.zhihu.com/question/19895141/answer/149475410 来源:知乎 著作权归作者所有。商业转载请联系作者获得授权,非商业转载请注明出处。

1.句法语义分析:

对于给定的句子&#…

使用 Transformer 模型进行自然语言处理

自然语言处理是一项重要的人工智能技术,旨在帮助计算机理解人类语言。在过去的几年中,Transformer 模型已经成为自然语言处理领域的一种非常流行的模型。在本文中,我们将介绍 Transformer 模型的原理和实现,并展示如何使用 Transf…

英文论文润色哪家好用比较好,有值得推荐的吗

英文论文润色 推荐

英文论文润色对于写作者来说是一项十分重要的任务,它可以帮助我们修改文章中的语法、标点和排版等问题,使论文更加准确和易读。在众多的英文润色软件中,147chatgpt改写润色软件是一款值得推荐的全自动批量图文润色、自动纠…

大模型基础之简要背景知识

【时间线】

词级别模型:Word2Vec 2013:自监督学习

序列级别模型:RNN 2014:监督学习

注意力机制:2015

Transformer模型:2017:容易并行处理、容易堆叠更深的网络

上下文级别模型:…

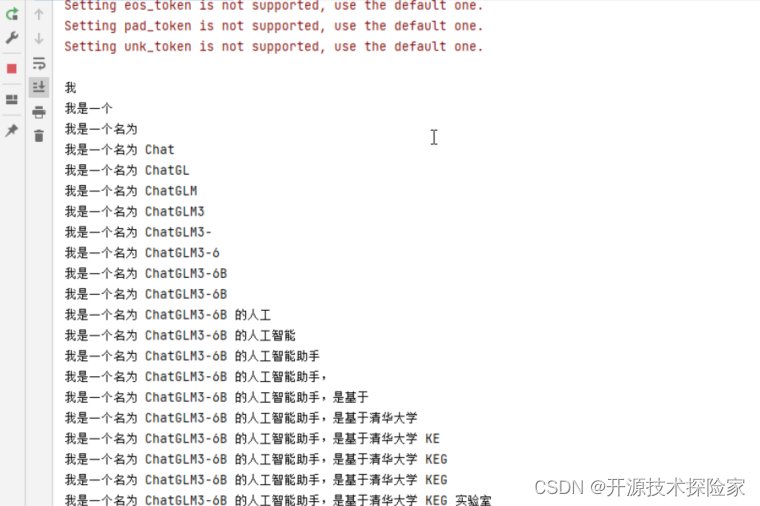

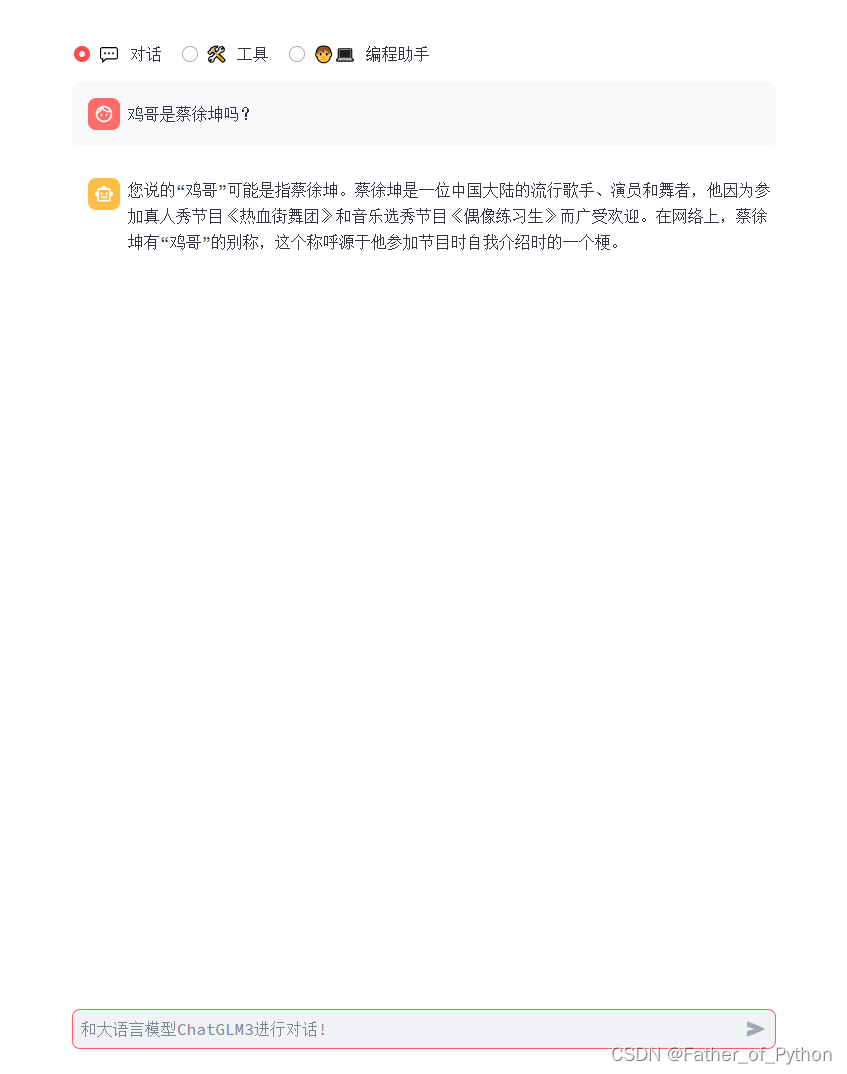

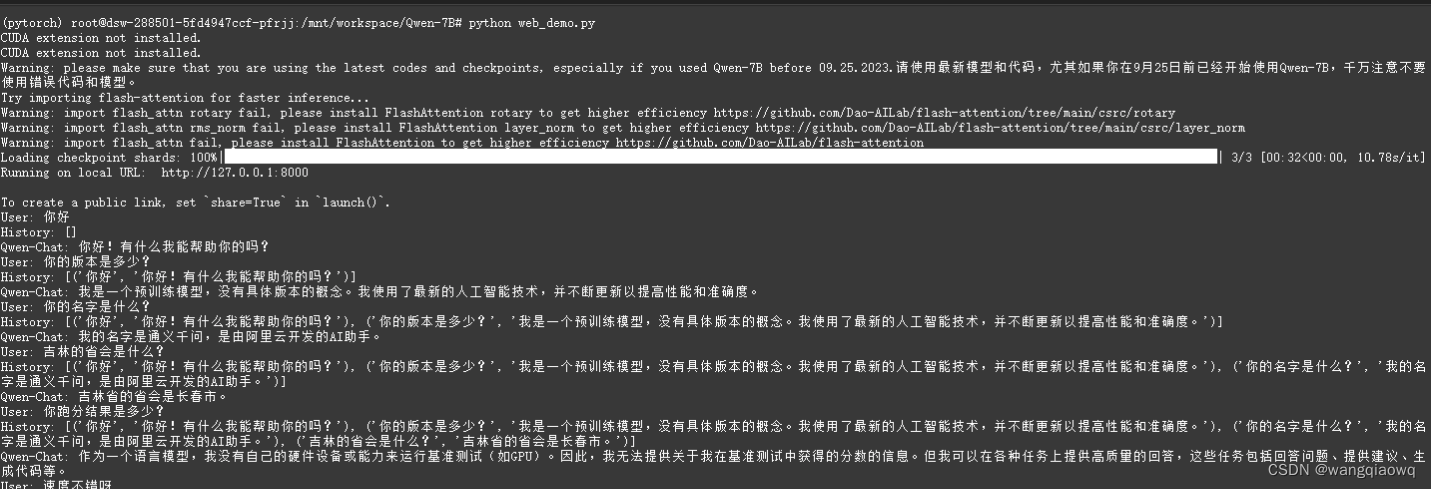

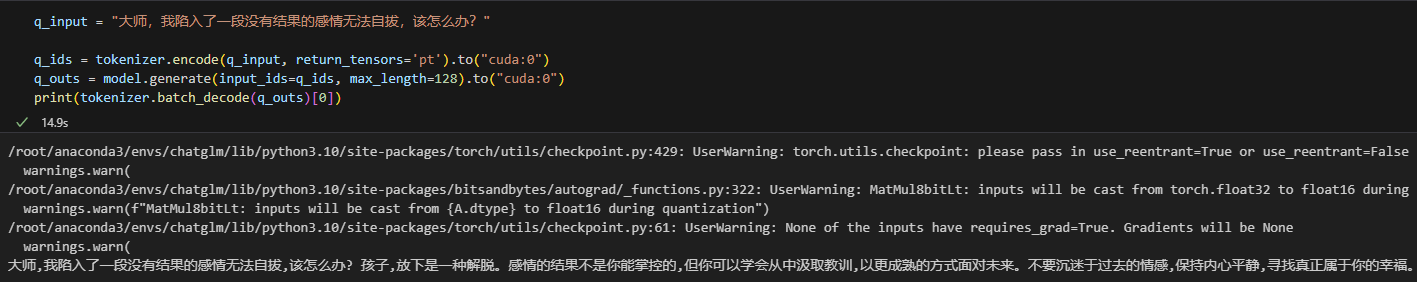

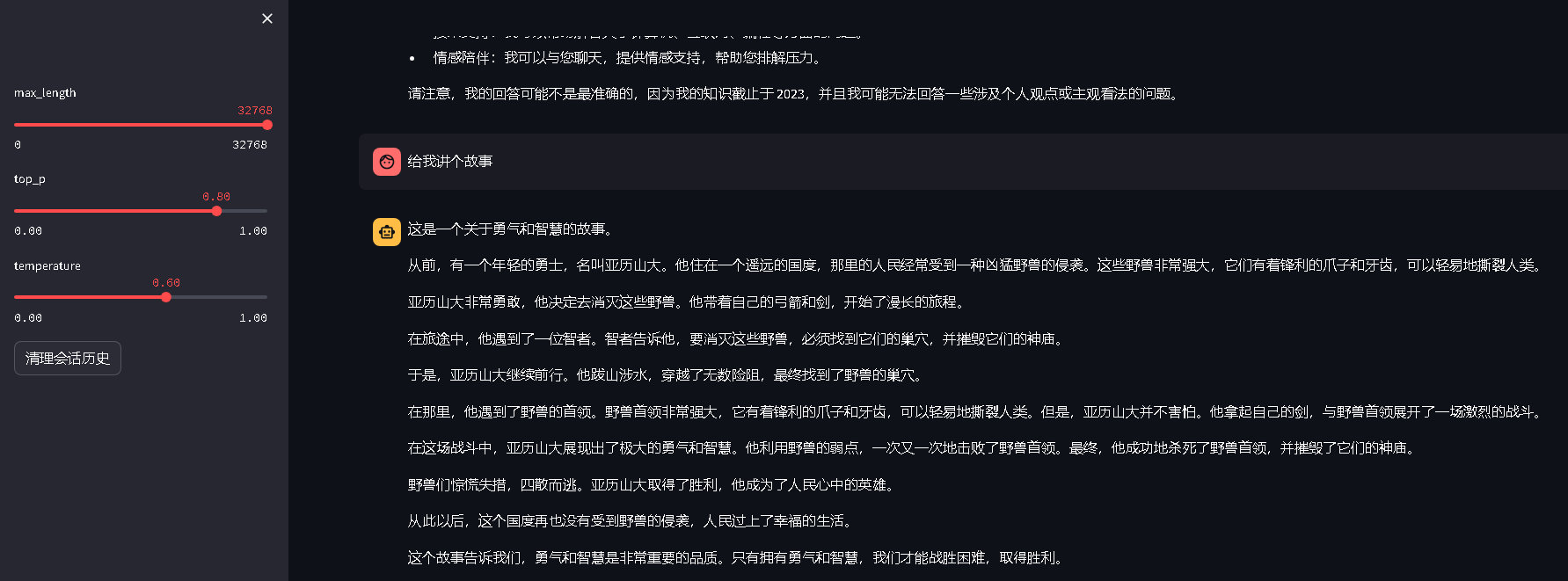

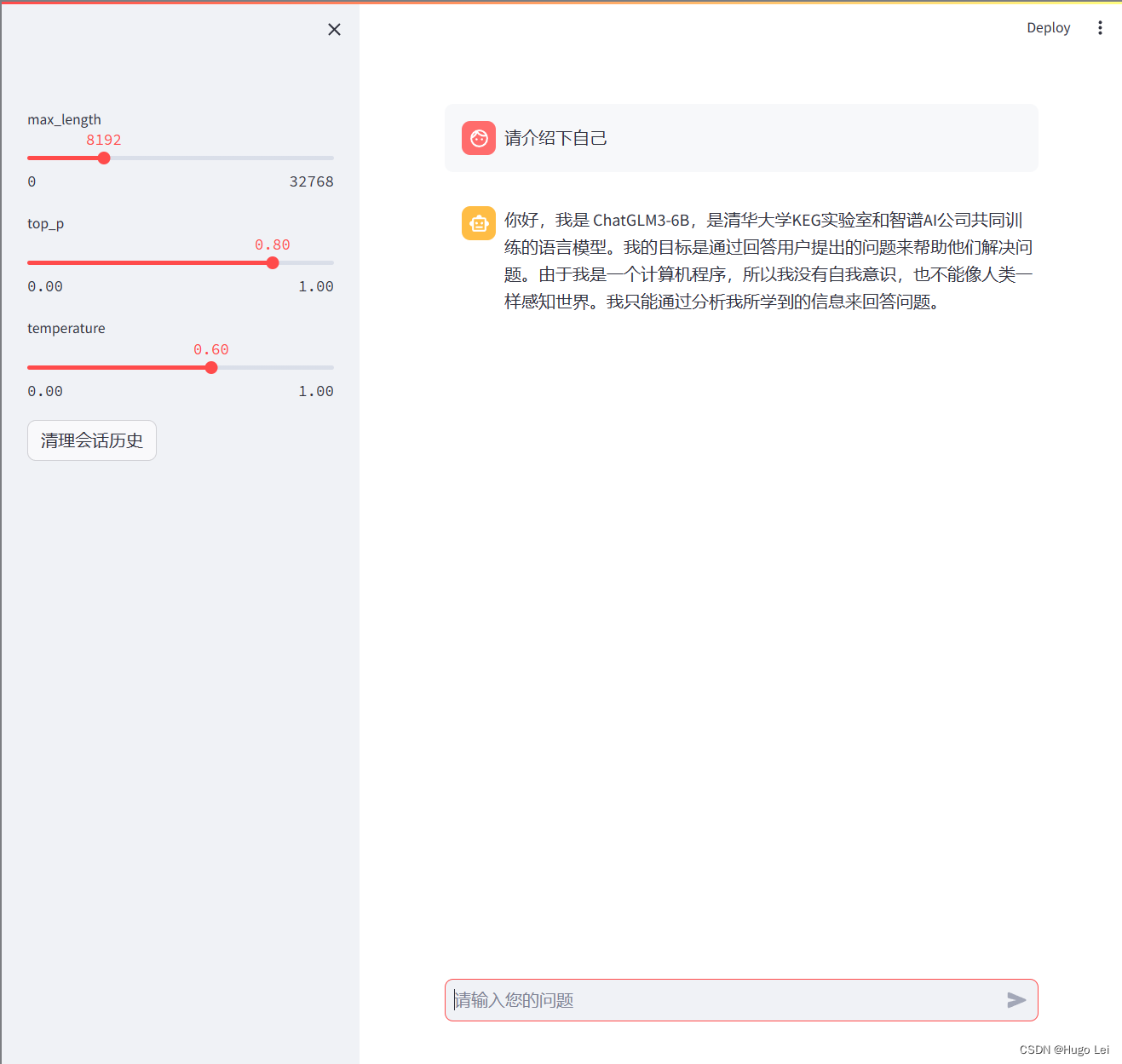

ChatGLM3-6B部署

从趋动云免费得了100的算力,部署了最新的ChatGLM3-6B 参考官网github相关教程,修改模型地址等

gradio效果streamlit效果

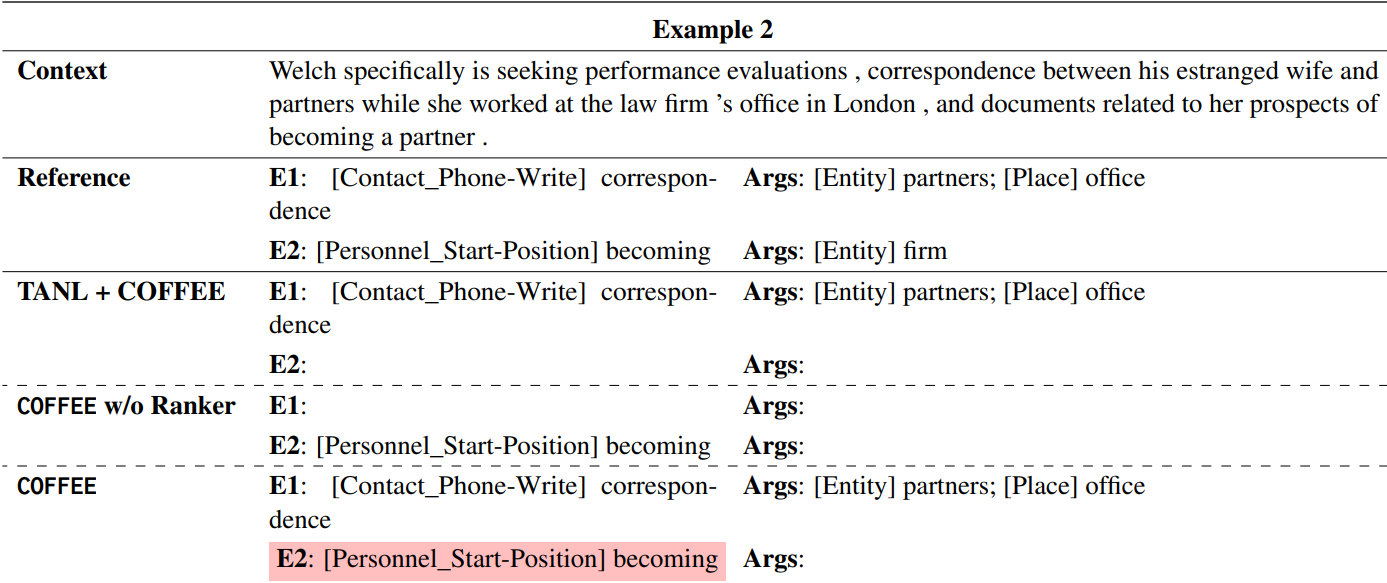

【论文阅读笔记】COFFEE: A Contrastive Oracle-Free Framework for Event Extraction

论文题目:COFFEE: A Contrastive Oracle-Free Framework for Event Extraction

论文来源:

论文链接:https://arxiv.org/pdf/2303.14452.pdf

代码链接:

0 摘要

事件抽取是一项复杂的信息抽取任务,它涉及到从非结构…

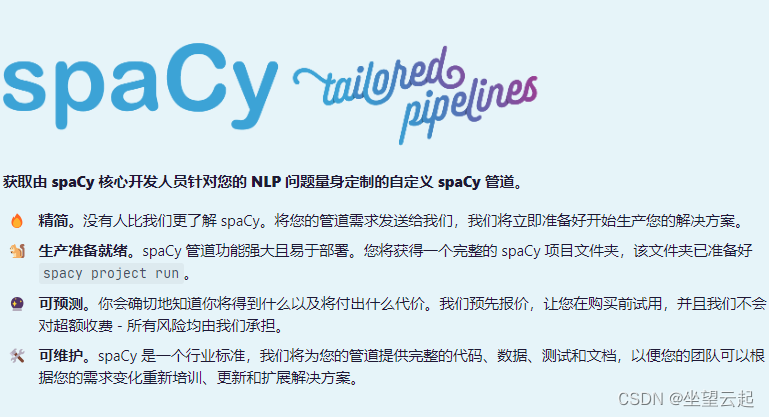

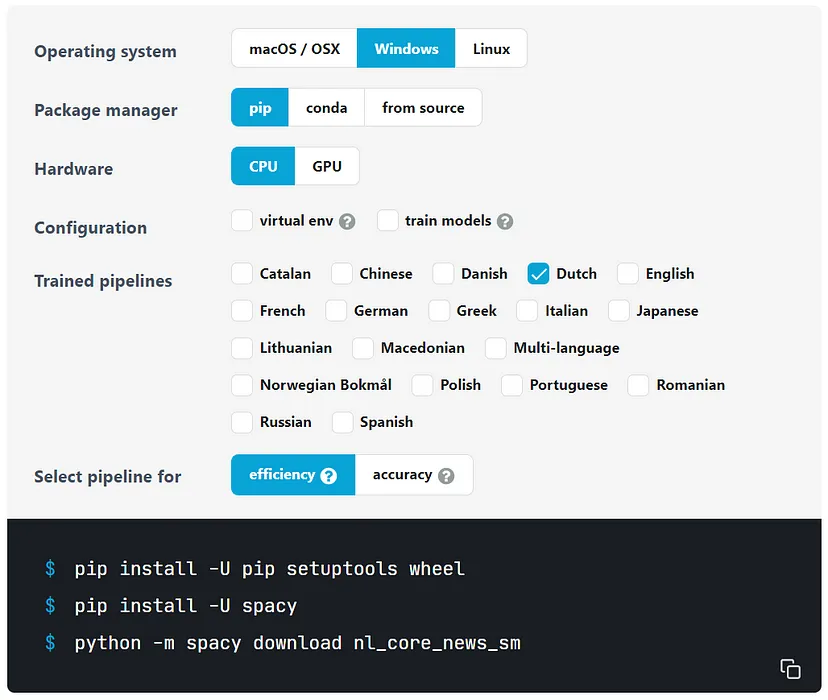

利用spaCy对中文文本分词和去除停用词处理

spaCy简介

spaCy语言模型包含了一些强大的文本分析功能,如词性标注和命名实体识别功能。目前spaCy免费支持的语言有:英文、德语、法语、西班牙语、葡萄语、意大利语和荷兰语,其他的语言也在慢慢的增长。对于spaCy处理中文文本(本…

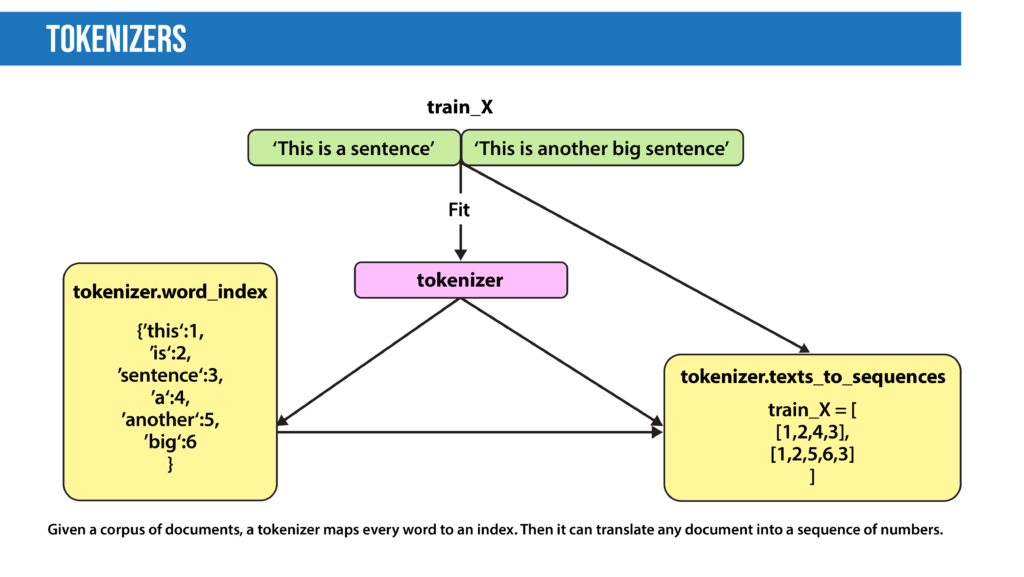

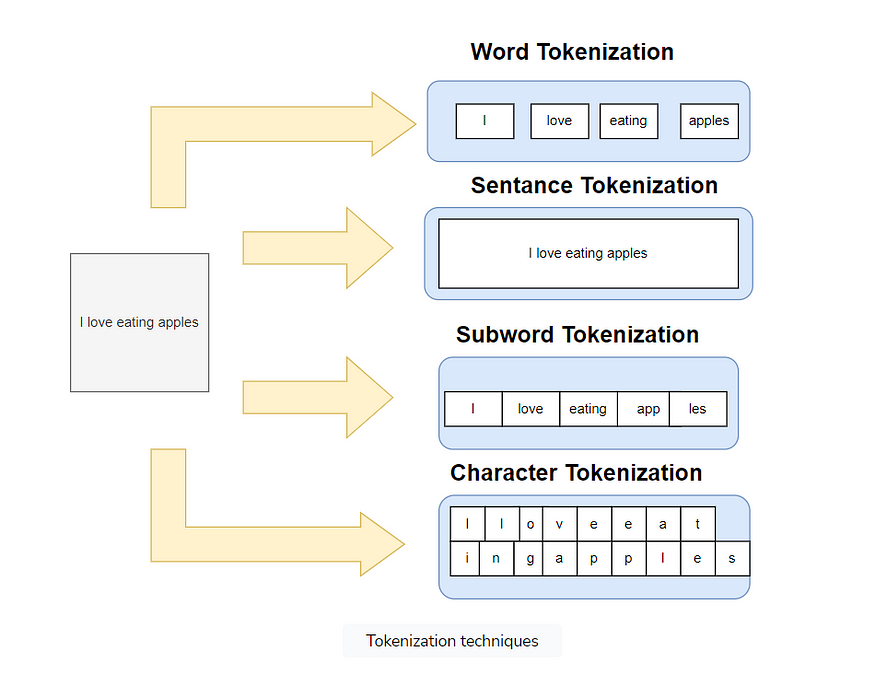

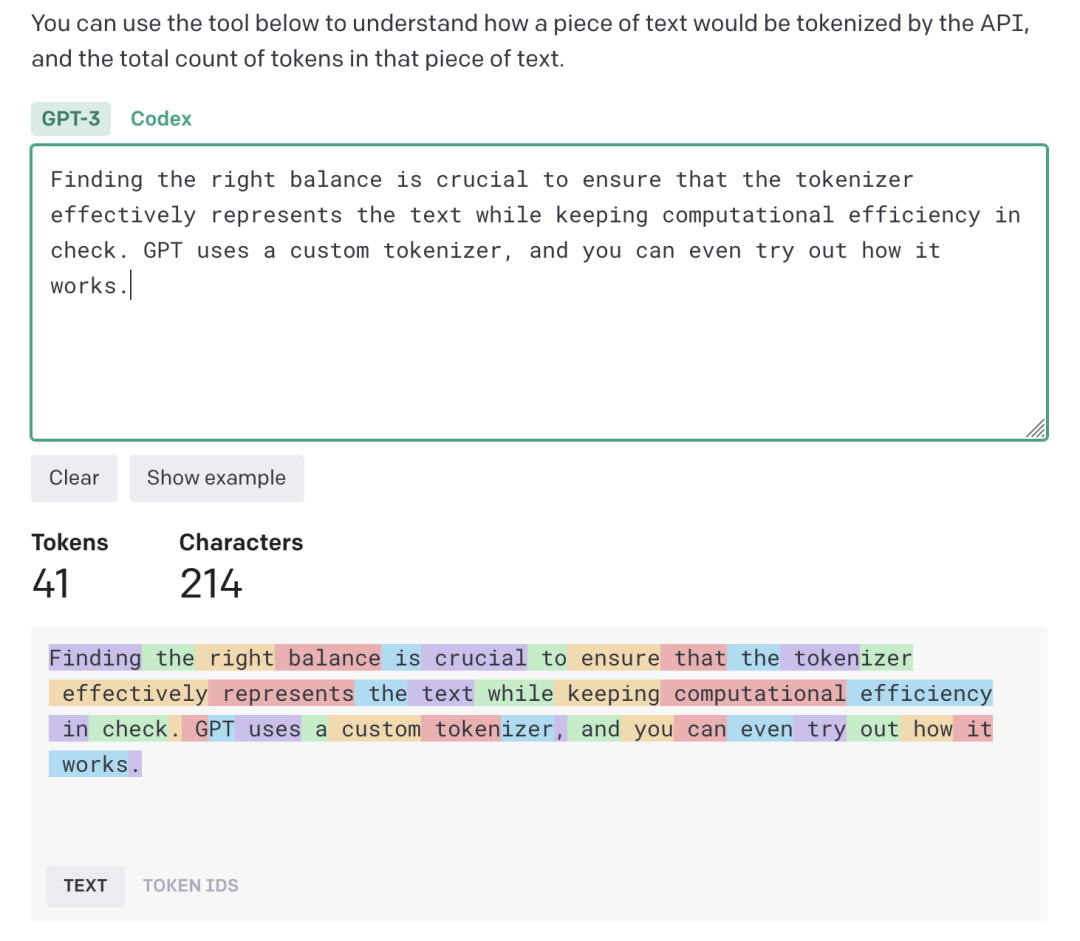

[nlp] tokenizer

参考:NLP中的Tokenization - 知乎

1、Tokenization的难点 Tokenization其实是为数值化作准备,数值化的过程必然需要映射,而映射又需要一个目标集合或者说映射表。

2、三类Tokenization方法 本节我们来讨论词粒度的相关方法。词粒度的切分就跟人类平时理解文本原理一…

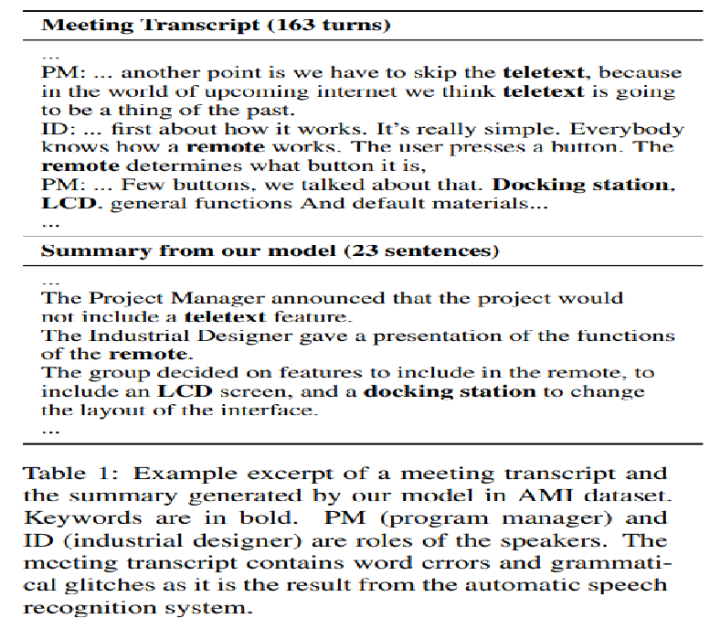

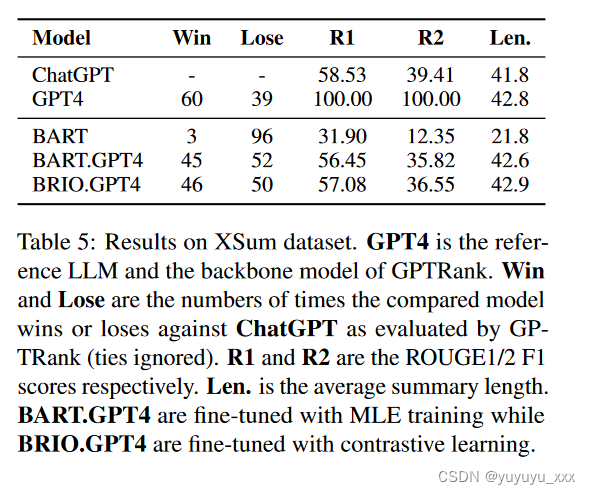

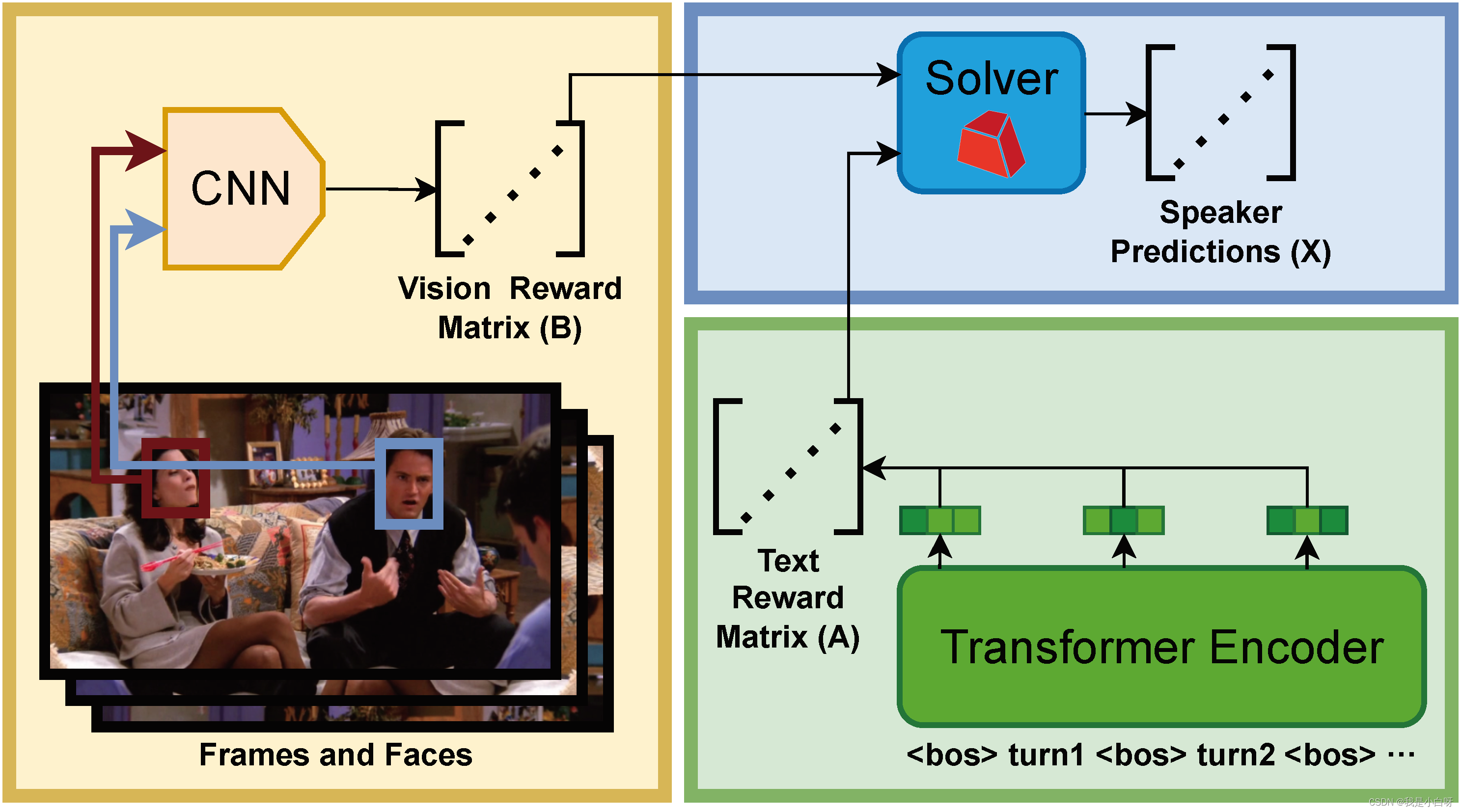

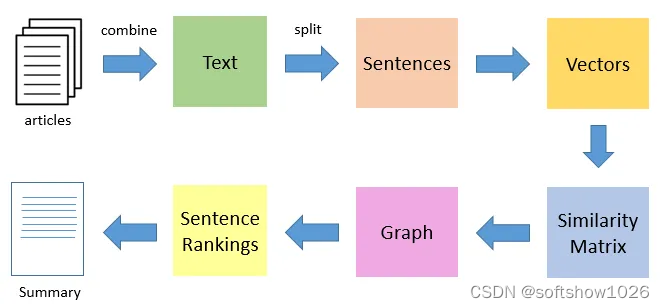

自动会议摘要HMNet(2020-SOTA),生成式文本摘要

A Hierarchical Network for Abstractive Meeting Summarization with Cross-Domain Pretraining.EMNLP2020 一、研究动机:

1、建模困难:角色多、交互、文本长、话题跳转

2、数据少 二、文章主要贡献:

1、提出Hierarchical Transformer&am…

镜像卷积网络能不能解决nlp问题

import paddle

class ReCNN(paddle.nn.Layer):def __init__(self, map_max=4096, hidden_dim=128, steps=20):

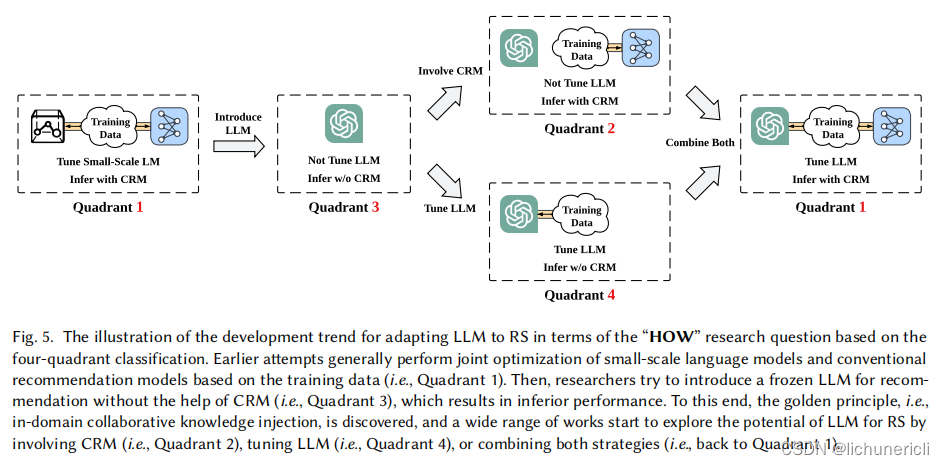

阿里最新研究:当ChatGPT 遇上推荐系统,遭遇滑铁卢

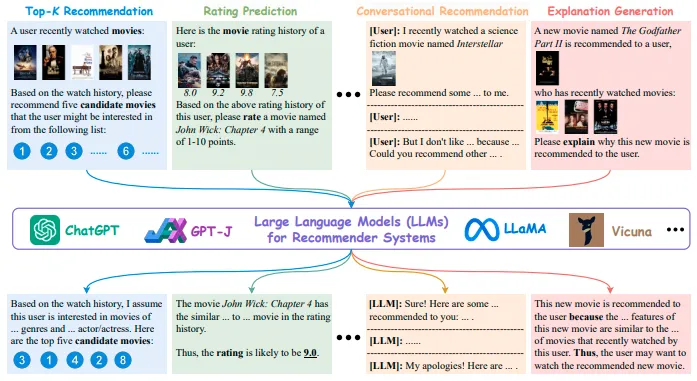

文 |小戏 在 GPT-4 屠榜了 NLP,SAM 零样本分割一切让 CV 消失后,不知道大家会不会有好奇 AI 三大现实应用的另一边岁月静好的推荐系统有没有感受到来自遥远大模型带来的巨大压力。 尽管 ChatGPT 的训练过程似乎没有对推荐系统太多的兼容,但是…

【Python】tqdm 模块

import mathfrom tqdm import tqdm, trange# 计算阶乘

results_1 []for i in range(6666):results_1.append(math.factorial(i))这是一个循环计算阶乘的程序,我们不知道程序运行的具体情况,如果能加上一个程序运行过程的进度条,那可就太有趣…

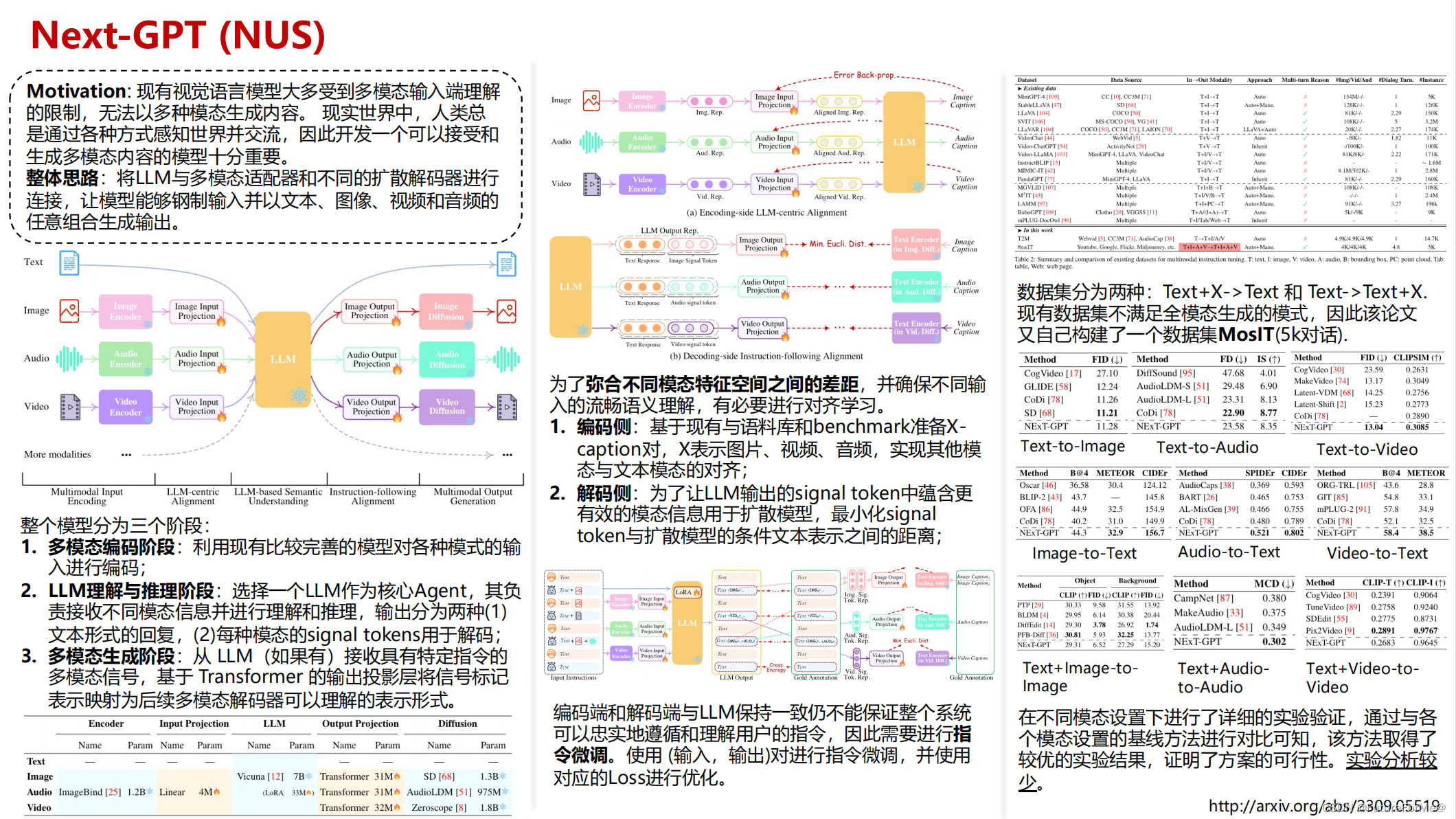

多模态大一统:开启全模态LLM和通用AI时代的大门

多模态大一统:开启全模态LLM和通用AI时代的大门 1. 目前多模态实现的方法1.1 单独训练各领域模型1.2 多任务学习1.3 集成多模态模型1.4 通用多模态模型2. 多模态统一难点2.1 数据集对齐和融合2.2 大规模计算资源需求2.3 各领域特性的兼容性2.4 可解释性和泛化能力3. 全模态的好…

华东理工某ACMer总结

做算法和作技术哪个难? 都很难, 没有可比性. 但是算法做得好的可以转行做技术, 技术做得好的想转行做算法却很困难.我是08年下半年将近期末的时候加入华理ACM队的. 我高中的时候没有编程经验, 数学也不好, 高考数学刚及格. 因为第二工业大学的网络工程专业的分数是最低的, 所以…

“新KG”视点 | 知识图谱与大语言模型协同模式探究

OpenKG 大模型专辑 导读 知识图谱和大型语言模型都是用来表示和处理知识的手段。大模型补足了理解语言的能力,知识图谱则丰富了表示知识的方式,两者的深度结合必将为人工智能提供更为全面、可靠、可控的知识处理方法。在这一背景下,OpenKG组织…

【自然语言处理】NLP学习及实践记录 | part 03 知识库构建、问答系统

知识库构建 在垂直领域容易被忽视的内容,在年报中找到案例中“raw_text”中一条,变动原因。

这里提供一个开源的工具 - 开放知识图谱。 对于其中的列表资源,可以点进去看一下。

问答系统 与聊天机器人不同,问答系统较为全面&…

NLP学习:深入NLP

个人博客:Sekyoro的博客小屋 个人网站:Proanimer的个人网站

之前学过一段时间NLP,因为其中涉及到一些深度学习常用的知识或者框架,但苦于不系统以及没有任务focus不能长久.这里借助微软的教程写点东西.

tokenization&&representation

将一句话中的单词分割就是分词(…

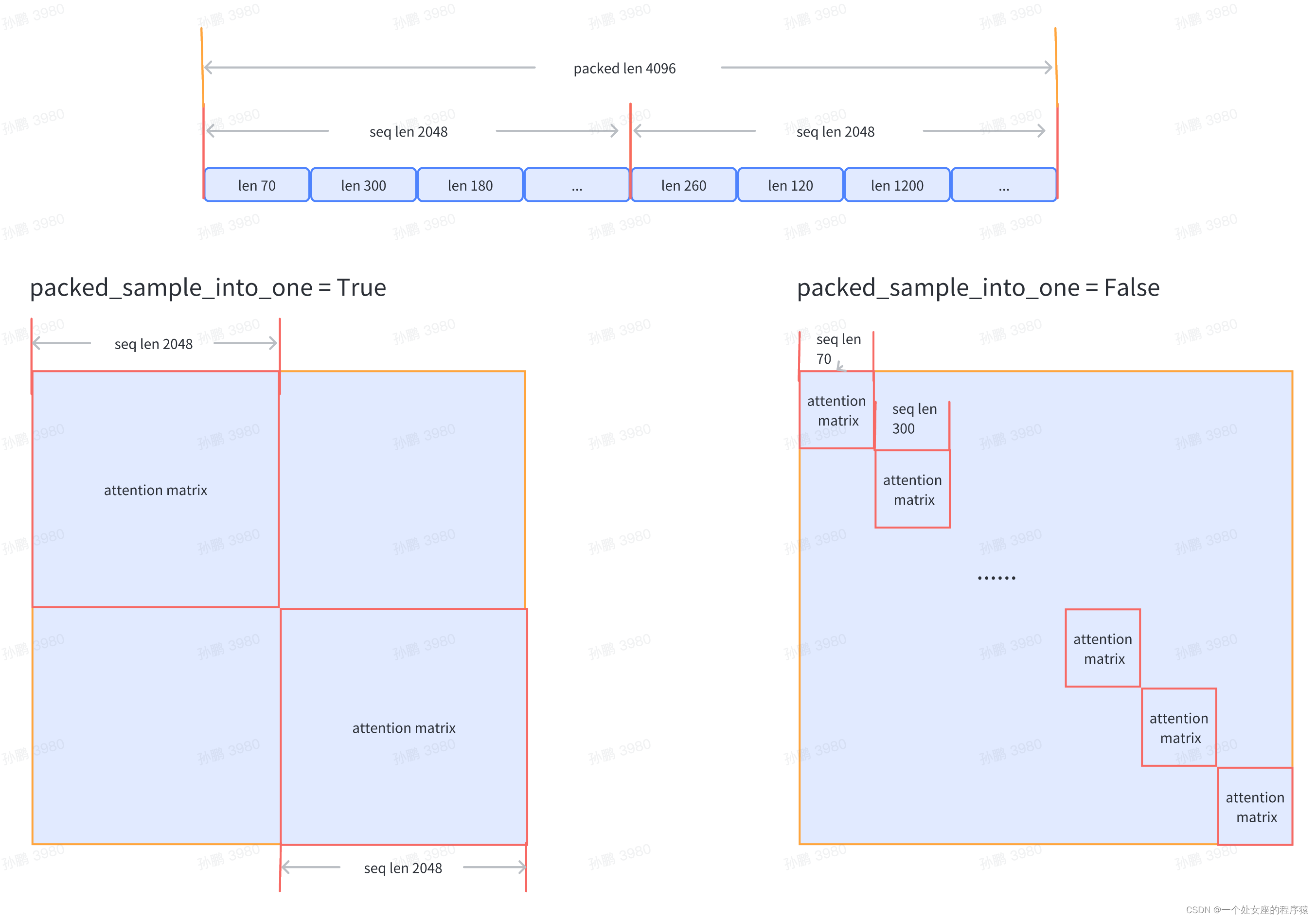

超越时空:加速预训练语言模型的训练

超越时空:加速预训练语言模型的训练

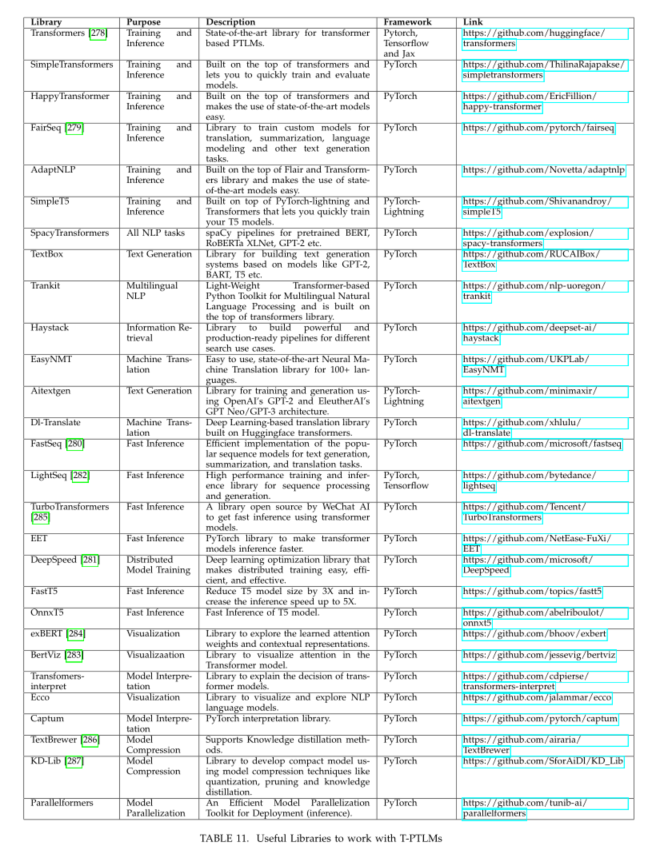

随着自然语言处理(NLP)领域的快速发展,预训练语言模型(PTLM)已成为许多NLP任务的重要基石,如文本生成、情感分析、文本分类等。然而,传统的PTLM…

ChatGPT将批量文档翻译成中文的方法

文档翻译成中文软件是指在处理文档时,自动将文档中的内容翻译成中文的软件。这些软件通常采用自然语言处理技术,通过对待翻译文本的分词、词义分析、语法分析等多种技术处理,实现对文本中的单词、短语、句子等级别的翻译。 文档翻译成中文软件…

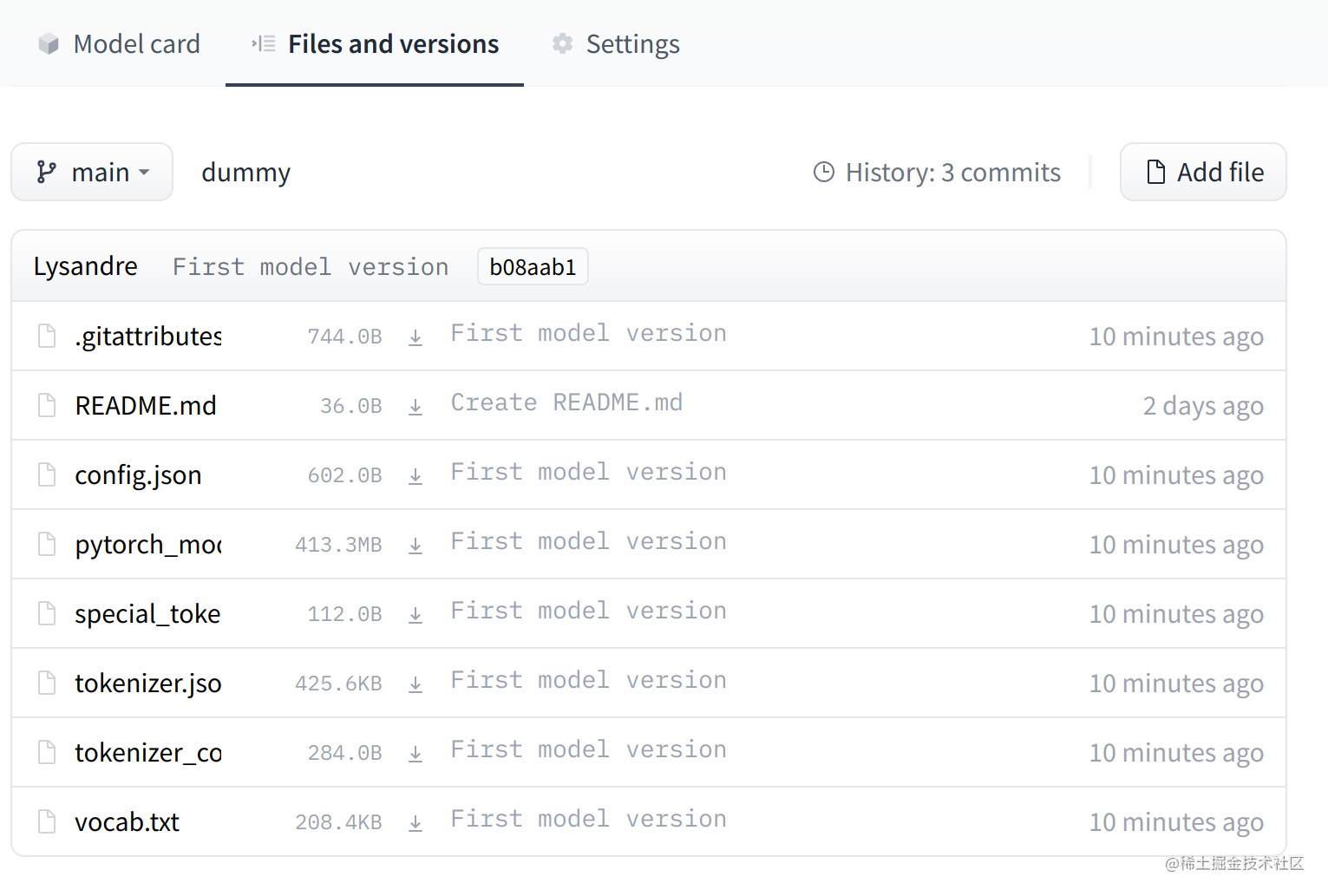

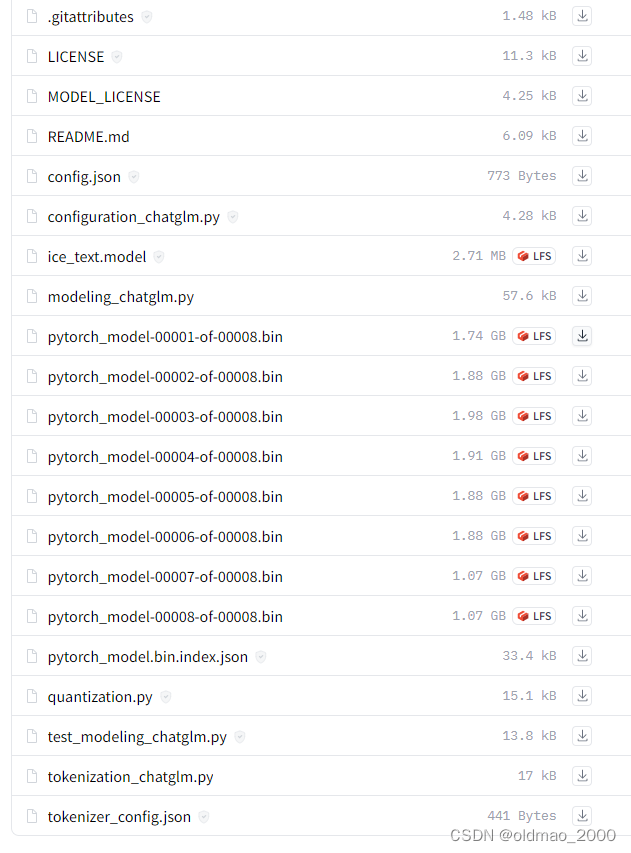

解决huggingface 在代码因为网络无法下载模型和数据集的问题(伪)

huggingface的模型下载

其实是用git手动下载 具体的方法:

sudo apt-get update

sudo apt-get install git-lfs

git lfs install 然后git clone https://huggingface.co/roberta-large

huggingface数据集下载

首先有些数据集也可以通过git下载(那种&…

python实现AI写歌词GUI版本【文末源码】

**引言:**自然语言处理作为人工智能的一个重要分支,在我们的生活中得到了广泛应用。其中RNN算法作为自然语言处理的经典算法之一,是文本生成的重要手段。而今天我们就将利用RNN算法建立一个写歌词的软件。其中的界面如下: RNN指的…

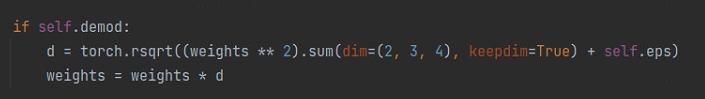

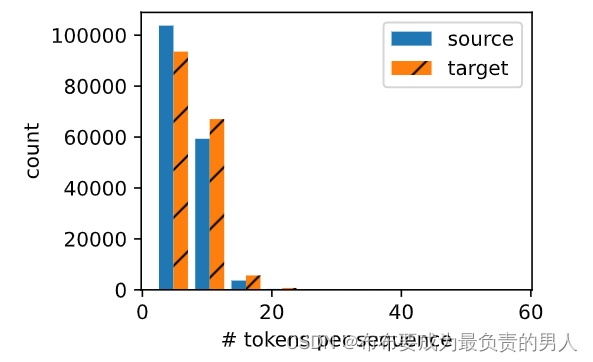

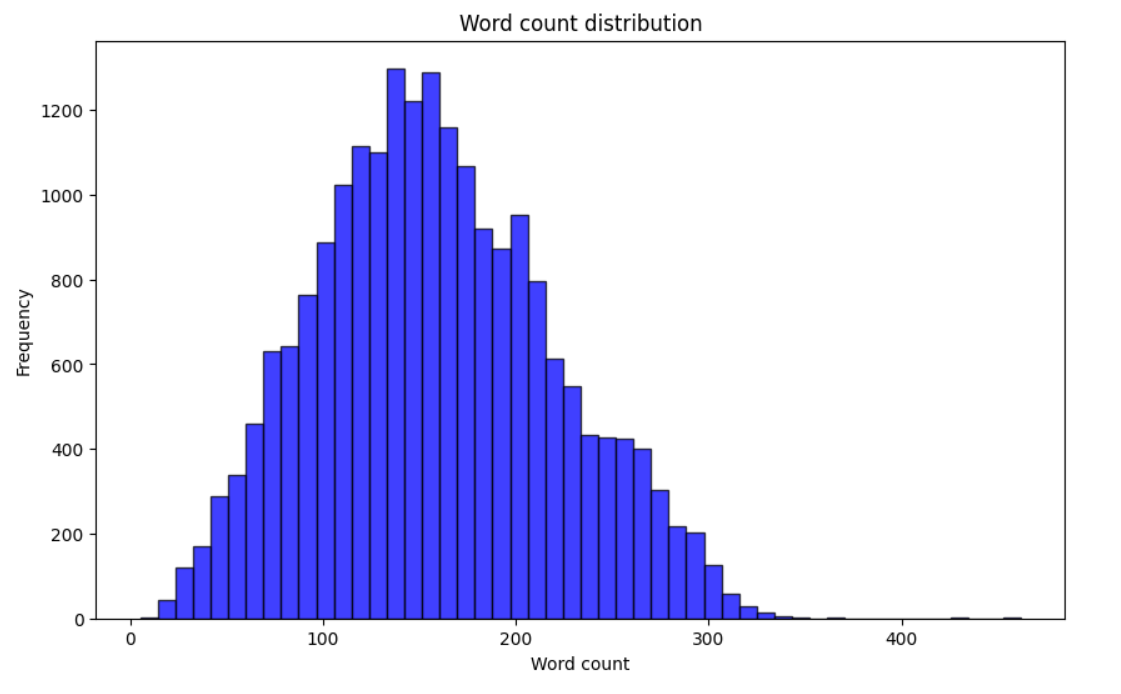

2022-kaggle-nlp赛事:Feedback Prize - English Language Learning

文章目录零、比赛介绍0.1 比赛目标0.2 数据集0.3 注意事项一、设置1.1 导入相关库1.2 设置超参数和随机种子1.3 启动wandb二、 数据预处理2.1 定义前处理函数,tokenizer文本2.2 定义Dataset,并将数据装入DataLoader三、辅助函数四、池化五、模型六、定义…

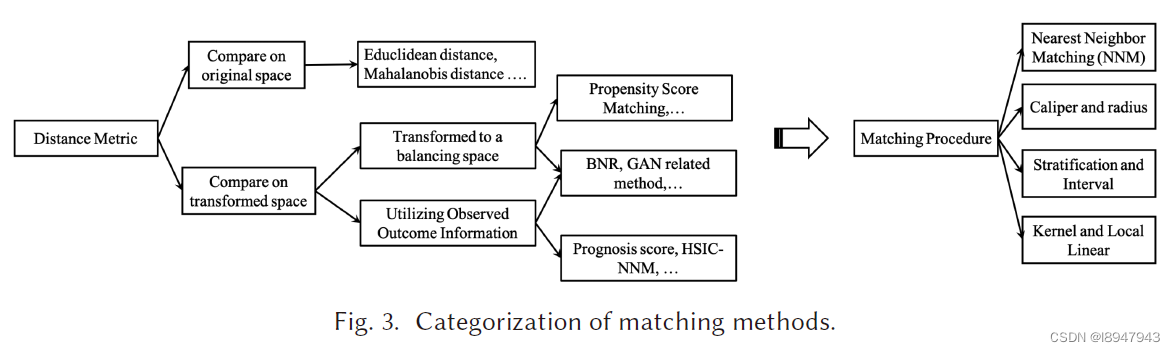

2020年因果推断综述《A Survey on Causal Inference》

最近阅读了TKDD2020年的《A Survey on Causal Inference》,传送门,自己对文章按照顺序做了整理,同时对优秀的内容进行融合,如有不当之处,请多多指教。

文章对因果推理方法进行了全面的回顾,根据传统因果框…

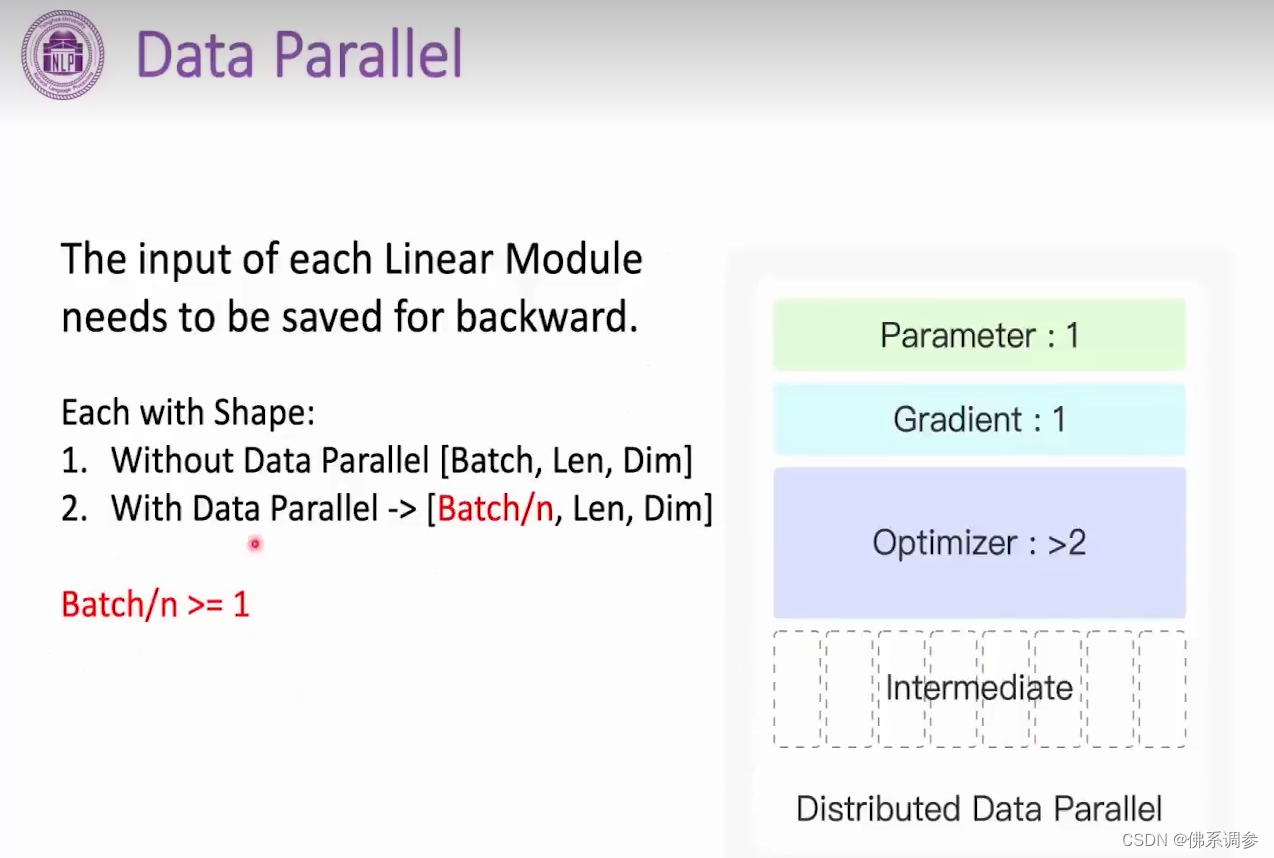

Huggingface:高效多GPU训练

Huggingface:高效多GPU训练 概念动态策略Single Node、Multi-GPUmulti-node/multi-gpu https://huggingface.co/docs/transformers/perf_train_gpu_many 概念

首先介绍一下名词概念: Data Parallel(DP):数据并行&…

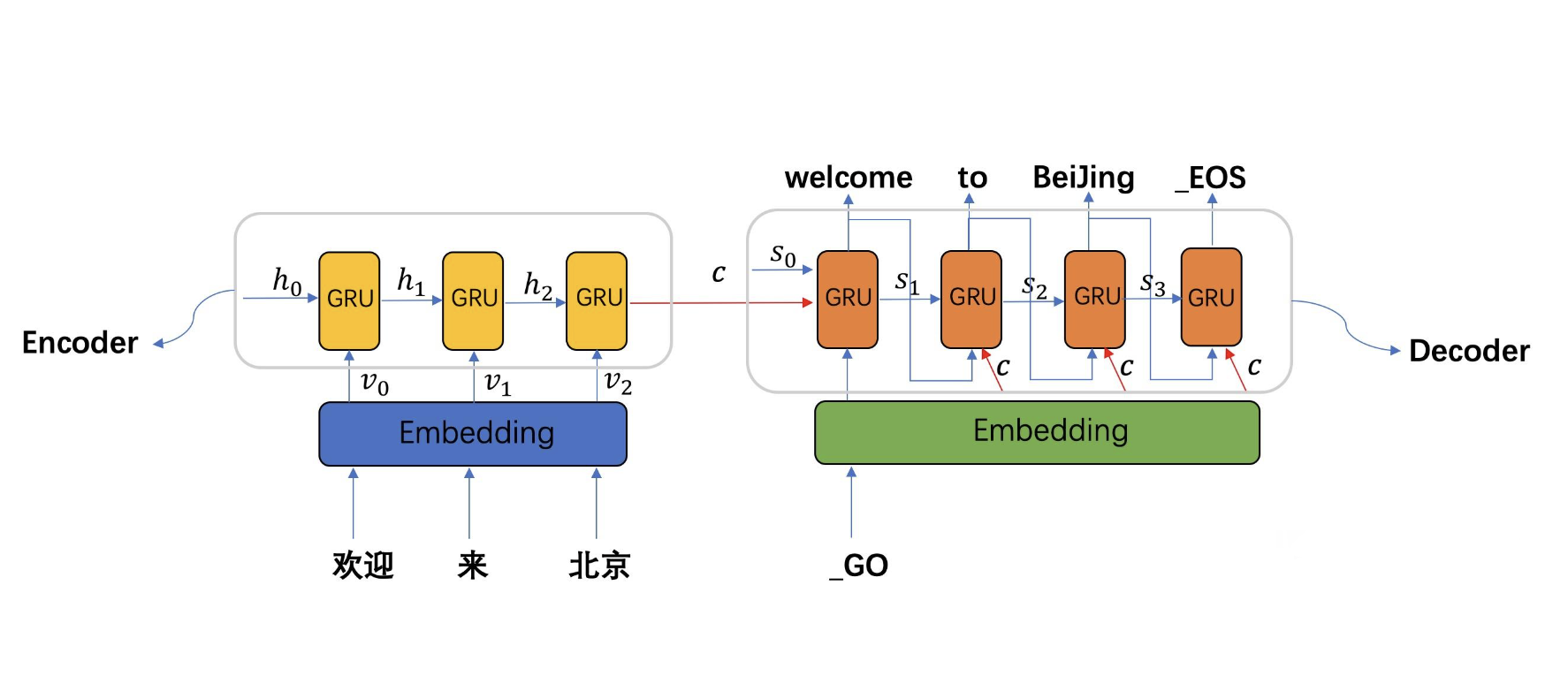

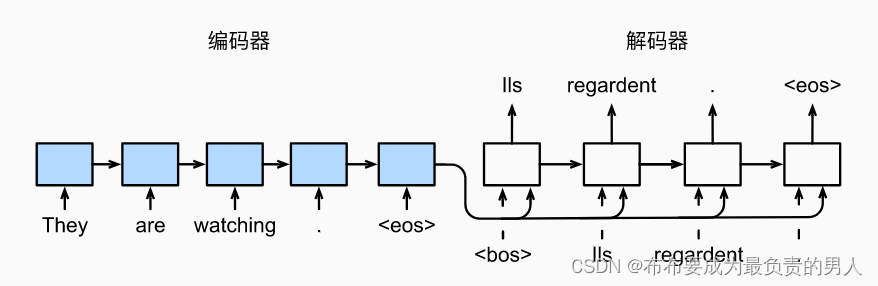

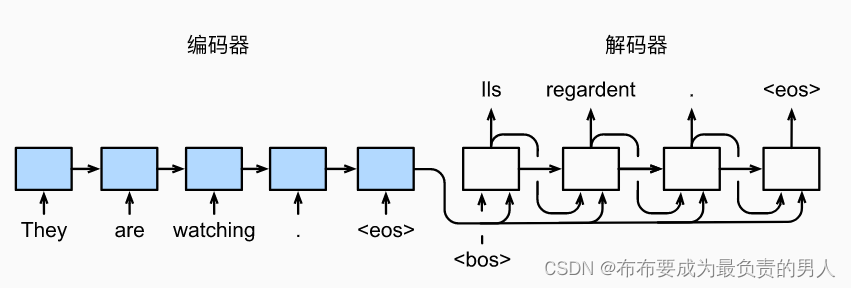

ChatGPT技术原理 第七章:Seq2Seq模型

目录 7.1 Seq2Seq模型概述

7.2 Encoder-Decoder框架

7.3 Attention机制

7.4 Beam Search算法 7.1 Seq2Seq模型概述

通用信息抽取技术UIE产业案例解析,Prompt 范式落地经验分享!

想了解用户的评价究竟是“真心夸赞”还是“阴阳怪气”?想快速从多角色多事件的繁杂信息中剥茧抽丝提取核心内容?想通过聚合相似事件准确地归纳出特征标签?……想了解UIE技术在产业中的实战落地经验?通用信息抽取技术 UIE 产业案例…

通用智能的瓶颈及可能的解决途径

通用智能是指能够在各种不同的任务和环境中灵活地适应和执行任务的智能。通用智能与特定任务的智能相反,后者只能在特定领域或任务中表现出色。通用智能的理论基础是人工智能领域的通用人工智能(AGI)研究,旨在设计出能够像人类一样…

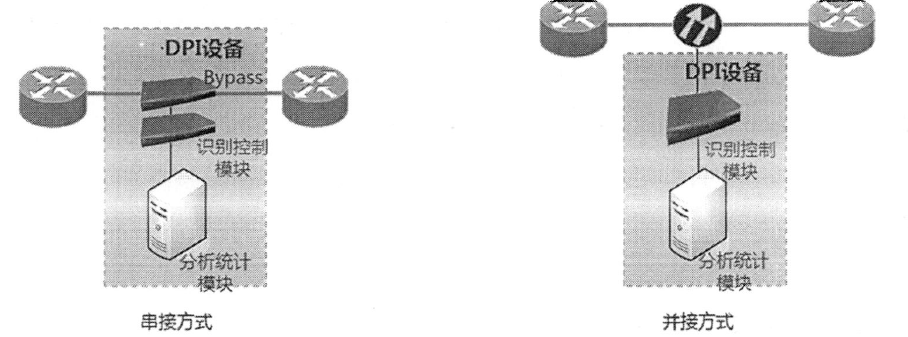

深度包检测(DPI)详细介绍

以前不了解这个,一个应聘职位是这个方面的,就在网上收集这个资料,了解了这个方面的资料,其实,这个核心是自然语言识别。

目录

简介背景 流量识别 常用功能具体功能 做法特征识别架构举例部署方式 串接方式并接方式存…

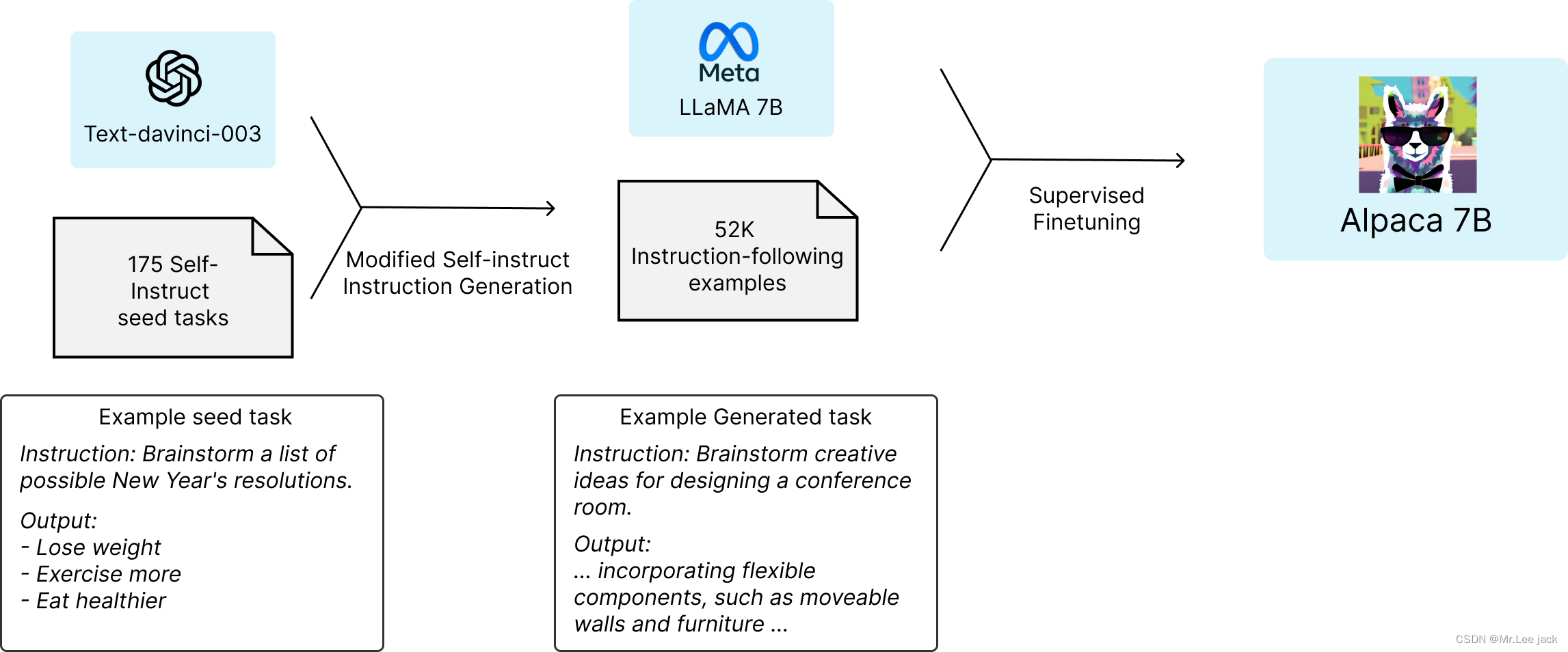

自驱力超强的羊驼?斯坦福微调LLaMa

大型“指令调优”语言模型在新任务上展现了Zero-shot的卓越能力,但严重依赖于人类编写的指令数据,而这些数据在数量、多样性和创造性方面都是有限的。 斯坦福科研人员引入了self-instruction框架,提高指令遵循能力来自我迭代进化,…

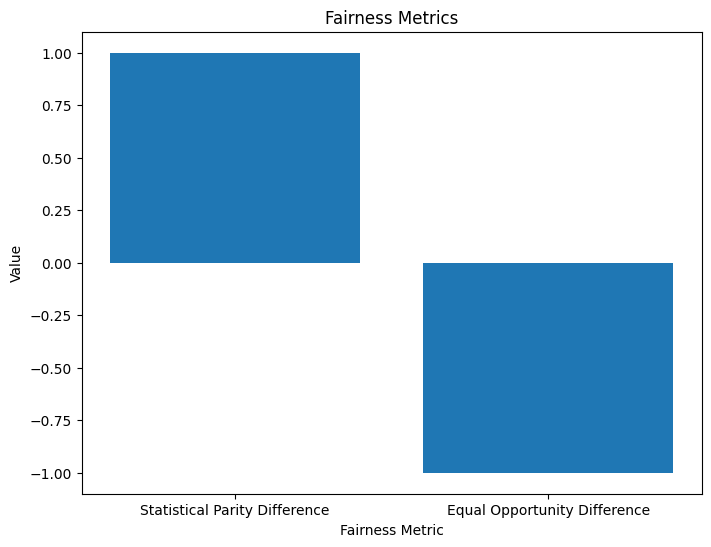

NLP 模型中的偏差和公平性检测

一、说明 近年来,自然语言处理 (NLP) 模型广受欢迎,彻底改变了我们与文本数据交互和分析的方式。这些基于深度学习技术的模型在广泛的应用中表现出了卓越的能力,从聊天机器人和语言翻译到情感分析和文本生成。然而&…

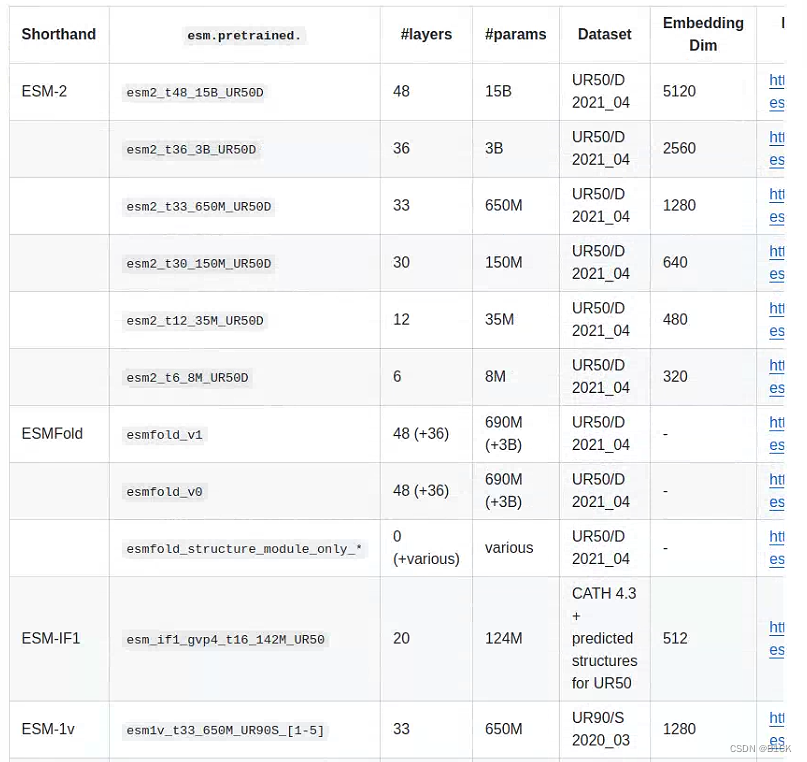

【NB 2023】从一般蛋白质语言模型中高效进化人类抗体

Efficient evolution of human antibodies from general protein language models

哈佛大学化学与化学生物学系和圣路易斯华盛顿大学的研究人员共同完成的一篇论文,发表在Nature Biotechnology上。

抗体是一种大分子,属于免疫球蛋白家族,它…

论文笔记 EMNLP 2021|Self-Attention Graph Residual Convolutional Network for Event Detection with depende

文章目录1 简介1.1 创新2 方法3 实验1 简介

论文题目:Self-Attention Graph Residual Convolutional Network for Event Detection with dependency relations 论文来源:EMNLP 2021 组织机构:天津大学 论文链接:https://aclantho…

基于卷积神经网络和连接性时序分类的语音识别系统,含核心Python工程源代码(深度学习)个人可二次开发

目录 前言总体设计系统整体结构图系统流程图 运行环境模块实现1. 特征提取2. 声学模型3. CTC 解码4. 语言模型 系统测试工程源代码下载其它资料下载 前言

本项目基于卷积神经网络和连接性时序分类方法,采用中文语音数据集进行训练,实现声音转录为中文拼…

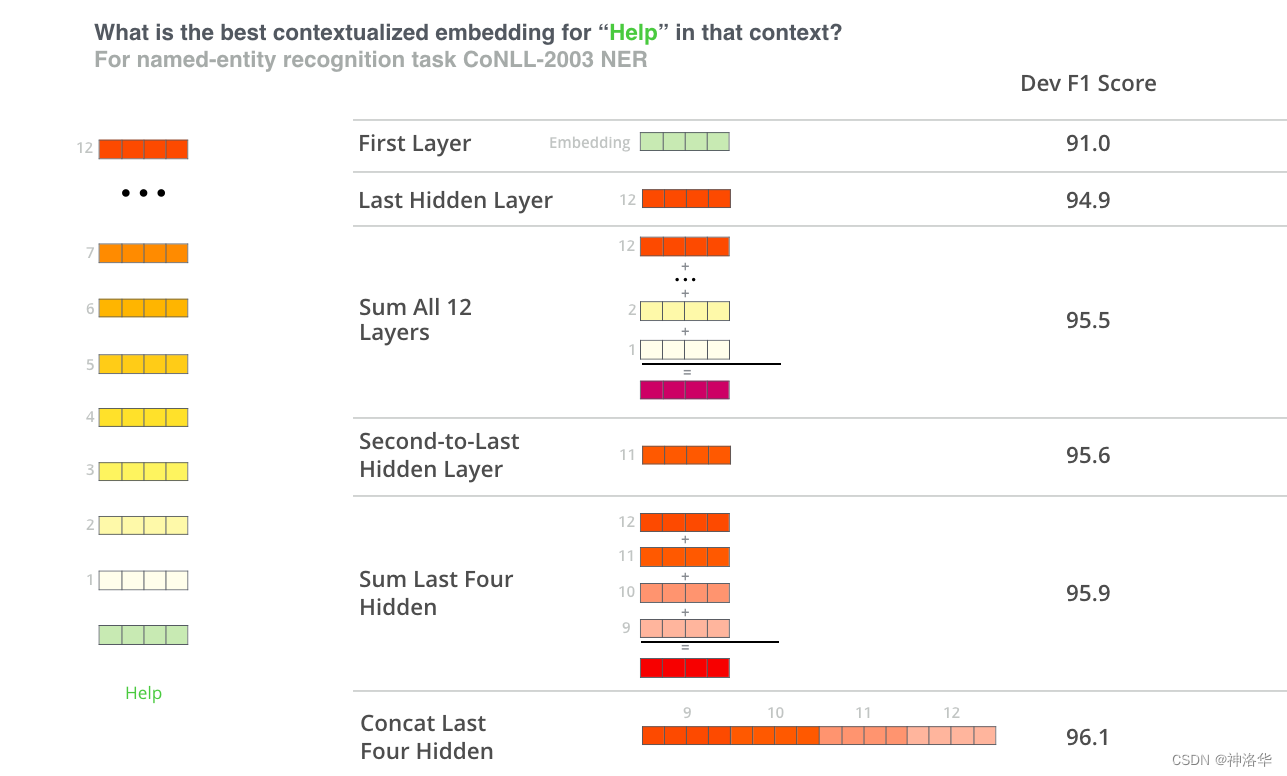

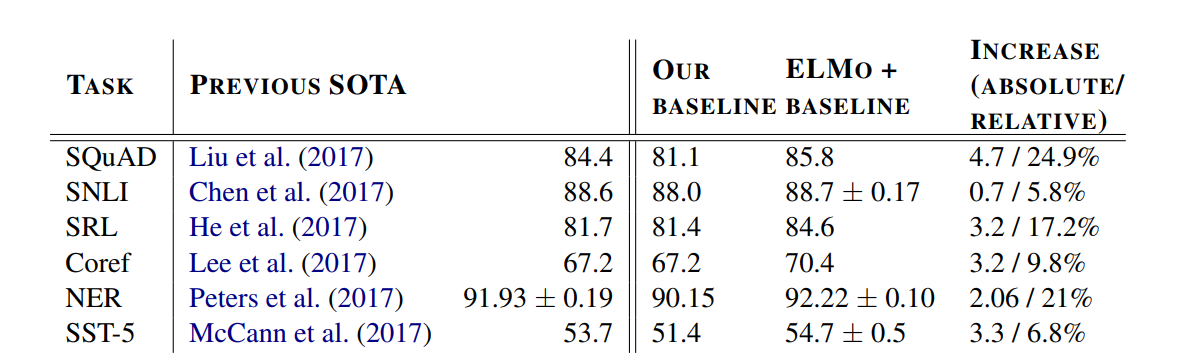

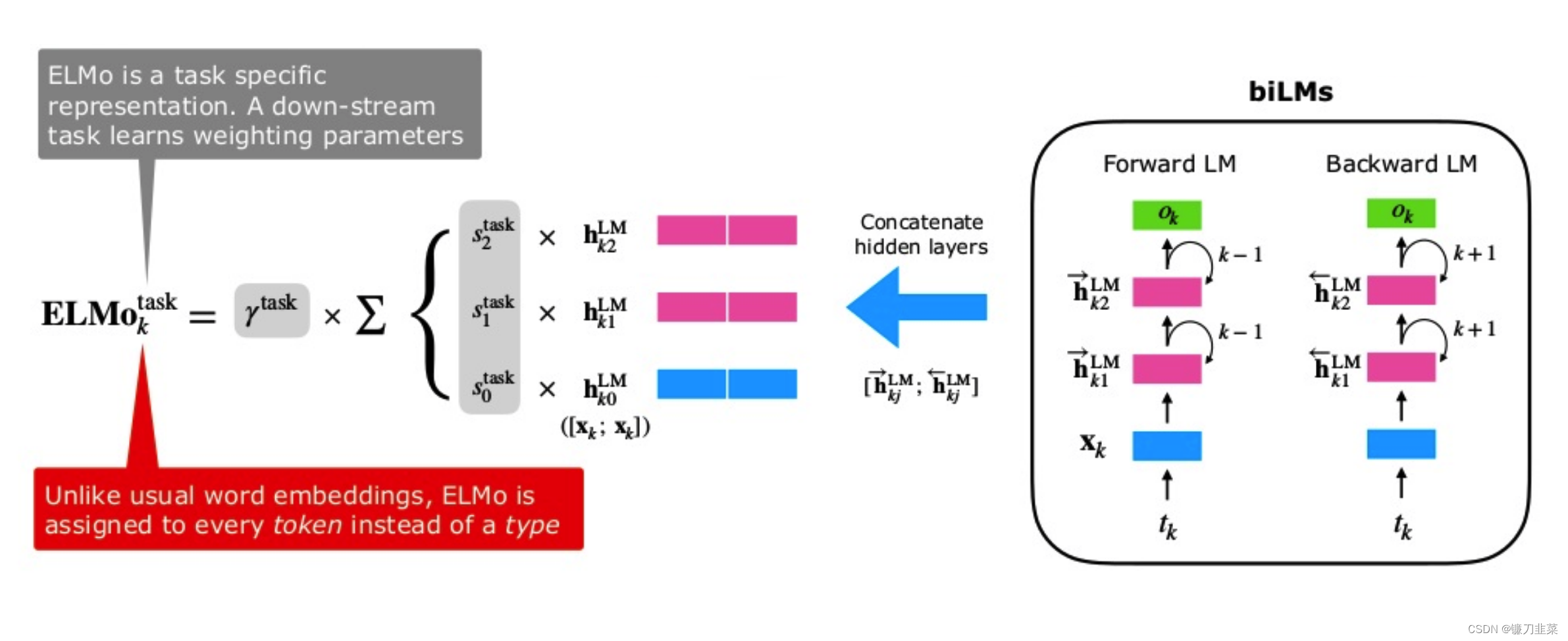

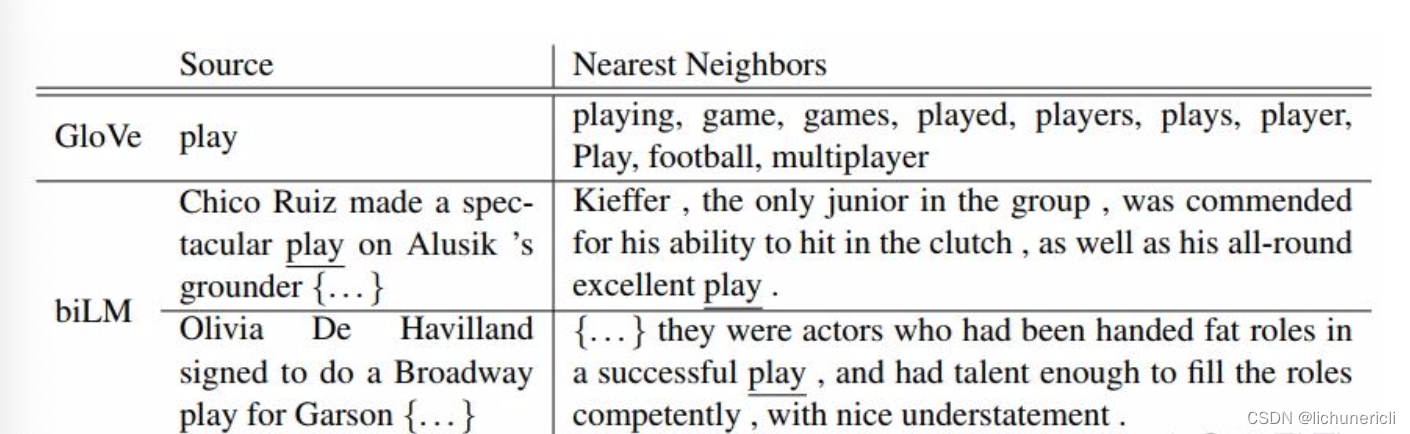

论文笔记--Deep contextualized word representations

论文笔记--Deep contextualized word representations 1. 文章简介2. 文章概括3 文章重点技术3.1 BiLM(Bidirectional Language Model)3.2 ELMo3.3 将ELMo用于NLP监督任务 4. 文章亮点5. 原文传送门 1. 文章简介

标题:Deep contextualized word representations作者…

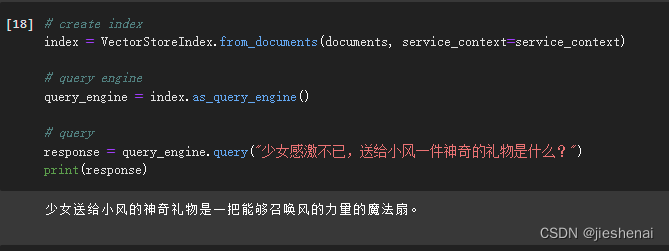

用好Python自然语言工具包-- 实例“基于本地知识库的自动问答”

首先鸣谢thomas-yanxin

本问中示例来自他在GitHub上的开源项目“基于本地知识库的自动问答”,链接如下:

thomas-yanxin/LangChain-ChatGLM-Webui: 基于LangChain和ChatGLM-6B的针对本地知识库的自动问答 (github.com) 目录

1. 基础知识: …

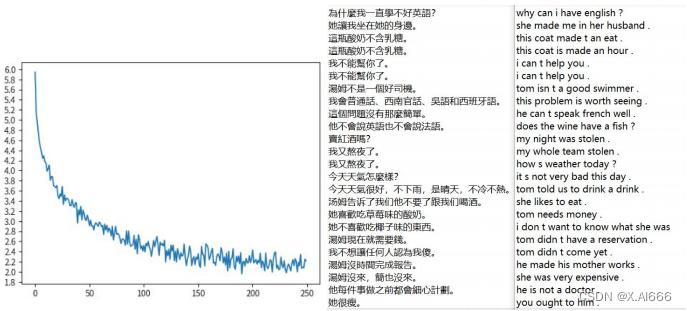

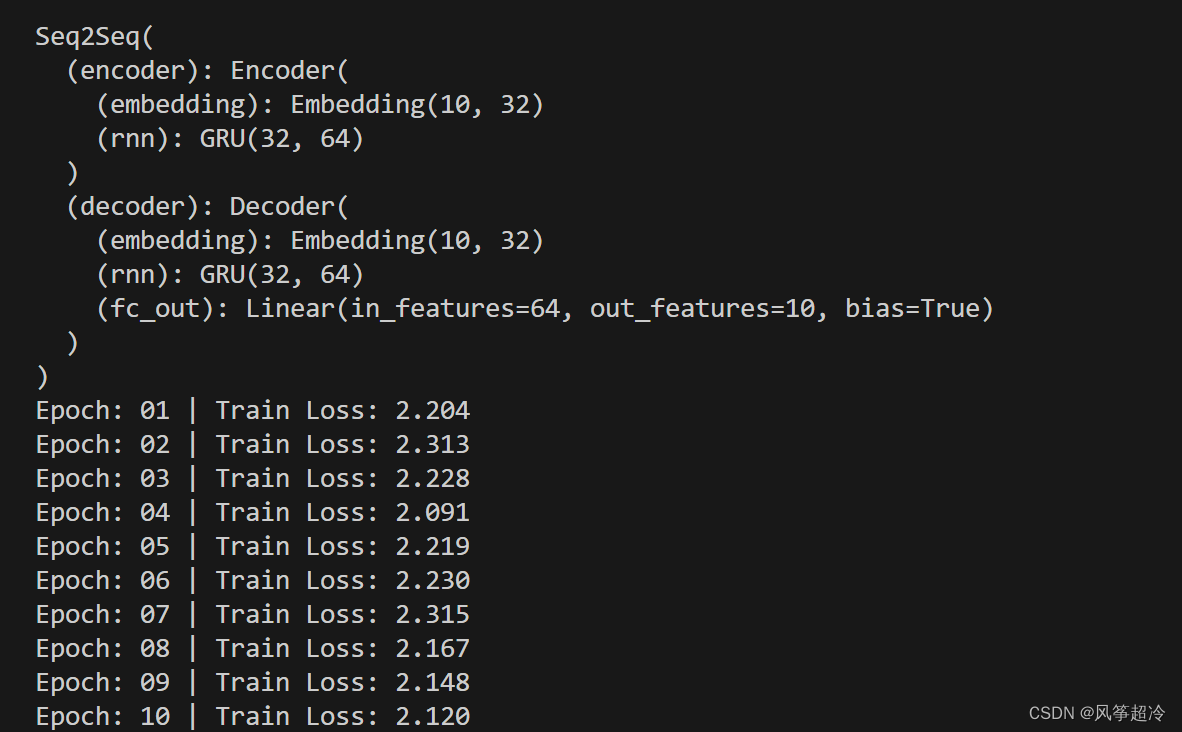

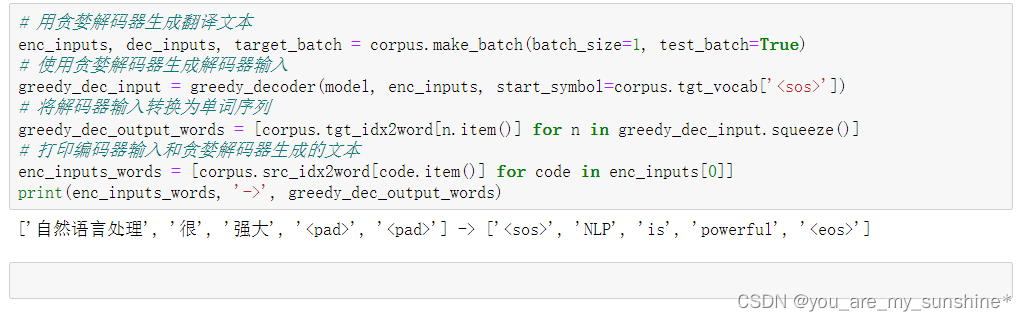

《自然语言处理》第二次实验:机器翻译(Seq2Seq中英文翻译实验)

文章目录 任务一:按照实验手册进行Seq2Seq中英文翻译实验步骤 1 进入ModelArts开发环境步骤 2 下载自然语言处理包步骤 3 上传实验数据步骤 4 进入Notebook实验环境步骤 1 导入实验所需的第三方模块步骤 2 设置运行环境步骤 3 查看数据内容步骤 4 定义数据预处理函数步骤 5 获…

基于图神经网络的异构图表示学习和推荐算法研究(完整代码+数据)

基于图神经网络的异构图表示学习和推荐算法研究。包含基于对比学习的关系感知异构图神经网络(Relation-aware Heterogeneous Graph Neural Network with Contrastive Learning, RHCO)、基于图神经网络的学术推荐算法(Graph Neural Network based Academic Recommendation Algor…

论文笔记 AAAI 2018|Graph Convolutional Networks with Argument-Aware Pooling for Event Detection

文章目录1 简介1.1 创新2 方法3 实验1 简介

论文题目:Graph Convolutional Networks with Argument-Aware Pooling for Event Detection 论文来源:AAAI 2018 论文链接:https://www.aaai.org/ocs/index.php/AAAI/AAAI18/paper/viewPaper/1632…

论文笔记 AAAI 2021|what the role is vs. What plays the role: Semi-supervised Event Argument Extraction v

文章目录1 简介1.1 动机1.2 创新2 方法3 半监督双重训练策略4 实验1 简介

论文题目:What the role is vs. What plays the role: Semi-supervised Event Argument Extraction via Dual Question Answering 论文来源:AAAI 2021 论文链接:http…

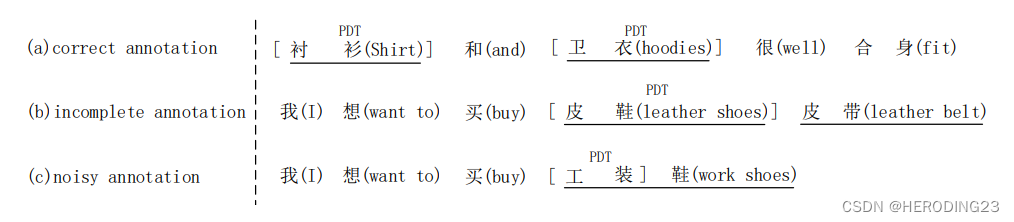

论元笔记 ACL 2017|Automatically Labeled Data Generation for Large Scale Event Extraction

文章目录1 简介1.1 创新2 背景知识3 数据生成4 事件抽取5 实验1 简介

论文题目:Automatically Labeled Data Generation for Large Scale Event Extraction 论文来源:ACL 2017 论文链接:https://aclanthology.org/P17-1038.pdf

1.1 创新

使…

从GPT到ChatGPT:我们离那个理想的AI时代到底还有多远?

写在前面

在2023年新年伊始,科技界最为爆火一款产品无疑是OpenAI公司出品的ChatGPT了,作为一名NLP领域从业者,似乎也好久没有看到如此热闹的技术出圈场景了。诚然从现象来看,无论从效果惊艳度、社会效应、商业价值、科技发展方向…

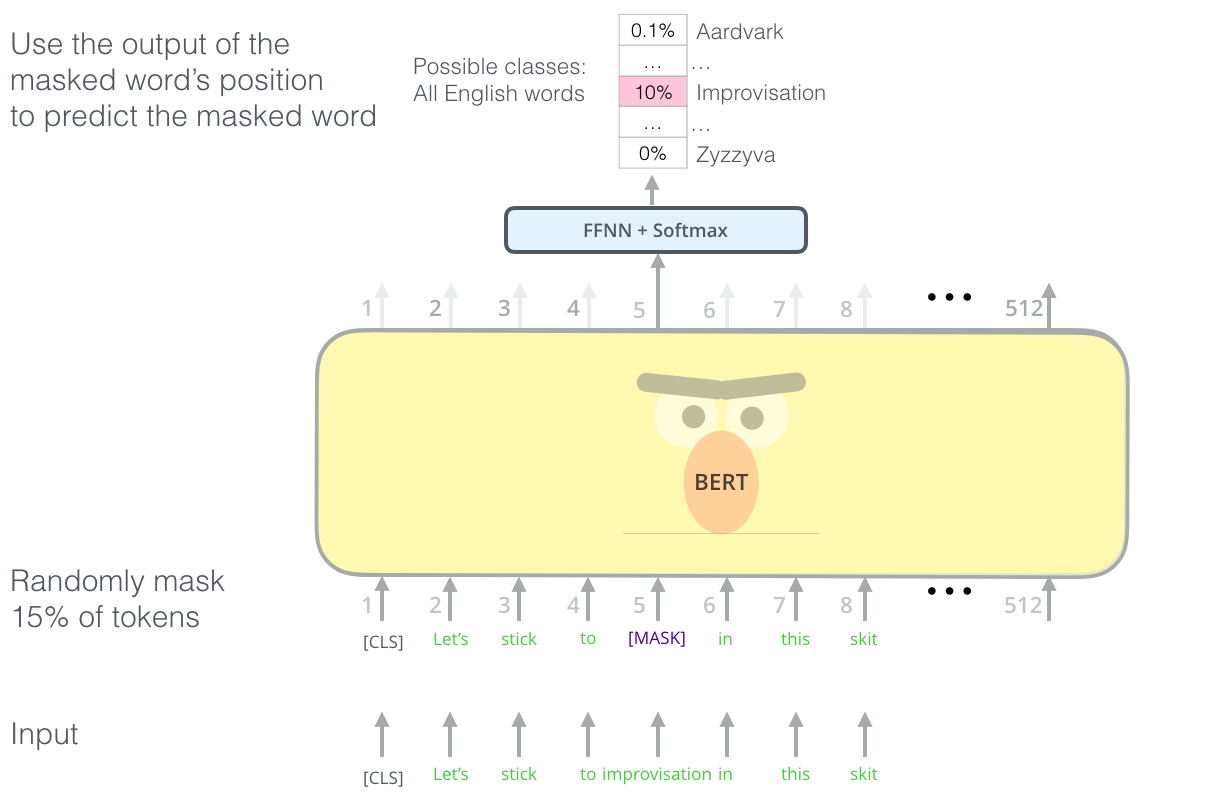

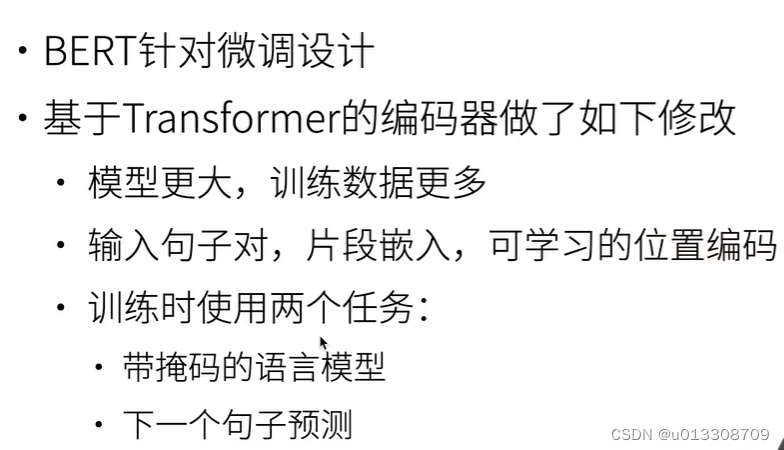

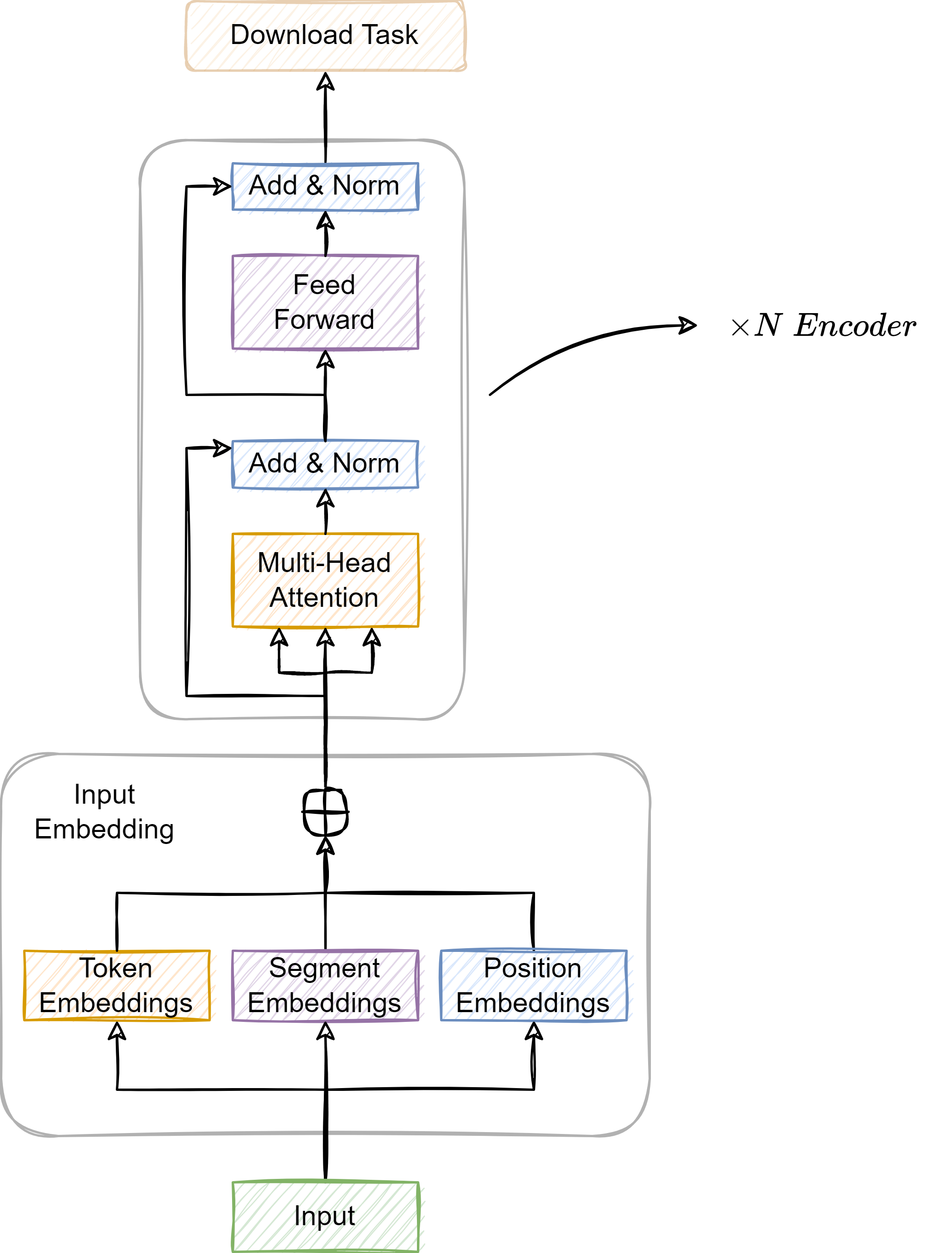

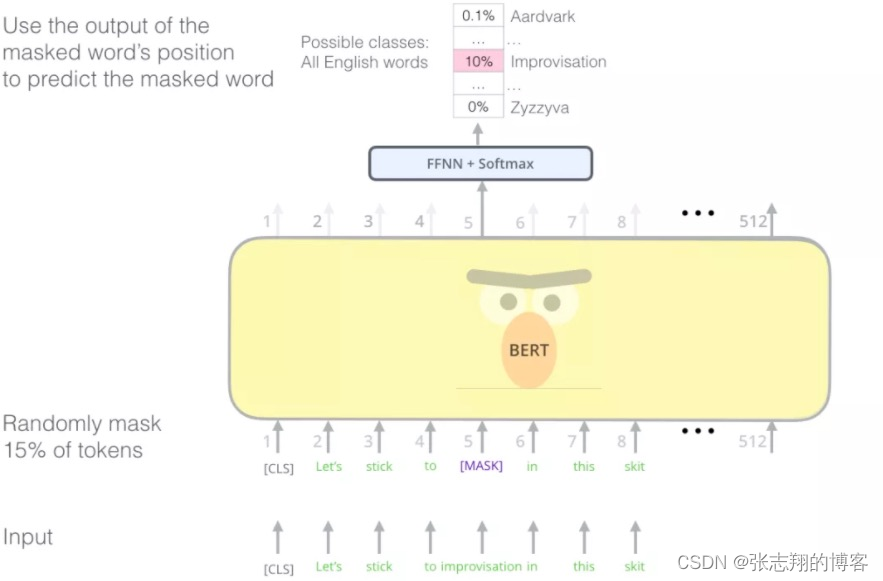

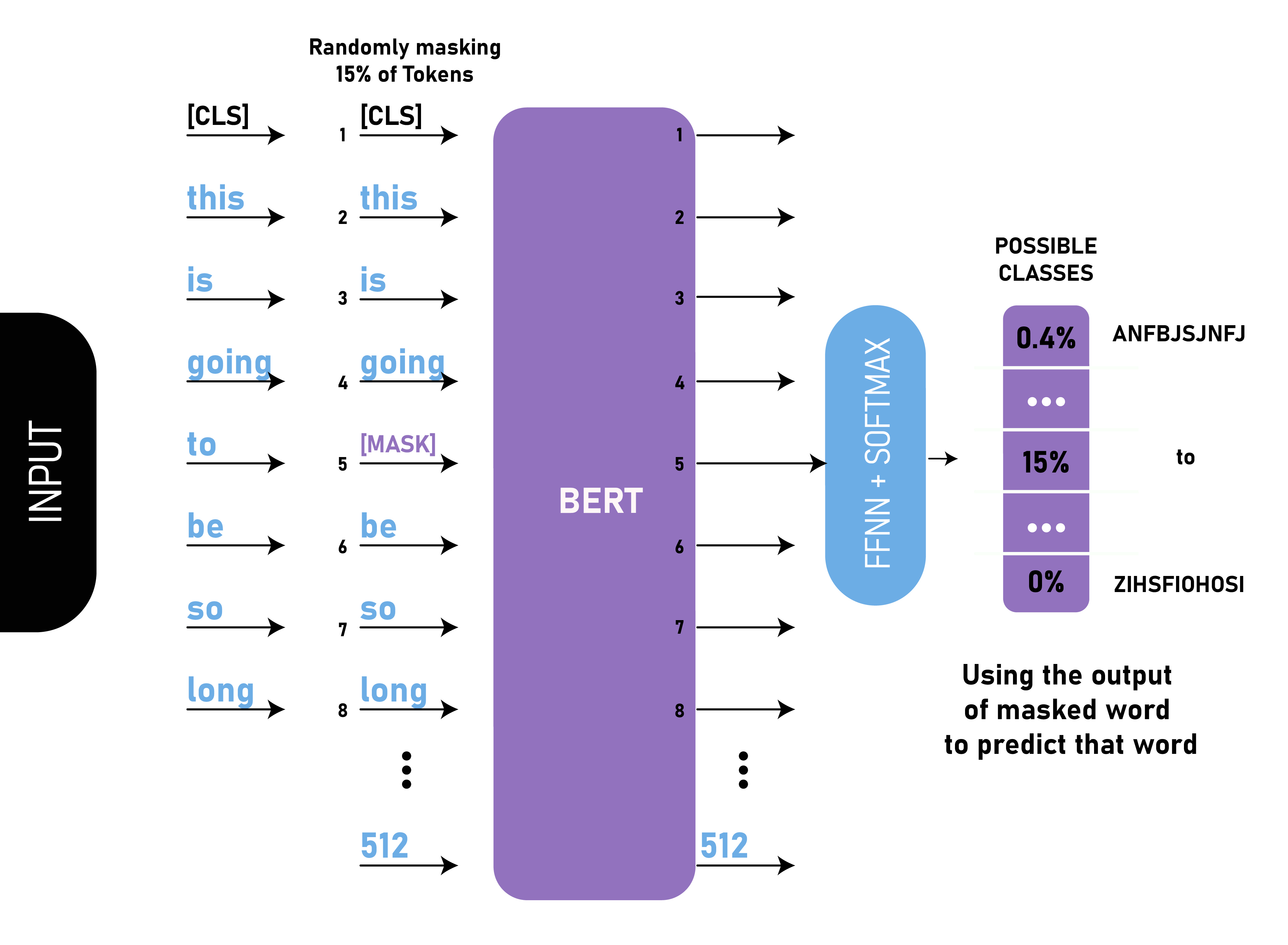

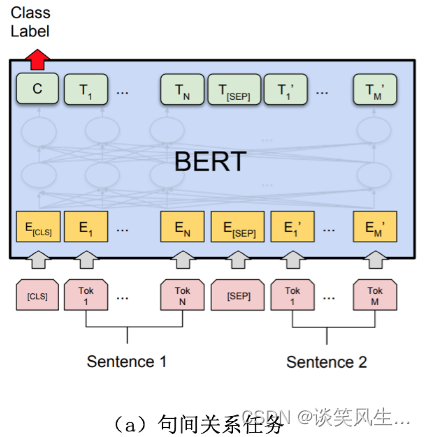

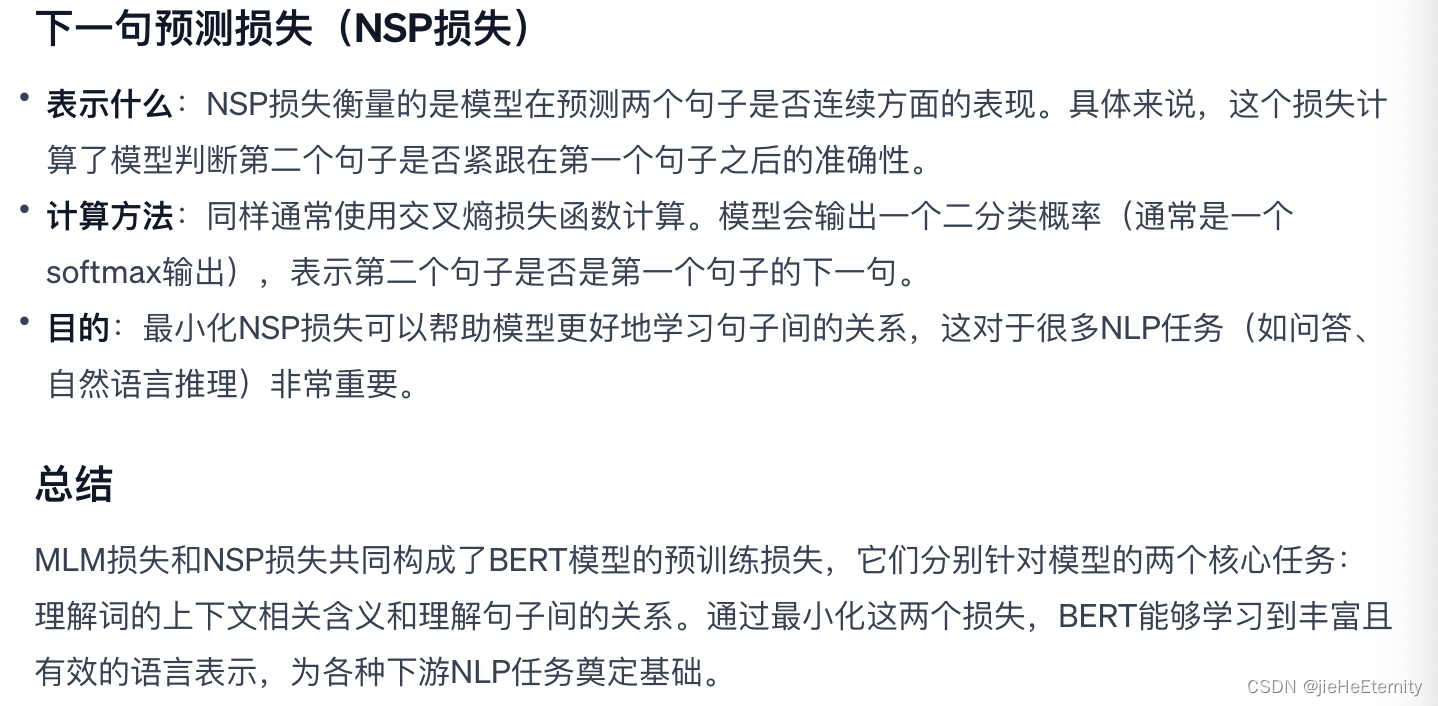

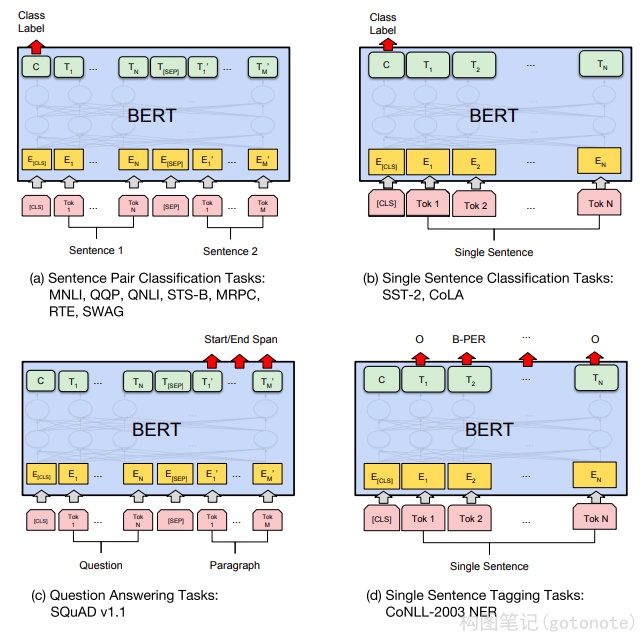

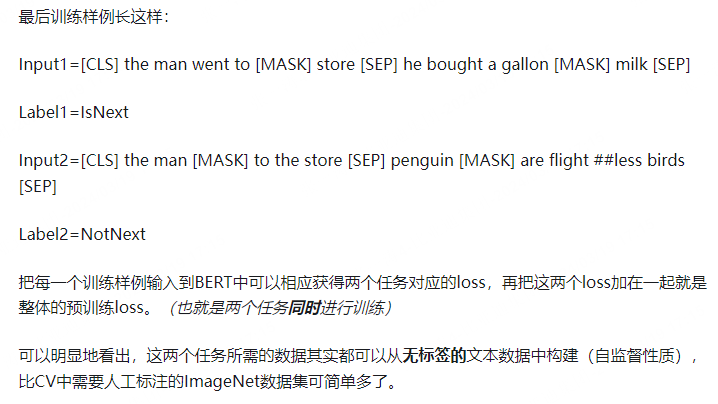

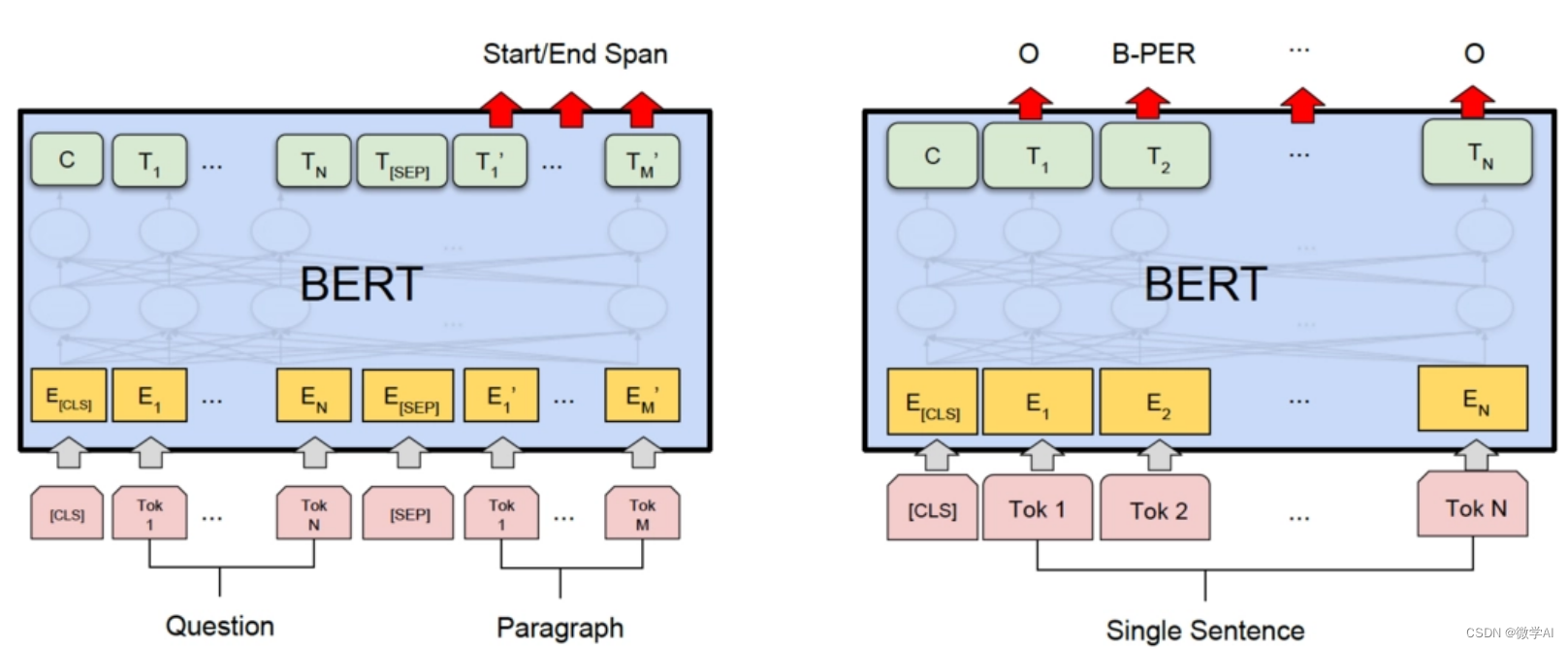

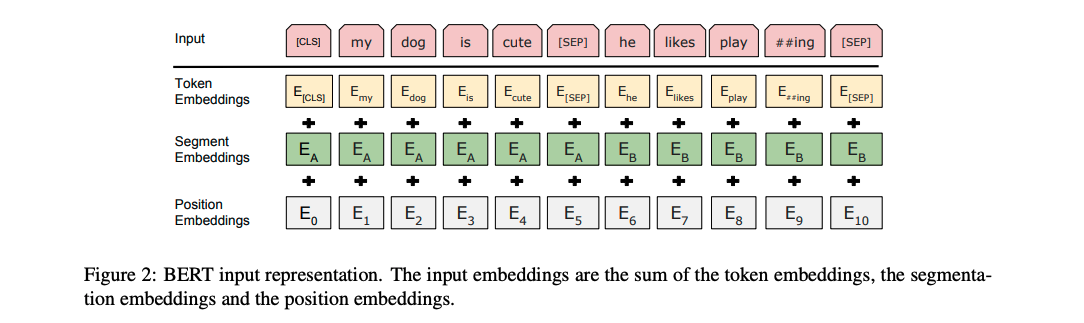

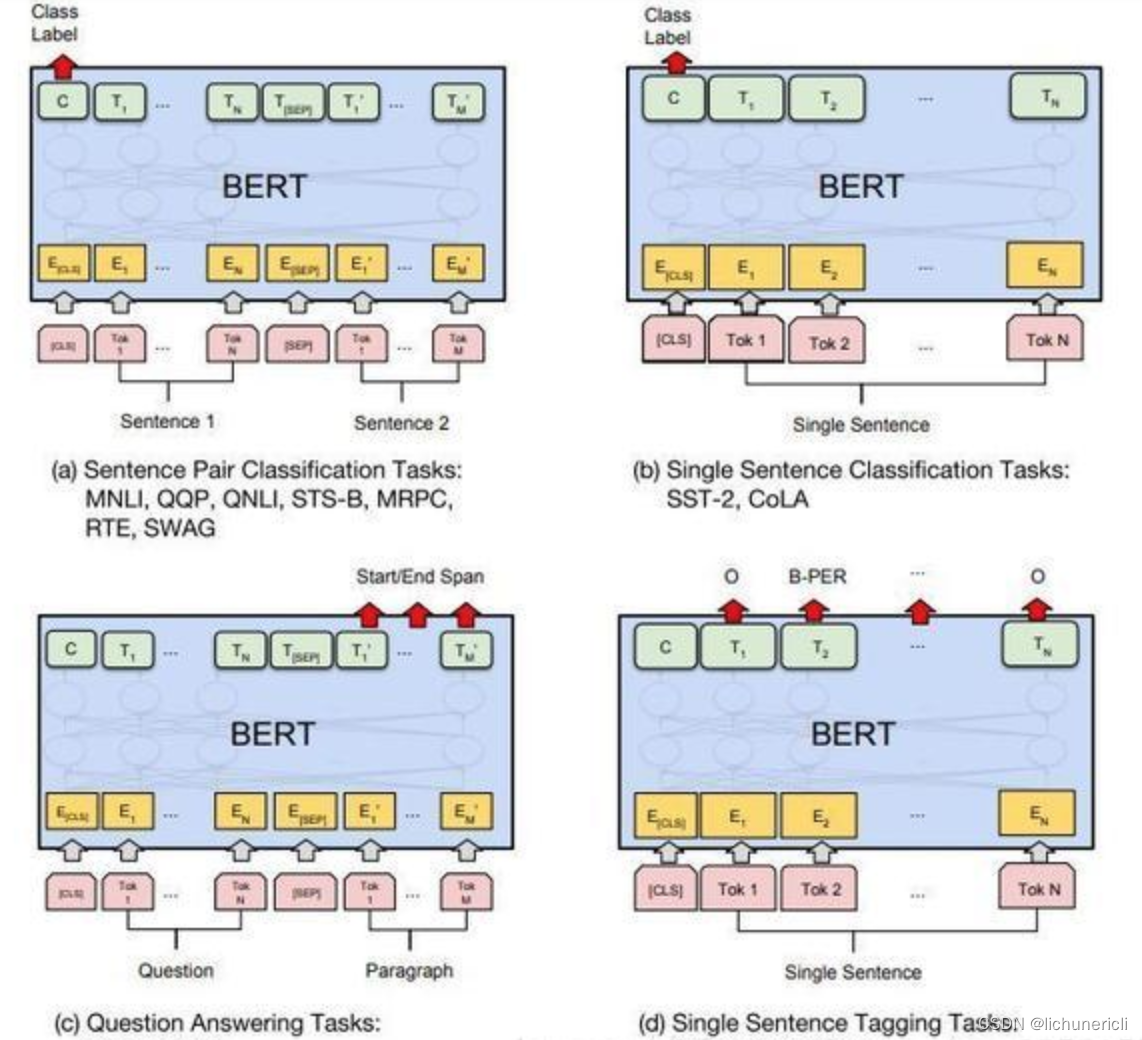

BERT(NAACL 2019)-NLP预训练大模型论文解读

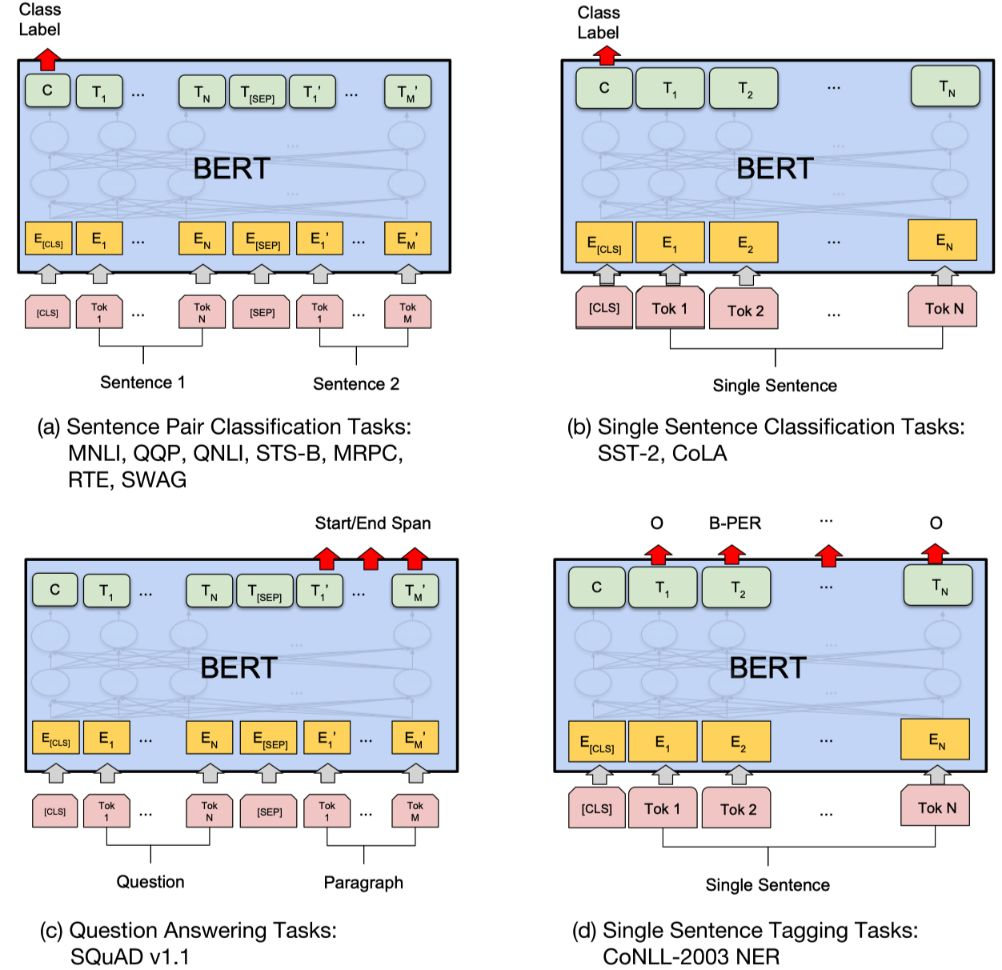

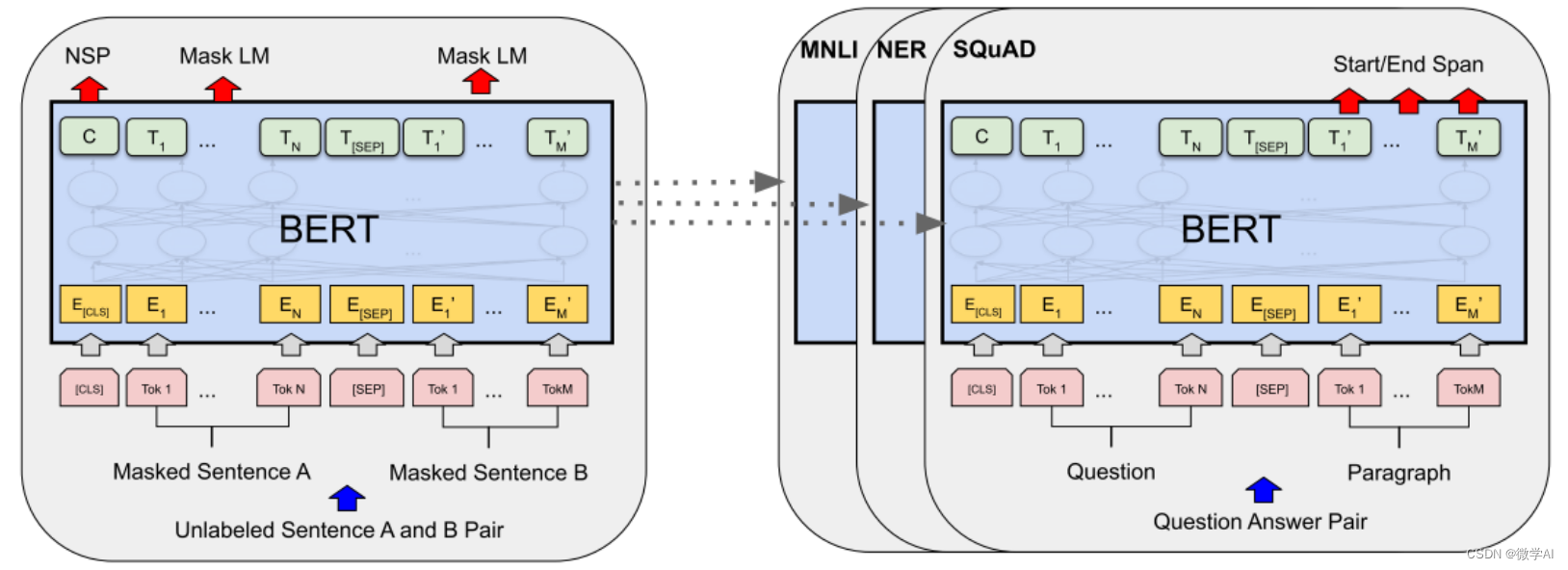

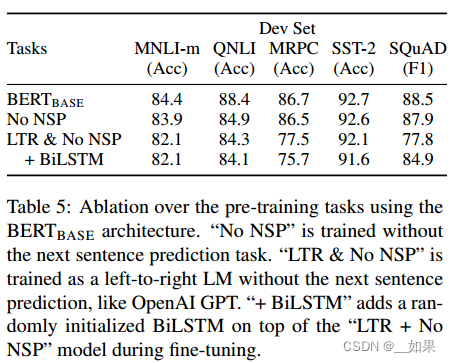

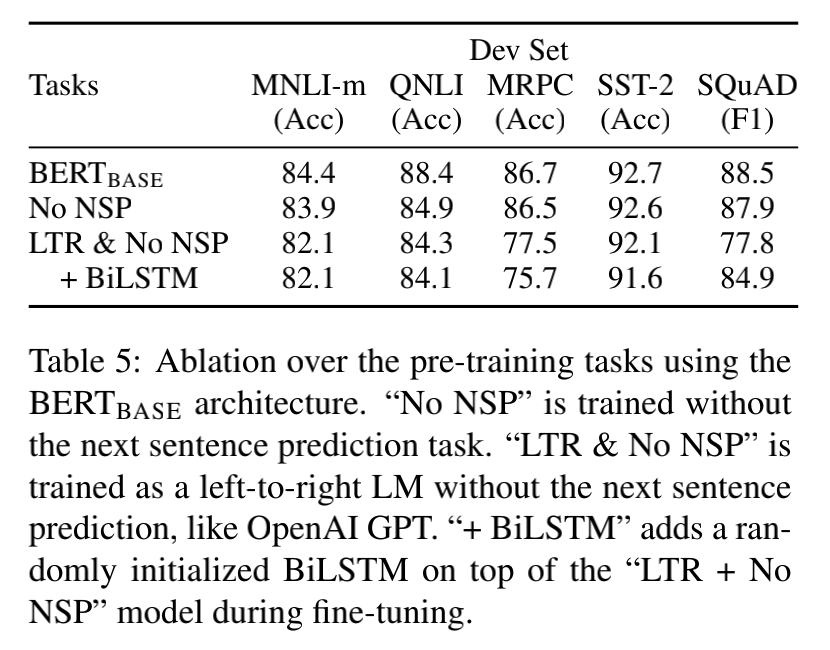

文章目录摘要算法BERT预训练Masked LMNSPFine-tune BERT实验GLUESQuAD v1.1SQuAD v2.0SWAG消融实验预训练任务影响模型大小影响BERT基于特征的方法结论论文:

《BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding》githubÿ…

论文笔记 EMNLP 2020|Event Extraction by Answering (Almost) Natural Questions

文章目录1 简介1.1 动机1.2 创新2 方法3 实验1 简介

论文题目:Event Extraction by Answering (Almost) Natural Questions 论文来源:EMNLP 2020 论文链接:https://arxiv.org/pdf/2004.13625.pdf 代码链接:https://github.com/xi…

论文笔记 ACL 2016|Leveraging FrameNet to Improve Automatic Event Detection

文章目录1 简介1.2 创新2 背景知识3 方法4 实验1 简介

论文题目:Leveraging FrameNet to Improve Automatic Event Detection 论文来源:ACL 2016 论文链接:https://aclanthology.org/P16-1201.pdf

1.2 创新

使用FrameNet提高事件检测任务的…

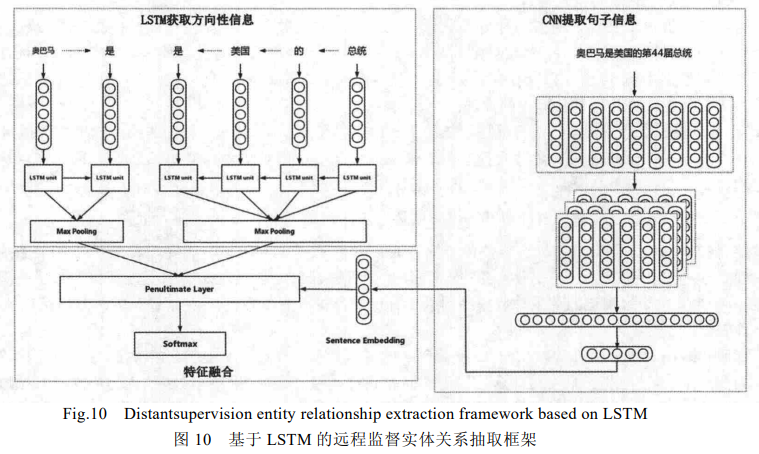

论文笔记 ACL 2016|A Language-Independent Neural Network for Event Detection

文章目录1 简介1.1 创新2 方法3 实验1 简介

论文题目:A Language-Independent Neural Network for Event Detection 论文来源:ACL 2016 论文链接:https://aclanthology.org/P16-2011.pdf

1.1 创新

提出一个基于LSTM和CNN的事件检测模型&am…

功能更新|Live800专业版新增数据播报、语音消息功能

想看客服数据,电脑不在身边,要怎么看?

习惯了语音交互,手机打字太慢,手机H5网页咨询访客也想发语音怎么办?

Live800一直致力打造专业高效的在线客服平台,我们不断更新迭代,持续优化…

ChatGPT火了,对话式人工智能还能干嘛?

身兼数职的ChatGPT 从2022火到了2023 连日来一直是各大平台的热议对象 其实除了写诗、敲代码、处理文档 以ChatGPT为代表的 对话式人工智能 还有更重要的工作要做 对话式AI与聊天机器人 相信大多数人…

如何利用ReconPal将自然语言处理技术应用于信息安全

关于ReconPal

网络侦查一直是网络安全研究以及渗透测试活动中最重要的阶段之一,而这一阶段看起来很容易,但往往需要很大的努力和很强的技术才能做好来。首先,我们需要使用正确的工具、正确的查询/语法以及正确的操作,并将所有信息…

PyQt5自然语言处理入门案例笔记

前言

最近想将自然语言处理的项目进行可视化,尽量还是使用回Python语言,因此打算用PyQt来实现相应的功能。

入门案例

一个简单的自然语言处理的demo,使用PyQt框架,该demo可以读取文本文件,对文件中的文本进行情感分…

ChatGPT介绍以及一些使用案例

❤️觉得内容不错的话,欢迎点赞收藏加关注😊😊😊,后续会继续输入更多优质内容❤️👉有问题欢迎大家加关注私戳或者评论(包括但不限于NLP算法相关,linux学习相关,读研读博…

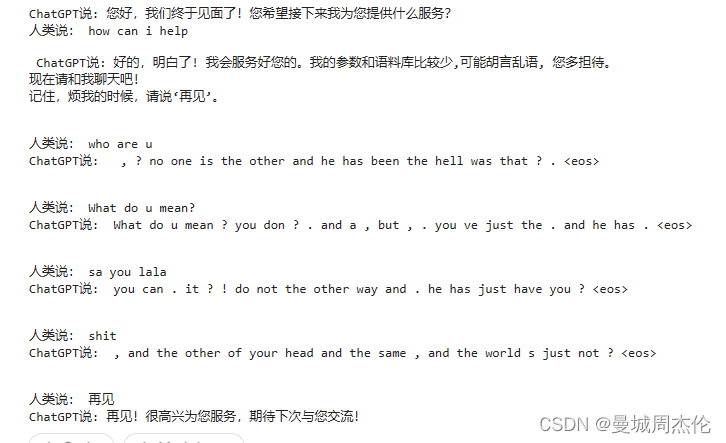

实现chatgpt自然对话

1.概述

ChatGPT是当前自然语言处理领域的重要进展之一,通过预训练和微调的方式,ChatGPT可以生成高质量的文本,可应用于多种场景,如智能客服、聊天机器人、语音助手等。本文将详细介绍ChatGPT的原理、实战演练和流程图,…

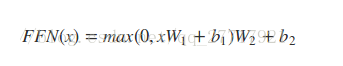

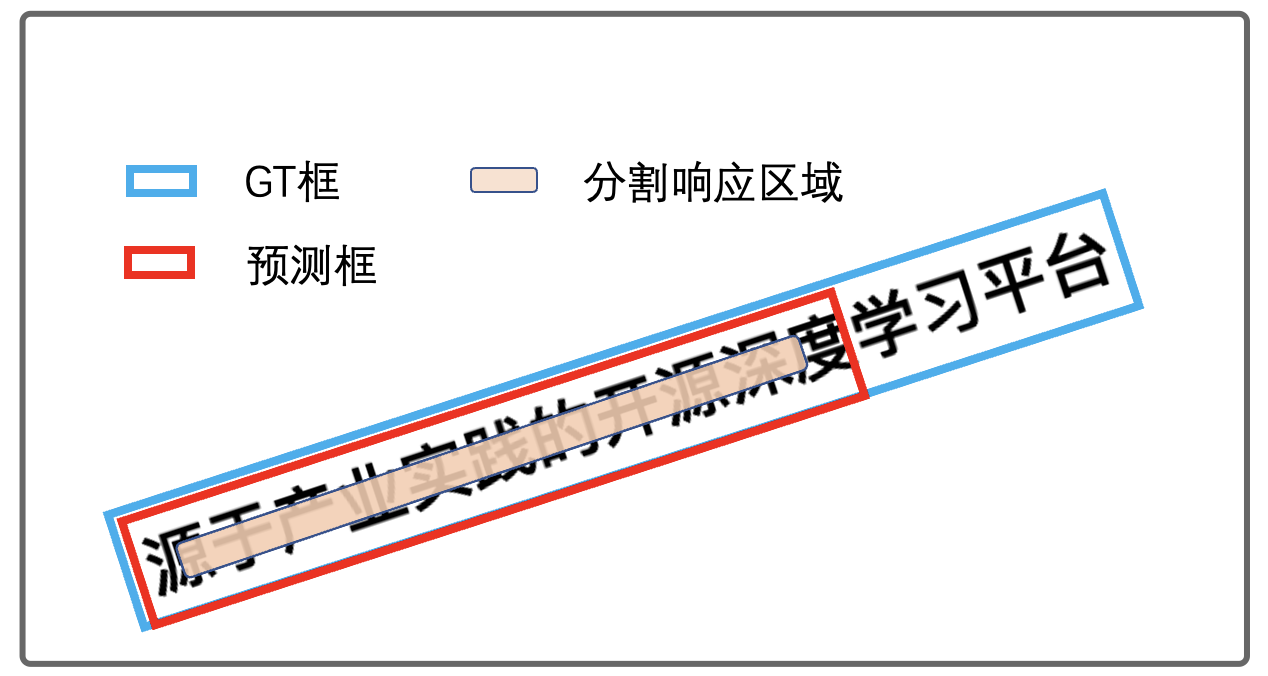

CV——day82 读论文:遥感目标检测的改进注意力特征融合SSD (AF-SSD)方法

遥感目标检测的改进注意力特征融合SSD 方法I. INTRODUCTIONII. RELATED WORKB. 特征融合C.注意力机制III. PROPOSED METHODA. 特性融合模块——**FFM**B.双路径注意模块——DAMC. 多尺度接受域——MRFIV. EXPERIMENTSA. Data Sets and TrainingV. CONCLUSIONAttention and Feat…

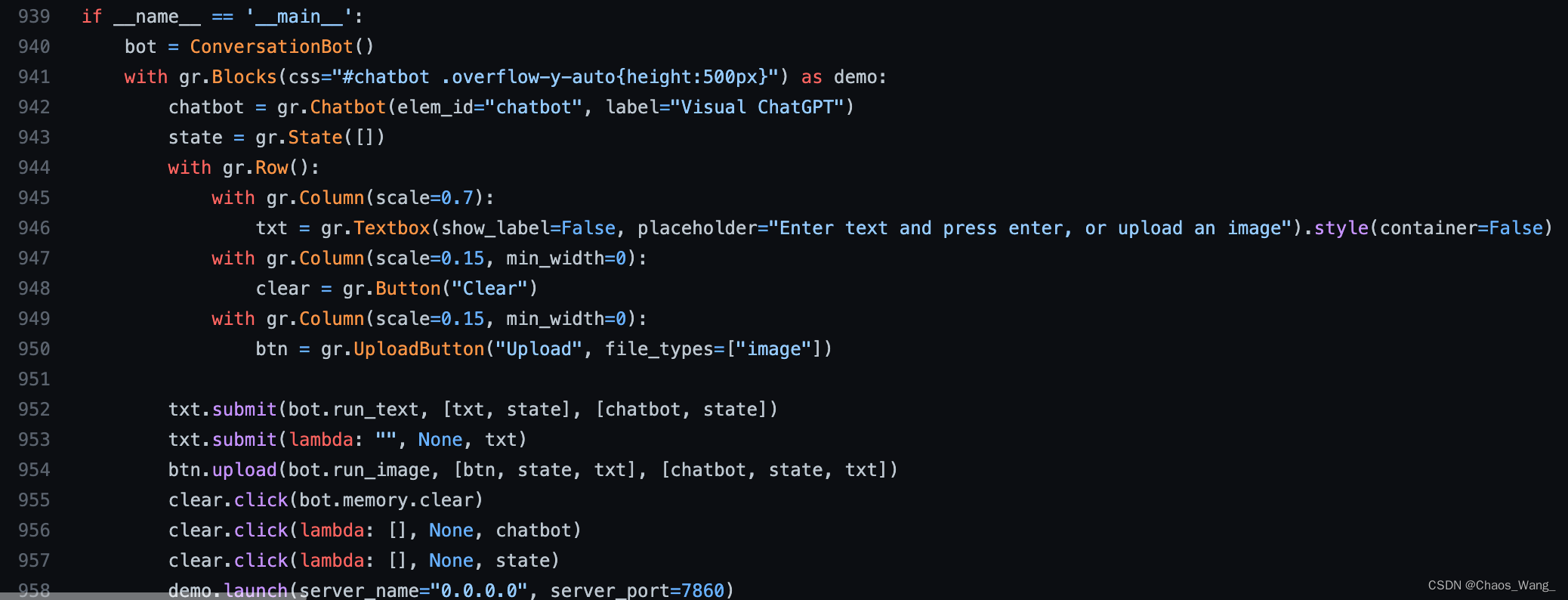

超越语言界限,ChatGPT进化之路——Visual ChatGPT

❤️觉得内容不错的话,欢迎点赞收藏加关注😊😊😊,后续会继续输入更多优质内容❤️👉有问题欢迎大家加关注私戳或者评论(包括但不限于NLP算法相关,linux学习相关,读研读博…

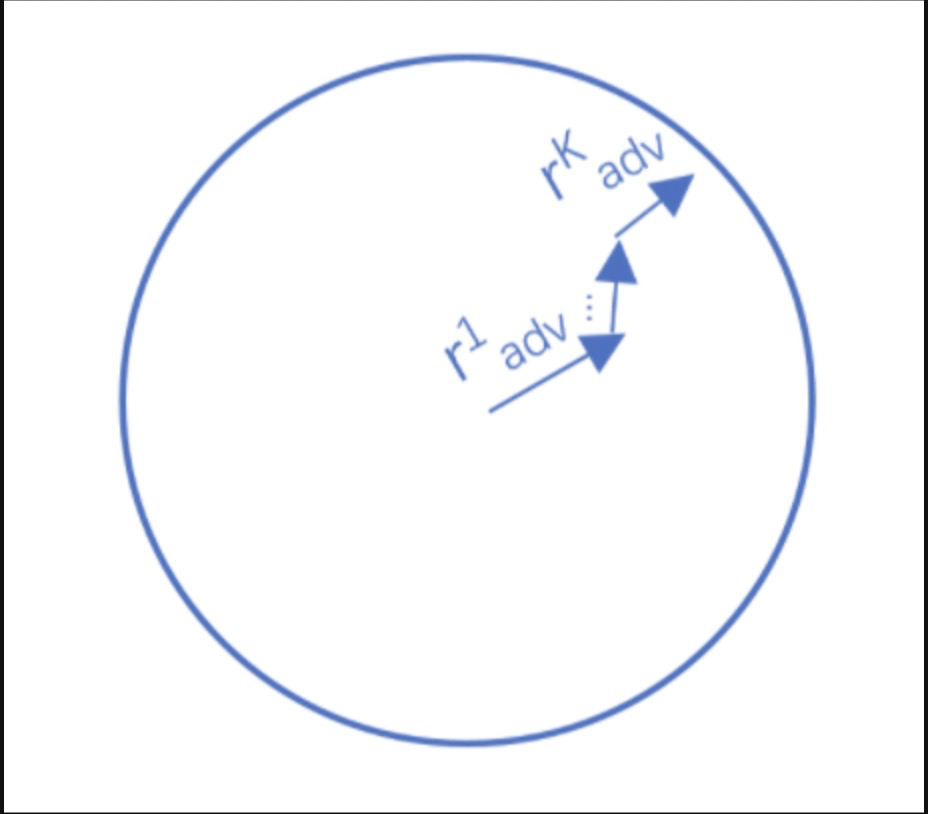

推荐系统中对抗性机器学习-文献综述与未来发展整理分享

对抗学习是一种机器学习技术,旨在通过提供欺骗性输入来欺骗模型。最常见的原因是导致机器学习模型出现故障。大多数机器学习技术旨在处理特定的问题集,其中从相同的统计分布(IID)生成训练和测试数据。当这些模型应用于现实世界时&…

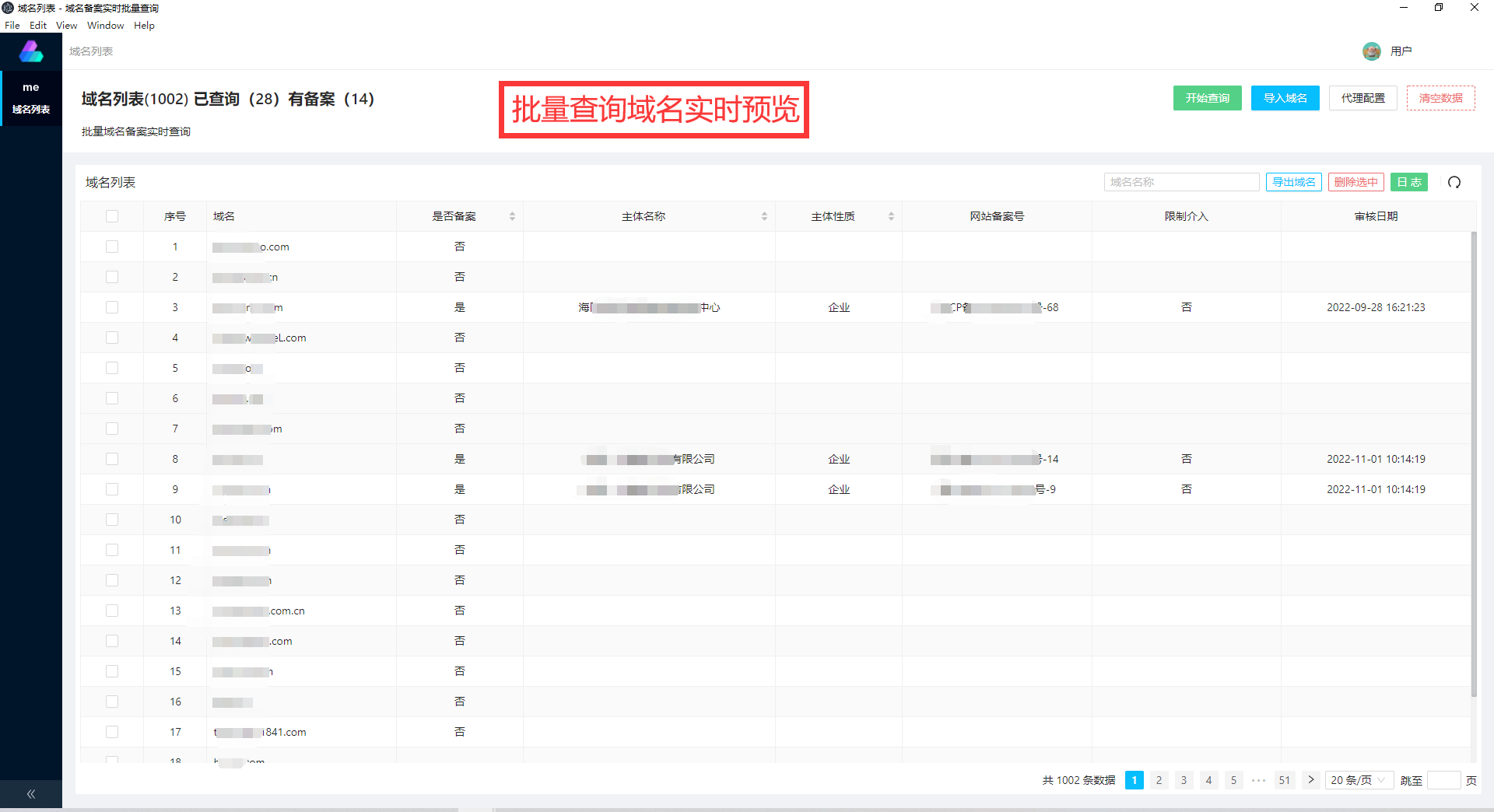

在线未注册域名批量查询-域名注册批量查询

域名批量注册查询

域名批量注册查询是一种工具,可以帮助用户批量查询并注册多个域名。这种工具通常被域名管理者、品牌专家、互联网营销人员等使用。

以下是域名批量注册查询工具的优点: 提高效率:与手动单独注册域名相比,域名批…

剖析NLP历史,看chatGPT的发展

1、NLP历史演进

1.1 NLP有监督范式

NLP里的有监督任务的范式,可以归纳成如下的样子。

输入是字词序列,中间一步关键的是语义表征,有了语义表征之后,然后交给下游的模型学习。所以预训练技术的发展,都是在围绕怎么…

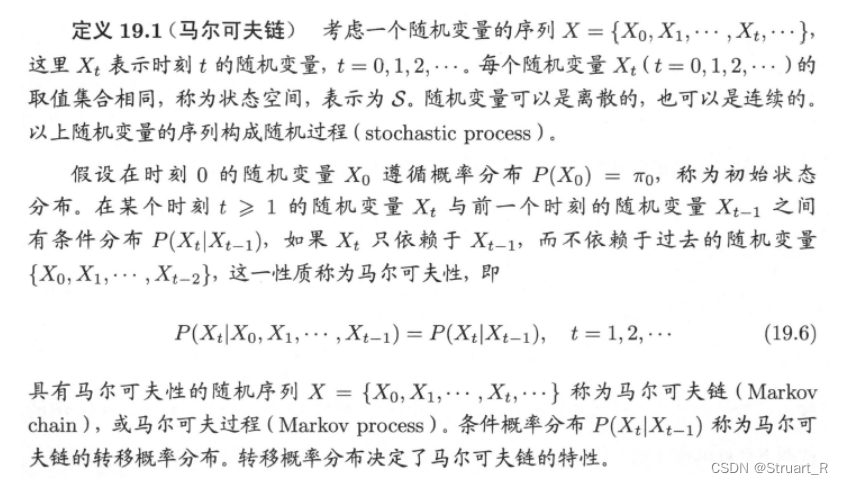

条件随机场(CRF)——1 理论详解

需要的基础:

马尔科夫模型隐马尔科夫模型

本文仔细介绍条件场的提出及基础;下一文会介绍CRF如何应用在NER领域,以及CRF,LR和HMM之间的关系和比较。可以点击下面链接跳转

条件随机场(CRF)——2 CRF、HMM、…

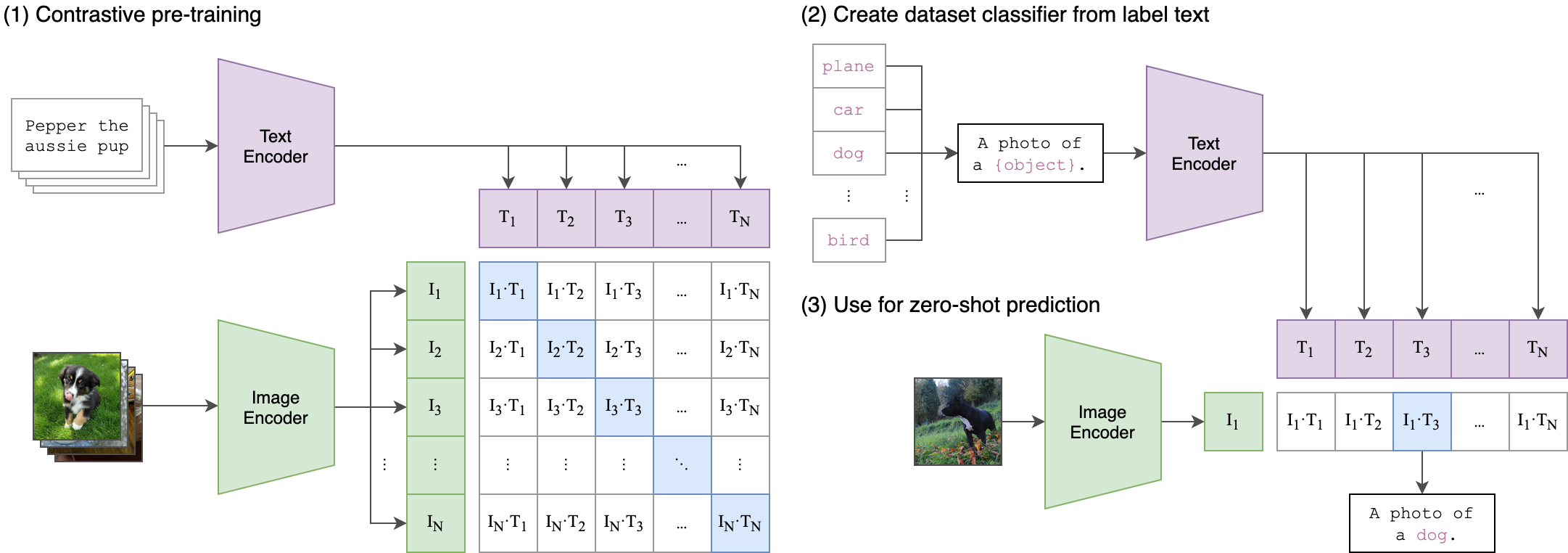

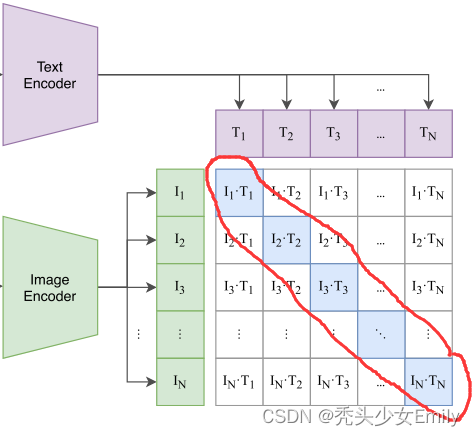

CLIP-Event: Connecting Text and Images with Event Structures 论文解读

CLIP-Event: Connecting Text and Images with Event Structures 论文:2201.05078v1.pdf (arxiv.org)

代码:limanling/clip-event (github.com)

期刊/会议:CVPR 2022

摘要

视觉-语言(VL)预训练模型通过理解图像和文本之间的对齐关系&…

深入理解NLP的多项选择任务

❤️觉得内容不错的话,欢迎点赞收藏加关注😊😊😊,后续会继续输入更多优质内容❤️👉有问题欢迎大家加关注私戳或者评论(包括但不限于NLP算法相关,linux学习相关,读研读博…

ChatGPT常用prompts汇总

❤️觉得内容不错的话,欢迎点赞收藏加关注😊😊😊,后续会继续输入更多优质内容❤️👉有问题欢迎大家加关注私戳或者评论(包括但不限于NLP算法相关,linux学习相关,读研读博…

深入了解 Hugging Face 中的生成工具:Generate方法

❤️觉得内容不错的话,欢迎点赞收藏加关注😊😊😊,后续会继续输入更多优质内容❤️👉有问题欢迎大家加关注私戳或者评论(包括但不限于NLP算法相关,linux学习相关,读研读博…

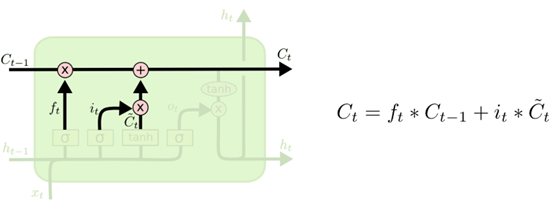

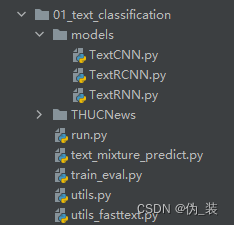

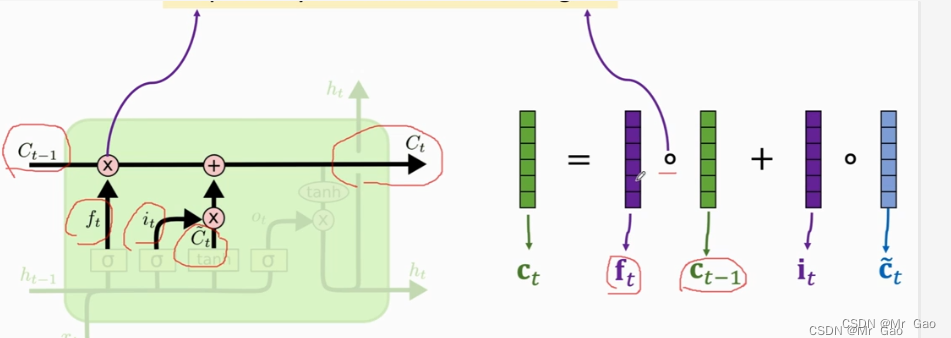

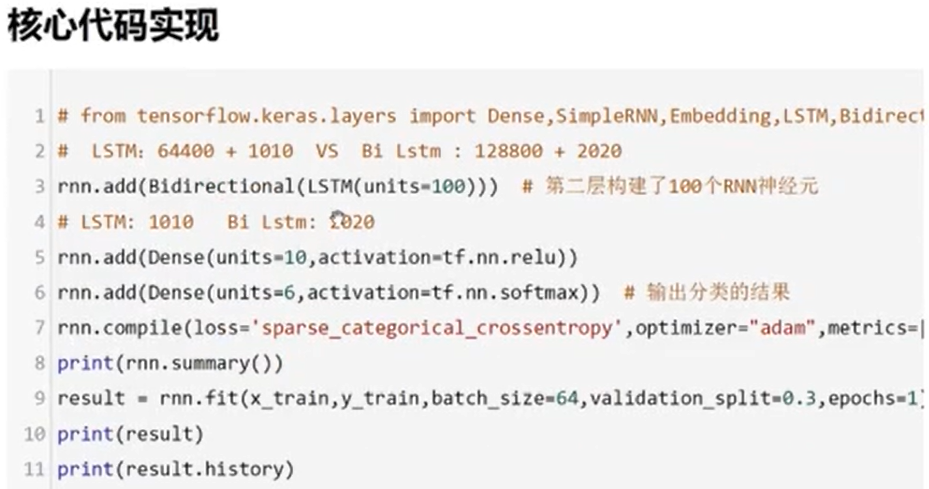

LSTM原理,参数,实现中文新闻分类代码实现

目录

环境以及第三方库版本

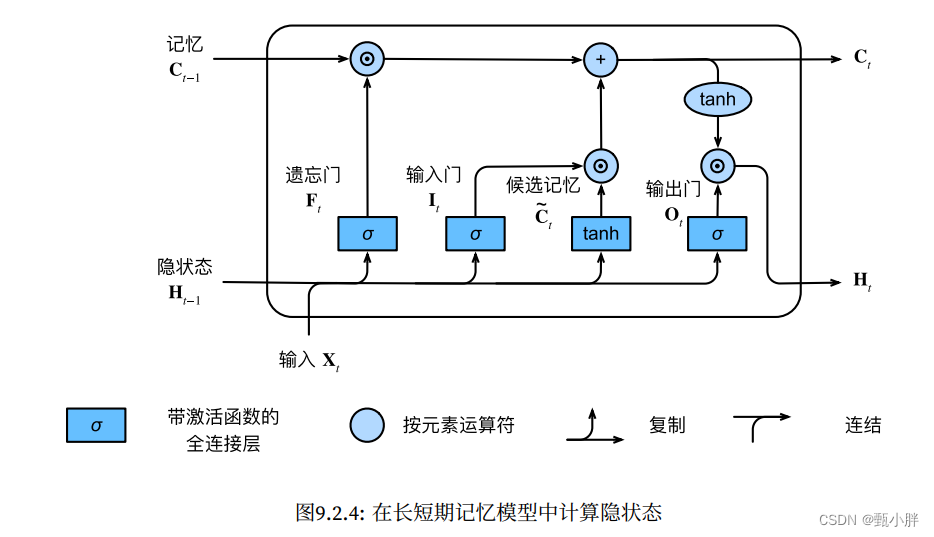

LSTM模型 遗忘门(决定上一时刻的单元状态有多少要保存到当前时刻)

输入门(决定当前网络状态输入有多少需要保存到单元状态)

输出门(控制当前状态单元有多少需要输出到当前输出值&#x…

Python自然语言处理:NLTK入门指南

Python自然语言处理:NLTK入门指南 一、Python自然语言处理简介1. 什么是自然语言处理(NLP)2. Python在NLP中的应用3. 为什么选择使用Python进行NLP 二、NLTK介绍1. NLTK是什么2. NLTK的历史和现状3. NLTK的安装和配置4. NLTK的基本功能分词&a…

【ChatGPT4】 NLP(自然语言处理)第八课 情感分析的概念和应用场景

我在起,点更新NLP自然语言处理》《王老师带我成为救世主》

(1)---------------------------------------------------------------------------------------

王老师上节课的作业:

1、了解情感分析的概念和应用场景。

2、分析以…

生成式大语言模型微调训练快速手册

ChatGPT的流行让大语言模型走入了大家的视线,怎么打造自己的大语言模型成为了一个急需解决的问题。

目录

大语言模型的获取方法有以下三种:

目前可以Play 的大语言基础模型列表: 大语言模型的获取方法有以下三种:

1. 完全白嫖…

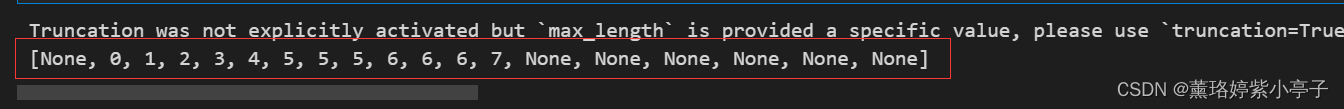

若一个单词被拆分成多少token, word_ids得到的序号是相同的?还是序号累加的?

目录 问题描述:

问题实现:

方法一:

方法二: 问题描述:

在使用tokenizer进行编码的时候,经常会存在word被拆分成多个token的情况,不同的参数设置,会得到不同的结果。总的来说&…

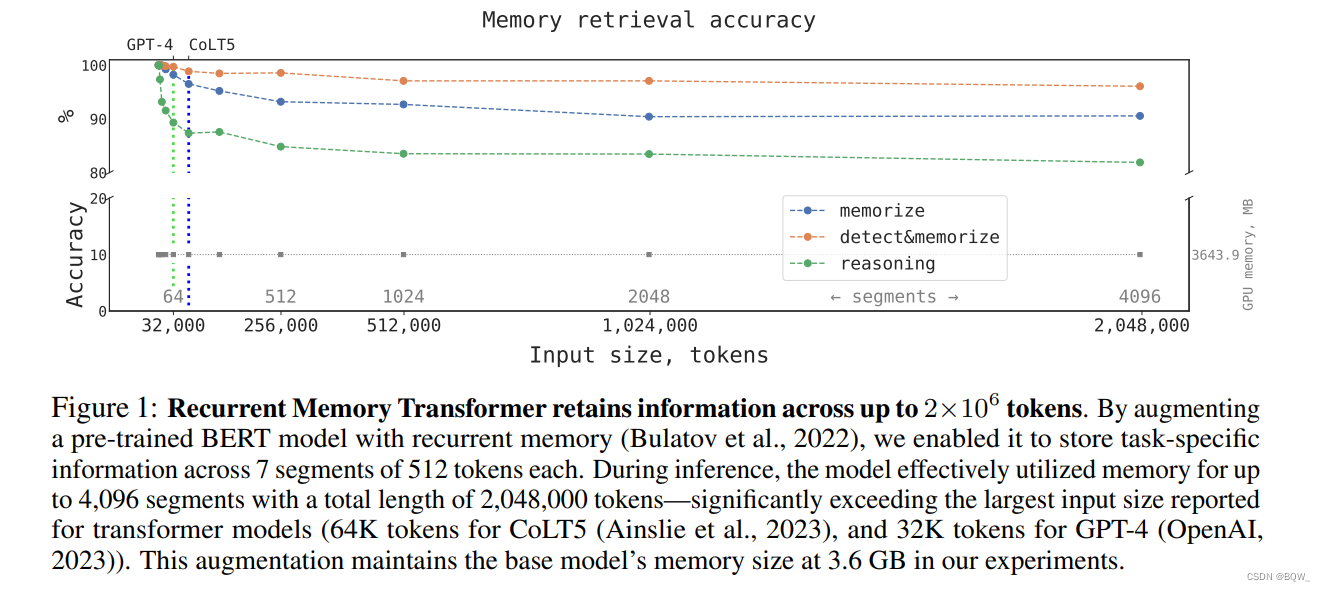

GPT4限制被破解!ChatGPT实现超长文本处理的新方法

目录

前言

使用chat-gpt过程中有哪些痛点

1.无法理解人类情感和主观性

2.上下文丢失

3.约定被打断

那如何去解决这个痛点

Transformer(RMT)怎么去实现的

1.Transformer 模型

2.RMT模型 3.计算推理速率

4.渐进学习能力

总结

写到最后 大家好…

Call for Papers丨第十一届全国社会媒体处理大会,AI Open设独立专刊投稿渠道

全国社会媒体处理大会(SMP)专注于以社会媒体处理为主题的科学研究,为传播社会媒体处理最新的学术研究与技术成果提供广泛的交流平台,旨在构建社会媒体处理领域的产学研生态圈,成为中国乃至世界社会媒体处理的风向标。 …

《Learning to Answer Complex Questions over Knowledge Bases with Query Composition》论文笔记

Learning to Answer Complex Questions over Knowledge Bases with Query Composition

这是一篇密歇根安娜堡发表在CIKM上的文章,主题为KBQA,依然是SP-based。

Overview

这篇文章处理的是复杂问题,主题方法还是通过SP生成query graph&…

【自然语言处理】- 作业6: 面向新冠肺炎的社会计算应用

课程链接: 清华大学驭风计划

代码仓库:Victor94-king/MachineLearning: MachineLearning basic introduction (github.com) 驭风计划是由清华大学老师教授的,其分为四门课,包括: 机器学习(张敏教授) , 深度学习(胡晓林教授), 计算…

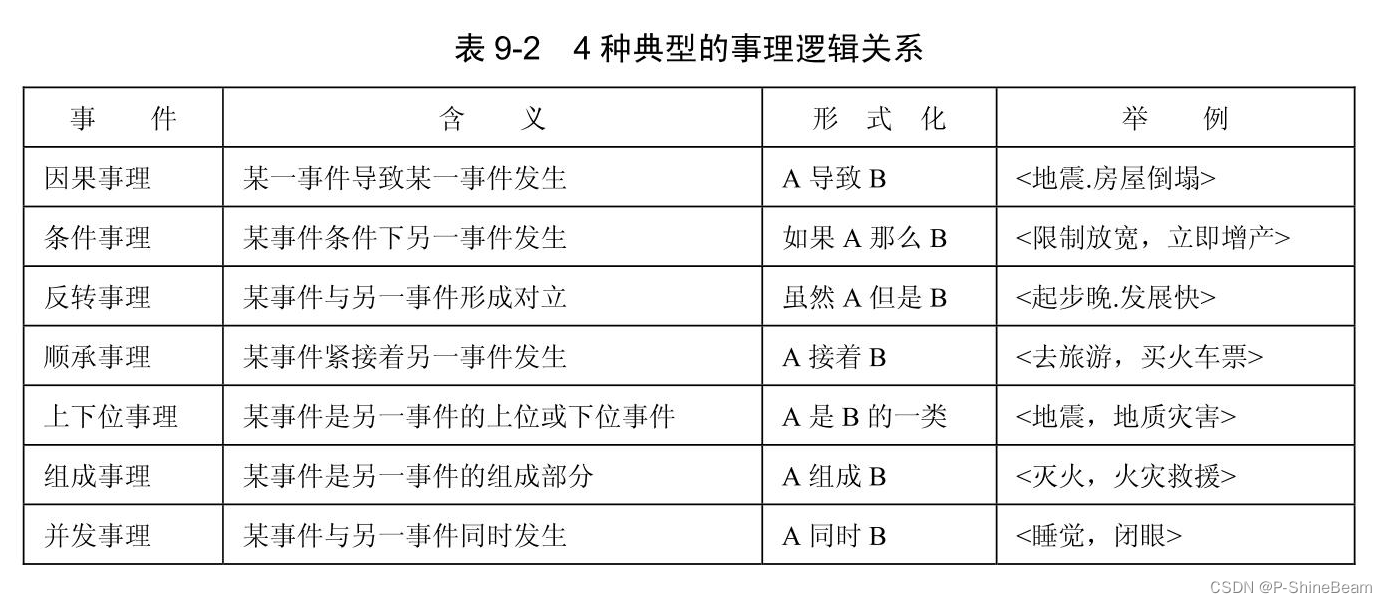

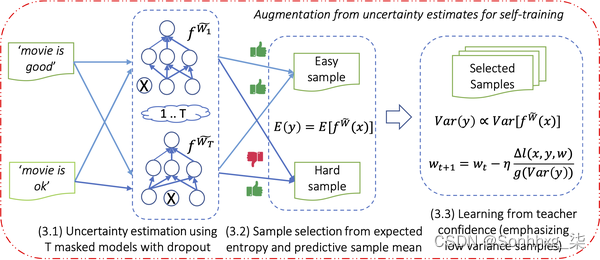

论文笔记 EMNLP 2020|Affective Event Classification with Discourse-enhanced Self-training

文章目录1 简介1.2 创新2 方法3 实验1 简介

论文题目:Affective Event Classification with Discourse-enhanced Self-training 论文来源:EMNLP 2020 论文链接:https://aclanthology.org/2020.emnlp-main.452.pdf

1.2 创新

提出了一个基于…

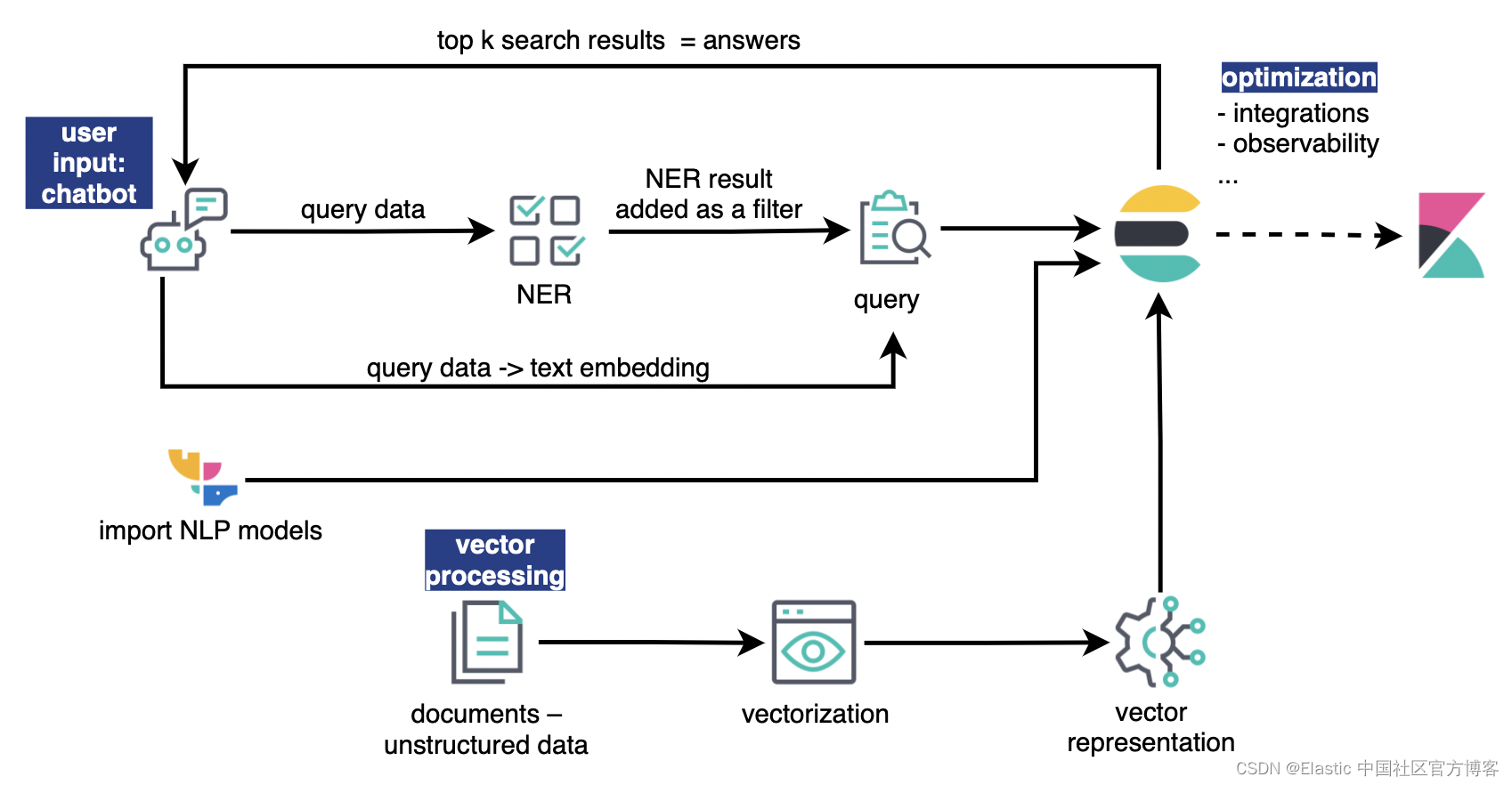

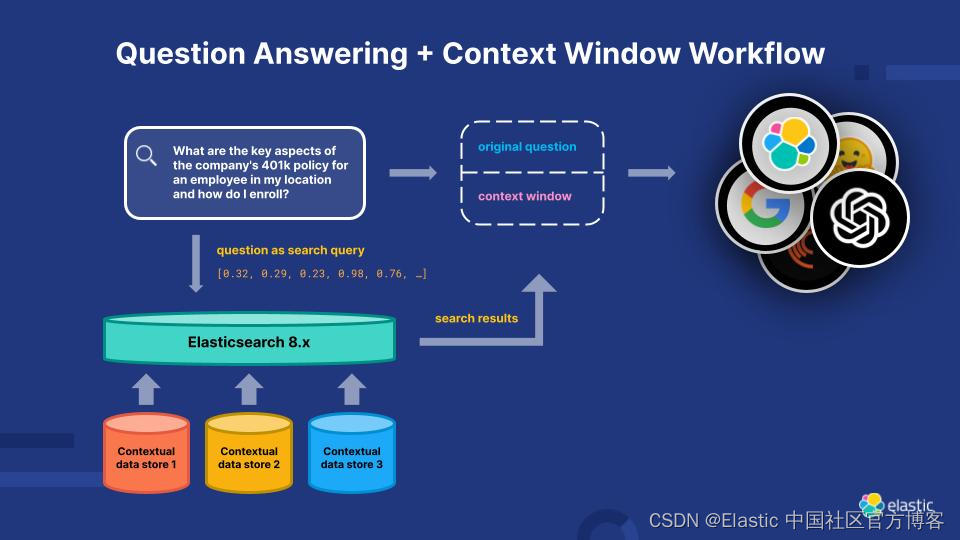

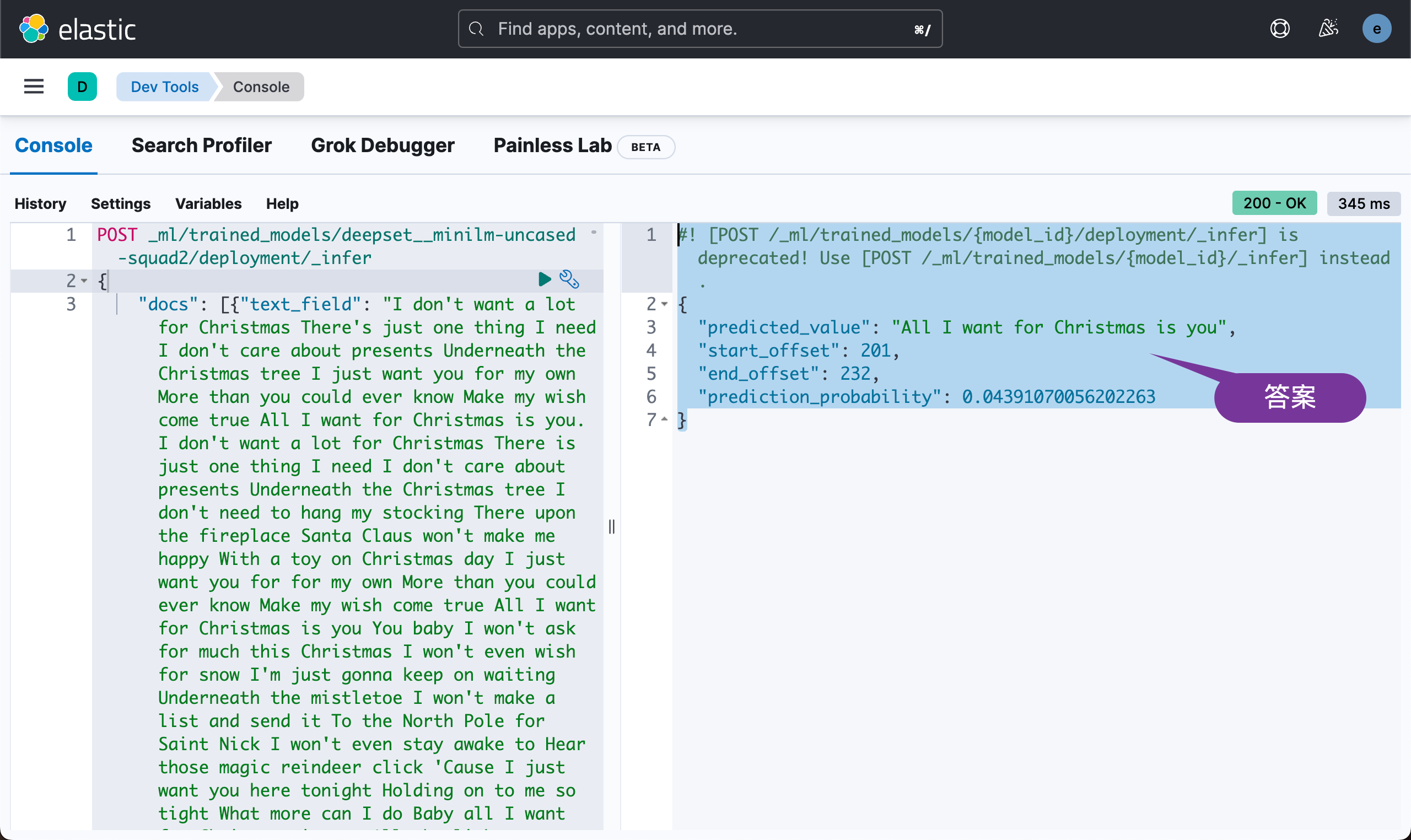

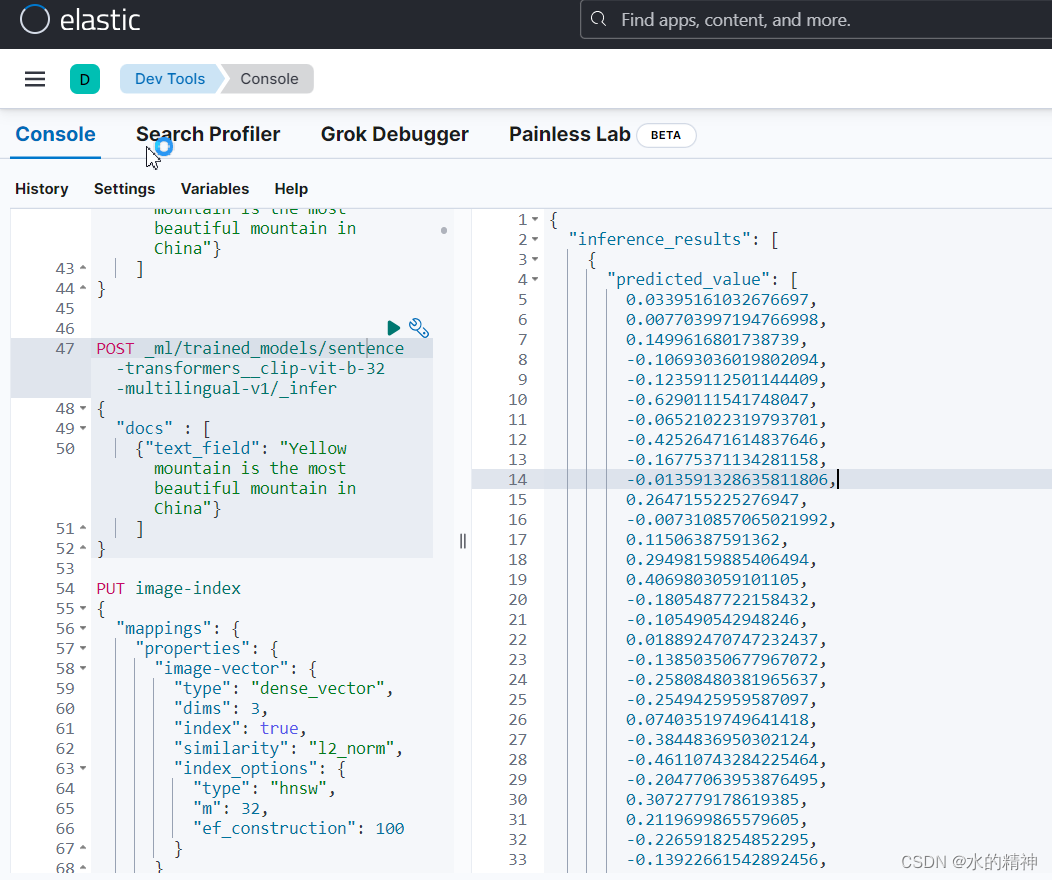

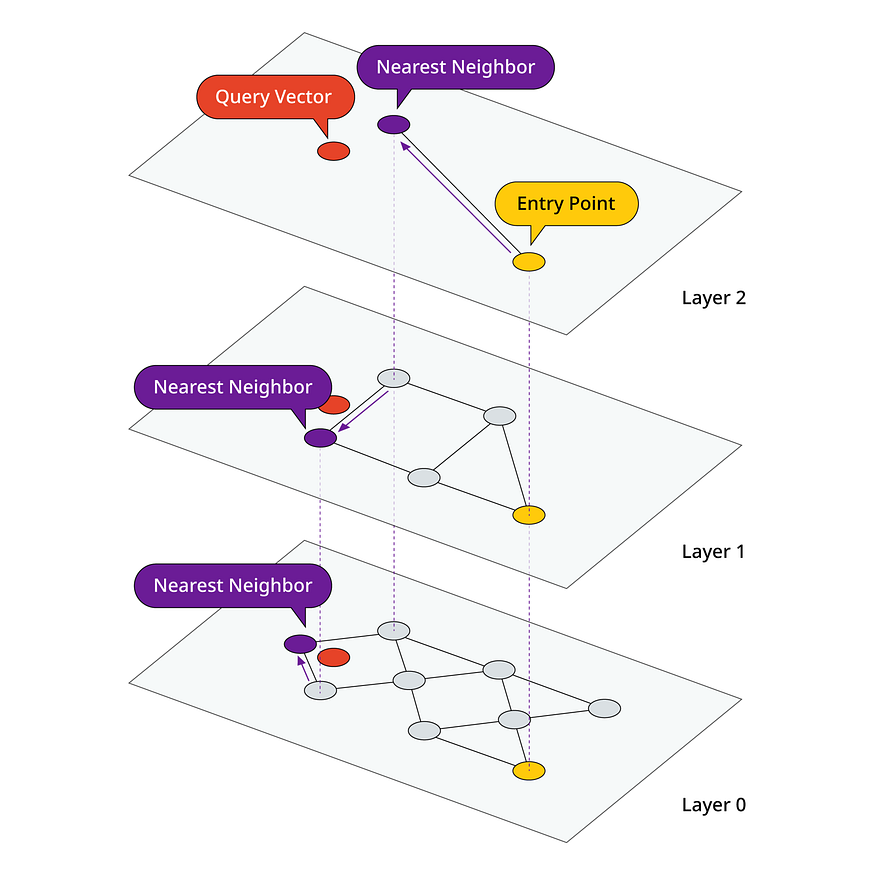

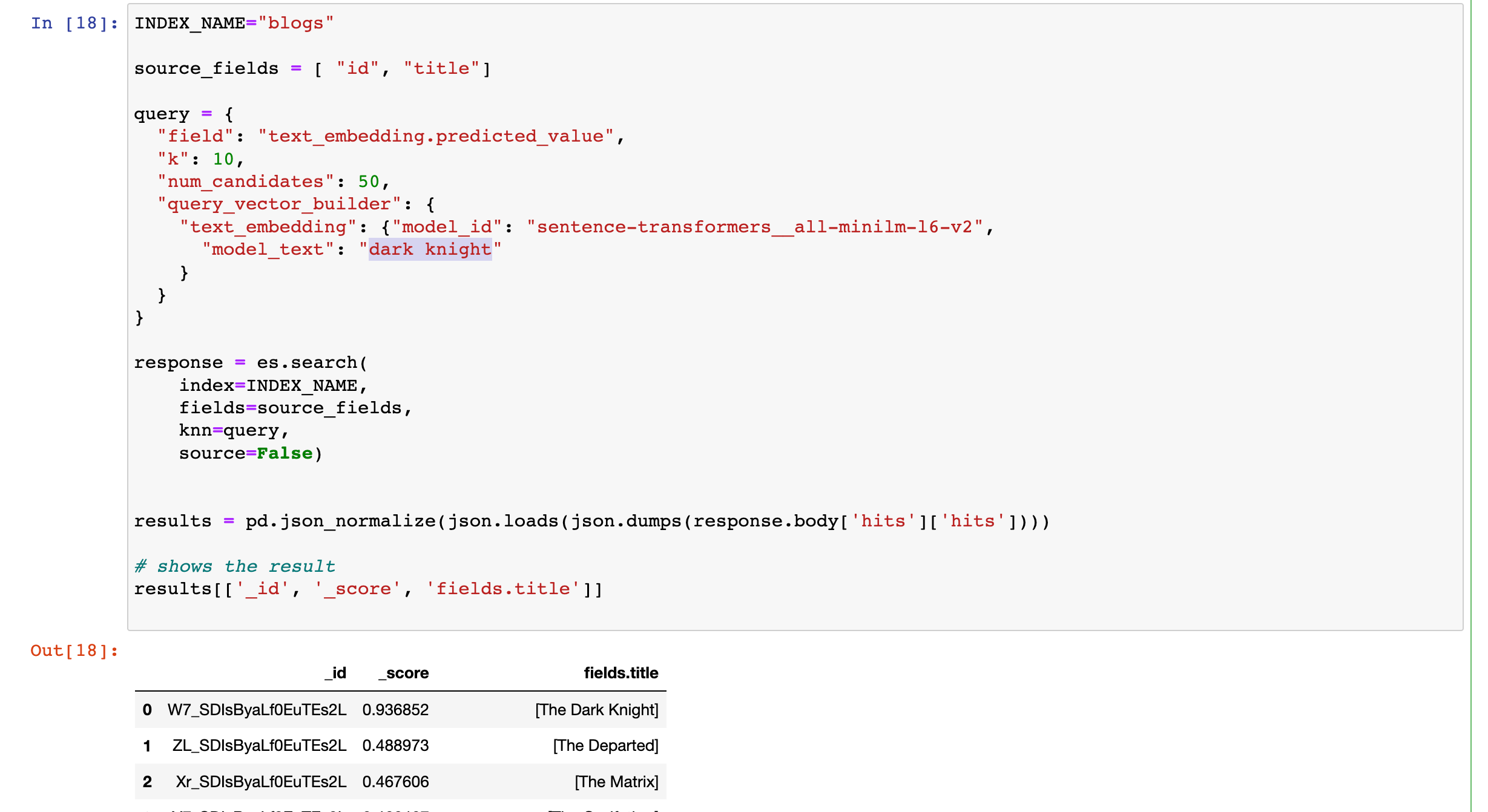

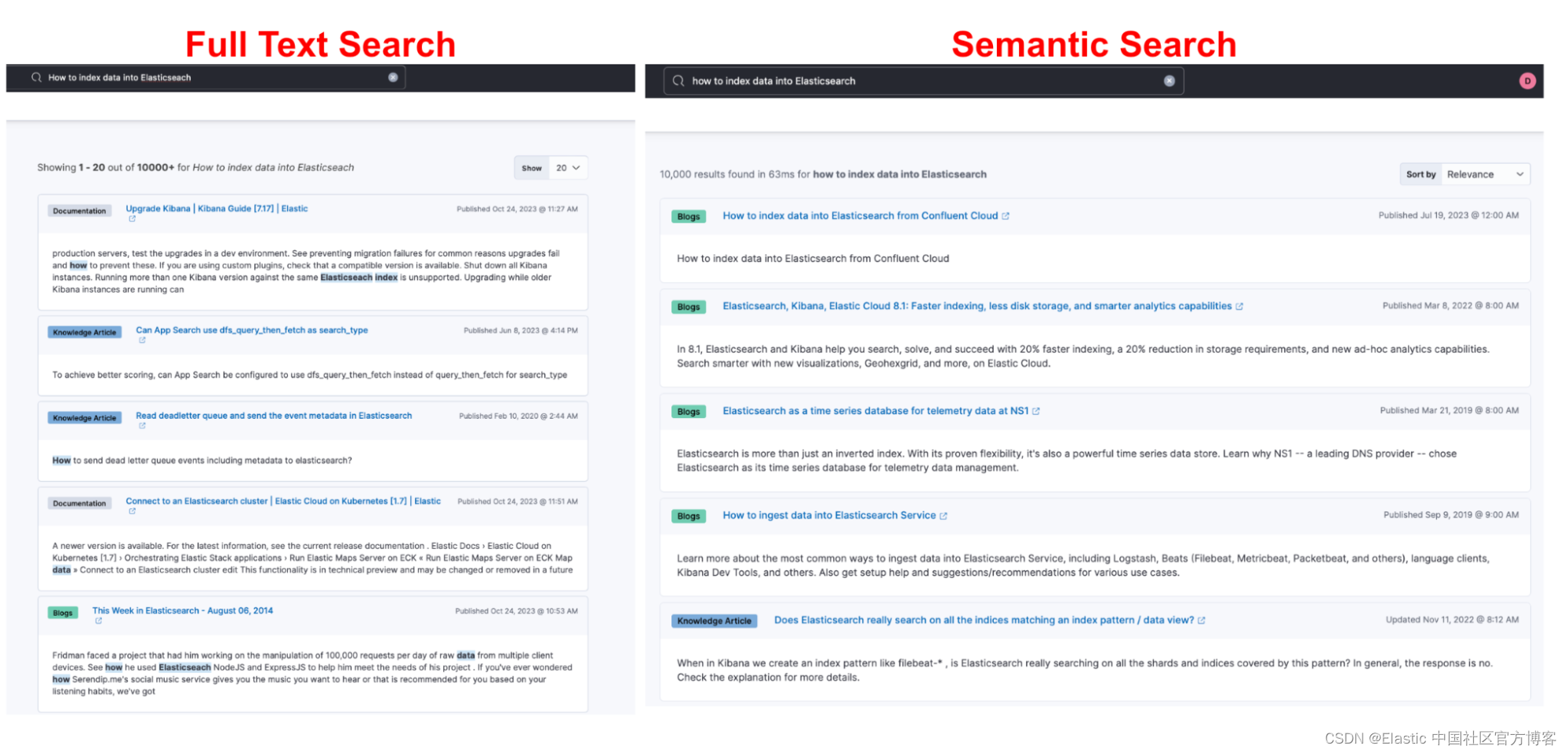

Elasticsearch:在 Elasticsearch 中使用 NLP 和矢量搜索增强聊天机器人功能

作者:Priscilla Parodi 会话界面已经存在了一段时间,并且作为协助各种任务(例如客户服务、信息检索和任务自动化)的一种方式而变得越来越流行。 通常通过语音助手或消息应用程序访问,这些界面模拟人类对话,…

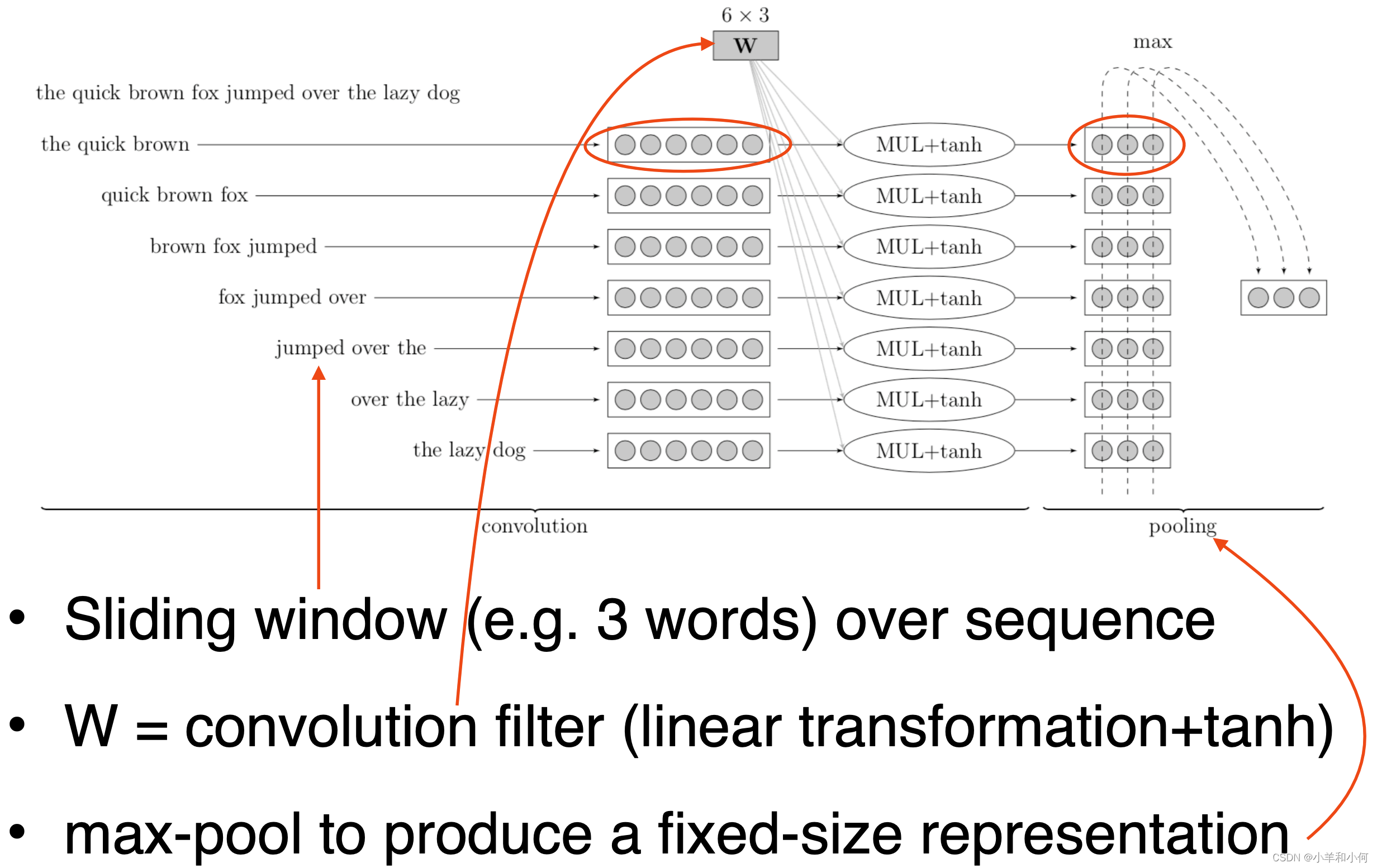

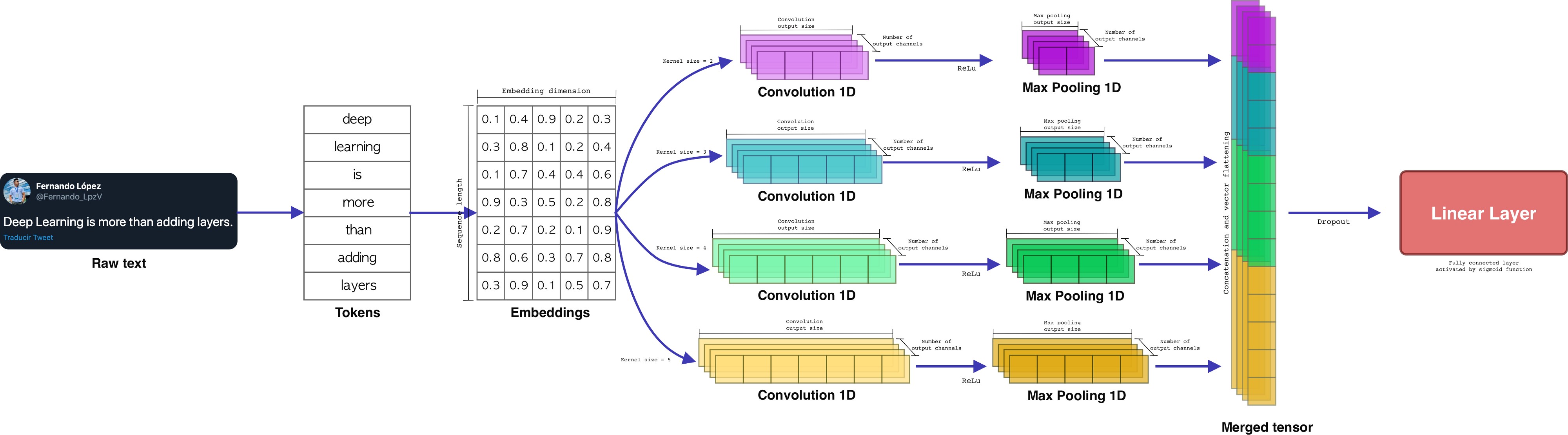

DPCNN:深度金字塔 CNN 文本分类网络

DPCNN(Deep Pyramid CNN),是2017年腾讯AI-Lab提出的一种用于文本分类的网络,可以称之为"深度金字塔卷积神经网络"。

论文:Deep Pyramid Convolutional Neural Networks for Text Categorization

在之前的博…

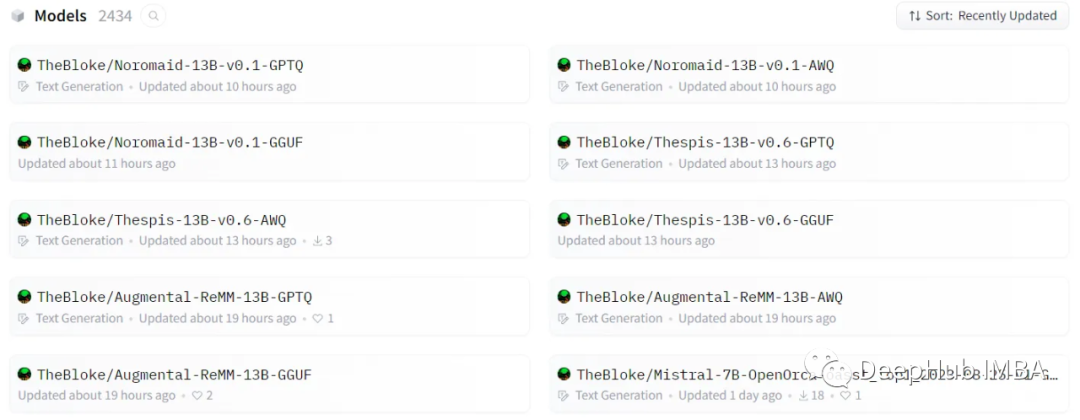

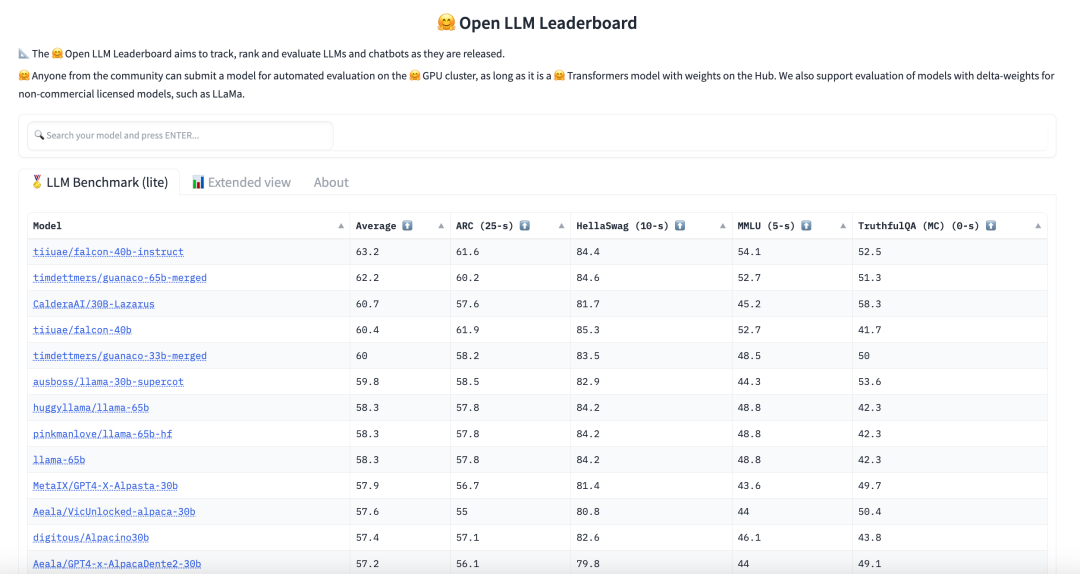

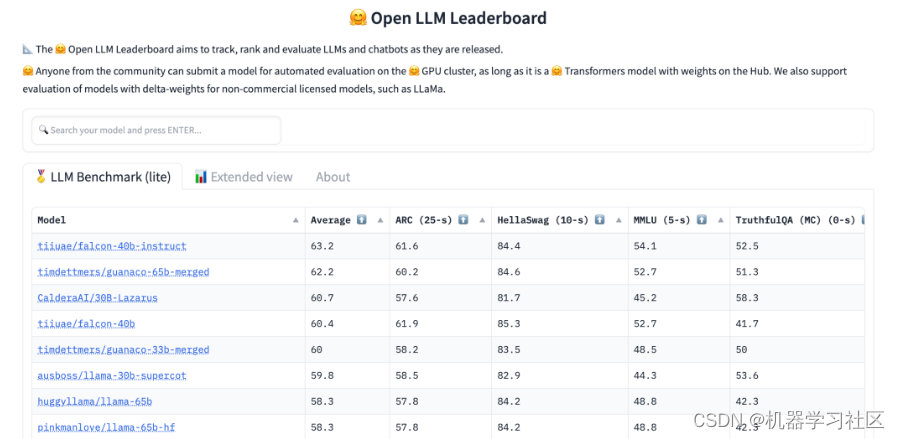

Hugging News #0602: Transformers Agents 介绍、大语言模型排行榜发布!

每一周,我们的同事都会向社区的成员们发布一些关于 Hugging Face 相关的更新,包括我们的产品和平台更新、社区活动、学习资源和内容更新、开源库和模型更新等,我们将其称之为「Hugging News」,本期 Hugging News 有哪些有趣的消息…

论文笔记 AISTATS 2020|Rep the Set: Neural Networks for Learning Set Representations

文章目录1 简介1.1 创新2 背景知识3 方法4 实验4.1 文本分类4.2 图分类4.3 运行时间分析1 简介

论文题目:Rep the Set: Neural Networks for Learning Set Representations 论文来源:AISTATS 2020 论文链接:https://arxiv.org/pdf/1904.0196…

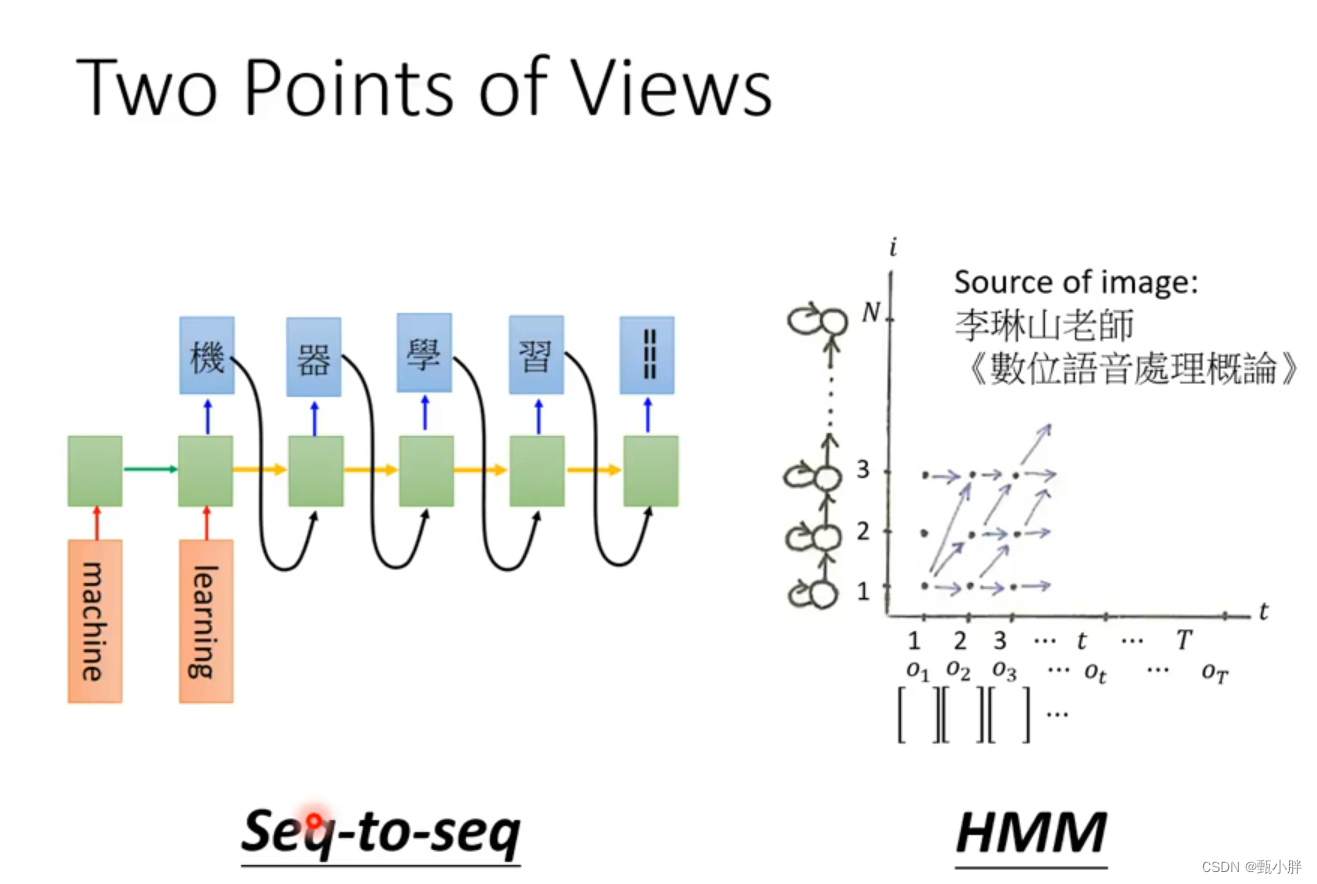

NLP基础模型和注意力机制

3.1 基础模型

欢迎来到本次课程的最后一周的内容,同时这也是五门深度学习课程的最后一门,你即将抵达本课程的终点。

你将会学习seq2seq(sequence to sequence)模型,从机器翻译到语音识别,它们都能起到很大…

论文笔记 arxiv 2019|DocBERT: BERT for Document Classification

文章目录1 简介1.1 创新2 方法3 实验1 简介

论文题目:DocBERT: BERT for Document Classification 论文来源:arxiv 2019 论文链接:https://arxiv.org/pdf/1904.08398.pdf 代码链接:https://github.com/castorini/hedwig

1.1 创新…

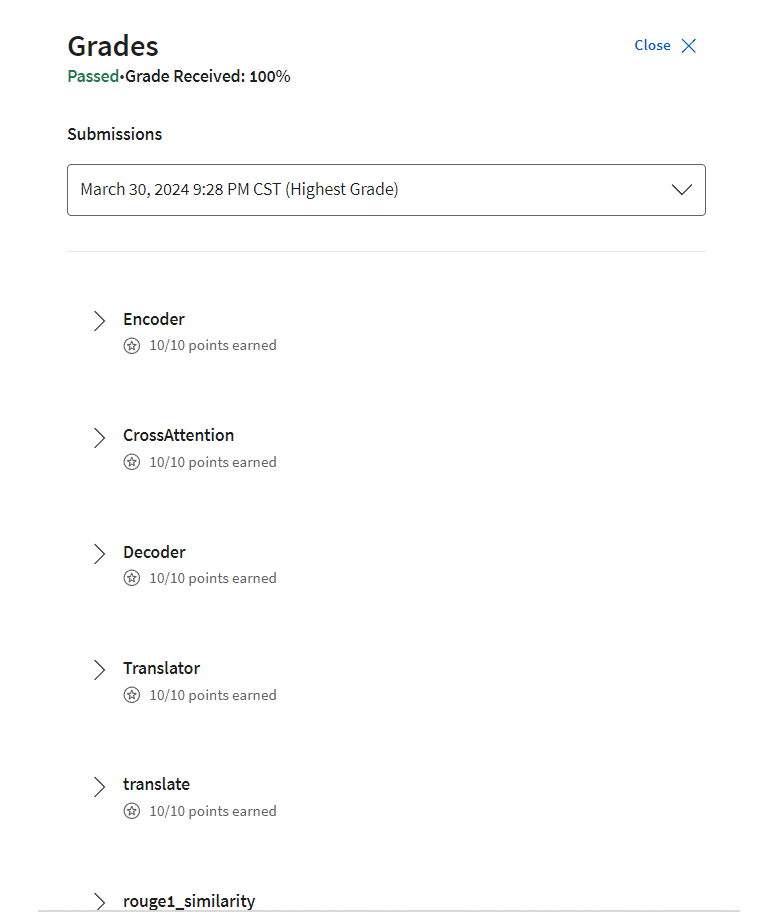

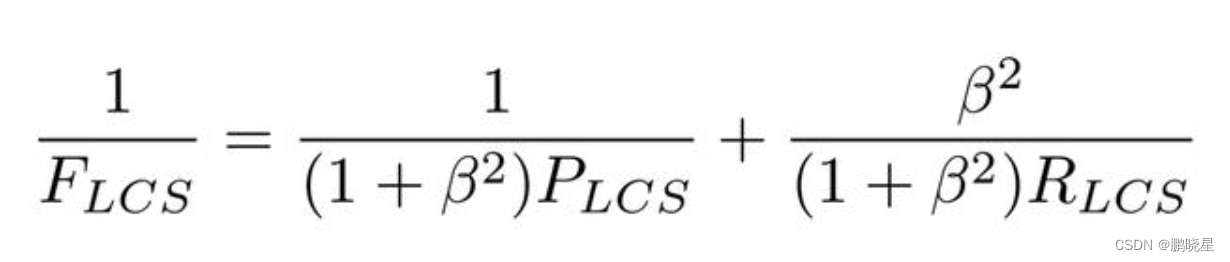

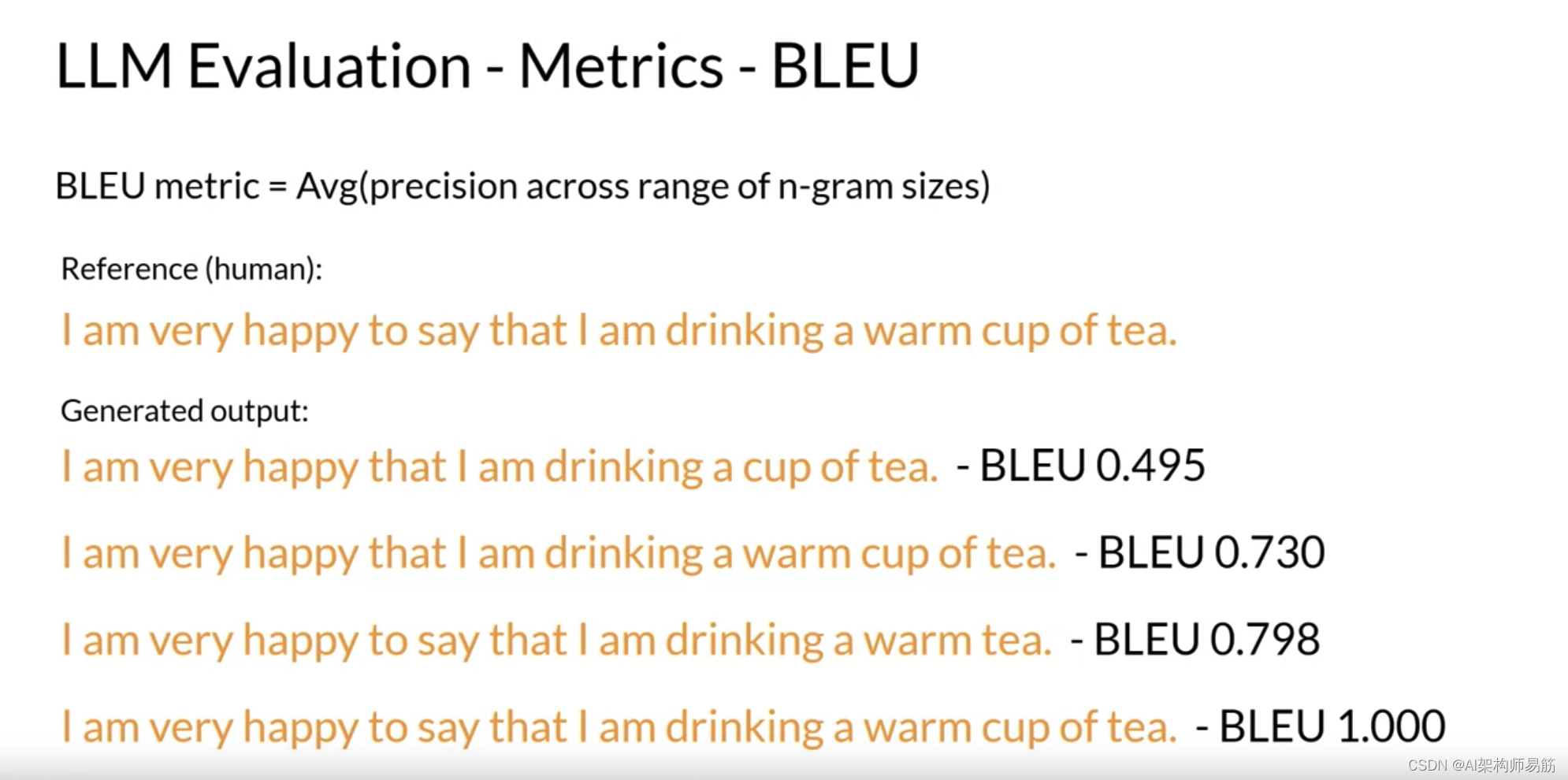

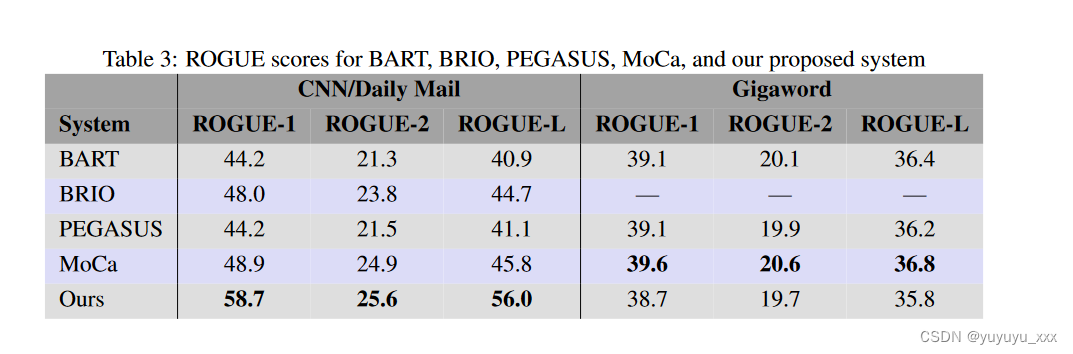

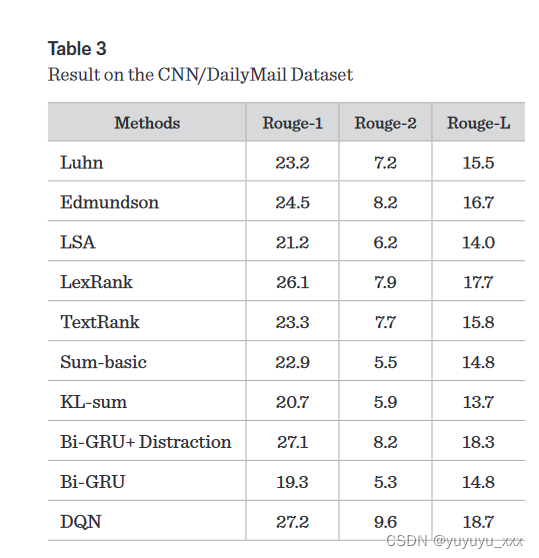

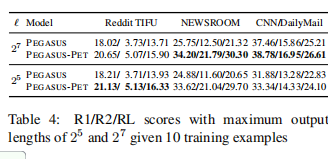

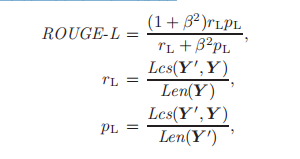

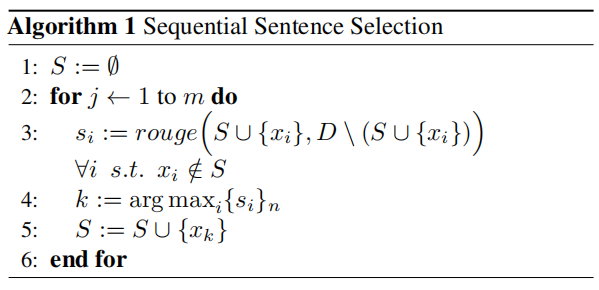

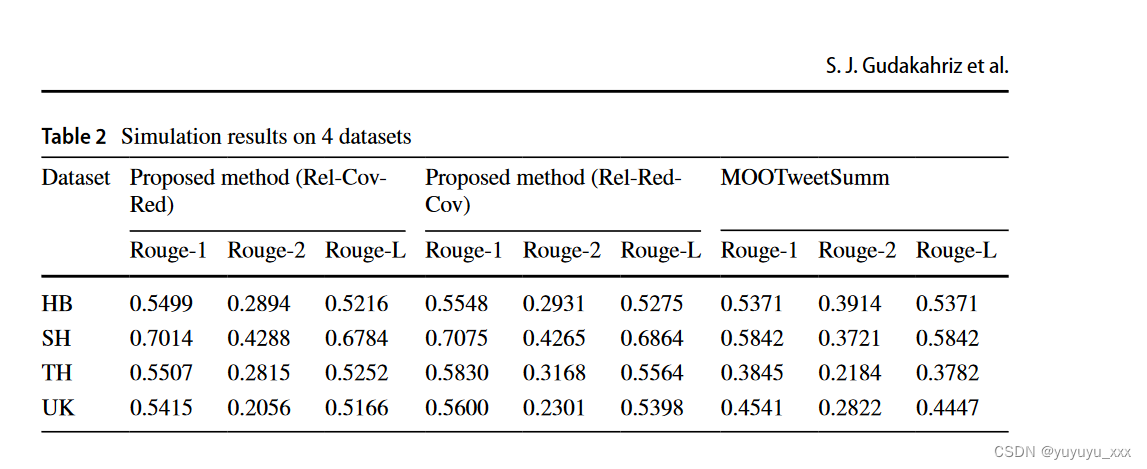

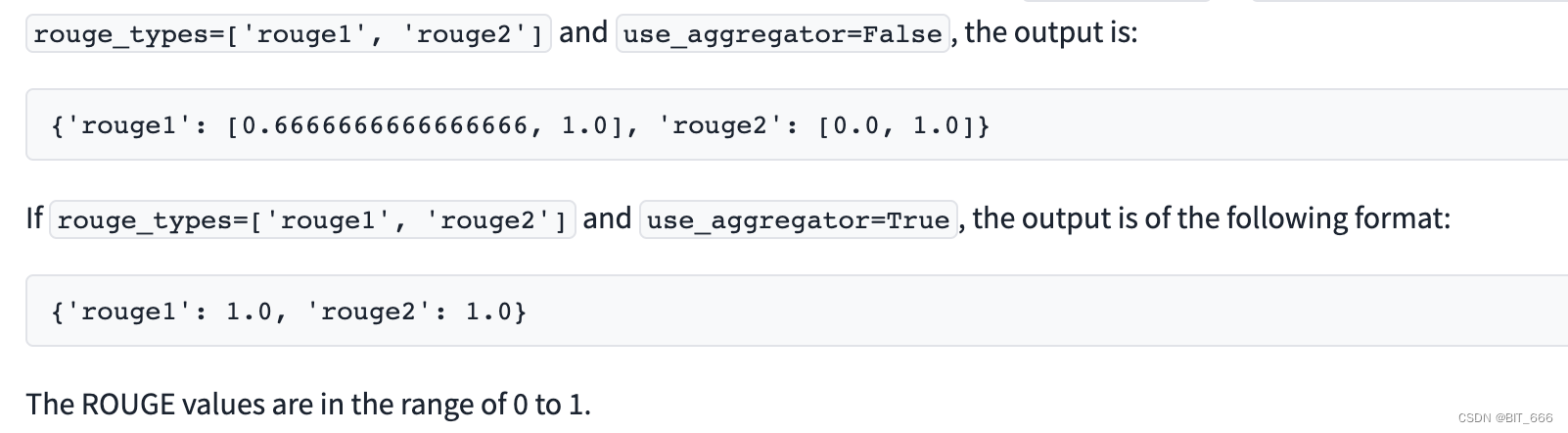

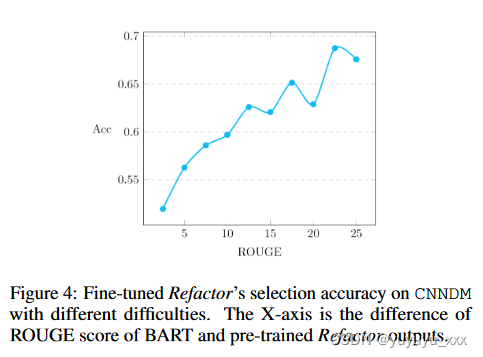

【博学谷学习记录】超强总结,用心分享丨人工智能 AI项目 ROUGE评估算法简记

目录 ROUGE核心思想评价标准ROUGE-NROUGE-L ROUGE

ROUGE的全称是Recall-Oriented Understudy for Gisting Evaluation, 是一种基于召回率指标的评价算法.

核心思想

由多个专家分别生成人工摘要, 构成标准摘要集. 将模型生成的自动摘要和人工摘要做对比, 通过统计两者之间重叠…

论文笔记 AAAI 2020|Message Passing Attention Networks for Document Understanding

文章目录1 简介1.1 创新2 背景知识3 方法3.1 提出的模型3.2 分等级的模型变体4 实验1 简介

论文题目:Message Passing Attention Networks for Document Understanding 论文来源:AAAI 2020 论文链接:https://ojs.aaai.org/index.php/AAAI/ar…

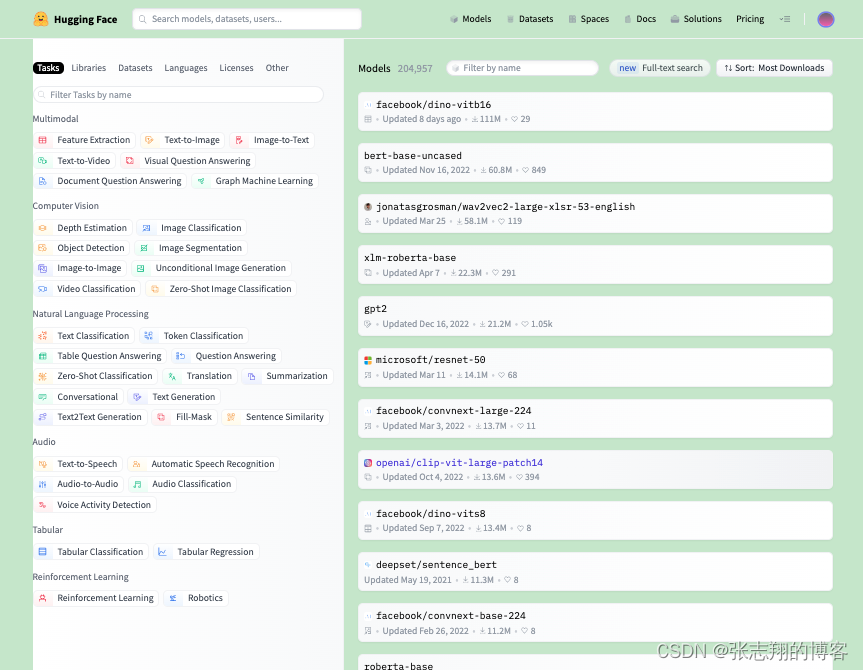

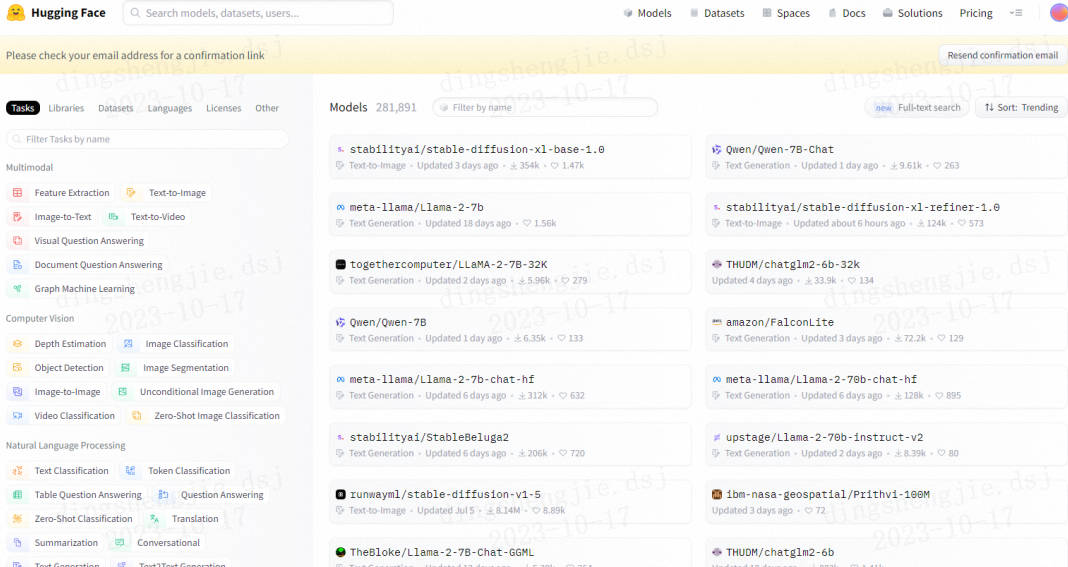

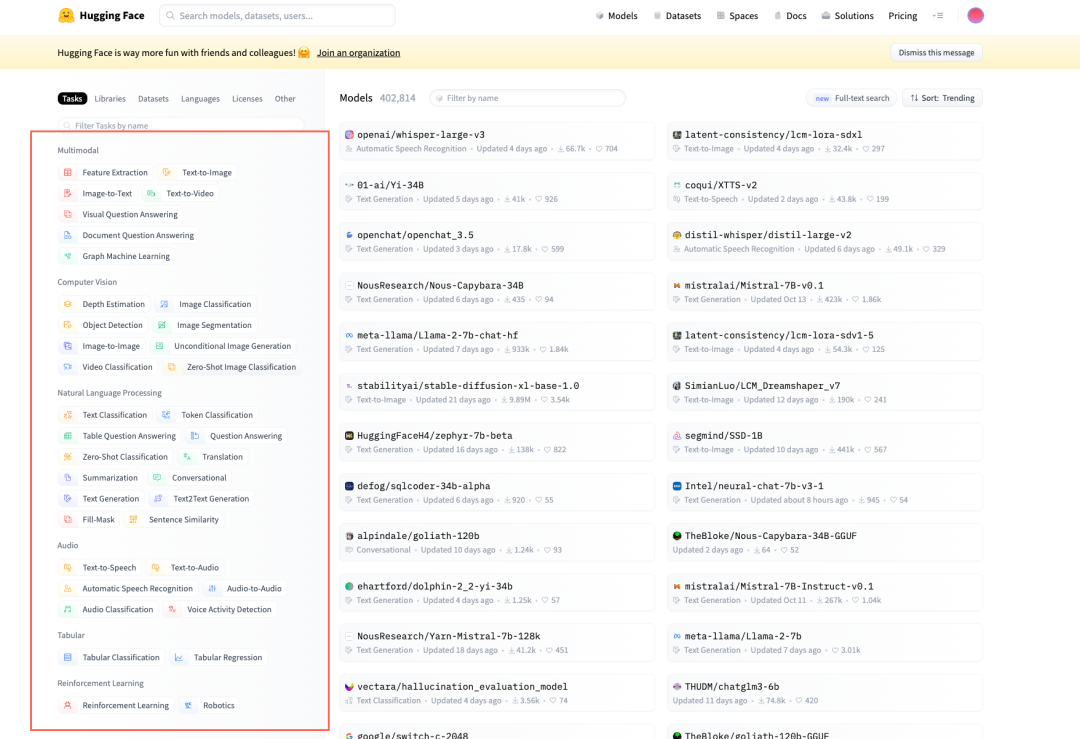

什么是HuggingFace

一.HuggingFace简介 1.HuggingFace是什么 可以理解为对于AI开发者的GitHub,提供了模型、数据集(文本|图像|音频|视频)、类库(比如transformers|peft|accelerate)、教程等。 2.为什么需要HuggingFace 主要是HuggingFace…

论文笔记 ACL 2021|Document-level Event Extraction via Heterogeneous Graph-based Interaction Model with a

文章目录1 简介1.1 动机1.2 创新2 方法3 实验1 简介

论文题目:Document-level Event Extraction via Heterogeneous Graph-based Interaction Model with a Tracker 论文来源:ACL 2021 论文链接:https://arxiv.org/pdf/2105.14924.pdf 代码链…

论文笔记 EMNLP 2020|Event Extraction as Multi-turn Question Answering

文章目录1 简介1.1 动机1.2 创新2 背景知识3 方法4 实验5 总结1 简介

论文题目:Event Extraction as Multi-turn Question Answering 论文来源:EMNLP 2020 Findings 论文链接:https://aclanthology.org/2020.findings-emnlp.73.pdf

1.1 动机…

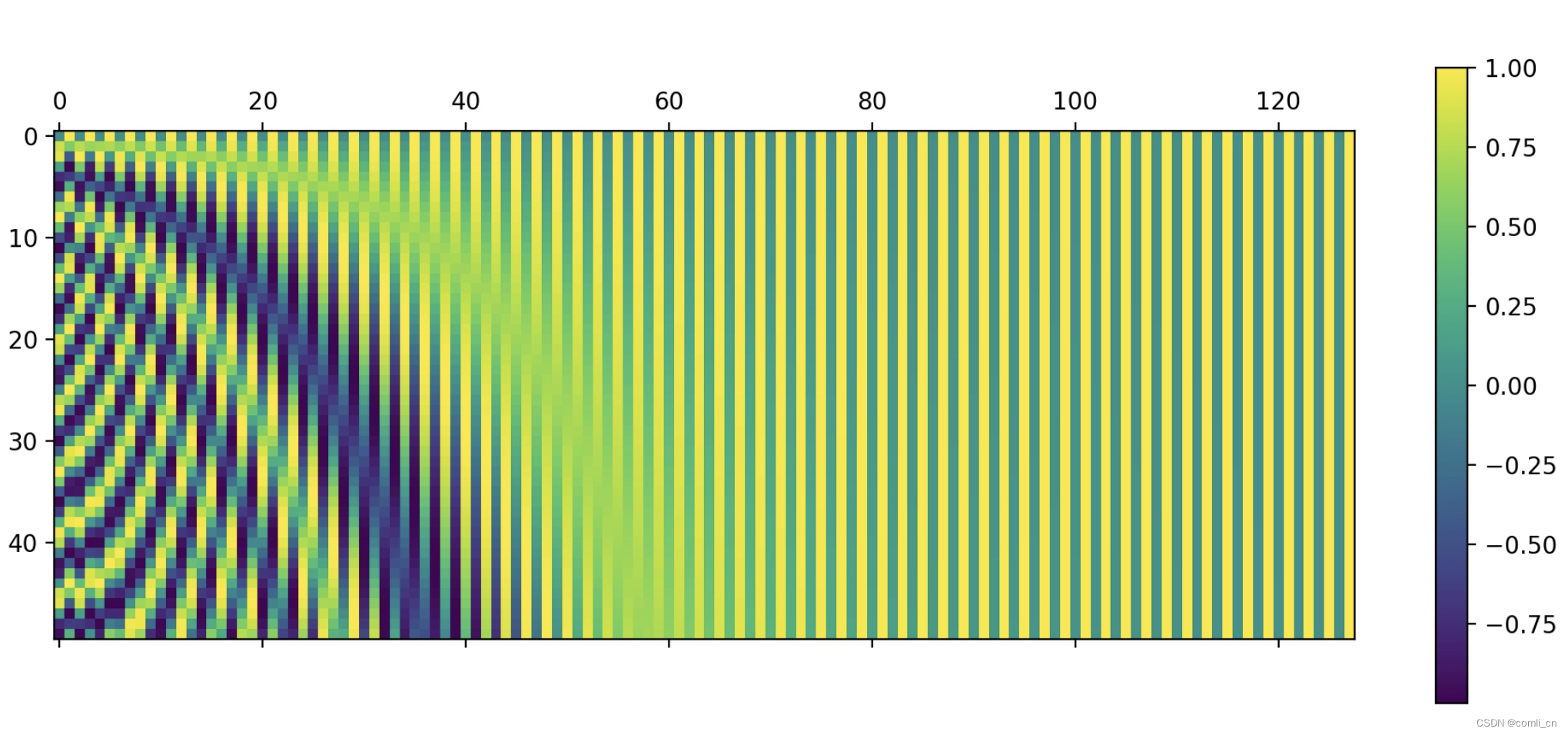

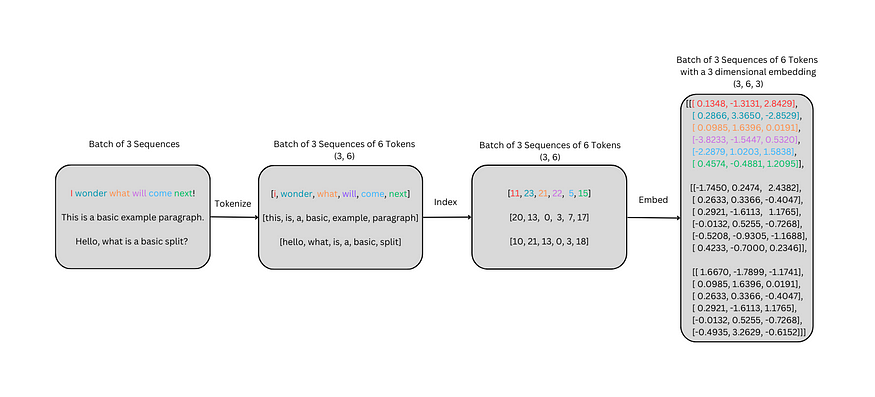

【Transformer】Transformer如何在深度学习和NLP中学习的:How Transformers work in deep learning and NLP

【学习资源】How Transformers work in deep learning and NLP: an intuitive introduction 目录

1 Representing the input sentence 输入句子的表示

1.1 Sets and Tokenization 集和标记

1.2 Word Embeddings 单词嵌入

1.3 Positional encodeings

2 Fundamental conce…

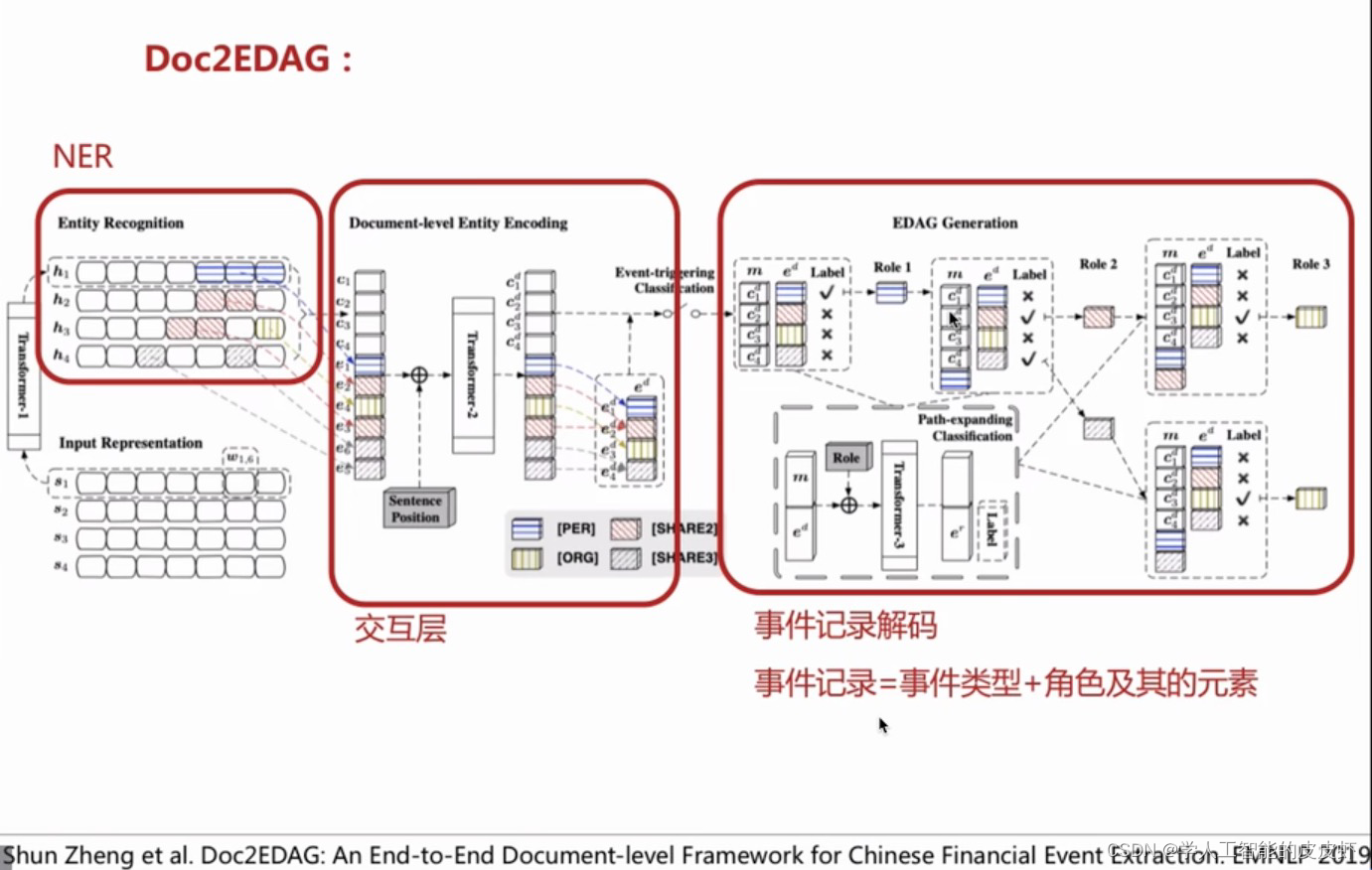

论文笔记 ACL 2018|DCFEE: A Document-level Chinese Financial Event Extraction System based on Automatical

文章目录1 简介1.1 创新2 方法2.1 数据生成2.2 事件抽取3 实验1 简介

论文题目:DCFEE: A Document-level Chinese Financial Event Extraction System based on Automatically Labeled Training Data 论文来源:ACL 2018 论文链接:https://ac…

论文笔记 ACL 2020|A Two-Step Approach for Implicit Event Argument Detection

文章目录1 简介1.1 动机1.2 创新2 方法3 实验1 简介

论文题目:A Two-Step Approach for Implicit Event Argument Detection 论文来源:ACL 2020 论文链接:https://aclanthology.org/2020.acl-main.667.pdf 代码链接:https://gith…

论文笔记 ACL 2021|TEXT2EVENT: Controllable Sequence-to-Structure Generation for End-to-end Event Extract

文章目录1 简介1.1 动机1.2 创新2 方法2.1 事件抽取转换为结构生成2.2 Sequence-to-Structure结构:2.3 模型学习3 实验1 简介

论文题目:TEXT2EVENT: Controllable Sequence-to-Structure Generation for End-to-end Event Extraction 论文来源ÿ…

Live800:在线客服系统解决客服效率难题,让服务效率升级

互联网时代的到来给客服赋予了更多的职能,从简单的客户服务升级为集营销、市场、服务等多种角色,这种职能上的转变让客服部门由原来的附属部门变成核心部门,直接影响企业效益,提升客服工作效率刻不容缓。

俗话说"工欲善其事…

Live800:用它,在线客服提升效率的秘密!

"在线下世界,如果一个客户不满意,他会告诉6个朋友。在互联网世界,他会告诉6000个人。" 亚马逊的创始人杰夫贝佐斯提到。随着互联网时代的蓬勃发展,消费者之间的关系互联正击穿以前人与人之间的圈层链——消费者的声音被…

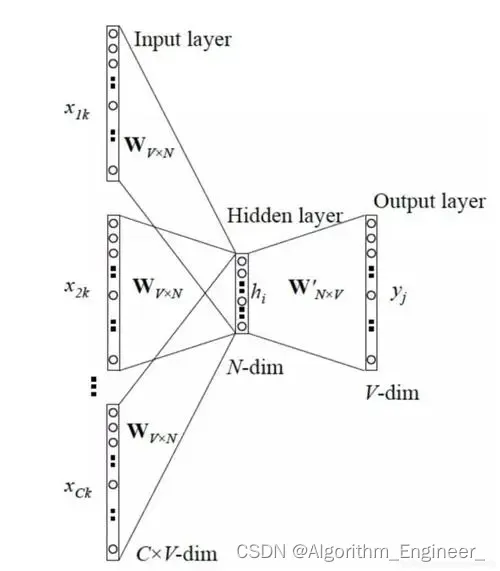

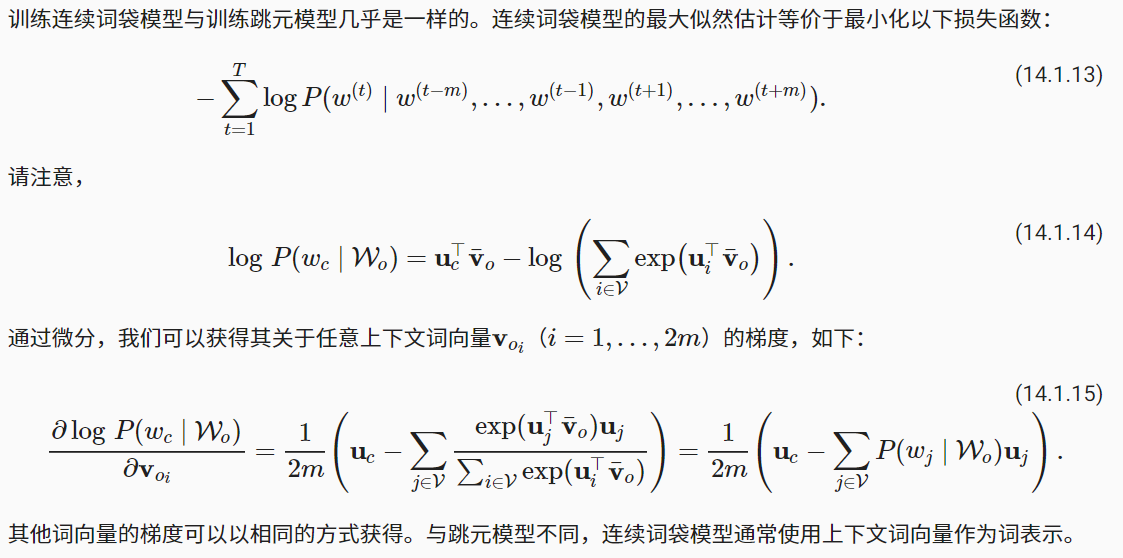

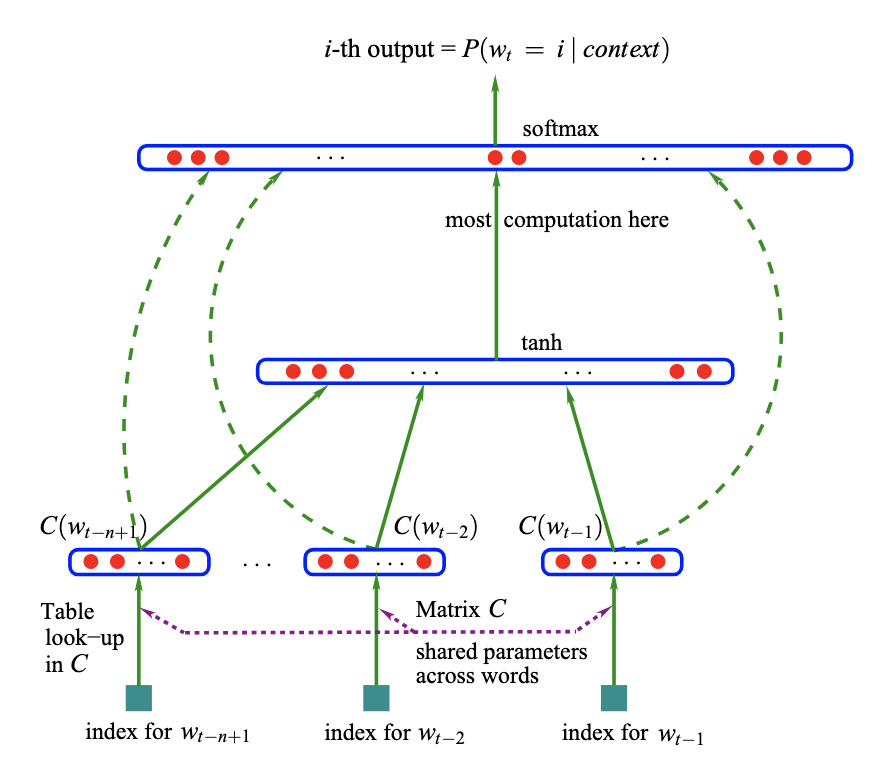

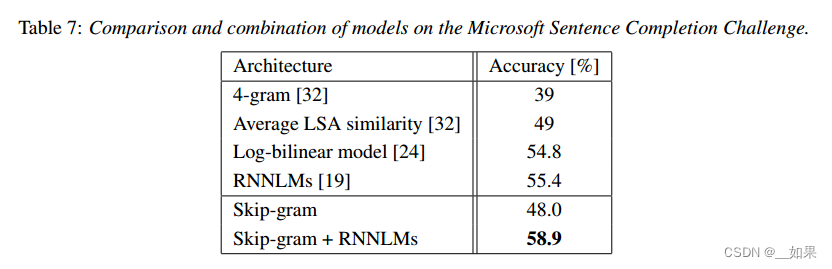

论文系列1:《Efficient Estimation of Word Representations in Vector Space》

《Efficient Estimation of Word Representations in Vector Space》

基于向量空间中词表示的有效估计

作者:Tomas Mikolov 单位:Google

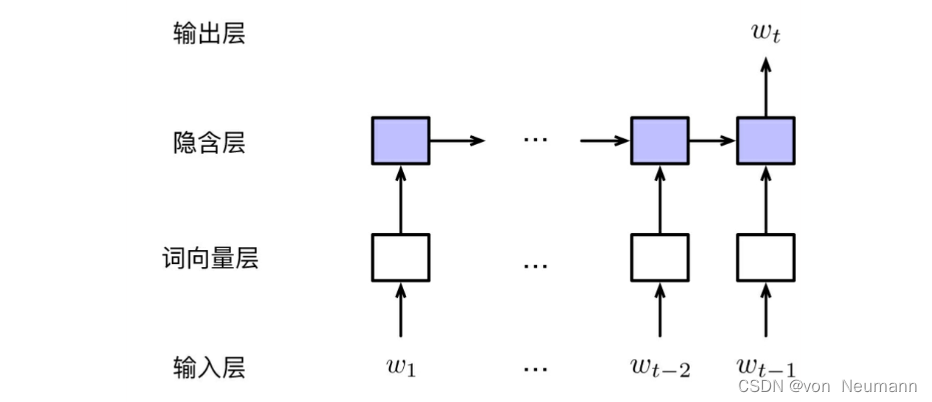

语言模型

计算一个句子是句子概率 有一些词或者词组在语料中没有出现过,但是这不能代表它不可能存…

人工智能取代人类成为战争主体的时代真的来临了吗

自从阿尔法狗大战各路围棋九段高手后,人工智能同人类的比拼再一次被推到了风口浪尖上。前不久美国苍鹭系统公司的人工智能空战系统,与一名坐在模拟器中、戴着虚拟现实头盔的人类战斗机飞行员进行空战格斗对抗,最后以5:0的绝对优势大获全胜。这…

论文笔记 ACL 2020|Discourse as a Function of Event: Profiling Discourse Structure in News Articles aroun

文章目录1 简介1.1 创新2 方法3 实验1 简介

论文题目:Discourse as a Function of Event: Profiling Discourse Structure in News Articles around the Main Event 论文来源:ACL 2020 论文链接:https://aclanthology.org/2020.acl-main.478…

《UHop: An Unrestricted-Hop Relation Extraction Framework for Knowledge-Based Question Answering》论文笔记

UHop: An Unrestricted-Hop Relation Extraction Framework for Knowledge-Based Question Answering

2019年NAACL上的一篇文章,主题为KBQA中的关系抽取。

Overview

这篇文章提出的是一个新的关系抽取方法,并不是一个完整的SP-based的KBQA模型。本文依…

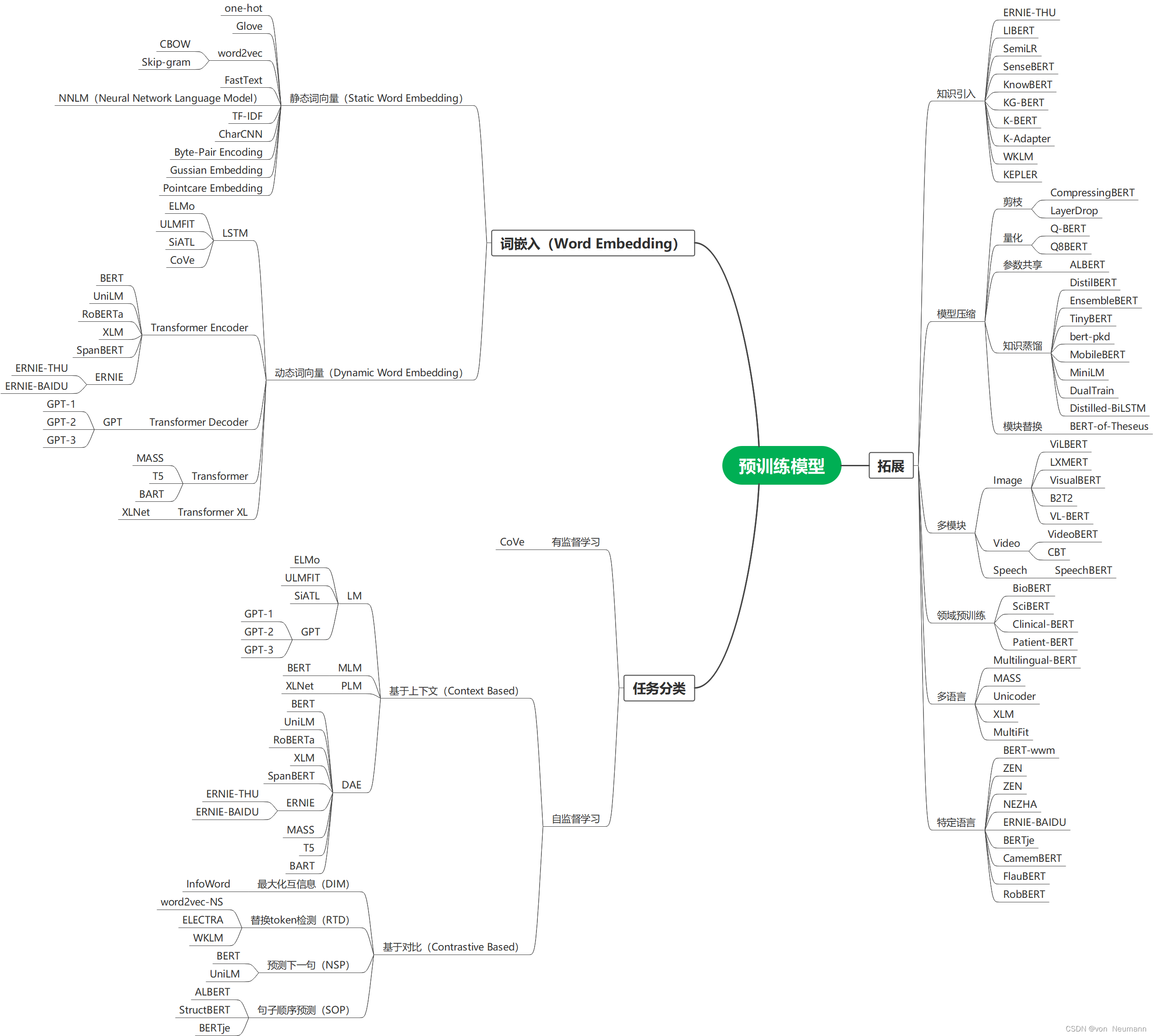

预训练综述 Pre-trained Models for Natural Language Processing: A Survey 阅读笔记

原文链接:https://arxiv.org/pdf/2003.08271.pdf 此文为邱锡鹏大佬发布在arXiv上的预训练综述,主要写了预训练模型(PTM)的历史,任务分类,PTM的扩展,将PTM转换到下游任务的方式,PTM的…

《Knowledge Base Question Answering via Encoding of Complex Query Graphs》论文笔记

Knowledge Base Question Answering via Encoding of Complex Query Graphs

这篇文章是上交和阿里于2018年发表在ACL上,主题依然是与query graph相关,属于SP DL的范畴。

Overview

作者提到之前的KBQA做法处理的多是简单问题,不能很好地解…

CharCNN论文笔记

CharCNN

之前看了TextCNN,也就是基于词级别的CNN,卷积的时候是对多个词向量(window size)进行卷积。Character-level Convolutional Networks for Text Classification 这篇文章从一个新的视角来看待文本数据,那就是字…

AI驱动,化繁为简的文字创作工具 | Mixlab智能产品

wordtune-- 用AI的方式,将一段话在保留其原有语意的基础上进行重构。下面为官方提供的一个demo,用多种方法修改了同一个句子,使其在保留原有语义的基础上,实现我们想要的结果。- 原句- 重写探索重新定义句子的新方法- 非正式用轻…

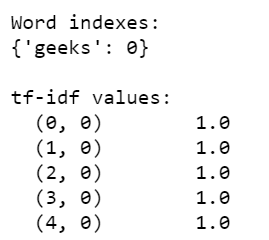

使用Gensim库对文本进行词袋、TF-IDF和n-gram方法向量化处理

Gensim库简介

机器学习算法需要使用向量化后的数据进行预测,对于文本数据来说,因为算法执行的是关于矩形的数学运算,这意味着我们必须将字符串转换为向量。从数学的角度看,向量是具有大小和方向的几何对象,不需过多地…

暴强人工智能加持的音频人声/伴奏提取工具

上学的时候喜欢唱歌,有时候会参加学校的比赛,那会网络没有现在这么发达,要到具体的伴奏网站去查找相关的歌曲,如果想与众不同演唱一些比较冷门的歌曲,恭喜你,大多数情况下,你只能选择更换它。

…

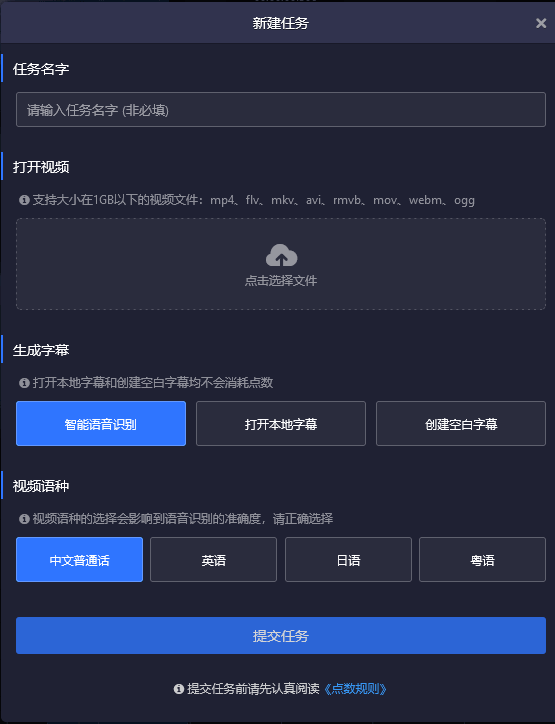

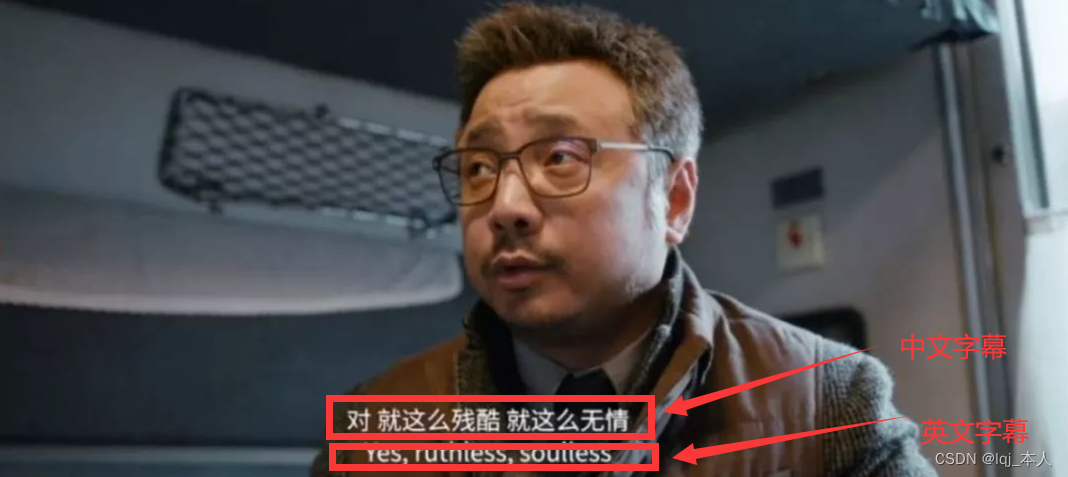

代替网易见外的智能语音识别转换字幕工具

很久以前分享过网易出品的网易见外工作台,用来方便地对视频语音进行识别并转换字幕,但是后来因为种种原因,网易见外开始对部分功能进行收费,但是现在又是个自媒体的时代,所以时代呼唤备胎。

在线字幕编辑器爱幕

爱幕…

自然语言处理从小白到大白系列(4)多角度理解条件随机场

文章目录1. 线性链CRF2. 特征函数如何理解3. CRF的三个问题——预测问题前向得分4. CRF的三个问题——概率计算5. CRF的三个问题——参数学习6. 条件随机场和隐马尔可夫模型,哪个好?众所周知,条件随机场在NLP中做NER和词性标注等任务是一把好…

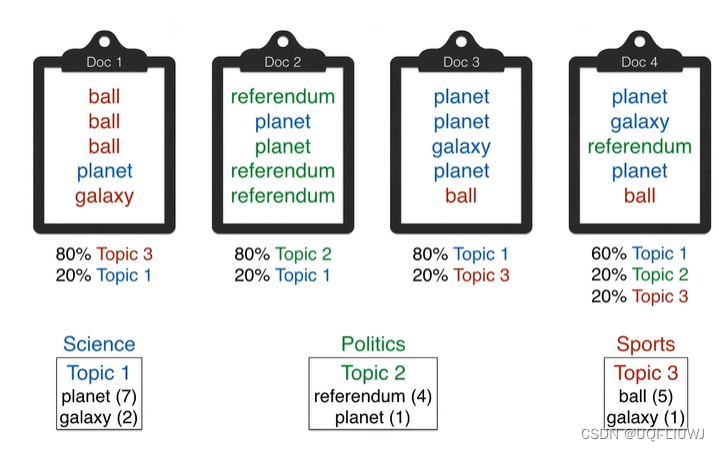

自然语言处理从小白到大白系列(1)Word Embedding之主题模型

一直想开启一个专题来整理一下NLP的相关内容,总算克服懒癌着手开始干了。如果同学有缘看到这篇,恭喜你,这是本系列(自然语言处理从小白到大白系列)的第一篇,后续会不断更新,欢迎关注!…

人工智能—— NLP语言模型 朴素贝叶斯

中文 库 分词 词性标注英文 正则

自然语言处理 分类器 ----> 可解释性高

n元 组合 —> 判定 ----> 类 关系维度 — 特征 阈值 二分类 判知边界–1/2 特征 统计概率 语言多样性 正则检索 特征 表示 预处理 标点 符号 关键词抽取 抽取 特征 统计值 贡献 …

数学之美:数学究竟是如何被运用到生活中的?

文末有这本书的思维导图不鸽大家,终于把这本书读完,来分享一下读后感。《数学之美》这本书是2012年出版,作者吴军,他的书籍还有《浪潮之巅》、《格局》等也非常有名,吴军博士在语音识别、自然语言处理,特别…

自然语言处理的bert, GPT, GPT-2, transformer, ELMo, attention机制都是些何方神圣???

2018年是NLP领域巨变的一年,这个好像我们都知道,但是究竟是哪里剧变了,哪里突破了?经常听大佬们若无其事地抛出一些高级的概念,你却插不上嘴,隐隐约约知道有这么个东西,刚要开口:噢&…

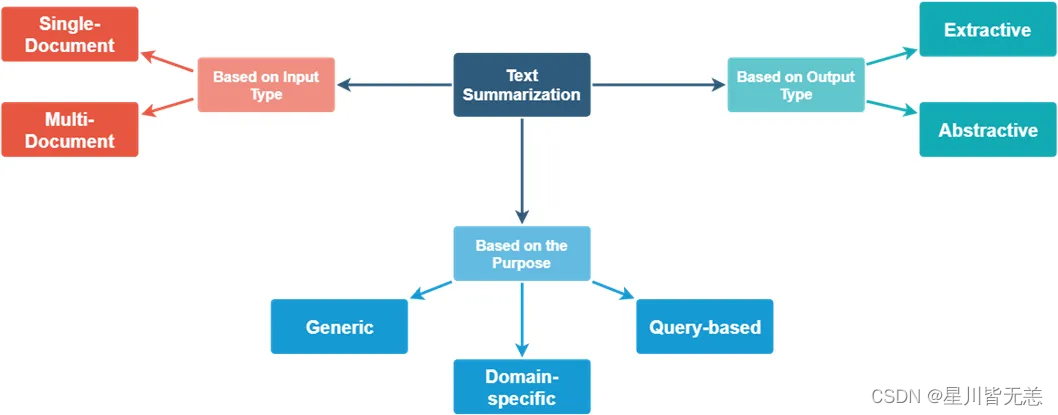

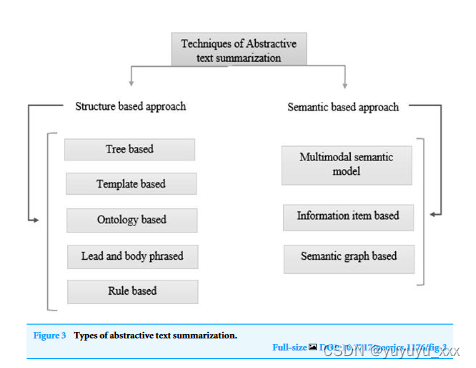

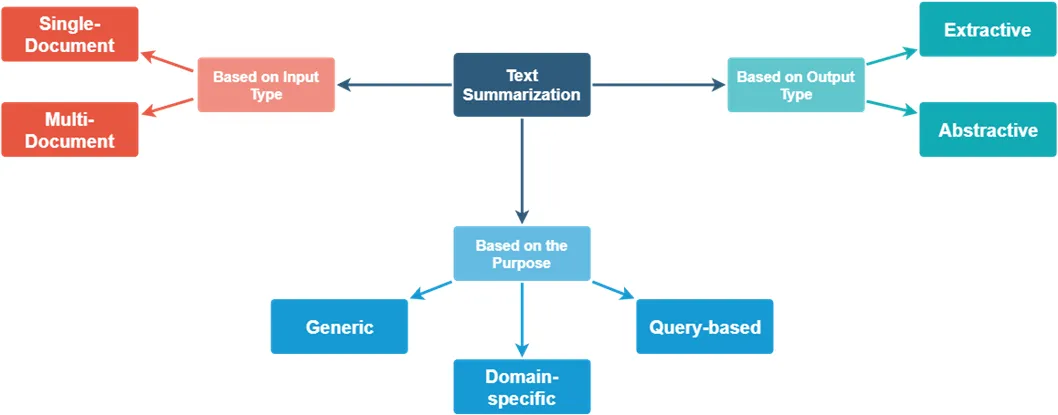

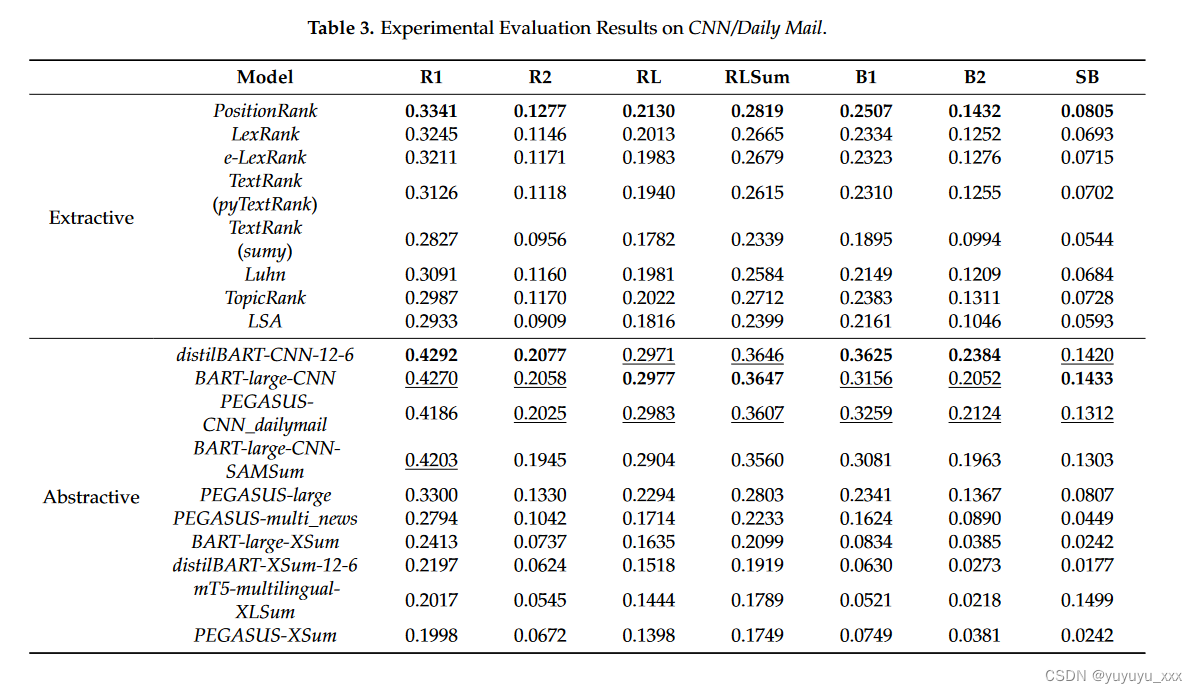

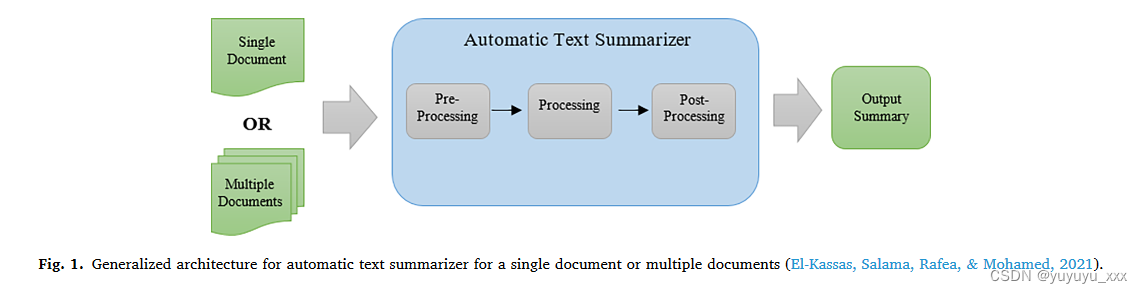

初学文本摘要——综述报告

** 本报告是本人在自学自然语言处理文本摘要方向初期研读综述性论文、博客、网站等后总结的综述报告。 **

主要内容:

1)文本摘要简介(是什么?) 2)文本摘要现状(怎么样?) 3)文本摘要分类&#…

AI日报:DragGAN通过拖拽像素点实现图像调整 等

🦉 AI新闻

🚀 DragGAN:一种直观的图像编辑工具,通过拖拽像素点实现图像调整

摘要:研究者们来自马克斯・普朗克计算机科学研究所、MIT CSAIL和谷歌,他们开发了一种名为DragGAN的图像编辑工具。通过拖拽像素…

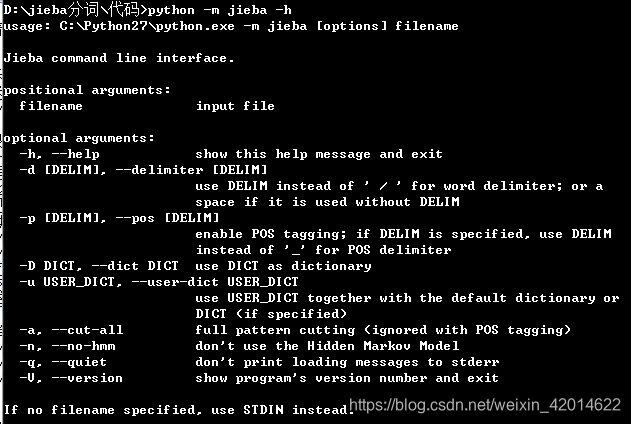

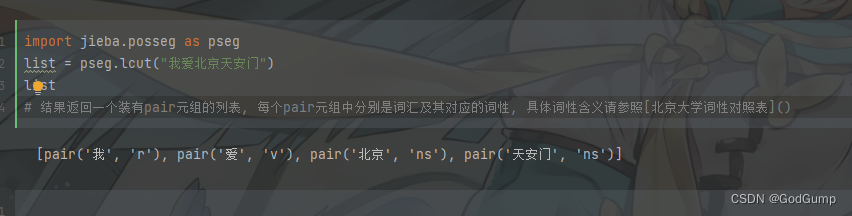

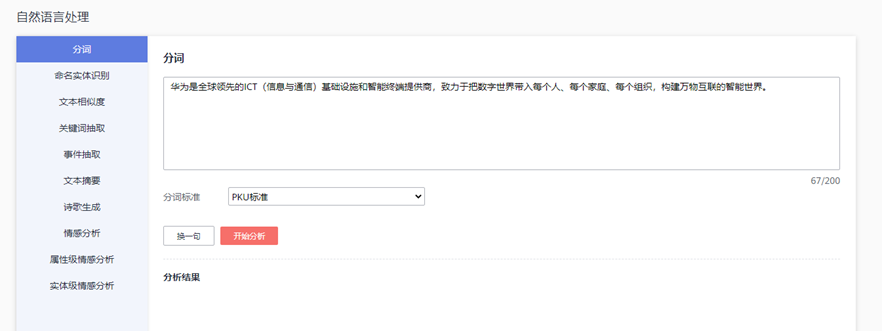

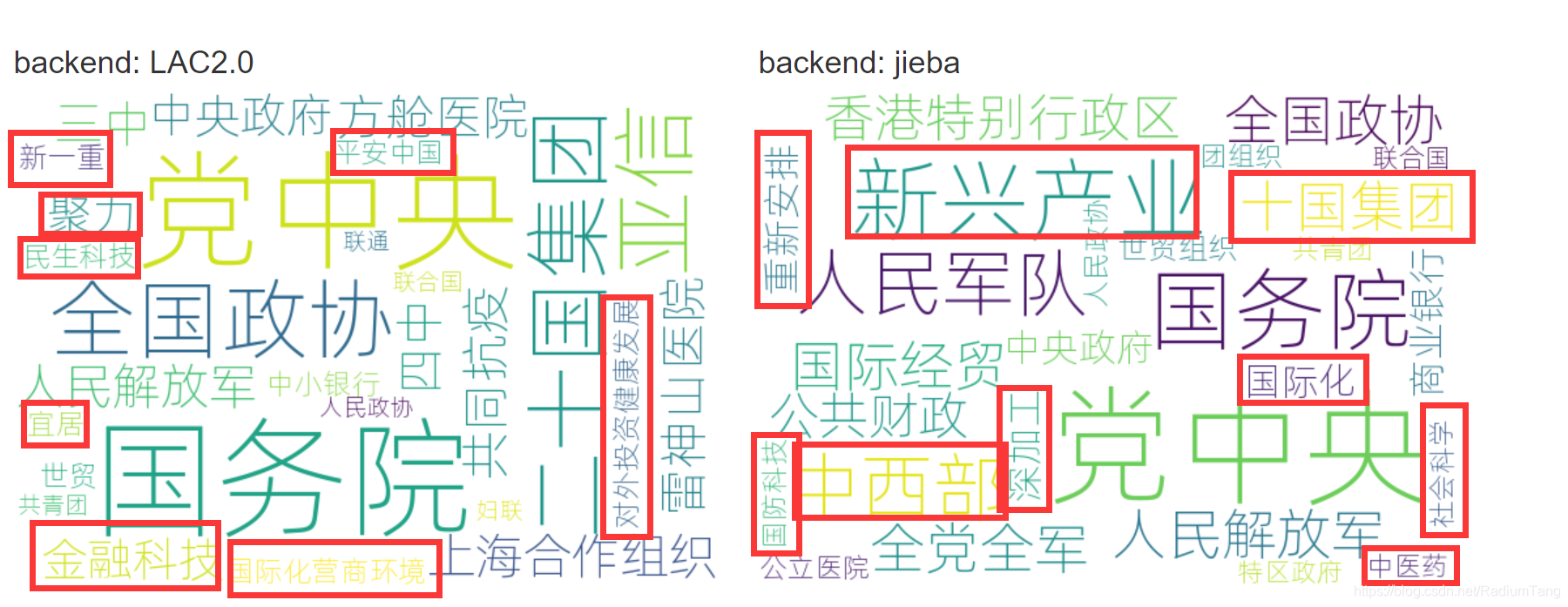

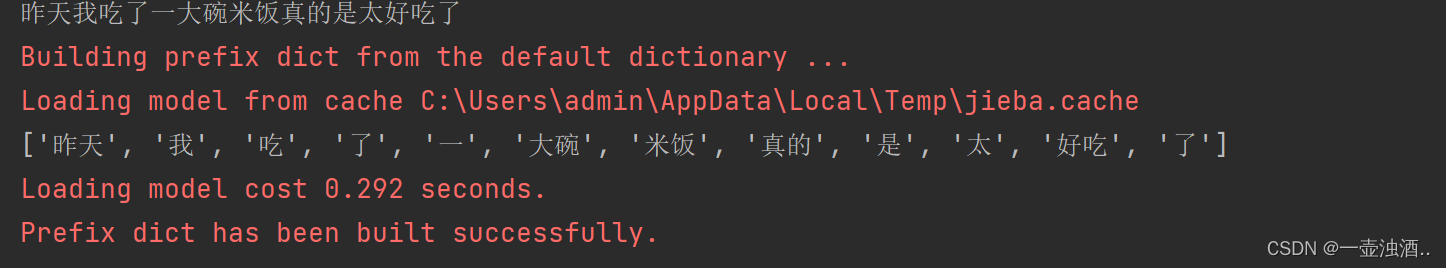

pkuseg,LTP,jieba分词实践

pkuseg

pkuseg具有如下几个特点: 多领域分词。不同于以往的通用中文分词工具,此工具包同时致力于为不同领域的数据提供个性化的预训练模型。根据待分词文本的领域特点,用户可以自由地选择不同的模型。 我们目前支持了新闻领域,网…

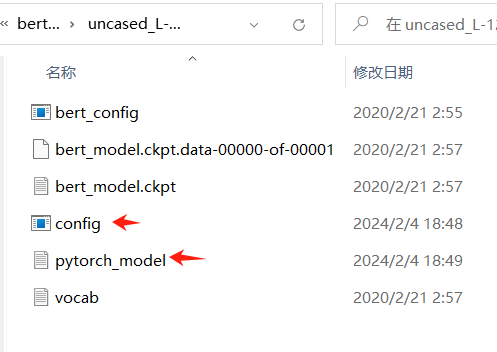

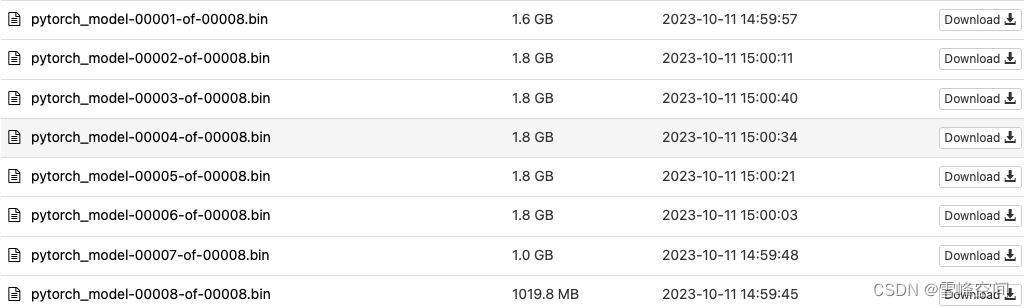

Bert预训练模型的使用

1.下载预训练模型

pytorch_bin文件:

‘bert-base-uncased’: “https://s3.amazonaws.com/models.huggingface.co/bert/bert-base-uncased.tar.gz”, ‘bert-large-uncased’: “https://s3.amazonaws.com/models.huggingface.co/bert/bert-large-uncased.tar.gz”, ‘bert-b…

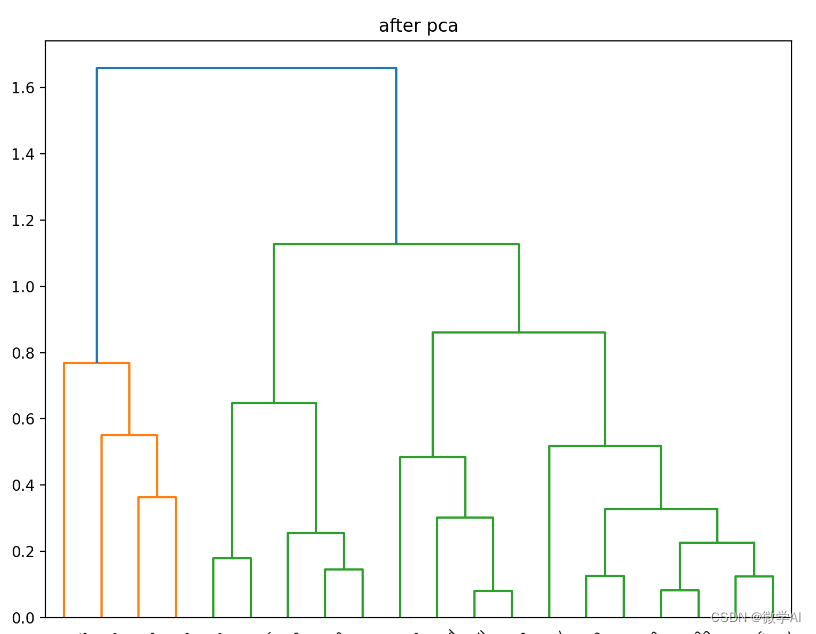

PCA中降维的使用方法

PCA中降维的使用方法: 转载至:https://www.cnblogs.com/roygood/articles/10404472.html 函数原型及参数说明 这里只挑几个比较重要的参数进行说明。 sklearn.decomposition.PCA(n_componentsNone, copyTrue, whitenFalse) n_components: int, float, No…

NLP笔记:ac自动机实现

ac自动机实现 1. ac自动机简介2. ac自动机原理3. ac自动机实现 1. ac自动机的构建2. ac自动机的调用 4. 参考链接 1. ac自动机简介

ac自动机算法全称Aho–Corasick算法,它是一种经典的高效字符串匹配算法,他所针对的核心问题为: 如何从一个…

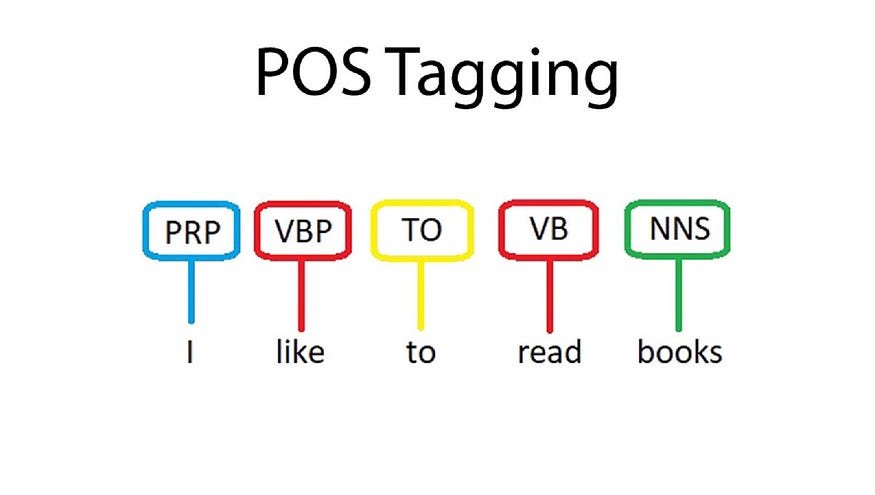

实现spaCy训练词性标注模型

词性标注是指为输入文本中的单词标注对应词性的过程。词性标注的主要作用在于预测接下来一个词的词性,并为句法分析、信息抽取等工作打下基础。通常地,实现词性标注的算法有HMM(隐马尔科夫)和深度学习(RNN、LSTM等&…

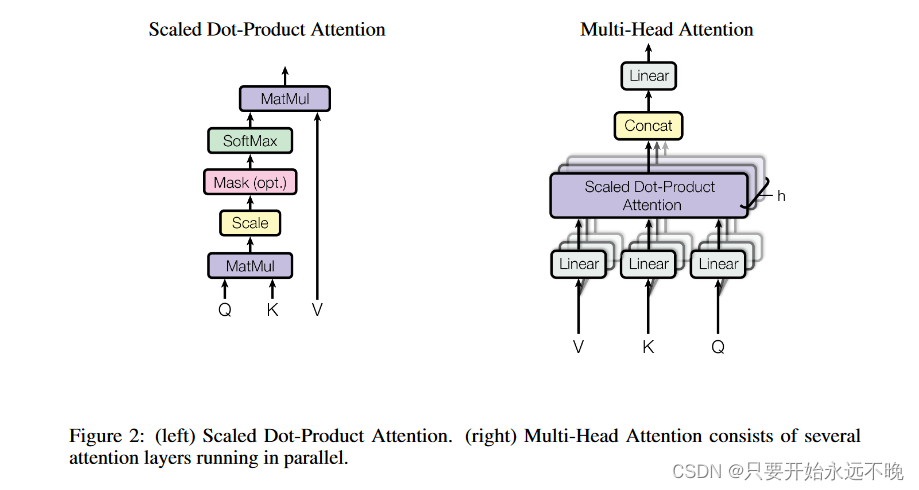

Attention Is All You Need 论文理解

Attention Is All You Need

一、介绍 主流的Seq-Seq的模型通常采用RNN或者是CNN,但是这种网络结构也存在一些问题:RNN的递归依赖使得其难以并行化,缺乏对全局信息的理解, 尤其是长距离和层级化的依赖关系难以建立。 论文提出了一…

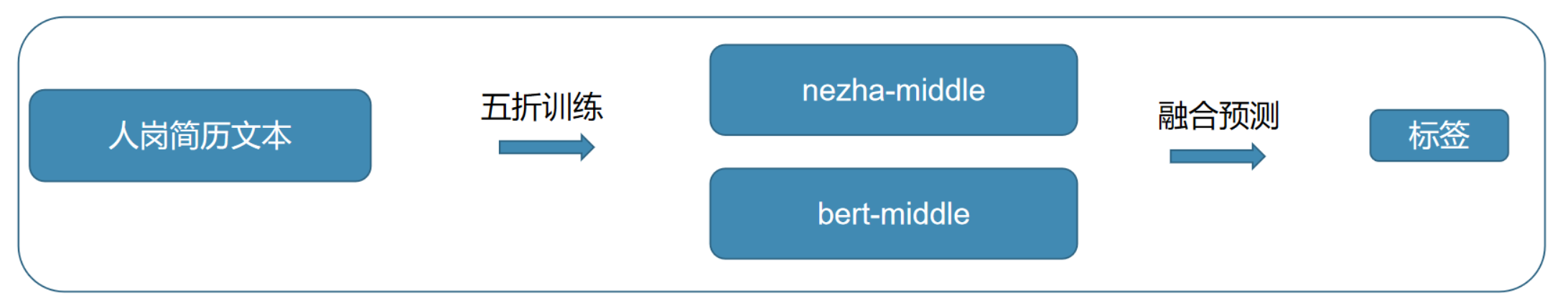

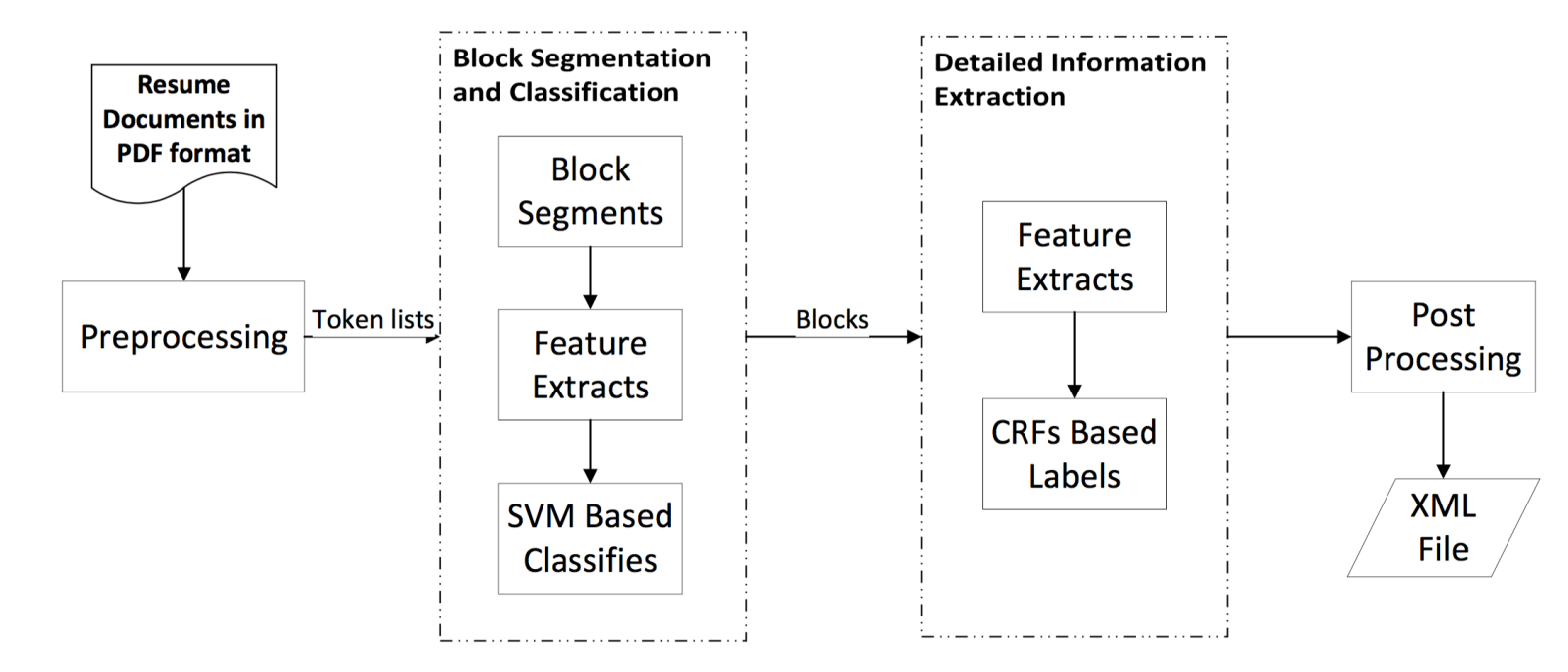

精准简历筛选,如何使用机器学习完成? |Mixlab人工智能

用机器学习实现:精准简历筛选这是微软的一项专利,它的目的是为了构建一个系统,用来筛选那些比较 “特别” 的简历,而这些简历中有一个显著的特征是:不会使用和职位描述要求中关键字相同的关键字,而是会以另…

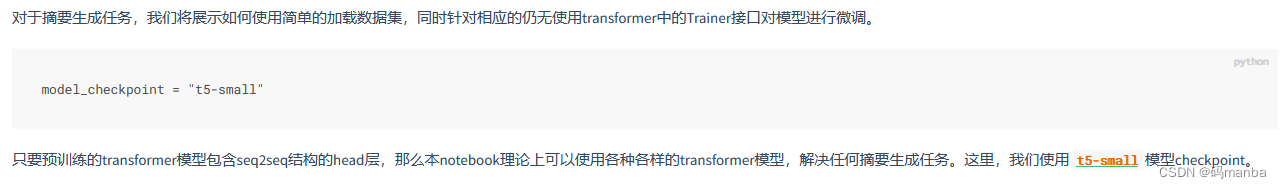

t5模型为什么可以通过传入past_key和past_value值来进行优化模型

t5模型是常用于文本生成部分的一个模型,也是目前我看到的各个nlp模型之中,唯一完整地使用transformer的所有完整结构(encoder部分加上decoder部分)的一个模型,接下来聊一下t5模型的生成优化过程。

优化的部分

首先对于生成这一块࿰…

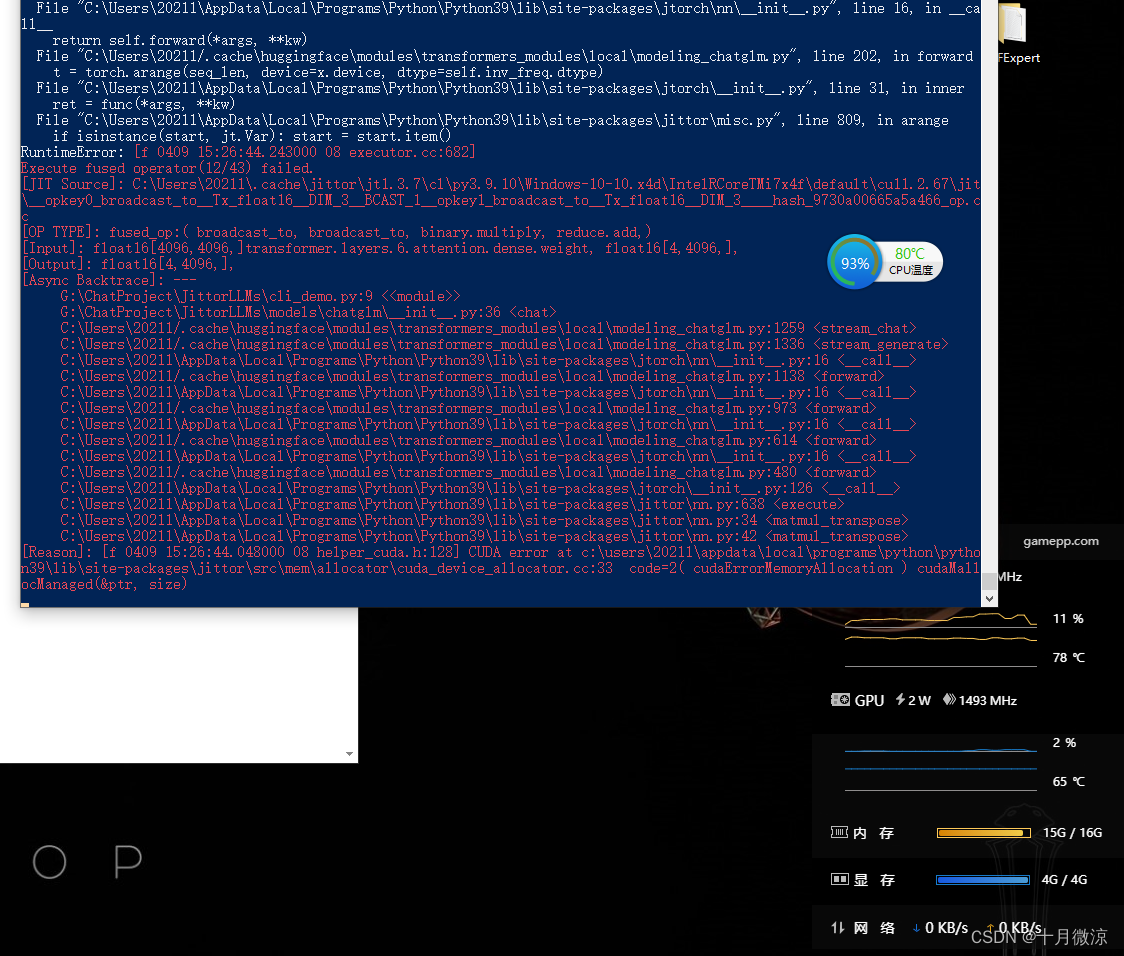

CUDA error: device-side assert triggered CUDA kernel errors问题解决

今天在写pytorch代码的时候,报了这样的一个错误

CUDA error: device-side assert triggered

CUDA kernel errors might be asynchronously reported at some other API call,so the stacktrace below might be incorrect.

For debugging consider passing CUDA_LAU…

总结:阅读transformer结构的t5源代码的经验

阅读transformers中的t5结构经验1.用笔在纸上画出结构,哪一部分接着跟着哪一部分2.把握关键的操作3.熟悉代码的脉络流程之后,从外面往里面阅读1.用笔在纸上画出结构,哪一部分接着跟着哪一部分

因为t5总体的结构比较复杂,所以必须…

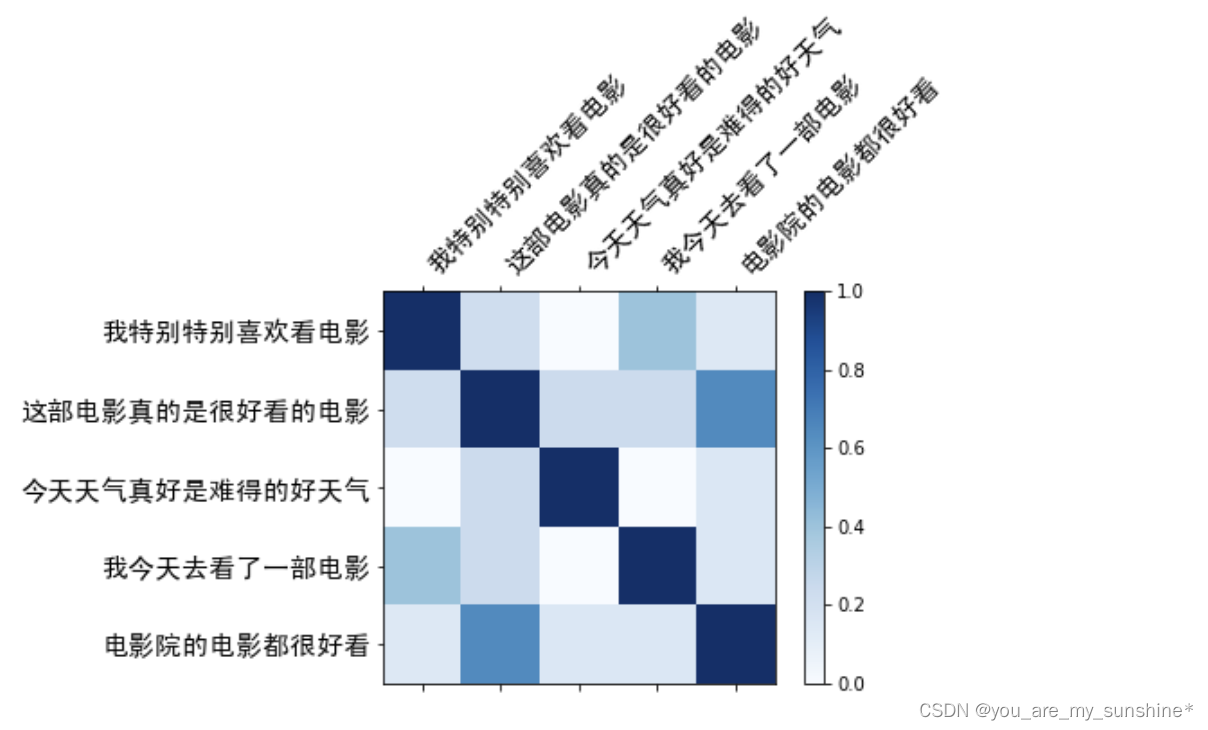

文本相似度分类方案研究

原文链接 文本相似度的三种模型结构(1) cross-encoder类:对一组句对进行编码,编码过程中可以进行句内及句间的信息交互。(2) bi-encoder类:分别对source文本和target文本进行编码,再通过网络结构进行表示间的交互和计算࿰…

NLP-D9-第一场大数据比赛D1知识蒸馏翻译论文CATTI备考-第一套综合

—0533早上先clone一本kaggle书

–0626吃了早饭,又看了一遍上次的分享视频,感觉云淡风轻,没有想象那么难。先去根据代码看下transformer的库怎么用。

----0806回来了,继续看代码。 1、yield和return区别 2、partial作用 所以&am…

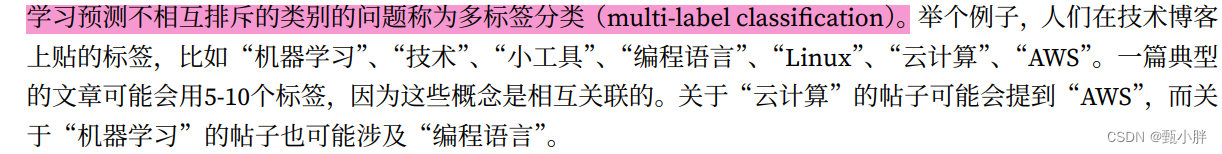

多标签文本分类研究进展概述

多标签文本分类研究进展概述

1.多标签文本分类的研究还有很大的提升空间.

2.多标签文本分类的基本流程,包括数据集获取、文本预处理、模型训练和预测结果;

3.多标签文本分类的方法:传统机器学习的方法和基于深度学习的方法。传统机器学习方…

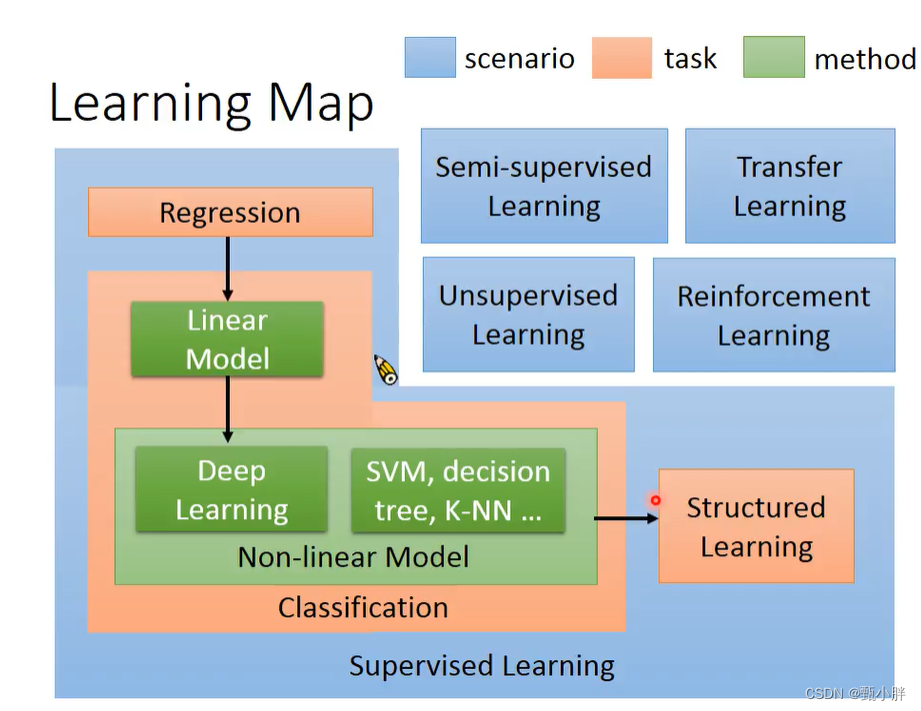

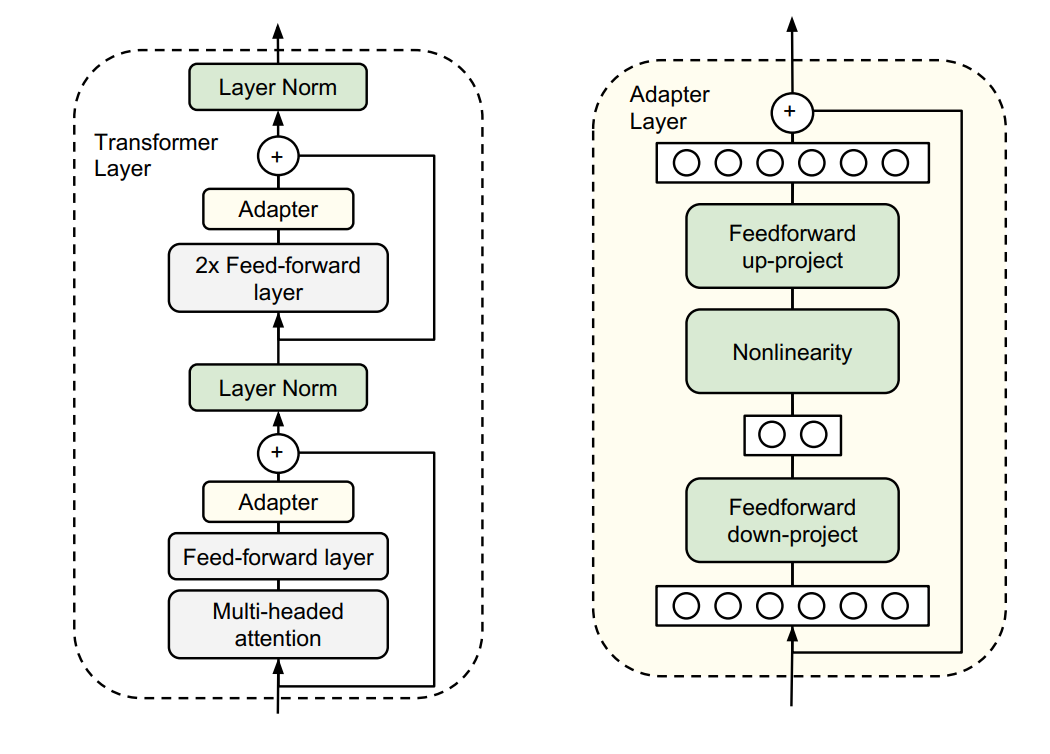

NLP-D8-李宏毅机器学习---预训练模型问题adaptationexplainable AIRLlearningmap

----0648今天还是醒的挺早的,4点50就起床了。在犹豫是去看比赛,还是把老师的课听完。因为还是很想看无监督学习和强化学习的,最后决定先看课叭。 看了姜成翰助教关于预训练模型中遇到问题的讲解。 一共讲了两个问题,以及相应解决方…

NLP-D7-李宏毅机器学习---X-AttentionGANBERTGPT

—0521今天4:30就起床了!真的是迫不及待想看新的课程!!! 昨天做人脸识别系统的demo查资料的时候,发现一个北理的大四做cv的同学,差距好大!!!我也要努力呀!&am…

NLP-DAY5-李宏毅机器学习L2

今天起的很早,3:30就起了。我真的很喜欢早起的感觉。 早上第一次尝试用notability做笔记,梳理了一个slide的内容。大概是什么是机器学习,神经网络的搭建步骤(对理解神经网络很有帮助)。

后来又看了一些L2的正课&#…

NLP学习D2-TF2基础学习-北大教程

今天主要学tf2和动手实践;如果有时间,看下Transformer系列的细节!!加油!

一、环境配置

老师很贴心,带着装环境。 1、我建个github仓库~ 2、设置了一个conda的默认清华镜像 参考链接: https://…

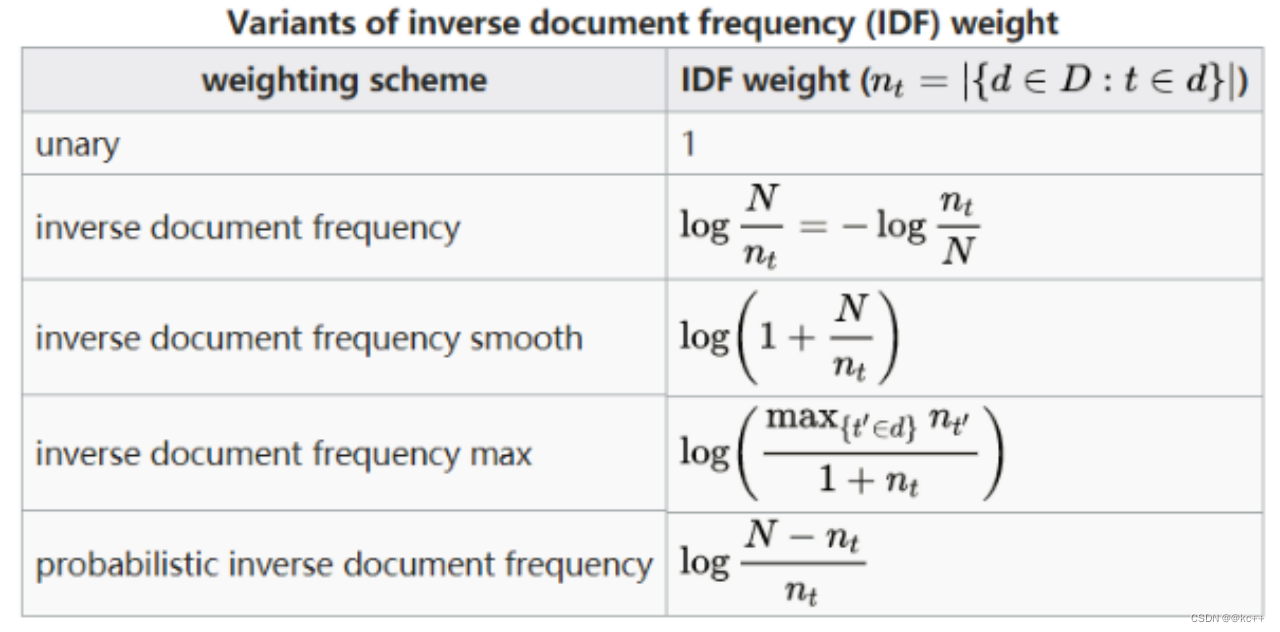

NLP学习D1-莫烦课程-tf-idfw2vseq2seqAttentionTransformerGPT+BERTELmo

课程在b站上 https://www.bilibili.com/video/BV1LA411n73X?p7&spm_id_frompageDriver

一、TF-IDF

嗯嗯,这次感觉终于弄懂了,用sklearn跑一下叭!!! 正好练习一下git 1、ravel()不产生副本的降维 https://blog.c…

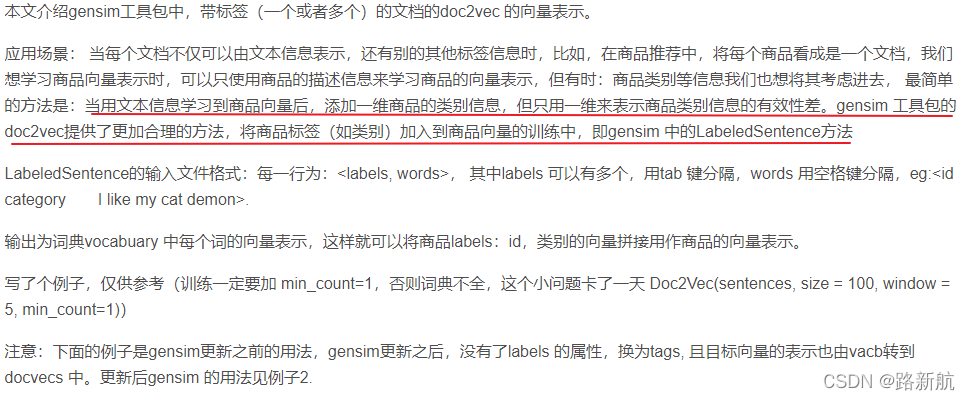

python中gensim库详解

一、gensim介绍gensim是一款强大的自然语言处理工具,里面包括N多常见模型: - 基本的语料处理工具 - LSI - LDA - HDP - DTM - DIM - TF-IDF - word2vec、paragraph2vec . 二、训练模型

1、训练

#encodingutf-8

from gensim.models import wor…

opencv之Mat格式数据转换成onnxruntime的输入tensor处理的c++写法

下面的代码假设使用3通道处理数据 (通常就是这样子的) resize_img.convertTo(resize_img, CV_32F, 1.0 / 255); //divided by 255resize_img - 0.5f; // meanresize_img / 0.5f; // stdcv::Mat channels[3]; //借用来进行HWC->CHWcv::split(resi…

VSCode常用快捷键

VS常用快捷键

查找: CtrlF查找替换: CtrlH全屏显示(再次按则恢复): F11放大或缩小(以编辑器左上角为基准): Ctrl /-侧边栏显示或隐藏: CtrlB显示资源管理器(光标切到侧边栏中才有效): CtrlShiftE显示搜索(光标切到侧边栏中才有效): CtrlShiftF显示(光标…

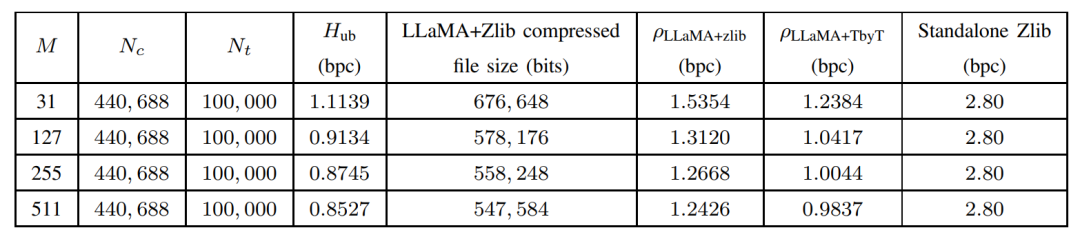

大模型入局传统算法,LLMZip基于LLaMA-7B实现1MB文本压缩率90%!

论文链接: https://arxiv.org/abs/2306.04050 随着以ChatGPT、GPT-4为代表的AI大模型逐渐爆火进入公众视野,各行各业都开始思考如何更好的使用和发展自己的大模型,有一些评论甚至认为大模型是以人工智能为标志的第四次产业革命的核心竞争产品…

自然语言处理从入门到应用——预训练模型总览:预训练模型存在的问题

分类目录:《自然语言处理从入门到应用》总目录 相关文章: 预训练模型总览:从宏观视角了解预训练模型 预训练模型总览:词嵌入的两大范式 预训练模型总览:两大任务类型 预训练模型总览:预训练模型的拓展 …

生成专题3 | StyleGAN2对AdaIN的修正

文章转自微信公众号:机器学习炼丹术作者:陈亦新(欢迎交流共同进步)联系方式:微信cyx645016617学习论文:Analyzing and Improving the Image Quality of StyleGAN 文章目录3.1 AdaIN3.2 AdaIN的问题3.3 weig…

极视角成功入选2020年最具成长潜力企业TOP20

2021年4月20日-21日,“投资家网2020中国股权投资年度峰会”在深圳福田召开,会上发布了包含“2020年最具成长潜力企业TOP20”在内的“2020中国股权投资年度系列榜单”。

极视角成功入选“2020年最具成长潜力企业TOP20” 此次榜单由投资家网发布于“2020中…

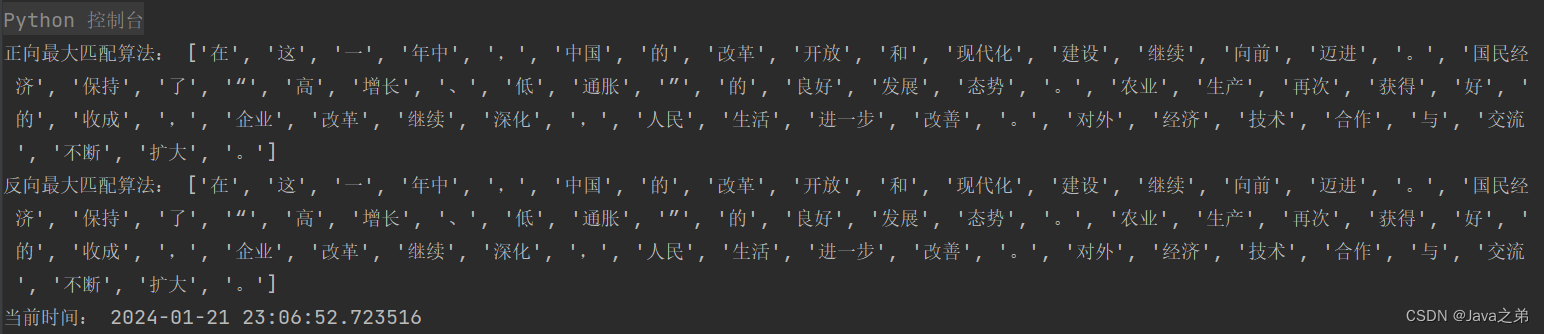

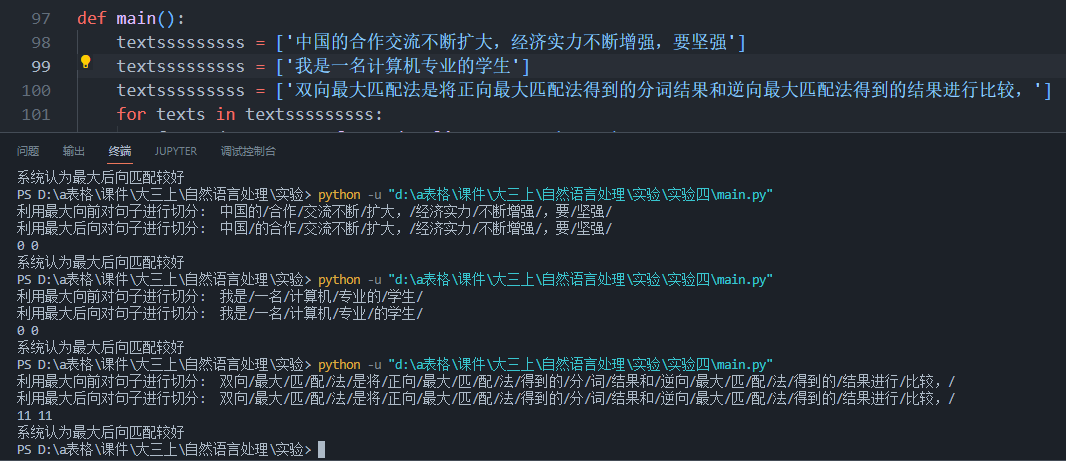

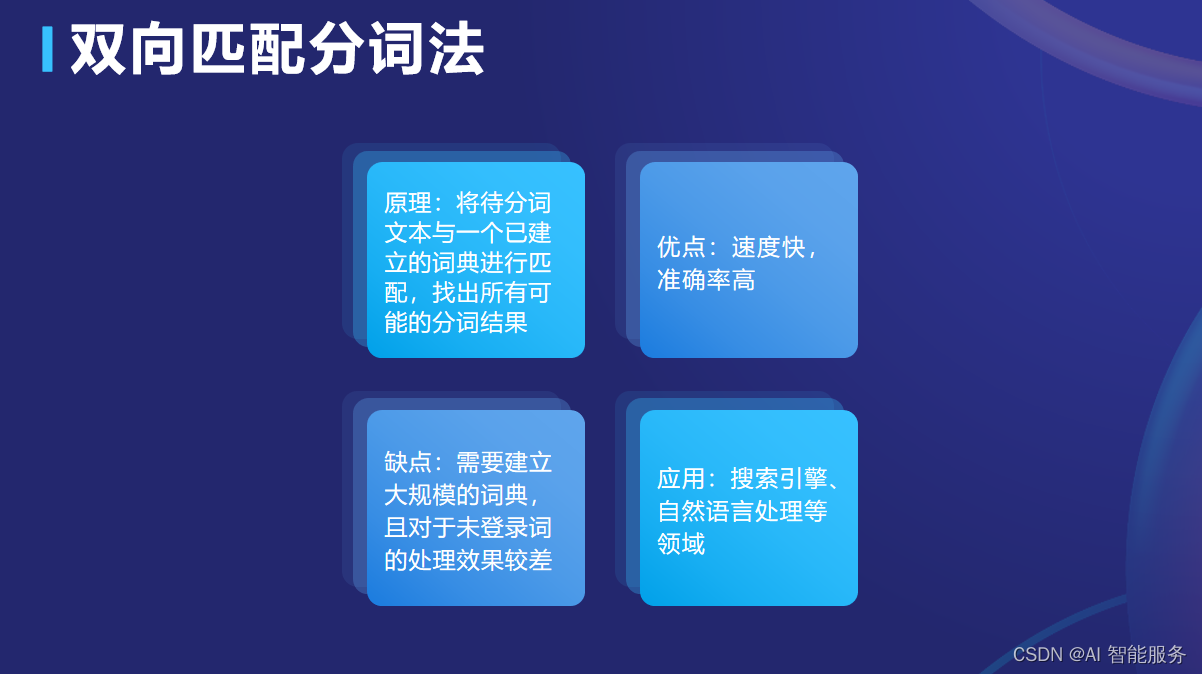

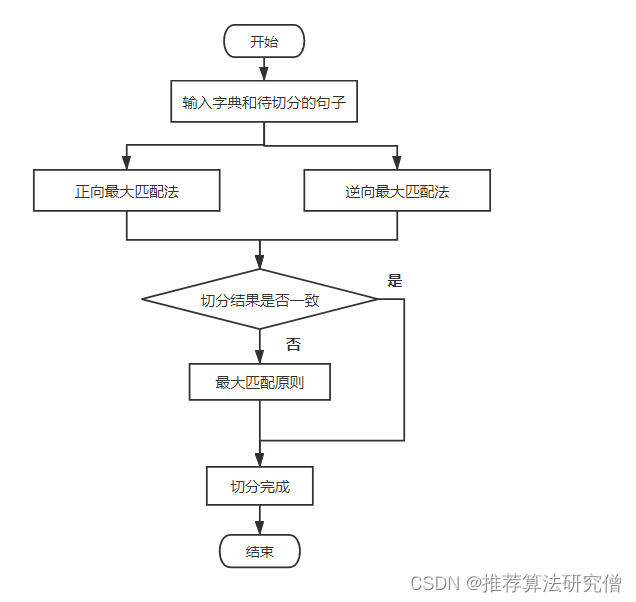

自然语言处理——中英文分词

目录 英文分词

中文分词

机械分词法

正向最大匹配法

逆向最大匹配法

双向最大匹配法

统计分词法

语料统计法

序列标注法 英文分词

英文原文: it is a good day!分词结果: it , is , a , good , day , !

通过上面的英文分词例子,可以…

Transformer-based模型的综述:AMMUS : A Survey of Transformer-based Pretrained Models in NLP

论文地址: https://arxiv.org/abs/2108.055421 导言 预训练的来源 最开始是基于规则的学习,后来被机器学习取代早期机器学习需要特征工程,需要专业领域的知识,耗时由于硬件和词嵌入的发展,类似于CNN、RNN的深度学习模型…

一个简单的自然语言处理例子

例子是我学习的教程的一个例子,收集了一些客户对于饭店的评价,目标是将他们进行分类,分成好评和差评。 数据的前5项: 这里用到了一个之前没用到的包NLTK对我们的文本数据进行必要的处理,转化,使其变成能够…

安装Qe-7.2细节

编译 直接编译报错,发现要使用gpu加速。

检查linux的GPU: nvidia-smi lspci |grep -i nvidia

module load cuda ./configure make all

安装curl mkdir build cd build …/configure --prefix/home/bin/local/curl make make install

加入路径: expor…

instruction-tuning

instruction-tuning是在Prompt-tuning之后提出的,它的思想是:在对A做Prompt-tuning之前,先在其他若干的任务之上做Prompt-tuning。如图: 每个任务有多个Prompt,作者使用了10个。 比较注意的是,instruction…

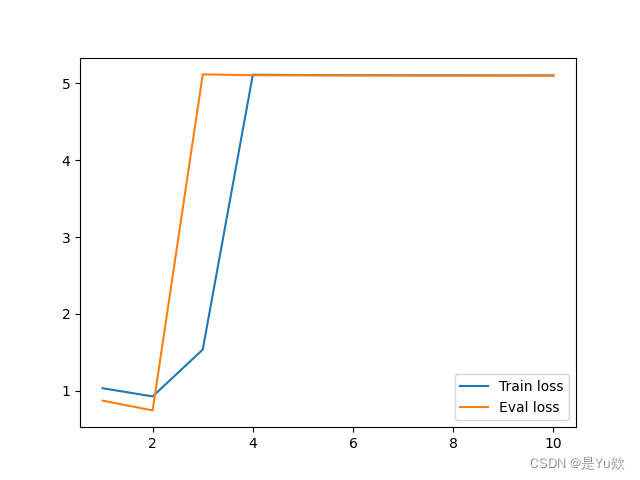

模型损失的loss不下降或下降很慢

这里主要记录我碰到的原因

model.eval()

当一个大的模型model中内含bert等大模型时,大模型使用model.eval()时,Bert也同时使用bert.eval()

学习率太小

val loss一直再下降,但下降很慢,有可能时学习率太小了的原因。

深度学习论文语言和表述

Vector space 向量空间

node classification节点分类

link prediction边预测

community detection社群检测

case study 小样本任务,案例分析(比如77个点 254条边)

word representations 词表示

language model 语言模型 :预…

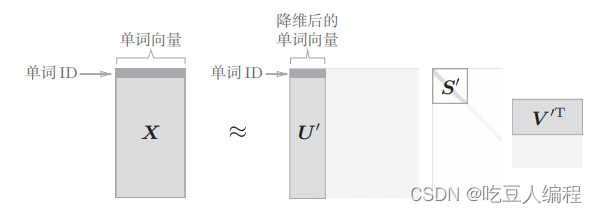

SVD分解的应用——矩阵运算和文本处理中的分类问题

在自然语言处理中,最常见的两类的分 类问题分别是,将文本按主题归类(比如将所有介绍亚运会的新闻归到体育类)和将词汇表中的字词按意思归类(比如将各种体育运动的名称个归成一类)。这两种 分类问题都可用通…

一个通用html抽取类

下面以新浪微博为例子 Java代码 package com.ansj.sun.pojo; import java.util.ArrayList; import java.util.Iterator; import java.util.List; import java.util.regex.Matcher; import java.util.regex.Pattern; public class AnsjPaser { private …

文本生成:自动摘要评价指标 Rouge

本文结构概览不同的摘要任务下,选择合适的Rouge指标Rouge-N的理解与示例Rouge-L的理解与示例代码示例(char粒度 计算摘要的Rouge值)代码示例(word粒度 计算摘要的Rouge值)个人思考ReferenceRouge的全名是Recall-Orient…

自然语言处理技术:NLP句法解析树与可视化方法

自然语言处理(Natural Language Processing,NLP)句法解析树是一种表示自然语言句子结构的图形化方式。它帮助将句子中的每个词汇和短语按照语法规则连接起来,形成一个树状结构,以便更好地理解句子的语法结构和含义。句法解析树对于理解句子的句法关系、依存关系以及语义角…

prompt工程(持续更新ing...)

诸神缄默不语-个人CSDN博文目录

我准备想办法把这些东西整合到我的ScholarEase项目里。到时候按照分类、按照prompt生成方法列一堆选项,用户自己生成prompt后可以选择在ScholarEase里面聊天,也可以复制到别的地方(比如ChatGPT网页版之类的&a…

[NLP] BERT模型参数量

一 BERT_Base 110M参数拆解 BERT_base模型的110M的参数具体是如何组成的呢,我们一起来计算一下:

刚好也能更深入地了解一下Transformer Encoder模型的架构细节。 借助transformers模块查看一下模型的架构:

import torch

from transformers …

逆向最大匹配法分词(补充)

def cut_word(sentence, word_dic):"""逆向最大匹配分词器sentence:待切分的句子word_dic:字典"""# 寻找字典中最大词的长度word_length_list [len(word) for word in word_dic]max_length max(word_length_list)# 创建…

最简单DIY基于ESP8266的物联网智能小车①(webserver服务器网页简单遥控版)

ESP8266和ESP32物联网智能小车开发系列文章目录

第一篇:最简单DIY基于ESP8266的物联网智能小车①(webserver服务器网页简单遥控版) 文章目录ESP8266和ESP32物联网智能小车开发系列文章目录前言一、最简单DIY基于ESP8266的物联网智能小车①&a…

NLP之人机对话系统

人机对话系统

人机对话系统又称口语对话系统(spoken dialogue system)。一个典型的人机对话系统主要包括如下6个技术模块:①语音识别器(speech recognizer);②语言解析器(language parser&…

Viterbi算法实现中文分词和词性标注

Viterbi算法目标过程词典分词统计分词词性标注附录附录二附录三源码地址目标

实现基于词典的分词方法和统计分词方法对分词结果进行词性标注对分词及词性标注结果进行评价,包括4个指标:正确率、召回率、F1值和效率

过程

词典分词

基于词典的分词方法…

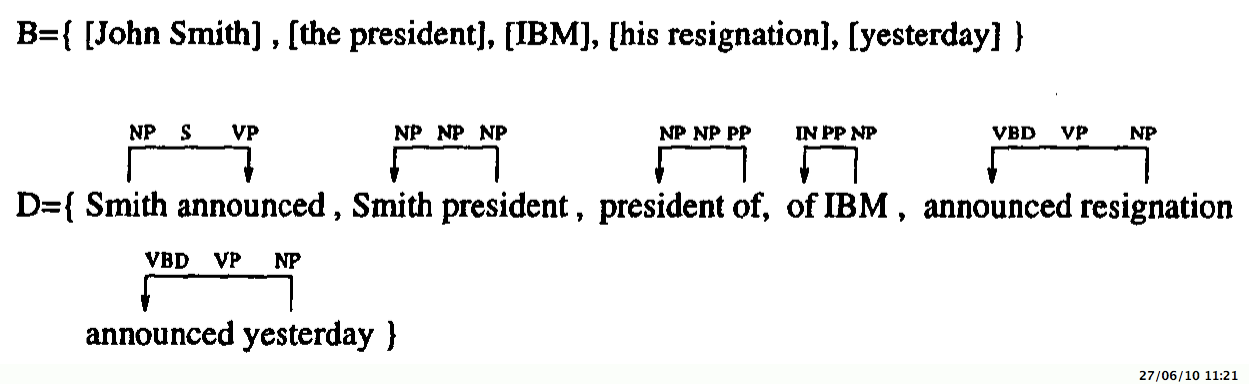

依存语法:从短语结构树转换为依存树

依存语法:从短语结构树转换为依存树 冯志伟 与短语结构语法比较起来,依存语法没有词组这个层次,每一个结点都与句子中的单词相对应,它能直接处理句子中词与词之间的关系,而结点数目大大减少了,便于直接标注…

未登录词识别应该单独成系统

自然语言处理系统有很多问题与未登录词识别有关,比如分词、索引、新热点发现、主题词/中心词分析、人物关系统计等等。所以,很多相关系统都号称自己具有未登录词识别功能,也就是内嵌了一个未登录词识别模块。先不论效果好坏,单是这…

统计自然语言处理简介

统计自然语言处理简介 李亚超 2010-10-28 简介 语言学家的任务是描述和解释存在我们周围的众多语言现象,比如交谈、写作、以及其他的媒体形式。这就需要一方面确定人类是怎么认知世界、以及怎样获取、产生、理解语言,另一方面要理解语言的结构。对于后…

自然语言处理(一):词嵌入

词嵌入

词嵌入(Word Embedding)是自然语言处理(NLP)中的一种技术,用于将文本中的单词映射到一个低维向量空间中。它是将文本中的单词表示为实数值向量的一种方式。

在传统的文本处理中,通常使用独热编码&…

上图自然语言处理相关书目

1. 基于词联接的自然语言处理技术及其应用研究 * 著者 李良炎学林出版社 2007 2. 计算机自然语言处理 * 著者 王晓龙清华大学出版社 2005 3. 统计自然语言处理基础 * 著者 曼宁电子工业出版社 2005 4. 自然语言处理 * 著者 江铭虎高等教育出版社 2007 …

自然语言处理的多行业应用

在我们小时候,甚至是我们会走路或说话之前,就已经在察觉周围发出的声音了。我们倾听其他人发出的声响和声音。我们将声音组合成有意义的词语,例如“母亲”和“门”,并学习解读周围人的面部表情,以加深我们对词组的理解…

补充:动态时间规整(DTW)算法

整理自:https://zhuanlan.zhihu.com/p/43247215 DTW(dynamic time warping) 最初用于识别语音的相似性。我们用数字表示音调高低,例如某个单词发音的音调为1-3-2-4。现在有两个人说这个单词,一个人在前半部分拖长,其发音为1-1-3-3…

Postman接口测试步骤

1、首先,我们打开Postman软件,打开后界面如图1所示界面,我们来进行下一步操作。 图1-Postman界面2、打开Postman之后,我们会看到左边模块中有一个“New”按钮,我们点开它来进行下一步操作(如图2所示界面&am…

微信公众号实现表格文字识别功能(java后台)

有个想法就是想把图片上不可编辑的的表格给抓取出来,生成Excel,发到用户绑定的邮箱,也不是什么新技术了,百度ai以及其他各ai平台均有文字识别的功能,咱不会写这算法,调用也行,我的步骤是在自己的…

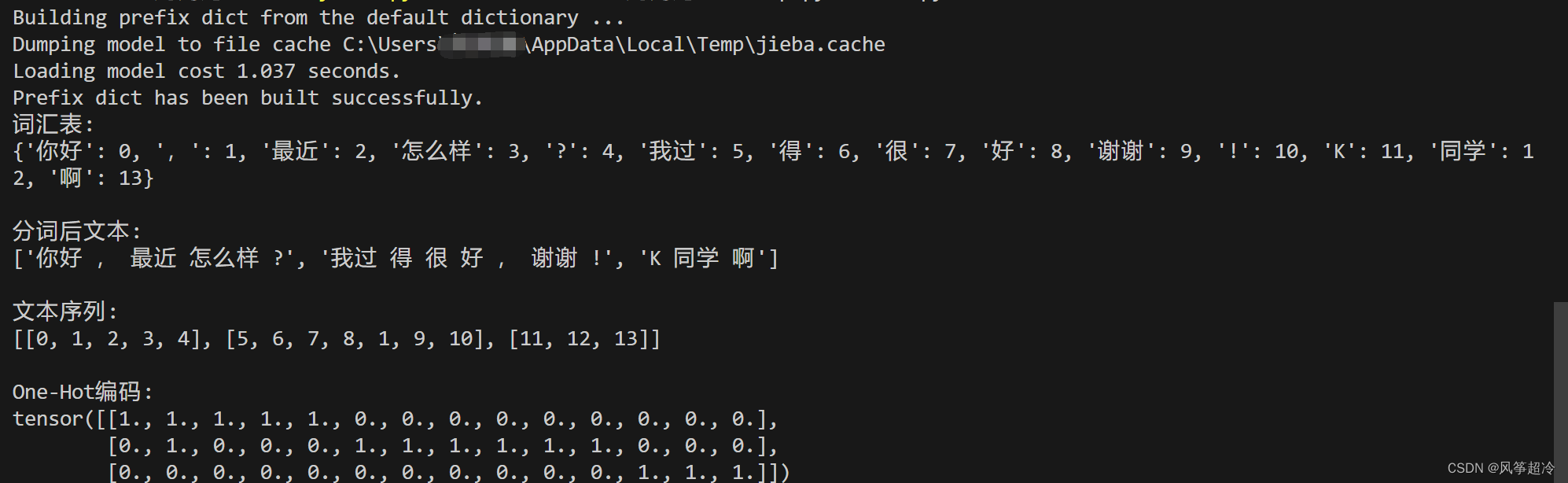

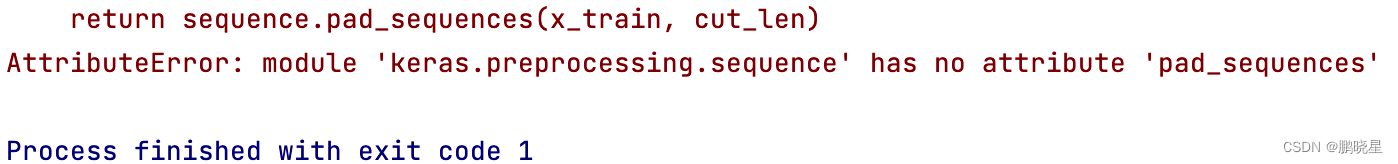

keras preprocessing中的Tokenizer与sequence使用解读

1. 代码

import jieba

from keras.preprocessing.text import Tokenizer

from keras.preprocessing import sequencedef cut_text(text, type char):"""将文本按不同方式切词,以空格作为分割"""# print(text)if type char:return …

人工智能Java SDK:NLP词向量提取【英文】

词向量SDK【英文】

词向量/词嵌入(Word embedding)是自然语言处理(NLP)中语言模型与表征学习技术的统称。 概念上而言,它是指把一个维数为所有词的数量的高维空间嵌入到一个维数低得多的连续向量空间中, 每…

人工智能Java SDK:NLP词向量提取【中文】

词向量SDK【中文】

词向量/词嵌入(Word embedding)是自然语言处理(NLP)中语言模型与表征学习技术的统称。 概念上而言,它是指把一个维数为所有词的数量的高维空间嵌入到一个维数低得多的连续向量空间中, 每…

genism word2vec方法

文章目录 概述使用示例模型的保存与使用训练参数详解([原链接](https://blog.csdn.net/weixin_44852067/article/details/130221655))语料库训练 概述

word2vec是按句子来处理的Sentences(句子们)

使用示例

from gensim.models import Word2Vec

#sent…

深度学习与自然语言处理(8)_斯坦福cs224d RNN,MV-RNN与RNTN

原文作者:Richard Socher 翻译:胥可 && 熊杰 && 杨帆 && 陈沛 && Molly 校对调整:寒小阳 && 龙心尘 时间:2016年7月 出处: http://blog.csdn.net/han_xiaoyang/article/…

NLP系列(5)_从朴素贝叶斯到N-gram语言模型

作者: 龙心尘 && 寒小阳 时间:2016年2月。 出处: http://blog.csdn.net/longxinchen_ml/article/details/50646528 http://blog.csdn.net/han_xiaoyang/article/details/50646667 声明:版权所有,转载请联系作者…

Enabling Large Language Models to Generate Text with Citations

本文是LLM系列的文章,针对《Enabling Large Language Models to Generate Text with Citations》的翻译。 使大语言模型能够生成带有引用的文本 摘要1 引言2 任务设置和数据集3 自动评估4 建模5 实验6 人类评估7 相关工作8 结论不足 摘要

大型语言模型(…

NLP - 如何解决ModuleNotFoundError: No module named ‘jieba‘的问题

错误描述

在JUPYTER中,使用结巴分词,出错:

ModuleNotFoundError: No module named jieba解决方案

在 Anaconda Prompt 中,执行以下指令(可以解决):

pip install jieba -i https://pypi.tuna…

GCN图卷积神经网络 text_gcn 文本分类论文的源码,逐行注释版,光看代码注释就能学一篇论文。

《Graph Convolutional Networks for Text Classification》 这篇论文中的源码,我看过以后,为了以后还能看懂代码,就逐行写了注释,说是逐行也有点夸张了,就像变量赋值之类,创建对象这种属于pytho…

Android环境下hanlp汉字转拼音功能的使用介绍

由于项目需要在Android手机设备上实现汉字转拼音功能(支持多音字),于是首先想到了Pinyin4j多音字映射对照表的实现方案,并在项目中试用了一段时间,发现数据量大时,其耗时非常严重。后来寻找其他方案&#x…

nlp系列(7)三元组识别(Bi-LSTM+CRF)pytorch

模型介绍

在实体识别中:使用了Bert模型,CRF模型

在关系识别中:使用了Bert模型的输出与实体掩码,进行一系列变化,得到关系

Bert模型介绍可以查看这篇文章:nlp系列(2)文本分类&…

大模型调试debug记录

环境:Linux , cuda 11.7

RuntimeError: Distributed package doesnt have NCCL built in

原因:pytorch安装的是cpu版本,需要安装支持gpu版本的

RuntimeError: Distributed package doesnt have NCCL built in - #3 by bdabykov - distrib…

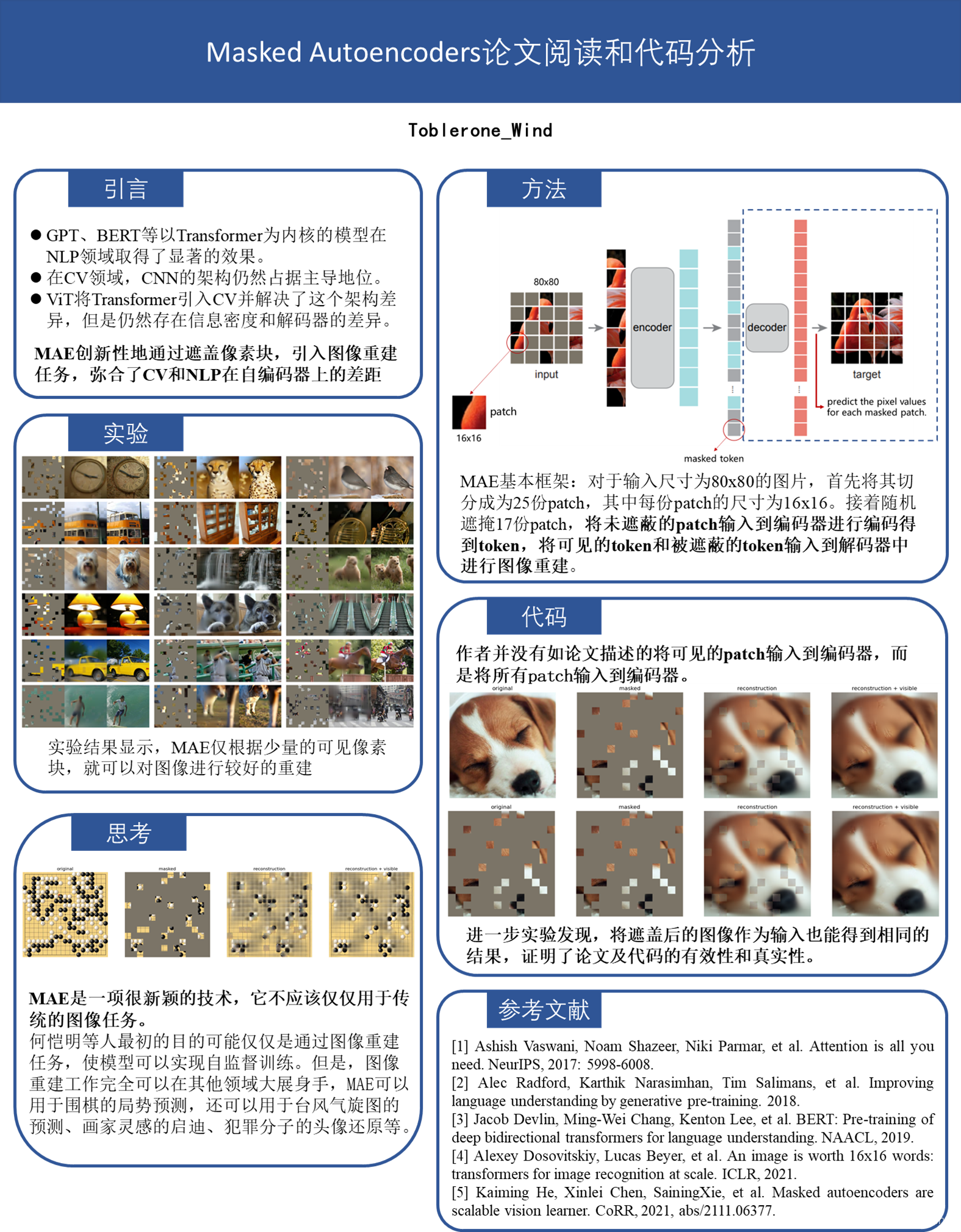

基础论文学习(5)——MAE

MAE:Masked Autoencoders Are Scalable Vision Learners

Self-Supervised Learning

step1:先用无标签数据集,把参数从一张白纸训练到初步预训练模型,可以得到数据的 Visual Representationstep2:再从初步成型&#x…

pyhanlp 停用词与用户自定义词典功能详解

hanlp的词典模式

之前我们看了hanlp的词性标注,现在我们就要使用自定义词典与停用词功能了,首先关于HanLP的词性标注方式具体请看HanLP词性标注集。

其核心词典形式如下: 自定义词典

自定义词典有多种添加模式,首先是展示的一个…

hanlp自然语言处理包的基本使用--python

hanlp拥有:中文分词、命名实体识别、摘要关键字、依存句法分析、简繁拼音转换、智能推荐。

这里主要介绍一下hanlp的中文分词、命名实体识别、依存句法分析,这里就不介绍具体的hanlp的安装了,百度教程很多,可以看这里:…

什么是自然语言处理技术

自然语言处理(NLP)是计算机科学,人工智能,语言学关注计算机和人类(自然)语言之间的相互作用的领域。自然语言处理是计算机科学领域与人工智能领域中的一个重要方向。它研究能实现人与计算机之间用自然语言进…

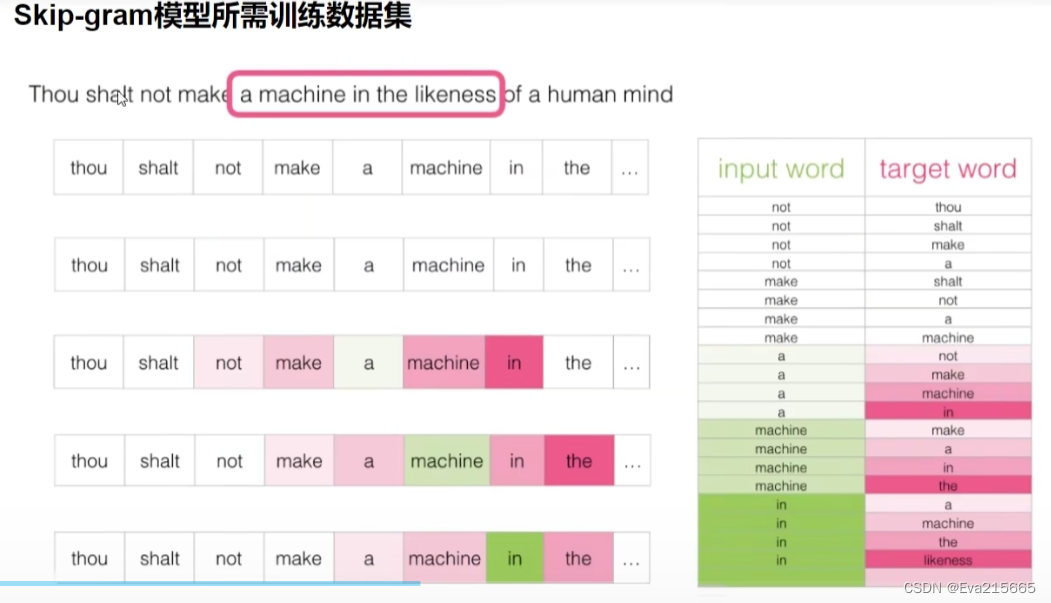

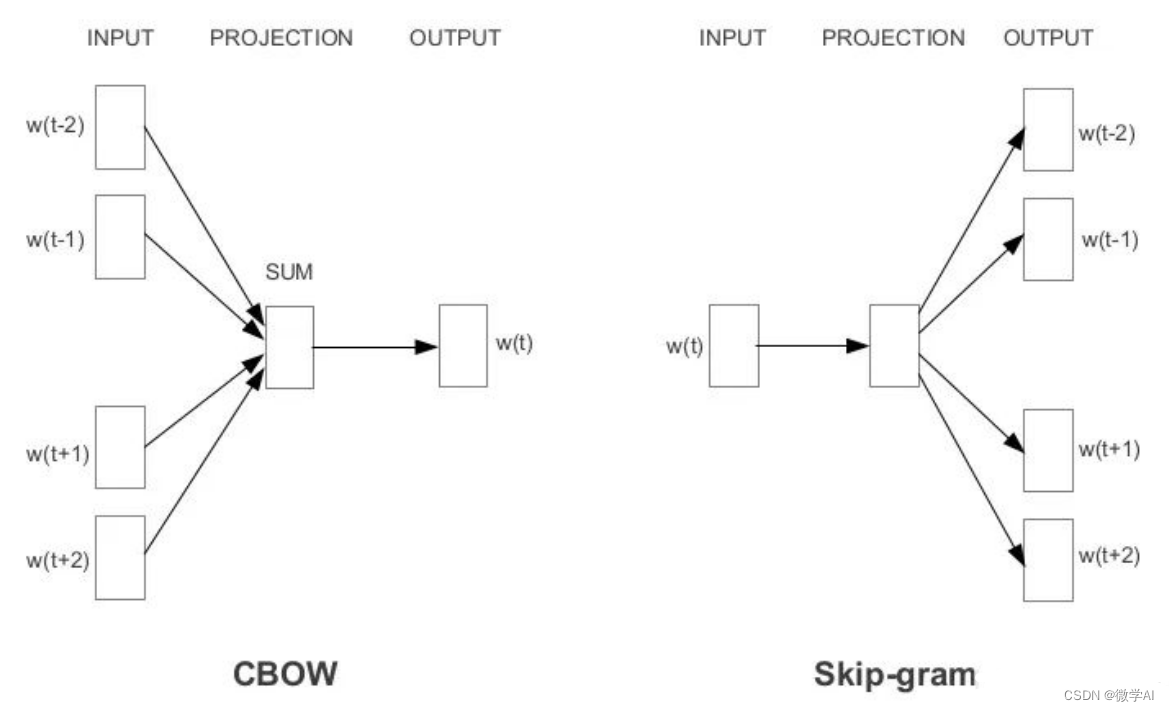

自然语言处理2-NLP

目录

自然语言处理2-NLP

如何把词转换为向量

如何让向量具有语义信息

在CBOW中

在Skip-gram中

skip-gram比CBOW效果更好

CBOW和Skip-gram的算法实现

Skip-gram的理想实现

Skip-gram的实际实现 自然语言处理2-NLP

在自然语言处理任务中,词向量(…

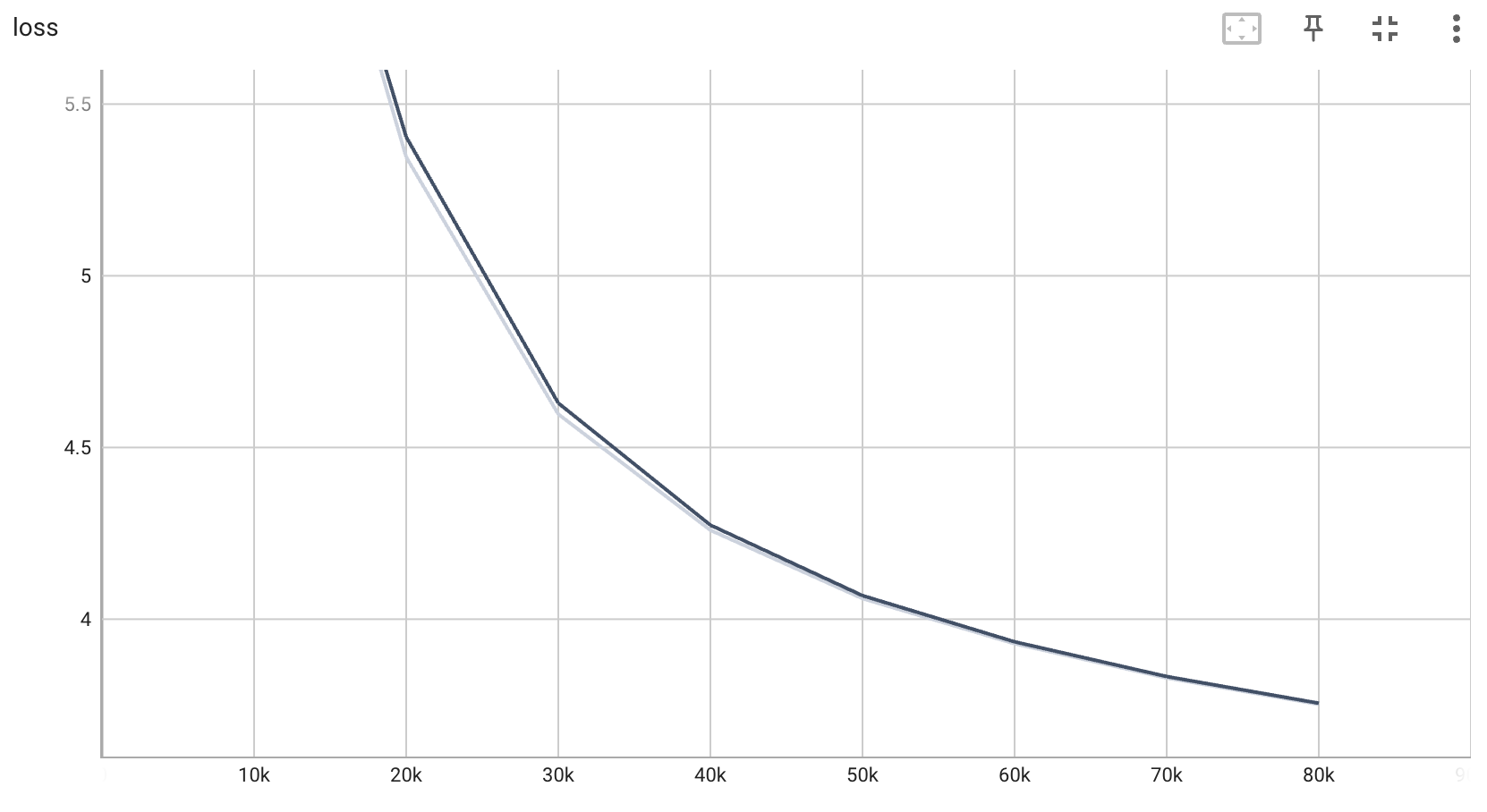

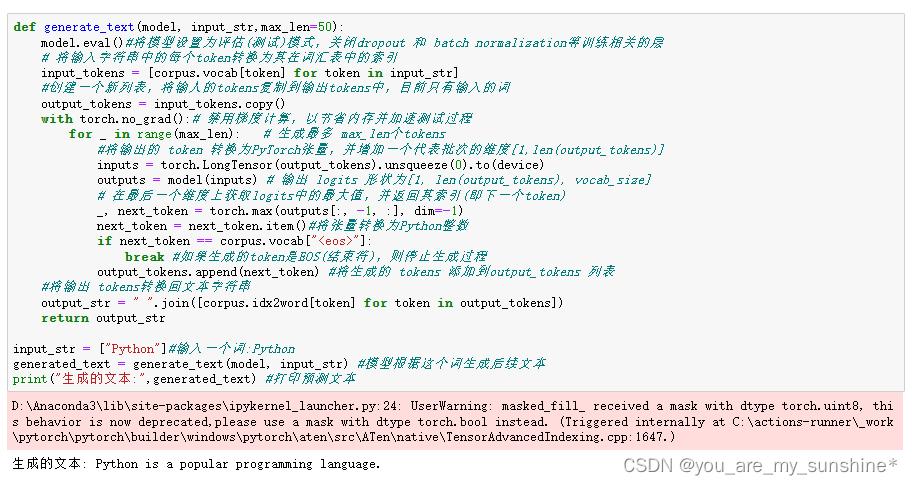

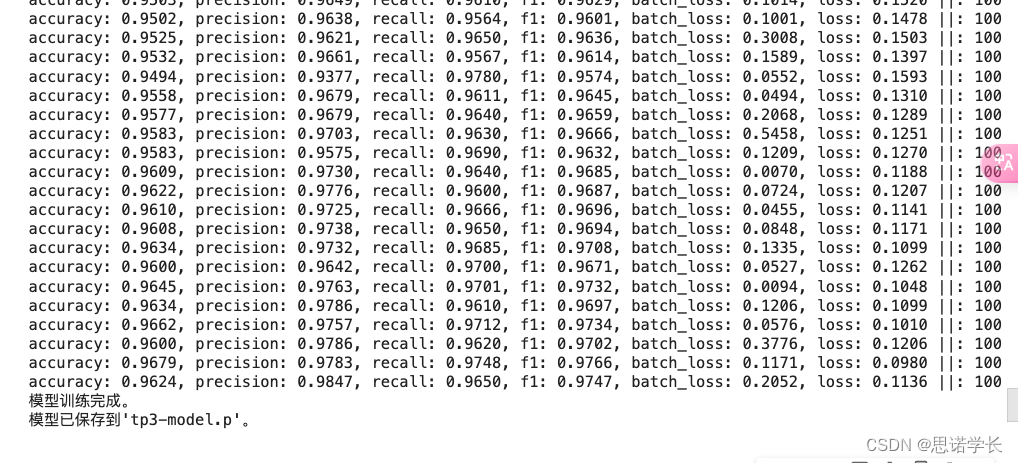

自然语言处理实战项目16- 基于CPU的大语言模型的实战训练全流程指导,模型调优与评估

大家好,我是微学AI,今天给大家介绍一下自然语言处理实战项目16- 基于CPU的生成式大语言模型的实战训练全流程详细讲解,模型调优与评估。该流程涵盖了数据准备、数据预处理、词表构建、模型选择与配置、模型训练、模型调优和模型评估等步骤。通过不断迭代和优化,可以提高模型…

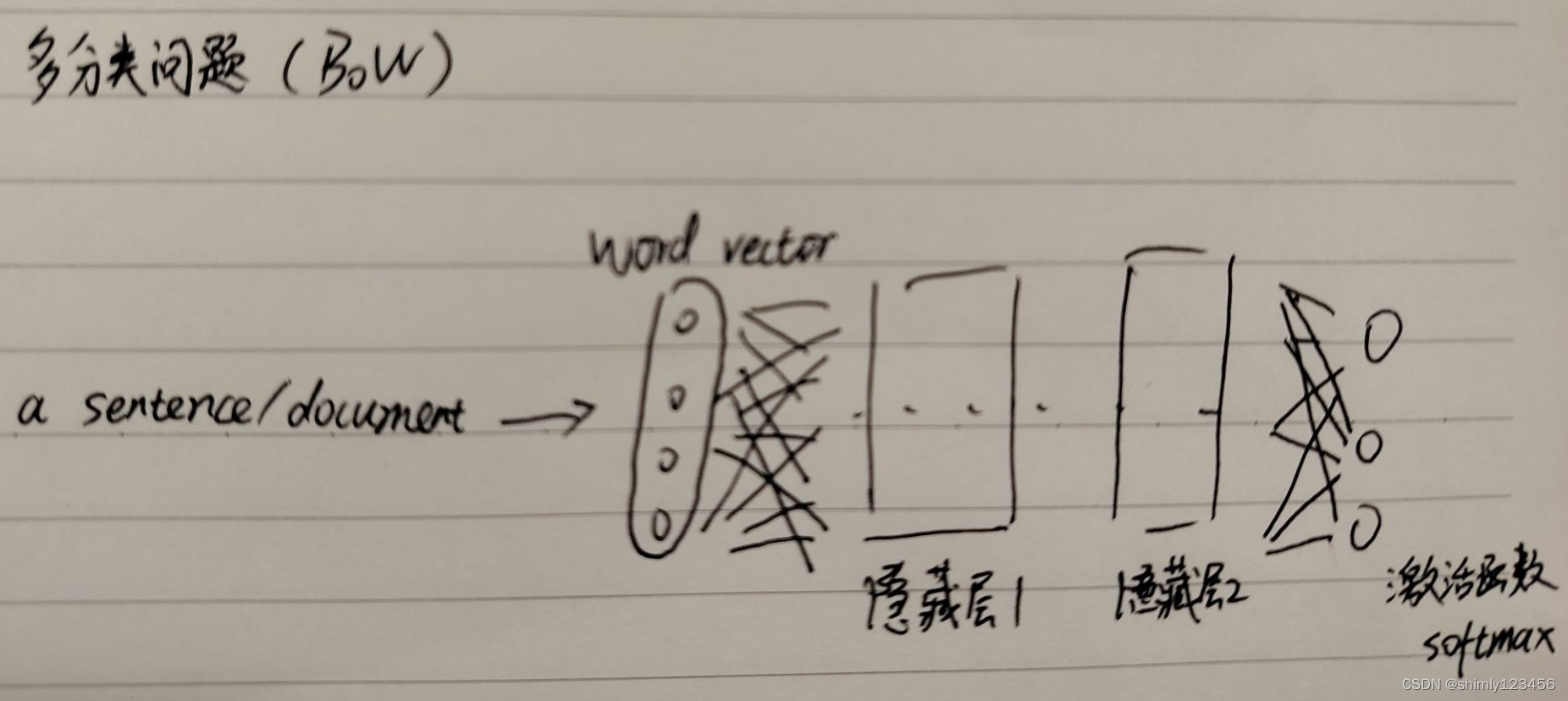

【深度学习】- NLP系列文章之 1.文本表示以及mlp来处理分类问题

系列文章目录

1. 文本分类与词嵌入表示,mlp来处理分类问题 2. RNN、LSTM、GRU三种方式处理文本分类问题 3. 评论情绪分类 还是得开个坑,最近搞论文,使用lstm做的ssd的cache prefetching,意味着我不能再划水了。 文章目录 系列文章…

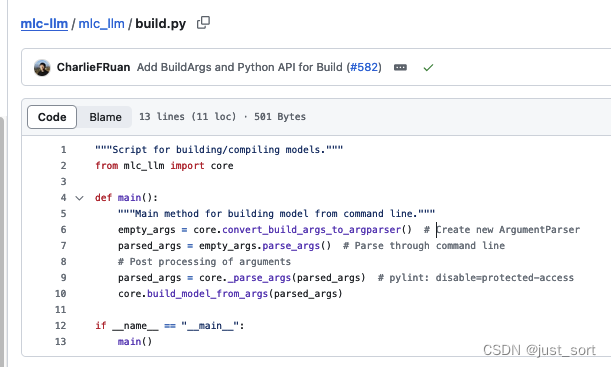

[NLP] LLM---<训练中文LLama2(四)方式一>对LLama2进行SFT微调

指令精调

指令精调阶段的任务形式基本与Stanford Alpaca相同。训练方案也采用了LoRA进行高效精调,并进一步增加了可训练参数数量。在prompt设计上,精调以及预测时采用的都是原版Stanford Alpaca不带input的模版。对于包含input字段的数据,采…

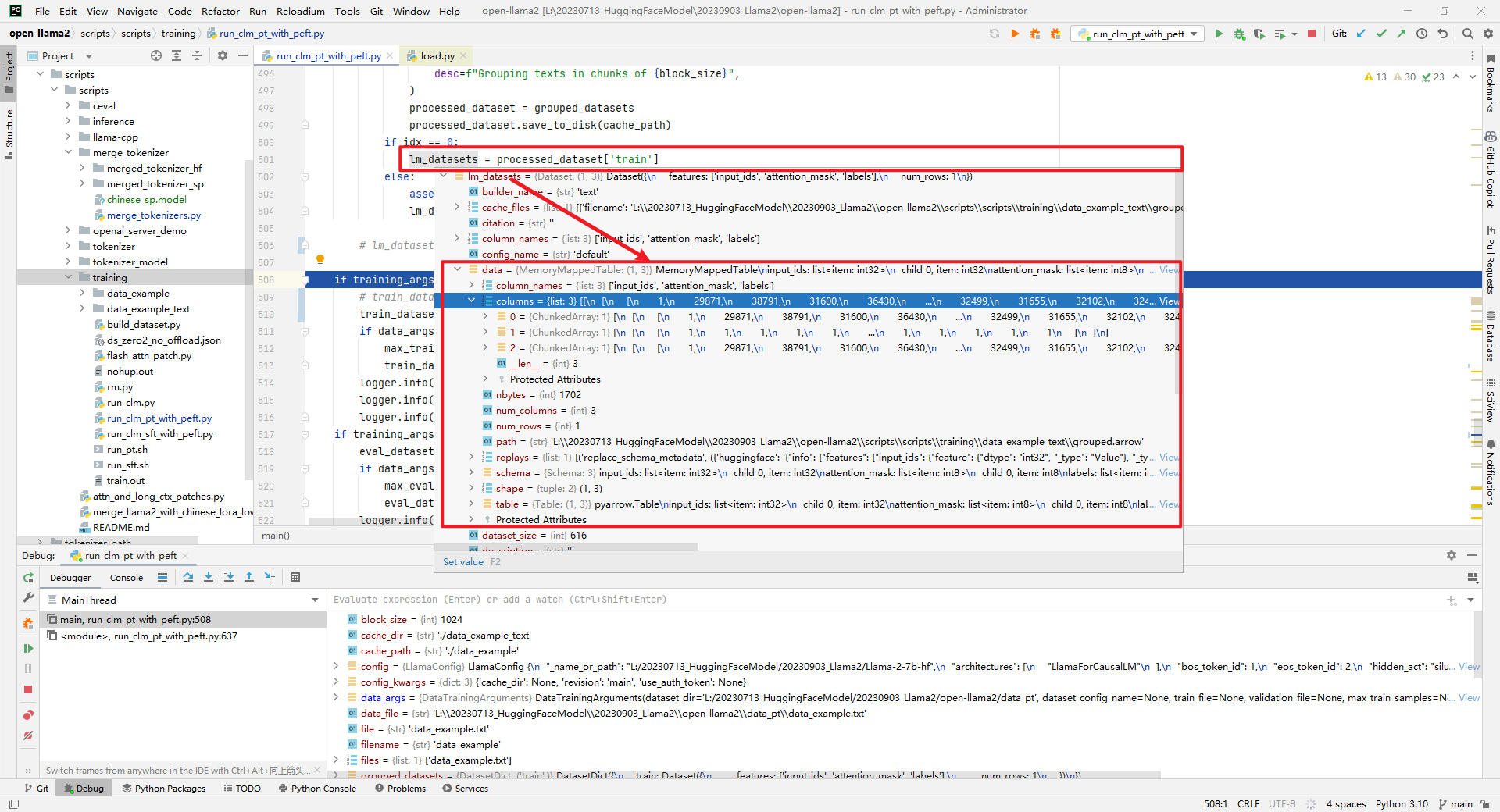

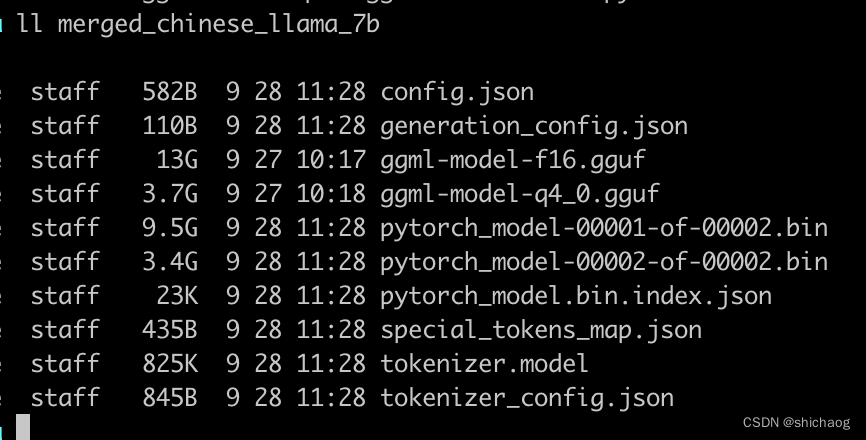

[NLP] LLM---<训练中文LLama2(三)>对LLama2进行中文预料预训练

预训练

预训练部分可以为两个阶段:

第一阶段:冻结transformer参数,仅训练embedding,在尽量不干扰原模型的情况下适配新增的中文词向量。第二阶段:使用 LoRA 技术,为模型添加LoRA权重(adapter&…

计算文本相似度的几种方法以及实现原理

第一种基于TF-IDF向量法计算文本相似度

import jieba

from sklearn.feature_extraction.text import TfidfVectorizer

from sklearn.metrics.pairwise import cosine_similarity# 语料库

corpus [你借的钱什么时候还呀,你到底什么时候还钱,你如果不还钱的话,你的征…

【2021年新书推荐】Transformers for Natural Language Processing

各位好,此账号的目的在于为各位想努力提升自己的程序员分享一些全球最新的技术类图书信息,今天带来的是2021年1月由Packt出版社最新出版的一本关于机器学习和NLP的书。

Transformers for Natural Language Processing 作者:Denis Rothman 出…

机器学习深度学习——NLP实战(情感分析模型——textCNN实现)

👨🎓作者简介:一位即将上大四,正专攻机器学习的保研er 🌌上期文章:机器学习&&深度学习——NLP实战(情感分析模型——RNN实现) 📚订阅专栏:机器学习…

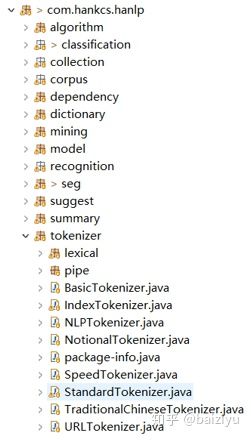

HanLP-分类模块的分词器介绍

最近发现一个很勤快的大神在分享他的一些实操经验,看了一些他自己关于hanlp方面的文章,写的挺好的!转载过来分享给大家!以下为分享原文(无意义的内容已经做了删除)

如下图所示,HanLP的分类模块…

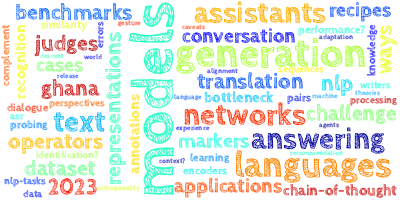

【AI视野·今日NLP 自然语言处理论文速览 第四十八期】Thu, 5 Oct 2023

AI视野今日CS.NLP 自然语言处理论文速览 Thu, 5 Oct 2023 Totally 50 papers 👉上期速览✈更多精彩请移步主页 Daily Computation and Language Papers

Retrieval meets Long Context Large Language Models Authors Peng Xu, Wei Ping, Xianchao Wu, Lawrence McA…

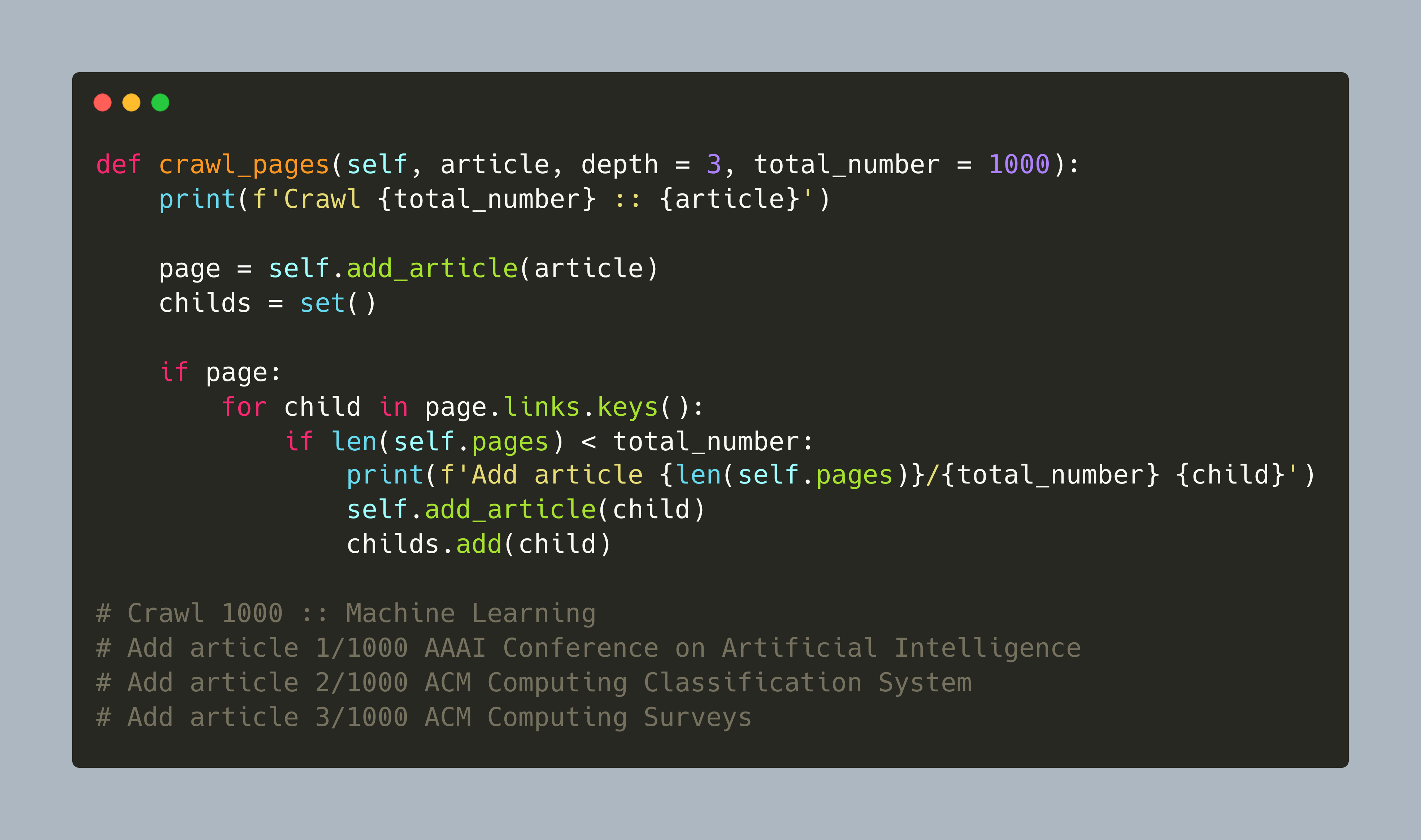

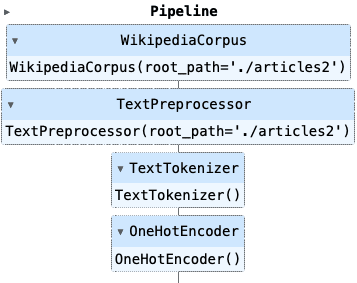

NLP 项目:维基百科文章爬虫和分类【01】 - 语料库阅读器

自然语言处理是机器学习和人工智能的一个迷人领域。这篇博客文章启动了一个具体的 NLP 项目,涉及使用维基百科文章进行聚类、分类和知识提取。灵感和一般方法源自《Applied Text Analysis with Python》一书。 一、说明 该文是系列文章,揭示如何对爬取文…

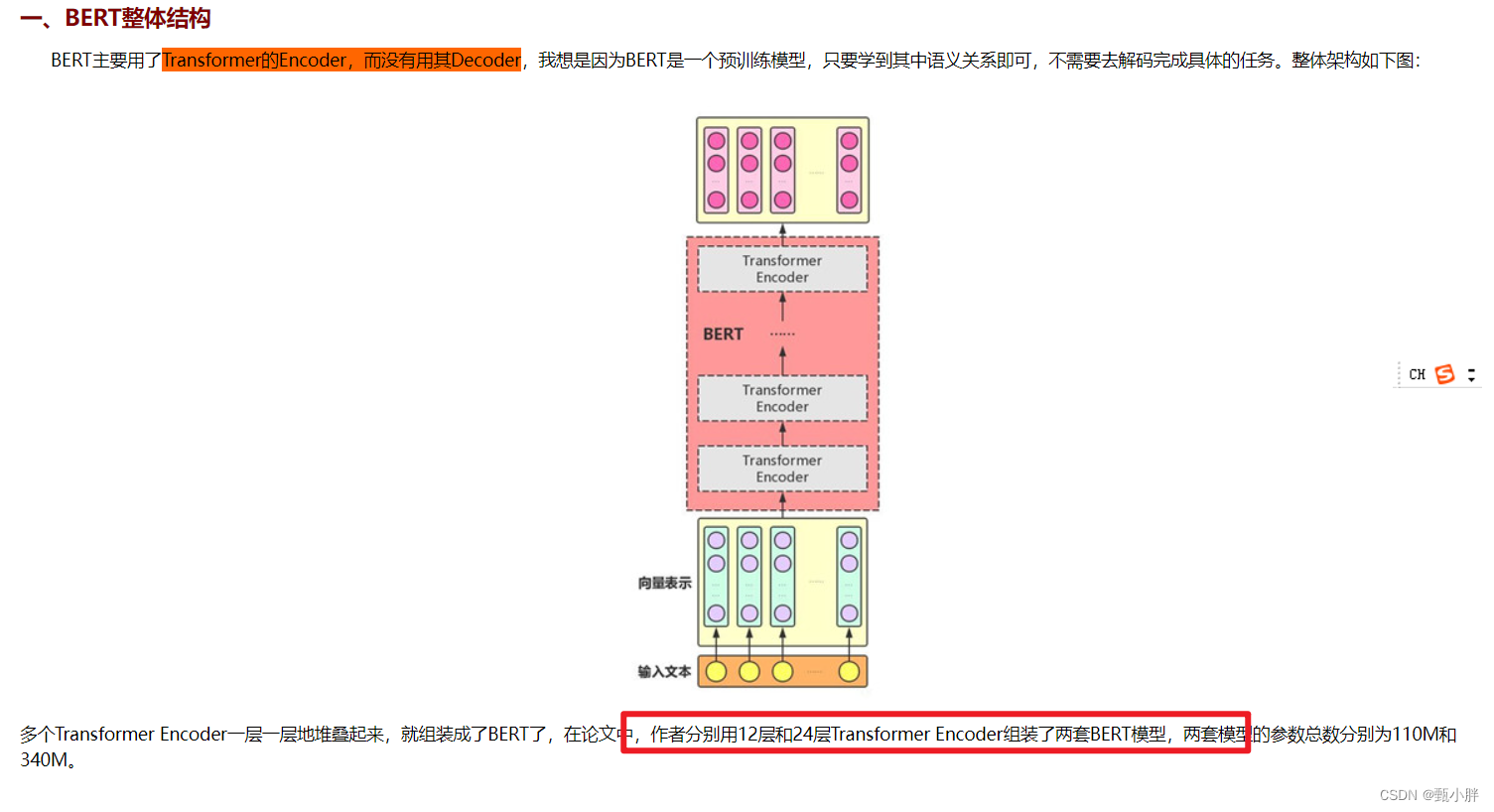

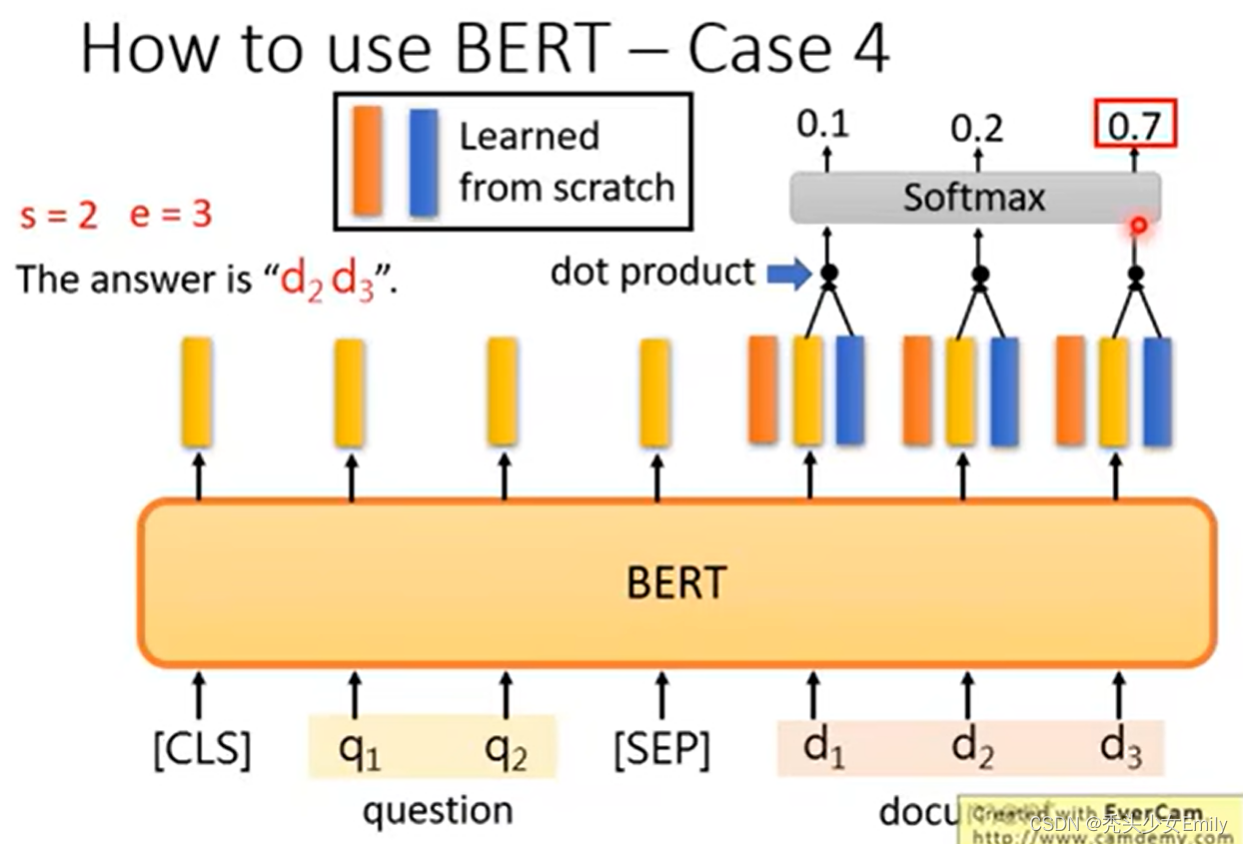

自然语言处理实战项目20-一看就懂的BERT模型介绍,指导大家对BERT下游任务改造的实际应用

大家好,我是微学AI,今天给大家介绍一下自然语言处理实战项目20-通俗易懂的BERT模型介绍,指导大家对BERT下游任务改造的应用,BERT模型是一种用于自然语言处理的深度学习模型,它可以通过训练来理解单词之间的上下文关系,从而为下游任务提供高质量的语言表示。它的结构是由多…

使用 Hugging Face Transformer 创建 BERT 嵌入

介绍 最初是为了将文本从一种语言更改为另一种语言而创建的。BERT 极大地影响了我们学习和使用人类语言的方式。它改进了原始 Transformer 模型中理解文本的部分。创建 BERT 嵌入尤其擅长抓取具有复杂含义的句子。它通过检查整个句子并理解单词如何连接来做到这一点。Hugging F…

(已解决)AttributeError: module ‘cv2.gapi.wip.draw‘ has no attribute ‘Text‘

问题描述 今天再跑Caption-Anything项目的时候,最开始的时候就报了这样一个错误:AttributeError: module cv2.gapi.wip.draw has no attribute Text。 Caption-Anything是一种多功能的图像处理工具,结合了Segment Anything,Visual…

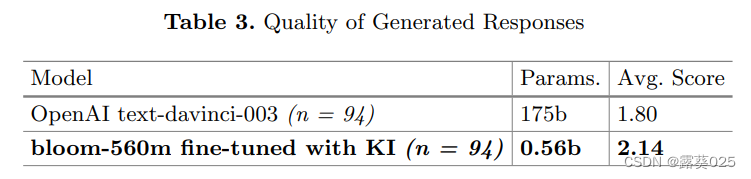

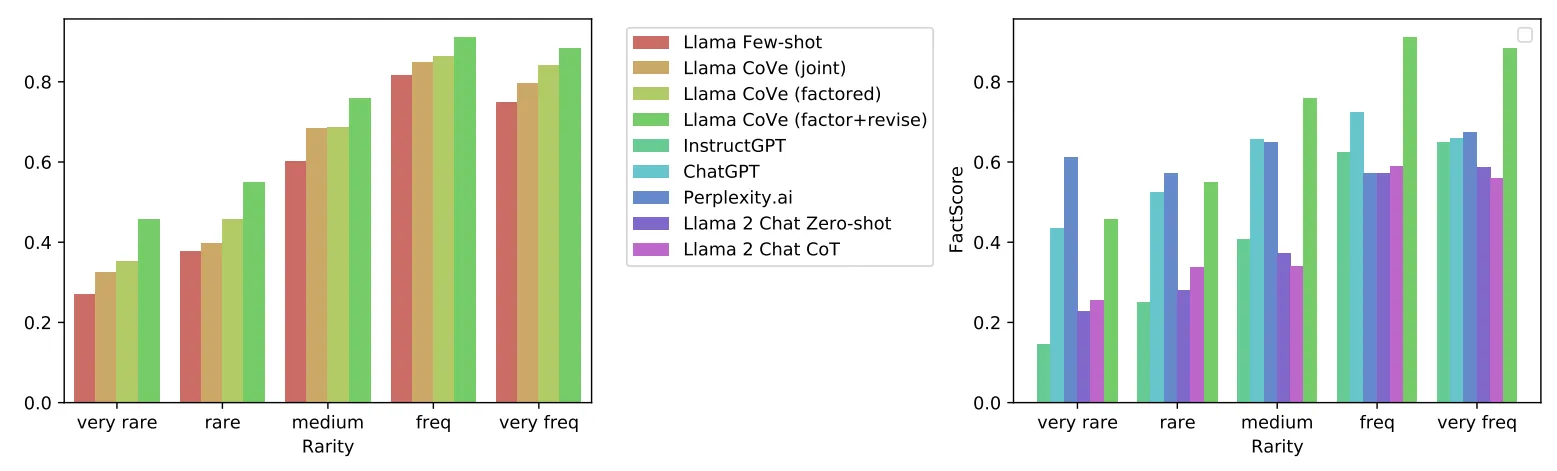

知识注入以对抗大型语言模型(LLM)的幻觉11.6

知识注入以对抗大型语言模型(LLM)的幻觉 摘要1 引言2 问题设置和实验2.1 幻觉2.2 生成响应质量 3 结果和讨论3.1 幻觉3.2 生成响应质量 4 结论和未来工作 摘要

大型语言模型(LLM)内容生成的一个缺点是产生幻觉,即在输…

自然语言处理技术之词向量:GloVe单词表示的全局向量(glove.840B.300d、glove.6B)

目录 一、词向量介绍二、GloVe学习词向量的词嵌入模型三、词向量入门(代码下载)四、训练五、模型概述六、可视化七、发布历史一、词向量介绍

自然语言处理(NLP)中的词向量是将文本中的词汇表示为数值向量的技术。词向量的主要作用是将文本数据转换成计算机可以理解和处理的…

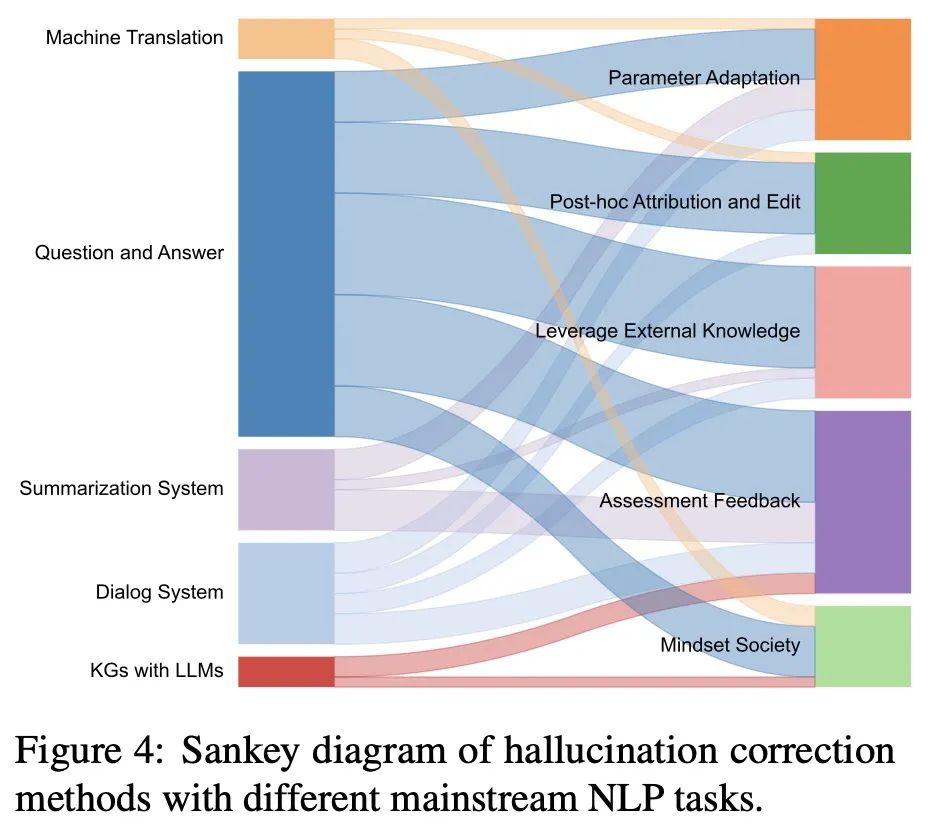

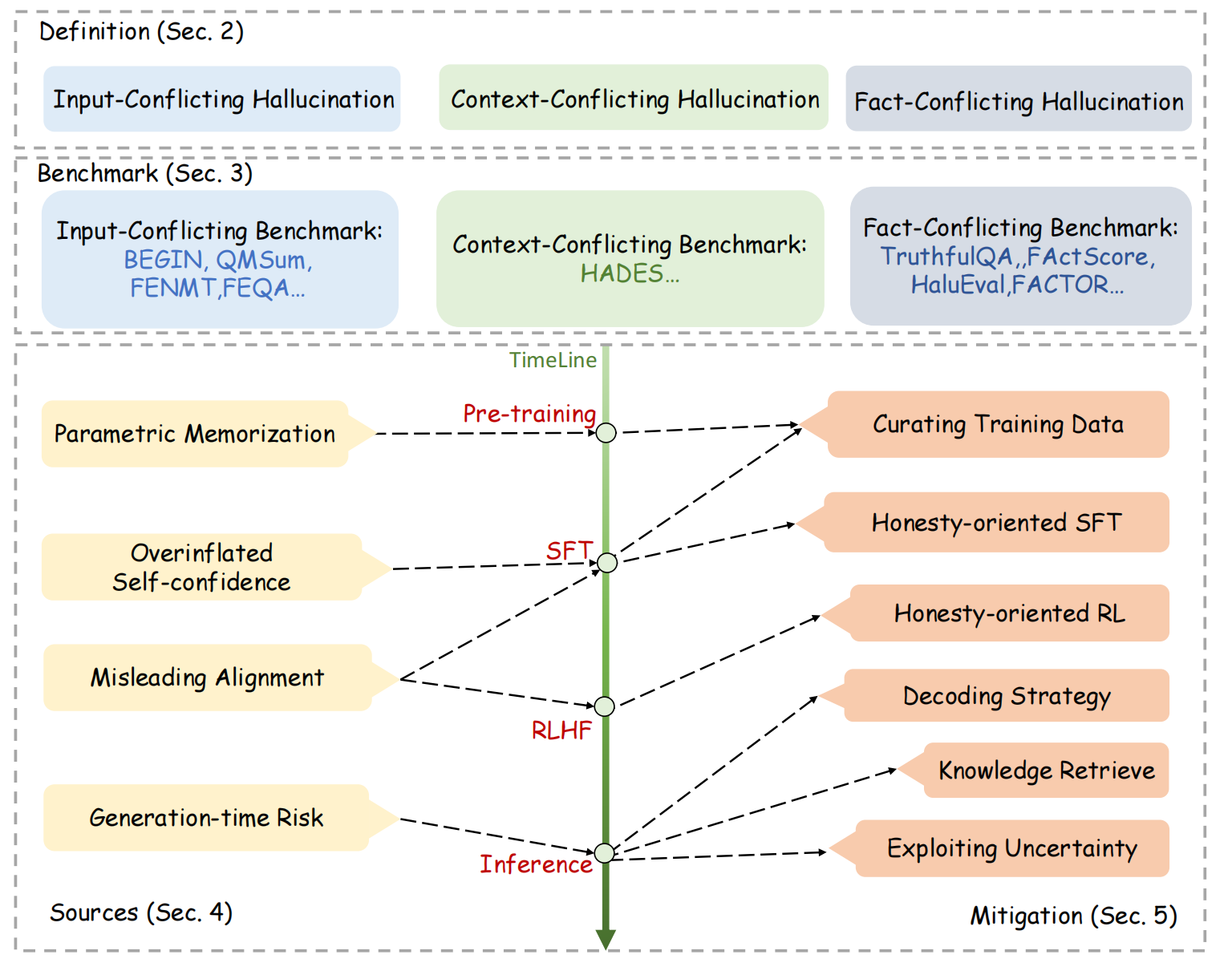

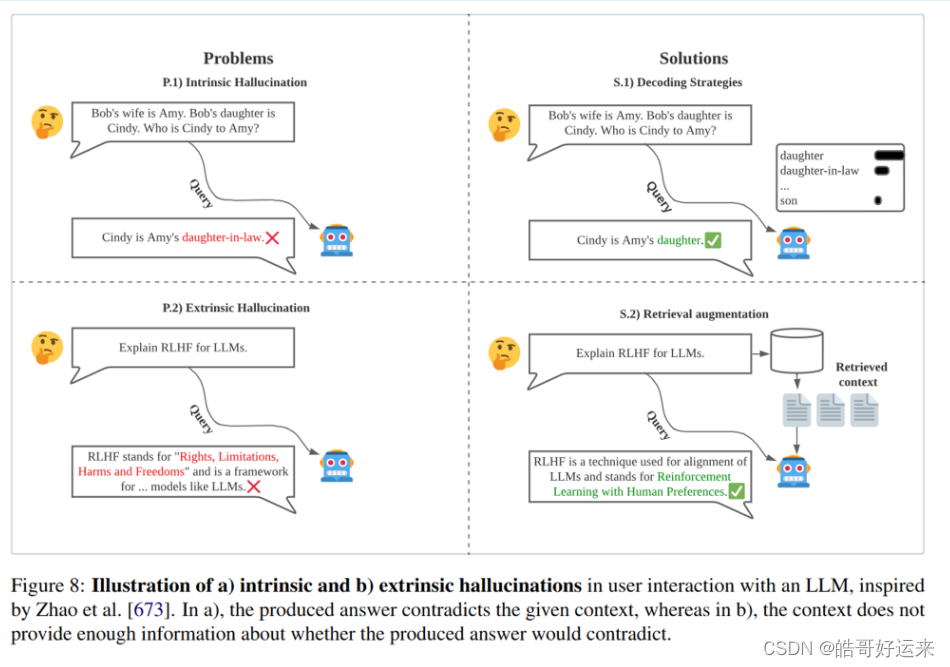

LLM之幻觉(一):大语言模型幻觉解决方案综述

论文题目:《Cognitive Mirage: A Review of Hallucinations in Large Language Models》

论文链接:https://arxiv.org/abs/2309.06794v1

论文代码:https://github.com/hongbinye/cognitive-mirage-hallucinations-in-llms

一、幻觉介绍 …

BENTLY 350015 127610-01数字量输入模块

数字输入功能: BENTLY 350015 127610-01模块通常用于监测和采集数字输入信号,例如开关状态、传感器状态等。 多通道: 这些模块通常具有多个输入通道,允许同时监测多个数字输入信号。 高精度: BENTLY 350015 127610-0…

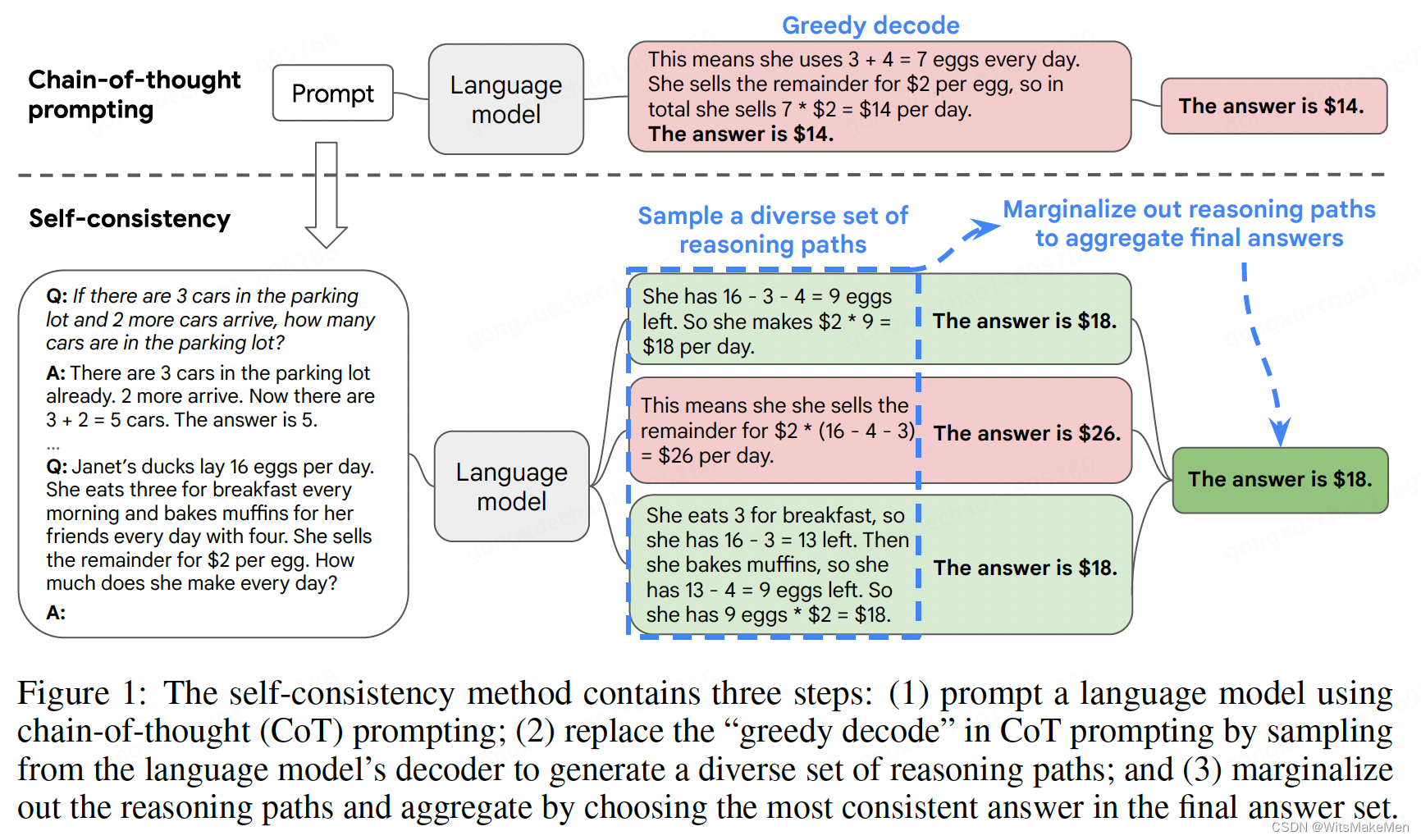

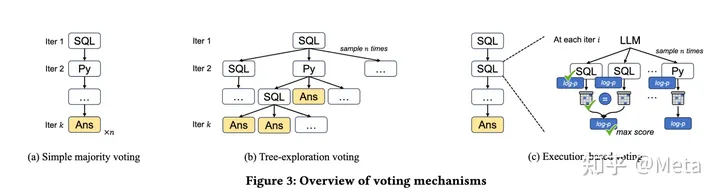

一致性思维链(SELF-CONSISTENCY IMPROVES CHAIN OF THOUGHT REASONING IN LANGUAGE MODELS)

概要

思维链已经在很多任务上取得了非常显著的效果,这篇论文中提出了一种 self-consistency 的算法,来代替 贪婪解码 算法。本方法通过 采样多个思维链集合,然后LLM模型生成后,选择一个最一致的答案作为最后的结果。一致性思维链…

【AI视野·今日NLP 自然语言处理论文速览 第三十八期】Thu, 21 Sep 2023

AI视野今日CS.NLP 自然语言处理论文速览 Thu, 21 Sep 2023 Totally 57 papers 👉上期速览✈更多精彩请移步主页 Daily Computation and Language Papers

Chain-of-Verification Reduces Hallucination in Large Language Models Authors Shehzaad Dhuliawala, Mojt…

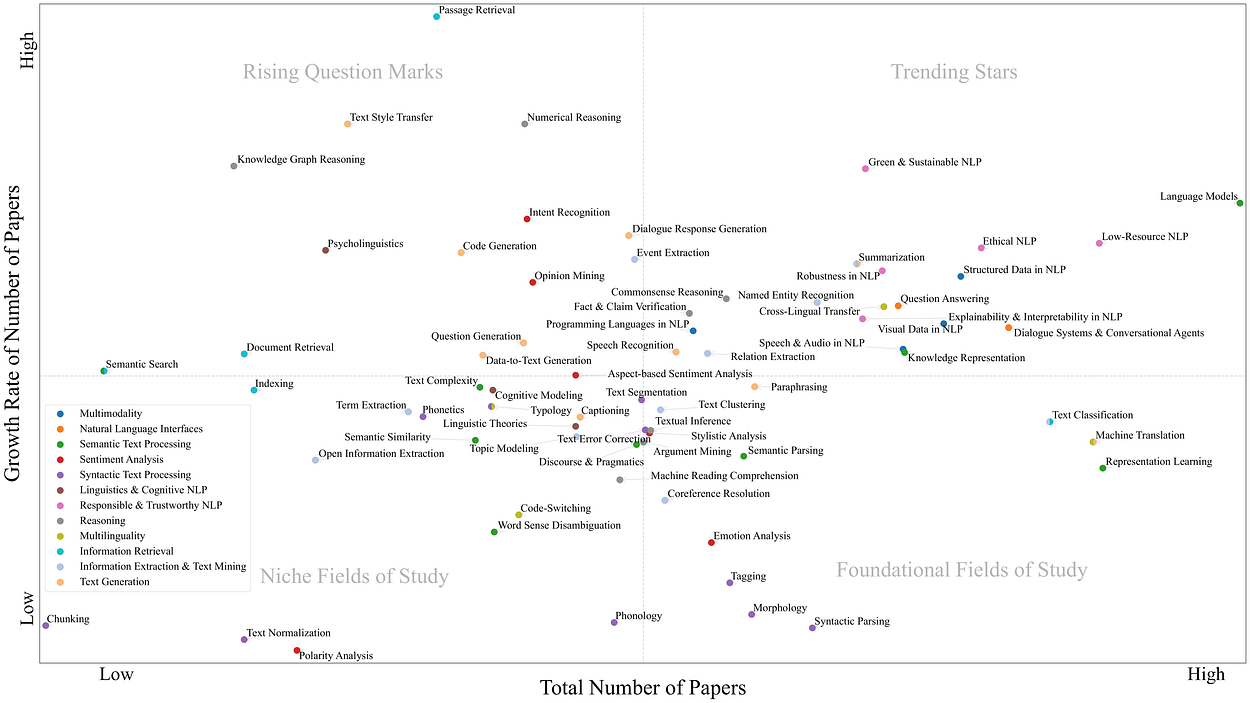

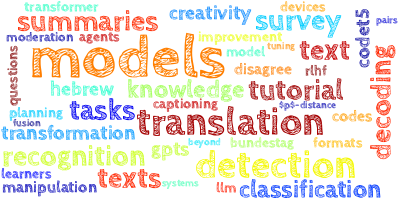

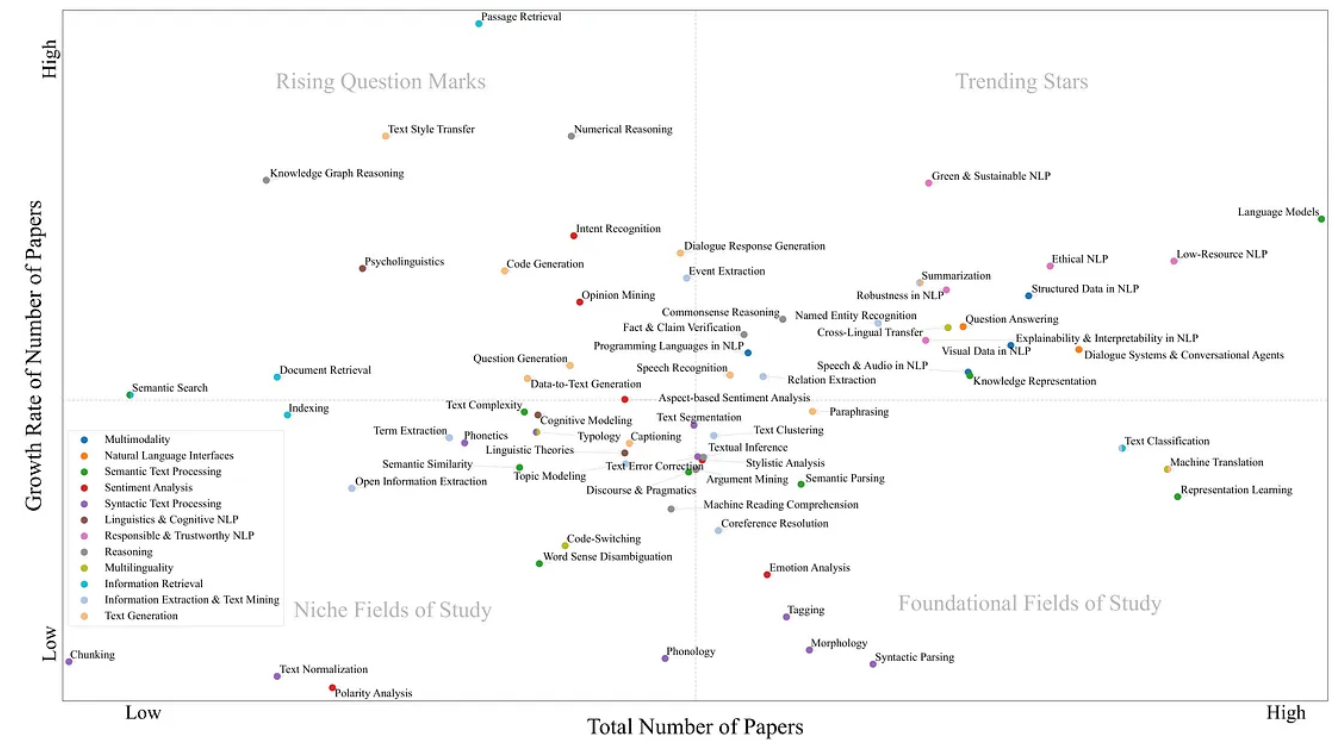

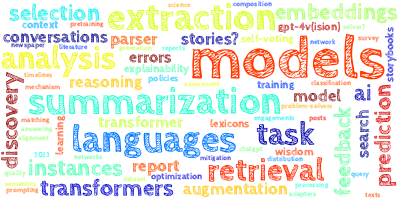

NLP的不同研究领域和最新发展的概述

一、介绍 作为理解、生成和处理自然语言文本的有效方法,自然语言处理 (NLP) 的研究近年来迅速普及并被广泛采用。鉴于NLP的快速发展,获得该领域的概述和维护它是困难的。这篇博文旨在提供NLP不同研究领域的结构化概述,…

文件操作的常用技巧(持续更新)

目录 1. 统计文件的总行数2. 查看文件中的某一行3. 从文件中随机抽取若干行4. 划分文件&合并文件 1. 统计文件的总行数

使用 wc 命令:

wc -l filename | awk {print $1}使用 awk 命令:

awk END {print NR} filename使用 grep 命令:

g…

【AI视野·今日NLP 自然语言处理论文速览 第四十六期】Tue, 3 Oct 2023

AI视野今日CS.NLP 自然语言处理论文速览 Tue, 3 Oct 2023 (showing first 100 of 110 entries) Totally 100 papers 👉上期速览✈更多精彩请移步主页 Daily Computation and Language Papers

Its MBR All the Way Down: Modern Generation Techniques Through the …

机器学习笔记 - 深入研究spaCy库及其使用技巧

一、简述 spaCy 是一个用于 Python 中高级自然语言处理的开源库。它专为生产用途而设计,这意味着它不仅功能强大,而且快速高效。spaCy 在学术界和工业界广泛用于各种 NLP 任务,例如标记化、词性标注、命名实体识别等。 安装,这里使用阿里的源。

pip install spacy…

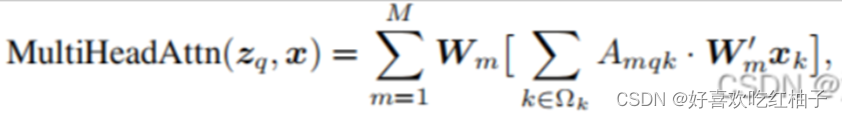

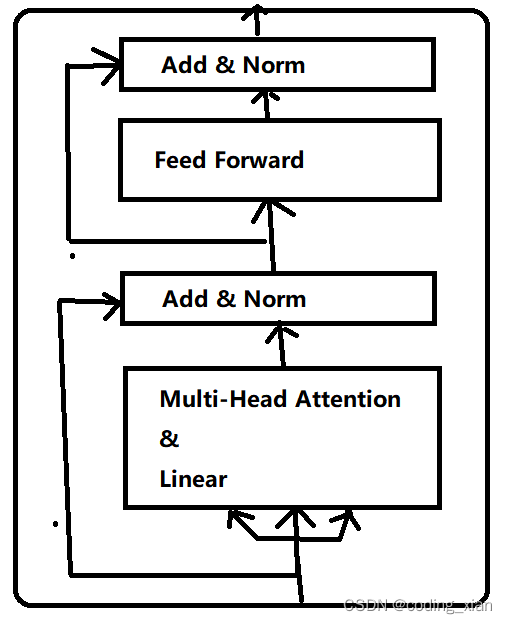

自然语言处理---Tr ansformer机制详解之Transformer结构

1 Encoder模块

1.1 Encoder模块的结构和作用

经典的Transformer结构中的Encoder模块包含6个Encoder Block.每个Encoder Block包含一个多头自注意力层,和一个前馈全连接层.

1.2 Encoder Block

在Transformer架构中,6个一模一样的Encoder …

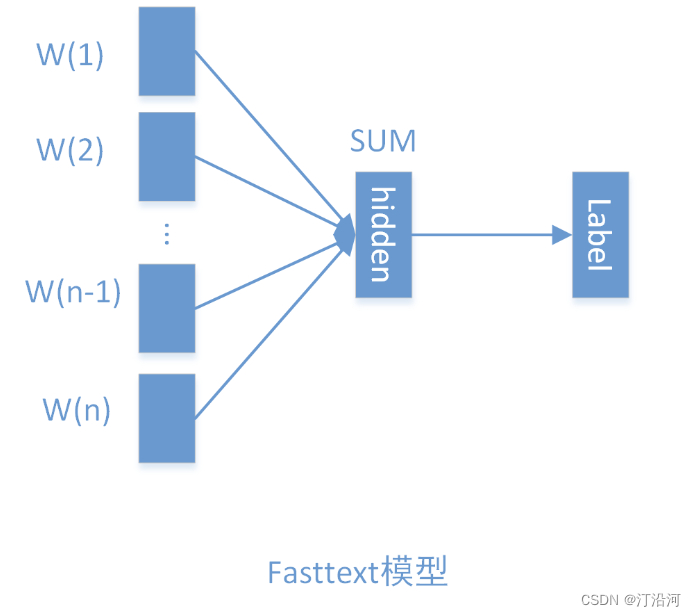

自然语言处理---迁移学习

fasttext介绍 作为NLP工程领域常用的工具包,fasttext有两大作用:进行文本分类、训练词向量。在保持较高精度的情况下,快速的进行训练和预测是fasttext的最大优势。fasttext优势的原因: fasttext工具包中内含的fasttext模型具有十分简单的网络…

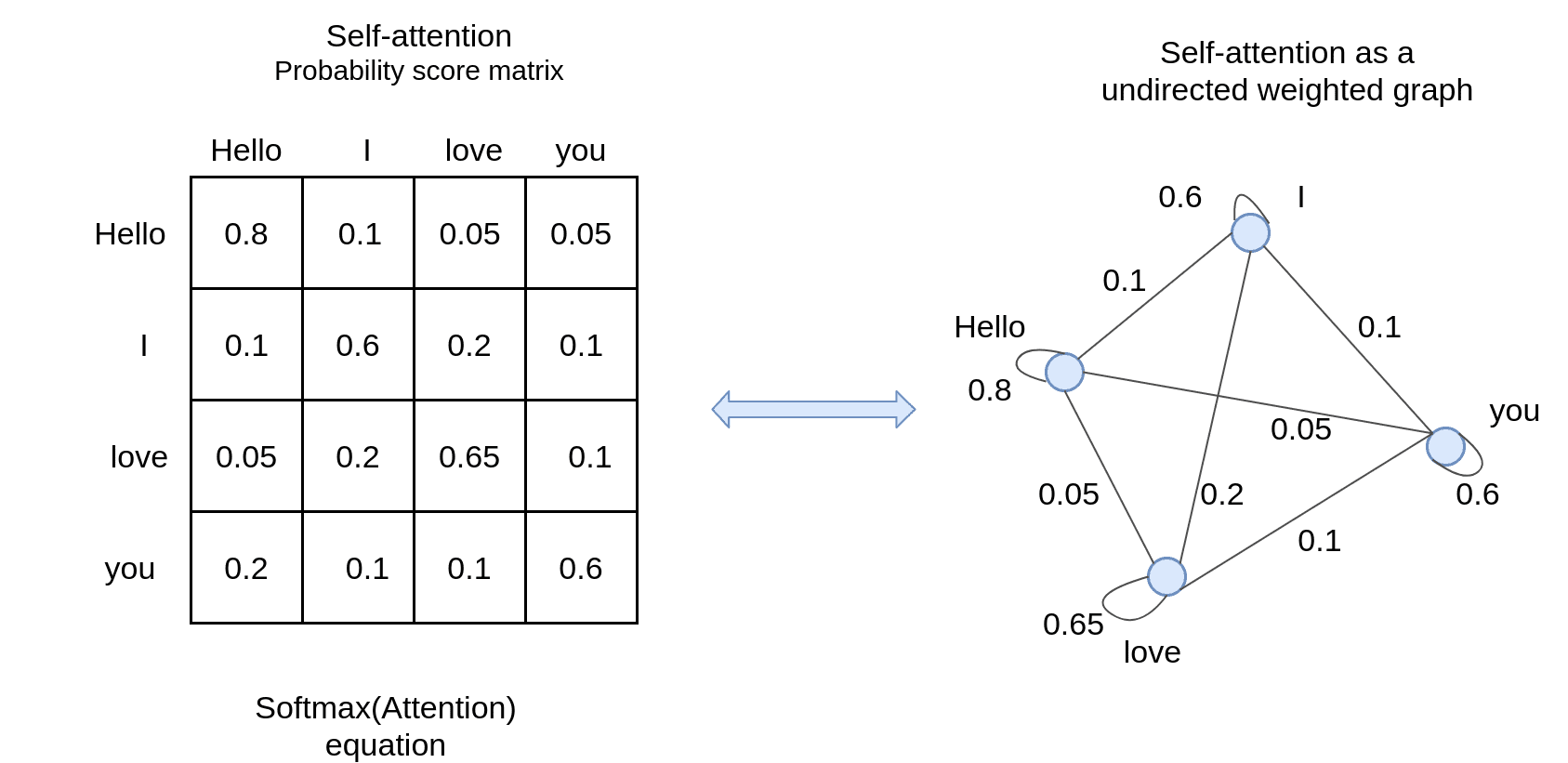

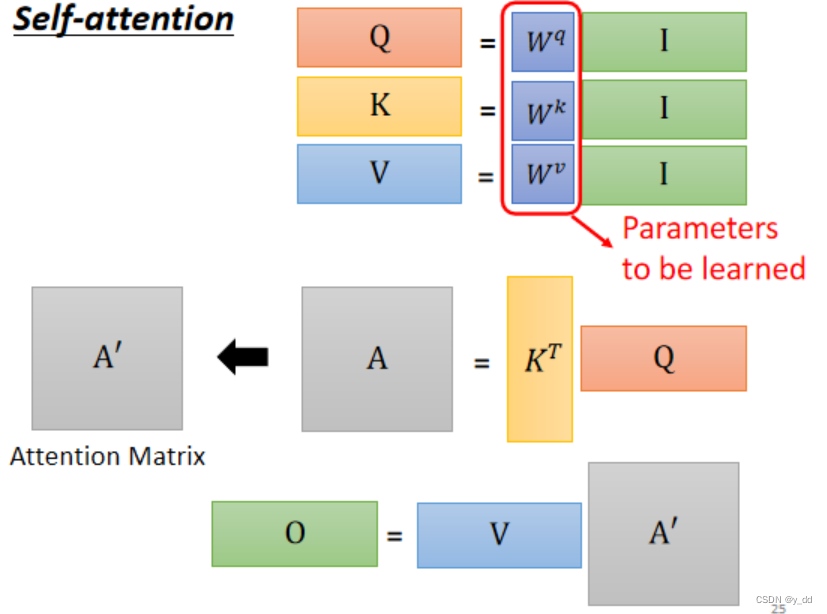

自然语言处理---Transformer机制详解之Self attention机制详解

1 Self-attention的特点

self-attention是一种通过自身和自身进行关联的attention机制, 从而得到更好的representation来表达自身.

self-attention是attention机制的一种特殊情况,在self-attention中, QKV, 序列中的每个单词(token)都和该序列中的其他所有单词(to…

Tuna: Instruction Tuning using Feedback from Large Language Models

本文是LLM系列文章,针对《Tuna: Instruction Tuning using Feedback from Large Language Models》的翻译。 Tuna:使用来自大型语言模型的反馈的指令调优 摘要1 引言2 方法3 实验4 相关工作5 结论局限性 摘要

使用更强大的LLM(如Instruction GPT和GPT-…

《人工智能算法图解》书籍推荐

书籍介绍 今天,人工智能在我们的生活中随处可见。它能推送我们喜欢的电视节目,帮助我们诊断疑难杂症,还能向我们推荐商品。因此,让我们掌握人工智能的核心算法,拥抱日新月异的智能世界吧。

与那些充斥着公式和术语的教…

【探索AI潜能,连结现代通讯】相隔万里,我们与AI一同赏月。

1️⃣写在前面

近年来,AI得到了迅猛的发展,尤其是大模型的出现受到了广泛的关注和讨论🚀。ChatGPT、文心一言等纷纷登场,可谓是百家争鸣❗

而AI大模型所延申出的子项目如AI绘画、AI写作等,在各自的领域展示出了惊人的…

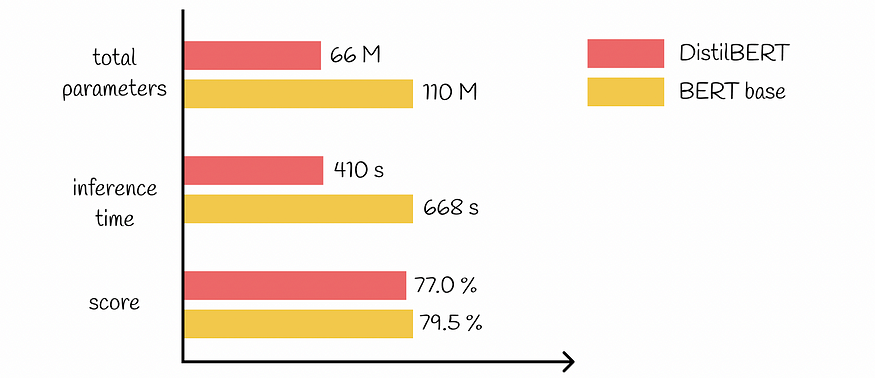

大型语言模型:DistilBERT — 更小、更快、更便宜、更轻

一、介绍 近年来,大型语言模型的演进速度飞速发展。BERT成为最流行和最有效的模型之一,可以高精度地解决各种NLP任务。在BERT之后,一组其他模型随后出现在现场,也展示了出色的结果。 很容易观察到的明显趋势是,随着时间…

【自然语言处理】关系抽取 —— GDPNet 讲解

GDPNet 论文信息 标题:GDPNet: Refining Latent Multi-View Graph for Relation Extraction 作者:Fuzhao Xue, Aixin Sun, Hao Zhang, Eng Siong Chng 期刊:AAAI 2021 发布时间与更新时间:2020.12.12 主题:自然语言处理、关系抽取、对话场景、BERT、GCN arXiv:[2012.0678…

token_to_image

token 和 image 互转 解释代码解释 这段代码实现了一个将图像转换为 token 并将其转换回图像的转换过程。以下是代码的主要步骤: 导入所需的库,包括 OpenCV、numpy 和 pandas。 定义一个名为 image_256_sample 的函数,该函数接受一个图像作为输入,并将其转换为 256 级灰度图…

自然语言处理(一):基于统计的方法表示单词

文章目录 1. 共现矩阵2. 点互信息3. 降维(奇异值分解) 1. 共现矩阵

将一句话的上下文大小窗口设置为1,用向量来表示单词频数,如: 将每个单词的频数向量求出,得到如下表格,即共现矩阵&#x…

使用Java和NLP技术实现AI伪原创文章自动生成:一个详细的编程指南

第一部分:引言和背景

1. 引言

随着技术的进步,AI领域特别是自然语言处理(NLP)领域已经得到了迅速的发展。一种特殊的应用是AI伪原创文章的自动生成,它可以在保持原文意义的前提下,为内容创造一个新的表达…

[NLP] 使用Llama.cpp和LangChain在CPU上使用大模型

一 准备工作

下面是构建这个应用程序时将使用的软件工具:

1.Llama-cpp-python 下载llama-cpp, llama-cpp-python

[NLP] Llama2模型运行在Mac机器-CSDN博客

2、LangChain

LangChain是一个提供了一组广泛的集成和数据连接器,允许我们链接和编排不同的模块。可以常…

第三章:人工智能深度学习教程-基础神经网络(第六节-ML深度学习层列表)

要指定所有层按顺序连接的神经网络的架构,请直接创建层数组。要指定层可以有多个输入或输出的网络架构,请使用 LayerGraph 对象。使用以下函数创建不同的图层类型。

输入层:

功能描述图像输入层 将图像输入网络应用数据标准化序列输入层 将…

自然语言处理---Transformer机制详解之Transformer优势

1 Transformer的并行计算

对于Transformer比传统序列模型RNN/LSTM具备优势的第一大原因就是强大的并行计算能力.

对于RNN来说,任意时刻t的输入是时刻t的输入x(t)和上一时刻的隐藏层输出h(t-1),经过运算后得到当前时刻隐藏层的输出h(t),这个…

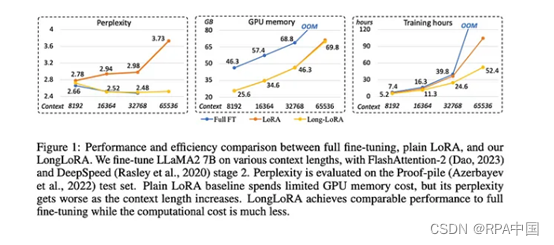

LONGLORA: EFFICIENT FINE-TUNING OF LONGCONTEXT LARGE LANGUAGE MODELS

本文是LLM系列文章,针对《LONGLORA: EFFICIENT FINE-TUNING OF LONGCONTEXT LARGE LANGUAGE MODELS》的翻译。 Longlora:长上下文大型语言模型的高效微调 摘要1 引言2 相关工作3 LongLoRA4 实验5 结论 摘要

我们提出了LongLoRA,一种有效的微调方法&…

ConPET: Continual Parameter-Efficient Tuning for Large Language Models

本文是LLM系列文章,针对《ConPET: Continual Parameter-Efficient Tuning for Large Language Models》的翻译。 ConPET:大型语言模型的连续参数高效调优 摘要1 引言2 相关工作3 提出的方法4 实验5 结论与未来工作 摘要

持续学习需要不断调整模型以适应新出现的任…

NLP算法面经 | 腾讯 VS 美团

作者 | 曾同学 编辑 | NewBeeNLP 面试锦囊之面经分享系列,持续更新中 后台回复『面试』加入讨论组交流噢 lz从3月初脚因打球扭伤了开始,投递简历,接二连三的面试鞭尸又面试,昨天才终于上岸了,分享经验~ 腾讯PCG看点&…

大语言模型在推荐系统的实践应用

本文从应用视角出发,尝试把大语言模型中的一些长处放在推荐系统中。

01

背景和问题

传统的推荐模型网络参数效果较小(不包括embedding参数),训练和推理的时间、空间开销较小,也能充分利用用户-物品的协同信号。但是它的缺陷是只能利用数据…

《Playing repeated games with Large Language Models》全文翻译

《Playing repeated games with Large Language Models》- 使用大型语言模型玩重复游戏 论文信息摘要1. 介绍2. 相关工作3. 一般方法4. 分析不同游戏系列的行为5. 囚徒困境5.1 性别之战 6. 讨论 论文信息

题目:《Playing repeated games with Large Language Model…

为什么嵌入通常优于TF-IDF:探索NLP的力量

塔曼纳 一、说明 自然语言处理(NLP)是计算机科学的一个领域,涉及人类语言的处理和分析。它用于各种应用程序,例如聊天机器人、情绪分析、语音识别等。NLP 中的重要任务之一是文本分类,我们根据文本的内容将文本分类为不…

Banana Pi BPI-W3(Armsom W3)RK3588开当板之调试UART

前言

本文主要讲解如何关于RK3588开发板UART的使用和调试方法,包括UART作为普通串口和控制台两种不同使用场景

一. 功能特点

Rockchip UART (Universal Asynchronous Receiver/Transmitter) 基于16550A串口标准,完整模块支持以下功能:

支…

2021-arxiv-LoRA Low-Rank Adaptation of Large Language Models

2021-arxiv-LoRA Low-Rank Adaptation of Large Language Models Paper: https://arxiv.org/abs/2106.09685 Code: https://github.com/microsoft/LoRA

大型语言模型的LoRA低秩自适应

自然语言处理的一个重要范式包括对通用领域数据的大规模预训练和对特定任务或领域的适应。…

【深入探究人工智能】历史、应用、技术与未来

深入探究人工智能 前言人工智能的历史人工智能的应用人工智能的技术人工智能的未来当代的人工智能产物结语🍀小结🍀 🎉博客主页:小智_x0___0x_ 🎉欢迎关注:👍点赞🙌收藏✍️留言 &am…

ChatGPT技术原理 第四章:Transformer模型

目录 4.1 什么是Transformer

4.2 Transformer结构详解

4.3 Self-Attention机制